2025年のビジネス現場では、ウェブ上に溢れる膨大なデータを「どれだけ早く、しかも高品質で手に入れられるか」が勝負の分かれ目になっています。営業やEC、オペレーション、市場調査など、どんな分野でもウェブサイトから必要なデータを大量かつタイムリーに集める力が、今や大きな競争力になっています。Pythonはこの分野で圧倒的な人気を誇り、がウェブデータ抽出に選んでいるのも納得です。理由は、ライブラリが豊富で扱いやすく、拡張性も抜群だからです。

とはいえ、Pythonが万能な一方で、最近はのようなノーコードツールも登場し、プログラミングが苦手な人でも直感的にウェブデータを抽出・整理できる時代になりました。この記事では、Pythonによる伝統的な手法(Requests、Beautiful Soup、Selenium、Scrapy、Pandas)と、Thunderbitのような最新AIツールの両方を比較しながら、実践的なコード例やビジネス活用シーン、現場で得たノウハウを紹介します。

「Pythonでウェブサイトからデータを取得する」とは?

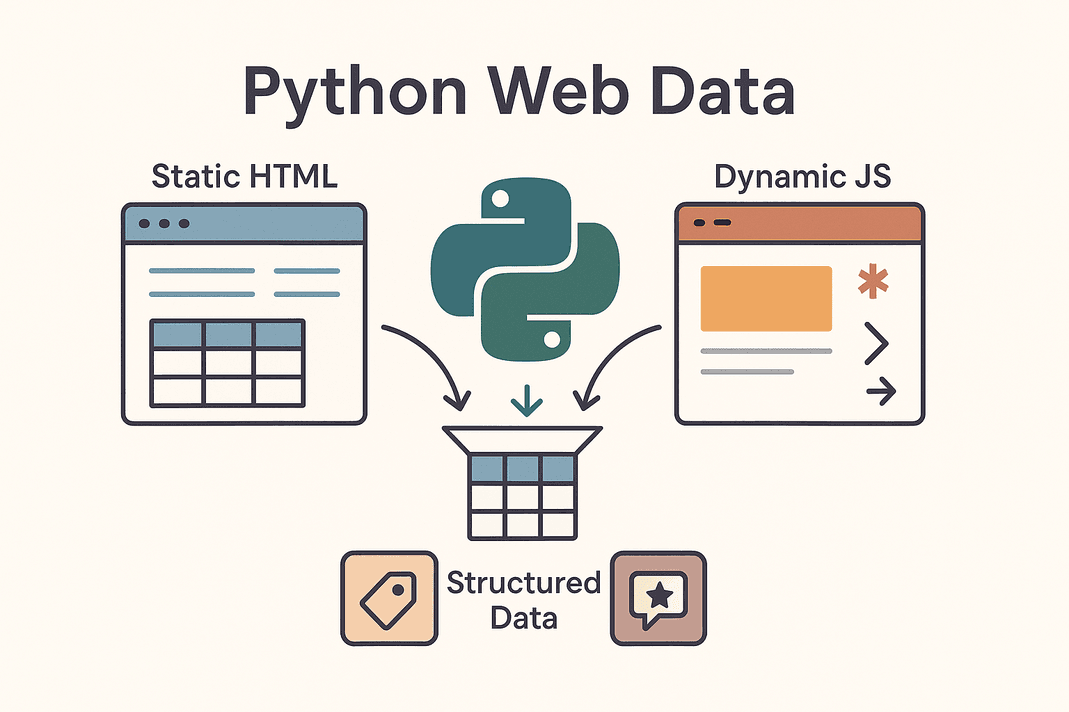

「Pythonでウェブサイトからデータを取得する」とは、Pythonスクリプトを使ってウェブページから自動で情報を集め、バラバラなHTMLを使いやすい構造化データに変換することを指します。いわゆるウェブスクレイピングです。商品価格や連絡先、レビューなどを手作業でコピペする代わりに、Pythonがその作業を自動化してくれるイメージです。

「Pythonでウェブサイトからデータを取得する」とは、Pythonスクリプトを使ってウェブページから自動で情報を集め、バラバラなHTMLを使いやすい構造化データに変換することを指します。いわゆるウェブスクレイピングです。商品価格や連絡先、レビューなどを手作業でコピペする代わりに、Pythonがその作業を自動化してくれるイメージです。

ウェブサイトには大きく2種類あります:

- 静的サイト:最初のHTMLにすべての情報が含まれているタイプ。「ページのソースを表示」で見える内容がそのままデータです。HTMLを取得して解析するだけなので比較的簡単です。

- 動的サイト:JavaScriptでページ表示後にデータが読み込まれるタイプ。無限スクロールやリアルタイム価格更新、ボタンを押して初めて表示される情報などが該当します。こうした場合はSeleniumなどでブラウザ操作を再現したり、裏側のAPIを探す必要があります()。

よくスクレイピングされるのは、商品リスト、リード情報、価格、レビュー、画像など。リードリスト作成、競合価格の追跡、市場の声の収集など、Pythonを使えばウェブ全体を自分専用のデータベースに変えられます。

ビジネスがPythonでウェブデータを取得する理由

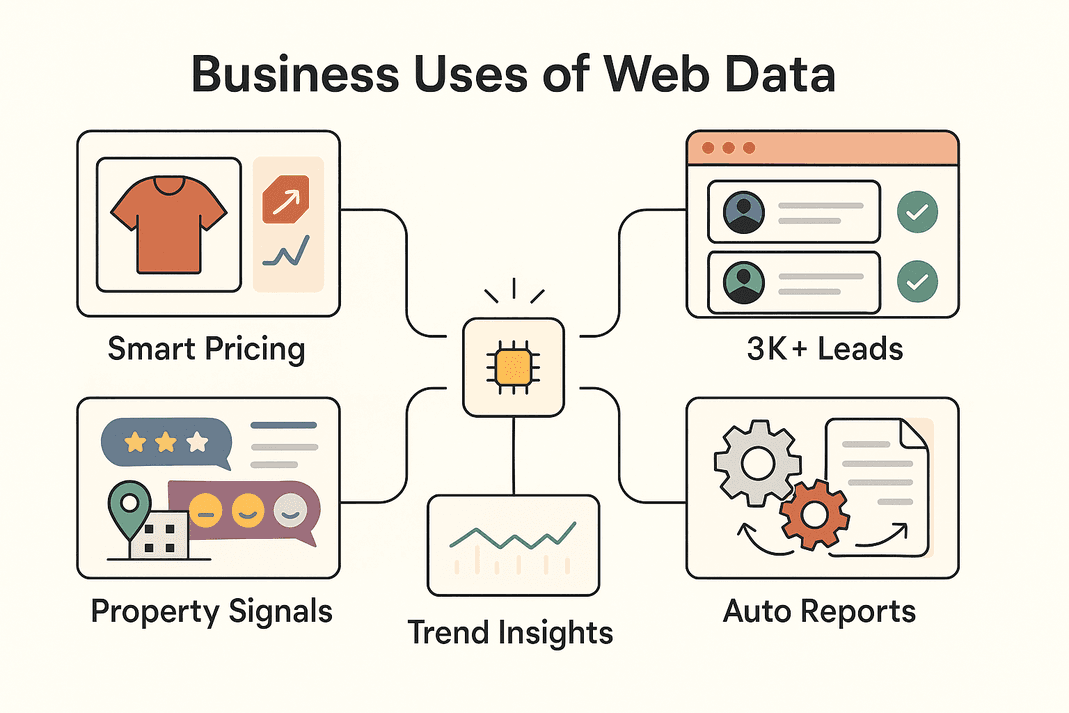

実際にどんなビジネス課題が解決できるのか、主な活用例と得られる効果をまとめました:

| ビジネス用途 | 取得データ | ROI / 効果 |

|---|---|---|

| リード獲得(営業) | ディレクトリやSNSの連絡先 | 月3,000件以上のリード獲得、担当者1人あたり週8時間の工数削減 (Thunderbit)) |

| 価格モニタリング(EC) | 商品価格、在庫状況 | 売上4%増加、アナリスト工数30%削減 (blog.apify.com) |

| 市場調査 | レビュー、SNS投稿、フォーラムコメント | ターゲティング精度向上;スクレイパーの26%がSNSデータを収集 (Thunderbit) |

| 不動産リスティング | 物件情報、相場、立地データ | 案件発掘の高速化、最新の相場把握 |

| 業務自動化 | 在庫、レポート、定型データ | 手作業の10〜50%を自動化 |

要するに、Python(やThunderbit)によるウェブデータ抽出は、業務のスピードアップ、意思決定の質向上、単純作業の自動化に直結します。実際、に達し、今も急成長中です。

Pythonでウェブデータを抽出する主要ツール

Pythonがウェブスクレイピングで選ばれる理由は、その豊富なライブラリ群にあります。代表的なツールと用途をまとめました:

| ツール | 得意分野 | メリット | デメリット |

|---|---|---|---|

| Requests | 静的HTMLやAPIの取得 | シンプル・高速・初心者向け | JavaScriptには非対応 |

| Beautiful Soup | HTML/XMLの解析 | 使いやすく柔軟 | HTML取得が前提、JSサイトは不可 |

| Selenium | 動的/JS多用サイト、ログインやクリック | ブラウザでできる操作は全て可能 | 動作が重く、セットアップもやや複雑 |

| Scrapy | 大規模・多ページクロール | 高速・非同期・拡張性抜群 | 学習コスト高め、JSは標準非対応 |

| Thunderbit | ノーコード/ローコード、ビジネスユーザー向け | AI搭載、JS対応、簡単エクスポート | 複雑なロジックのカスタマイズは限定 |

実際の現場では、シンプルな案件はRequests+Beautiful Soup、動的サイトはSelenium、大規模クロールはScrapy、スピード重視やノーコードならThunderbit…と使い分けるのが一般的です。

ステップ1:Python Requestsでウェブデータを取得

まずは基本のRequests。ウェブページ取得の定番です。

-

Requestsのインストール

1pip install requests -

ページ取得例

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"データ取得失敗: {response.status_code}")()

-

トラブルシューティング

- ブラウザを装うヘッダー追加:

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) response.raise_for_status()でエラー処理- APIがJSON返却なら:

data = response.json()

- ブラウザを装うヘッダー追加:

Requestsは静的ページやAPI取得に最適。もしデータが見つからなければ、JavaScriptで後から読み込まれている可能性大。その場合はSeleniumの出番です。

ステップ2:Beautiful SoupでHTMLを解析

HTMLを取得したら、Beautiful Soupで必要な情報を抽出します。

-

インストール

1pip install beautifulsoup4 -

HTML解析

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

データ抽出例

- 商品カードを全て取得:

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - テーブルの場合:

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # 必要に応じてセルデータを抽出

- 商品カードを全て取得:

ポイント:

- ブラウザの開発者ツールでセレクタを調べる

.get_text()や.textでテキスト抽出- 欠損データは

if price_elem else "N/A"のようにチェック

Requests+Beautiful Soupは、静的サイト向けの王道コンビです。

ステップ3:Seleniumで動的コンテンツに対応

JavaScriptでデータが後から表示される場合は、Seleniumでブラウザ操作を自動化します。

-

Seleniumのインストール

1pip install seleniumChromeDriverなどのブラウザドライバも用意し、PATHに追加します。

-

ブラウザ自動操作例

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

ログインやクリック操作

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

動的コンテンツの待機

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

ヘッドレスモード(画面非表示)

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Seleniumは強力ですが、動作が重め。どうしてもブラウザ操作が必要な場合に使いましょう。

ステップ4:Scrapyで大規模データ取得を自動化

数百〜数千ページをクロールしたい場合は、Scrapyが最適です。

-

Scrapyのインストール

1pip install scrapy 2scrapy startproject myproject -

スパイダー作成例

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

スパイダー実行

1scrapy crawl products -o products.csv

Scrapyは非同期で高速、大規模クロールや複雑なページネーションに最適です。

ステップ5:ThunderbitでAIによるデータ抽出を加速

ここでの登場です。ノーコードでAIがウェブデータ抽出をサポートします。

- AIによるカラム提案:ページを自動解析し、最適な抽出項目を提案。HTMLを調べる手間なし。

- 動的ページも対応:JavaScriptや無限スクロール、ログイン後のデータもそのまま取得。

- サブページ抽出:各アイテムの詳細ページも自動で巡回し、データを拡充。

- テンプレート完備:Amazon、Zillow、Shopifyなど人気サイトは即利用可能なテンプレートあり。

- ワンクリック抽出:ページ内のメールや電話番号も一発抽出。

- スケジューリング&クラウド実行:自然言語で「毎週月曜9時」など定期実行もOK。最大50ページを同時処理。

- 多彩なエクスポート:Excel、Google Sheets、Airtable、Notion、CSV/JSON形式で即出力。無料・無制限。

Thunderbitは、スピード重視・ノーコードでデータを取得したいチームに最適。Thunderbitでデータを取得し、Pythonで分析…という使い方もおすすめです。

ステップ6:Pandasでデータのクレンジング&分析

PythonやThunderbitで取得したデータは、Pandasで整形・分析しましょう。

-

データ読み込み

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

データクレンジング

- 重複削除:

1df = df.drop_duplicates() - 欠損値処理:

1df = df.fillna("N/A") - フォーマット統一(例:価格)

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- 重複削除:

-

分析例

- 基本統計量:

1print(df.describe()) - カテゴリごとの平均価格:

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- 基本統計量:

Pandasは、バラバラなウェブデータをビジネスに役立つ情報へ変換する万能ツールです。

ステップ7:取得データの整理・共有

クリーンなデータをチームで活用しましょう。

- CSV/Excel:

df.to_csv("out.csv", index=False)やdf.to_excel("out.xlsx")で簡単共有。 - Google Sheets:やPythonの

gspreadライブラリを活用。 - データベース:大規模データは

df.to_sql()でSQLに保存。 - 自動化:スクリプトやThunderbitのスケジュール機能で常に最新データを維持。

- 運用のコツ:データにタイムスタンプを付与、カラムの意味を記録、機密データはアクセス制御を徹底。

チームのワークフローに合わせて、スプレッドシートやデータベースを使い分けましょう。

ThunderbitとPythonコード、どちらが自分たちに合う?

比較表で整理します:

| 比較項目 | Thunderbit(ノーコードAI) | Pythonライブラリ(コード) |

|---|---|---|

| 必要スキル | 不要(ブラウザUI) | Pythonプログラミングが必要 |

| セットアップ時間 | 数分(AI提案・即スクレイピング) | 数時間〜数日(コーディング・デバッグ) |

| JS/インタラクティブ対応 | 標準対応(ブラウザ/クラウドモード) | Selenium/Playwright等が必要 |

| メンテナンス | 低い—AIが多くのサイト変更に自動対応 | サイト変更時は手動でコード修正 |

| スケール | 中規模(クラウドで10〜100ページ高速処理) | 大規模(Scrapyで数千ページ以上も可) |

| カスタマイズ | UIやAIプロンプトで柔軟対応 | 無制限(あらゆるロジック・連携が可能) |

| アンチボット/プロキシ | 内部で自動処理 | 手動で実装が必要 |

| データ出力 | 1クリックでSheets、Excel、Notion、Airtable | カスタムコードが必要 |

| おすすめ用途 | 非エンジニア、スピード重視、保守負担を減らしたい場合 | 開発者、複雑・大規模案件 |

ポイント: Thunderbitはスピード重視・ビジネスチーム向け、Pythonは高度なカスタマイズや大規模処理向け。両方を併用するチームも多く、まずThunderbitで素早くデータ取得→Pythonで自動化や拡張、という流れもおすすめです。

ウェブデータ抽出のビジネス活用事例

実際にどんな現場で使われているか、具体例を紹介します:

実際にどんな現場で使われているか、具体例を紹介します:

- EC:John Lewisは。

- 営業:月3,000件以上のリードを自動収集し、担当者1人あたり週8時間の手作業を削減()。

- 市場調査:数千件のレビューやSNS投稿を収集し、ダッシュボード更新前にトレンドを把握。

- 不動産:物件リストを自動取得し、割安物件や新規市場をいち早く発見。MLS更新を待つ必要なし。

- 業務自動化:在庫チェックやレポート作成、FAQ自動生成など、パートナーサイトや社内サイトのデータを活用。

多くの場合、Thunderbitでデータ取得→Pythonで整形・分析→SheetsやDBで共有、というハイブリッド運用が主流です。

まとめ・ポイント

Python(とThunderbit)によるウェブデータ取得は、現代ビジネスの必須スキルです。要点をおさらい:

- Requests+Beautiful Soup:静的サイト向け、手軽で高速。

- Selenium:動的・JS多用・ログイン必須サイトに。

- Scrapy:大規模・多ページクロールに最適。

- Thunderbit:ノーコード・AI搭載でビジネスユーザーに最適。素早く簡単。

- Pandas:データの整形・分析・可視化に。

- エクスポートは柔軟に:CSV、Sheets、DBなどワークフローに合わせて選択。

自分の技術レベルや業務ニーズに合ったツールから始め、必要に応じて組み合わせていきましょう。ウェブスクレイピングの手軽さを体感したい方は、やもぜひチェックしてみてください。

データがいつでもクリーンで、構造化され、すぐに活用できる状態でありますように!

よくある質問

1. Pythonでウェブサイトからデータを取得する一番簡単な方法は?

静的サイトならRequestsでHTMLを取得し、Beautiful Soupで必要なデータを抽出するのが基本です。動的サイトはSeleniumが必要になる場合もあります。

2. Pythonコードの代わりにThunderbitを使うべきタイミングは?

素早くデータが欲しい、コーディングしたくない、動的ページやサブページ、Excel/Sheetsへの即時エクスポートが必要な場合はThunderbitが最適です。ビジネスユーザーや短納期案件に特におすすめ。

3. JavaScriptでデータが読み込まれるサイトはどう対応する?

Selenium(またはPlaywright)でブラウザ自動化するか、Thunderbitのブラウザ/クラウドモードを使えば自動でJS対応できます。

4. 抽出したデータのクレンジング・分析のコツは?

Pandasにデータを取り込み、重複削除・欠損値処理・フォーマット統一を行い、groupbyやdescribeで素早く傾向を把握しましょう。

5. ウェブスクレイピングはビジネスで合法・安全?

一般的に公開データの取得は合法ですが、各サイトの利用規約やrobots.txtは必ず確認しましょう。個人情報の無断取得はNG。ThunderbitもPythonも、倫理的なスクレイピングを推奨しています。

データ活用を次のレベルへ。 するもよし、Pythonで本格運用するもよし。どちらでも、すぐに価値あるウェブデータを手に入れられます。

さらに詳しく知りたい方へ