正直なところ、初めてウェブスクレイパーを作ったときは、まるで隠された超能力を手に入れたような感覚でした。営業リストや価格調査のために、何時間もかけてウェブサイトから手作業でコピペしていた日々が一瞬で過去のものになったんです。Pythonで自分だけのウェブスクレイパーを作るのは、ネット上の面倒な作業を自動化したい人なら一度は通る道。ビジネスユーザーにとっては、金曜の夜をスプレッドシートと格闘して過ごすか、ハッピーアワーに間に合うかの分かれ道にもなります。

このガイドでは、Pythonでウェブスクレイパーの作り方を、実際に使えるコード付きでわかりやすく解説します。そして、ほとんどのビジネスチームにとっては、を使えば、コード不要で2クリックで完了する、もっと簡単な方法があることも紹介します。Python好きな人も、とにかくデータだけ欲しい人も、自分に合ったやり方がきっと見つかります。

Pythonでウェブスクレイピングって何?超シンプル入門

まずは基本から。ウェブスクレイピングとは、ウェブサイトから自動で情報を集めること。つまり、ロボットのインターンにコピペ作業を全部任せるようなものです。しかもロボットは飽きずに文句も言いません。

ウェブスクレイパーは、こんな感じのスクリプトやプログラムです:

- ウェブページにアクセス(ブラウザと同じように)

- 必要なデータ(商品名、価格、連絡先など)を抽出

- データを構造化された形式(スプレッドシートやJSONファイルなど)で保存

Pythonがよく使われる理由は、読みやすくて便利なライブラリが豊富で、まさにプログラミング界の万能ツールだから。実際、。

基本の流れはこんな感じ:

- ウェブページを取得(HTMLをゲット)

- HTMLを解析して欲しいデータを見つける

- 結果を使いやすい形で保存

ケーキ作りに例えるなら、材料(HTML)を集めて、必要な部分(データ)を取り出し、盛り付ける(エクスポート)イメージです。

ビジネスチームにとってウェブスクレイピングが大事な理由

ウェブスクレイピングは、エンジニアやデータ好きだけのものじゃありません。営業、マーケ、EC、不動産など、最新で正確なウェブデータが意思決定に欠かせない分野では、今や必須のスキルです。に達し、年28%のペースで成長中。膨大なデータが新たなビジネスチャンスを生み出しています。

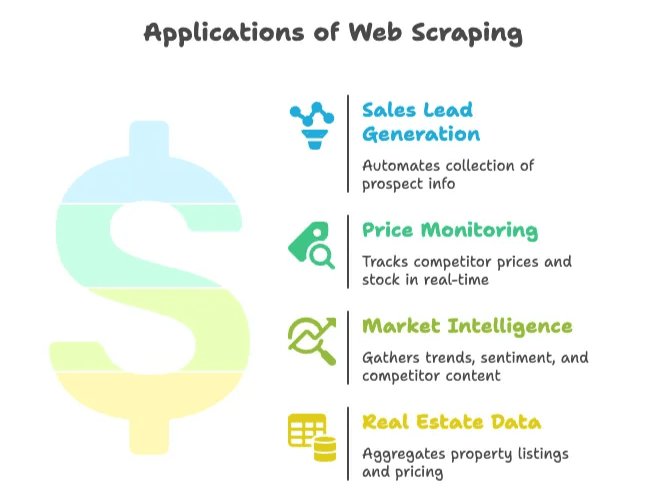

実際のビジネス活用例を見てみましょう:

| ユースケース | メリット | 具体的な成果例 |

|---|---|---|

| 営業リード獲得 | ディレクトリやSNSから見込み客情報を自動収集 | 1人あたり週8時間短縮、月3,000件のリード獲得、3ヶ月で売上10倍 |

| 価格モニタリング | 競合の価格や在庫をリアルタイムで追跡 | データ収集時間30%削減、価格最適化で売上4%増 |

| 市場調査・分析 | トレンドや競合情報、口コミなどを収集 | 70%以上の企業が市場分析にウェブデータを活用 |

| 不動産データ | 複数サイトから物件情報や価格を集約 | Zillow/Truliaを活用し、地域市場の変化を先取り |

つまり、ウェブスクレイピングは時間を節約し、手作業を減らし、競争力を高める武器です。もし今もコピペ作業をしているなら、ライバルはすでに一歩先を行っているかもしれません。

準備編:ウェブスクレイパー作成に必要なツールとスキル

コードを書く前に、必要な準備をチェックしましょう。

基本セット

- Pythonのインストール: 最新バージョン()をダウンロードして、ターミナルで

pythonが使えるか確認。 - コードエディタ: VS Code、PyCharm、Notepad++など。Python対応が充実しているVS Codeがイチオシ。

- 仮想環境: 必須じゃないけど、依存関係を整理するために

python -m venv venvで作っておくと便利。

主要なPythonライブラリ

- Requests: ウェブページ取得用()

- BeautifulSoup: HTML解析・要素抽出用()

- Selenium: JavaScriptで動的に生成されるページの取得用()

インストール方法:

1pip install requests beautifulsoup4 lxml seleniumHTMLの基礎知識

ウェブ開発者じゃなくても、HTMLの構造を調べる方法は知っておきましょう。ページ上で右クリック→「検証」でDOMツリーが表示され、ターゲットとなるタグやクラス名を確認できます()。

実践編:Pythonでウェブスクレイパーを作る手順

それでは、実際にシンプルなウェブスクレイパーを作ってみましょう。ここでは商品リストやニュース見出しの取得を例にしますが、他の用途にも応用できます。

Python環境のセットアップ

まず、プロジェクト用フォルダと仮想環境を作成:

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# Windowsの場合:

5venv\Scripts\activate

6# macOS/Linuxの場合:

7source venv/bin/activate必要なライブラリをインストール:

1pip install requests beautifulsoup4 lxmlscraper.pyというファイルを作成し、エディタで開きます。

ウェブページの取得と解析

まずはターゲットサイトのHTMLを取得します。例としてを使います。

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()次に、BeautifulSoupでHTMLを解析:

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # "Hacker News"と表示されるはず必要なデータの抽出

例えば、全てのニュースタイトルとリンクを取得したい場合、<a class="storylink">タグを探します。

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)商品情報を取得したい場合は、<div class="product-item">などを探し、内部の要素を抽出します。汎用的な例:

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})データをCSVやJSONで保存

抽出したデータを実際に使える形で保存しましょう。

CSVで保存:

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])JSONで保存:

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)CSVはExcelで、JSONはテキストエディタで開けば、手作業の何時間分も一気に自動化できます。

応用編:ページ送りや動的コンテンツへの対応

実際のサイトは1ページで完結しないことが多いです。ここでは、より高度なケースへの対応方法を紹介します。

ページネーション(ページ送り)

URLに?page=2のようなパラメータがある場合、ページ番号をループで回します:

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # データ抽出処理()

「次へ」ボタンがある場合は、リンクをたどります:

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # データ抽出

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = None動的コンテンツ(JavaScriptで生成されるデータ)

HTMLにデータが見当たらない場合(JavaScriptで後から表示される場合)は、Seleniumを使います:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# ここからデータ抽出()

Seleniumなら「もっと見る」ボタンのクリックや自動スクロールも可能ですが、Requestsより動作が重くなります。

自作ウェブスクレイパーでよくある落とし穴と課題

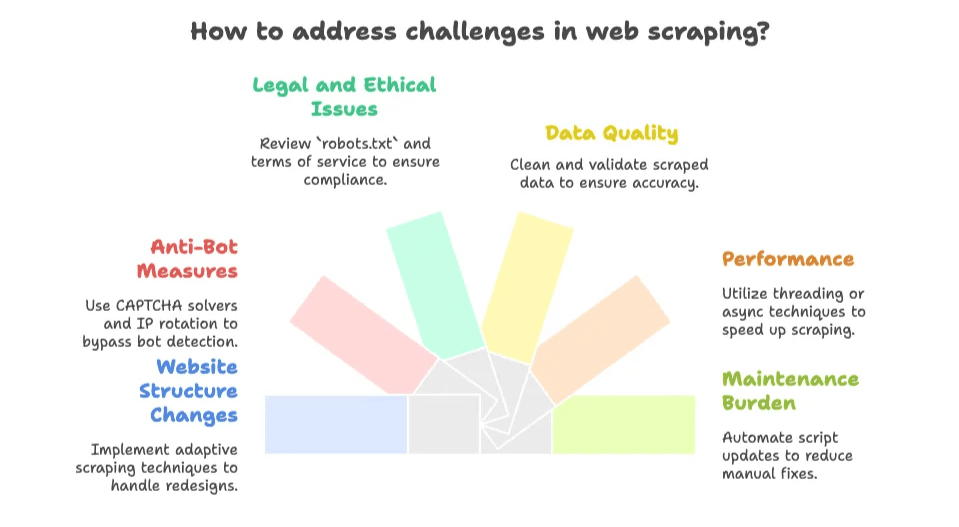

ここからが本番です。ウェブスクレイパー作りは楽しい反面、サイトの仕様変更で深夜にスクリプトが動かなくなる…なんてことも。主な課題は以下の通り:

- サイト構造の変更: デザインやクラス名が変わると、スクレイパーが動かなくなることも。保守作業はつきものです()。

- ボット対策: CAPTCHAやアクセス制限、IPブロックなど、。

- 法的・倫理的な問題:

robots.txtや利用規約は必ず確認。公開データはOKでも、非公開や著作権付きデータはNGの場合も()。 - データ品質: 抽出データが乱雑な場合も。HTMLタグや空白、文字化けの修正が必要になることも。

- パフォーマンス: 大量ページのスクレイピングは、スレッドや非同期処理を使わないと遅くなりがち。

- 保守負担: 新しいサイトや仕様変更ごとにスクリプト修正が必要。まさにモグラ叩き状態です。

開発好きならこの試行錯誤も楽しめますが、単にデータが欲しいだけなら、すぐに面倒に感じるかもしれません。

もっと賢く!ThunderbitのようなAIウェブスクレイパーの活用

ここでThunderbitの出番です(私の頭の中では稲妻マークのキャップをかぶっています)。多くのビジネスユーザーは、コードを書いたり保守したりしたくない、今すぐデータが欲しいだけなのです。

そこで開発されたのが。で、ウェブサイトやPDF、画像も2クリックでデータ化。コードも設定もHTML知識も不要です。

Thunderbitの特長

- 2クリックで完了: ページを開いて「AIフィールド提案」→「スクレイピング」で即データ化。

- AIによるフィールド自動提案: 商品名や価格、評価など、AIが最適なカラムを自動で抽出。

- サブページ・ページ送り対応: 「次へ」リンクや詳細ページも自動でたどり、データを充実化。

- 即エクスポート: Excel、Googleスプレッドシート、Airtable、Notion、CSV、JSONなどにワンクリックで出力。

- 多彩なデータ型: メールアドレス、電話番号、画像、PDFや画像内テキスト(OCR搭載)も抽出可能。

- クラウド・ブラウザ両対応: クラウドなら最大50ページ同時取得、ログインが必要なサイトはブラウザで対応。

- 保守不要: AIがレイアウト変更にも自動対応。スクリプト修正の手間なし。

比較:Python自作 vs. Thunderbit

| 項目 | Pythonスクレイパー | Thunderbit(AIウェブスクレイパー) |

|---|---|---|

| 準備時間 | コード作成・デバッグで数時間 | 拡張機能を入れて数分、すぐ使える |

| 技術スキル | 高(Python、HTML、CSS、デバッグ) | 低(クリック操作のみ、コード不要) |

| 保守性 | サイト変更ごとに自分で修正 | ThunderbitのAIが自動対応 |

| ページ送り・サブページ | ループやロジックを自作 | オプションを切り替えるだけでOK |

| データ型 | 基本はテキストのみ、画像やPDFは追加実装が必要 | テキスト・画像・メール・電話・PDFなどワンクリック抽出 |

| スケール・速度 | コードとPC性能に依存 | クラウドで50ページ同時取得、ログインサイトはブラウザ対応 |

| コスト | Python自体は無料だが、時間やインフラ・プロキシ費用が発生 | 無料プランあり、有料は年3万クレジットで月約16.5ドル〜(料金詳細) |

| 柔軟性・制御 | カスタムロジックで最大限自由 | 標準的な用途なら最大限手軽 |

多くのビジネスユーザーにとって、Thunderbitは「面倒なく構造化データを手に入れる最短ルート」です。

どちらを選ぶ?自作ウェブスクレイパーとAIウェブスクレイパーの使い分け

どちらが自分に合っているのか、正直な見解をまとめます:

自作スクレイパーが向いている場合

- 高度なカスタム処理(2段階認証ログインや複雑なワークフロー、独自システム連携など)が必要

- プログラミングが得意で、試行錯誤が好き

- サイト構造が安定していて、スクリプトの保守も苦にならない

- スクレイピングを大規模システムに組み込みたい

- ログインが必要、またはAIツールが対応していないデータを取得したい

AIウェブスクレイパー(Thunderbit)が向いている場合

- コードを書きたくない、スクリプトの保守もしたくない

- すぐにデータが欲しい(単発・定期どちらも)

- サイトの仕様変更やボット対策が多い(Thunderbitが自動対応)

- OCRやメール・電話抽出、各種ツールへのエクスポートなど、便利機能を活用したい

- 分析や意思決定に集中したい、デバッグに時間をかけたくない

判断の目安:

- データが公開されていて、ログイン不要?→ Thunderbitが最適

- 単発・アドホックな用途?→ Thunderbit

- カスタマイズやシステム連携が必要?→ Pythonスクリプト

- 開発者がいて、コードを書くのが好き?→ Pythonスクリプト

- 保守の手間を減らしたい?→ Thunderbit

まずはThunderbitで手軽に始めて、必要に応じて自作スクリプトに移行するのもおすすめです。

AIウェブスクレイパーの仕組みや活用シーンについては、もご覧ください。

まとめ:ビジネスでウェブスクレイピングを活かすポイント

最後にポイントをまとめます:

- Pythonによるウェブスクレイピングは強力で柔軟ですが、学習コストや保守の手間がかかります。

- ThunderbitのようなAIウェブスクレイパーなら、誰でも手軽にデータ抽出が可能。コード不要、設定不要、すぐに結果が得られます。

- 多くのビジネスユーザーにとっては、AIツールを使うのが最速・最短の方法。特殊な要件がある場合のみ自作を検討しましょう。

- ウェブはデータの宝庫。最適な方法を選べば、手作業の何時間・何日分も効率化できます。

よくある質問(FAQ)

1. ウェブスクレイピングとは?なぜPythonがよく使われるの?

ウェブスクレイピングは、ウェブサイトから自動でデータを収集する技術です。Pythonは、コードが読みやすく、requestsやBeautifulSoup、Seleniumなどのライブラリが充実しているため、ウェブスクレイピングに最適とされています。

2. ビジネスでの主な活用例は?

営業リードの獲得、価格調査、市場分析、不動産データの集約など、繰り返しのデータ収集を自動化し、最新情報を意思決定に活かす用途で広く使われています。

3. 自作ウェブスクレイパーの主な課題は?

サイト構造の変化、ボット対策(CAPTCHAなど)、法的・倫理的な問題、データの品質、保守の手間などが主な課題です。

4. ThunderbitのAIウェブスクレイパーは従来のPythonスクレイパーと何が違う?

Thunderbitは、AIによるフィールド提案や自動ページ送り、各種エクスポート機能を備えたノーコードツールです。セットアップ不要で、サイトの変更にも自動対応。非開発者でも簡単に使えます。一方、Pythonスクリプトはコーディングや保守が必要です。

5. コードを書くよりThunderbitのようなAIスクレイパーを使うべきなのはどんな時?

コード不要で、迅速かつ確実にデータを取得したい場合(特に公開データや単発作業)はThunderbitが最適。カスタマイズやシステム連携、複雑なログインが必要な場合はPython自作が向いています。

さらに詳しく知りたい方へ:

ウェブスクレイピングについてもっと学びたい方は、以下のガイドもおすすめです:

最も簡単なウェブスクレイピングを体験したい方は、してみてください。金曜の夜も、データも、きっとあなたの味方になります。