もし大量のウェブデータを前にして、「これ、どうやってスプレ드시트にまとめればいいんだろう…」と悩んだことがあるなら、同じような経験をした人はたくさんいるよ。自分もまさにその一人。コーヒー片手に、どんどん増えていくタブを見つめながら「コピペじゃ絶対終わらないな」と悟った瞬間、きっとみんなもあるはず。2025年の今、ウェブスクレイピングはビジネスインテリジェンスや営業、オペレーションチームにとって“あったら便利”どころか、データドリブンな意思決定の中心になってる。でも、AIウェブスクレイパーから定番のPythonライブラリまで選択肢が多すぎて、「100種類のアイスから1つ選ぶ」みたいな気分になるのも正直なところ。

そこで今回は、SaaS・自動化・AIの現場で鍛えた自分の知見をもとに、2025年におすすめしたいウェブスクレイピングツール20選を徹底比較!2クリックでデータを取りたいビジネスユーザーから、細かくカスタマイズしたい開発者まで、きっとぴったりのツールが見つかるはず。実体験からのアドバイスや、ちょっと笑える小ネタ、そして見やすい比較表も用意したよ。

2025年版:ウェブスクレイピングツール20選 早見表

まずは主要な20ツールをカテゴリごとにまとめた比較表をチェック。機能・価格・おすすめ用途・ユーザー評価が一目でわかるよ。(ちなみに、手軽さ重視のAIウェブスクレイパーならThunderbitが一番おすすめ!)

この表の使い方:

- AIウェブスクレイパー:エンジニアじゃなくてもOK。自動化や柔軟性を重視するチームにぴったり。

- ノーコード/ローコード:ビジュアル操作で、ある程度自分でカスタマイズしたいビジネスユーザー向け。

- API系:技術力のあるチームがワークフローに組み込みたいときにおすすめ。

- Pythonライブラリ:フルカスタマイズや細かい制御を求める開発者向け。

| ツール名 | カテゴリ | 主な特徴 | 価格(2025年) | おすすめ用途 | メリット | デメリット | ユーザー評価(G2, Capterra, Trustpilot, Chrome Store) |

|---|---|---|---|---|---|---|---|

| Thunderbit | AIウェブスクレイパー | AIフィールド提案、サブページ抽出、即時テンプレート、無料データエクスポート、定期実行、ブラウザ/クラウド対応 | 無料(6ページ)、有料$15/月〜 | 営業、オペレーション、非エンジニア | 2クリック設定、ノーコード、高精度、無料エクスポート | 無料枠が少なめ、G2/Capterraで新しい | Chrome Store ★4.9, Thunderbit Blog |

| Browse AI | AIウェブスクレイパー | ビジュアル記録、ロボットテンプレ、AIパターン検出 | 無料、有料$19/月〜 | 非エンジニア、短時間作業 | ポイント&クリック、AI補助、連携豊富 | カスタマイズ性や大規模処理はやや弱い | G2 ★4.8, Capterra ★4.5, Chrome Store ★4.7 |

| Bardeen AI | AIウェブスクレイパー | 自動化ワークフロー、拡張機能、アプリ連携 | 無料、有料$10/月〜 | ワークフロー自動化 | 繰り返し作業の自動化、アプリ連携 | 複雑な抽出には不向き | G2 ★4.7, Chrome Store ★4.8 |

| Diffbot | AIウェブスクレイパー | コンピュータビジョン抽出、ナレッジグラフ、API | $299/月〜 | 大規模データ、エンタープライズ | ノーコード、レイアウト変化に強い、JS対応 | 高額、従量課金 | G2 ★4.9, Capterra ★4.5 |

| Zyte (AI) | AIウェブスクレイパー | AI抽出、アンチボット、スマートプロキシ | 無料、有料$29/月〜 | 開発者、データ企業 | 信頼性高い、プロキシ強力、エコシステム充実 | 開発者向け、規模拡大でコスト増 | G2 ★4.3 |

| Octoparse | ノー/ローコード | ビジュアルビルダー、クラウド、ログイン/ページネーション対応 | 無料(10タスク)、有料$119/月〜 | 非技術者、大規模データ | 直感的、複雑サイトも対応 | 上級機能は学習必要 | G2 ★4.8, Capterra ★4.7, Trustpilot ★2.7 |

| Parsehub | ノー/ローコード | ビジュアルエディタ、デスクトップ/クラウド、スケジューリング | 無料(200ページ/回)、有料$189/月〜 | アナリスト、記者 | 柔軟、IPローテーション、クロスプラットフォーム | デスクトップ実行、サポートが営業寄り | G2 ★4.3, Capterra ★4.5 |

| Webscraper.io | ノー/ローコード | Chrome拡張、クラウドプラン、サイトマップ設定 | 無料(拡張)、有料$50/月〜 | 趣味、小規模データ | ローカル無料、クラウド安価 | Chrome限定、高度な用途は制限 | G2 ★4.7, Capterra ★4.4, Trustpilot ★4.4 |

| Data Miner | ノー/ローコード | ブラウザ拡張、テンプレート駆動 | 無料、有料$19/月〜 | 小規模・短時間作業 | テンプレ豊富、エクスポート簡単 | 複雑な用途には不向き | Chrome Store ★4.4 |

| Apify | API | アクターマーケット、カスタムスクリプト、スケジューリング | 無料、有料$49/月〜 | 開発者&非開発者(アクター経由) | 柔軟・拡張性高い、連携豊富 | カスタムはコーディング必要、UI複雑 | G2 ★4.5, Capterra ★4.7 |

| ScrapingBee | API | ヘッドレスブラウザAPI、JSレンダリング、プロキシローテ | 無料トライアル、有料$49/月〜 | JS多用サイトの開発者 | シンプルAPI、信頼性高い | 開発者向け、規模拡大でコスト増 | G2 ★4.6 |

| ScraperAPI | API | プロキシ管理、CAPTCHA対応、非同期API | 無料(5kリクエスト)、有料$49/月〜 | 開発者、大規模、アンチブロック | フルスタック、高成功率、コスパ良 | 開発スキル必須 | G2 ★4.3, Capterra ★4.6, Trustpilot ★4.7 |

| Bright Data | API | Web Scraper IDE、プロキシネットワーク、データセット | 無料トライアル、有料$500/月〜 | エンタープライズ、大量データ | 強力、コンプライアンス、サポート | 高額、学習コスト | G2 ★4.5, Trustpilot ★4.3 |

| Oxylabs | API | プロキシネットワーク、データ配信API | 有料$99/月〜 | エンタープライズ、コンプライアンス | 高成功率、サポート、地域指定 | 高額、開発セットアップ必要 | G2 ★4.6 |

| Zyte (API) | API | Scrapy Cloud、スマートプロキシ、自動抽出 | 無料、有料$29/月〜 | 開発者、データ企業 | 実績豊富、Scrapy連携 | コーディング必要、規模拡大でコスト増 | G2 ★4.3 |

| Selenium | Pythonライブラリ | ブラウザ自動化、動的サイト対応 | 無料 | QA、開発者、動的サイト | どんなサイトも対応、コミュニティ大 | 遅い、リソース消費、セットアップ手間 | G2 ★4.5(テストツール) |

| BeautifulSoup4 | Pythonライブラリ | HTML/XMLパース、簡単API | 無料 | 初心者、簡易パース | シンプル、柔軟、堅牢 | JS非対応、クローラー機能なし | G2 ★4.4 |

| Scrapy | Pythonライブラリ | 非同期クロール、拡張性、パイプライン | 無料 | カスタムクローラー開発者 | 高性能、カスタマイズ自在 | 学習コスト高い | GitHub ★55k |

| Puppeteer | Pythonライブラリ | ヘッドレスChrome自動化、JS抽出 | 無料 | 開発者、動的コンテンツ | 強力、最新、スクリーンショット | Node.js中心、リソース消費 | GitHub ★85k |

| Playwright | Pythonライブラリ | マルチブラウザ自動化、最新API | 無料 | 開発者、JS多用サイト | 高速、クロスブラウザ、自動待機 | コーディング必須、リソース消費 | Devコミュニティ ★4.8 |

※ユーザー評価は執筆時点の目安。最新情報は各サービス公式サイトやG2、Capterra、Trustpilot、Chromeウェブストアでチェックしてね。

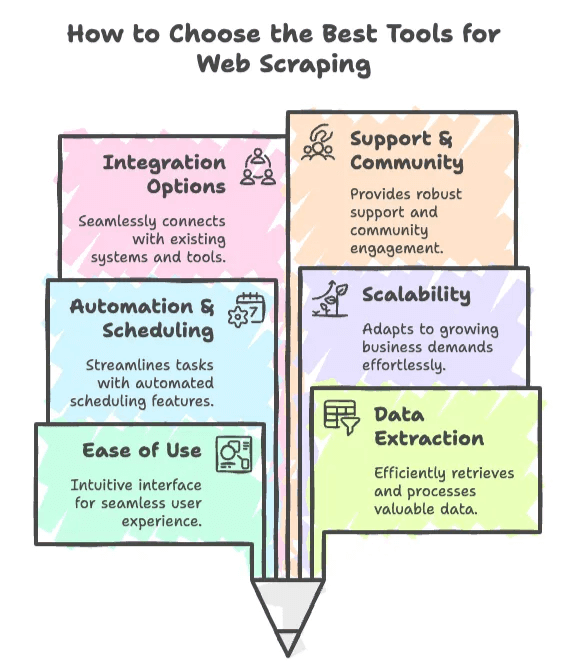

ウェブスクレイピングツールの選び方

正直、ウェブスクレイピングツール選びは“マッチングアプリ”みたいなもの。信頼できて、使いやすくて、肝心なときに音信不通にならないものが理想。自分が実際に重視しているポイントをまとめてみたよ。

1. 使いやすさ

- AIウェブスクレイパー(ThunderbitやBrowse AIなど)は、エンジニアじゃなくてもOK。5分以内に「データが欲しい」→「スプレッドシート完成」まで進みたいならこれ一択。

- ノー/ローコード系は、もう少し細かく操作したいビジネスユーザー向け。ちょっと学習は必要だけど、コーディングは不要。

2. データ抽出力

- 動的・JavaScript多用サイトを抜きたいなら、ブラウザ自動化対応(Selenium, Playwright, ScrapingBeeなど)を選ぼう。

- リストやテーブル、サブページからの抽出は、AIやビジュアル系ツールが得意。

3. 自動化・スケジューリング

- 毎日・毎週データ更新が必要なら、スケジューリング機能付き(Thunderbit, Octoparse, Apifyなど)を。

- 単発なら、拡張機能や簡単なスクリプトでも十分。

4. スケーラビリティ

- 数百ページ程度なら多くのツールでOK。

- 数百万ページ規模なら、API系やPythonフレームワーク(ScraperAPI, Bright Data, Scrapyなど)を検討しよう。

5. 連携オプション

- Google SheetsやAirtable、データベースに直接連携したいなら、内蔵連携機能(Thunderbit, Simplescraper, Apifyなど)を。

- 開発者はAPIやライブラリで独自ワークフロー構築も可能。

6. サポート・コミュニティ

- 初心者は、サポートやコミュニティが充実したツール(Octoparse, Apify, Thunderbitなど)が安心。

- 上級者は、ScrapyやSeleniumなどオープンソースの大規模コミュニティも心強い。

ワンポイントアドバイス:

リード獲得や価格調査、競合分析などビジネス用途なら、まずはAIやノーコード系から。開発者や技術チームならAPIやPythonライブラリで柔軟に対応しよう。

AIウェブスクレイパー:次世代のデータ抽出ツール

ここ数年で一気に伸びてきたのがAIウェブスクレイパー。CSSセレクタの設定や、サイト構造の変化で毎回壊れる心配から解放されて、機械学習やコンピュータビジョンで“人間みたいに”ページを読み取り、最小限の設定で構造化データを自動抽出してくれる。

なぜ重要か?2025年には65%以上の企業がAI/MLモデルやビジネスインテリジェンスのためにウェブスクレイピングを活用しているんだって()。AIスクレイパーは特にエンジニアじゃないチームにとって、速くて柔軟、しかもメンテナンス不要という大きなメリットがある。

1. Thunderbit:ビジネス向け最強AIウェブスクレイパー

まずは自分のイチオシ(自社製品だけど、本当におすすめ)を紹介!

Thunderbitの特長

- AIフィールド提案:ワンクリックで最適なカラムやデータ型を自動提案。

- サブページ抽出:リストページだけじゃなく、商品詳細などのサブページもAIが自動巡回して表をリッチに拡張。

- 即時テンプレート:Amazon、Zillow、Instagram、Shopifyなど人気サイトはテンプレ選ぶだけ。

- 無料データエクスポート:Excel、Google Sheets、Airtable、Notion、CSV、JSONにワンクリックで出力。追加料金なし。

- 定期実行:スケジュールを日本語で入力すればAIが自動で設定。価格監視や在庫更新に最適。

- ブラウザ/クラウド両対応:ログインが必要なサイトはブラウザ、スピード重視ならクラウド(最大50ページ同時)で抽出。

- AIオートフィル:AIでフォーム入力やワークフロー自動化も無料で使える。

- メール・電話・画像抽出:ワンクリックで連絡先や画像も取得。

Thunderbitはこんな人におすすめ

- 営業リスト(メール・電話・氏名)を集めたい営業チーム

- 競合SKUや価格を監視したいEC担当

- 物件情報や価格を追いたい不動産業者

- 2クリックでウェブデータを取得したい全ての人

料金プラン

- 無料枠:6ページ(1ページあたり行数無制限)

- スターター:$15/月(500クレジット)

- プロ:$38〜$249/月(3,000〜20,000クレジット)

ユーザーの声

- Chrome Store:★4.9(高評価キープ中)

- 「2クリックで設定完了」「コーディング不要」と好評

- で実例も多数

開発者の想い

Thunderbitは「データ分析に集中したい」「ツールの設定に時間を取られたくない」人のために作った。AIエージェントがサイト構造の変化にも自動対応、サブページ抽出でリッチなデータも簡単に取れるよ。

2. Browse AI

Browse AIは、ビジュアル操作でロボットを“録画”して学習させるAIウェブスクレイパー。クリックで欲しいデータを指定すれば、AIが類似項目(商品名や価格など)を自動でグループ化。ページネーションや定期実行もクラウドでOK。

主な特徴

- ポイント&クリックで直感的に学習

- よく使うサイト向けロボットテンプレート

- リストやテーブルのAIパターン検出

- Google Sheets、Zapier、Slackなど連携

料金

- 無料プランあり

- 有料$19/月〜

おすすめユーザー

- すぐにデータを取りたい非エンジニア

- マーケター、営業、スモールビジネス

メリット

- 圧倒的な使いやすさ

- コーディング・初期設定不要

- 自動化・連携機能も充実

デメリット

- 複雑なワークフローはカスタマイズ性が低い

- 大規模処理はやや遅い

- 強力なアンチボット対策サイトには不向き

ユーザー評価

- G2:★4.8

- Capterra:★4.5

- Chrome Store:★4.7

「5分で“欲しいデータ→スプレッドシート”を実現したい」人にぴったり。

3. Bardeen AI

Bardeen AIは、ウェブスクレイピングをワークフロー自動化に組み込める拡張機能。Google SheetsやNotion、Airtableなどビジネスアプリと連携して、繰り返し作業を自動化できる。

主な特徴

- スクレイピング以外も含めた自動化ワークフロー

- 多数のビジネスアプリと連携

- 抽出データをトリガーにアクション実行

料金

- 無料プランあり

- 有料$10/月〜

おすすめユーザー

- 繰り返し作業やデータ抽出を自動化したいチーム

メリット

- 複数ステップの自動化が強力

- ビジネスツールとの深い連携

デメリット

- 複雑な抽出にはやや不向き

- ワークフロー構築に慣れが必要

ユーザー評価

- G2:★4.7

- Chrome Store:★4.8

「スクレイピングを自動化の一部として使いたい」人におすすめ。

4. Diffbot

Diffbotはエンタープライズ向けAIウェブスクレイパーの代表格。コンピュータビジョンと機械学習で、どんなウェブページからも構造化データを抽出し、巨大なナレッジグラフも提供。

主な特徴

- 人間のようにページを読むコンピュータビジョン抽出

- 記事・商品・画像など多様なAPI

- JavaScriptや動的サイトも対応

- エンティティリンク付きナレッジグラフ

料金

- $299/月〜(25万クレジット)

- 無料トライアルあり

おすすめユーザー

- エンタープライズ、大規模データ、機械学習チーム

メリット

- ノーコード、レイアウト変化に強い

- 動的コンテンツやJSも対応

- スケーラブルで信頼性高い

デメリット

- 高額(小規模案件には不向き)

- AIのブラックボックス性(細かい調整不可)

ユーザー評価

- G2:★4.9

- Capterra:★4.5

ミッションクリティカルな大規模データパイプラインに最適。

5. Instant Data Scraper

Instant Data Scraperは、WebRobots.ioが提供するシンプルなChrome拡張型スクレイパー。エンジニアじゃなくてもテーブルやリスト、ディレクトリのデータをすぐに抽出できる。

主な特徴

- ノーコード、テーブル自動検出

- Chrome拡張でポイント&クリック抽出

- CSV/Excel即時エクスポート

料金

- 完全無料

おすすめユーザー

- 非エンジニア、カジュアルな抽出、リードリストやテーブル取得

メリット

- セットアップ不要、超簡単

- ログイン・登録不要

- テーブルやリスト型ページに最適

デメリット

- 自動化やクラウド抽出は非対応

- 複雑・JS多用ページは苦手

ユーザー評価

- Chrome Web Store:★4.8(1万件超)

「とにかく手早くテーブルを抜きたい」時に最適。

ノーコード/ローコード系:コーディング不要で柔軟なデータ抽出

「プログラミングは苦手だけど、もう少し細かく制御したい」人にはノー/ローコード系がぴったり。ビジュアル操作、スケジューリング、クラウド実行など多機能。

6. Octoparse

Octoparseは、直感的なビジュアル操作と複雑サイト対応で人気のノーコードスクレイパー。ログインや無限スクロールもOK。

主な特徴

- ウィザード&上級モードのビジュアルビルダー

- クラウド抽出・スケジューリング

- ログイン・フォーム・動的コンテンツ対応

料金

- 無料枠(10タスク)

- 有料$119/月〜

おすすめユーザー

- 非エンジニア、大規模データ、EC・不動産

メリット

- 直感的で使いやすい

- 複雑なシナリオも対応

- 学習用の無料プランあり

デメリット

- 上級機能は学習必要

- Trustpilot評価はやや低め(サポート課題)

ユーザー評価

- G2:★4.8

- Capterra:★4.7

- Trustpilot:★2.7

ガイド付きで始めたい人におすすめ。

7. Parsehub

Parsehubは、デスクトップアプリ&クラウド実行対応の柔軟なローコードスクレイパー。アナリストや記者に人気。

主な特徴

- スクリプトロジック付きビジュアルエディタ

- デスクトップ&クラウド両対応

- IPローテーション、ページネーション、ネスト抽出

料金

- 無料枠(200ページ/回)

- 有料$189/月〜

おすすめユーザー

- アナリスト、記者、技術に強いユーザー

メリット

- 高い柔軟性

- クロスプラットフォーム対応

- 小規模案件向け無料枠あり

デメリット

- デスクトップ実行はPCが必要

- サポートが営業寄り

ユーザー評価

- G2:★4.3

- Capterra:★4.5

「コーディングは苦手だけど細かく制御したい」人に最適。

8. Webscraper.io

Webscraper.ioは、無料Chrome拡張から始まり、今ではクラウド抽出も可能。初心者や趣味ユーザーに人気。

主な特徴

- ローカル抽出用Chrome拡張

- スケジューリング・大規模対応のクラウドプラン

- サイトマップ型ナビゲーション

料金

- 拡張は無料

- クラウド$50/月〜

おすすめユーザー

- 趣味、リサーチ、小規模ビジネス

メリット

- ローカル抽出は無料

- クラウドも手頃

デメリット

- Chrome限定

- 高度な用途は制限あり

ユーザー評価

- G2:★4.7

- Capterra:★4.4

- Trustpilot:★4.4

「まずは手軽に試したい」人におすすめ。

9. Data Miner

Data Minerは、テンプレート駆動型のChrome拡張。小規模・短時間の抽出に最適。

主な特徴

- Chrome拡張

- よく使うサイト向けテンプレート

- CSV/Excelへの簡単エクスポート

料金

- 無料枠あり

- 有料$19/月〜

おすすめユーザー

- 小規模・短時間抽出、非エンジニア

メリット

- テンプレで即設定

- エクスポートも簡単

デメリット

- 複雑・大規模用途には不向き

ユーザー評価

- Chrome Store:★4.4

テンプレートで手早く抽出したい人におすすめ。

API系:スケーラブルな自動データ抽出

API系は、技術力のあるチームが大規模・自動化したいときの定番。プロキシやブラウザレンダリング、アンチボット対策も自動で処理。

10. Apify

Apifyは、マーケットプレイス型の“アクター”とカスタムスクリプトAPIを備えた自動化プラットフォーム。

主な特徴

- アクターマーケット(既製スクレイパー)

- Node.js/Pythonでカスタムスクリプト

- スケジューリング、ストレージ、API連携

料金

- 無料枠あり

- 有料$49/月〜

おすすめユーザー

- 開発者&非開発者(アクター利用)、自動化ワークフロー

メリット

- 柔軟・拡張性高い

- コミュニティアクターで時短

デメリット

- カスタムはコーディング必要

- 大規模案件はUIが複雑

ユーザー評価

- G2:★4.5

- Capterra:★4.7

柔軟性とコミュニティ活用を重視する人におすすめ。

11. ScrapingBee

ScrapingBeeは、JS多用サイト向けの開発者向けAPI。ヘッドレスChromeでレンダリング。

主な特徴

- ヘッドレスブラウザAPI(Chromium)

- JSレンダリング、プロキシローテーション

- スクリーンショットAPI

料金

- 無料トライアル

- 有料$49/月〜

おすすめユーザー

- 動的・JS多用サイトを抜きたい開発者

メリット

- シンプルAPI、信頼性高い

- ドキュメント・サポート充実

デメリット

- 開発者向け、非エンジニアには不向き

- 規模拡大でコスト増

ユーザー評価

- G2:★4.6

モダンなWebアプリ抽出に最適。

12. ScraperAPI

ScraperAPIは、プロキシ・レンダリング・アンチボット対策を一括で提供するフルスタックAPI。

主な特徴

- プロキシ管理、CAPTCHA対応

- 非同期APIでバルク処理

- 主要サイト向け構造化データエンドポイント

料金

- 無料(5,000リクエスト)

- 有料$49/月〜

おすすめユーザー

- 開発者、大規模抽出、アンチブロック

メリット

- 高成功率、スケール時もコスパ良

- フルスタック対応

デメリット

- 開発スキル必須

- カスタムサイトはパース必要

ユーザー評価

- G2:★4.3

- Capterra:★4.6

- Trustpilot:★4.7

インフラ構築不要でデータ取得に集中したい開発者向け。

13. Bright Data Web Scraper API

Bright Dataは、世界最大級のプロキシネットワークとWebスクレイピングIDEを持つエンタープライズ向けプラットフォーム。

主な特徴

- Web Scraper IDE(ビジュアル/コード)

- 7,200万IP超のプロキシネットワーク

- 既製データコレクターAPI

料金

- 無料トライアル

- 有料$500/月〜

おすすめユーザー

- エンタープライズ、大量・コンプライアンス重視案件

メリット

- 強力・スケーラブル・コンプライアンス対応

- 専任サポート

デメリット

- 高額、IDEの学習コスト

ユーザー評価

- G2:★4.5

- Trustpilot:★4.3

大規模データパイプラインに最適。

14. Oxylabs

Oxylabsは、エンタープライズ向けプロキシ&スクレイピングAPIで信頼性・コンプライアンス重視。

主な特徴

- プロキシネットワーク、データ配信API

- 地域指定、コンプライアンスサポート

料金

- 有料$99/月〜

おすすめユーザー

- エンタープライズ、コンプライアンス、地域指定抽出

メリット

- 高成功率、サポート、地域オプション

デメリット

- 高額、開発セットアップ必要

ユーザー評価

- G2:★4.6

大規模・法令順守案件におすすめ。

15. Zyte (API機能)

ZyteのAPIは、Scrapy Cloudやスマートプロキシ、自動抽出APIを提供。

主な特徴

- Scrapy Cloudでスパイダー実行

- スマートプロキシ(Crawlera)

- 自動抽出API

料金

- 無料枠あり

- 有料$29/月〜

おすすめユーザー

- 開発者、カスタム抽出プロジェクト

メリット

- 実績豊富、Scrapy連携

デメリット

- コーディング必要、規模拡大でコスト増

ユーザー評価

- G2:★4.3

大規模カスタムクローラー構築に最適()。

Pythonライブラリ:開発者向け最強スクレイピングツール

「自分でコードを書いて細かく制御したい」開発者には、Pythonライブラリが最適。無料・オープンソースで、巨大なコミュニティも魅力。

16. Selenium

Seleniumは、ブラウザ自動化の定番。ChromeやFirefoxを操作し、動的・JS多用サイトも抽出可能。

主な特徴

- ブラウザ自動操作(クリック・スクロール・フォーム入力)

- JS・ログイン・無限スクロール対応

- スクリーンショット・マルチブラウザ

おすすめユーザー

- QAチーム、動的サイト抽出、複雑なユーザーフロー

メリット

- ほぼ全てのサイトに対応

- コミュニティ・チュートリアル豊富

デメリット

- 遅い、リソース消費大

- 大規模処理はセットアップが大変

ユーザー評価

- G2:★4.5(テストツールとして)

リアルなユーザー操作を再現したい場合に最適。

17. BeautifulSoup4

BeautifulSoup4は、HTML/XMLパースの定番Pythonライブラリ。シンプルで柔軟、小〜中規模の抽出に最適。

主な特徴

- HTML/XMLパース用の簡単API

- 崩れたHTMLも柔軟に対応

- requestsやlxmlと連携

おすすめユーザー

- 初心者、簡易パース、データクレンジング

メリット

- シンプル・直感的・堅牢

- 他ライブラリとの連携も容易

デメリット

- JS非対応、クローラー機能なし

ユーザー評価

- G2:★4.4

クイックスクリプトや学習用途に最適。

18. Scrapy

Scrapyは、高性能なPython製クローラー&スクレイピングフレームワーク。

主な特徴

- 非同期クロール(高速・スケーラブル)

- パイプライン・ミドルウェアで拡張自在

- コミュニティ・プラグイン豊富

おすすめユーザー

- カスタムクローラー開発者、大規模案件

メリット

- 高性能・カスタマイズ自在

- 無料・オープンソース

デメリット

- 学習コスト高い

- JSレンダリングはSeleniumやSplash併用必要

ユーザー評価

- GitHub:★55k(最も人気のスクレイパー)

堅牢な大規模パイプライン構築に最適。

19. Puppeteer

Puppeteerは、Node.js(Pythonラッパーもあり)でヘッドレスChromeを制御。動的コンテンツやスクリーンショット取得に強み。

主な特徴

- ヘッドレスChrome自動化

- スクリーンショット・PDF生成

- ネットワークインターセプト

おすすめユーザー

- 動的・JS多用サイト抽出の開発者

メリット

- 最新・強力・柔軟

デメリット

- Node.js中心、リソース消費

ユーザー評価

- GitHub:★85k

高度な抽出や自動化に最適。

20. Playwright

Playwrightは、Microsoft発の最新ブラウザ自動化ライブラリ。複数ブラウザ・多言語対応(Python含む)。

主な特徴

- マルチブラウザ(Chromium, Firefox, WebKit)

- 自動待機・非同期API

- スクリーンショット・ネットワークインターセプト

おすすめユーザー

- 複雑・JS多用サイト抽出の開発者

メリット

- 高速・信頼性・クロスブラウザ

- 最新API・並列処理に強い

デメリット

- コーディング必須、リソース消費

ユーザー評価

- Devコミュニティ:★4.8

最新のブラウザ自動化を求める人におすすめ。

ビジネス用途別おすすめツール早見表

- リード獲得・連絡先抽出:Thunderbit, Browse AI, Bardeen AI, Data Miner

- 価格監視・EC:Thunderbit, Octoparse, Parsehub, ScraperAPI, Bright Data

- 競合調査・市場分析:Thunderbit, Diffbot, Apify, Scrapy

- 不動産リスト:Thunderbit, Octoparse, Webscraper.io

- ワークフロー自動化:Bardeen AI, Apify, Thunderbit(AIオートフィル)

- 大規模・カスタム案件:Scrapy, Selenium, Playwright, API系(ScraperAPI, Zyte, Bright Data)

ワンポイントアドバイス:

まずは無料枠やデモで試してみよう。多くのツールは、実際のワークフローを体験できる無料プランを用意してるよ。

まとめ:2025年のウェブスクレイピングツール

ウェブスクレイピングは、昔は開発者の専門技術だったけど、今やビジネスの必須スキル。2025年には96%の企業が「データが意思決定の中心」と答えていて()、ウェブデータの重要性はどんどん高まってる。AIの進化とリアルタイム分析ニーズの高まりで、市場も急成長中()。

ThunderbitみたいなAIウェブスクレイパーは、エンジニアじゃなくてもボタン一つでデータ抽出できる時代を切り拓いてるけど、ノーコード・API・Python系まで、用途に合わせて最適なツールが必ず見つかる。

進化のスピードはどんどん加速中。新機能や新ツールも続々登場してるから、ぜひ色々試してみて。最適なウェブスクレイピングツールは、単なるデータ取得だけじゃなく、チームの意思決定をもっと速く・賢く・自信を持ってできる力になるよ。

さらに詳しい解説やチュートリアル、レビューはで随時公開中。「もっと賢く、効率的にデータを集めたい」と思ったら、をぜひ試してみて。きっと未来の自分(とコーヒー代)が感謝するはず!

よくある質問(FAQ)

1. 2025年、非エンジニアにおすすめのウェブスクレイピングツールは?

Thunderbit、Browse AI、Bardeen AIなどのAIウェブスクレイパーが最適。コーディング不要で、ビジュアル操作や自動化、ページネーションやサブページ抽出、スプレッドシートへのエクスポートも簡単。

2. 大規模・エンタープライズ向けに最適なツールは?

Diffbot、Bright Data、Oxylabs、Scrapyなどが大規模案件に強い。大量データ抽出や自動化、JS多用サイト・アンチボット対策も対応。

3. ノーコード/ローコードとAIスクレイパーの違いは?

Octoparse、Parsehub、Webscraper.ioなどのノー/ローコード系は、AIスクレイパーよりカスタマイズ性が高い一方、多少の学習が必要。ThunderbitのようなAIスクレイパーは、スピードと手軽さ重視で、機械学習によるフィールド自動選択やサブページ抽出が得意。

4. 開発者向けのおすすめPythonライブラリは?

Scrapy、Selenium、BeautifulSoup4、Puppeteer、Playwrightなどが定番。柔軟性・パフォーマンス・コミュニティサポートも充実。

5. 自社に合ったウェブスクレイピングツールの選び方は?

技術力・データ量・プロジェクトの複雑さで選ぼう。スピード・手軽さ重視ならAI系、中規模ならノーコード、スケールやカスタマイズ重視ならAPIやPython系がおすすめ。まずは無料枠やデモで試すのが一番。

さらに詳しく知りたい人へ: