想像してみて。もしあなたがジャーナリストで、いろんなニュースサイトから話題の記事をチェックして、PRのチャンスを探しているとしたら?あるいはSEO担当として、特定キーワードで上位に出てくるブログやライバルのコンテンツを分析したい時もあるよね。研究者なら、特定テーマのオンラインジャーナルや論文を幅広く集めたいこともあるはず。

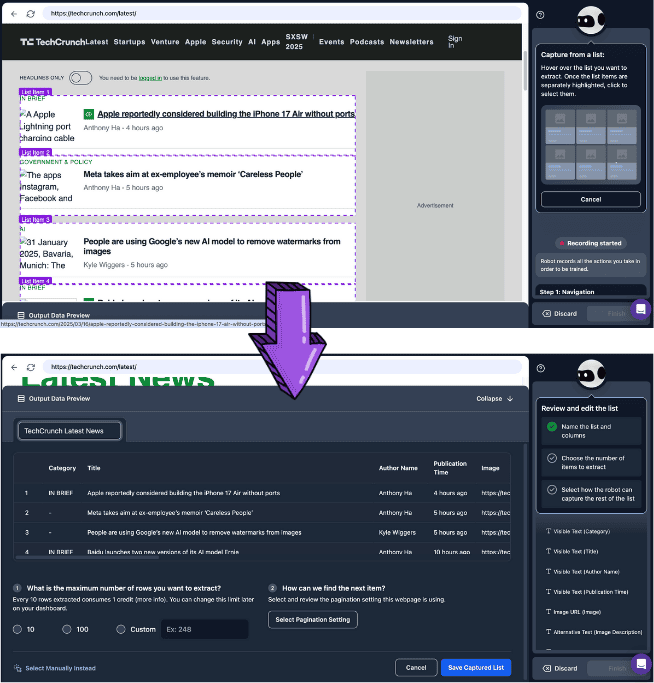

でも、手作業でコピペを繰り返すのは本当に時間がかかるし、正直やってられない。だからを使ってニュース記事やコンテンツを自動で集めたくなるのは当然だよね。ただ、プログラミングが苦手な人にとっては、コードの壁が高く感じることも多い。も人気だけど、複数サイトを扱うと設定が面倒になりがちだし、サイトの構造が変わると今までの設定が全部パーになることも。

じゃあ、もっと手軽で効率的なってないの?その答えが。AIがウェブの構造やコンテンツを自動で解析してくれるから、面倒なを自分で設定する必要なし。ワンクリックで複数サイトに対応できて、データのクレンジングや分析まで一気にこなせるんだ。

どのを選べばいいか迷っている人のために、この記事では主要なツールの特徴やメリット・デメリット、どんなシーンに向いているかを分かりやすくまとめてみたよ。

TL;DR

| メリット | デメリット | おすすめ用途 | |

|---|---|---|---|

| AI記事スクレイパー | - 複数サイトを高精度で一括取得 - ノイズ自動除去 - サイト構造の変化にも柔軟対応 - 動的コンテンツも取得可能 - データクレンジングコストが低い | - 計算コストが高い - 処理時間がやや長い - 一部ページは手動調整が必要な場合あり - アンチスクレイピング対策に引っかかることも | - 複雑・動的なニュースサイトやSNSのスクレイピング - 大規模なデータ収集 |

| 従来型ノーコード記事スクレイパー | - 高速処理 - 低コスト - サーバー・PC負荷が小さい - 細かい制御が可能 | - サイト構造変化で頻繁なメンテナンスが必要 - 複数サイト同時取得不可 - 動的コンテンツ非対応 - データクレンジングコストが高い | - シンプルな静的ページの大量取得 - リソースや予算が限られている場合 |

記事スクレイパーって何?なぜAI記事スクレイパーが注目されてるの?

は、ニュースサイトなどからタイトル・著者・公開日・本文・キーワード・画像・動画などを自動で抜き出して、JSONやCSV、Excelみたいな構造化データにまとめてくれるの一種。

はを使ってページのから情報を抜き出すけど、こんな課題があるんだ:

- 汎用性が低い:サイトごとに違うが必要で、構造が変わるたびに設定を直さないといけない。

- 動的コンテンツに弱い:AJAXやJavaScriptで表示される情報はじゃ取れない。

- データ加工が面倒:取れるのはの一部だけで、クレンジングや整形、意味解析、感情分析は別作業になる。

そこで登場するのが。

そこで登場するのが。

- LLMでページを理解して、

- 賢く情報抽出:タイトル・著者・要約・本文などを自動で見分けてくれる

- ノイズ自動除去:ナビや広告、関連記事など余計なものを排除して必要な情報だけ抜き出す

- 構造変化にも強い:サイトのデザインや構造が変わっても、AIが意味や見た目から情報を抽出

- 複数サイトもOK:従来型と違って、いろんなサイトでも設定不要で使える

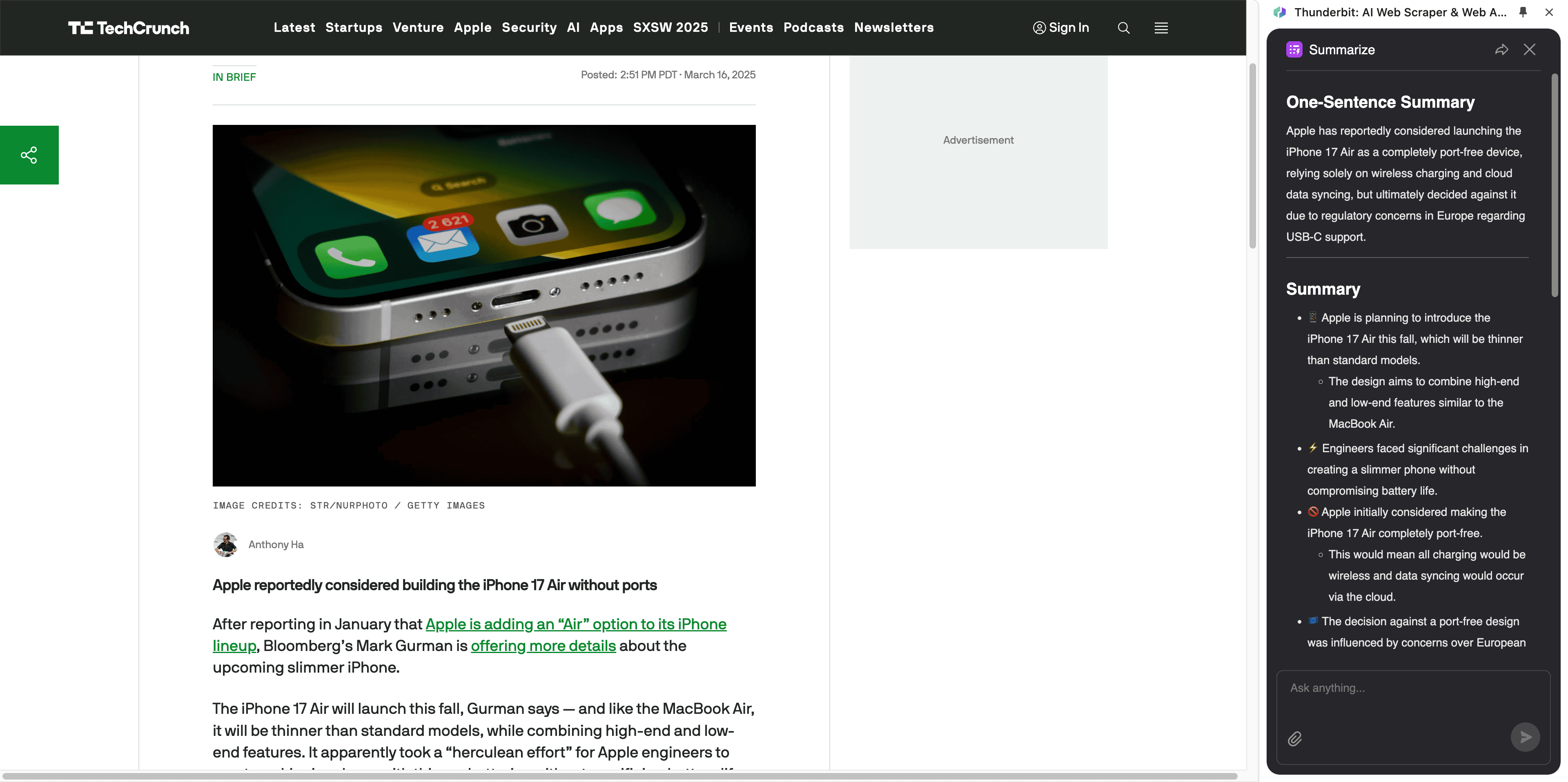

- NLPやディープラーニングと連携して、翻訳・要約・感情分析も自動でできる。

2025年に選ぶべき記事スクレイパーの条件

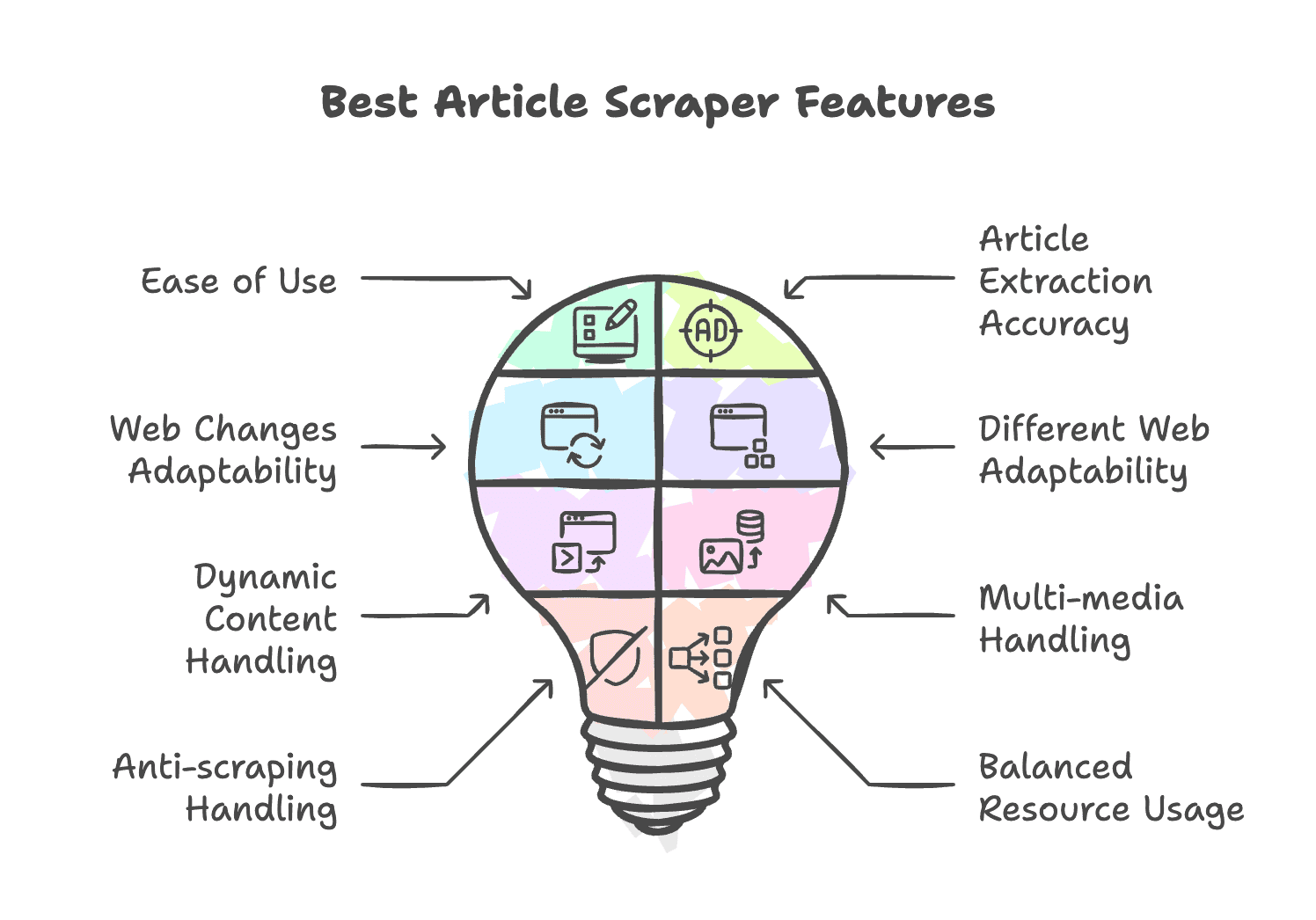

良い記事スクレイパーは、性能・コスト・使いやすさ・柔軟性・拡張性のバランスが大事。2025年におすすめの選び方はこんな感じ:

- 直感的な操作:コーディング不要で誰でも使える

- 記事抽出の精度:広告やナビを除外して、必要な情報だけ正確に取れる

- サイト構造の変化に自動対応:頻繁なメンテナンスがいらない

- いろんなサイトに対応:構造が違うサイトでも使える

- 動的コンテンツもOK:JavaScriptやAJAXで表示される情報も取れる

- マルチメディア対応:画像・動画・音声も認識できる

- アンチスクレイピング対策:IPローテーションやCAPTCHA回避、プロキシ対応

- リソース効率:PCやサーバーへの負荷が少ない

記事・ニューススクレイパー主要ツール早見表

| ツール名 | 主な特徴 | おすすめユーザー | 料金 |

|---|---|---|---|

| Thunderbit | AI搭載スクレイパー; テンプレート多数; PDF・画像・ドキュメント対応; 高度なデータ処理 | 技術知識がなく複数のニッチサイトを取得したい方 | 7日間無料、年額プラン月9ドル~ |

| WebScraper.io | ブラウザ拡張; 動的コンテンツ対応; プロキシ非対応 | 複雑なページや高度な機能が不要な方 | 7日間無料、年額プラン月40ドル~ |

| Browse.ai | ノーコード型スクレイパー&監視; ロボット多数; 仮想ブラウザ; 多彩なページネーション; 強力な連携 | 大規模・複雑サイトのスクレイピングが必要な企業 | 月額19ドル~(年額) |

| Octoparse | CSSセレクタベースのノーコード; 自動検出・ワークフロー生成; テンプレート多数; 仮想ブラウザ; アンチスクレイピング対策 | 複雑なサイトのデータ取得が必要なビジネス | 月額99ドル~(年額) |

| Bardeen | 幅広い自動化機能; テンプレート多数; ノーコード; ワークスペース連携 | 記事取得を既存業務に組み込みたいGTMチーム | 7日間無料、年額プラン月99ドル~ |

| PandaExtract | シンプルなUI; 自動検出・ラベリング | 設定不要でワンクリック抽出したい方 | 49ドル買い切り |

ビジネスユーザー向け最強AI記事スクレイパー

- メリット:

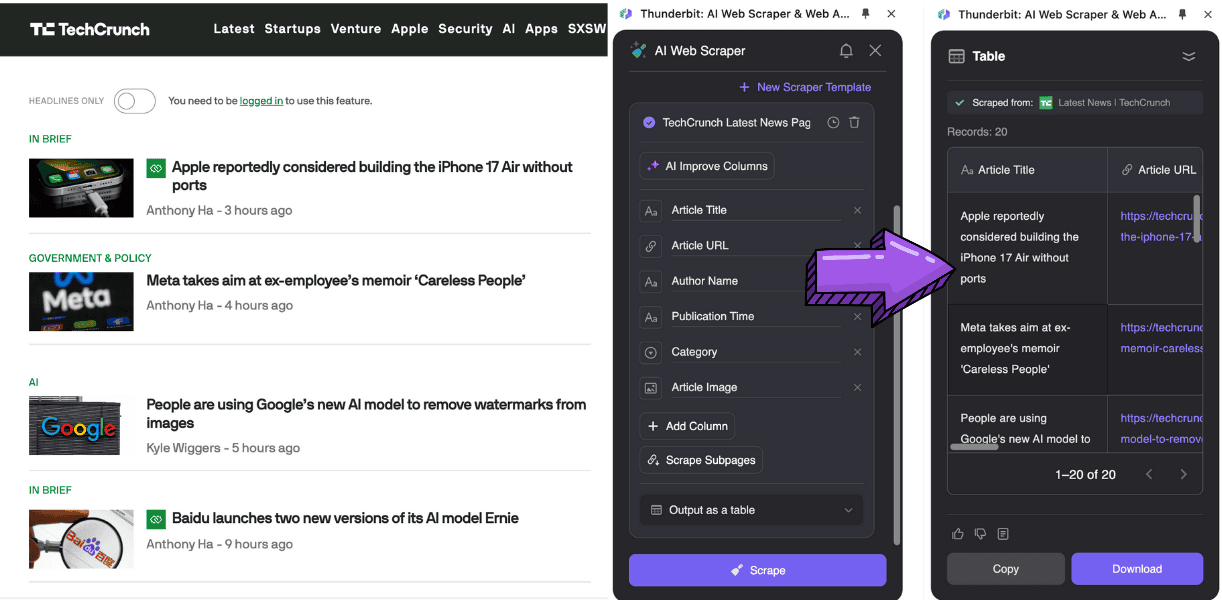

- 自然言語でAIに指示できて、CSSセレクタ不要で情報抽出・分析ができる

- AIによるデータ分析(フォーマット変換、、分類、翻訳、タグ付けなど)

- でワンクリック取得

- デメリット:

- のみ対応

- 大規模データ取得には不向き

- 複数ページの取得はやや遅いが、バックグラウンドで高速化可能

企業向けAI記事スクレイパー

Browse.ai

- メリット:

- ノーコードで記事取得・監視ができる

- 仮想ブラウザでアンチスクレイピング対策を回避

- 、、などのロボット多数

- やなどと連携

- デメリット:

- 詳細抽出には2つのロボット作成が必要で手順が複雑

- ニッチサイトではCSSセレクタの精度が低い

- 価格が高く、大規模・継続的なデータ取得向け

小規模データ取得向けノーコードスクレイパー

PandaExtract

- メリット:

- 記事リストや詳細を自動判別、直感的なUI

- リスト・詳細・メール・画像の抽出に対応、小規模な構造化データ取得に最適

- 一度の購入で永久利用可能

- デメリット:

- ブラウザ拡張のみ、クラウド実行不可

- 無料版はコピーのみ、CSVやJSON出力は不可

組織向けオールインワン記事スクレイパー

Octoparse

- メリット:

- ノーコードで自動検出・ワークフロー生成

- 記事テンプレート多数、すぐに使える

- 仮想ブラウザ+IPローテーション・CAPTCHA回避・プロキシでアンチスクレイピング突破

- デメリット:

- 自動検出はCSSセレクタ依存で精度は平均的

- 高度な機能は学習や技術知識が必要

- 大規模データ取得はコスト高

GTMチーム向け最強自動化ツール

Bardeen

- メリット:

- LLM活用のノーコード記事スクレイパーでワンクリック自動化

- 、、など100以上のアプリと連携

- データ取得後のAI分析も自動化

- 既存業務フローへの組み込みに最適

- デメリット:

- プレイブック依存が強く、カスタムフローは試行錯誤が必要

- ノーコードでも複雑な自動化は学習コストがかかる

- サブページ抽出の設定が複雑

- 価格が非常に高い

即時データ取得に最適な軽量記事スクレイパー

Webscraper.io

- メリット:

- ノーコードで直感的なポイント&クリック操作

- 動的コンテンツ対応

- クラウド実行可能

- 、、と連携

- デメリット:

- テンプレートがなく、サイトマップ作成が必要

- CSSセレクタ未経験者には学習コストが高い

- ページネーションやサブページ抽出の設定が複雑

- クラウド版は高額

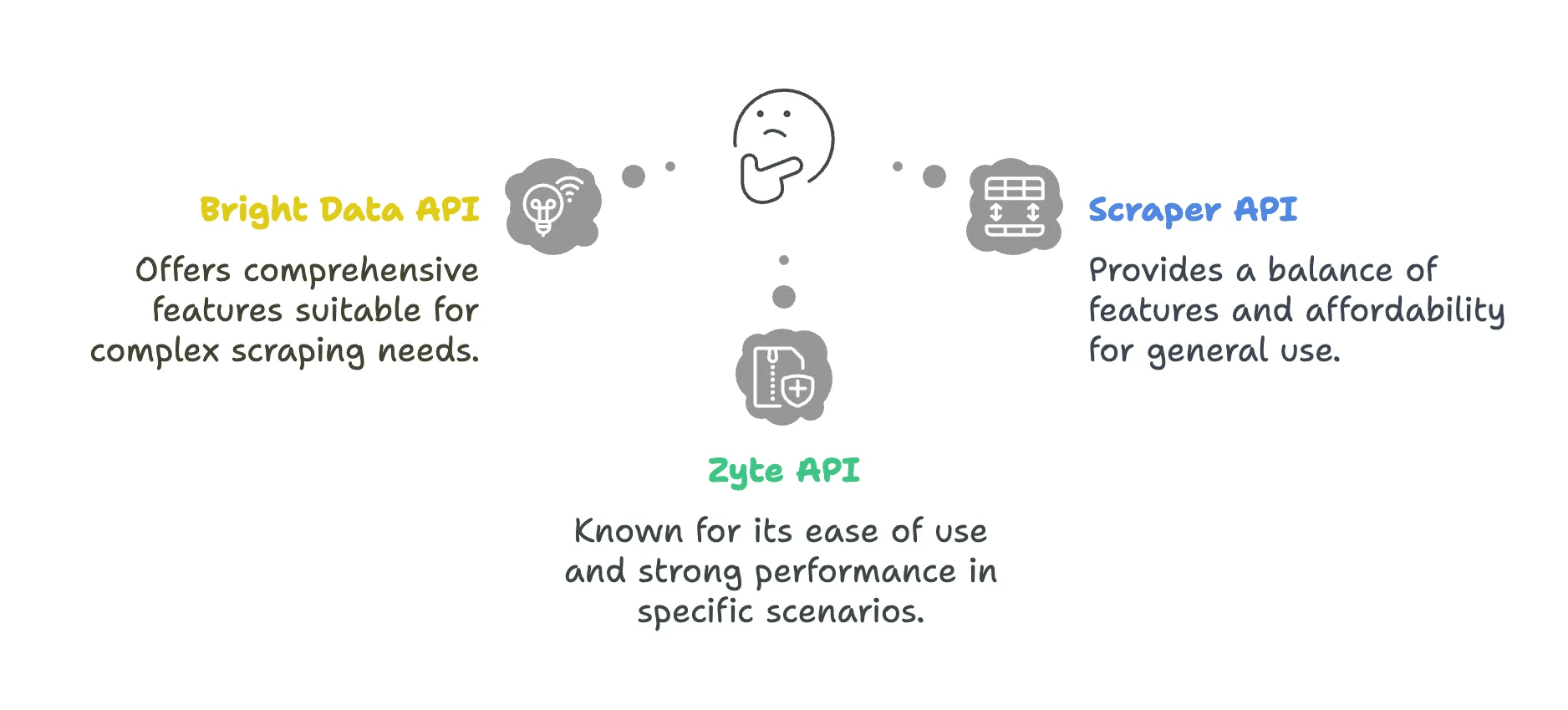

エンジニア向けの高度なAPIソリューション

エンジニアならも選択肢。これらは:

- 柔軟性:APIでカスタム取得、動的レンダリングやIPローテーション対応

- 拡張性:独自のデータパイプラインに組み込めて、大規模・高頻度な取得に最適

- 低メンテナンス:プロキシやアンチスクレイピング対策の運用不要

API主要サービス早見表

| API | メリット | デメリット |

|---|---|---|

| Bright Data API | - 世界195カ国・7200万IPの巨大プロキシ網 - 都市/郵便番号単位のジオターゲティング - 強力なIPローテーション | - レスポンスが遅め(平均22秒) - 小規模チームには高額 - 設定がやや難しい |

| ScraperAPI | - 月49ドルから利用可能 - 自動データ抽出のAutoparse機能 - Web UIでテスト可能 | - ブロックされたリクエストも課金対象 - JavaScriptレンダリング機能が限定的 - 高度なパラメータ利用でコスト増 |

| Zyte API | - AIによる自動データ解析 - 失敗リクエストは課金対象外 | - 月額約450ドル~と高額 - クレジットの繰越不可 |

- Bright Data Web Scraper API

- メリット:

- 195カ国・7200万IPで自動IPローテーション&ジオロケーション、アンチスクレイピングが厳しいやにも対応

- JavaScript動的コンテンツやページスナップショット取得も可能

- デメリット:

- リクエスト・帯域ごとの従量課金で小規模案件には割高

- メリット:

- Scraper API

- メリット:

- 世界4000万プロキシ、データセンター/住宅IP自動切替、Cloudflare回避、連携

- 構造化エンドポイントや非同期スクレイパーで高速取得

- デメリット:

- 動的ページレンダリングは追加料金、複雑なAJAXサイトは対応が限定的

- メリット:

- Zyte API

- メリット:

- AIによる自動データ抽出、サイトごとのルール開発・保守不要

- 柔軟な従量課金制

- デメリット:

- 高度な機能(セッション管理やスクリプトブラウザ)は学習が必要

- メリット:

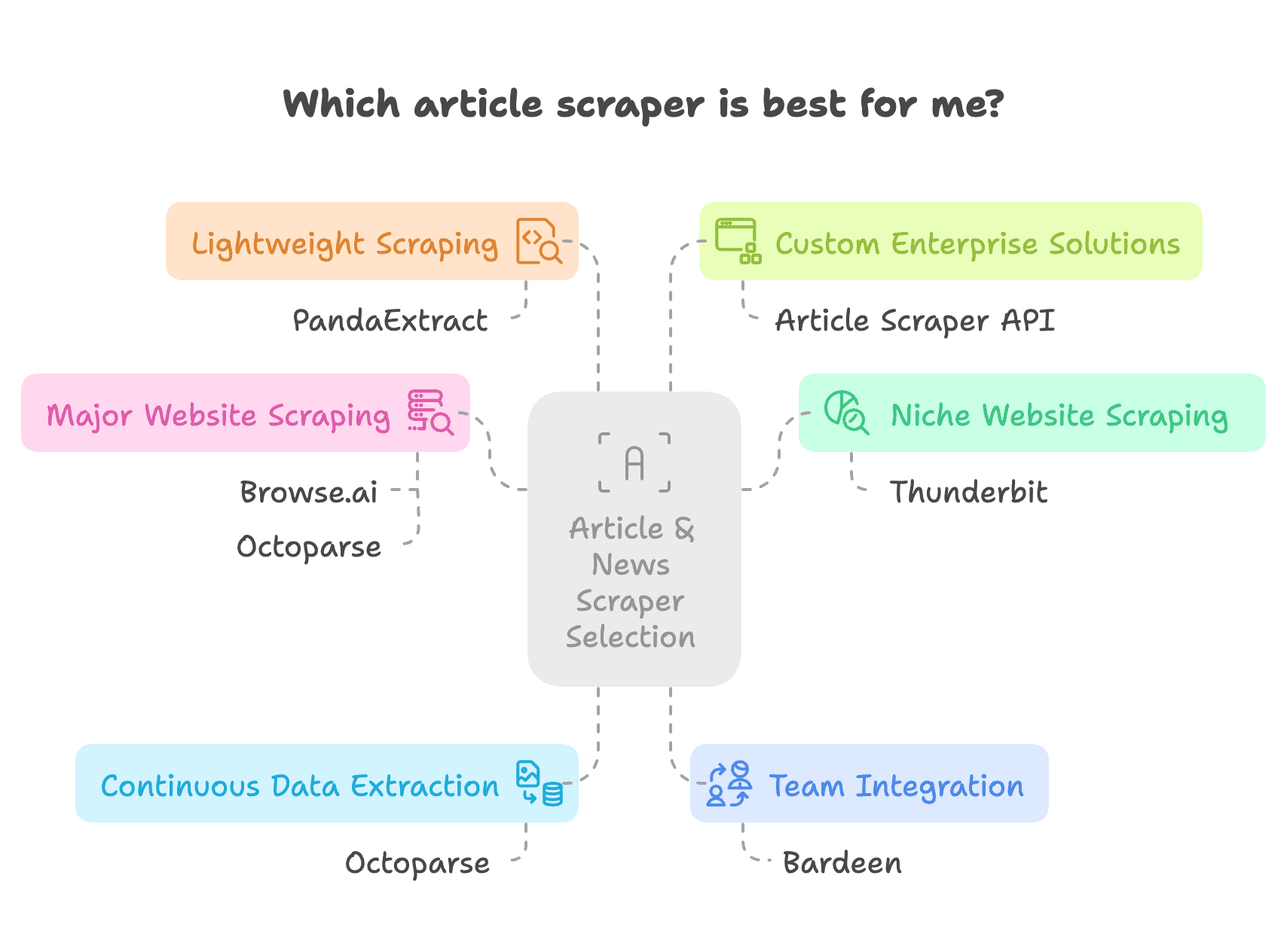

記事・ニューススクレイパーの選び方

選ぶときは、業務ニーズ・技術力・予算をしっかり考えよう。

- 複数のニッチサイトを個別に設定せずに取得したい&予算に余裕があるなら、がベスト。AIがウェブ構造を解析して、取得後のAI分析もできる。Thunderbit AIならどのサイトも同じ感覚で取得できるよ。

- やなど大手サイトのニュース・記事取得には、アンチスクレイピング対策やテンプレートが充実したBrowse.aiやOctoparseが有力。ただ、一番手軽なのはのChrome拡張。個人のブラウジングやコピペ感覚で、ログイン情報も簡単に扱える。

- 大規模・定期的なデータ取得には、スケジューリング機能のあるOctoparseなどが便利。

- チーム利用や既存業務への組み込みなら、Bardeenが最適。記事取得以外の自動化も幅広く対応。

- 学習コストをかけずに小規模データを手軽に取得したいなら、PandaExtractのようなポイント&クリック型が便利。

- 技術者やエンタープライズ用途なら、APIツールや自作スクレイパーも検討しよう。

まとめ

この記事では、記事・ニューススクレイパーの概要と活用シーンを紹介したよ。はを使うから、やの知識が必要で、特に高度な操作はハードルが高い。一方、はAIの意味理解や画像認識を活用して、サイト構造の変化や横断的な利用、動的コンテンツ、データクレンジング・分析まで圧倒的に柔軟。

また、主要な記事・ニューススクレイパーやAPIツール6選を比較して、それぞれの強み・弱み、どんなデータ規模やサイト特性に向いているか、ターゲットユーザーも整理した。記事・ニュース取得を考えるときは、業務ニーズに合った最適なツールを選んで、性能とコストのバランスを意識しよう。

よくある質問

1. AI記事スクレイパーって何?どうやって動くの?

- AIがウェブページを解析して、CSSセレクタ不要でコンテンツを自動抽出してくれる。

- タイトル・著者・公開日・本文などを高精度で見分ける。

- 広告やナビゲーションなど余計な要素を自動で除去。

- サイト構造の変化や違うサイトにも柔軟に対応。

2. AI搭載記事スクレイパーのメリットは?

- 1つのツールで複数サイトから一括取得できる

- JavaScriptやAJAXで表示される動的コンテンツも取れる

- CSSベースより設定・メンテが圧倒的に少ない

- 要約・翻訳・感情分析など追加機能も充実

3. Thunderbitはプログラミング不要で使える?

- もちろん、Thunderbitはノーコード設計で非技術者でも簡単に使えるよ。

- AIが自動で記事コンテンツを検出・抽出してくれる。

- テンプレートも豊富で、すぐにスクレイピング可能。

- CSV・JSON・Google Sheetsなどいろんな形式でデータ出力できる。

もっと詳しく知りたい人は: