競合サイトを何百件もチェックしたいのに、手作業でコピペしていたら一日が終わってしまう…そんな経験、みんな一度はあるんじゃないかな?今やウェブ上のデータはビジネスの金脈。営業やマーケ、リサーチ、オペレーションなど、あらゆる現場で活用されているよ。実際、ウェブスクレイピングはを占めていて、**アメリカの小売業者の81%**が価格調査に自動スクレイパーを導入しているんだ()。つまり、毎日大量のボットが裏でデータ収集を支えているってわけ。

じゃあ、こうしたボットはどうやって動いているの?そして、なぜ多くのチームがNode.js(今のウェブの基盤になっているJavaScriptランタイム)で自分たちのウェブクローラーを作っているの?SaaSや自動化の現場で長年やってきて、のCEOとしても、正しいツールがウェブデータの悩みを一気に競争力に変える瞬間を何度も見てきたよ。ここでは、node ウェブクローラーの基本や仕組み、プログラミング未経験でも使える方法まで、分かりやすく紹介するね。

Nodeウェブクローラーの基本を押さえよう

まずはシンプルに説明するね。Nodeウェブクローラーは、Node.jsで作られたプログラムで、ウェブページを自動で巡回しながらリンクをたどって情報を集めてくれる。まるで休まず働くデジタルインターンみたいに、指定したURLからスタートして、次々とページを回って必要なデータを集めてくれるんだ。

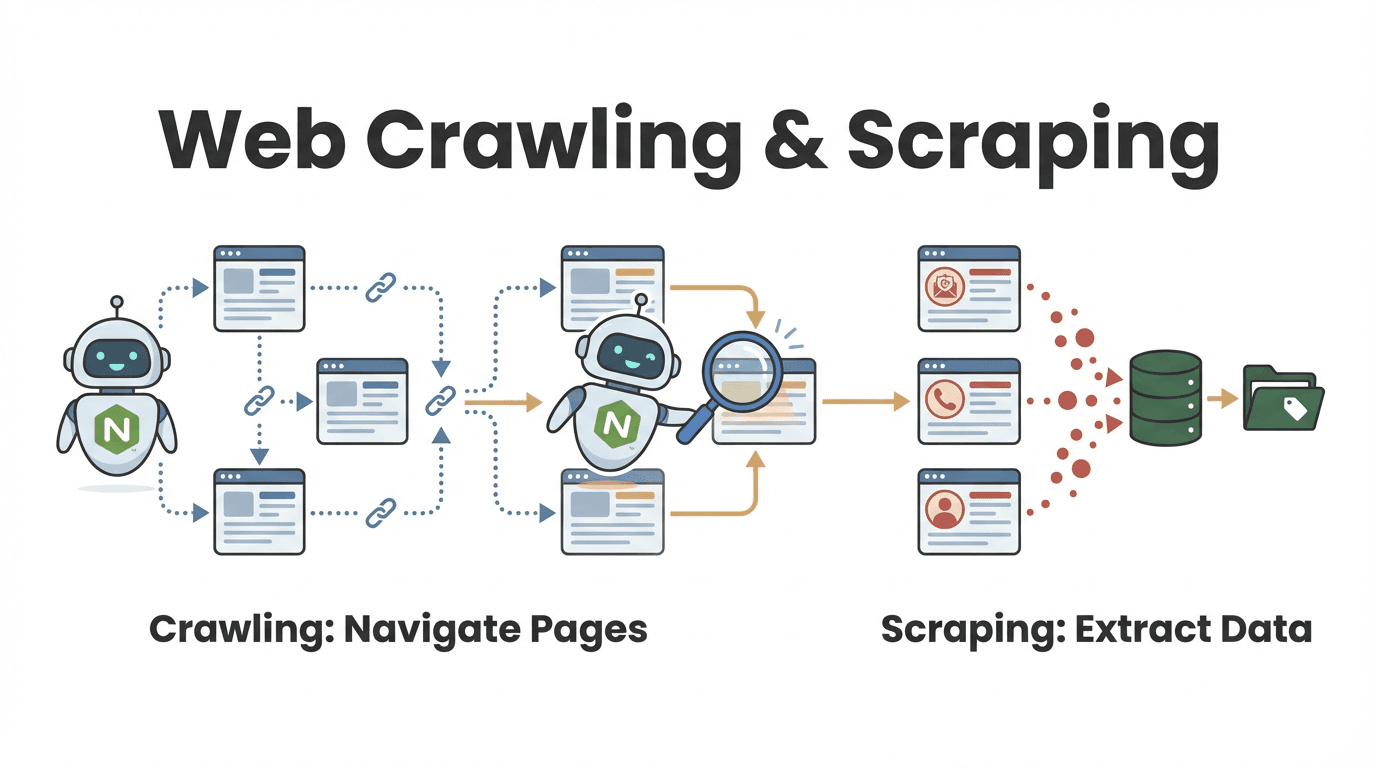

よくある質問が「ウェブクローリングとウェブスクレイピングって何が違うの?」ってやつ。

- ウェブクローリングは、たくさんのページを見つけて回ること。図書館の本を片っ端からめくって、関連する本を探すイメージ。

- ウェブスクレイピングは、特定の情報を抜き出すこと。見つけた本から大事な引用だけを抜き出す感じ。

実際には、多くのNodeウェブクローラーがこの両方をやってる。たとえば営業チームなら、ディレクトリサイトをクローリングして全企業ページを見つけて、そこから連絡先情報をスクレイピングする、みたいな使い方が定番だよ()。

Nodeウェブクローラーの動き方

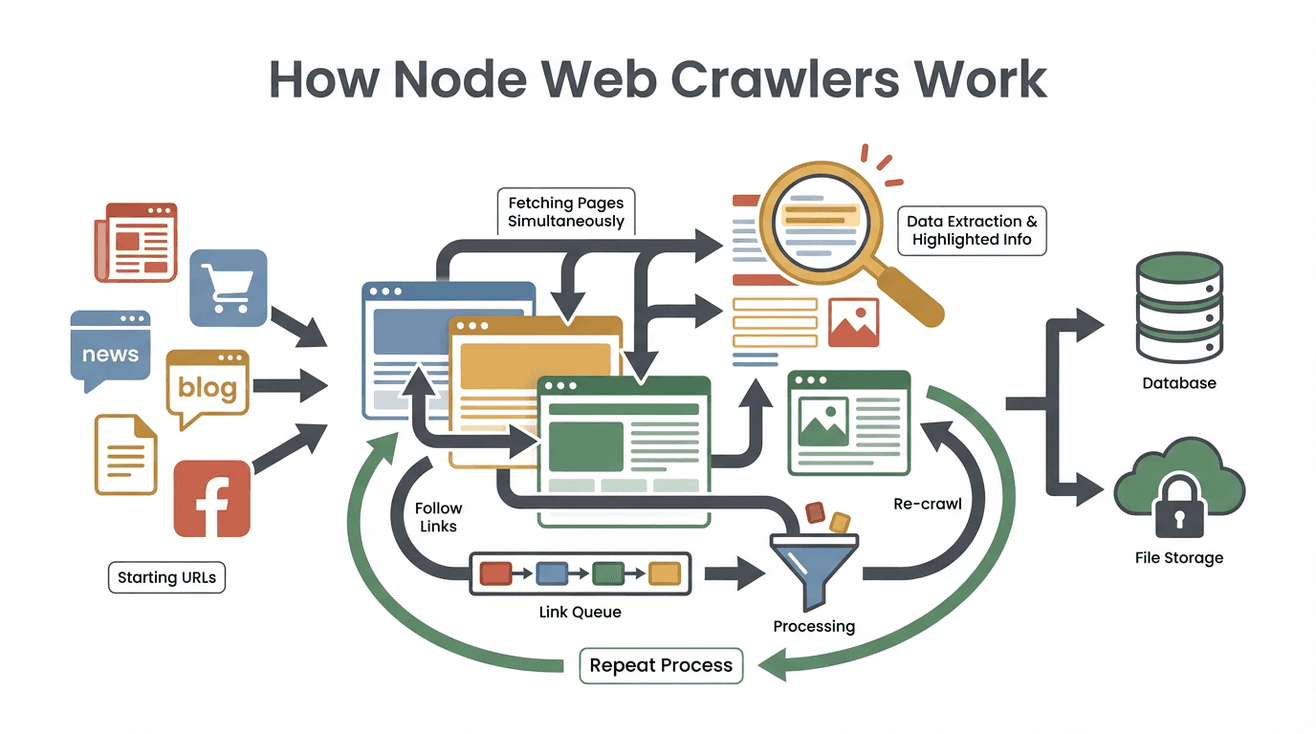

Nodeウェブクローラーはどんな流れで動くのか、ざっくりまとめてみたよ。

Nodeウェブクローラーはどんな流れで動くのか、ざっくりまとめてみたよ。

- シードURLの指定:最初に巡回を始めるURL(例:トップページや商品一覧)を決める。

- ページ内容の取得:クローラーが各ページのHTMLをダウンロード。見た目は表示せず、データだけをゲット。

- 必要なデータの抽出:Cheerioみたいなツール(Node版jQueryみたいなやつ)で、名前や価格、メールアドレスなど欲しい情報を抜き出す。

- 新しいリンクの発見とキューイング:ページ内のリンク(「次へ」や詳細ページなど)を探して、巡回リスト(クロールフロンティア)に追加。

- 繰り返し処理:新しいリンクを順番に回って、データ抽出とリンク探索を繰り返す。

- 結果の保存:集めたデータはCSVやJSON、またはデータベースに保存。

- 終了条件でストップ:新しいリンクがなくなるか、設定した上限に達したら終了。

たとえば求人サイトから全求人情報を集めたい場合、一覧ページから各求人のリンクを抜き出して、詳細ページを回って情報を取得、「次へ」をたどって全件収集…みたいな流れになるよ。

この裏で活躍してるのがNode.jsのイベント駆動・ノンブロッキングな仕組み。複数ページを同時に処理できるから、遅いサイトを待たずに効率よくデータ収集できる。まるで何人ものインターンが同時に作業してるみたいな感じ!

Node.jsがウェブクローラーで選ばれる理由

じゃあ、なんでNode.jsがウェブクローラー開発で人気なの?PythonやJavaじゃなくてNode.jsが選ばれる理由をまとめてみたよ。

- イベント駆動・ノンブロッキングI/O:Node.jsはたくさんのページリクエストを同時に処理できて、待ち時間が少ない()。

- 高パフォーマンス:GoogleのV8エンジン(Chromeと同じ)で動くから、大量データの解析や処理が速い。

- ライブラリが豊富:HTML解析のCheerio、HTTPリクエストのGot、ヘッドレスブラウジングのPuppeteer、大規模クロール管理のCrawleeなど、用途別のライブラリが充実()。

- JavaScriptとの相性抜群:多くのウェブサイトがJavaScriptで動いてるから、Node.jsなら自然に連携できる。JSONデータの扱いも得意。

- リアルタイム対応:価格変動や速報ニュースの監視など、リアルタイム性が求められる用途にも強い。

こうした理由から、CrawleeやCheerioなどNodeベースのツールはに使われているよ。

Nodeウェブクローラーの主な機能とビジネス活用例

Nodeウェブクローラーは、ウェブデータ収集の万能ツール。主な機能と、それがどんなビジネス課題に役立つかをまとめてみたよ。

| 機能・役割 | Nodeクローラーでの動作 | ビジネス活用例 |

|---|---|---|

| 自動ナビゲーション | リンクやページ送りを自動でたどる | リード獲得:オンラインディレクトリ全ページを巡回 |

| データ抽出 | セレクタやパターンで特定項目(名前、価格、連絡先など)を取得 | 価格調査:競合サイトの商品価格を抽出 |

| 複数ページ同時処理 | 非同期処理で多数のページを並行取得 | リアルタイム更新:複数ニュースサイトを同時監視 |

| 構造化データ出力 | CSVやJSON、データベースに保存 | 分析:BIダッシュボードやCRMへのデータ連携 |

| カスタムロジック・フィルタ | コードで独自ルールやデータ整形処理を追加 | 品質管理:古いページを除外、データ形式を変換 |

たとえばマーケティングチームなら、業界ブログから全記事のタイトルとURLを集めて、Googleスプレッドシートにまとめてコンテンツ企画に活かせるよ。

Thunderbit:Nodeウェブクローラーのノーコードな選択肢

ここからは、プログラミング不要で使える便利な選択肢を紹介するね。は、AIを活用したChrome拡張型のAIウェブスクレイパー。専門知識がなくても、誰でも簡単にウェブデータを抽出できるよ。

使い方は超シンプル。拡張機能を開いて「AIで項目を提案」をクリックすれば、ThunderbitのAIがページを解析して、抽出すべきデータを自動でテーブル化してくれる。たとえば「商品名と価格を全部取得したい」と日本語で指示するだけで、AIが最適な方法を考えてくれる。サブページの巡回やページ送りもワンクリックでOK。

Thunderbitの主な特徴はこんな感じ:

- 自然言語インターフェース:やりたいことを日本語で伝えるだけで、AIが技術的な部分を自動で処理。

- AIによる項目提案:ページを解析して、最適なカラムを自動で提案。

- ノーコードでサブページ巡回:詳細ページ(商品やプロフィールなど)も自動で巡回・統合。

- 構造化エクスポート:Excel、Googleスプレッドシート、Airtable、Notionなどにすぐエクスポート。

- 無料データエクスポート:抽出結果のダウンロードに追加料金なし。

- 自動化・スケジューリング:自然言語で「毎週月曜9時に」など定期実行も設定できる。

- 連絡先抽出:メール・電話番号・画像もワンクリックで無料抽出。

「このデータが欲しい」と思ったら、数分でスプレッドシート化できるのがThunderbitの魅力。実際、でも、非エンジニアの人がリードリスト作成や価格監視、リサーチに活用している事例がたくさんあるよ。

NodeウェブクローラーとThunderbitの比較(ビジネスユーザー向け)

どっちを選ぶか迷ったら、下の比較表を参考にしてみて。

| 比較項目 | Node.jsウェブクローラー(カスタム開発) | Thunderbit(ノーコードAIスクレイパー) |

|---|---|---|

| セットアップ時間 | 数時間〜数日(コーディング・デバッグ・環境構築) | 数分(インストールしてクリックするだけ) |

| 技術スキル | プログラミング(Node.js、HTML、セレクタ)が必要 | コーディング不要。日本語指示やクリック操作でOK |

| カスタマイズ性 | どんなロジックやワークフローも柔軟に対応 | 内蔵機能とAIの範囲内で対応 |

| スケーラビリティ | 大規模対応可能(サーバーやプロキシの構築が必要) | クラウドスクレイピングで中〜大規模まで対応 |

| メンテナンス | サイト変更時のコード修正やエラー対応が必要 | 最小限(ThunderbitのAIが自動適応) |

| アンチボット対策 | プロキシ・遅延・ヘッドレスブラウザ等の実装が必要 | Thunderbitのバックエンドで自動対応 |

| 外部連携 | APIやDB、ワークフローなど深い連携が可能 | Sheets、Notion、Airtable、Excel、CSVにエクスポート |

| コスト | ツール自体は無料だが、開発・サーバー運用コスト | 無料枠あり。従量課金またはサブスクリプション |

Node.jsが向いているケース:

- 独自ロジックや高度な連携が必要なとき

- 開発リソースがあって細かく制御したいとき

- 大規模なデータ収集や自社サービス開発をしたいとき

Thunderbitが向いているケース:

- すぐに結果が欲しい、セットアップを簡単に済ませたいとき

- プログラミング経験がない、または不要にしたいとき

- 日常業務でいろんなサイトからデータを取得したいとき

- 使いやすさやAIの柔軟性を重視したいとき

多くのチームは、まずThunderbitでスピーディに成果を出して、必要に応じてNodeクローラーのカスタム開発に移行する流れを取っているよ。

Nodeウェブクローラー利用時の主な課題と対策

Nodeウェブクローラーは強力だけど、注意点もある。よくある課題とその対策をまとめてみた。

- アンチスクレイピング対策:CAPTCHAやIPブロック、ボット検知など。プロキシのローテーションやヘッダーのランダム化、Puppeteerなどのヘッドレスブラウザ利用が必要()。

- 動的コンテンツ:JavaScriptでデータが後から読み込まれるサイトや無限スクロール対応。単純なHTML解析だけじゃ足りない場合、実際のブラウジングを再現したりAPIを使う必要あり。

- パース・データ整形:ウェブページの構造がバラバラな場合、欠損データや文字化けなどの処理が必要。

- メンテナンス:サイト構造の変更でコードが動かなくなることも。定期的な更新やエラー処理が必須。

- 法的・倫理的配慮:robots.txtや利用規約、個人情報保護法などを守ること。著作権や機密データの取得はNG。

ベストプラクティス:

- Crawleeなどのフレームワークを活用して、標準で多くの課題に対応

- リトライや遅延、エラーログの実装

- 定期的なクローラーの見直し・更新

- サイトに負荷をかけず、ルールを守ってスクレイピング

Nodeウェブクローラーとクラウドサービスの連携

本格的なデータ収集プロジェクトでは、ローカルPCだけじゃなくクラウド連携が欠かせない。

- サーバーレス関数:NodeクローラーをAWS LambdaやGoogle Cloud Functionsとしてデプロイして、定期実行やS3・BigQueryなどクラウドストレージに自動保存()。

- コンテナ化クローラー:Dockerでパッケージ化して、AWS FargateやGoogle Cloud Run、Kubernetesで大規模並列処理。

- 自動化ワークフロー:AWS EventBridgeなどのスケジューラーで定期実行、クラウド保存、BIや機械学習へのデータ連携も可能。

これでスケーラビリティや信頼性、完全自動化が実現できる。実際、されていて、今後も増えていくよ。

Nodeウェブクローラーとノーコードツール、どっちを選ぶ?

迷ったときの判断ポイントをまとめてみた:

-

独自のカスタマイズや社内システム連携が必要?

→ Node.jsウェブクローラー -

コーディング不要で素早くデータが欲しい?

→ Thunderbit(または他のノーコードツール) -

単発または頻度の低い作業?

→ Thunderbit -

大規模・継続的なミッションクリティカル用途?

→ Node.js(+クラウド連携) -

開発リソースやメンテナンスの余裕がある?

→ Node.js -

非エンジニアのチームメンバーにも使わせたい?

→ Thunderbit

おすすめは、まずノーコードツールでサクッと成果を出して、必要に応じてNodeクローラーの開発にステップアップする方法。多くのチームがThunderbitで9割の業務をカバーして、時間と手間を大幅に減らしているよ。

まとめ:ウェブデータ活用でビジネスを加速

ウェブデータの抽出は、もはや一部の技術者だけのものじゃない。Nodeウェブクローラーを自作する場合も、AI搭載のみたいなツールを使う場合も、目的は「ウェブの膨大な情報を、使える形で手に入れる」こと。

ウェブデータの抽出は、もはや一部の技術者だけのものじゃない。Nodeウェブクローラーを自作する場合も、AI搭載のみたいなツールを使う場合も、目的は「ウェブの膨大な情報を、使える形で手に入れる」こと。

Node.jsなら複雑・大規模なプロジェクトにも柔軟に対応できるけど、多くのビジネスユーザーにとっては、ノーコード&AIツールの登場で、誰でも手軽に・確実にデータを取得できる時代になった。

する今、ウェブデータを使いこなすチームが競争をリードするよ。開発者も、マーケターも、コピペ作業に疲れた人も、今こそウェブクローリングの力を体感してみて。

まずはを無料でダウンロードして、ウェブデータ抽出の手軽さを実感してみよう。さらに詳しく知りたい人は、で最新ガイドや活用事例もチェックしてみてね。

よくある質問(FAQ)

1. Nodeウェブクローラーとウェブスクレイパーの違いは?

Nodeウェブクローラーは自動でウェブページを巡回(クローリング)し、ウェブスクレイパーはそのページから特定のデータを抽出するよ。多くのNodeクローラーは両方の機能を持っている。

2. なぜNode.jsがウェブクローラー開発で人気なの?

Node.jsはイベント駆動・ノンブロッキングで、たくさんのページを同時に処理できる。高速で、ライブラリも豊富、リアルタイムや大規模データ収集にもぴったり。

3. Nodeウェブクローラーの主な課題は?

アンチボット対策(CAPTCHAやIPブロック)、動的コンテンツ対応、データ整形、サイト変更時のメンテナンスなど。フレームワークやベストプラクティスの活用が大事だけど、技術的な知識が必要。

4. ThunderbitはNodeウェブクローラーとどう違う?

Thunderbitはノーコード・AI搭載のウェブスクレイパー。Chrome拡張と自然言語でデータ抽出ができて、プログラミング不要。ビジネスユーザーに最適。

5. NodeウェブクローラーとThunderbit、どちらを使うべき?

高度なカスタマイズや大規模・連携重視ならNode.js。日常的なデータ収集や非エンジニアの活用ならThunderbitがおすすめ。

ウェブデータ活用をレベルアップしたい人は、をぜひ試してみて。さらに詳しく知りたい人はもチェックしてね。ハッピークローリング!

さらに詳しく