もし도 많은 웹페이지를 앞에 두고 “이 데이터, 한 번에 스프레드시트로 정리할 수 있으면 얼마나 좋을까…”라고 생각해본 적 있다면, 너만 그런 게 아니야. 요즘 비즈니스 현장에서는 웹 데이터 활용이 점점 더 중요해지고 있어. 경쟁사 가격 조사, 리드 리스트 만들기, 부동산 트렌드 파악 등, 기업들은 인터넷을 비즈니스 무기로 삼으려고 치열하게 움직이고 있지. 그 중심에 있는 게 바로 python 웹 스크래퍼야. 자동으로 데이터 수집을 하고 싶은 사람들에게는 진짜 비장의 무기지.

하지만 python 웹 스크래퍼는 개발자들 사이에선 익숙하지만, 많은 비즈니스 유저들에겐 “뭔가 복잡한 프로그램”처럼 느껴질 때가 많아. 나도 에서 “웹 데이터 추출을 더 쉽게”라는 미션으로 일하면서 그걸 실감하고 있어. 그럼 python 웹 스크래퍼가 대체 뭔지, 왜 웹 데이터 추출의 표준 툴이 됐는지, 그리고 AI의 발전 덕분에 프로그래밍을 몰라도 쓸 수 있는 시대가 온 이유는 뭔지, 하나씩 풀어볼게.

Python 웹 스크래퍼란? 비즈니스 유저가 꼭 알아야 하는 이유

먼저 기본부터 짚고 가자. python 웹 스크래퍼(줄여서 “스크래퍼”라고도 해)는 python으로 만든 웹 데이터 자동 수집 프로그램이야. 마치 엄청 똑똑한 디지털 어시스턴트를 고용한 것처럼, 지정한 웹사이트를 돌아다니면서 필요한 정보(이름, 가격, 이메일 등)를 읽어오고, 스프레드시트처럼 정리된 형태로 저장해줘.

왜 비즈니스 유저에게 중요할까? 손으로 데이터 모으는 건 시간도 엄청 걸리고, 실수도 많지. python 웹 스크래퍼를 쓰면 수백, 수천 페이지의 데이터도 짧은 시간에 정확하게 모을 수 있어. 어떤 가이드에서는 “웹 스크래퍼는 웹사이트에서 정보를 자동으로 추출해 구조화된 데이터(스프레드시트 등)로 바꿔준다”고 설명하지. 이제 복붙 지옥에서 벗어날 수 있어().

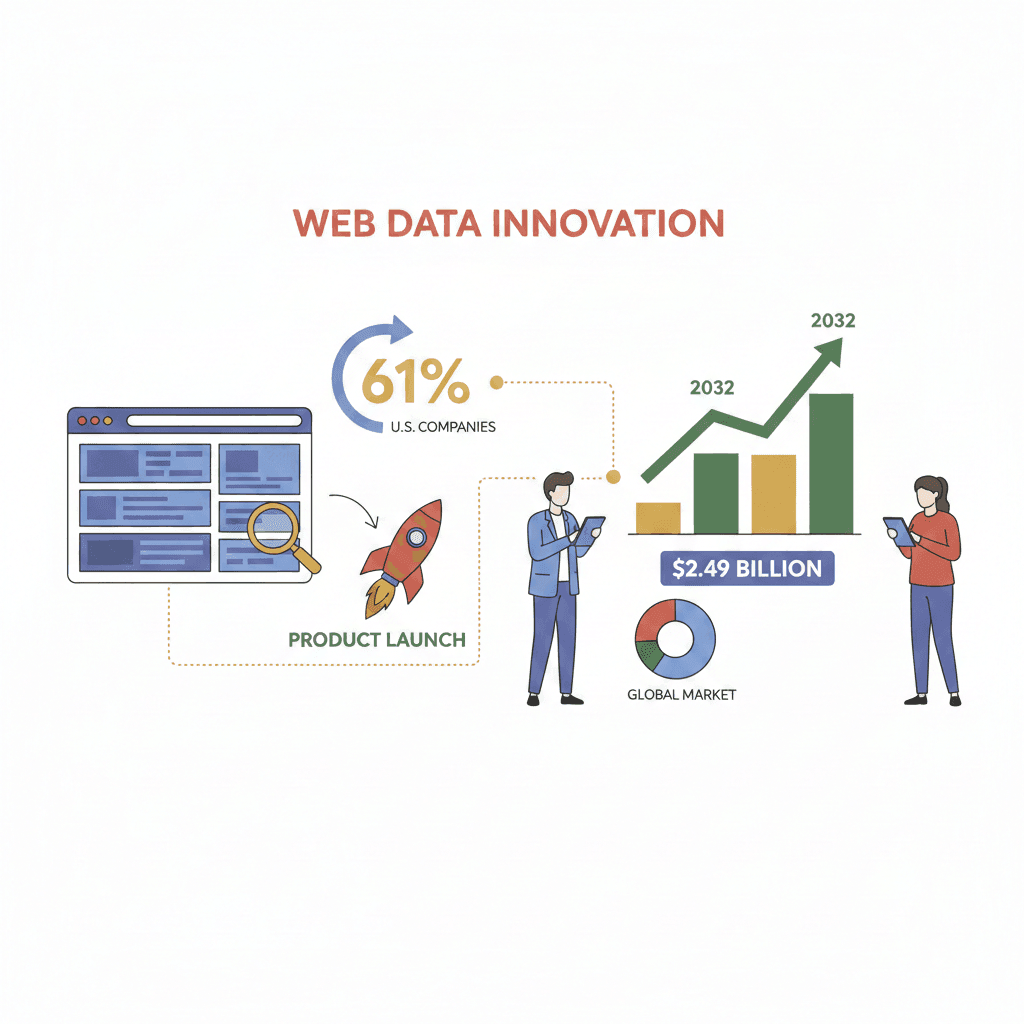

이런 수요는 해마다 커지고 있어. 미국 기업의 가 신제품이나 신기능 개발에 외부 웹 데이터를 활용하고 있고, 웹 스크래핑 소프트웨어 시장은 까지 성장할 거라고 해. 데이터 활용을 시작하지 않으면 경쟁사에 뒤처질 수도 있다는 얘기지.

Python 웹 스크래퍼의 주요 기능

그럼 python 웹 스크래퍼로 뭘 할 수 있을까? 대표적인 특징을 정리해보면:

- 다양한 데이터 추출: 상품 리스트, 이메일, 전화번호, 이미지, 숨겨진 메타데이터까지, 웹페이지에 있는 거의 모든 정보를 가져올 수 있어. 리드 확보용 연락처 수집, 상품 스펙·가격·리뷰 추출도 손쉽게 가능.

- 대량·반복 작업 자동화: 수백, 수천 페이지도 똑같은 방식으로 자동 처리. 페이지 넘김이나 무한 스크롤도 문제없고, 지치지 않고 계속 작업해.

- 링크 따라가며 서브페이지까지 수집: 리스트 페이지에서 각 상품 상세 페이지까지 돌아다니며, 더 자세한 데이터도 한 번에 모을 수 있어.

- 페이지 분할·동적 콘텐츠 대응: JavaScript로 표시되는 데이터나 여러 페이지로 나뉜 정보도, 적절한 라이브러리만 쓰면 사람처럼 조작해서 가져올 수 있어.

- 비즈니스용 포맷으로 내보내기: 모은 데이터는 CSV, Excel, JSON, 데이터베이스 등으로 바로 내보낼 수 있어서, 분석·리포트·CRM 연동에 바로 활용 가능.

, Scrapy, Selenium 같은 python 라이브러리가 이런 걸 가능하게 해주지만, 어느 정도 기술 지식은 필요해.

왜 python 웹 스크래퍼가 데이터 수집의 끝판왕인가

손으로 데이터 모으는 것과 python 웹 스크래퍼를 쓰는 건, 숟가락으로 터널 파는 것과 전동 드릴 쓰는 것만큼 차이가 커. 그 이유는:

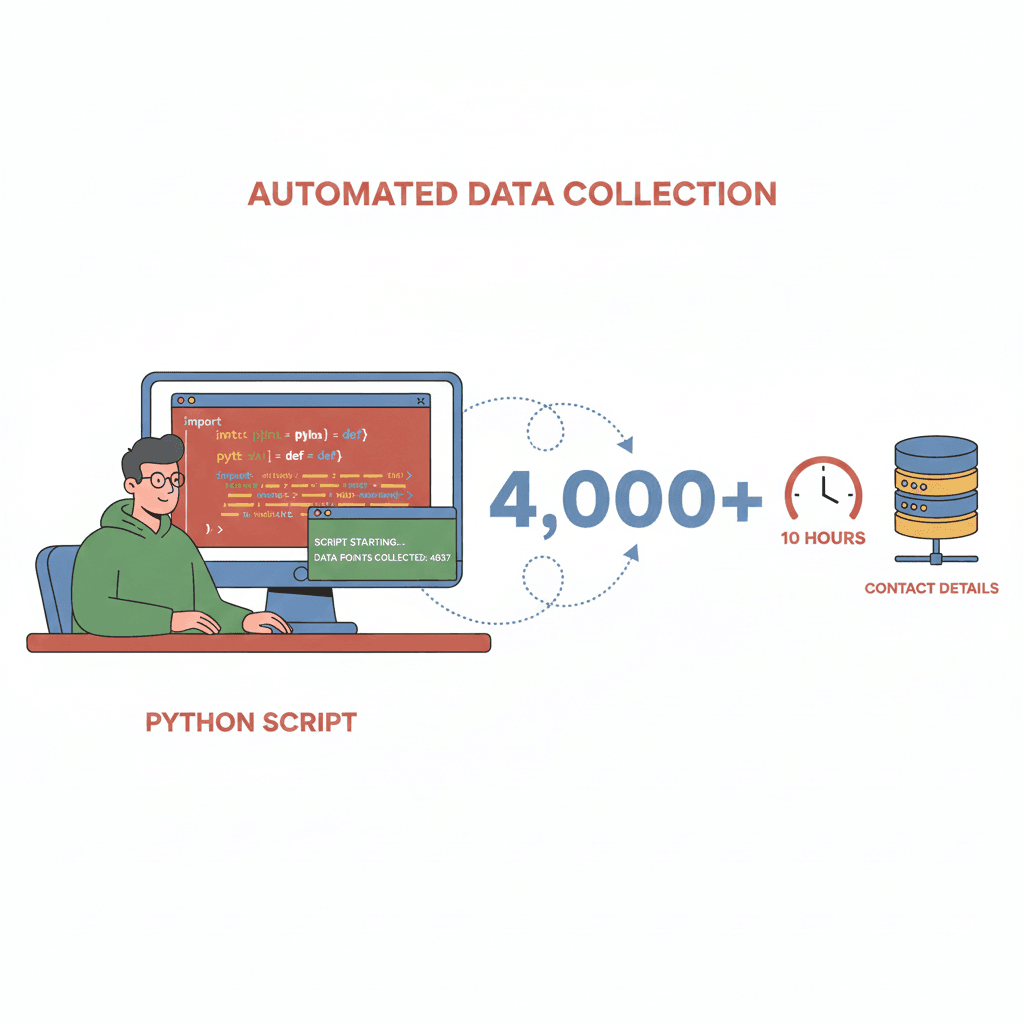

- 압도적인 속도와 효율: 사람이 며칠 걸릴 작업도 스크래퍼면 몇 분이면 끝. 어떤 개발자는 python 스크립트로 했어.

- 대용량 데이터도 거뜬: 경쟁사 사이트의 상품 전체 모니터링이나, 수천 건의 리뷰 집계도 자동으로 처리.

- 높은 정확도와 일관성: 지시한 대로 정확하게 데이터 추출. AI 활용하면 도 가능해.

- 비용 절감: 예전엔 인력이나 비싼 외주 서비스가 필요했던 작업도, 스크래퍼로 이 가능해.

주요 비즈니스 활용 예시와 ROI를 정리하면:

| 활용 예시 | 추출 데이터 | 비즈니스 효과(ROI) |

|---|---|---|

| 영업 리드 확보 | 디렉터리에서 이름·이메일·전화번호 | 몇 시간 만에 4,000건 넘는 리스트 생성(Medium) |

| 가격 모니터링(EC) | 경쟁사 가격·재고 정보 | 다이내믹 프라이싱으로 매출 +4%(Browsercat) |

| 시장·경쟁사 조사 | 상품 리스트·리뷰·후기 | 73% 기업이 시장 분석에 활용(Browsercat) |

| 부동산 분석 | 매물 정보·가격·특징 | 최신 시세·트렌드 파악으로 투자 판단 강화 |

| 뉴스·리서치 집계 | 헤드라인·기사·조사 데이터 | 애널리스트용 실시간 정보 수집, 수작업 불필요 |

Python 웹 스크래퍼 실전 활용 사례

실제로 어떤 업계에서 쓰이고 있는지, 구체적으로 살펴보자:

EC·리테일

리테일러들은 경쟁사 가격, 재고, 리뷰를 모니터링하려고 스크래퍼를 적극 활용해. 가 다이내믹 프라이싱을 위해 데이터 수집을 하고 있어.

영업·리드 확보

영업팀은 공개 디렉터리, 단체 사이트, Google Maps 등에서 잠재 고객 리스트를 자동으로 만들어. 오래된 리스트를 사는 것보다, 최신 연락처를 직접 모으는 게 훨씬 효율적이지.

부동산

에이전트나 투자자들은 Zillow, Realtor.com 등에서 매물 정보와 가격 동향을 수집해서, 실시간으로 시장을 파악하고 있어.

시장 조사·뉴스

애널리스트들은 뉴스 사이트, 포럼, SNS에서 트렌드나 경쟁사 동향을 자동으로 수집해. 손으로는 도저히 못 따라갈 정보량도, 스크래퍼면 한 번에 모을 수 있지.

자주 겪는 문제

물론 모든 게 순조롭진 않아. 스크래퍼가 자주 부딪히는 문제는:

- 동적 콘텐츠: JavaScript로 표시되는 데이터

- 안티 스크래핑 방지책: CAPTCHA, IP 제한, 로그인 필수 등

- 웹사이트 구조 변경: 사이트가 리뉴얼되면 스크립트가 안 돌아감

하지만 AI가 탑재된 새로운 툴이 나오면서, 이런 벽도 점점 낮아지고 있어.

기술적 원리: python 웹 스크래퍼의 동작을 쉽게 설명

어려운 용어 빼고, python 웹 스크래퍼의 기본 흐름을 쉽게 설명할게:

- 요청 보내기: 스크래퍼가 웹사이트에 “페이지 내용 좀 주세요”라고 요청해.

- 콘텐츠 받기: HTML 코드(필요하면 Selenium 등으로 동적 데이터도)를 받아와.

- 데이터 파싱: BeautifulSoup 같은 라이브러리로, 원하는 정보(상품명, 가격, 이메일 등)를 HTML에서 뽑아내.

- 데이터 정리: 불필요한 공백 제거, 포맷 통일, 전화번호 정규화 등 데이터 다듬기.

- 내보내기: 최종 데이터를 CSV나 Excel 등으로 저장해서, 비즈니스에 바로 쓸 수 있게 해.

웹이 거대한 도서관이라면, python 웹 스크래퍼는 “신발 관련 책 다 찾아서 저자랑 가격을 스프레드시트로 정리해줘”라고 시킬 수 있는 로봇 사서 같은 존재야. 게다가 지치지도 않고 엄청 빠르지.

학습 난이도: python 웹 스크래퍼를 쓰려면 필요한 스킬

여기가 핵심인데, 기존 python 웹 스크래퍼는 강력한 대신 배우기가 쉽지 않아.

- 프로그래밍 지식: python 기본, 라이브러리 설치, 디버깅 방법 등 필요

- HTML/CSS 이해: 웹페이지 구조를 보고, 원하는 요소(예:

<h2 class='product-title'>)를 찾는 능력 - 웹 특유의 대응력: JavaScript 대응, 로그인 처리, 봇 방지 우회 등

- 유지보수: 사이트 구조가 바뀌면 스크립트도 고쳐야 함. 타이밍에 따라선 큰일이 될 수도

비개발자에겐 진입장벽이 높고, 개발자도 유지보수에 시간 뺏기기 쉬워. 결국 다시 손작업으로 돌아가는 경우도 많지.

Thunderbit: python 웹 스크래퍼의 힘을 누구나 쉽게

여기서 소개하고 싶은 게, 우리가 만든 야. Thunderbit은 으로, python 웹 스크래퍼의 힘을 프로그래밍 없이 누구나 쓸 수 있게 만들었어.

Thunderbit의 특징은:

- AI로 필드 자동 감지: 버튼 한 번만 누르면 AI가 페이지를 분석해서 “상품명”, “가격”, “이메일” 등 최적의 추출 항목을 제안하고 자동으로 이름까지 붙여줘.

- 2클릭 스크래핑: 제안된 컬럼을 확인하고 “스크래핑”만 누르면 끝. 페이지 넘김, 서브페이지, 동적 콘텐츠도 자동 대응.

- 다양한 내보내기 지원: Excel, Google 스프레드시트, Notion, Airtable, CSV, JSON 등으로 바로 내보내기. 추가 비용이나 복잡한 절차도 없어.

- 서브페이지 자동 순회: 상세 정보가 필요할 때도 각 서브페이지(상품 상세, LinkedIn 프로필 등)를 자동으로 돌아다니며 테이블을 풍성하게 만들어줘.

- 설정·유지보수 필요 없음: 확장 프로그램만 설치하면 바로 쓸 수 있고, 사이트 구조가 바뀌어도 “AI 필드 제안”만 다시 실행하면 OK. AI가 자동으로 대응해.

진짜 “python 웹 스크래퍼의 서비스화”야. 개발자뿐 아니라 누구나 쓸 수 있게 설계했어.

Thunderbit가 기술 장벽을 어떻게 없애는지

기존 python 웹 스크래퍼와 Thunderbit의 차이를 비교해보면:

| 단계 | 기존 python 웹 스크래퍼 | Thunderbit AI 웹 스크래퍼 |

|---|---|---|

| 필요한 스킬 | python 코딩, HTML/CSS, 트러블 대응 | 없음—기본 웹 사용만 할 줄 알면 OK |

| 설치·세팅 시간 | 몇 시간~며칠(설치, 코딩, 디버깅) | 몇 분(확장 프로그램 설치, 바로 시작) |

| 페이지 넘김 대응 | 루프 코딩, 사이트 변경 시 코드 수정 필요 | AI가 자동으로 페이지 넘김 감지·조작 |

| 서브페이지 수집 | 사이트마다 커스텀 코드 필요 | 원클릭—AI가 자동 순회·통합 |

| 동적 콘텐츠 대응 | Selenium/Playwright 등 브라우저 제어 필요 | 브라우저에서 보이는 그대로 바로 추출 |

| Excel/Sheets 내보내기 | 내보내기용 코드 작성, 파일 포맷 대응 필요 | 원클릭으로 Excel, Sheets, Notion, Airtable 내보내기 |

| 유지보수 | 사이트 변경 시 코드 수정 필요 | “AI 필드 제안”만 다시 실행—AI가 자동 대응 |

즉, Thunderbit만 있으면 브라우저만 쓸 줄 알아도 누구나 가능해.

AI×python 웹 스크래퍼로 데이터 품질과 비즈니스 가치를 극대화

Thunderbit은 단순한 데이터 추출 툴이 아니야. AI의 힘으로 더 똑똑하고 고품질의 데이터를 제공해:

- 고도화된 추출 정확도: AI가 패턴을 인식해서 복잡한 페이지나 동적 콘텐츠도 로 데이터 추출.

- 노이즈 제거: 광고, 푸터, 네비게이션 등 불필요한 정보는 AI가 자동으로 빼줘.

- 데이터 정규화: 전화번호 국제 포맷 통일, 주소·카테고리 자동 라벨링 등 커스텀 지시도 AI가 처리.

- 실시간 데이터 가공: 텍스트 번역, 설명 요약, 상품 카테고리 분류 등도 추출과 동시에 AI가 실행.

덕분에 후처리 없이 바로 쓸 수 있는 고품질 데이터를 바로 받을 수 있어.

python 웹 스크래퍼 툴에서 자주 겪는 문제와 해결법

웹 스크래핑에는 고민거리도 있지만, 최신 툴만 있으면 걱정할 필요 없어:

- 안티 스크래핑 방지책: Thunderbit은 브라우저 조작을 흉내 내서, 차단이나 CAPTCHA에 잘 안 걸리게 설계됐어. 까다로운 사이트는 클라우드 모드로 IP 로테이션, 안티봇 기술도 활용.

- 동적 콘텐츠: 브라우저에서 보이는 건 Thunderbit으로 다 추출 가능. JavaScript 대응도 필요 없어.

- 사이트 구조 변경: 사이트가 바뀌어도 “AI 필드 제안”만 다시 실행하면 OK. AI가 자동으로 적응해.

- 데이터 품질: 중복 제거, 에러 처리, AI 클린업으로 항상 고품질 데이터 제공.

- 컴플라이언스: Thunderbit은 적절한 속도 제한, robots.txt 준수, 민감 데이터 회피 등 윤리적 스크래핑을 권장해.

예전엔 개발자만 쓸 수 있었던 스크래핑, 이제는 누구나 안전하고 쉽게 쓸 수 있는 시대야.

정리: 우리 회사에 딱 맞는 데이터 추출 솔루션 고르는 법

여기까지 살펴본 것처럼, python 웹 스크래퍼는 웹의 방대한 정보를 정리해서 비즈니스에 활용할 수 있는 강력한 툴이야. 영업, EC, 리서치 등 다양한 분야에서 활약하지만, 예전엔 프로그래밍 지식이 필수였지.

하지만 같은 AI 탑재 툴이 나오면서 그 벽이 사라졌어. 영업 담당자, 마케터, 부동산 에이전트 등 누구나 몇 분 만에 필요한 데이터를 추출할 수 있어. 코드도, 세팅도, 유지보수도 필요 없어. 결과만 바로 얻으면 돼.

자체 개발 python 웹 스크래퍼가 필요한 건, 전담 개발팀이 있고, 독자적인 워크플로우나 시스템 연동이 꼭 필요한 경우뿐이야. 대부분의 비즈니스 유저에겐 Thunderbit 같은 AI 툴이 훨씬 효율적이고 신뢰도도 높아.

일단 부터 다운받아서, 웹 데이터 추출이 얼마나 쉬운지 직접 경험해봐. “왜 이제야 썼지?” 싶을 거야.

웹 스크래핑, AI 데이터 추출, 업무 자동화에 대해 더 알고 싶다면 도 꼭 참고해봐.

자주 묻는 질문(FAQ)

1. python 웹 스크래퍼란? 손작업과 뭐가 달라?

python 웹 스크래퍼는 웹사이트에서 데이터를 자동으로 추출해 스프레드시트 등 구조화된 데이터로 바꿔주는 프로그램이야. 손으로 복붙하는 것과 달리, 대량 데이터도 빠르고 정확하게 가져올 수 있어.

2. python 웹 스크래퍼로 어떤 데이터를 얻을 수 있어?

테이블, 리스트, 이미지, 이메일, 전화번호, 가격, 상품 정보, 리뷰 등 웹페이지에 있는 거의 모든 정보를 추출할 수 있어.

3. python 웹 스크래퍼 쓰려면 프로그래밍이 꼭 필요해?

기존 python 웹 스크래퍼는 프로그래밍 지식이 필요했지만, 같은 AI 탑재 툴은 클릭만으로 누구나 데이터 추출이 가능해.

4. Thunderbit은 비개발자도 쉽게 쓸 수 있나?

Thunderbit은 AI가 자동으로 데이터 항목을 감지하고, 페이지 넘김·서브페이지도 대응. Excel, Google 스프레드시트, Notion, Airtable로도 원클릭 내보내기. 원하는 데이터만 말하면 끝이야.

5. 웹 스크래핑은 합법이고 안전한가?

공개 데이터만 대상으로 하고, 사이트 이용약관과 개인정보 보호를 지키면 비즈니스 활용도 합법이야. Thunderbit은 윤리적 스크래핑을 권장하고, 컴플라이언스 기능도 갖추고 있어.

웹 데이터 추출의 간편함을 직접 느끼고 싶다면, 해봐. 비즈니스 무기로 웹을 제대로 활용해보자.

더 자세히 알고 싶다면