インターネットの世界には、営業やEC、マーケティングリサーチなど、さまざまな分野で役立つデータがゴロゴロ転がっています。ウェブスクレイピングはリード獲得や価格調査、競合分析の強力な武器ですが、最近は多くの企業がウェブスクレイピング対策を本気で強化してきています。実際、していて、はもはや当たり前。Pythonスクリプトが20分間順調に動いていたのに、突然403エラーの嵐…そんな経験、きっと一度はあるはずです。

自分もSaaSや自動化の現場で長年ウェブスクレイピングに関わってきました。「余裕でしょ!」と思っていた案件が、気づけば「なぜか全部ブロックされる…」なんてことも珍しくありません。そこで今回は、Pythonでブロックされずにウェブスクレイピングを成功させるための実践テクやコード例、さらにAI搭載の代替手段の使いどころまで、分かりやすくまとめます。Python経験者はもちろん、これから始める人も、信頼できるデータ抽出のコツをしっかり身につけていきましょう。

Pythonで「ブロックされない」ウェブスクレイピングとは?

ブロックされないウェブスクレイピングとは、ウェブサイトのボット検知をうまくすり抜けてデータを取得すること。Pythonの場合、ただrequests.get()を繰り返すだけではすぐにバレてしまうので、実際のユーザーっぽく振る舞う工夫が必要です。

なぜPythonなのか?。シンプルな文法や豊富なライブラリ(requests、BeautifulSoup、Scrapy、Seleniumなど)、そして柔軟性が魅力。でも、その人気ゆえに、ボット対策もPython特有の動きを狙い撃ちしてくるようになっています。

つまり、確実にデータを取りたいなら、基本的なやり方を超えた工夫が必要。サイト側の検知ロジックを理解しつつ、ルールやマナーも守りながら、賢く立ち回ることが大事です。

Pythonスクレイピングでブロック回避が重要な理由

ブロックされると、単なる技術的な問題だけじゃなく、ビジネス全体に大きな影響が出ます。具体的にはこんな感じ:

| ユースケース | ブロックされた場合の影響 |

|---|---|

| リード獲得 | 顧客リストの不完全化・機会損失 |

| 価格調査 | 競合価格の見逃し・誤った価格判断 |

| コンテンツ集約 | ニュースやレビュー、調査データの抜け漏れ |

| 市場分析 | 競合や業界動向の把握漏れ |

| 不動産情報 | 古い・不正確な物件データ、商機の逸失 |

スクレイパーがブロックされると、データが取れないだけじゃなく、リソースの無駄や法令違反リスク、不完全な情報での誤った意思決定につながります。している今、信頼性は超重要です。

サイトがPythonウェブスクレイパーを検知・ブロックする仕組み

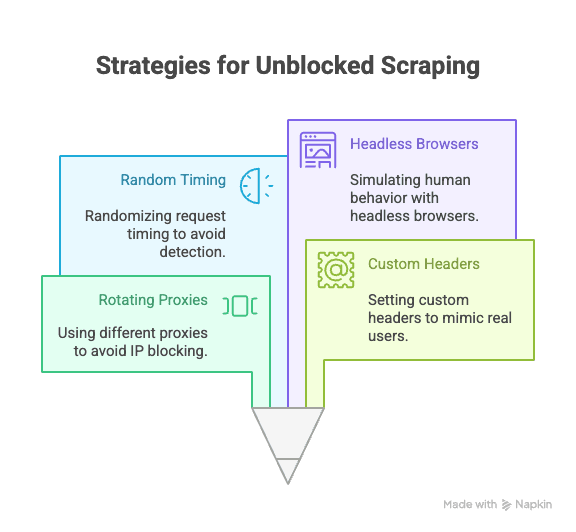

最近のウェブサイトは、ボット検知がめちゃくちゃ進化しています。主な対策はこんな感じ(, ):

- IPアドレスのブラックリスト化:同じIPからの大量アクセスは即ブロック。

- User-Agentやヘッダーのチェック:デフォルトのPythonヘッダー(例:

python-requests/2.25.1)は一発でバレる。 - リクエスト頻度制限:短時間に大量アクセスすると制限やBAN。

- CAPTCHA:人間かどうかを判別するパズル。

- 行動パターン分析:同じ操作を同じ間隔で繰り返すとロボット認定。

- ハニーポット:人間には見えないリンクやフィールドを設置し、ボットだけが反応。

- ブラウザフィンガープリント:ブラウザや端末情報を集めて自動化ツールを特定。

- Cookie・セッション管理:Cookieやセッションを正しく扱わないとフラグが立つ。

空港のセキュリティみたいに、周りと同じように振る舞えばスムーズだけど、怪しい動きをするとすぐにチェックされます。

Pythonでブロックされずにスクレイピングするための基本テクニック

それでは、Pythonでブロックを回避するための主なテクニックを紹介します。

プロキシ・IPアドレスのローテーション

ポイント:同じIPからアクセスし続けると、すぐにブロックされます。プロキシを使ってIPを分散させることで、検知を回避できます。

Pythonでの実装例:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...他のプロキシ

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # レスポンス処理有料のローテーションプロキシ(住宅用など)を使うと、さらに安定します(参照)。

User-Agentやカスタムヘッダーの設定

ポイント:デフォルトのPythonヘッダーはすぐにバレます。実際のブラウザっぽく偽装しましょう。

サンプルコード:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "en-US,en;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)User-Agentも定期的にローテーションすると、さらにバレにくくなります(参照)。

リクエスト間隔やパターンのランダム化

ポイント:ボットは高速かつ規則的に動きますが、人間はゆっくり・不規則に行動します。リクエスト間隔や操作順序をランダムにしましょう。

Python例:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # 2〜7秒のランダム待機Seleniumを使う場合は、クリックやスクロールのパターンもランダム化できます。

Cookie・セッションの管理

ポイント:多くのサイトはCookieやセッショントークンが必須。これを無視するとブロックされやすくなります。

Pythonでの管理方法:

1import requests

2session = requests.Session()

3response = session.get(url)

4# sessionが自動でCookieを管理もっと複雑なフローでは、SeleniumでCookieを取得・再利用することも可能です。

ヘッドレスブラウザで人間の行動を再現

ポイント:JavaScriptやマウス操作、スクロールなど、人間らしい動作が求められるサイトも増えています。SeleniumやPlaywrightなどのヘッドレスブラウザを活用しましょう。

Selenium例:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))これで、動的コンテンツや行動分析も突破しやすくなります(参照)。

応用編:PythonでCAPTCHAやハニーポットを回避する方法

CAPTCHAはボット対策の定番。Pythonで簡単なCAPTCHAを解くライブラリもありますが、本格運用なら2CaptchaやAnti-Captchaなどの外部サービスを使うのが一般的です(参照)。

サンプル連携例:

1# 2Captcha APIの疑似コード

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# 解答を待ってリクエストに利用ハニーポットは、実際のブラウザでは見えないフィールドやリンク。これらに反応しないよう、画面上に表示されている要素だけを操作しましょう(参照)。

Pythonライブラリでリクエストヘッダーを柔軟に設計する

User-Agent以外にも、RefererやAccept、Originなどのヘッダーをランダム化・ローテーションすることで、より自然なリクエストを演出できます。

Scrapyの場合:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'en-US,en;q=0.9',

6 # 他のヘッダー

7 }

8 }Seleniumの場合:ブラウザプロファイルや拡張機能、JavaScriptでヘッダーを注入できます。

ヘッダーの内容は、実際のブラウザのリクエストをDevToolsで確認し、最新のものを参考にしましょう。

従来のPythonスクレイピングが通用しない時代へ

現実として、スクレイピングの普及とともに、ボット対策もどんどん進化しています。。AIによる検知や動的なリクエスト制限、ブラウザフィンガープリントなど、従来のPythonスクリプトでは突破が難しいケースも増えています(参照)。

どんなに工夫しても突破できない場合は、別のアプローチも考えてみましょう。

Thunderbit:Pythonに代わるAIウェブスクレイパー

Pythonで限界を感じたら、のようなノーコード・AI搭載のウェブスクレイパーが頼れる味方になります。プロキシやヘッダー、CAPTCHA対策に悩む必要はなく、ThunderbitのAIエージェントがウェブサイトを解析し、抽出項目の提案からサブページの巡回、データ出力まで自動でやってくれます。

Thunderbitの特長

- AIによる項目提案:「AIで項目を提案」ボタンを押すだけで、ページを解析し、最適なカラムや抽出指示を自動生成。

- サブページの自動巡回:商品詳細やLinkedInプロフィールなど、サブページも自動で巡回し、データを充実化。

- クラウド・ブラウザ両対応:公開ページはクラウド、高度な認証ページはブラウザで高速スクレイピング。

- 定期実行:スケジュール設定で常に最新データを自動取得。

- 即使えるテンプレート:Amazon、Zillow、Shopifyなど人気サイトは1クリックでテンプレート利用可能。

- 無料データ出力:Excel、Google Sheets、Airtable、Notionなどに追加料金なしでエクスポート。

Thunderbitはしていて、プログラミング不要ですぐに始められます。

Thunderbitがブロック回避と自動化を実現する理由

ThunderbitのAIは単なる人間の動作模倣にとどまらず、各サイトの構造変化にもリアルタイムで適応し、ブロックリスクを最小限に抑えます。

- AIがレイアウト変更に自動対応:サイトのデザインが変わってもスクリプトが壊れません。

- サブページ・ページネーションも自動巡回:人間のようにリンクやリストをたどります。

- クラウドで大量ページも高速処理:最大50ページを一括抽出。

- ノーコード・メンテナンス不要:分析に集中でき、トラブル対応の手間が激減。

詳しくはもチェックしてみてください。

PythonスクレイピングとThunderbitの比較

両者の違いを表でまとめました:

| 機能 | Pythonスクレイピング | Thunderbit |

|---|---|---|

| 導入の手間 | 中〜高(スクリプト・プロキシ等) | 低(2クリック、AIが自動化) |

| 技術スキル | コーディング必須 | ノーコードでOK |

| 信頼性 | サイト変更で壊れやすい | AIが自動適応し高信頼性 |

| ブロックリスク | 中〜高 | 低(AIが人間の動作を再現) |

| 拡張性 | カスタム実装・クラウド構築が必要 | クラウド・バッチ処理標準搭載 |

| メンテナンス | 頻繁(サイト変更・ブロック対応) | 最小限(AIが自動調整) |

| 出力形式 | 手動(CSV、DB等) | Sheets、Notion、Airtable、CSVに直接出力 |

| コスト | 無料(ただし工数大) | 無料枠あり・大規模は有料 |

Pythonが向いているケース

- 独自ロジックや他のPythonワークフローとの連携が必要な場合

- ボット対策が緩いサイトを対象とする場合

Thunderbitが向いているケース

- すぐに使いたい、信頼性重視、設定不要で始めたい場合

- 複雑・頻繁に変化するサイトを対象とする場合

- プロキシやCAPTCHA、コーディングに煩わされたくない場合

実践ガイド:Pythonでブロックされずにウェブスクレイピングを設定する手順

ここでは、サンプルサイトの商品データをブロック回避しながら取得する例を紹介します。

1. 必要なライブラリをインストール

1pip install requests beautifulsoup4 fake-useragent2. スクリプトの準備

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # 取得対象URL

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "en-US,en;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # データ抽出処理

16 print(soup.title.text)

17 else:

18 print(f"{url}でブロックまたはエラー: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # ランダムな待機3. プロキシのローテーション(任意)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # 他のプロキシ

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...続きの処理4. Cookie・セッションの管理

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...続きの処理5. トラブルシューティングのコツ

- 403や429エラーが多発する場合は、リクエスト間隔を空けるか、プロキシを変更しましょう。

- CAPTCHAが表示されたら、SeleniumやCAPTCHA解決サービスの利用を検討。

- サイトの

robots.txtや利用規約も必ず確認しましょう。

まとめ・ポイント

Pythonによるウェブスクレイピングは強力ですが、ボット対策の進化でブロックリスクは常に付きまといます。ブロック回避のコツは、プロキシの活用、ヘッダーの工夫、リクエストのランダム化、セッション管理、ヘッドレスブラウザの活用など、技術的なベストプラクティスと、サイトのルールやマナーを守る姿勢の両立です。

それでも突破できない場合は、のようなAI搭載ツールを使えば、ノーコード・高信頼・ブロック耐性のあるデータ抽出が実現できます。

スクレイピングをもっと手軽に始めたい人は、をぜひ試してみてください。さらに詳しいノウハウはでも紹介しています。

よくある質問(FAQ)

1. なぜウェブサイトはPythonのスクレイパーをブロックするの?

ウェブサイトは、データ保護やサーバー負荷防止、不正利用防止のためにスクレイパーをブロックします。Pythonスクリプトは、デフォルトヘッダーやCookie未対応、大量リクエストなどで検知されやすい傾向があります。

2. Pythonでブロックされずにスクレイピングする一番効果的な方法は?

プロキシのローテーション、リアルなUser-Agentやヘッダーの設定、リクエスト間隔のランダム化、Cookie・セッション管理、SeleniumやPlaywrightによる人間らしい動作の再現が有効です。

3. ThunderbitはPythonスクリプトと比べてどうやってブロック回避してるの?

ThunderbitはAIでサイト構造を解析し、人間のブラウジングを模倣。サブページやページネーションも自動で処理し、リアルタイムで手法を最適化するため、コーディングやプロキシ不要でブロックリスクを大幅に低減します。

4. PythonスクレイピングとThunderbit、どっちを使うべき?

独自ロジックや他のPythonコードとの連携が必要な場合はPython、スピード・信頼性・拡張性重視や複雑なサイトを対象とする場合はThunderbitがおすすめです。

5. ウェブスクレイピングは合法?

公開データのスクレイピングは合法ですが、各サイトの利用規約やプライバシーポリシー、関連法令を必ず守りましょう。機密情報や個人情報の取得は厳禁です。常に倫理的かつ責任ある利用を心がけてください。

賢く、効率的にスクレイピングを始めたい人は、ぜひThunderbitを試してみてください。

さらに詳しく知りたい方へ:

- PythonでGoogleニュースをスクレイピングする手順ガイド

- PythonでBest Buyの価格トラッカーを作る方法

- ブロックされずにウェブスクレイピングする14の方法

- ウェブスクレイピングでブロックされないための10のコツ