ウェブスクレイピングは、営業や業務、EC、不動産など、さまざまなビジネスチームが競争力を上げるための“隠れた武器”として活用されています。ネット上には膨大なデータが溢れているけど、特に動的でインタラクティブなサイトから情報を引っ張ってくるのは一筋縄ではいきません。実際、2025年にはウェブスクレイピング市場が約490億ドル規模に成長すると予想されていて、今やほとんどの企業がデータ分析を意思決定に使っています。でも、ウェブサイトが進化して無限スクロールやポップアップ、JavaScriptで動的に生成されるコンテンツが増えると、従来のウェブスクレイピングツールだけでは太刀打ちできない場面も増えてきました。

そこで頼りになるのがSelenium。Seleniumは、実際のブラウザ操作を自動化できる“万能ツール”で、どんなに複雑で動的なサイトからでもデータを引き出せます。「本物のユーザーみたいにサイトを動かして情報を集めたい!」と思ったことがあるなら、Seleniumはまさに理想の相棒。本記事では、selenium ウェブスクレイピングの基礎から応用まで、専門知識がなくても実践できる方法をわかりやすく紹介します。

Seleniumによるウェブスクレイピングとは?やさしい入門編

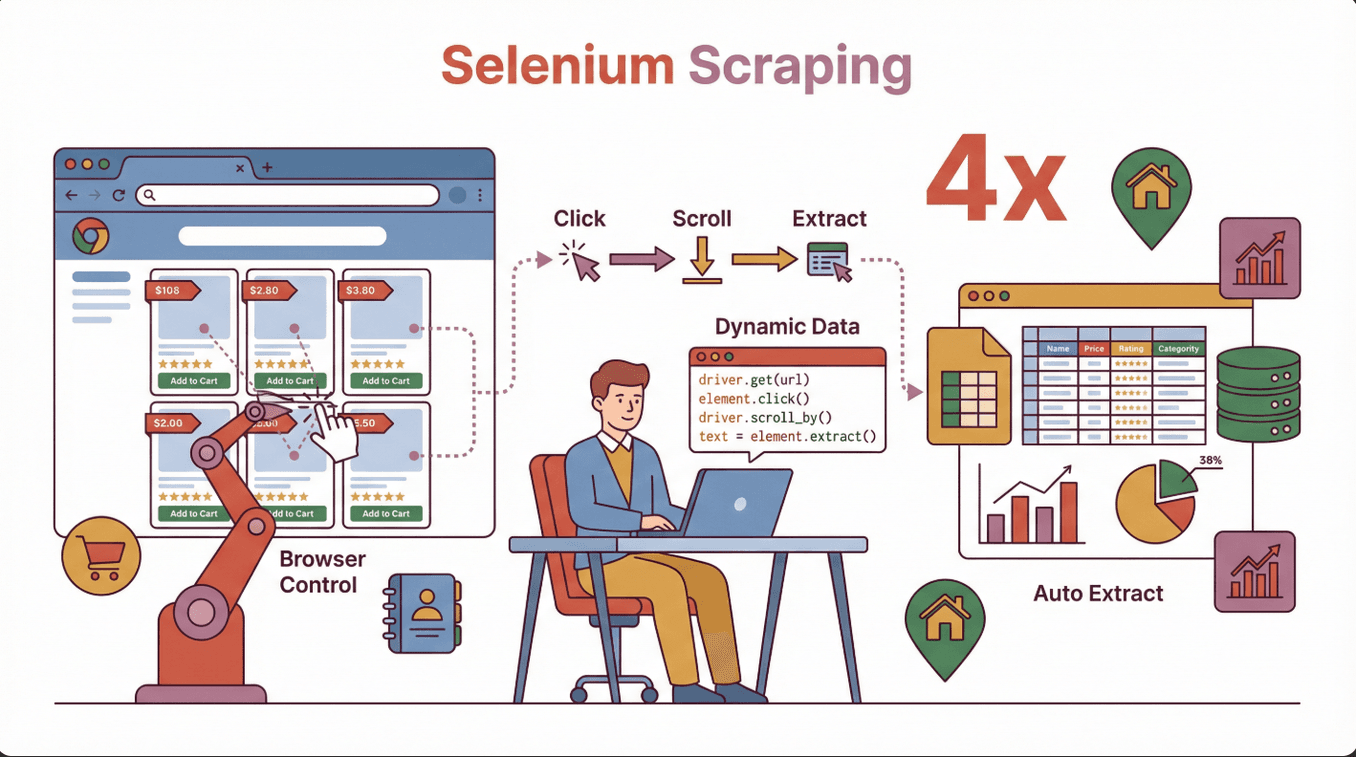

ざっくり言うと、selenium ウェブスクレイピングは、Seleniumライブラリを使って(ChromeやFirefoxなどの)本物のブラウザをコードで動かし、人間のようにボタンをクリックしたり、フォームに入力したり、スクロールしたりしてデータを取得するやり方です。従来のスクレイパーが静的なHTMLしか読めないのに対し、SeleniumはJavaScriptで動的に生成されるコンテンツにもバッチリ対応できるのが大きな強み。

ざっくり言うと、selenium ウェブスクレイピングは、Seleniumライブラリを使って(ChromeやFirefoxなどの)本物のブラウザをコードで動かし、人間のようにボタンをクリックしたり、フォームに入力したり、スクロールしたりしてデータを取得するやり方です。従来のスクレイパーが静的なHTMLしか読めないのに対し、SeleniumはJavaScriptで動的に生成されるコンテンツにもバッチリ対応できるのが大きな強み。

Seleniumが活躍するビジネスシーン例:

- ECサイト:スクロールで表示される商品リストや価格、レビューの取得

- 営業・リード獲得:ログインや複数ステップの操作が必要なディレクトリからの連絡先抽出

- 不動産:ポップアップや地図上で表示される物件情報の収集

- 市場調査:最新のWebアプリ型サイトから競合データを取得

「スクレイピングしたのに必要な情報が半分しか取れない…」なんて経験があるなら、それはページ表示後にデータが読み込まれているからかも。Seleniumなら、ユーザーと同じように待機・クリック・操作ができるので、こうした課題もクリアできます()。

なぜSeleniumを選ぶのか?他ツールとの比較

ウェブスクレイピングには、BeautifulSoupやScrapy、などいろんなツールがあります。じゃあ、なぜselenium スクレイピングを選ぶべきなのか?

| ツール | 得意分野 | JavaScript対応 | インタラクション | 速度 | 使いやすさ |

|---|---|---|---|---|---|

| Selenium | 動的・インタラクティブなサイト | あり | 完全 | やや遅い | 普通 |

| BeautifulSoup | シンプルな静的HTMLページ | なし | なし | 速い | 簡単 |

| Scrapy | 大規模な静的・半動的サイト | 限定的(プラグイン) | 限定的 | 非常に速い | 普通 |

| Thunderbit | ビジネス向けのノーコード高速抽出 | あり(AI搭載) | 限定的 | 速い | 非常に簡単 |

Seleniumの強み:

- JavaScriptで動的に生成されるページや無限スクロール、ポップアップにも対応

- ログインやボタン操作、フォーム入力など人間の操作を自動化できる

- ユーザー操作後に表示されるデータの取得に最適

Seleniumが向いているケース:

- 必要なデータがJavaScriptで後から表示される場合

- サイト内でログインやクリック、スクロールなどの操作が必要な場合

- SPA(シングルページアプリ)など複雑なレイアウトのサイト

他ツールが向いているケース:

- 静的でシンプルなサイトならBeautifulSoupやScrapyで高速処理

- ノーコードで手軽に使いたい場合はThunderbitが最適()

Seleniumのインストールと初期設定:つまずかない導入手順

Seleniumの導入って難しそうに感じるかもしれないけど、実はめちゃくちゃシンプル。よくあるトラブルも含めて、スムーズに始める方法を紹介します。

1. Pythonのインストール(まだの人向け)

Seleniumの解説はPythonが多いけど、JavaやC#など他の言語にも対応。からPythonをダウンロードしよう。

2. pipでSeleniumをインストール

ターミナルやコマンドプロンプトで下記を実行:

1pip install selenium()

3. ブラウザドライバーのダウンロード

Seleniumでブラウザを動かすには「ドライバー」が必要。ChromeならChromeDriver、FirefoxならGeckoDriverを使うよ。

- ブラウザのバージョン確認:Chromeの場合は

chrome://settings/helpでチェック - 対応するドライバーをダウンロード:

- ドライバーの配置:ダウンロードしたドライバーを好きなフォルダに置いて、パスをシステムのPATHに追加

ポイント:ドライバーのバージョンはブラウザと必ず合わせよう。違うと chromedriver executable needs to be available in the path みたいなエラーが出る()。

4. 動作確認

Pythonで下記を実行してみて:

1from selenium import webdriver

2driver = webdriver.Chrome() # または Firefox()

3driver.get("https://www.google.com")

4print(driver.title)

5driver.quit()ブラウザが立ち上がってタイトルが表示されればOK!

よくあるトラブル:

- PATHが正しく設定されていない→環境変数を再確認

- ドライバーとブラウザのバージョン不一致→両方を最新に揃える

- 権限エラー(Mac/Linux)→

chmod +x chromedriverで実行権限を付与

Seleniumで初めてのウェブスクレイピング:実践ステップ

サンプルのECサイトから商品名を取得する簡単なスクリプトを作ってみよう。

1. Seleniumのインポートとドライバー設定

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()2. 対象ページを開く

1driver.get("https://example-ecommerce.com/products")3. コンテンツの読み込みを待つ(必要に応じて)

動的コンテンツの場合は明示的な待機を使おう:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3wait = WebDriverWait(driver, 10)

4wait.until(EC.presence_of_element_located((By.CLASS_NAME, "product-title")))4. データの抽出

1products = driver.find_elements(By.CLASS_NAME, "product-title")

2for product in products:

3 print(product.text)5. 後片付け

1driver.quit()このスクリプトの流れ: Seleniumでブラウザを開き、商品が表示されるまで待機し、product-titleクラスの要素を全部取得してテキストを表示します。

動的コンテンツをSeleniumで攻略するコツ

今や多くのサイトが無限スクロールやポップアップ、クリック後に表示されるコンテンツを使っています。こうした動的要素への対応方法を紹介します。

1. 要素の出現を待つ

データが表示されるまで明示的に待機:

1wait.until(EC.presence_of_element_located((By.ID, "dynamic-content")))2. スクロールでデータを追加読み込み

無限スクロール対応:

1driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")必要に応じて繰り返そう。

3. ポップアップの処理

ポップアップを検出して閉じる:

1try:

2 close_button = driver.find_element(By.CLASS_NAME, "close-popup")

3 close_button.click()

4except:

5 pass # ポップアップがなければスキップ4. フォームやボタンの操作

検索フォームへの入力や「次へ」ボタンのクリック:

1search_box = driver.find_element(By.NAME, "search")

2search_box.send_keys("laptop")

3search_box.submit()実例: スクロールで表示される不動産リストや、タブをクリックして初めて現れる商品レビューの取得など。

よくあるトラブルと解決策:Seleniumスクレイピングの落とし穴

経験者でもつまずきやすいポイントと、その対処法をまとめました。

| 問題 | 解決策 |

|---|---|

| 要素が見つからない | 待機を使う、セレクタを見直す、他の検索方法を試す |

| タイムアウトエラー | 待機時間を延長、コンテンツの遅延読み込みを確認 |

| CAPTCHAやボット検知 | リクエスト間隔を空ける、操作をランダム化、プロキシ利用 |

| ドライバー/ブラウザの不一致 | 両方を最新の互換バージョンに更新 |

| サイトレイアウトの変更 | セレクタやスクリプトを定期的に見直す |

| 動作が遅い | ブラウザ操作を最小限に、可能ならヘッドレスモードを利用 |

ポイント: Seleniumは実際のユーザー操作を再現するため、他ツールより動作が遅くなりがち()。大規模な処理には他の手法も検討しよう。

取得したデータの活用・エクスポート方法

データを取得したら、ビジネスで使いやすい形に保存しよう。基本的な流れを紹介します。

1. リストやDataFrameに格納

1import pandas as pd

2data = []

3for product in products:

4 data.append({"name": product.text})

5df = pd.DataFrame(data)2. CSVやExcelにエクスポート

1df.to_csv("products.csv", index=False)

2# または

3df.to_excel("products.xlsx", index=False)()

3. ビジネスツールと連携

- Google SheetsやAirtableにCSVをインポート

- ZapierやAPIでデータフローを自動化

コツ: インポート前にデータの形式や欠損値を整理しておくとスムーズ()。

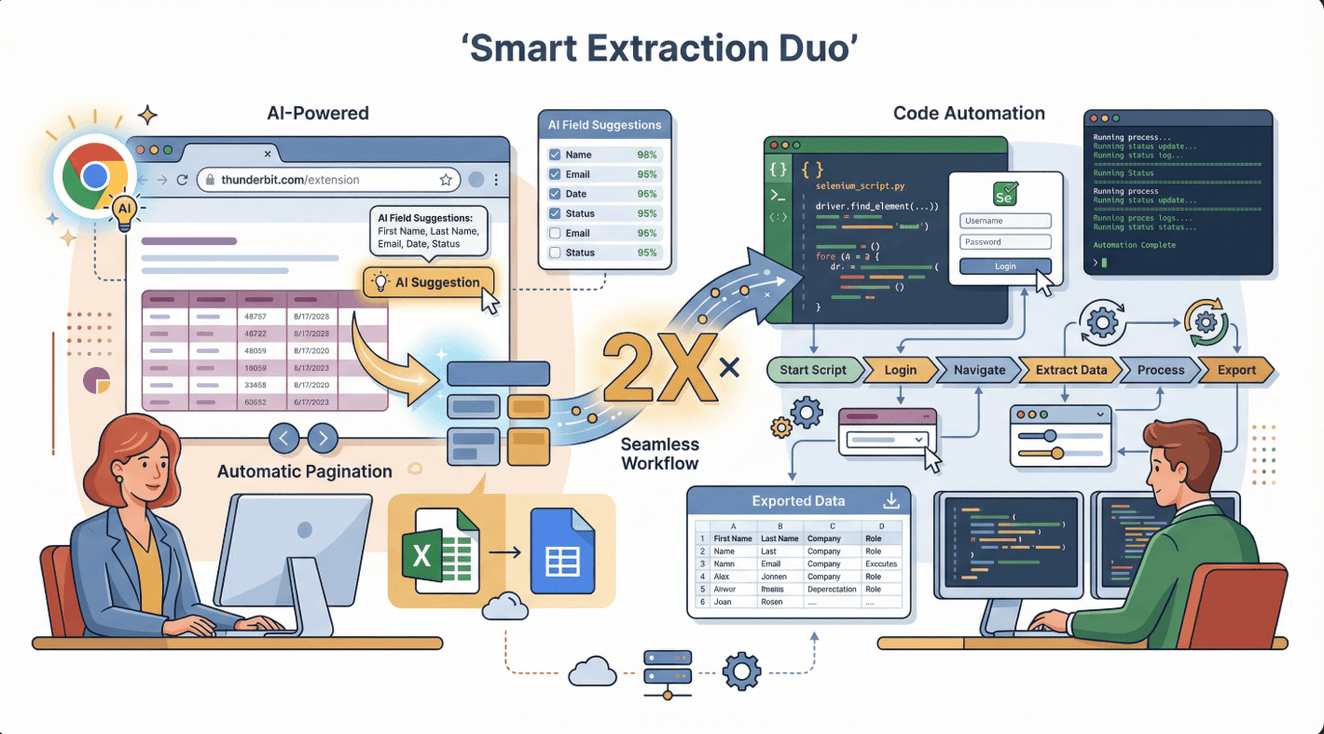

Selenium × Thunderbit:複雑なデータ抽出の最強コンビ

Seleniumはとても強力だけど、すべての用途で最速・最適とは限りません。そこで活躍するのが。ThunderbitはAI搭載のAIウェブスクレイパー Chrome拡張機能で、ほとんどのウェブサイトから数クリックでデータを抽出できます。コーディングや面倒な設定は一切不要。

Seleniumはとても強力だけど、すべての用途で最速・最適とは限りません。そこで活躍するのが。ThunderbitはAI搭載のAIウェブスクレイパー Chrome拡張機能で、ほとんどのウェブサイトから数クリックでデータを抽出できます。コーディングや面倒な設定は一切不要。

両者の使い分け例:

- Thunderbit:テーブルやリスト、シンプルなページからの構造化データ抽出に最適。営業やEC、リサーチチームがすぐに結果を出したいときにおすすめ。

- Selenium:ログインや複雑な操作が必要な場合、またはユーザー操作後にしか表示されないデータの取得に最適。

おすすめワークフロー: まずThunderbitで簡単なデータを取得し、ログインや動的コンテンツなど難しい部分だけSeleniumで補完。Thunderbitで抽出したデータをSeleniumスクリプトに渡して高度な処理を行うことも可能。

Thunderbitの強み:

- AIによるフィールド自動提案—「AIでフィールド提案」をクリックするだけ

- ページネーションやサブページ対応、Excel・Google Sheets・Notion・Airtableへの直接エクスポート

- メンテナンス不要—AIがサイトの変化に自動対応()

法令遵守:Seleniumで安全・倫理的にスクレイピングするために

ウェブスクレイピングは便利だけど、法的・倫理的な配慮も大事。トラブルを避けるためのポイントをまとめました。

1. サイトの利用規約を確認

スクレイピング前に必ず利用規約をチェックしよう。明確に禁止しているサイトもあれば、個人利用のみOKな場合も()。

2. robots.txtの尊重

robots.txtファイルでクロールやスクレイピングの可否が示されている。https://website.com/robots.txt で確認できる()。

3. 機微な個人情報は取得しない

健康・金融・プライベートな情報の取得は絶対NG。法的リスクや訴訟につながる恐れあり()。

4. サーバーへの配慮(リクエスト間隔・識別)

サーバーに負荷をかけないよう、リクエスト間隔を空けたり、スクレイパーの識別情報を送るなど配慮しよう。

5. 公式APIがあれば優先利用

公開APIがある場合は、そちらを使うのが一番安全で確実。

法令遵守チェックリスト:

- [ ] サイトの利用規約・robots.txtを確認し遵守

- [ ] 公開・非機微なデータのみ取得

- [ ] リクエスト頻度を制限し、サイト運営に支障を与えない

- [ ] 必要に応じてデータソースを明記

- [ ] 最新の法規制を常に確認()

スケールアップ:Seleniumを卒業すべきタイミング

Seleniumは小〜中規模の用途に最適だけど、限界もある。

主な制約:

- 実ブラウザを動かすため他ツールより遅い

- 複数ブラウザを同時に動かすとPCの負荷が大きい

- 数千〜数万ページの大量取得には不向き

乗り換えの目安:

- 大量(数千〜数百万ページ)のデータ取得が必要

- クラウドや定期実行で自動化したい

- プロキシローテーションやリトライ、分散処理など高度な機能が必要

主な代替手段:

- Thunderbit:AI搭載・ノーコードでビジネスユーザー向けの高速スクレイピング()

- Scrapy:大規模・分散型スクレイパーを開発したいエンジニア向け()

- マネージドAPI:ScraperAPIやApifyなど、スケーラブルな自動化サービス()

| ツール | 得意分野 | メリット | デメリット |

|---|---|---|---|

| Selenium | 複雑・インタラクティブ | どんなサイトも対応、細かい制御 | 遅い、PC負荷大 |

| Thunderbit | ビジネス向け高速抽出 | ノーコード、AI、簡単エクスポート | 高度な制御はやや弱い |

| Scrapy | 大規模・開発者向け | 高速・スケーラブル・カスタマイズ性 | コーディング必須、インタラクション弱 |

| マネージドAPI | エンタープライズ・自動化 | スケーラブル、手間いらず | コスト、柔軟性は限定 |

まとめ・ポイントのおさらい

selenium ウェブスクレイピングは、動的でインタラクティブなサイトからデータを取得したい人にとって強力な武器。ユーザー操作を自動化できるから、クリックやスクロール、ログインが必要な場面でも大活躍。覚えておきたいポイントは:

- Seleniumが最適なのは:動的サイト、JavaScriptコンテンツ、複雑な操作が必要な場合

- 導入のコツ:ブラウザとドライバーのバージョンを揃え、PATH設定や待機処理を忘れずに

- Thunderbitとの併用:簡単なデータはThunderbit、複雑な処理はSeleniumで使い分け

- 法令遵守:利用規約やrobots.txtを確認し、機微なデータは避ける

- 大規模化には:マネージドAPIやクラウド型ツールも検討

まずはselenium スクレイピングで商品名や価格の取得など簡単なスクリプトから始めてみよう。次はThunderbitを使って、ビジネスデータの自動取得にもチャレンジしてみて。無料で試せるから、手作業の時間を大幅に減らせるよ()。

さらに詳しく知りたい人は、で最新のスクレイピングガイドをチェックしたり、で実践動画を見てみてね。

よくある質問(FAQ)

1. Seleniumは他のウェブスクレイピングツールと何が違うの?

Seleniumは実際のブラウザを操作できるから、JavaScriptで動的に生成されるサイトや、クリック・ログインなどユーザー操作が必要な場面でも対応できる。BeautifulSoupみたいな従来型スクレイパーでは取れないデータも扱えるのが特徴。

2. Selenium導入時によくあるミスは?

一番多いのは、ブラウザとドライバーのバージョン不一致、ドライバーのPATH未設定、動的コンテンツに対して待機処理を入れていないこと。バージョン確認と明示的な待機を忘れずに。

3. SeleniumとThunderbitは併用できる?

もちろんOK。Thunderbitはノーコードで手軽にデータ抽出でき、Seleniumは複雑な操作や動的な処理に最適。多くのチームが、簡単なデータはThunderbit、難しい部分はSeleniumで使い分けてる。

4. Seleniumでのウェブスクレイピングは合法?

サイトの利用規約やrobots.txtを守り、機微なデータを避け、サーバーに負荷をかけない範囲なら合法。必ず現地の法令も確認して、責任を持って使おう。

5. Selenium以外のツールに切り替えるべきタイミングは?

大量ページの高速取得やクラウド自動化が必要な場合は、ThunderbitやScrapy、マネージドAPIなどの利用を検討しよう。Seleniumは小〜中規模・インタラクティブな用途に最適。

ウェブスクレイピングを極めたい人は、ぜひselenium スクレイピングで次のプロジェクトに挑戦してみて。そして、ビジネスデータの高速抽出にはも試してみてね。

さらに詳しく知りたい方へ