ウェブスクレイピングは、今や現代ビジネスチームにとって欠かせない“필살기”になっています。영업, 운영, 경쟁사 분석 등, 웹사이트에서 데이터를 뽑아내는 능력은 이제 기본 소양이죠. 최근 몇 년 사이, 웹 환경은 훨씬 더 다이나믹해지고, 대시보드나 무한 스크롤, 클릭해야만 보이는 콘텐츠가 확 늘었습니다. 이 중심에는 바로 JavaScript가 있습니다. 웹의 거의 모든 동적인 움직임을 책임지는 언어죠.

SaaS와 자동화 현장에서 오랜 경험을 쌓아온 입장에서 보면, JavaScript와 Node.js는 개발자 전용 툴에서 비즈니스 데이터 추출의 핵심 엔진으로 진화했습니다. 실제로 하고 있고, 웹 스크래핑 시장도 2030년까지 두 자릿수 성장세가 예상됩니다(). 이 가이드에서는 JavaScript와 Node.js로 웹 스크래핑을 시작하는 기본부터, 왜 중요한지, 그리고 비개발자도 같은 툴로 쉽게 활용하는 방법까지, 알기 쉽게 풀어볼게요. 개발자가 아니어도, 지금이야말로 웹의 혼돈을 비즈니스 무기로 바꿀 최고의 타이밍입니다.

JavaScript로 웹 스크래핑이란? 기본부터 잡자

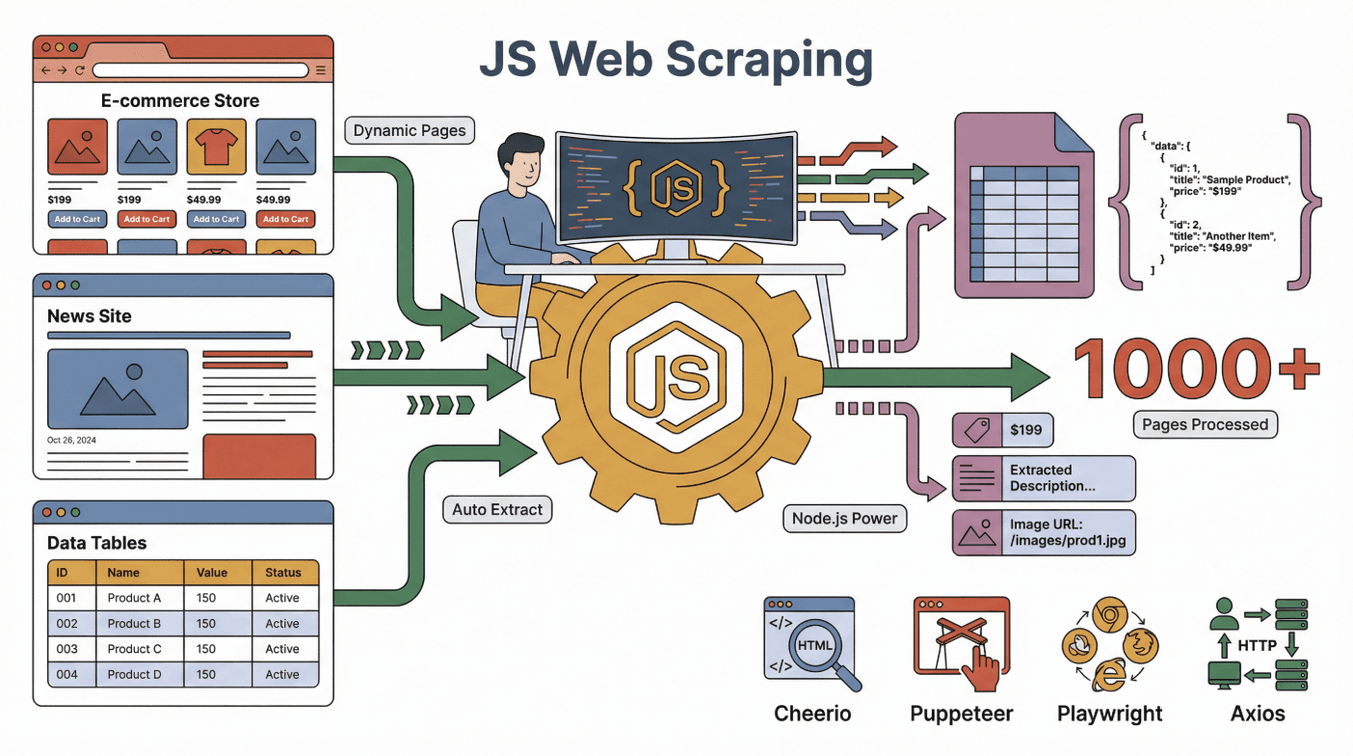

먼저 기본부터. JavaScript로 하는 웹 스크래핑은 JavaScript(대부분 Node.js와 함께)를 활용해 웹사이트에서 자동으로 데이터를 뽑아내는 방법입니다. 마치 디지털 어시스턴트가 웹페이지를 읽고, 필요한 정보를 스프레드시트에 정리해주는 느낌이죠. 게다가 이 어시스턴트는 수천 페이지도 거뜬하고, 버튼 클릭이나 폼 입력도 척척 해냅니다.

먼저 기본부터. JavaScript로 하는 웹 스크래핑은 JavaScript(대부분 Node.js와 함께)를 활용해 웹사이트에서 자동으로 데이터를 뽑아내는 방법입니다. 마치 디지털 어시스턴트가 웹페이지를 읽고, 필요한 정보를 스프레드시트에 정리해주는 느낌이죠. 게다가 이 어시스턴트는 수천 페이지도 거뜬하고, 버튼 클릭이나 폼 입력도 척척 해냅니다.

JavaScript는 브라우저가 웹페이지를 만들고 업데이트할 때 쓰는 언어라, 스크래핑에 딱 맞아요. Node.js를 쓰면 브라우저 밖에서도 JavaScript를 돌릴 수 있어서, 아래와 같은 자동화가 가능합니다:

- 동적/인터랙티브 페이지 로딩

- 버튼 클릭, 스크롤, 콘텐츠 로딩 대기

- 텍스트, 이미지, 가격, 이메일 등 페이지 내 모든 정보 추출

JavaScript로 인기 있는 웹 스크래핑 툴은 다음과 같습니다:

- : 정적인 HTML 페이지 분석·데이터 추출에 최적(서버사이드 jQuery 느낌)

- : 실제 Chrome 브라우저를 자동 조작, 동적 사이트 스크래핑에 강력

- : Puppeteer의 업그레이드 버전, 여러 브라우저 자동화 지원

- : 웹페이지나 API에 HTTP 요청 보내기

이 툴들을 조합하면, Axios나 Puppeteer로 페이지를 가져오고, Cheerio로 HTML을 분석, Node.js가 전체를 관리하는 구조가 완성됩니다.

정적 페이지 vs 동적 페이지: JavaScript가 중요한 이유

- 정적 페이지: 콘텐츠가 고정되어 있고, 페이지 로딩 시 전부 표시됨. 간단한 툴로 쉽게 스크래핑 가능.

- 동적 페이지: JavaScript로 나중에 콘텐츠가 로딩됨. Puppeteer 같은 브라우저 자동화가 필수().

Amazon, LinkedIn, Zillow 등 많은 사이트가 동적 콘텐츠를 쓰기 때문에, JavaScript 기반 스크래핑이 대세가 됐습니다.

왜 JavaScript로 웹 스크래핑? 다른 언어와의 차별점

개발자 커뮤니티에서는 “JavaScript vs Python vs Ruby vs Go” 논쟁이 끊이지 않죠. 제 경험을 바탕으로 포인트만 정리해볼게요:

JavaScript의 강점

- 동적 콘텐츠 대응력: JavaScript는 브라우저 표준 언어라 최신 동적 사이트와 자연스럽게 소통 가능().

- 브라우저 자동화: Puppeteer, Playwright로 클릭, 스크롤, 폼 입력 등 사람 행동을 그대로 재현.

- 프론트엔드 경험 활용: 이미 JavaScript로 웹 개발 경험이 있다면, 그대로 스크래핑에도 적용 가능().

- 병렬 처리와 속도: Node.js는 여러 작업을 동시에 처리, 대량 페이지 스크래핑에 최적().

- 풍부한 생태계: 수천 개의 라이브러리, 튜토리얼, 커뮤니티 지원이 빵빵.

Python·Ruby·Go와 비교

| 言語 | 動的コンテンツ対応 | ブラウザ自動化 | コミュニティ | 速度 | 得意分野 |

|---|---|---|---|---|---|

| JavaScript | 非常に優秀 | 非常に優秀 | 非常に大きい | 高速 | インタラクティブサイト、フロントエンドチーム |

| Python | 良好(Selenium/Playwright利用時) | 良好 | 非常に大きい | 高速 | API、静的サイト、データサイエンス |

| Ruby | 普通 | 限定的 | ニッチ | 中速 | シンプルな静的スクレイピング |

| Go | 限定的 | 限定的 | 成長中 | 非常に高速 | 大規模・バックエンド向けスクレイピング |

최신 인터랙티브 웹사이트를 스크래핑하려면 JavaScript(Node.js)가 최강입니다(). Python도 인기지만, JavaScript가 많이 쓰인 페이지에선 역시 JavaScript가 한 수 위죠().

JavaScript·Node.js에서 쓰는 주요 스크래핑 툴

JavaScript 스크래핑의 대표 툴을 정리해볼게요:

- Node.js: 브라우저 밖에서 JavaScript를 돌리는 엔진, 전체 컨트롤러 역할

- Cheerio: HTML 분석, 요소 추출(예: “이 페이지의 모든 상품명 가져오기”)

- Puppeteer/Playwright: 실제 브라우저 자동 조작, 동적 콘텐츠·로그인·복잡한 작업도 OK

- Axios/Fetch: 웹페이지나 API 직접 가져오기

- 기타 보조 툴: 데이터 내보내기(CSV, Excel), 프록시 관리, 정기 실행 등

연계 이미지: Puppeteer는 로봇 브라우저, Cheerio는 데이터 탐정, Node.js는 프로젝트 매니저처럼 전체를 조율합니다.

JavaScript로 웹 스크래핑하는 흐름: 단계별 설명

실제 흐름을 쉽게 설명할게요. 일반적인 JavaScript 스크래핑 절차는:

- 요청 보내기: Axios나 Puppeteer로 페이지 가져오기

- 콘텐츠 로딩 대기: 동적 페이지라면 JavaScript 실행 완료까지 대기(Puppeteer로 최종 화면 확인)

- 데이터 추출: Cheerio나 브라우저 API로 필요한 정보 뽑기

- 페이지 넘기기·서브페이지 처리: “다음” 버튼이나 링크 따라가며 추가 데이터 수집

- 데이터 내보내기: CSV, Excel, Google Sheets, 데이터베이스 등에 저장

이미지: 똑똑한 인턴이 모든 페이지를 돌며 메모를 정리해주는 느낌입니다.

정적 콘텐츠와 동적 콘텐츠의 차이

- 정적 사이트 예시: HTML에 모든 글이 표시된 블로그. Cheerio+Axios로 충분.

- 동적 사이트 예시: 스크롤해야 가격이 보이는 쇼핑몰. Puppeteer나 Playwright로 최종 가격 추출().

프로 꿀팁: 스크래핑할 때 빈 페이지가 뜬다면, 동적 페이지일 확률 높음. 이럴 땐 Puppeteer가 필요해요.

Thunderbit: 노코드로 JavaScript급 웹 스크래핑

여기서부터가 진짜 핵심! 개발자가 아니어도 쓸 수 있는 게 바로 입니다. JavaScript 수준의 스크래핑을 누구나 쉽게 할 수 있도록 설계됐어요.

우리의 생각: 웹 스크래퍼는 “인턴처럼 업무를 이해”해야 한다고 봅니다. 하고 싶은 걸 말만 하면, AI가 최적의 방법을 자동으로 찾아줍니다.

Thunderbit가 JavaScript 스크래핑을 모두의 기술로

- AI 필드 추천: 클릭 한 번이면 AI가 페이지를 분석, 추출할 데이터를 자동 제안·설정

- 서브페이지 지원: 상세 정보가 필요할 때도 Thunderbit가 각 서브페이지(상품, 프로필 등)를 돌며 테이블을 자동 완성

- 즉시 사용 가능한 템플릿: Amazon, Zillow, Shopify 등 인기 사이트는 템플릿만 골라서 바로 시작

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion으로 바로 내보내기, 추가 비용 없음

실제 예시: 영업팀이 Thunderbit로 동적 디렉토리에서 수백 건의 리드(이메일·전화번호 포함)를 몇 번의 클릭만으로 확보. 코딩 없이, 마치 JavaScript 개발자가 팀에 있는 느낌!

주요 활용 사례: 영업·운영에서 JavaScript 웹 스크래핑

JavaScript 웹 스크래핑은 개발자만의 전유물이 아닙니다. 실제 팀 활용 사례를 볼까요?

| チーム | 活用例 | 成果 |

|---|---|---|

| 営業 | ディレクトリからリード獲得 | リード数10倍、CRMへの即インポート |

| EC | 競合価格のモニタリング | 柔軟な価格調整、迅速な市場対応 |

| オペレーション | 在庫情報の集約 | 複数サプライヤーのSKUを一元管理 |

| 不動産 | 物件情報の集約 | 最新の市場データを1つのスプレッドシートに |

| マーケティング | レビュー・感情分析 | インサイトの迅速化、ターゲティング精度向上 |

사례: 한 EC팀은 Thunderbit로 경쟁사 가격을 자동 수집, 주 20시간 이상 작업을 줄이고 자사 가격도 거의 실시간으로 조정하게 됐어요().

JavaScript 웹 스크래핑의 윤리·법적 주의사항

많이 궁금해하는 게 “웹 스크래핑 합법인가?”라는 점이죠. 결론부터 말하면, 공개 데이터를 규칙에 맞게 수집하면 보통 문제 없습니다(). 단, 아래는 꼭 지켜야 해요:

- robots.txt 준수: “스크래핑 금지” 명시된 경우 반드시 따르기

- 이용약관 확인: 명확히 금지하는 사이트도 있음

- 개인정보 보호: 개인정보 수집·악용은 절대 금지

- 서버 부하 배려: 적절한 속도로 스크래핑

최근 판례에선 공개 데이터 스크래핑이 인정되는 추세지만, 저작권·개인정보법은 항상 신경 써야 합니다(). 불안하다면 전문가 상담이 답입니다.

베스트 프랙티스: 공개적으로 공유 가능한 데이터만 수집하고, 반드시 출처를 명시하세요.

JavaScript 웹 스크래핑의 미래: AI와 자동화의 진화

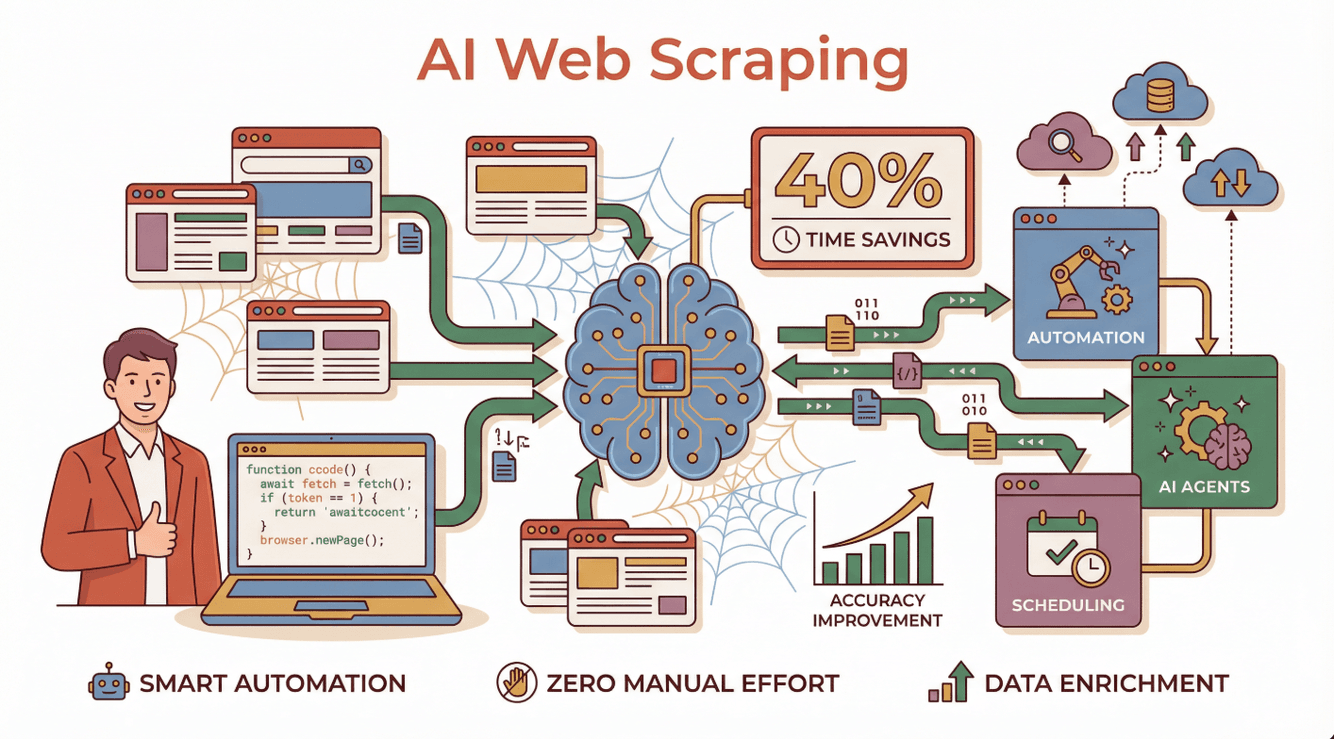

지금 웹 스크래핑은 AI 덕분에 엄청나게 진화 중입니다. 예전처럼 손으로 코딩하던 시대에서, 훨씬 똑똑하고 자동화된 프로세스로 바뀌고 있죠. AI 탑재 스크래퍼를 도입한 기업들은 , 정확도 향상, 복잡한 동적 사이트 대응력까지 실감하고 있습니다().

지금 웹 스크래핑은 AI 덕분에 엄청나게 진화 중입니다. 예전처럼 손으로 코딩하던 시대에서, 훨씬 똑똑하고 자동화된 프로세스로 바뀌고 있죠. AI 탑재 스크래퍼를 도입한 기업들은 , 정확도 향상, 복잡한 동적 사이트 대응력까지 실감하고 있습니다().

실제로 어떻게 달라질까?

- AI 에이전트가 자연어 지시를 이해, 사이트 변화에도 유연하게 대응, 에러도 자동 복구().

- 자동 스케줄링으로 매일 최신 데이터 손쉽게 확보

- 데이터 고도화: AI가 카테고리 분류, 요약, 번역까지 자동 처리

Thunderbit는 이 흐름의 최전선에서, 누구나 AI 탑재 웹 스크래퍼를 노코드로 만들고 운영할 수 있는 세상을 열고 있습니다.

AI 웹 스크래핑의 미래가 궁금하다면: 도 꼭 참고해보세요.

처음 시작하는 분들을 위한 실전 팁

JavaScript(또는 Thunderbit 노코드)로 웹 스크래핑을 시작하고 싶다면, 아래 실전 스텝을 따라 해보세요:

- 목적 명확히: 어떤 데이터가 필요하고, 어디에 쓸지 정리

- 툴 선택: 개발자라면 Node.js+Puppeteer나 Cheerio, 비개발자라면 후 AI에 맡기기

- 소규모 테스트: 우선 몇 페이지만 시도, 점차 확장

- 데이터 분석: Google Sheets, Excel, Notion 등에서 분석·활용

- 윤리 준수: 개인정보, 이용약관, 데이터 수집량 항상 신경쓰기

더 배우고 싶다면: 초보자 튜토리얼이나 Stack Overflow, Reddit r/webscraping 커뮤니티도 추천합니다.

정리: JavaScript와 웹 스크래핑으로 비즈니스 가치를 극대화

결론적으로, JavaScript와 Node.js는 특히 동적·인터랙티브 사이트 웹 스크래핑에서 필수불가결한 존재가 됐습니다. 개발자는 물론, 비즈니스 유저도 브라우저 자동화, 풍부한 생태계, 그리고 AI 탑재 툴 덕분에 그 어느 때보다 빠르고 정확하게 데이터를 뽑아낼 수 있죠.

게다가 같은 노코드 솔루션이라면, 코딩 없이도 JavaScript급 스크래핑이 가능합니다. 하고 싶은 걸 말하고 클릭만 하면, 필요한 데이터가 바로 손에 들어오죠. 분석, 리드 확보 등 비즈니스의 다음 한 수에 적극 활용해보세요.

웹의 혼돈을, 구조화된 인사이트로 바꾸고 싶다면 지금이 바로 시작할 타이밍! 스크래핑을 즐기면서, 항상 클린하고 법규 준수, 그리고 경쟁사보다 한발 앞선 데이터 활용을 목표로 해보세요.

자주 묻는 질문(FAQ)

1. JavaScript와 Node.js로 웹 스크래핑이란?

JavaScript(대부분 Node.js에서 동작)를 활용해 웹사이트에서 자동으로 데이터를 추출하는 방법입니다. 특히 JavaScript로 동적으로 생성되는 사이트에 강점이 있어요.

2. 왜 동적 사이트 스크래핑에서 JavaScript가 Python이나 Ruby보다 뛰어난가요?

JavaScript는 브라우저 표준 언어라 동적 콘텐츠와 찰떡궁합입니다. Puppeteer, Playwright 같은 툴로 실제 브라우저 조작을 자동화할 수 있어, JavaScript 기반 사이트도 쉽게 데이터 수집이 가능합니다.

3. 비개발자도 JavaScript로 웹 스크래핑 할 수 있나요?

물론이죠! 같은 노코드 툴을 쓰면, 자연어로 지시만 해도 AI가 기술적인 부분을 전부 자동화해줍니다.

4. 웹 스크래핑은 합법인가요?

기본적으로 공개 데이터 수집은 합법이지만, 각 사이트의 이용약관, robots.txt, 개인정보법은 꼭 지켜야 해요. 개인정보나 저작권 데이터 무단 수집은 피하세요.

5. AI는 JavaScript 웹 스크래핑을 어떻게 바꾸나요?

AI 도입으로 웹 스크래핑은 훨씬 똑똑하고 쉬워졌어요. 사이트 변화에도 자동 대응, 에러 처리, 데이터 자동 가공까지 가능. Thunderbit가 이 AI 시대를 대표하는 툴입니다.

더 자세한 가이드와 최신 정보는 나 도 참고해보세요.

관련 링크