ターミナルを使ったことがある人なら、cURLに一度は触れたことがあるはず。cURLはネットの世界で“何でも屋”のような存在で、世界中の何十億台ものデバイスに標準搭載されています。URLさえあれば、データの取得・送信・デバッグまで何でもこなせるのが魅力。実際、cURLの開発者によるとされているそうで、その普及率は圧倒的です。

では、2025年になってもなぜ開発者やビジネスパーソンがcURLを使い続けているのでしょう?AI搭載の最新スクレイピングツールが次々登場している今でも、cURLは「手軽さ」「スクリプト化のしやすさ」「余計な準備がいらない」といった理由で根強い人気を誇ります。この記事では、cURLウェブスクレイピングが今も選ばれる理由や、どんな場面で最適なのか、プロの使い方、そして現代的なAIウェブスクレイパーと組み合わせて作業効率を最大化する方法まで、詳しくご紹介します。

2025年もcURLがウェブスクレイピングで活躍する理由

正直、私はcURLが大好きです。たった一行のコマンドで生データが流れ込んでくる瞬間は、何度やってもテンションが上がります。私だけでなく、多くの開発者も同じ気持ちのようです。では昨年、回答者数が28%も増加。Stack Overflowでも「curl」タグのにのぼります。開発者からは「信頼できる」「最高」「ウェブリクエストの共通言語」といった声も。新しいツールが次々登場しても、cURLはHTTP/3対応など進化を続けています。

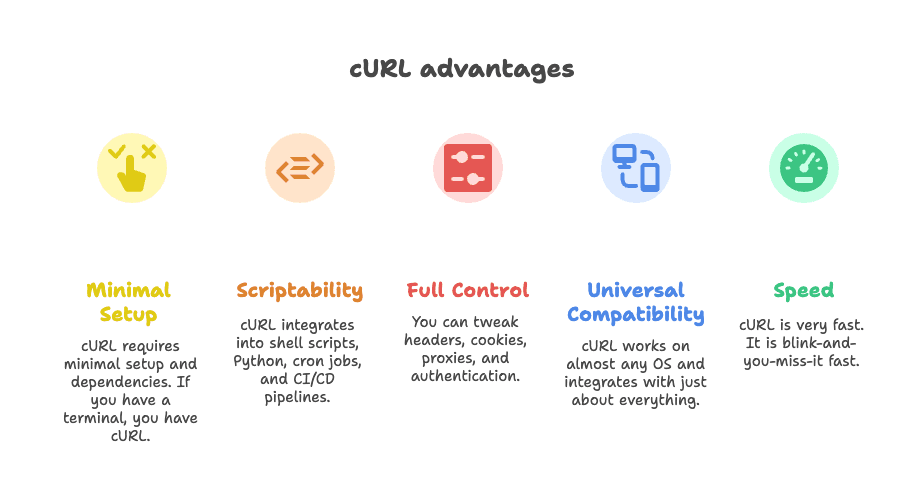

では、なぜcURLはウェブスクレイピングで今も重宝されるのでしょうか?

- 導入が超簡単:追加インストール不要。ターミナルがあればすぐ使えます。

- スクリプト化が得意:シェルスクリプトやPython、cron、CI/CDにもサクッと組み込めます。

- 細かい制御ができる:ヘッダーやクッキー、プロキシ、認証なども自在に設定可能。

- 幅広い互換性:ほぼ全てのOSで動作し、他ツールとの連携もラクラク。

- とにかく速い:一瞬でデータ取得が終わります。

ある開発者は「やりたいことは何でもcURLでできる」と語っています()。

cURLウェブスクレイピングの主な活用シーン

もちろん、cURLが全てのスクレイピングに最適というわけではありません。でも、特定の用途では他の追随を許しません。cURLが本領を発揮する場面を紹介します。

1. REST APIからのJSONデータ取得

最近の多くのウェブサイトは、裏側でAPI通信を使ってデータを取得しています。ブラウザの「ネットワーク」タブでエンドポイントを見つければ、cURLで一発取得。データの一括取得やAPIテスト、自動化スクリプトへの組み込みに最適です。

2. 静的または構造が明確なページからのデータ抽出

必要な情報がHTML内にそのまま載っている場合(ニュース記事、ディレクトリ、商品一覧など)、cURLで即座に取得可能。grepやsed、jqなどと組み合わせれば簡単なパースもできます。

3. 複雑なHTTPリクエストのデバッグや再現

ログインのシミュレーションやWebhookのテスト、APIの挙動確認など、cURLならリクエストの中身を細かく操作できます。開発者が「裏側で何が起きているか」を把握するのに最適です。

4. スクリプトへの組み込みによる自動データ取得

cURLはシェルスクリプトやPython、ZapierのWebhookなどにも組み込みやすく、裏方の自動化処理を支えています。

cURLの得意・不得意をまとめた表はこちら:

| 用途 | cURLが向いている理由 | 苦手な点 | 代替ツール |

|---|---|---|---|

| JSON APIの取得 | 高速・スクリプト化・ヘッダー/トークン対応 | JSONパースは手動、複雑な認証は面倒 | Python Requests, Postman, Thunderbit |

| 静的HTMLページ | 軽量・CLIツールと連携しやすい | HTMLパース不可、JavaScript非対応 | Scrapy, BeautifulSoup, Thunderbit |

| セッション認証付きスクレイピング | クッキー・ヘッダー・基本認証対応 | 複数ステップのログインは面倒、JS非対応 | Requests sessions, Selenium, Thunderbit |

| シェル/Python連携 | どんなスクリプトにも組み込める | パースやエラー処理は手動 | ネイティブHTTPライブラリ, Thunderbit |

さらに詳しい解説はも参考にどうぞ。

2025年版:cURLウェブスクレイピングの実践テクニック

ここからは、2025年に役立つcURLの実践的な使い方やコツを紹介します。

ヘッダーやユーザーエージェントの設定

多くのサイトは、デフォルトのcURLリクエストをブロックします。実際のブラウザに近いUser-Agentや必要なヘッダーを指定しましょう:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/data複数のヘッダーを追加する場合:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataヘッダーの偽装は、データ取得成功のカギです。詳しくはも参考に。

クッキー・セッションの扱い

ログインやセッション維持が必要な場合は、cURLのクッキージャーを活用:

1# ログインしてクッキー保存

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# 保存したクッキーでアクセス

4curl -b cookies.txt https://example.com/dashboardクッキーを直接指定することも可能:

1curl -b "SESSIONID=abcd1234" https://example.com/pageリダイレクトを追う場合(ログイン後など)は-Lを追加しましょう。

プロキシの利用でブロック回避

IPブロックに遭遇したら、プロキシ経由でリクエスト:

1curl --proxy 198.199.86.11:8080 https://target.com複数のプロキシをローテーションする場合は、リストから読み込んでスクリプト化しましょう。無料プロキシは不安定なことが多いので注意。

レスポンスの保存とパース

cURLは生データを返します。整形や抽出にはコマンドラインツールを組み合わせましょう:

-

JSONの場合:

jqで整形やフィールド抽出1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

HTMLの場合:

grepやsedでパターン抽出1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

より複雑なパース:

htmlq(CSSセレクタ対応)やPythonのBeautifulSoupもおすすめ

cURLとjqの連携例はが参考になります。

認証・レートリミット対策

認証例:

-

Basic認証:

1curl -u username:password https://api.example.com/data -

Bearerトークン:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

セッションクッキー:

-cと-bオプションを活用

OAuthなど複雑な認証はスクリプト化が必要です。

レートリミット・リトライ例:

-

遅延を入れる:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # 2〜4秒のランダム遅延 4done -

リトライ:

1curl --retry 3 --retry-delay 5 https://example.com/data

サーバーに負荷をかけすぎないよう、429 Too Many Requestsのレスポンスには注意しましょう。

cURLウェブスクレイピングの限界と注意点

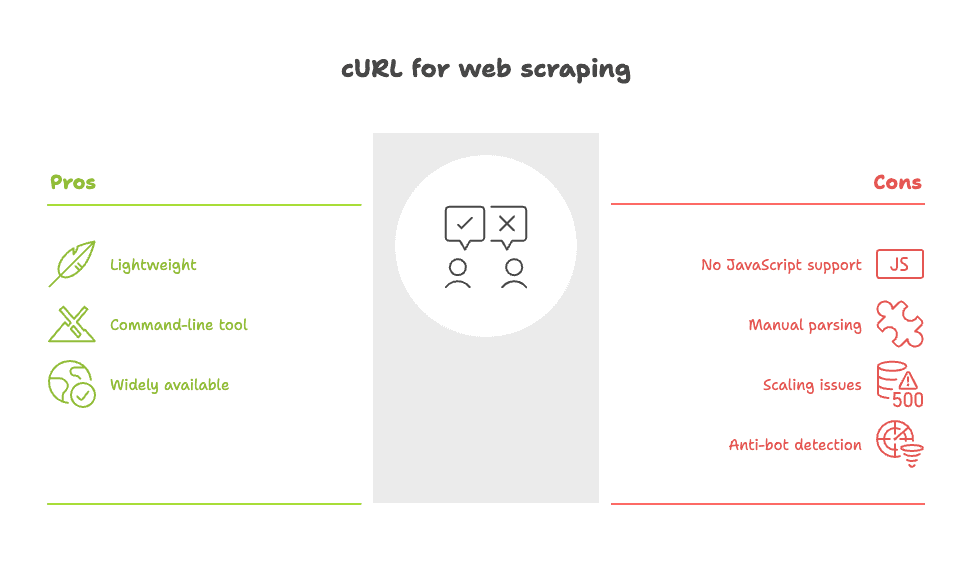

ここで現実的な話も。cURLは万能ではありません。主な弱点は以下の通りです:

- JavaScript非対応:cURLはスクリプト実行や動的コンテンツのレンダリングができません。ページ表示後にデータが読み込まれる場合は、APIを探すかブラウザベースのツールが必要です。

- パースは手作業:取得できるのは生のHTMLやJSON。データの整形は自分でスクリプトを書く必要があります。

- 大規模スクレイピングは非効率:数百・数千ページの取得やエラー処理、データクレンジングは手間がかかります。

- ボット対策に検知されやすい:cURLの通信は多くのサイトで見分けられ、ヘッダー偽装してもブロックされることがあります。

Redditでも「簡単な用途ならcurlやwgetで十分だが、複雑なサイトには苦労する」との声が()。

cURLの課題を詳しく知りたい方はもご覧ください。

ThunderbitでcURLウェブスクレイピングを強化しよう

「cURLのスピードや柔軟性はそのままに、面倒な作業は省きたい」——そんな方におすすめなのがです。

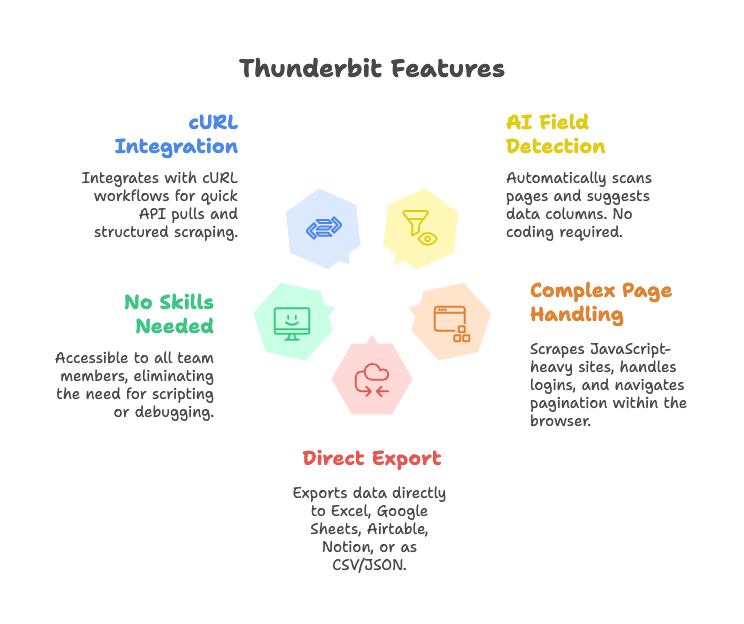

ThunderbitはAI搭載のウェブスクレイパーChrome拡張機能。cURLの弱点を補い、データ抽出を劇的に効率化します。

- AIによるフィールド自動検出:「AIでフィールドを提案」をクリックするだけで、ページ内のデータを自動で抽出・構造化。セレクタやコードは不要です。

- 複雑なページも対応:ブラウザ上で動作するため、JavaScriptで生成されるページやログインが必要なサイト、ページネーションもOK。

- 直接エクスポート:Excel、Google Sheets、Airtable、Notionなどにワンクリックで出力。CSV/JSONダウンロードも可能。

- 専門知識不要:チームの誰でも使える直感的なUI。スクリプトやヘッダーのデバッグは不要です。

- cURLワークフローとの連携:開発者はAPI取得やプロトタイピングにcURLを使い、構造化や繰り返し作業はThunderbitに任せる、といった使い分けも可能です。

Thunderbitの実際の動作はやでチェックできます。

Thunderbit × cURL:ビジネス現場での活用例

実際に、cURLとThunderbitを組み合わせてどんな業務改善ができるのか、具体例を紹介します。

1. 市場調査の高速化

- まずcURLで競合サイトのAPIや静的HTMLの有無をチェック

- 取得できる場合は、スクリプトで一括データ取得

- 複数ページにまたがる商品リストなどはThunderbitに切り替え、AIでフィールド検出・ページネーション対応・Sheets出力まで一気に実現

2. リード獲得

- シンプルなディレクトリAPIからcURLで連絡先情報を取得

- 複雑なサイト(例:LinkedIn風プロフィールや不動産リスト)はThunderbitで氏名・メール・電話番号・画像まで自動抽出

3. 商品リストや価格のモニタリング

- REST APIがある場合はcURLスクリプトで定期チェック

- APIがない場合はThunderbitでスクレイピングし、AirtableやNotionに自動連携

ワークフローイメージ:

1[ブラウザ/ターミナル] --(cURLでテスト)--> [データ取得]

2 |

3 v

4[Thunderbit Chrome拡張] --(AI抽出)--> [構造化データ] --> [Sheets/Airtable/Notion]Thunderbitと手書きcURLスクリプトの比較

両者の違いをまとめると:

| 機能 | Thunderbit(AIウェブスクレイパー) | cURL(CLIツール) |

|---|---|---|

| 導入時間 | ポイント&クリック、AIが自動検出 | 手動スクリプト作成、HTML知識必須 |

| 使いやすさ | 誰でも使える、視覚的フィードバック | CLIのみ、習得に時間がかかる |

| 構造化出力 | あり(表形式、Sheets/CRM出力) | 生HTML/JSON、手動パース |

| 動的ページ対応 | あり(ブラウザ動作、JS・サブページ・ページネーションOK) | なし(静的HTMLのみ) |

| メンテナンス | 低(AIがサイト変更に対応、更新も簡単) | 高(サイト変更でスクリプト修正必須) |

| 連携 | ビジネスツールに直接エクスポート | カスタムコードが必要 |

| 多言語・翻訳 | あり(AIがフィールドを正規化・翻訳) | なし(手動対応) |

| スケール | 中規模まで得意、大規模クロールは非推奨 | 大規模も可能だがスクリプト構築が必要 |

| コスト | 無料枠あり、有料プランは月9ドル〜 | 無料だが開発工数がかかる |

詳細はもご覧ください。

ThunderbitのAI活用で、スクリプト作成に悩む時間を減らし、ビジネス価値のあるデータ取得に集中できます。開発者もビジネスユーザーも、最速でウェブデータを活用できるのが魅力です。

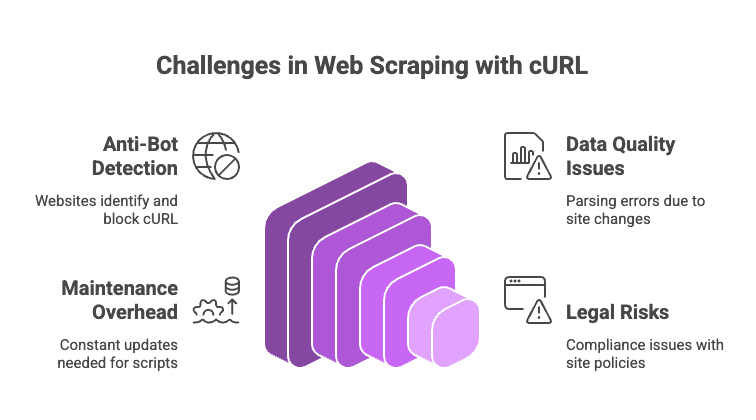

cURLウェブスクレイピングの落とし穴と対策

2025年のウェブスクレイピングは一筋縄ではいきません。注意すべきポイントと対策をまとめました。

- ボット対策:CloudflareやAkamai、DataDomeなどの高度な防御はcURLをすぐ検知。ヘッダー偽装しても、JavaScript実行やTLS指紋などで見抜かれます。CAPTCHAが出たらcURLでは突破できません。

- データ品質・一貫性:HTMLを正規表現やgrepでパースするのは脆弱。サイト構造が変わるとスクリプトがすぐ壊れます。

- メンテナンス負荷:サイトが変わるたびにコード修正が必要。

- 法的・コンプライアンスリスク:利用規約やプライバシーポリシーは必ず確認しましょう。「できる」からといって「やっていい」とは限りません。

プロのコツ:

- ブロックされやすい場合はUser-AgentやIPをローテーション

- リクエスト間にランダムな遅延を入れる

- JSONは

jq、HTMLはhtmlqでパース - 動的・保護されたサイトはThunderbitやスクレイピングAPIなどブラウザベースのツールに切り替え

落とし穴と回避策の詳細はも参考に。

まとめ:2025年の最適なウェブスクレイピング手法とは

私の結論:cURLはAPIや静的ページ、デバッグなど「ピンポイントで素早く試したい」用途に今も最強です。サイトの可能性を探るには最速の選択肢。

一方、構造化データや動的コンテンツ、ビジネス向けのワークフローが必要なら、ThunderbitのようなAIウェブスクレイパーが圧倒的に効率的。手作業を省き、複雑なサイトにも対応し、必要な場所にデータを即座に届けます。

つまり、用途に応じて最適なツールを選びましょう。小規模・スクリプト化重視ならcURL、大規模・動的・チーム利用ならThunderbitが頼りになります。

よくある質問:2025年版cURLウェブスクレイピング

1. cURLでJavaScript生成のデータは取得できますか?

できません。cURLは初期HTMLしか取得できないため、JavaScriptで後から読み込まれるデータは見えません。APIを探すか、Thunderbitのようなブラウザベースのツールを使いましょう。

2. cURLでブロックされないためのコツは?

現実的なヘッダー(User-AgentやAccept)を設定し、IPやUser-Agentをローテーション、リクエスト間に遅延を入れ、クッキーを再利用しましょう。Cloudflareなど強力な対策にはやヘッドレスブラウザ、スクレイピングAPIの利用も検討を。

3. cURLの出力を構造化データに変換するには?

JSONはjqで、HTMLはgrepやsed、htmlqなどでパース。複雑な場合はPython+BeautifulSoupやThunderbitのAI抽出が便利です。

4. cURLは大規模スクレイピングに向いていますか?

可能ですが、リトライ・エラー処理・プロキシ・データ整形など多くを自作する必要があります。大規模案件はScrapyやブラウザベースのツールの方が効率的です。

5. Thunderbitは従来のcURLスクレイピングと何が違う?

Thunderbitはフィールド自動検出、動的ページ対応、セッション・サブページ管理、ビジネスツールへの直接出力などを自動化。スクリプトやセレクタ不要、メンテナンスも最小限です。

スクレイピングをもっと簡単にしたい方はをぜひお試しください。Chrome拡張もからどうぞ。

「やっぱりターミナルとカーソル点滅が一番落ち着く」という方も、cURLはこれからも現役です。サーバーには優しく、シスアドさんにはコーヒーを忘れずに。

ウェブスクレイピングや自動化、AI活用の最新ノウハウはで随時発信中!