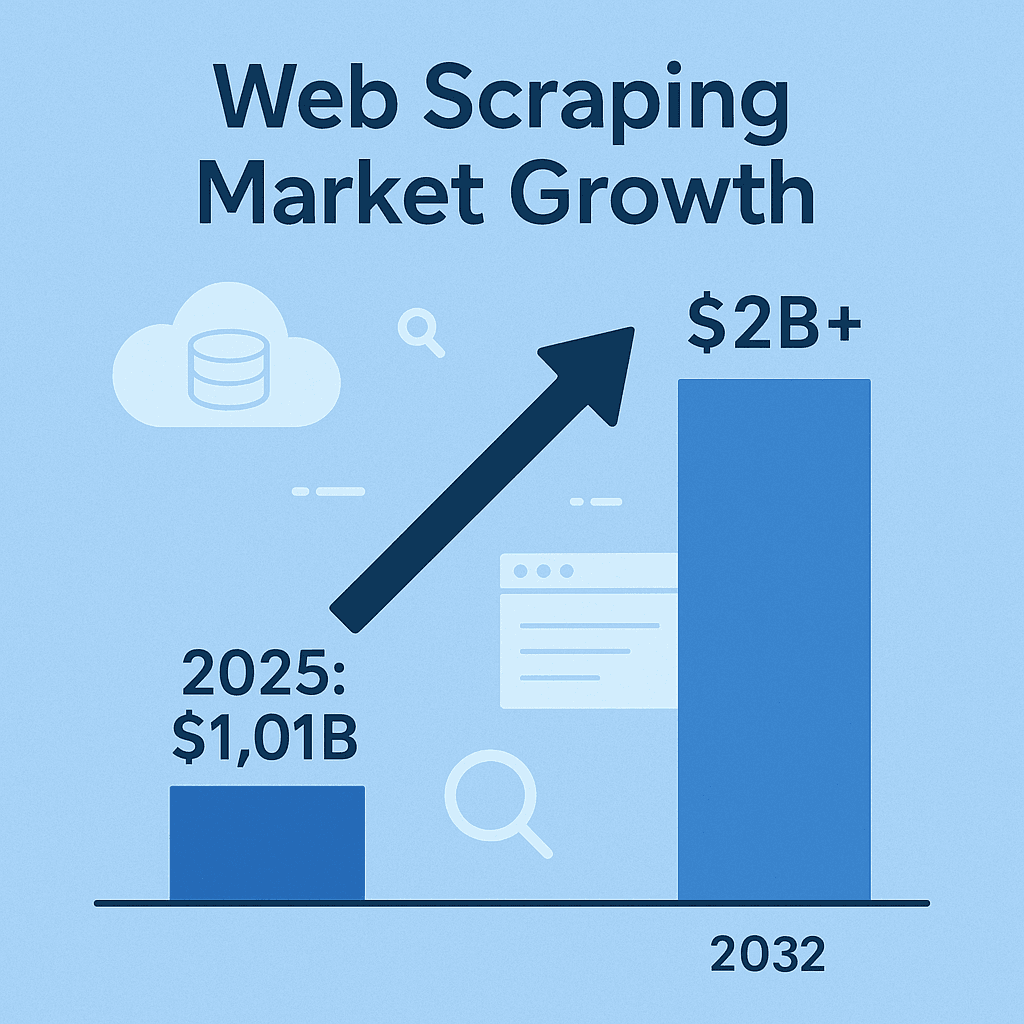

ウェブスクレイピングは、今やビジネスインテリジェンスや営業、マーケットリサーチの現場で欠かせないツールになっています。競合の価格や商品リスト、市場の動向、リード情報など、ウェブ上のデータを集めていない会社は、すでにデータを活用しているライバルに差をつけられているかもしれません。実際、ウェブスクレイピング関連のソフトウェア市場はに到達し、2032年にはさらに倍増する見込みです。これは一時的なブームではなく、業界全体を揺るがす大きな流れです。Pythonがよく話題になりますが、Javaも今なお、信頼性・スピード・大規模システムとの連携を重視する現場で根強い人気があります。

SaaSや自動化の現場で長年やってきた自分の経験から言うと、Javaによるウェブスクレイピングは今も現役バリバリ。特に、安定性やマルチスレッド処理、大規模データ基盤との連携が求められるエンタープライズ領域では外せません。ただ、スクレイピングは単にデータを取るだけじゃなく、効率的かつクリーンに、そして(法的なトラブルを避けるためにも)コンプライアンスを守ってやることが大事です。ここからは、Javaでウェブスクレイピングを極めるためのベストプラクティスを、AIウェブスクレイパーの活用も交えて紹介します。

Javaで始めるウェブスクレイピング:基本の流れ

ウェブスクレイピングは、プログラムでウェブサイトから自動的に情報を抜き出す技術です。基本の流れはシンプルで、HTTPリクエストでページを取得し、HTMLを解析して必要なデータ(価格、商品名、レビューなど)を抽出し、CSVやJSON、またはデータベースに保存します()。

なぜJavaなのか? Pythonは手軽なスクリプト用途で人気ですが、Javaは大規模・長時間稼働・高信頼性が求められる現場で重宝されています。静的型付けで堅牢、ネットワークやHTML解析、並列処理のライブラリも豊富。既存のデータ基盤や分析システムがJavaベースなら、シームレスに連携できるのも大きな強みです()。

つまり、Java製のスクレイパーは長時間・大規模なデータ収集に強く、エンタープライズ環境との相性も抜群。ただし、目的やサイトの特性に合わせて最適なツール選びが大切です。

Javaで使える代表的なウェブスクレイピングライブラリ

ここからは、Javaでよく使われるウェブスクレイピング用ライブラリを紹介します。それぞれ特徴や得意分野が違います。

| ツール | 得意分野 | 強み | 制約 |

|---|---|---|---|

| Jsoup | 静的HTMLページ、シンプルな抽出 | 軽量・APIが直感的・高速・簡単な用途に最適 | JavaScriptや動的コンテンツには非対応 |

| Selenium | 動的・インタラクティブなサイト | 実ブラウザを自動操作・JS対応・ユーザー操作も再現・コミュニティが大きい | リソース消費大・動作が遅い・UI変更に弱い・ブラウザドライバが必要 |

| HtmlUnit | ヘッドレスブラウジング、簡易JS対応 | 完全Java製・一部JS実行可・外部ブラウザ不要 | Jsoupより遅い・最新JSフレームワークには弱い・アンチブロック機能なし |

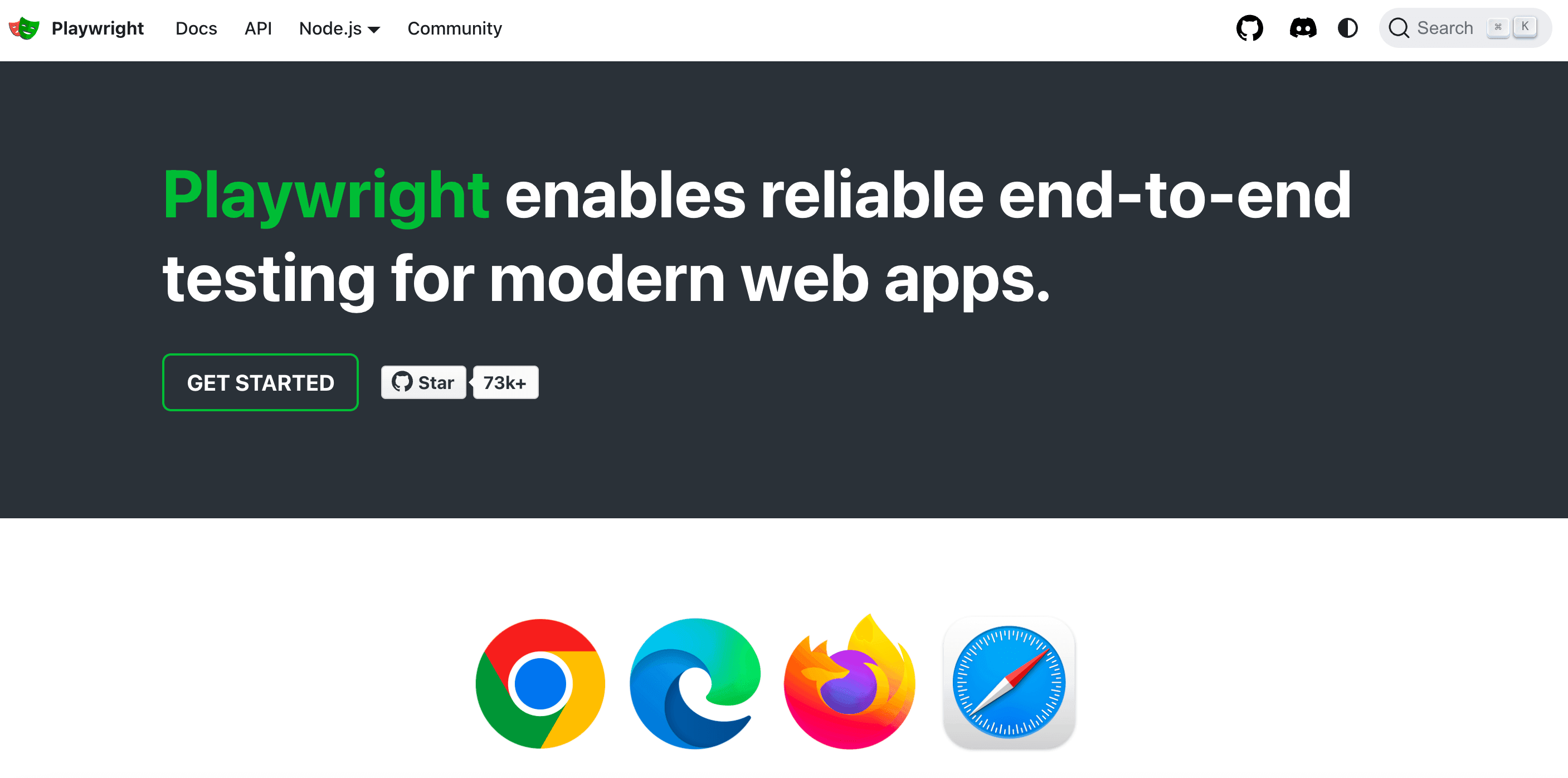

| Playwright | 最新のJS多用サイト、自動化 | 高速・効率的・複数ブラウザ対応・ポップアップや多ページ遷移も自動・自動待機 | エコシステムが新しい・ブラウザリソース必要・JavaでのサポートはSeleniumより少なめ |

(参考:, )

Jsoup:静的HTML抽出の定番

は、静的なウェブページのデータ抽出にぴったりなJavaライブラリです。jQueryみたいな感覚で、Jsoup.connect(URL).get()でページを取得し、CSSセレクタで欲しい要素をサクッと抜き出せます。たとえば、すべての<h1>タイトルや、<div class="product-name">内の商品名も数行で取得できます。

例:ECサイトの商品名を抽出

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoupは高速かつシンプルで、ブログ記事や商品リスト、ニュース記事のスクレイピングに最適。ただし、JavaScriptで生成されるデータには非対応なので、HTMLソースにデータがなければ取得できません。

Selenium・HtmlUnit:動的コンテンツへの対応

JavaScriptで動的に生成されるデータや、ボタン操作が必要な場合はが活躍します。Seleniumは実際のブラウザ(ChromeやFirefoxなど)を自動操作し、人間と同じようにページを操作してデータを取得できます。

HtmlUnitはより軽量なJava製ヘッドレスブラウザで、一部のJavaScriptも実行可能。ただし、ReactやAngularなど最新のJSフレームワークには弱いので、複雑な動的サイトにはSeleniumやPlaywrightを使いましょう。

ヘッドレスブラウザが必要な場面: ログインやボタン操作、JavaScript実行後に表示されるデータの取得にはブラウザ自動化が有効です。ただし、動作が遅くなりやすく、サイトのレイアウト変更にも注意が必要です。

Playwright:次世代の自動化フレームワーク

はMicrosoftが開発した新しい自動化ツールで、Seleniumより40~50%高速、複数のブラウザエンジンに対応し、ポップアップや無限スクロール、多ページ遷移も簡単に処理できます。最新のクライアントサイドレンダリングサイトのスクレイピングには特におすすめです。

プロジェクトに最適なJavaウェブスクレイピングツールの選び方

すべての案件に最強ツールが必要なわけじゃありません。選ぶときのポイントは以下の通りです:

- サイトの複雑さ: 静的HTMLならJsoup、動的JSならSeleniumやPlaywright、簡単なJSならHtmlUnitもOK。

- データ量・頻度: 単発ならシンプルに。大規模・定期的な収集なら並列処理やエラー耐性のあるツールを。

- 使いやすさと柔軟性: Jsoupは習得が簡単。Selenium/Playwrightは高機能だけど設定や保守が必要。

- 要件・予算: オープンソースは無料だけど全部自作・保守が必要。APIやクラウドサービスは時短できるけどコストがかかる。

選定マトリクス:

| 基準 | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| 静的HTML | ✔️ | ✔️ | ||

| 動的JS | ✔️ | (一部) | ✔️ | |

| 高速性 | ✔️ | ✔️ | ||

| 使いやすさ | ✔️ | |||

| ログイン・クリック対応 | ✔️ | (基本) | ✔️ | |

| 大規模・並列処理 | ✔️ | (やや難) | (可) | ✔️ |

| コストパフォーマンス | ✔️ | ✔️ | ✔️ | ✔️ |

まずはシンプルな構成から始めて、必要に応じて拡張しましょう。複数ツールの組み合わせもアリです。

Thunderbit:Java開発者のためのウェブスクレイピングをもっと簡単に

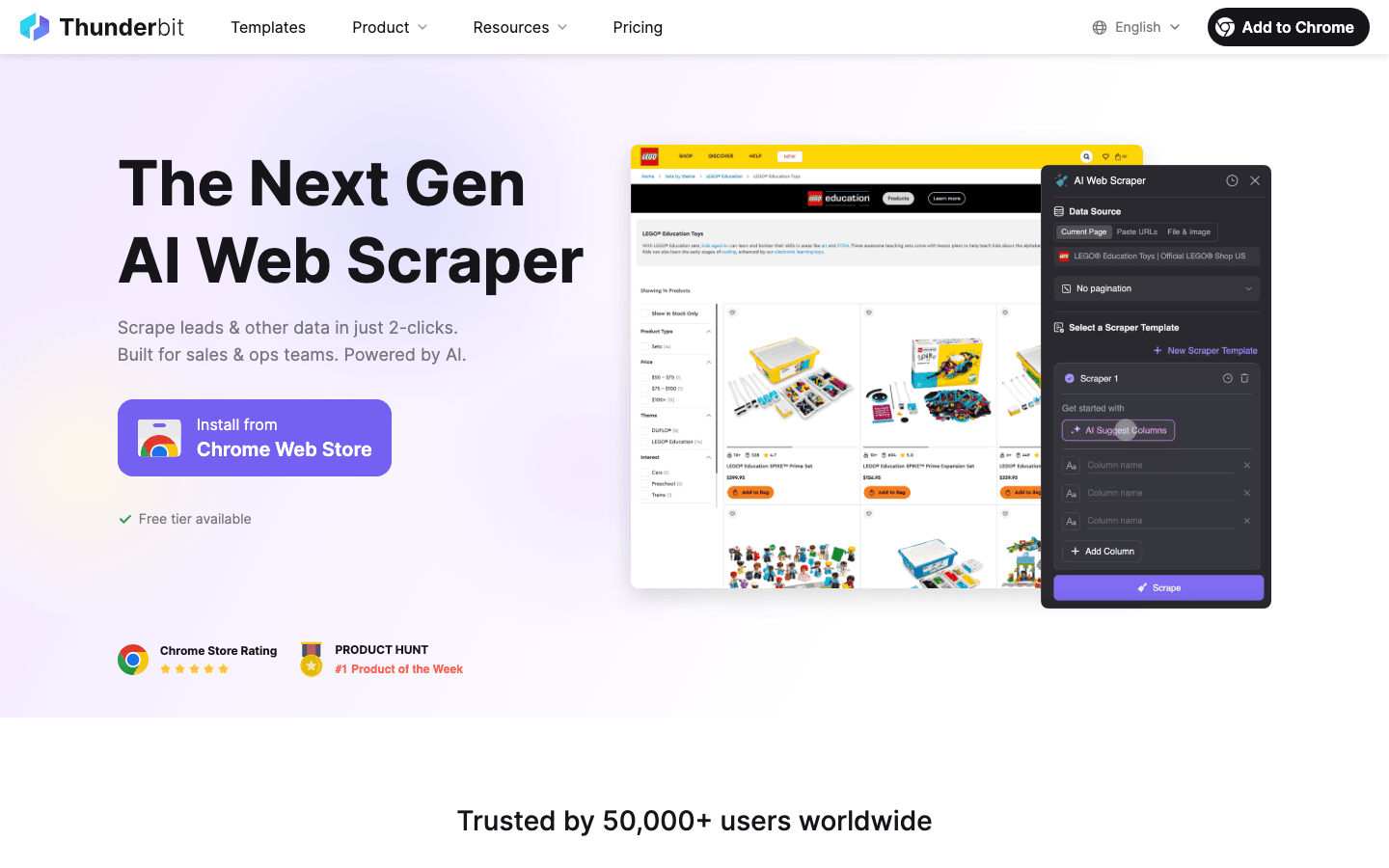

ここで、現場で「ゲームチェンジャー」と感じているのがです。ThunderbitはAIウェブスクレイパーのChrome拡張機能で、数クリックでどんなサイトからでも構造化データを抽出できます。コーディングもテンプレートも不要、直感的に使えます。

ThunderbitがJava開発者やビジネスユーザーに選ばれる理由:

- AIによるフィールド自動検出: ページをAIが解析し、最適なカラムを自動提案。CSSセレクタ探しやパースコードの手間が不要。

- サブページ自動遷移: 詳細ページへのリンクも自動で辿り、データを拡充。商品リスト+詳細情報も一括取得。

- ページネーション・無限スクロール対応: 「次へ」ボタンやスクロールも自動で処理し、全データを収集。

- 多彩なエクスポート: Excel、Google Sheets、Airtable、Notionへ直接出力。CSV/JSONでダウンロードしJavaアプリに連携も可能。

- クラウド・ブラウザ両対応: クラウドで最大50ページ同時処理、ログインが必要なサイトはブラウザで実行。

- スケジューリング: 毎日・毎週・カスタムスケジュールで自動実行。自然言語で「毎週月曜9時」などもOK。

Java開発者にとって、Thunderbitはプロトタイピングやクイックなデータ収集、さらには非エンジニアのチームメンバーにもデータ収集を任せたい時に大きな時短効果を発揮します。

Thunderbitが営業・オペレーション現場にもたらす価値

Thunderbitは開発者だけのものじゃありません。営業・マーケティング・EC運用・不動産チームなど、日々いろんな現場で活用されています。

- リード獲得: ディレクトリやLinkedIn、イベント参加者リストから連絡先を簡単抽出。コーディング不要。

- 競合モニタリング: 競合の価格や商品リスト、マーケティング施策を定期的に自動収集。

- リスト集約: 複数サイトから商品・物件・求人情報を一つの表にまとめて管理。

「このデータが欲しい」と思ってから、10分以内にスプレッドシート化できることも珍しくありません。サブページ抽出やAIによるフィールド検出で、複雑なサイトも簡単に攻略できます。

Javaウェブスクレイピングでデータ品質を担保するポイント

データを集めるだけじゃダメ。データが不正確・不完全・古いままだと、意思決定を誤るリスクがあります。自分が実践している品質管理のコツを紹介します:

- バリデーションとクレンジング: 正確性・完全性・一貫性をチェック。Javaの型安全性を活かし、異常値(例:「N/A」など)を検出。日付・通貨・電話番号などのフォーマットも統一()。

- 重複排除: スクレイピングデータは重複しやすいので、URLやIDなど一意キー+JavaのSetコレクションで管理。

- 自動品質チェック: 取得件数や空欄フィールドの有無を自動チェック。異常時はログやアラートで即対応。

- データの適切な保存: 大規模案件はデータベース(Postgres、MongoDB等)に保存し、スキーマ管理や重複排除を効率化()。

エラー処理と堅牢性:信頼できるスクレイパーの作り方

ウェブスクレイピングは「接触型スポーツ」と言われるほど、サイトの変化や障害がつきものです。以下の工夫で安定稼働を目指しましょう:

- エラー処理の徹底: HTTPエラー(404, 500)、タイムアウト、パース例外をキャッチ。失敗時は指数バックオフでリトライ()。

- 変化への耐性: セレクタの堅牢化、nullチェック、フォールバック処理。構造変化時は生HTMLをログ保存。

- ログ・アラート: 取得・成功・失敗をすべて記録。想定外の件数やエラー時はアラート通知。

- チェックポイント保存: 長時間処理では定期的に進捗を保存。クラッシュ時も途中から再開可能に。

- リクエスト制御: サーバーに優しく。リクエスト間隔を空け、同時接続数を制限、User-Agentもローテーション。

Javaでのリトライ例:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Attempt " + attempt + " failed: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // 指数バックオフ

9 }

10}(参考:)

法令遵守:ウェブスクレイピングの法律・倫理ポイント

ウェブスクレイピングは「何でもあり」じゃありません。ルールを無視すると、アクセス禁止や法的トラブルのリスクも。

- データの所有権を尊重: 公開・非機密データの取得は一般的に合法ですが、個人情報(氏名・メール等)はGDPRやCCPAなどで厳しく規制。正当な根拠なくPIIを取得しない()。

- 利用規約・robots.txtの遵守: サイトが「スクレイピング禁止」と明記している場合はリスクを認識。robots.txtやレート制限も必ず守る。

- サーバー負荷をかけない: リクエスト間隔や同時接続数を調整し、サイト運営に迷惑をかけない()。

- 著作権・ログイン保護コンテンツの回避: 著作権のあるコンテンツの再利用や、許可なくログインが必要なデータの取得はNG。

- データの安全管理・匿名化: 機密情報は安全に保管し、削除依頼にも対応。

倫理的なウェブスクレイピングの実践ポイント

- 事前に利用規約・robots.txtを確認

- 意味のあるUser-Agentを設定(例:「Java/1.8.0_201」だけは避ける)

- リクエスト頻度・同時接続数を制限

- 可能な限りAPIや公開データセットを利用

- 取得データとその目的を記録

- 法律や最新のベストプラクティスを常にチェック()

パフォーマンス最適化:Javaウェブスクレイパーのスケーリング術

スクレイピング規模が大きくなると、パフォーマンスが重要になります。効率的に拡張するコツを紹介します:

- リクエストの並列化: Javaの

ExecutorServiceやスレッドプールで複数ページを同時取得。サイトへの負荷も考慮()。 - データのストリーミング保存: 取得結果は都度DBやファイルに書き出し、メモリ消費を抑制。

- 効率的なパース: Jsoupのセレクタで必要な部分だけ抽出。大規模案件はストリーミングや軽量パーサも検討。

- クラウドリソース活用: クラウドサーバーで実行し、帯域や信頼性を確保。Thunderbitのクラウドモードも大規模案件に有効。

- ネットワーク最適化: 圧縮利用、ターゲットに近いサーバー配置、レスポンスのキャッシュ活用。

Javaでのマルチスレッド例:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();(参考:)

まとめ:Javaウェブスクレイピング成功のポイント

Javaでウェブスクレイピングを極めるためのポイントをおさらいしましょう:

- 最適なツール選び: 静的ページはJsoup、動的サイトはSelenium/Playwright、Javaだけで完結したいならHtmlUnit。

- 自動化・AIの活用: のようなツールでフィールド検出やサブページ抽出、データ出力を効率化。ビジネスユーザーやプロトタイピングにも最適。

- データ品質の重視: バリデーション・クレンジング・重複排除・適切な保存を徹底。

- 法令遵守: 公開データのみ取得、サイトルール遵守、個人情報は正当な根拠がある場合のみ。

- スケール対応: Javaの並列処理・効率的な保存・クラウド活用で大規模案件にも対応。

ウェブスクレイピングは単なる技術じゃなく、ビジネスを加速させる武器です。堅牢なJavaスクレイパーを作る開発者も、Thunderbitでデータ収集を自動化する営業・運用担当者も、これらのベストプラクティスを押さえれば、チームの成果を大きく伸ばせます。

AI搭載のスクレイピングを体験したい人は、をダウンロードして、どんなウェブサイトも簡単に構造化データに変換してみてください。さらに詳しく知りたい人は、で最新のチュートリアルや比較記事、実践事例もチェックできます。

よくある質問(FAQ)

1. なぜJavaはウェブスクレイピングで今も選ばれるのですか?

Javaは信頼性・マルチスレッド処理・エンタープライズシステムとの連携に強いです。大規模・長時間・高パフォーマンスが求められる案件や、既存のデータ基盤がJavaの場合に特に最適です()。

2. Jsoup・Selenium・HtmlUnit・Playwrightの違いは?

Jsoupは静的HTML向け、SeleniumとPlaywrightは動的・JS多用サイト向け、HtmlUnitはJava製ヘッドレスブラウザで簡易JS対応。サイトの複雑さや要件に応じて選びましょう()。

3. ThunderbitはJava開発者やビジネスユーザーにどう役立ちますか?

ThunderbitはAIでフィールド検出・サブページ遷移・データ構造化を自動化。コーディング不要で、ビジネスユーザーやプロトタイピング、非エンジニアのデータ収集にも最適です()。

4. ウェブスクレイピングでデータ品質を担保するベストプラクティスは?

データのバリデーション・クレンジング・重複排除・自動品質チェック・大規模案件はDB保存を徹底。取得データは必ず加工・精査しましょう()。

5. 法令遵守・倫理的にウェブデータを取得するには?

公開・非機密データのみ取得、robots.txtや利用規約を守る、サーバー負荷をかけない、個人情報は正当な根拠がある場合のみ。GDPRやCCPAなど最新法令も要チェック()。

ウェブスクレイピングをさらに極めたい人は、Thunderbitを無料で試すか、ここで紹介したベストプラクティスを参考にJavaスクレイパーを作ってみてください。安全・倫理的に、そしてデータの品質を常に意識して取り組みましょう。

さらに学ぶ