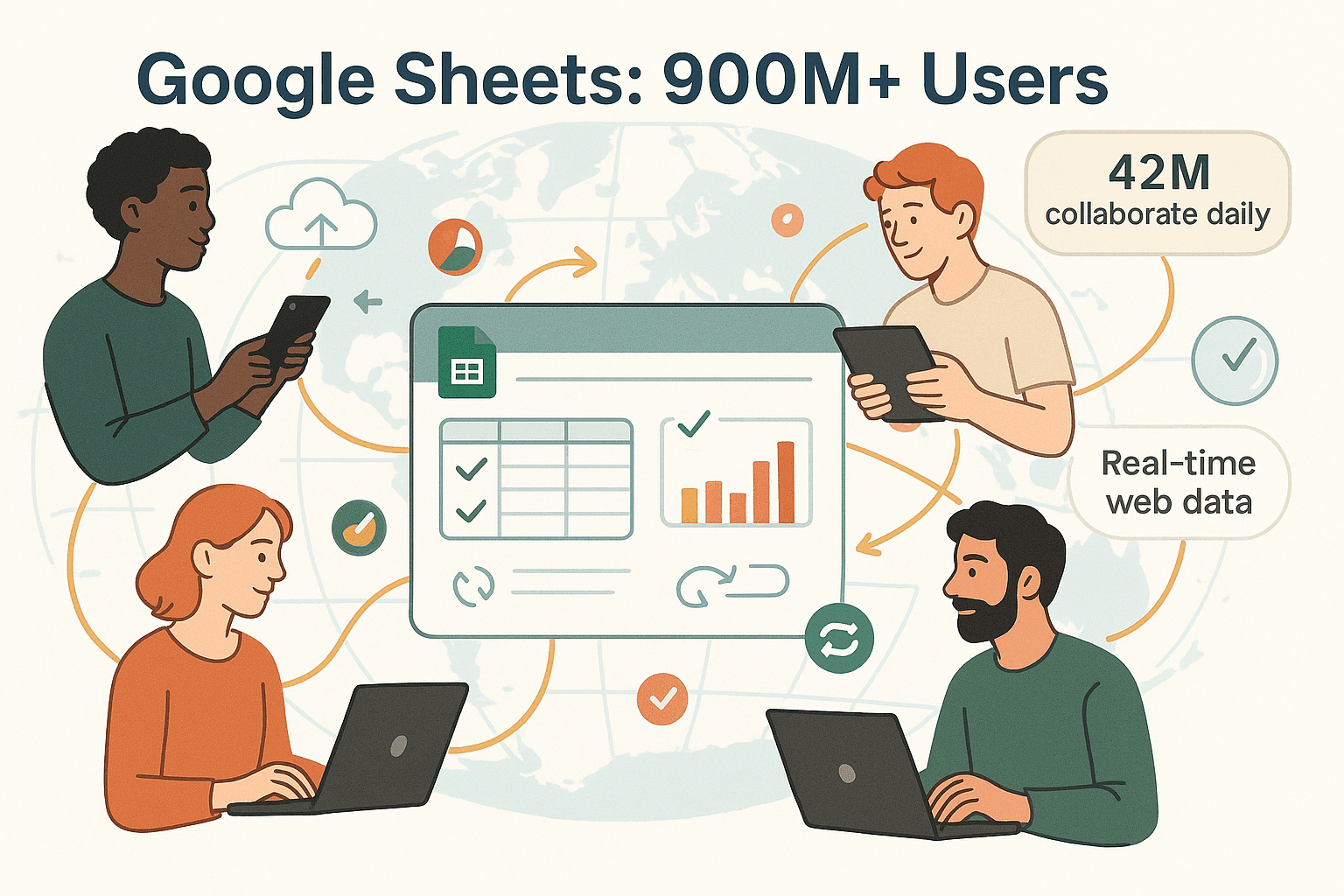

Googleスプレッドシートが「ビジネスデータのオールラウンダー」と呼ばれるのは伊達じゃありません。スピーディーでコラボにも強く、日々の業務で手放せない人も多いですよね。でも、会社がデータドリブンに進化していく中で、本当に大変なのは「グラフをきれいに作ること」じゃなくて、「新鮮で信頼できるウェブデータを、手作業でコピペせずにスプレッドシートへ取り込むこと」なんです。営業チームがリードリストの更新に毎週何時間もかけたり、オペレーション担当が価格表の変化に追いつけなかったり…そんな光景、何度も見てきました。

ウェブデータをGoogleスプレッドシートに取り込もうとしたことがある人なら、その大変さは身にしみてるはず。手入力は遅いしミスも多いし、IMPORTHTMLやIMPORTXMLみたいな関数も、動的なウェブサイトだとエラーばかり返してきます。そこで今回は、昔ながらのGoogleスプレッドシートのテクニックと、みたいなAI搭載の最新ツールを使って、ウェブデータ抽出をもっとラクに、楽しくする方法を紹介します。実践的な手順やよくある落とし穴、Googleスプレッドシートを“自動更新ダッシュボード”に変えるコツも解説します。

なんでウェブデータ抽出をGoogleスプレッドシートで自動化するの?

正直、誰も「ウェブサイトからスプレッドシートにデータをコピペする作業」をやりたいわけじゃないですよね。でも、、している今、最新で正確なウェブデータのニーズはどこにでもあります。営業は新しいリード、オペレーションはリアルタイムの価格表、アナリストは新鮮な市場データ——全部スプレッドシートで、しかも常に最新の状態で管理したいんです。

ウェブデータ抽出を自動化すると、現代のチームにはこんなメリットが:

ウェブデータ抽出を自動化すると、現代のチームにはこんなメリットが:

- 時間の節約: 自動化でが単純作業から解放されます。

- 精度アップ: 手入力はがあり、大量データだとミスも増えがち。

- リアルタイム性: 自動更新で、いつでも最新データをキープ。

- スケーラビリティ: 10行でも1万行でも、手間は変わりません。

- コスト効率: 単純作業が減れば、もっと価値ある仕事に集中できます。

つまり、ウェブデータの自動化は単なる効率化じゃなく、チームの競争力を底上げする武器なんです。

従来のウェブデータ収集方法の限界

昔ながらのやり方といえば、手作業のコピペやCSVダウンロード。少量なら問題ないけど、定期的な更新や動的なデータが必要になると、すぐに限界が見えてきます。

主な課題はこんな感じ:

| 方法 | メリット | デメリット |

|---|---|---|

| 手作業コピペ | シンプル、準備不要 | 遅い、ミスが多い、拡張性なし、静的なスナップショットのみ |

| CSVエクスポート/インポート | 構造化されていて速い | 最終ダウンロード時点のデータのみ、エクスポート機能のあるサイトに限定 |

| 組み込み関数 | ライブ、自動更新 | シンプル/静的なページのみ対応、動的・ログイン必須サイトでは動作しない |

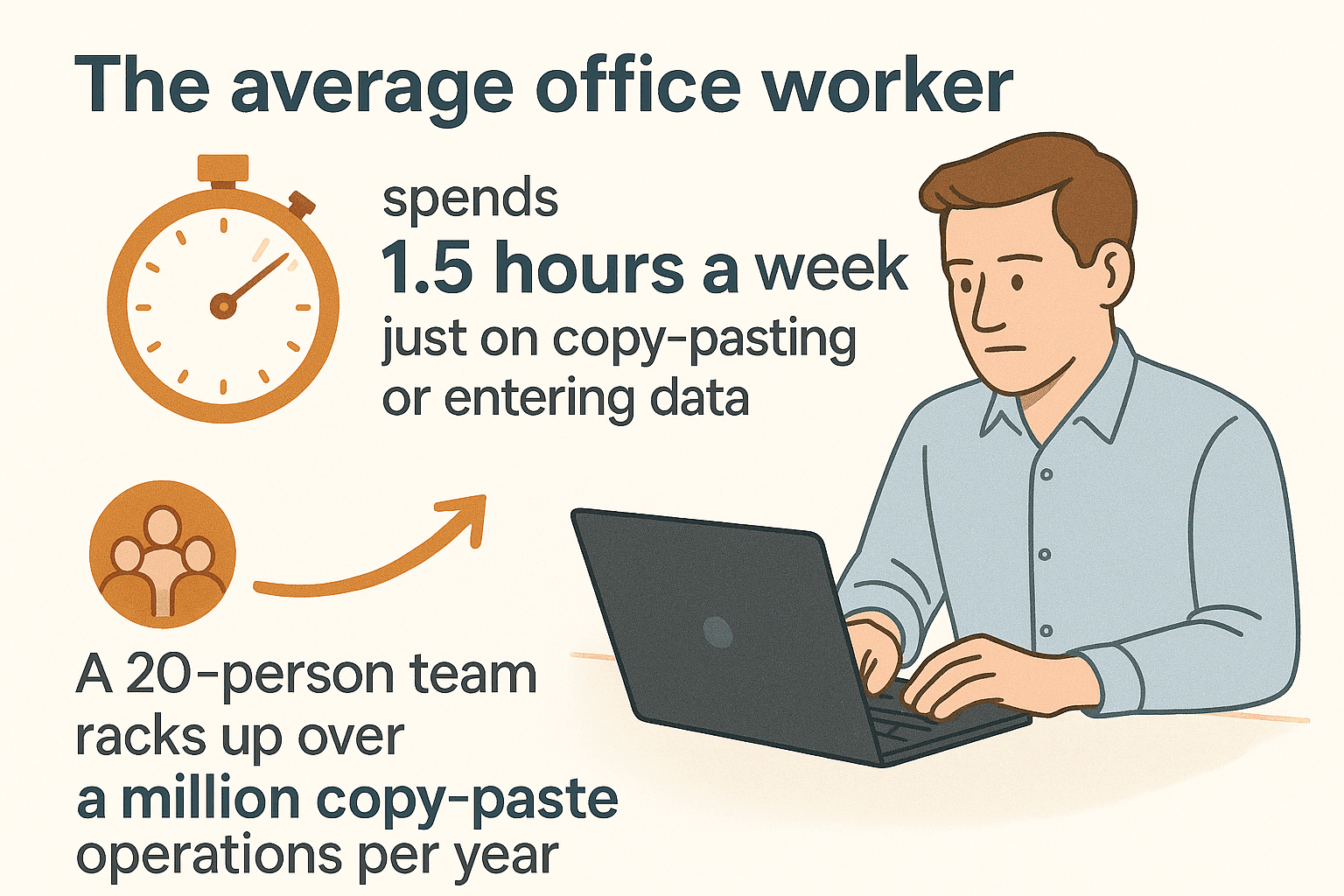

平均的なオフィスワーカーはと言われ、20人のチームなら年間100万回以上のコピペ操作が発生します。ミスも増えるし、時間ももったいないですよね。

手作業の方法だと、

手作業の方法だと、

- 動的コンテンツ: JavaScriptで後から読み込まれるデータには対応できません。

- ページ分割: 複数ページにまたがるデータは半分以上見落としがち(参照)。

- 一貫性のなさ: 疲れてたり集中力が切れるとミスが出やすい。

- リアルタイム性なし: 作業が終わる頃にはデータが古くなってることも。

つまり、ちょっと本格的な用途には、もっと賢い方法が必要なんです。

Googleスプレッドシートの組み込み関数でウェブデータを取得する

Googleスプレッドシートには、ウェブ上の公開データを直接取り込める“import”系関数がいくつか用意されています。これらは簡易的なウェブスクレイパーみたいなもので、追加の拡張機能は不要。主な関数は以下の通り:

- IMPORTHTML: 公開ウェブページのテーブルやリストを取得

- IMPORTXML: XPathクエリで特定要素を抽出

- IMPORTRANGE: 他のGoogleスプレッドシートからデータを連携

- IMPORTDATA: 公開URLのCSVやTSVファイルをインポート

- IMPORTFEED: RSSやAtomフィードを取得

それぞれの使い方や得意・不得意を見ていきましょう。

IMPORTHTML:テーブルやリストの抽出

使い方:

=IMPORTHTML("URL", "table" または "list", インデックス番号)

例:

天気サイトの最初のテーブルを取得する場合:

=IMPORTHTML("https://weather.gc.ca/canada_e.html", "table", 1)

得意なケース:

- Wikipediaのリストや株価表など、公開HTMLのテーブルやリスト

注意点:

- 静的HTMLのみ対応(JavaScriptで生成されたデータは不可)

- 正しいテーブル/リスト番号を指定する必要あり

- ログインが必要なサイトや動的サイトでは使えません

IMPORTXML:XPathで柔軟にデータ抽出

使い方:

=IMPORTXML("URL", "XPathクエリ")

例:

商品ページの価格をすべて取得:

=IMPORTXML("https://example.com/product123", "//span[@class='price']")

得意なケース:

- HTML構造から特定要素(メタタグ、リンク、カスタムフィールドなど)を抽出

注意点:

- XPathやHTMLの知識が必要

- サイト構造が変わると動かなくなる

- JavaScriptで後から表示されるデータは取得不可

IMPORTRANGE:シート間のデータ連携

使い方:

=IMPORTRANGE("スプレッドシートURL", "シート名!A1:Z100")

得意なケース:

- 複数のGoogleスプレッドシート間でデータを連携

注意点:

- 両方のシートにアクセス権が必要(初回は「アクセスを許可」する必要あり)

- IMPORTRANGEが多すぎるとシートが重くなる

IMPORTDATAとIMPORTFEED

- IMPORTDATA: 公開URLのCSVやTSVファイルを取得

- IMPORTFEED: RSSやAtomフィード(ニュースやブログなど)を集約

構造化データには便利ですが、公開かつ静的なデータに限られます。

組み込み関数の限界:現場で直面する課題

実際にこれらの関数を使うと、こんな壁にぶつかります:

- JavaScript非対応: IMPORTHTMLやIMPORTXMLは初期HTMLしか見えず、ページ読み込み後のデータは取得できません(参照)。

- ログイン・セッション不可: ログインや有料会員限定のデータにはアクセスできません。

- 脆弱性: XPathやテーブル番号はサイト構造が変わるとすぐに壊れます。

- ページ分割未対応: 1ページ分しか取得できず、「次へ」やスクロールには非対応。

- サイト側のブロック: 一部サイトはGoogleのimport関数自体をブロックしています(参照)。

- 更新頻度の遅さ: データの自動更新は約1時間ごとで、リアルタイムとは言えません。

「Imported content is empty」や#N/Aエラーに悩まされたこと、きっとあるはず。

AIウェブスクレイパーはGoogleスプレッドシートの最強パートナー

ここで登場するのがAIウェブスクレイパー。Googleスプレッドシートの“頼れる相棒”として、みたいなツールは、

- どんなウェブサイトもOK: 動的・JavaScript対応・ログイン必須ページもバッチリ

- フィールド自動検出: Thunderbitの「AIフィールド提案」機能で、コーディングやXPath不要

- ページ分割・サブページも自動処理: 「次へ」ボタンやスクロール、詳細ページ巡回も自動化

- Googleスプレッドシートへワンクリック出力: すぐに分析できる形でデータを転送

- 定期自動更新も可能: スケジュール設定で、常に最新データを維持

技術に自信がなくても、ThunderbitとGoogleスプレッドシートを組み合わせれば、誰でも本格的なデータ自動化が実現できます。営業やオペレーション担当が、コードを書かずに自動データパイプラインを作っている例もたくさんあります。

実践ガイド:ThunderbitでウェブデータをGoogleスプレッドシートに自動連携

Thunderbitを使ってウェブデータをGoogleスプレッドシートに自動で取り込む手順を、技術知識ゼロでもできるように解説します。

1. Thunderbit Chrome拡張機能をインストール

から拡張機能を追加し、無料アカウントを作成します(無料プランで数ページのスクレイピングが体験可能)。

2. 取得したいウェブサイトを開く

データを抽出したいウェブサイト(商品一覧、企業ディレクトリ、競合の価格ページなど)を開きます。ログインが必要な場合は、先にログインしておきましょう(Thunderbitはブラウザで見えている内容を抽出できます)。

3. 「AIフィールド提案」で自動フィールド検出

ChromeツールバーのThunderbitアイコンをクリックし、「AIフィールド提案」を選択。ThunderbitのAIがページを解析し、「商品名」「価格」「評価」など適切なカラムを自動で提案します。必要に応じて編集や追加もOK。

4. メインページ・サブページのデータを抽出

「スクレイピング開始」をクリックすると、Thunderbitが

- ページ分割(「次へ」ボタンやスクロール)を自動処理

- サブページ(商品詳細など)も巡回して詳細データを取得

- すべての情報を構造化テーブルにまとめてくれます

5. Googleスプレッドシートへエクスポート

抽出が完了したら「エクスポート」→「Googleスプレッドシート」を選択。Googleアカウントを認証し、出力先シートを指定すれば、データが即座に転送されます(無料で利用可能)。

定期的な作業には、スクレイパーテンプレートを保存し、スケジュール実行も設定できます。

Thunderbitの「AIフィールド提案」で複雑なページも簡単抽出

複雑で動的なページでも、この機能があれば安心。XPathやテーブル番号を調べる手間なく、ThunderbitのAIが最適なフィールドを自動で提案。たとえばECサイトなら「商品名」「価格」「画像URL」「評価」など、HTMLが複雑でも正確に抽出できます。

これまで数時間かかっていた作業や、エンジニアの手を借りていた業務も、わずか数クリックで完了。特に営業やオペレーション担当が、スクレイピングに最適化されていないサイトから構造化データを抜き出すときに大活躍します。

Thunderbitで動的・複数ページのデータも自動取得

Thunderbitは、複数ページや「もっと見る」ボタンの裏に隠れたデータ抽出も得意。AIエンジンが

- ページ分割を自動検出しクリック

- 無限スクロールページも自動で下まで取得

- サブページ(商品詳細やプロフィールなど)も巡回し、追加情報をテーブルに統合

たとえば不動産リストを抽出する場合、メインページで概要を取得し、各物件の詳細ページで連絡先や設備情報もまとめて1つのスプレッドシートに整理できます。

Thunderbitの動的・複数ページ対応力は、Googleスプレッドシートで最新かつ網羅的な情報を管理したい人にとって大きな武器になります。

Googleスプレッドシート×Thunderbit定期スクレイピングでリアルタイム自動更新

「毎朝自動でGoogleシートを最新化したい」——そんなニーズもThunderbitのスケジュールスクレイピングで簡単に実現できます。

- Thunderbitで通常通りスクレイピング設定

- 「スケジュール」を選び、英語で「毎日8時」など実行間隔を指定

- 出力先にGoogleスプレッドシートを選択

- 保存してスケジュールを有効化

これで指定したタイミングで自動的にスクレイピングが実行され、最新データがシートに反映されます。たとえば、

- 価格監視

- リードリストの自動更新

- 在庫管理

- ニュースやSNSダッシュボード

など、Googleスプレッドシートのスクリプトやアドオンと組み合わせれば、強力なリアルタイム業務ダッシュボードが作れます。

Googleスプレッドシートでウェブデータを安定運用するコツ

データパイプラインを安定稼働させるためのポイント:

- 用途に応じてツールを選ぶ: シンプルな静的ページはIMPORTHTML/IMPORTXML、動的・複数ページ・ログイン必須サイトはThunderbitを活用

- データの整形: ThunderbitのフィールドAIプロンプトで抽出時に整形・分類、またはシート上で後処理

- エラー監視: データが突然消えた場合は、サイト構造やログイン要件の変更を確認

- クォータ管理: Googleスプレッドシートの外部データ取得回数には上限があるので、import関数の多用は避ける

- 重要データのバックアップ: 重要なダッシュボードは定期的に別タブやファイルにアーカイブ

さらに詳しいトラブルシューティングや応用テクは、やをチェック!

まとめ:Googleスプレッドシート×ウェブデータの真価を引き出す

結論として、Googleスプレッドシートの組み込み関数は、シンプルで公開されたデータの取得には最適。でも、動的・複雑・業務クリティカルな用途には、みたいなAIウェブスクレイパーとの組み合わせが最強。スプレッドシートの手軽な分析・共同作業と、どんなウェブデータも自在に取得できるパワーを両立できます。

手作業で毎週何時間もかかっていた更新作業が、今では自動で最新化されるライブダッシュボードに。データの精度も意思決定のスピードもアップ、チームの満足度も上がります(コピペ疲れともお別れ!)。

ぜひ一度して、最初のスクレイピングを体験してみてください。さらに高度なワークフローに興味があれば、で詳しい解説やチュートリアルもチェックしてみてください。

よくある質問(FAQ)

1. Googleスプレッドシートにウェブデータを取り込む一番簡単な方法は?

シンプルで静的なテーブルやリストなら、IMPORTHTMLやIMPORTXML関数が便利。動的・ページ分割・ログイン必須の場合は、みたいなAIウェブスクレイパーを使おう。

2. IMPORTHTMLやIMPORTXMLでエラーや空データになるのはなぜ?

これらの関数はページの初期HTMLしか取得できません。JavaScriptで表示されるデータや、ログインが必要な場合、またはサイト側がGoogleのアクセスをブロックしている場合は、エラーや空データになります。

3. ThunderbitはGoogleスプレッドシートとどう連携しますか?

Thunderbitでウェブサイトからデータを抽出し、ワンクリックでGoogleスプレッドシートにエクスポートできます。定期的な自動スクレイピングも設定可能です。

4. Thunderbitは複数ページやサブページのデータも取得できますか?

はい。ThunderbitのAIは自動でページ分割をクリックしたり、サブページ(商品詳細など)も巡回して、すべてのデータを1つのテーブルにまとめます。

5. ThunderbitをGoogleスプレッドシートと無料で試せますか?

もちろん!には無料プランがあり、スクレイピングやGoogleスプレッドシートへのエクスポートを気軽に体験できます。

ビジネス自動化のヒントをもっと知りたい人は、以下のガイドもどうぞ:

自動化で、あなたのスプレッドシートがいつも新鮮で、コピペ疲れから解放されますように!

さらに詳しく