正直なところ、2025年の今、ウェブは猫のミームやSNSを眺めるだけの場所じゃなく、ビジネスデータの宝庫になっています。営業、EC、マーケティング、不動産など、どの業界でもウェブ上のデータを集めて整理し、活用したいというニーズがどんどん高まっています。でも、ウェブスクレイピングツールは星の数ほどあって、どれを選べばいいのか迷ってしまうのが現実。まるでスーパーのシリアルコーナーで「一番おいしい」と書かれた箱を前に立ち尽くすようなものです。

私自身、SaaSや自動化の現場で長年仕事をしてきましたが、ピッタリのウェブスクレイパーを使えば、面倒なコピペ作業もたった2クリックで終わることを何度も経験しています。ただし、すべてのツールが同じではありません。開発者向け、ビジネスユーザー向け、「とにかくデータだけ欲しい!」という人向けなど、用途もさまざま。このガイドでは、2025年におすすめのウェブスクレイピングツール17選を、AIウェブスクレイパー(など)、ノーコード型、API、Pythonライブラリまで幅広く紹介します。実際のユーザー評価や料金、そして私自身の視点から、それぞれの特徴や強み・弱みをわかりやすく解説します。

早見表:主要ウェブスクレイピングツール比較

細かい説明の前に、2025年注目のウェブスクレイピングツール17種を一覧で比較してみましょう。カテゴリ、料金、使いやすさ、自動化・AI機能、エクスポート形式、連携、ユーザー評価(、、、Chromeストア)、そしてどんなユーザーに向いているかをまとめています。(すべてのツールが万人向けというわけではありません)

...

各ツールの詳しい機能やメリット・デメリットは、本文でさらに解説します。もっと詳しいレビューや活用事例はもぜひチェックしてみてください。

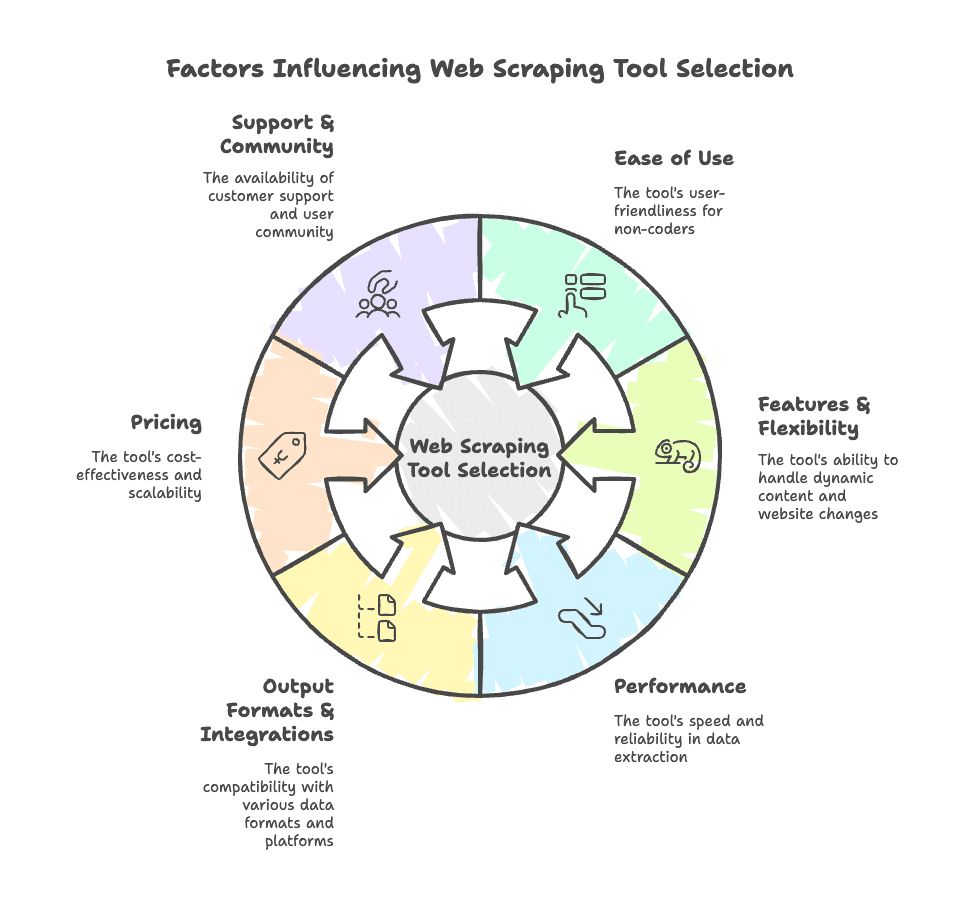

自分に合ったウェブスクレイピングツールの選び方

- 使いやすさ: コーディングが得意?それともコマンドラインを見るだけで拒否反応が出るタイプ?やBrowse AIのようなツールは非エンジニア向け、ScraperAPIやSeleniumは開発者向けです。

- 機能・柔軟性: 動的コンテンツやログイン、ページネーション、アンチボット対策に対応しているか?サイト構造が変わっても柔軟に対応できるか?

- パフォーマンス: 抽出の速さや安定性は十分か?IPブロックを回避し、大量データにも対応できるか?

- 出力形式・連携: CSV、Excel、Google Sheets、Airtable、Notion、CRMなどにエクスポートできるか?

- 料金: 無料枠や手頃なプランはあるか?利用量に応じてスケールできるか?

- サポート・コミュニティ: サポート体制やドキュメント、ユーザーコミュニティは充実しているか?

特に営業や業務部門の方は、自分のITスキルや業務フローに合ったツールから始めるのがオススメ。リード獲得や競合調査を自動化したいなら、AIウェブスクレイパーやノーコード型が最適。開発チームがある場合や大規模運用なら、APIやPythonライブラリも選択肢です。

ツール選びの詳しいポイントはも参考にしてみてください。

AIウェブスクレイパー:次世代のウェブスクレイピングツール

今、注目を集めているのがAIウェブスクレイパー。これは特に非エンジニアにとっては革命的な存在です。従来のツールのようにCSSセレクタやXPathをいじる必要はなく、AIが人間のようにページを「読んで」自動で必要なデータを抽出してくれます。面倒な設定や「またスクレイパーが壊れた!」というストレスからも解放されます。

AIウェブスクレイパーの特徴

- CSSセレクタ不要: AIがページ構造や内容を解析してくれるので、セレクタ探しやレイアウト変更への対応が不要。

- セットアップが速い: ほとんどのAIウェブスクレイパーは数クリックでデータ抽出が可能。欲しい情報を伝えるだけでOK。

- 高精度: AIはごちゃごちゃしたページや非構造化データも処理でき、要約・分類・翻訳も自動でやってくれます。

- メンテナンス不要: サイト構造が変わってもAIが自動で適応。毎週スクレイパーを作り直す必要はありません。

営業、EC、不動産などでリードや商品リスト、物件情報をノーコードで取得したい方には、AIウェブスクレイパーはまさに「次元が違う」選択肢です。

Thunderbit:ビジネスチーム向けAIウェブスクレイパー

ちょっと自社推しですが、それには理由があります。は、ビジネスユーザーの「困った!」を解決するために開発したAIウェブスクレイパーです。

主な機能:

- AIフィールド提案: 「AIフィールド提案」をクリックするだけで、Thunderbitがサイトを読み取り、カラム名を自動で提案・設定します。

- サブページ抽出: 商品やリストの詳細ページも自動で巡回し、データを拡充します。

- 即時データエクスポート: 抽出データはExcel、Google Sheets、Airtable、Notion、CSV/JSONで無料エクスポート可能。

- 多様なデータ型: テキスト、数値、日付、URL、メール、電話番号(自動整形)、画像も抽出。

- テンプレート搭載: Amazon、Zillow、Instagram、Shopifyなど主要サイトはワンクリックで使えるテンプレートを用意。

- AI自動入力: AIがオンラインフォームの入力やワークフローも自動化(追加料金なし)。

- スケジュール実行: AIによる自然言語指定で定期的な自動抽出も可能。

- 無料のメール・電話・画像抽出: 連絡先や画像もワンクリックで取得。

料金: 無料枠で6ページ(トライアルで10ページ)まで利用可能。有料プランは月額$9(年払い)から5,000クレジットで、利用量に応じて拡張できます。

ユーザー評価: Thunderbitは新しいサービスですが、Chromeウェブストアで4.9★、3万人以上が利用中。「驚くほど簡単」「リード獲得や商品監視の時短に最適」と高評価です。(G2やCapterraでの評価も今後増加予定)

メリット:

- これまでで一番簡単なセットアップ。ITが苦手な方でも使えます。

- AIがページ変更に自動対応。メンテナンス不要。

- ビジネス現場で使う主要ツールに直接エクスポート。

- 連絡先や画像抽出も無料。

デメリット:

- 超大規模な企業向けクロールには不向き(AI処理のためやや時間がかかる)

- 高度な機能や大量利用は有料プランが必要

- Chrome拡張として動作(多くのユーザー向け)。サーバーサイドやヘッドレス用途には非対応

おすすめ: 営業リード抽出、ECのSKU・価格監視、不動産リスト集約など、ノーコードで「ごちゃごちゃしたサイトからきれいなデータを取りたい」方に最適です。

実際の動作を見たい方はやもぜひご覧ください。

Kadoa:AI搭載ウェブスクレイパー

KadoaもAIウェブスクレイパー分野で注目されているツールで、特に大規模なデータ抽出やデータチーム向けに最適化されています。

主な機能:

- AIオーケストレーション: 複数のAIエージェントがサイトを巡回し、ページネーションや構造変化にも自動対応。

- 自己修復型スクレイパー: サイト構造が変わってもAIが抽出ロジックを自動更新。

- 自動データ変換: 内蔵の機械学習モデルでデータを自動クレンジング・マッピング。

- 高いスケーラビリティ: 毎日数百万件規模のデータ抽出も可能。

料金: 無料枠(500クレジット)、有料は月額$39(25,000クレジット)から。エンタープライズ向けプランもあり。

ユーザー評価: まだ新しいためG2やCapterraでの評価は少ないですが、ヘッジファンドやSaaS企業からは「信頼性が高く、メンテナンス負担が減った」と好評です。

メリット:

- ノーコードで一度設定すればほぼ放置でOK

- ログインや多段階ナビゲーションなど複雑なサイトにも対応

- 強力なアンチブロック機能や企業向けオプション

デメリット:

- 機能は進化中で一部は開発途上

- シンプルな用途にはややオーバースペック

- 複雑なワークフロー設定には慣れが必要

おすすめ: 金融分析やECインテリジェンスなど、継続的かつ大規模なデータ抽出が必要な組織向け。

ノーコード/ローコード型ウェブスクレイパー:直感的に使えるツール

AIにすべて任せるのはまだちょっと不安…という方には、ノーコード/ローコード型のウェブスクレイパーがぴったり。プログラミング不要で、画面上でクリックやドラッグ&ドロップするだけでワークフローを作れますが、セレクタの知識が少し必要な場合もあります。

主な特徴:

- ビジュアルワークフロービルダー(ドラッグ&ドロップやクリック選択)

- 動的コンテンツ、ログイン、ページネーション対応

- スケジューリングや自動化機能

- CSV、Excel、JSON、API経由でのエクスポート

代表的なノーコード/ローコード型ツールを紹介します:

Octoparse:非エンジニア向けビジュアル型ウェブスクレイパー

主な機能:

- ドラッグ&ドロップ操作でリストやテーブルを自動検出

- 動的コンテンツやログイン、アンチボット(IPローテーション)対応

- クラウドスクレイピングやスケジューリングで大規模運用も可能

- 主要サイト向けテンプレートも豊富

料金: 無料枠(10タスク)、有料は月額$119〜

ユーザー評価: G2: 約4.4★、Capterra: 約4.5★。高機能・柔軟性が評価される一方、学習コストや価格の高さが指摘されています。

おすすめ: 複雑なサイトを大規模にスクレイピングしたい非エンジニアや分析担当者

ParseHub:柔軟なローコード型ウェブスクレイパー

主な機能:

- 条件分岐や多段階ナビゲーション対応のビジュアルワークフロー

- AJAXやフォーム、動的コンテンツも抽出可能

- クラウド実行やスケジューリング

料金: 無料(5プロジェクト)、有料は月額$149〜

ユーザー評価: G2: 約4.2★、Capterra: 約4.3★。多機能だが動作が遅い、UIが古いという声も。

おすすめ: 複雑なナビゲーションや入力フォームがあるサイトを扱うITリテラシー高めの非エンジニア(記者・研究者など)

Web Scraper.io:手軽に使えるChrome拡張

主な機能:

- Chrome・Firefox対応の無料ブラウザ拡張

- ビジュアルな「サイトマップ」作成で要素選択やナビゲーション定義

- 動的コンテンツやページネーション対応

- クラウドサービスでスケジューリングや自動化も可能

料金: ローカル利用は無料、クラウドは月額$50

ユーザー評価: G2: 約4.2★、Capterra: 約4.4★。初心者や趣味用途に最適ですが、セレクタの知識が多少必要です。

おすすめ: 小〜中規模の抽出や学習用、無料で手軽に始めたい方

Browse AI

主な機能:

- ノーコードで「操作を記録→実行」するボット型

- リアルタイム監視や変更アラート

- 大量データ抽出やワークフロー連携

- Google SheetsやZapierなどと連携

料金: 無料枠(50クレジット)、有料は約$49/月〜

ユーザー評価: G2: 約4.8★、Capterra: 約4.5★。直感的な操作や連携が好評ですが、複雑なページは調整が必要な場合も。

おすすめ: マーケターや中小企業、ウェブデータの監視や簡単な自動化をしたい方

Bardeen AI

主な機能:

- AI搭載「MagicBox」でノーコード自動化ワークフローを構築

- Sheets、Notion、Salesforceなど130以上のアプリと連携

- データ抽出、フォーム入力、ブラウザ操作も自動化

料金: 無料(100クレジット)、有料は月額$60〜

ユーザー評価: G2: 約4.7★、Capterra: 約4.5★。強力な自動化だが学習コストあり。

おすすめ: データ抽出と他アプリ連携を含む複数ステップの業務自動化をしたいビジネスユーザー

ScrapeStorm

主な機能:

- AIフィールド認識搭載のビジュアル型スクレイパー

- 動的コンテンツやログイン、クラウド/ローカル実行対応

- CSV、Excel、JSON、SQLなど多様なエクスポート

料金: 無料版あり、有料は$50+/月〜(買い切りも選択可)

ユーザー評価: G2: 約4.0★(データ少なめ)。簡単なタスクはすぐ使えるが、複雑なレイアウトは苦手な場合も。

おすすめ: ECやディレクトリサイトのデータを手早くAI補助で抽出したい非エンジニア

Web Scraper API:開発者向けのスケーラブルなデータ抽出

開発者やエンジニアチームがいる場合、Web Scraper APIを使えば自社ワークフローに直接スクレイピングを組み込めます。プロキシやCAPTCHA、JavaScriptレンダリングなど面倒な部分をサービス側が処理してくれるので、データの解析や活用に集中できます。

主な特徴:

- プロキシ管理やアンチボット対策

- JS多用サイト向けのヘッドレスブラウザレンダリング

- 構造化データのエンドポイント(場合による)

- 高いスケーラビリティと同時実行性

代表的なAPI型ツールを紹介します:

ScraperAPI:APIファーストのウェブスクレイピングツール

主な機能:

- 大規模プロキシネットワークと自動ローテーション

- CAPTCHA対応やJavaScriptレンダリング

- シンプルなAPI設計(URLを渡すだけでHTML取得)

料金: 無料1,000回/月、有料は月額$29〜

ユーザー評価: G2: 約4.5★。信頼性とシンプルさが開発者に好評。

おすすめ: プロキシやアンチボット管理を省きたい開発者

Bright Data Web Scraper API

主な機能:

- 7,200万以上のIPを持つ巨大プロキシネットワーク、地域指定も可能

- ビジュアルスクレイパービルダーや構造化データ出力

- 企業向けのコンプライアンス・セキュリティ対応

料金: 無料トライアル、有料は月額$500〜

ユーザー評価: G2: 約4.5★、Trustpilot: 4.3★。高機能・サポートが評価される一方、価格は高め。

おすすめ: 大規模・高信頼性・法令順守が求められる企業

Zyte

主な機能:

- スマートプロキシ管理やヘッドレスブラウザAPI

- 主要データ型向けAI抽出

- Scrapy Cloudでカスタムスパイダーのデプロイも可能

料金: 無料枠、有料は月額$29〜

ユーザー評価: G2: 約4.3★。開発者コミュニティで信頼性・柔軟性が高評価。

おすすめ: 強力なバックエンドやマネージドサービスを求める開発者・企業

ZenRows

主な機能:

- HTMLや構造化データのAPIエンドポイント

- 自動アンチボット・JavaScriptレンダリング

- シンプルで開発者フレンドリーな料金体系

料金: 無料トライアル、有料は月額$49〜

ユーザー評価: 新しいツールですが、開発者から「使いやすい」と好評。

おすすめ: シンプルでアンチブロックなAPIを求める開発者・スタートアップ

ScrapingBee

主な機能:

- JS多用サイト向けのヘッドレスブラウザサービス

- プロキシ管理やカスタムレンダリング

- デバッグやビジュアルデータ用のスクリーンショットAPI

料金: 無料トライアル、有料は月額$49〜

ユーザー評価: G2: 約4.6★。JSサイト対応やサポートが高評価。

おすすめ: 最新WebアプリやJSレンダリングが必要な開発者

Pythonウェブスクレイピングライブラリ:カスタム・高度な用途向け

コーディングに慣れている方や開発チームがいる場合、Pythonライブラリを使えば最大限の柔軟性が得られます。リクエストやパース、プロキシ管理などすべて自分で制御できます。

Selenium:動的サイト向けブラウザ自動化

主な機能:

- ChromeやFirefoxなどのブラウザ自動操作で動的コンテンツも抽出

- ヘッドレスモードやクリック・フォーム入力など完全なユーザー操作も可能

- 複数言語対応

料金: 無料(オープンソース)

ユーザー評価: G2: 約4.5★(テストツールとして)。強力だが大規模処理はやや遅い。

おすすめ: 動的サイトやユーザー操作の自動化が必要なQAエンジニア・開発者

Beautiful Soup:シンプルなHTMLパース

主な機能:

- Python用のHTML/XMLパースライブラリ

- 使いやすく、壊れたHTMLにも強い

requestsと組み合わせて利用されることが多い

料金: 無料(オープンソース)

ユーザー評価: 開発者コミュニティで5★。シンプルさが人気。

おすすめ: 静的HTMLから構造化データを抽出したいPython開発者

Playwright:最新サイト向け高速自動化

主な機能:

- Chromium、Firefox、WebKit対応

- 高速・高信頼のブラウザ自動化

- 最新Webアプリや非同期スクレイピングも対応

料金: 無料(オープンソース)

ユーザー評価: 開発者コミュニティで約4.8★。高速・堅牢。

おすすめ: 最新Webサイトの高速・信頼性重視の自動化が必要な開発者

Urllib3:軽量HTTPリクエスト

主な機能:

- Python用の低レベルHTTPクライアント

- コネクションプーリングやリトライ、プロキシ対応

- 他のスクレイピングライブラリの基盤としても利用

料金: 無料(オープンソース)

ユーザー評価: 開発者コミュニティで4.5★。信頼性・効率性が高い。

おすすめ: HTTPリクエストを細かく制御したいPython開発者

無料で使えるウェブスクレイピングツール

「とにかくお金をかけずにデータを取りたい!」という方におすすめの無料ツールをまとめました:

- : 無料枠(6ページ、トライアルで10ページ)、Excel・Sheets・Airtable・Notionへのエクスポート無制限

- Kadoa: 無料500クレジット

- Octoparse: 無料プラン(10タスク、速度制限あり)

- ParseHub: 無料(5プロジェクト、1回200ページまで)

- Web Scraper.io: ローカル利用は無料

- Browse AI: 無料枠(50クレジット/月)

- Bardeen AI: 無料(100クレジット/月)

- ScrapeStorm: 無料版(ページ数制限あり)

- Selenium, Beautiful Soup, Playwright, Urllib3: すべて無料・オープンソース

注意点: 無料プランはページ数やクレジット、速度に制限がある場合が多いです。ビジネス利用ではテストや小規模用途に最適ですが、定期的・大規模な抽出には有料プランが必要になることが多いです。

ウェブスクレイピングツールの種類別メリット・デメリット・活用例

主なカテゴリごとに特徴を整理します:

AIウェブスクレイパー(Thunderbit、Kadoa)

- メリット: 最速セットアップ、サイト変更にも自動適応、ノーコード、複雑・頻繁に変わるサイトにも強い

- デメリット: 超大規模用途には不向き(AI処理に時間がかかる)、高度機能は有料

- おすすめ: 営業・業務・EC・不動産チーム、複雑サイトからノーコードでデータを取得したい方

ノーコード/ローコード型(Octoparse、ParseHub、Web Scraper、Browse AI、Bardeen AI、ScrapeStorm)

- メリット: 直感的な操作、動的コンテンツ対応、スケジューリング、一部AI補助

- デメリット: 学習コストあり、セレクタ知識が必要な場合も、大規模運用は遅い・高価になりがち

- おすすめ: 学習意欲のある非エンジニア、分析担当、マーケター、研究者

Web Scraper API(ScraperAPI、Bright Data、Zyte、ZenRows、ScrapingBee)

- メリット: スケーラブル、プロキシ・アンチボット対応、カスタムワークフローに組み込みやすい

- デメリット: コーディングやパースロジックが必要、大量利用は高コスト

- おすすめ: 開発者、スタートアップ、社内開発チームを持つ企業

Pythonライブラリ(Selenium、Beautiful Soup、Playwright、Urllib3)

- メリット: 最大限の柔軟性、無料、どんなワークフローにも統合可能

- デメリット: プログラミング必須、すべて手動設定、大規模処理は遅い場合も

- おすすめ: 開発者、技術チーム、高度なカスタム用途

2025年のウェブスクレイピングは、これまで以上に多様でパワフルになっています。2クリックでAI抽出したいビジネスユーザーも、カスタムワークフローを構築したい開発者も、単純作業を自動化したい方も、きっと自分に合ったツールが見つかるはずです。

まとめ:2025年に最適なウェブスクレイピングツールを選ぶには

AIウェブスクレイパーの登場で、もはやプログラミングスキルがなくてもウェブから価値あるデータを抽出できる時代になりました。ただし、利用時は各サイトの利用規約やプライバシー法を必ず守りましょう。

私のおすすめは、まずは評価の高いツールの無料トライアル(特にThunderbitはAIの実力を体感できます)から始めて、いろいろ試してみること。最適なウェブスクレイパーを使えば、面倒なコピペ作業から解放され、ビジネスチャンスも広がります。

さらに詳しく知りたい方はで最新情報やチュートリアル、AIウェブスクレイピングのトレンドをチェックしてください。今すぐ始めたい方はして、ウェブデータ抽出の手軽さを体感しましょう。

みなさんのデータが、いつも新鮮で構造化され、ワンクリックで手に入りますように。

よくある質問

Q1: 従来型とAI搭載ウェブスクレイピングツールの違いは?

従来型はCSSセレクタやXPathなど手動設定が必要で、サイト構造が変わると壊れやすいです。AI搭載ツール(ThunderbitやKadoaなど)は言語モデルでページを理解し、コーディング不要・レイアウト変更にも自動対応します。

Q2: ウェブスクレイピングツール選びで重視すべきポイントは?

使いやすさ、自動化機能、データ出力形式、コスト、動的コンテンツやアンチボット対応力などを比較しましょう。ビジネスユーザーはノーコードAI型、開発者はAPIやPythonライブラリを選ぶ傾向があります。

Q3: Thunderbitがビジネスユーザーに最適な理由は?

は非エンジニアチーム向けに設計されており、AIがページ解析・サブページ巡回・フィールド検出を自動化。Sheets、Airtable、Notionへの即時エクスポートや無料枠も充実しており、営業・業務・ECチームに最適です。

さらに詳しく: