ウェブサイトを見ていて「この情報、まとめてスプレッドシートにできたら最高なのに…」って思ったこと、ないですか?自分も何度も経験あります。ひたすらクリックしてコピペを繰り返して、「もっとラクなやり方ないの?」とため息が出たことも。今や、こうした悩みはエンジニアやデータサイエンティストだけのものじゃなくなっています。

今のウェブサイトは、ただのデジタルパンフレットじゃなくて、情報の宝庫。営業、EC運営、リサーチ、フリーランスまで、みんながウェブ上のデータをサクッと抽出・ダウンロードしたいと思っています。実際、、している時代。もし今も手作業でコピペしているなら、最新のサイトリップツールで一気に効率化できるチャンスを逃しているかもしれません。

この記事では、サイトリップの基本から、どんな人に役立つのか、そしてAI搭載の最新ツールまで、ウェブ上のURLからファイルをダウンロードして業務を自動化し、ウェブサイトを価値あるデータソースに変える方法をわかりやすく紹介します。

サイトリップって何?ウェブサイトを“使えるデータ”に変える

まず「サイトリップ」って何?というところから。サイトリップは、ウェブサイトの全部または一部のコンテンツをオフライン利用やバックアップ、データ抽出のためにダウンロードすること。ウェブサイトの「スナップショット」を取るイメージで、全ページでも一部の重要な情報だけでもOK。

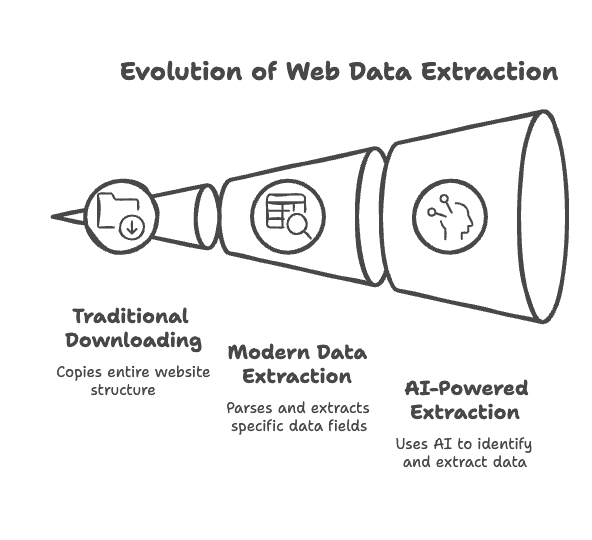

昔からあるサイトリッパー(とも呼ばれる)にはHTTrackやWgetなどがあり、HTMLや画像、PDFなどを丸ごと保存して、リンク構造もそのままオフラインで見られるようにしてくれます。バックアップやサイト移行、コード調査にも便利。

でも、最近のサイトリップツールはさらに進化。単なるファイルのコピーじゃなくて、もできるんです。たとえば、商品ページを保存するだけじゃなく、商品名・価格・評価などを表形式で抜き出せる。

さらにAI搭載のスクレイパーなら、ページ内容を理解して、レイアウトが変わっても柔軟に対応。テキスト要約やカテゴリ分けまで自動でやってくれます。つまり、。

サイトリップはどんな人におすすめ?営業・業務・リサーチまで幅広く活躍

「サイトリップってエンジニアやハッカー向けでしょ?」と思うかもしれませんが、今やビジネス現場で幅広く使われています。どんな人がどんな目的で使っているのか、主な例をまとめました。

| ユーザー層 | 活用例 | メリット・ROI |

|---|---|---|

| 営業チーム | 企業ディレクトリやLinkedInからリード・連絡先を抽出 | リスト作成が数分で完了、本来の営業活動に集中できる |

| マーケティング | 競合サイトのコンテンツ監視や口コミ収集 | 最新情報をもとに効果的な施策を立案 |

| EC運営 | 競合商品の価格・在庫を自動で追跡 | リアルタイムで価格調整や在庫管理が可能に |

| リサーチ/分析 | ニュース・フォーラム・公開DBから大量データ収集 | 網羅的かつ高精度なデータで深い分析が可能 |

| 不動産仲介 | 物件情報や連絡先を不動産サイトから抽出 | 常に最新の物件リストで顧客対応力アップ |

| コンテンツ管理 | サイトのバックアップや新プラットフォームへの移行 | オフラインコピーで災害対策や移行作業が簡単に |

どのケースでも共通しているのは、。データ収集を自動化した企業はし、2023年にはしています。

サイトリップの流れ:ダウンロードからデータ抽出まで

サイトリップの流れはシンプルですが、使うツールによってできることが大きく変わります。

従来型ウェブサイトダウンローダー:

URLを指定して、取得したいファイル形式や範囲を設定すると、ツールがリンクをたどってページやファイルをダウンロード。HTTrackやCyotek WebCopyなどが代表的で、サイト構造をそのまま保存できるのが特徴。ただし、特定データの抽出には向いていません。

最新のデータ抽出ツール:

これらはさらに進化し、できます。たとえば商品名や価格をクリックで指定すると、同じパターンのページから自動でデータを集めて、ExcelやCSV、Google Sheetsなどに出力可能。

AIの活用:

AI搭載ツール(例:)なら、「商品名・価格・画像URLを抽出したい」と日本語で指示するだけで、AIが最適な抽出方法を自動で判断。HTMLやCSSの知識は不要。さらに、データのクレンジングや構造化、サイト構造の変化への自動対応もOK。つまり、。

サクッと使えるおすすめサイトリップツール8選

ここからは、実際に使ってみて良かったおすすめツール8選を紹介します。定番のダウンローダーからAI搭載の最新ツールまで、それぞれの特徴をまとめました。

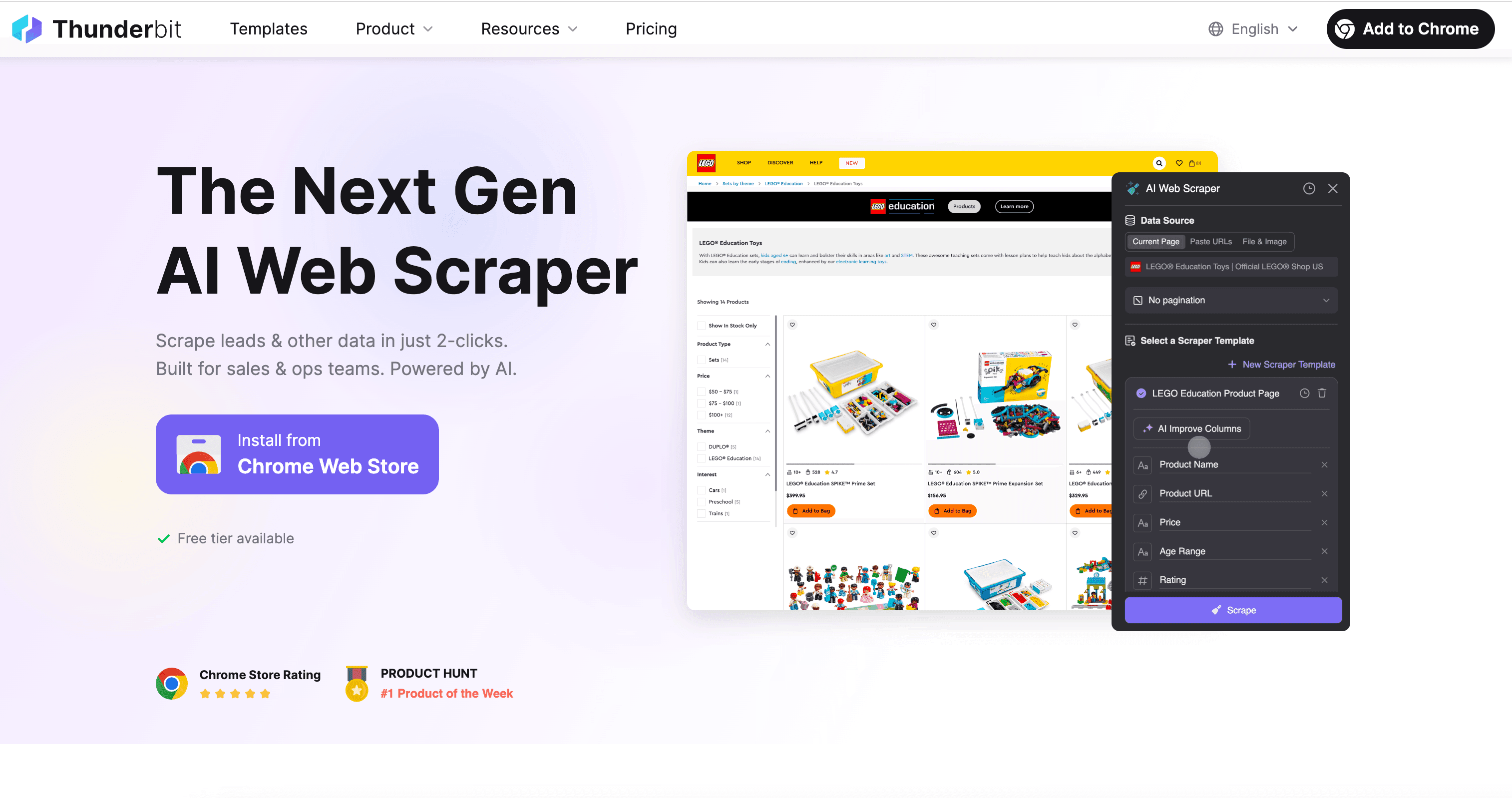

1. Thunderbit:AI搭載で誰でも使えるサイトリップ

Thunderbitは自分も開発に関わったツールで、「ウェブは読むだけじゃなく、データとして活用できる」という発想から生まれました。ウェブ上の膨大な非構造データを、AIの力で誰でも簡単に使える形に変換します。

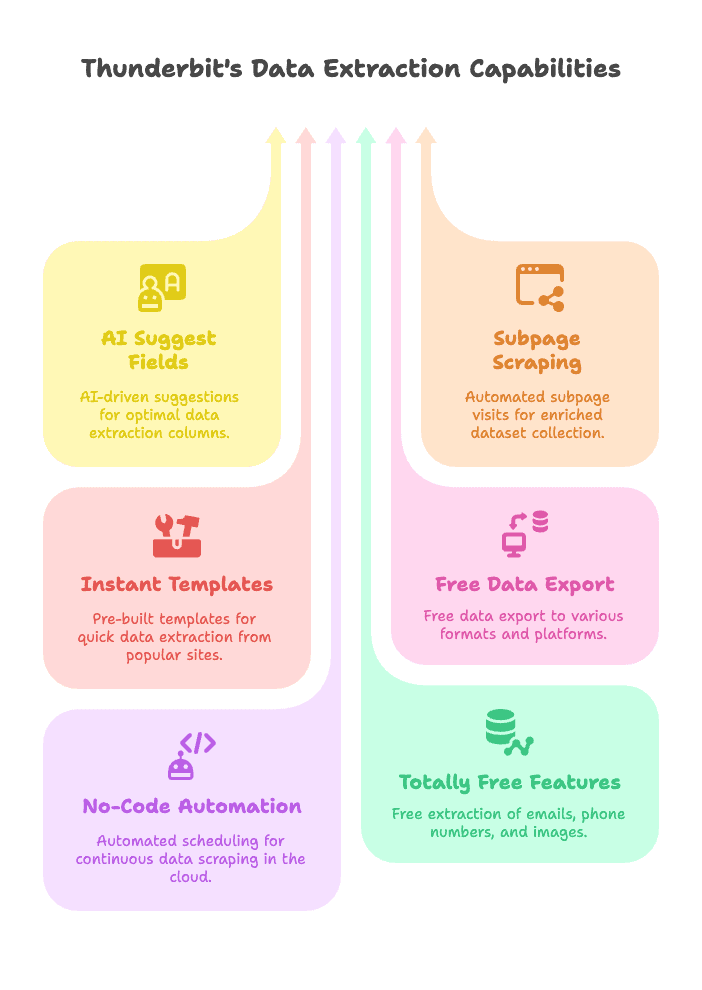

Thunderbitの強み

- AIによる項目自動提案: ボタン一つでAIがページを解析し、最適な抽出カラムを提案&設定。コーディングや試行錯誤は不要。

- サブページ自動抽出: 商品詳細などリスト以外のページも自動で巡回し、データを一括取得。

- 即使えるテンプレート: Amazon、Zillow、Instagram、Shopifyなど人気サイト用テンプレートを用意。ワンクリックで抽出可能。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notion、CSV/JSON形式で出力。無料プランでも追加料金なし。

- ノーコード自動化: スケジュール設定で自動実行(例:毎日価格チェック)。クラウドで重い処理もお任せ。

- 完全無料の抽出機能: メールアドレス・電話番号・画像もワンクリックで抽出可能。

- 34言語対応: Chrome拡張機能で世界中のユーザーが利用可能。

ThunderbitはIT知識がなくても直感的に使えます。営業リスト作成、EC価格監視、不動産物件収集など、幅広いユーザーに支持されています。しかも。

使い方はやでもチェックできます。

Thunderbitは、営業・EC・リサーチなど、どんな業種でも使える一番手軽な構造化データ抽出ツール。AIによる自動項目検出やサブページ抽出で、数クリックでデータ収集を自動化できます。

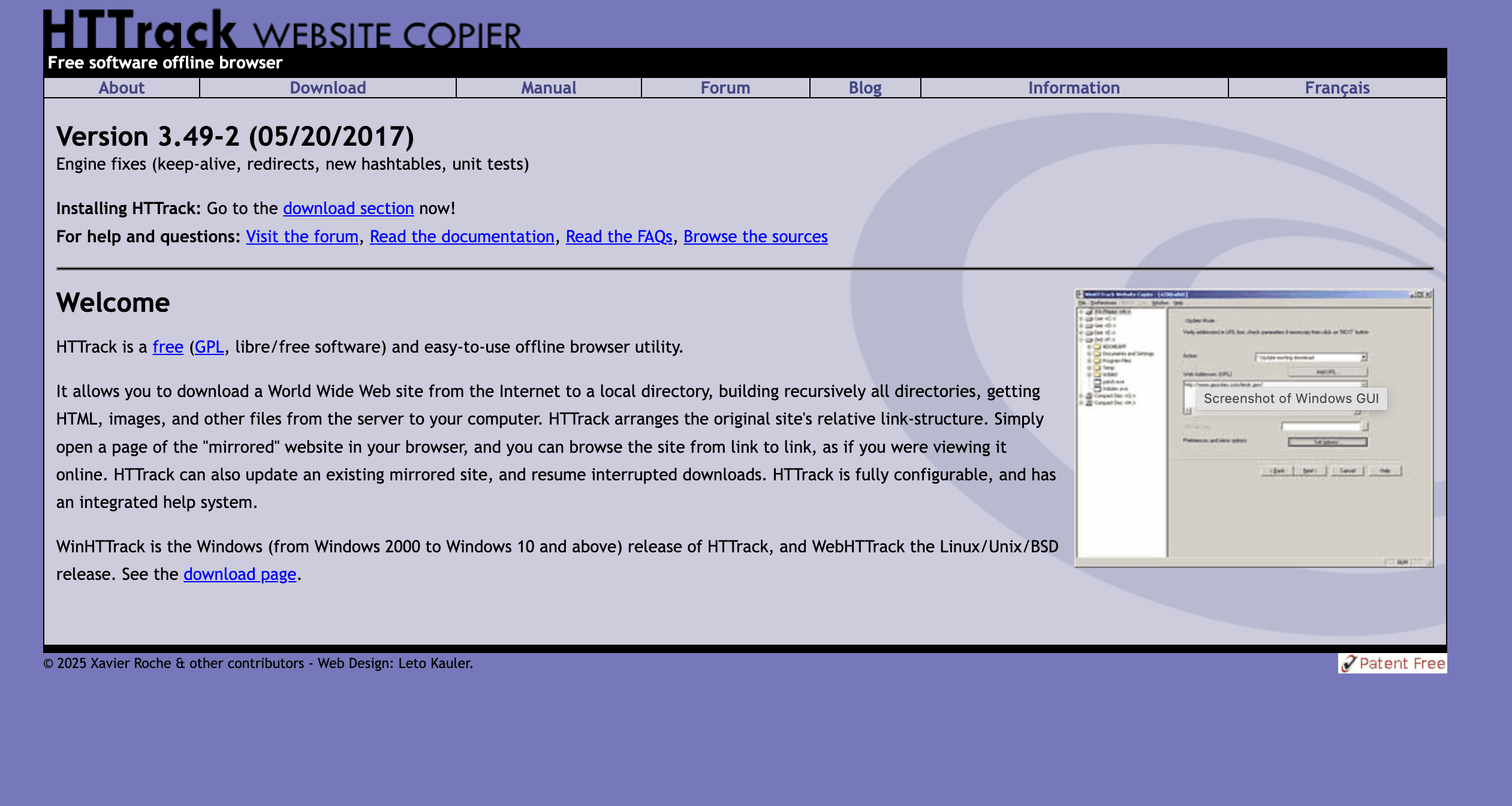

2. HTTrack:定番のウェブサイトダウンローダー

HTTrackは90年代から愛されている老舗のサイトリッパー。アーカイブや研究、オフライン閲覧用の完全コピーにぴったり。

主な機能

- オフライン閲覧: サイト全体(HTML、画像、CSSなど)をダウンロードし、リンク構造も維持。

- マルチプラットフォーム: Windows、Linux、Android対応。

- 細かい設定: フィルタやクロール深度、途中再開も可能。

注意点

- 動的コンテンツ非対応: JavaScript主体のサイトは苦手。

- 構造化データ抽出不可: ファイルやフォルダ単位の保存のみ。

- 全データ取得: フィルタ設定しないと不要なデータも大量取得。

静的サイトのバックアップやアーカイブ、オフライン閲覧に最適ですが、データ抽出には向きません。

3. Octoparse:ビジュアル型&クラウド対応のデータ抽出

Octoparseはビジネス用途で人気の高機能ウェブスクレイパー。Windowsアプリ&クラウドで、クリック操作だけで抽出フローを作成できます。サイト構造の理解は必要ですが、コーディング不要です。

主な特徴

- ビジュアルワークフロー: データ項目の選択、ページ送り、ログインやスクロールも自動化。

- クラウドスクレイピング: サーバー上でジョブ実行、スケジュール設定、各種形式でエクスポート。

- テンプレート多数: Amazon、Twitter、Yelpなど主要サイト対応。

- 高度な機能: IPローテーション、ブロック対策、API連携、チーム共有。

メリット・デメリット

- メリット: 複雑な動的サイトも対応、大規模データ抽出に強い、ノーコード。

- デメリット: 初心者にはやや難しい、上位プランは高額、Windows中心(クラウドは他OSも可)。

定期的に大量データを抽出したい分析担当やEC運営者におすすめ。詳細比較はも参考にどうぞ。

4. Cyotek WebCopy:Windows向けの柔軟な無料ダウンローダー

Cyotek WebCopyはWindows専用の無料ツールで、サイト全体または一部をオフライン保存できます。HTTrackより新しく、細かい制御が可能です。

特徴

- カスタムルール: ワイルドカードや正規表現でURLやファイル形式を指定可能。

- リンク自動修正: オフライン閲覧用にリンクを調整。

- レポート機能: クロール結果やリンク切れをレポート。

注意点

- Windows専用: MacやLinux非対応。

- JavaScript非対応: 動的サイトは苦手。

- 設定が多い: 複雑なジョブには慣れが必要。

Windowsユーザーで細かく制御したい方におすすめ。

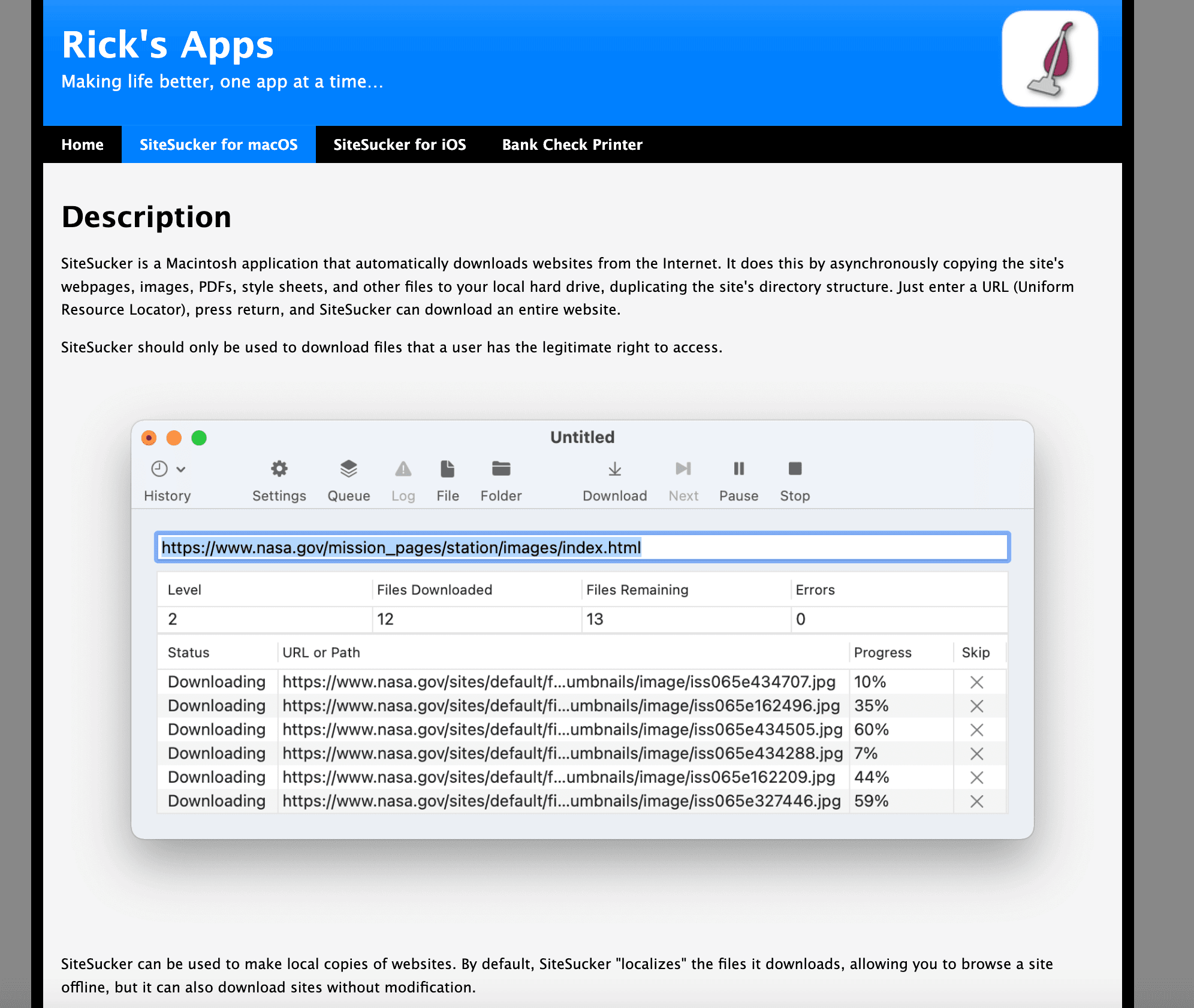

5. SiteSucker:Macユーザー向けのシンプルなダウンローダー

SiteSuckerはMacユーザーに人気のウェブサイトダウンローダー。Mac App Storeで購入でき、操作もとても簡単です。

主な機能

- ワンクリックダウンロード: URL入力→保存先選択→開始の簡単操作。

- 一時停止・再開: 大規模サイトや不安定な回線でも安心。

- 多言語対応: 各国語にローカライズ。

注意点

- Mac専用: Windows・Linux非対応。

- 静的コンテンツのみ: 動的・インタラクティブなサイトは非対応。

- 有料アプリ: 約5ドルですが、手軽さを重視する方に人気。

ブログやドキュメントのアーカイブ、オフライン閲覧に最適。構造化データ抽出には不向きです。

6. Getleft:オープンソース&多言語対応のシンプルダウンローダー

Getleftは知る人ぞ知るオープンソースのサイトリッパー。14言語対応で、学生や趣味ユーザーに人気です。

良い点

- ファイル形式選択: HTML、画像、PDFなど必要なファイルだけ取得可能。

- リンク編集: オフライン閲覧用にリンクを自動修正。

- ダウンロード再開: 中断時も安心。

注意点

- やや古い: JavaScript主体の現代的サイトは非対応。

- 構造化データ抽出不可: 静的HTMLのみ対応。

- UIがレトロ: 見た目はやや時代を感じる。

シンプルなサイトのコピーやオープンソース志向の方におすすめ。

7. Website :オンラインでURLから即ダウンロード

インストール不要で手軽に使いたいなら、Website が便利。URLを入力するだけで、HTML・CSS・画像などをZIPでまとめてダウンロードできます。

特徴

- インストール不要: ブラウザだけで利用可能。

- 即結果取得: 一度きりのダウンロードや制限付きPCでも便利。

- 静的アセット対応: HTML、画像、PDFなど取得。

注意点

- ファイル数制限: 無料版は約200ファイルまで。

- 構造化データ抽出不可: ファイル単位の取得のみ。

- 細かい制御不可: フィルタやログイン対応なし。

したい時や、ソースコードを手早く取得したい時におすすめ。

8. その他の注目ツール

上記7つ以外にも、特定用途で便利なツールがあります:

- Wget: Linuxユーザー向けのコマンドラインツール。

- Wayback Machine Downloader: 過去のウェブサイトアーカイブ取得用。

- その他Chrome拡張: ThunderbitほどAI機能が充実したものは少数。

サイトリップツール比較表:自分に合うのはどれ?

| ツール | 対応プラットフォーム | 価格 | 主な特徴 | おすすめ用途 | 制限事項 |

|---|---|---|---|---|---|

| Thunderbit | Chrome拡張+クラウド | 無料/有料 | AI項目検出、サブページ抽出、テンプレート、自動化、エクスポート | 構造化データ抽出、ノーコードユーザー | クレジット制限、Chrome必須 |

| HTTrack | Windows/Linux/Android | 無料(OSS) | サイト全体コピー、細かい設定、再開、マルチOS | オフライン閲覧、バックアップ | JS非対応、データ表抽出不可 |

| Cyotek WebCopy | Windows | 無料 | カスタムルール、リンク修正、レポート | オフラインコピーのカスタマイズ | Windows専用、JS非対応、設定多め |

| Octoparse | Windows+クラウド | 無料/有料 | ビジュアル操作、クラウド実行、テンプレート、API | データ分析、EC、大規模抽出 | 学習コスト、価格、Windows中心 |

| SiteSucker | macOS | 有料(約5ドル) | ワンクリックDL、一時停止/再開、多言語 | Macユーザー、オフライン閲覧 | Mac専用、静的のみ、データ表不可 |

| Getleft | Windows/Linux | 無料(OSS) | ファイル選択、多言語、再開 | OSS志向、シンプルサイト | 古い、JS非対応、構造化データ不可 |

| Website Downloader.io | Web(全OS) | 無料/有料 | ブラウザ完結、ZIPダウンロード、静的アセット | 手軽な取得、インストール不要 | ファイル数制限、フィルタ不可、静的のみ |

さらに詳しい比較はもどうぞ。

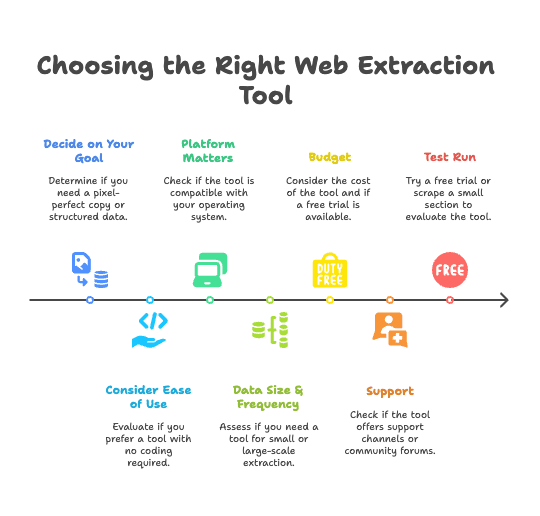

自分に合ったサイトリップツールの選び方

選択肢が多くて迷う人も多いはず。自分の経験から、選び方のポイントをまとめました。

- 目的をはっきりさせる:

- オフラインでそのまま見たい→従来型ダウンローダー(HTTrack、WebCopy、SiteSucker)

- 商品リストや連絡先など構造化データが欲しい→データ抽出ツール(Thunderbit、Octoparse)

- 使いやすさ重視か:

- コーディング不要でサクッと結果が欲しい→がおすすめ

- 学習コストOK&細かく制御したい→OctoparseやCyotek WebCopy

- 対応OSをチェック:

- Mac→Thunderbit(Chrome)またはSiteSucker

- Windows→全ツール利用可

- Linux→HTTrack、Getleft、Thunderbit(Chrome経由)

- データ量・頻度:

- 単発・小規模→Website や無料ツール

- 定期・大規模→ThunderbitやOctoparseで自動化

- 予算:

- 無料/OSSも良いけど、有料ツールは長期的に時短・効率化に貢献

- 多くの有料ツールは無料トライアルあり。まずは試してみるのがおすすめ

- サポート体制:

- サポートが必要→ThunderbitやOctoparseは公式サポートあり。OSSはコミュニティ頼み

- まずはお試し:

- 無料トライアルや一部ページでテストして、自分の用途に合うか確認

活用シーン例:

活用シーン例:

- 営業業務: 毎週リード収集→ThunderbitのAI&自動化で大幅時短

- アーカイブ: 会社サイトのバックアップ→HTTrackやWebCopy

- リサーチ: 競合商品データ収集→ThunderbitやOctoparseで表形式データ取得

- オフライン閲覧: チュートリアルサイト保存→SiteSucker(Mac)やHTTrack(Windows)

迷ったら、でまずは試してみて、合わなければ他ツールも検討してみてください。

まとめ:サイトリップのこれから—手作業からAIデータ抽出へ

昔はウェブページをExcelにコピペしていた時代も、今やサイトリップツールはAI搭載のデータ抽出プラットフォームに進化。これからは「ウェブ=読むもの」じゃなく、「ウェブ=使うもの」の時代です。

Thunderbitのビジョンは「ウェブは読むだけじゃなく、活用するためのもの」。賢いチームはもうコピペ作業から卒業して、AIに任せて本来の業務に集中しています。適切なツールを使えば、誰でもウェブの情報を価値あるインサイトやバックアップ、商品データに変換できます。

手作業から解放されて、業務を自動化しよう。営業、マーケ、リサーチ、一般ユーザーまで、あなたに合ったサイトリップツールがきっと見つかります。AI時代のサイトリップで、ウェブデータをもっと身近に。

今すぐワークフローをアップグレードしませんか?して、コピペ作業から卒業しよう。

関連記事:

データ抽出をもっと楽しく、効率的に!

よくある質問(FAQ)

1. サイトリップって何?どんな仕組み?

サイトリップは、ウェブサイトの全部または一部のコンテンツをオフライン利用やバックアップ、データ抽出のためにダウンロードすること。HTTrackなど従来ツールはサイトを丸ごと保存しますが、最新ツールはAIで表や商品リスト、連絡先などをCSVやExcel形式で抽出できます。

2. サイトリップツールはどんな人に役立つ?

営業のリード収集、マーケの競合調査、ECの価格監視、リサーチのデータ収集、不動産の物件抽出、コンテンツ管理のバックアップなど、幅広い業種で活用されています。

3. AI搭載サイトリップツールと従来型の違いは?

ThunderbitのようなAI搭載ツールは、ページ内容を理解して必要なデータ項目を自動検出、サイト構造の変化にも柔軟に対応し、きれいな構造化データを出力します。従来ツールはファイル単位のコピーのみで、内容の解析はしません。

4. 今おすすめのサイトリップツールは?

AIによるデータ抽出ならThunderbit、サイト全体のダウンロードならHTTrackやCyotek WebCopy、ビジュアル操作ならOctoparse、MacならSiteSucker、手軽なオンライン取得ならDownloader.ioなど、用途やスキルに応じて選べます。

5. 自分に合ったサイトリップツールの選び方は?

まず目的(オフライン閲覧かデータ抽出か)を明確にし、OSや使いやすさ、予算、抽出頻度・規模を考慮しましょう。ノーコードで構造化データが欲しいならThunderbit、静的サイトのバックアップならHTTrackが最適です。