想像してみてください。朝8時半、淹れたてのコーヒーを片手にデスクに座った瞬間、上司やそのまた上司から「競合他社の製品価格、カスタマーレビュー、ついでにCEOの好きなピザのトッピングまで全部まとめたスプレッドシートが欲しい」と頼まれたらどうしますか?手作業でコピペしていたら何時間もかかりますが、Pythonを使えば一気に効率化できます。でも「プログラミングは苦手」「HTMLのエラーで朝から頭を抱えたくない」…そんな方のために、この記事を用意しました。

こんにちは、の共同創業者兼CEO、Shuai Guanです。SaaSや自動化、AIの分野で長年、ウェブデータをビジネスの武器に変えるお手伝いをしてきました。この記事では、2025年注目のpython ウェブスクレイピング ライブラリ10選を、特徴・使い方・メリット・デメリット・得意分野まで徹底解説します。「でもPythonは書けない…」という方もご安心を。ThunderbitのノーコードAIウェブスクレイパーなら、たった2クリックで同じ結果が得られます。コードもトラブルも、カフェインの摂りすぎも不要です。

なぜpython ウェブスクレイピング ライブラリがビジネスチームに重要なのか

- リード獲得・営業: ディレクトリやSNS、フォーラムからターゲットリスト(氏名、メール、SNSアカウントなど)を自動収集。営業チームの手作業を大幅に削減できます()。

- 価格調査・競合分析: ECチームは競合の価格や在庫、キャンペーン情報をリアルタイムで取得し、自社戦略を即座に調整できます()。

- 市場調査・トレンド分析: レビューやSNS、ニュースサイトをスクレイピングすることで、マーケや商品企画チームがいち早くトレンドや顧客の声をキャッチできます()。

- 不動産・物件データ: 複数サイトから物件情報や価格、詳細をまとめて取得し、市場分析を効率化。

- EC運営: サプライヤー情報や商品カタログの監査も自動化でき、手作業のコピペ地獄から解放されます。

つまり、のです。ただし、ほとんどのpython ウェブスクレイピング ライブラリは「プログラミングができる人向け」。非エンジニアにはハードルが高いのが現実です。だからこそ、ノーコードでAIが自動化するのようなツールが注目されています(詳細は後ほど)。

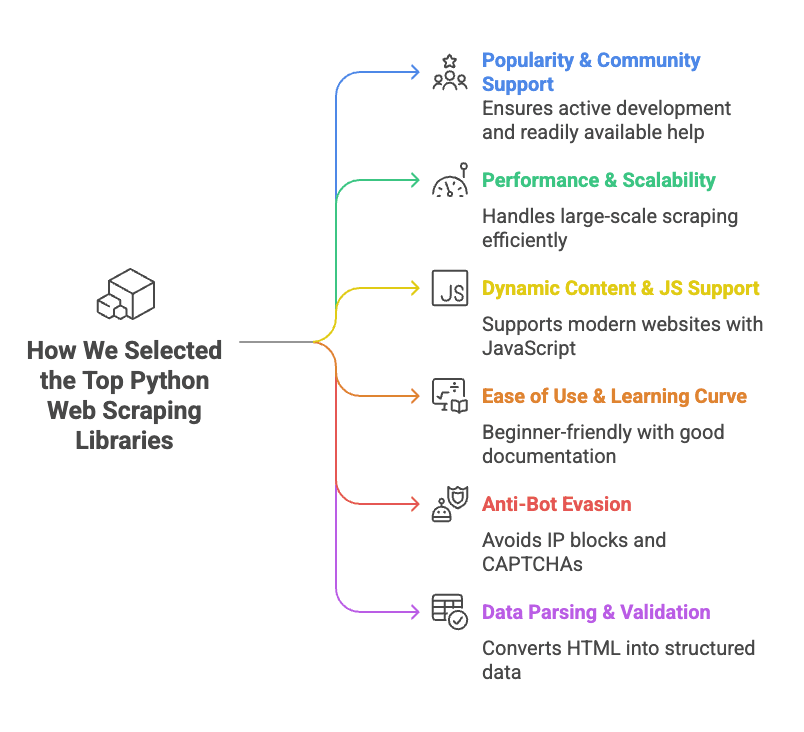

python ウェブスクレイピング ライブラリの選定基準

- 人気・コミュニティ: GitHubスター数や開発の活発さ、チュートリアルの多さ。困ったときにStack Overflowで答えが見つかるかも重要です。

- パフォーマンス・拡張性: 数千ページの処理や並列・非同期リクエストに対応できるか。速度も大事なポイント。

- 動的コンテンツ・JS対応: 最近のサイトはJavaScriptでデータを表示することが多いので、動的コンテンツに強いライブラリを高評価。

- 使いやすさ・学習コスト: プラグ&プレイで使えるものから、習得に苦労するものまで。初心者向けやドキュメントが充実しているものを優先。

- アンチボット対策: IPブロックやCAPTCHA、アクセス制限に対応できるか。対策が弱いとすぐにブロックされてしまいます。

- データのパース・バリデーション: HTMLを取得するだけでなく、きれいな構造化データに変換できるかも重要。

各ライブラリごとに、概要・使い方・メリット・デメリット・得意なシーンを紹介します。

早見表:python ウェブスクレイピング ライブラリ比較

主要10ライブラリを一覧で比較。用途に合ったツール選びの参考にどうぞ(上司への説明にも使えます!):

| ライブラリ | 使いやすさ | JS対応 | HTTPリクエスト | HTMLパース | アンチボット機能 | データバリデーション | 得意分野 |

|---|---|---|---|---|---|---|---|

| ZenRows | 非常に簡単(API) | ✅(ブラウザ) | ✅(API) | ✅ | ✅(プロキシ・CAPTCHA回避) | ❌ | 保護されたサイトの大規模スクレイピング |

| Selenium | 普通 | ✅(ブラウザ) | ✅(ブラウザ) | 一部 | ❌ | ❌ | 動的・インタラクティブなサイト |

| Requests | 非常に簡単 | ❌ | ✅ | ❌ | ❌ | ❌ | 静的ページ・API |

| Beautiful Soup | 簡単 | ❌ | ❌ | ✅ | ❌ | ❌ | 静的HTMLのパース |

| Playwright | 普通 | ✅(ブラウザ) | ✅(ブラウザ) | DOM操作 | ❌ | ❌ | モダンWebアプリ・マルチブラウザ対応 |

| Scrapy | 普通〜やや難 | 一部(アドオン) | ✅(非同期) | ✅ | ❌ | 限定的 | 大規模・構造化クローリング |

| urllib3 | 簡単(低レベル) | ❌ | ✅ | ❌ | ❌ | ❌ | カスタムHTTP・高並列処理 |

| HTTPX | 簡単〜普通 | ❌(非同期IO) | ✅(非同期) | ❌ | ❌ | ❌ | 高速・非同期スクレイピング |

| lxml | 普通 | ❌ | ❌ | ✅(高速) | ❌ | ❌ | 複雑なHTML/XMLの高速パース |

| Pydantic | 普通 | N/A | N/A | N/A | N/A | ✅ | スクレイピング後のデータ検証 |

注:「JS対応」はJavaScriptで生成されるコンテンツの取得可否、「アンチボット機能」はライブラリ標準の対策を指します。

ZenRows:オールインワンpython ウェブスクレイピング API

概要

は、プロキシの自動切り替えやCAPTCHA回避、ブラウザ指紋対策、JavaScriptレンダリングまで面倒な部分を全てAPIで代行してくれるウェブスクレイピングサービスです。APIコール一つで、必要なページを取得できます。

使い方

APIキーを取得し、Pythonのrequestsで呼び出すだけ:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])メリット

- 主要なアンチボット対策(プロキシ、CAPTCHA等)を自動で回避

- JavaScriptで生成されるページも取得可能

- APIだけで完結、ブラウザやプロキシの管理不要

- 大規模なスクレイピングにも対応

デメリット

- 有料サービス(無料トライアルあり)

- サードパーティAPIへの依存

おすすめ用途

大規模なデータ取得や、ボット対策が厳しいサイトのスクレイピングに最適。CAPTCHAやブロックに悩んでいる方は要チェック()。

Selenium:動的サイトのブラウザ自動操作

概要

は、ブラウザ自動化の定番ツール。PythonからChromeやFirefoxなどを操作し、クリックやフォーム入力、スクロールなど人間の操作を再現できます。人がブラウザでできることは、Seleniumでも可能です。

使い方

Seleniumパッケージとブラウザドライバ(例:ChromeDriver)をインストールし、以下のように実行:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()メリット

- 動的コンテンツやログイン、ポップアップなど、実際のブラウザで表示できるサイトは全て対応

- クリックや入力などユーザー操作の自動化

- 複数ブラウザに対応

デメリット

- ブラウザごとにメモリ・CPU消費が大きい

- HTTPベースのスクレイピングより遅い

- 並列処理や大規模運用はやや難易度高

- 高度なアンチボット対策には検知されやすい

おすすめ用途

動的・JavaScript中心のサイトや、ログインが必要なページのデータ取得に最適()。

Requests:Python標準のHTTPクライアント

概要

は「人間のためのHTTP」ライブラリ。PythonでウェブページやAPIを取得する際の定番で、シンプルかつ信頼性抜群です。

使い方

静的ページの取得例:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])メリット

- シンプルなAPIで直感的に使える

- 軽量かつ高速

- クッキーやリダイレクトなどHTTPの基本機能を網羅

- コミュニティが大きく、情報も豊富

デメリット

- JavaScript実行や動的コンテンツには非対応

- HTMLパース機能はなし(Beautiful Soupやlxmlと組み合わせて使用)

- アンチボット対策は自分でヘッダーやプロキシを設定する必要あり

おすすめ用途

静的ページやAPIの取得に最適。初心者はRequests+Beautiful Soupの組み合わせが定番()。

Beautiful Soup:PythonでのHTMLパースの定番

概要

(BS4)は、HTMLやXMLのパース専用ライブラリ。ページ取得自体はRequestsやSeleniumと組み合わせて使いますが、HTMLから必要なデータを抽出するのが得意です。

使い方

商品名を抽出する例:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)メリット

- 初心者にも優しく、多少崩れたHTMLでもパース可能

- タグ・クラス・CSSセレクタ・正規表現など柔軟な検索が可能

- 軽量で高速

- ドキュメントやサンプルが豊富

デメリット

- ページ取得やJavaScript実行は不可

- 大規模なドキュメントではlxmlより遅い

- 複雑なクエリはやや苦手(高度なXPathはlxml推奨)

おすすめ用途

HTMLから商品リストやテーブル、リンクなど構造化データを抽出したいときに最適()。

Playwright:最新のブラウザ自動化フレームワーク

概要

はMicrosoft製の新しいブラウザ自動化ツール。Selenium同様にブラウザを操作できますが、より高速で複数エンジン(Chromium, Firefox, WebKit)に対応し、モダンなAPIが特徴です。

使い方

ページ内容の取得例:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()メリット

- 動的・JavaScript中心のサイトも取得可能

- 複数ブラウザ(Chromium, Firefox, WebKit)対応

- 要素の自動待機で安定性が高い

- 非同期・並列処理もサポート

デメリット

- ブラウザ自動化なのでリソース消費は大きい

- 非同期コードの習得がやや難

- アンチボット対策には完全対応ではない

おすすめ用途

モダンなWebアプリや、ブラウザごとに挙動が異なるサイト、ネットワークリクエストの傍受が必要な場合に最適()。

Scrapy:大規模クローリングに特化したフレームワーク

概要

は、並列処理やパイプライン、エクスポート機能を標準搭載した本格的なウェブスクレイピングフレームワーク。数千ページ規模のクローリングに最適です。

使い方

スパイダーの定義例:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Scrapyプロジェクト内でscrapy crawl quotesと実行。

メリット

- 高速・高並列処理が可能

- スパイダー・パイプライン・ミドルウェアなど構造化された設計

- CSV/JSON/DBなど多彩なエクスポート

- コミュニティ・プラグインが豊富

デメリット

- 初心者にはやや学習コスト高

- プロジェクト構築が必要(ちょっとした用途には不向き)

- JavaScript対応は標準では限定的(アドオンで拡張)

おすすめ用途

複数サイトの物件情報や商品カタログなど、大規模・定期的なクローリングに最適()。

Urllib3:信頼性の高い低レベルHTTPクライアント

概要

は、Requestsの裏側でも使われている低レベルHTTPクライアント。接続やリトライ、プール制御など細かく設定したい場合に便利です。

使い方

ページ取得例:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])メリット

- 高速なコネクションプーリング

- スレッドセーフで並列処理に強い

- HTTP挙動を細かく制御可能

デメリット

- Requestsより手作業が多い

- HTMLパースやJS対応なし

- 初心者向けドキュメントは少なめ

おすすめ用途

カスタムHTTPや高並列スクレイピング、パフォーマンス重視の用途に()。

HTTPX:非同期・高速な次世代HTTPクライアント

概要

は、Requestsの使いやすさに非同期・HTTP/2対応を加えた新世代HTTPクライアント。大量ページの並列取得に最適です。

使い方

同期処理:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)非同期処理:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))メリット

- 非同期対応で高並列スクレイピングが可能

- HTTP/2対応(多くのサイトで高速化)

- Requestsに似たAPIで移行も簡単

- エラーハンドリングが強化

デメリット

- 新しいためチュートリアルは少なめ

- 非同期処理の理解が必要

- HTMLパース機能はなし

おすすめ用途

大量ページの高速取得やAPIスクレイピング、スピード重視の用途に()。

lxml:高速・高機能なHTML/XMLパーサー

概要

は、XPathやCSSセレクタに対応した高性能HTML/XMLパーサー。他の多くのツール(Scrapyのセレクタなど)でもエンジンとして使われています。

使い方

引用文と著者の抽出例:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))メリット

- 大規模ドキュメントでも圧倒的な高速処理

- 複雑なXPathクエリも自在

- メモリ効率が良い

デメリット

- XPath構文の習得が必要

- ドキュメントはBS4よりやや難解

- 環境によってはインストールが難しい場合あり

おすすめ用途

大規模・複雑なHTML/XMLのパースや、高度なクエリが必要な場合に()。

Pydantic:スクレイピング後のデータ検証・整形

概要

はスクレイピングツールではなく、データの型チェックやバリデーションを行うライブラリ。取得したデータをビジネスで使える形に整えます。

使い方

データ検証例:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))メリット

- 厳格なバリデーションでエラーを早期発見

- 型変換(文字列→数値・日付など)を自動化

- 宣言的なデータモデルで保守性が高い

- 複雑なネストデータにも対応

デメリット

- モデル構文の習得が必要

- パイプラインに若干のオーバーヘッド

おすすめ用途

取得データの品質担保や、分析・インポート前の整形に()。

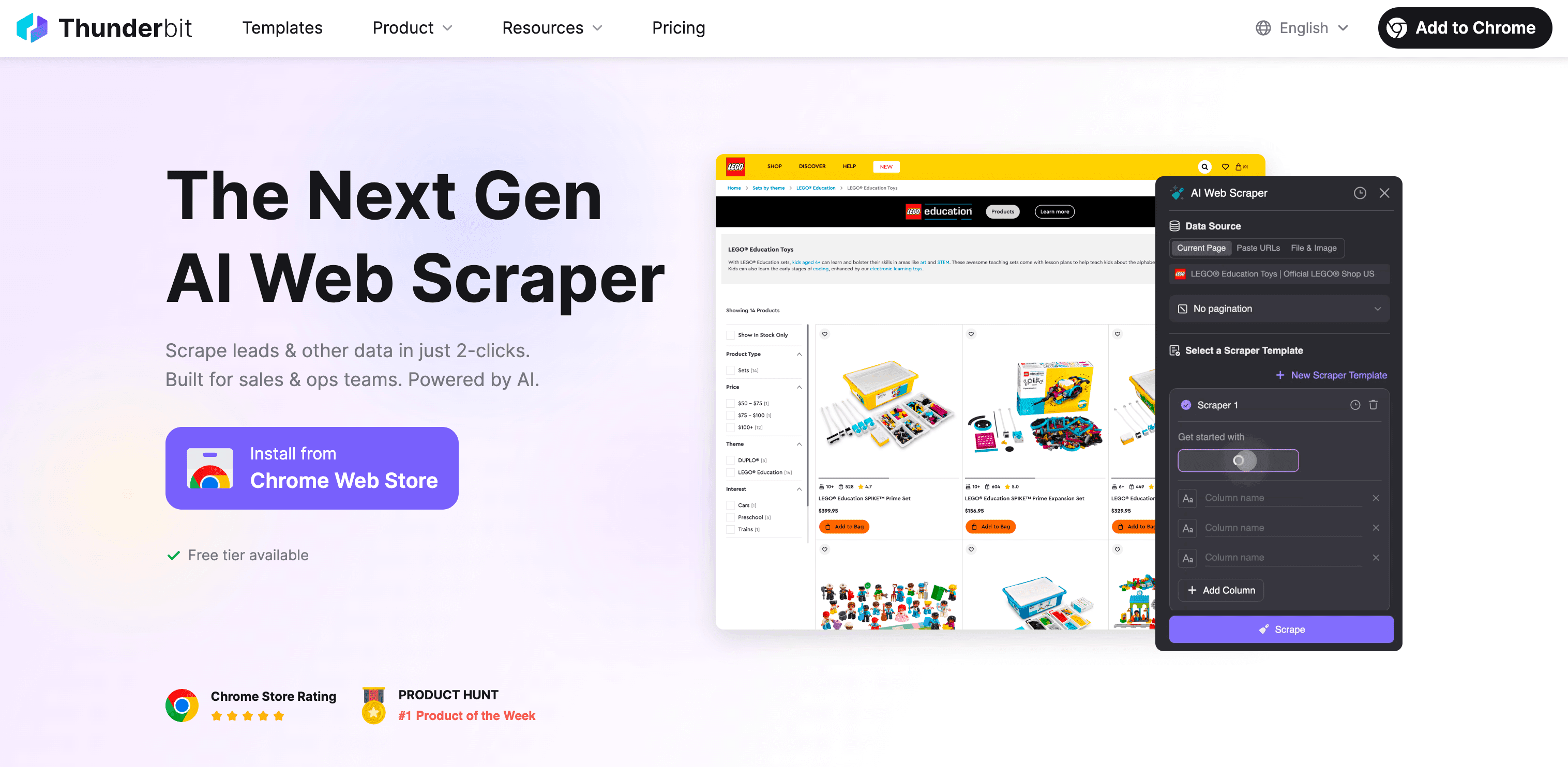

ノーコードの新定番:Thunderbit AIウェブスクレイパー

正直なところ、ここまで読んで「Pythonは便利そうだけど、XPathの勉強に週末を費やしたくない」と思った方も多いはず。そんな方のために私たちが開発したのがです。

Thunderbitとは?

Thunderbitは、AI搭載・ノーコードのウェブスクレイパーChrome拡張です。営業、EC運営、マーケ、不動産など、非エンジニアでも簡単にウェブデータを取得できるよう設計されています。コードやプロキシ、アンチボット対策の知識は一切不要です。

Thunderbitがpython ウェブスクレイピング ライブラリより優れている理由(非エンジニア向け)

- コード不要: 「AIでフィールドを提案」をクリック→AIがページを解析→「スクレイピング開始」で完了。ウェブサイト・PDF・画像も2クリックでデータ化。

- 動的コンテンツもOK: ブラウザ(またはクラウド)上で動作するため、JavaScriptで生成されるページや無限スクロール、ログイン後のデータも取得可能。

- サブページ自動巡回: 商品やプロフィールなど、各詳細ページも自動で巡回・データ追加。

- AIによるデータ構造化: フィールド名や型、カスタムプロンプトもAIが提案。ラベル付け・フォーマット・翻訳・整理も即座に可能。

- アンチボット耐性: プロキシ設定やブロック対策は不要。実際のブラウザセッションとAIで多くの制限を回避。

- 多彩なエクスポート: Excel、Googleスプレッドシート、Airtable、Notion、CSV、JSONなどに無制限で出力。

- テンプレート完備: Amazon、Zillow、Instagram、Shopifyなど人気サイトはテンプレートを選ぶだけ。面倒な設定不要。

- 無料機能も充実: メール・電話・画像抽出やAIフォーム自動入力は完全無料。

python ウェブスクレイピング ライブラリとの比較

| 機能 | Pythonライブラリ | Thunderbit |

|---|---|---|

| コーディング | 必要 | 不要 |

| 動的コンテンツ | 一部(ブラウザ系) | 〇(ブラウザ/クラウド) |

| アンチボット対策 | 手動(プロキシ・ヘッダー) | 標準搭載(ブラウザセッション・AI) |

| データ構造化 | 手動(コード・パース) | AIが自動で提案・整形 |

| サブページ巡回 | カスタムコード | 1クリックで自動 |

| エクスポート | CSV/JSON(コード) | Excel、Googleスプレッドシート、Airtable、Notion等 |

| テンプレート | 自作またはコミュニティ | 人気サイト用テンプレート内蔵 |

| メンテナンス | 自分でスクリプト更新 | Thunderbitチームが自動対応 |

Thunderbitはこんな方におすすめ

営業、EC運営、マーケ、不動産など、ウェブデータ(リード、価格、商品情報、物件情報など)が必要だけどプログラミングは苦手…という方に最適。思い立ったらすぐ「このデータが欲しい→はい、スプレッドシート!」が実現します。

実際に使ってみたい方は、を無料でダウンロード。さらに詳しい活用法はもご覧ください。

まとめ:Pythonライブラリとノーコードツール、どちらを選ぶ?

まとめると、python ウェブスクレイピング ライブラリは強力で柔軟性も高く、あらゆる用途に対応できます(コードに慣れていれば)。ポイントをおさらい:

- ZenRows: アンチボット機能搭載で大規模・保護サイト向け

- Selenium & Playwright: 動的・インタラクティブなサイトに強いが、やや重め

- Requests & HTTPX: 静的ページやAPI向け。HTTPXは非同期・高速処理が得意

- Beautiful Soup & lxml: HTMLパースの定番。BS4は初心者向け、lxmlは高速・高機能

- Scrapy: 大規模・構造化クローリングの本命

- urllib3: カスタム・高並列HTTP用途に

- Pydantic: データの品質担保・整形に

一方、「プログラミングは苦手」「とにかく早く結果が欲しい」ならが最短ルート。コードもメンテも不要、すぐに結果が出ます。

私からのアドバイス:

- Pythonが得意で細かく制御したいなら、用途やスキルに合ったライブラリを選びましょう。

- 「データが欲しいだけ」「時間を節約したい」なら、ThunderbitのAIに任せてみてください。

どちらを選んでも、ウェブにはビジネスのヒントが溢れています。Pythonのプロも、ノーコード派のビジネスユーザーも、2025年は自分に合った最適なツールでデータ活用を始めましょう。もしスクレイピングや自動化、CEOの好きなピザトッピングについて語りたくなったら、いつでもご連絡ください。

ハッピー・スクレイピング!

よくある質問(FAQ)

1. Pythonで人気のウェブスクレイピングライブラリは?

代表的なPythonライブラリには、静的ページ向けのRequests、JavaScript対応のSelenium、大規模クローリング向けのScrapyなどがあります。データの複雑さや並列処理の必要性、動的コンテンツの有無によって選ばれています。

2. JavaScriptで生成されるサイトをスクレイピングするには?

JavaScript中心のサイトにはSeleniumやPlaywrightが有効です。これらは実際のブラウザ操作を再現し、動的コンテンツも取得できます。ZenRowsもAPIでJavaScriptやアンチボット対策を自動化できる選択肢です。

3. Thunderbitはビジネスでどのように役立つ?

ThunderbitはノーコードのAIウェブスクレイパーで、プログラミング不要でウェブデータを収集できます。競合価格やリード獲得、商品データなど、AIが自動で動的コンテンツやアンチボット対策、エクスポートまで2クリックで完了します。

さらに詳しく: