もし、商品価格をスプレッドシートにひたすらコピペしたり、リードリスト作成のために手作業でデータを集めた経験があるなら、それはあなただけじゃないよ。実際、が週の25%以上を繰り返しのデータ作業に費やしていると言われてる。つまり、1チームあたり月に何百時間もが単純作業で消えてるってこと。でも、ここで朗報。ノーコードのウェブスクレイパーを使えば、プログラミングができなくても、数分でウェブデータの自動収集ができるんだ。

自分もSaaSや自動化ツールの開発に長く関わってきたけど、こうしたノーコードツールが営業・マーケ・オペレーション現場でどれだけ役立ってるか、肌で感じてる。ウェブスクレイピング市場は今後も拡大して、になる予測も。ノーコードツールはその成長を引っ張る存在。個人事業主からデータ重視のマーケター、単純作業にうんざりしてる人まで、このリストを参考に、自分に合ったノーコードウェブスクレイパーを見つけてみて。

なぜノーコードウェブスクレイパーツールが今のチームに必須なのか

正直、手作業でのデータ収集は生産性の大敵。平均的なオフィスワーカーはと言われていて、10人チームなら月400時間以上が無駄になってる。ノーコードウェブスクレイパーを使えば、

- 時間を大幅カット: 何時間もかかってた作業が、数分で終わる。

- IT部門に頼らなくてOK: 開発者にスクリプト作成をお願いする必要なし。

- 業務の柔軟性アップ: 営業は新規リード、マーケは競合調査、オペレーションは商品データを、技術の壁なくゲットできる。

- データ精度も向上: 自動化でコピペミスが減り、データの一貫性もバッチリ。

実際、によると、小規模ビジネスの経営者は毎日96分も自動化で時間を節約できてるらしい。さらに、ローコード/ノーコードツールを導入した企業ではされたというデータも。

ノーコードウェブスクレイパーツールの選び方ポイント

選択肢が多すぎて迷う人も多いはず。そこで、自分が9つのツールを厳選した基準を紹介するね。

- 使いやすさ: 非エンジニアでも直感的に使えるか。ポイント&クリックやAIアシストがあるか。

- 自動化・知能性: 自動フィールド検出、サブページ巡回、スケジューリング、クラウド実行などの機能。

- 拡張性: 小規模な単発作業から大規模な定期実行まで対応できるか。

- データ出力・連携: Excel、Google Sheets、JSON、API連携などのエクスポート対応。

- サポート・コミュニティ: テンプレやドキュメント、サポート体制の充実度。

- 価格・導入しやすさ: 無料プランの有無、料金体系の分かりやすさ、個人・チーム両方に対応してるか。

それじゃ、2025年におすすめのノーコードウェブスクレイパー9選を、それぞれの特徴や活用シーンと一緒に紹介するよ。

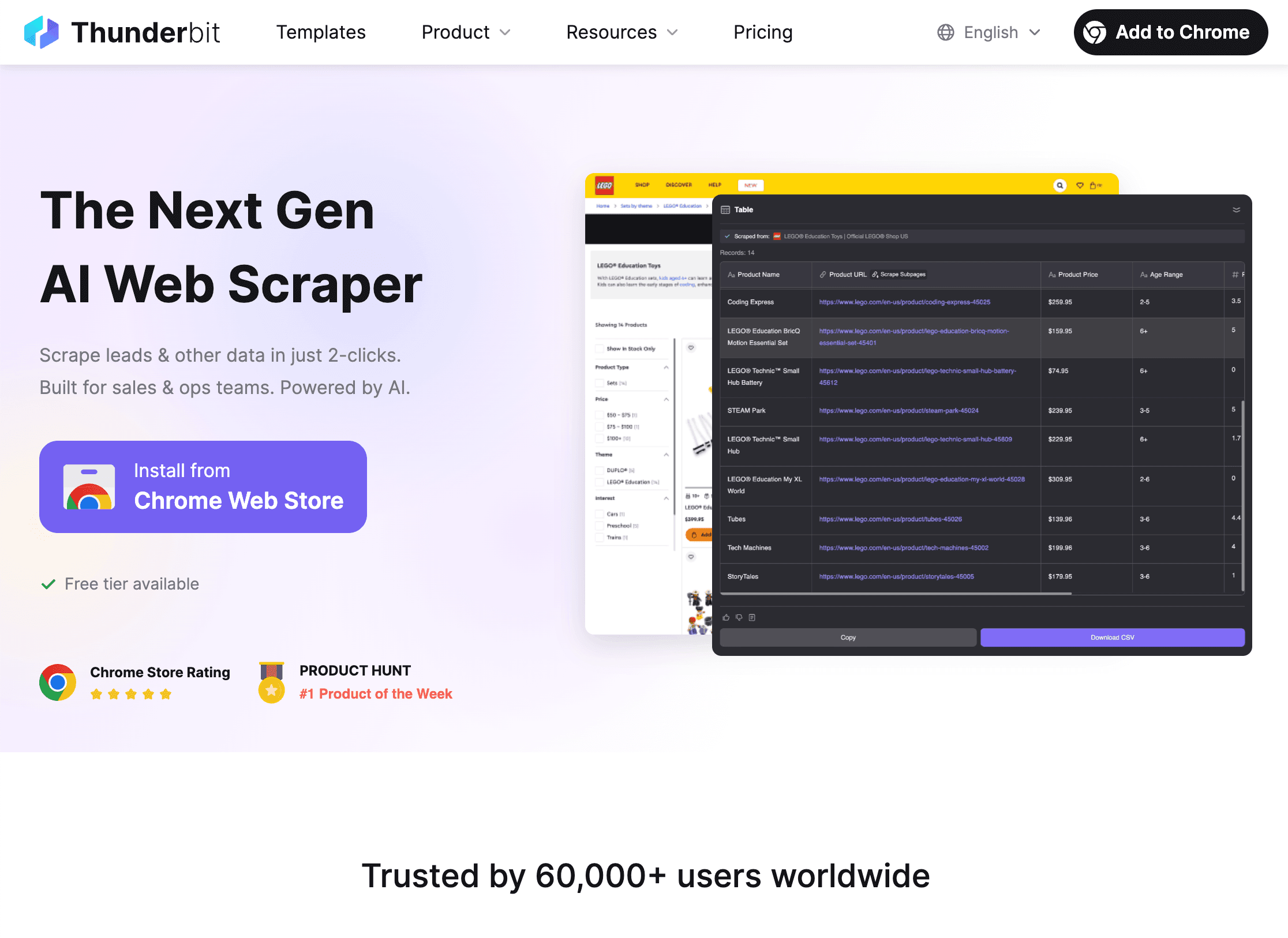

1. Thunderbit

は、「このデータが欲しい!」から「スプレッドシート完成!」まで、たった2クリックで完結できる自分イチオシのツール。共同創業者としてちょっと贔屓目だけど、ミッションは「ウェブスクレイピングを出前注文並みに簡単にする」こと。

は、「このデータが欲しい!」から「スプレッドシート完成!」まで、たった2クリックで完結できる自分イチオシのツール。共同創業者としてちょっと贔屓目だけど、ミッションは「ウェブスクレイピングを出前注文並みに簡単にする」こと。

Thunderbitの強み

- AIで超カンタン操作: 「AIでフィールドを提案」をクリックするだけで、AIがページを解析して、抽出すべき項目(名前、価格、メールなど)を自動で提案。コーディングや難しい設定は一切不要。

- 2クリックでデータ取得: AIの提案を承認して「スクレイピング開始」を押せば、すぐに構造化データが手に入る。

- サブページ・ページネーションも自動: 商品詳細やプロフィールなど、各サブページも自動で巡回してデータを拡充。営業リードや商品スペック収集にピッタリ。

- クラウド&ブラウザ両対応: ログインが必要なサイトはブラウザで、最大50ページの高速処理はクラウドで実行OK。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notion、CSV/JSON形式で自由に出力。自分のデータに課金は不要。

- AIオートフィル: ウェブフォームの自動入力もAIで無料対応。

- スケジューリング: 「毎週月曜9時」みたいに自然言語で定期実行を設定して、完全自動化もできる。

Thunderbitはに使われていて、営業・不動産・ECなど幅広い業種で活躍中。無料プランで6~10ページまでお試しできて、有料プランは月15ドルから(従量課金制)。

ウェブスクレイピングの手軽さを体感したい人は、してぜひ試してみて。

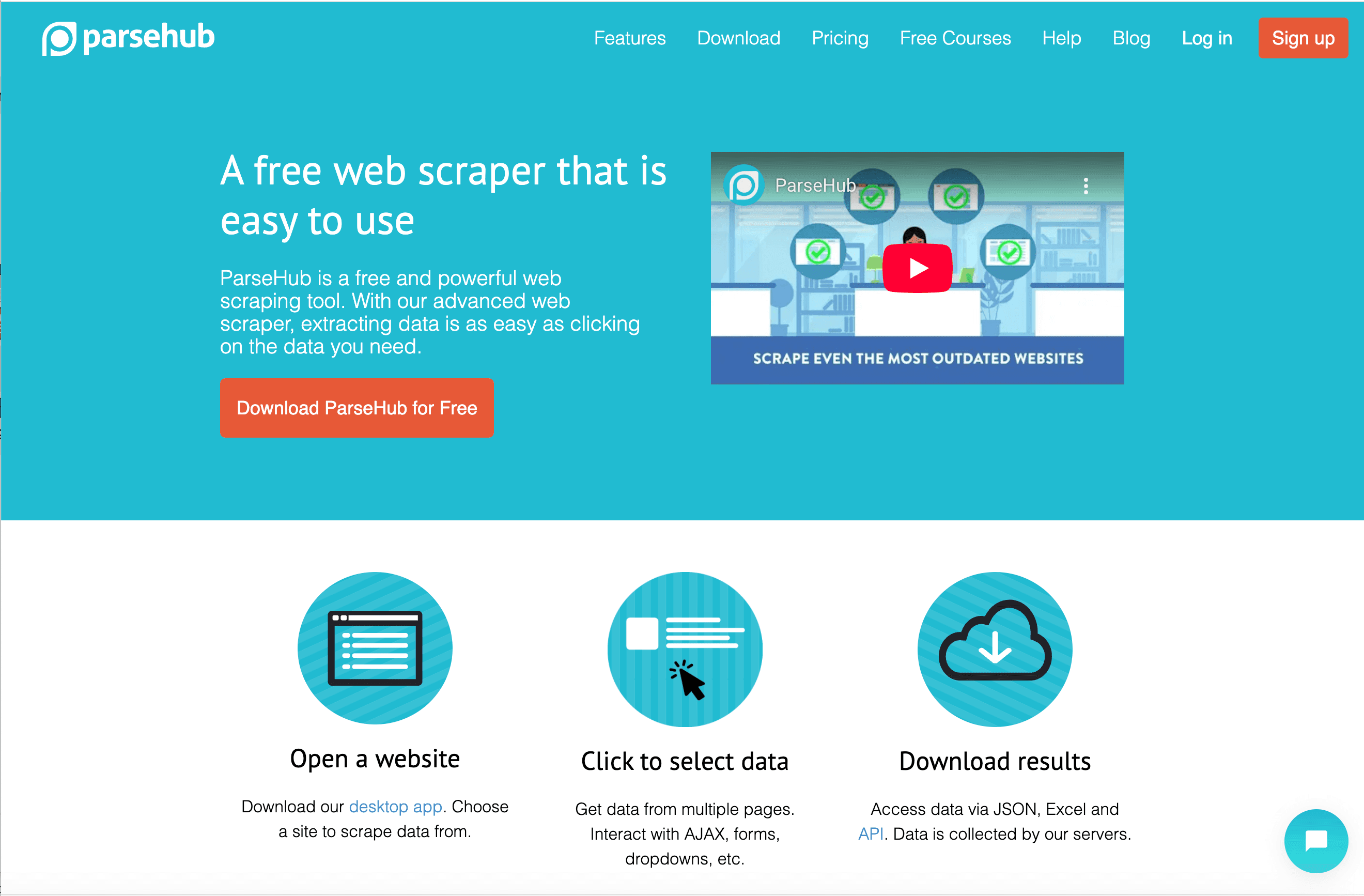

2. Parsehub

は、ノーコードスクレイピング界の老舗で、ビジュアルなワークフロー構築と複雑な動的サイト対応が強み。

は、ノーコードスクレイピング界の老舗で、ビジュアルなワークフロー構築と複雑な動的サイト対応が強み。

- ビジュアルワークフロー: 実際のブラウザ画面を操作しながら、手順を記録して「レシピ」を自動生成。

- 動的コンテンツ対応: JavaScriptやポップアップ、複雑なナビゲーションも得意(EC、求人、不動産サイトなど)。

- 条件分岐・ループ: 多段階のワークフローやログイン、ページネーション、ネストデータも柔軟に対応。

- クラウド実行&スケジューリング: Parsehubのサーバーでジョブを実行し、定期実行も可能(有料プラン)。

- API連携: プログラムからデータ取得もOK。

Parsehubは、細かい制御を求めるアナリストやリサーチャーにおすすめ。無料プランは1回200ページまで、有料は月189ドルから。複雑な案件はちょっと学習コストがかかるけど、パワフルな一台。

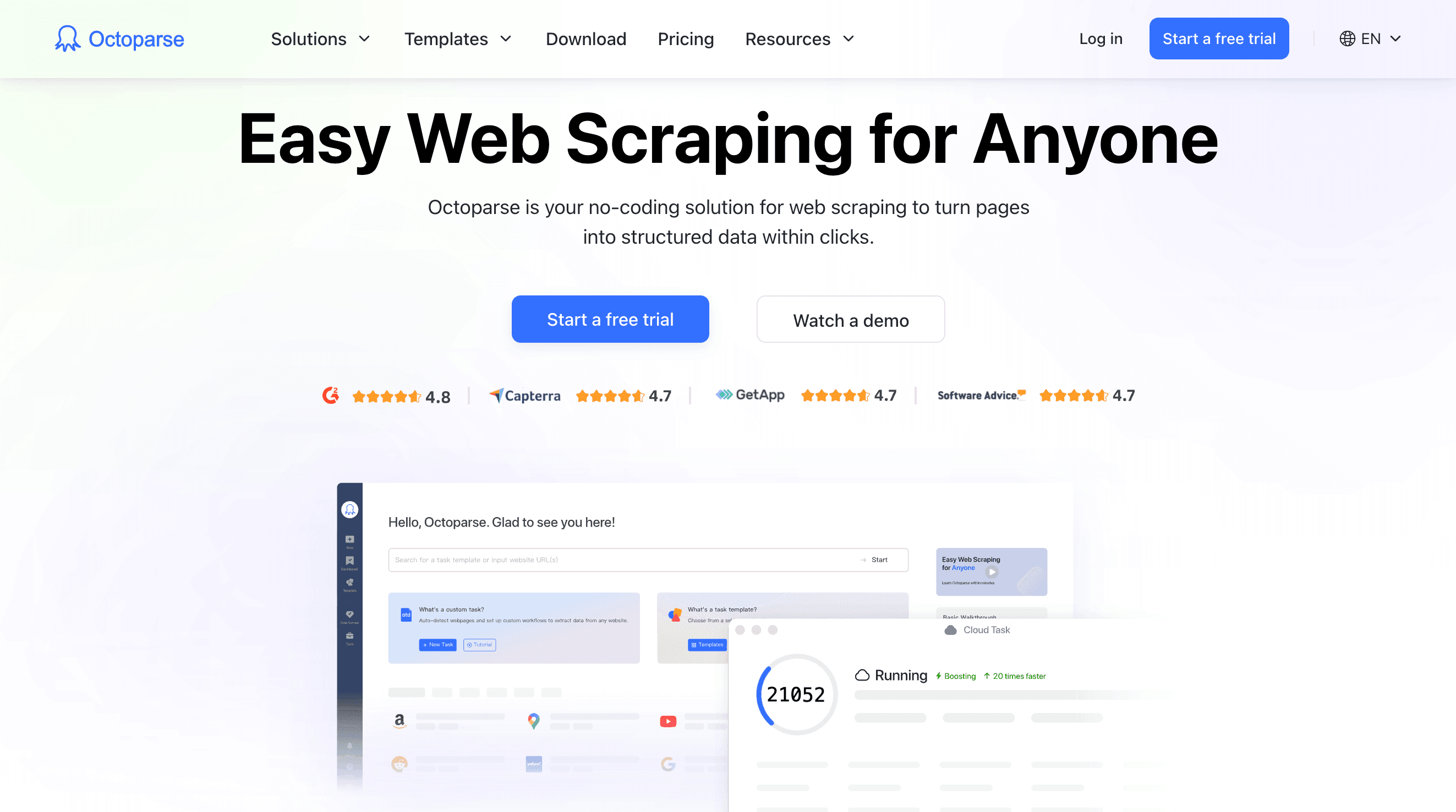

3. Octoparse

は「10分でウェブデータ抽出」を掲げていて、ドラッグ&ドロップ操作と豊富なテンプレートが魅力。

は「10分でウェブデータ抽出」を掲げていて、ドラッグ&ドロップ操作と豊富なテンプレートが魅力。

- ポイント&クリックの簡単操作: ページ上の要素をクリックするだけで、リストやテーブル、次ページボタンを自動検出。

- 100種類以上のテンプレート: Amazon、LinkedIn、Twitter、Zillowなど主要サイト用の即使えるテンプレートが充実。

- クラウドスクレイピング&スケジューリング: 複数ジョブの並列実行や定期実行、IPローテーションやブロック対策も自動化。

- データクレンジング&エクスポート: 内蔵フィルターでデータ整形、CSV/Excel/JSON/API出力対応。

Octoparseは、マーケターや中小企業、データ好きな人に人気。無料プランも試しやすく、有料は月75ドル(Standard)、月249ドル(Professional)から。手軽に始めたい人におすすめ。

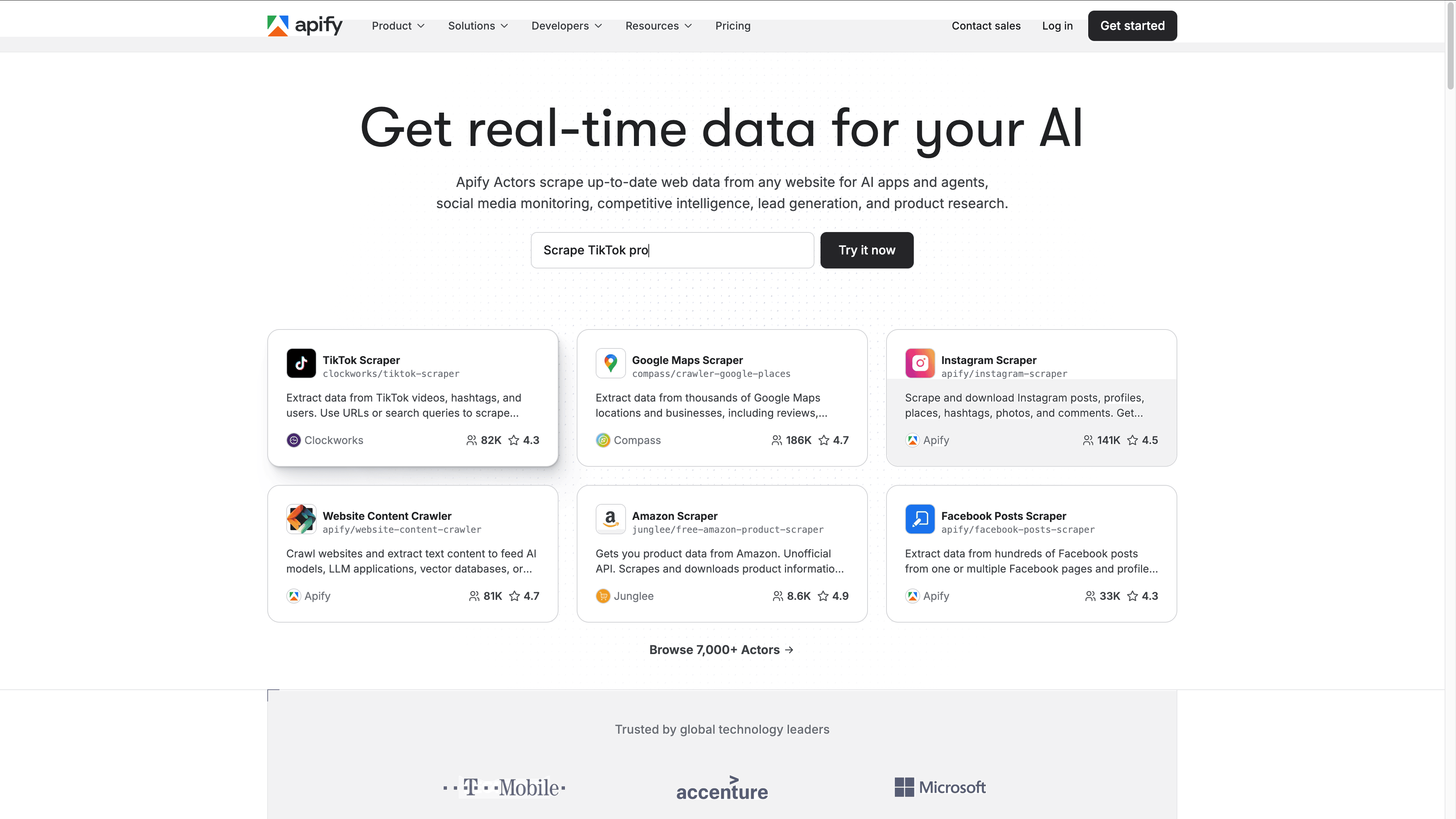

4. Apify

は、5,000以上の「アクター」(スクレイパー)が揃うクラウド型プラットフォーム。自作ワークフローも柔軟に作れる。

は、5,000以上の「アクター」(スクレイパー)が揃うクラウド型プラットフォーム。自作ワークフローも柔軟に作れる。

- アクターマーケットプレイス: Googleマップ、Amazon、SNS、ニッチサイト用のスクレイパーを検索して即実行。

- カスタムワークフロー: ノーコードでも、必要に応じてコードで高度な処理も可能。

- クラウドインフラ: 大規模実行、プロキシローテーション、ブロック対策、スケジューリングも標準装備。

- チームコラボ: プロジェクト共有、アクセス管理、実行ログやダッシュボードで進捗管理。

- API&連携: JSON/CSV出力や、DB・BIツール・Webhook連携も。

Apifyは、データチームやエンジニア、スケーラブルな運用が必要な人に最適。無料枠(クレジット制)あり、有料は月49ドルから。

5. Import.io

は、エンタープライズ向けのノーコードウェブデータパイプライン構築に特化した大手サービス。

は、エンタープライズ向けのノーコードウェブデータパイプライン構築に特化した大手サービス。

- ビジュアル抽出: 例示クリックでパターンを学習し、抽出ルールを自動生成。

- 構造化クロール&スケジューリング: サイト全体の巡回やページネーション、定期データフィードも自動化。

- データ変換&連携: データのクレンジング・正規化、BIツールやDB、API連携も。

- コンプライアンス&サポート: 監査証跡や専任サポート、大企業向けの法令対応機能も充実。

Import.ioは、ミッションクリティカルな大規模データ運用を求める企業・データチーム向け。価格はカスタム(目安:月300~400ドル~)、無料トライアルあり。

6. Data Miner

は、Chrome/Edge用の拡張機能で、ワンクリックで手軽にデータ抽出ができる。

は、Chrome/Edge用の拡張機能で、ワンクリックで手軽にデータ抽出ができる。

- テーブル・リスト自動検出: 任意のウェブページからテーブルやリストを即座に抽出。

- 60,000以上のレシピ: 人気サイト用のワンクリックスクレイパーが豊富。

- ページネーション・クロール: 「次へ」ボタンの自動追跡や、URLリスト一括抽出も可能。

- CSV/Excel/Google Sheets出力: データを直接スプレッドシートにエクスポート。

Data Minerは、営業・リクルーター・リサーチャーに人気。無料プランは月500ページ、有料は月19.99ドルから。

7. Dexi.io

(旧CloudScrape)は、ノーコードで複雑な自動化ワークフローを作れるクラウド型プラットフォーム。

(旧CloudScrape)は、ノーコードで複雑な自動化ワークフローを作れるクラウド型プラットフォーム。

- ビジュアルロボットデザイナー: 条件分岐やループ、データ変換を含む多段階プロセスを直感的に設計。

- クラウド実行&スケジューリング: クラウド上でロボットを実行し、定期ジョブや複数同時実行も可能。

- 連携機能: クラウドストレージやDB、API、外部サービスとの連携も。

- エンタープライズ機能: Fortune 500の1/3が利用する、継続的なデータ監視・レポート機能も。

Dexi.ioは、継続的な大規模スクレイピングが必要な企業や上級者向け。価格は月119ドル(1ワーカー)から。

8. Web Scraper

は、無料で使えるオープンソースのブラウザ拡張(Chrome/Firefox対応)。初心者や小規模案件に最適。

は、無料で使えるオープンソースのブラウザ拡張(Chrome/Firefox対応)。初心者や小規模案件に最適。

- サイトマップ型スクレイピング: クリック操作で巡回・抽出ルールを設定。構造化サイトに強い。

- ページネーション・多階層クロール: リスト抽出やリンク追跡、サブページの詳細データも取得。

- データ出力: CSV/JSON形式でダウンロード。

- クラウドサービス(オプション): 大規模ジョブや定期実行、API連携も可能(有料は月約50ドル~)。

Web Scraperは、学生や趣味ユーザー、まずは無料で試したい人におすすめ。

9. ScraperAPI

は、APIファーストのスクレイピングサービスで、プロキシやCAPTCHA、ヘッドレスブラウザも自動処理。

は、APIファーストのスクレイピングサービスで、プロキシやCAPTCHA、ヘッドレスブラウザも自動処理。

- ノーコードデータパイプライン: ダッシュボードでジョブ設定・スケジューリング・データ管理が可能。

- 自動プロキシ&アンチボット: 厳重な保護サイトからも大規模データ取得が可能。

- 構造化データエンドポイント: AmazonやGoogle、Walmartなど主要サイトのパース済みJSONを提供。

- 大規模スケーラビリティ: 月間数百万リクエストも高速並列処理。

ScraperAPIは、開発者やデータチーム、大量データ取得が必要な人に最適。価格は月49ドル(25万リクエスト)から。

ノーコードウェブスクレイパー比較表

| ツール | 主な特徴 | おすすめ用途 | 無料プラン | 有料プラン(開始価格) |

|---|---|---|---|---|

| Thunderbit | AI 2クリック抽出、サブページ、Sheets出力 | 営業、オペレーション、非エンジニア | あり(6~10ページ) | $15/月(従量課金) |

| Parsehub | ビジュアルワークフロー、動的サイト、クラウドスケジューリング | アナリスト、リサーチャー、複雑案件 | あり(200ページ) | $189/月(Standard) |

| Octoparse | ドラッグ&ドロップ、100+テンプレ、クラウド、スケジューリング | マーケター、中小企業、手軽な自動化 | あり(制限あり) | $75/月(Standard) |

| Apify | クラウド、5,000+アクター、チーム連携、API | データチーム、開発者、スケーラブル | あり(クレジット制) | $49/月(従量課金) |

| Import.io | ビジュアル抽出、コンプライアンス、BI連携 | 企業、大規模データチーム | 無料トライアル | カスタム($300~$400/月~) |

| Data Miner | 拡張機能、60,000+レシピ、Google Sheets | 営業、リクルーター、単発作業 | あり(500ページ) | $19.99/月(Solo) |

| Dexi.io | ビジュアルロボットデザイナー、クラウド、自動化 | 企業、継続的モニタリング | 無料トライアル | $119/月(1ワーカー) |

| Web Scraper | 無料拡張、サイトマップ型、CSV出力 | 初心者、学生、小規模案件 | あり(無制限) | $50/月(クラウド、オプション) |

| ScraperAPI | API、アンチボット、DataPipeline、JSONエンドポイント | 開発者、データチーム、大量取得 | 無料トライアル | $49/月(25万リクエスト) |

あなたに合ったノーコードウェブスクレイパーの選び方

ビジネスシーン別のおすすめツール早見表:

- 初めてで手軽に始めたい人: のAIガイドや、のテンプレ・チュートリアルがぴったり。

- 複雑・動的なサイトを抽出したい: やは複雑なナビゲーションや多段階ワークフローに強い。

- 定期的・大規模案件: 、、はクラウド実行・スケジューリング・連携に最適。

- 単発・簡単な抽出: やはブラウザ上でテーブルやリストをサクッと取得。

- 企業向け・法令対応・サポート重視: やはホワイトグローブサービスと堅牢な自動化を提供。

まずは無料プランやトライアルで実際に使ってみて、データ品質や操作感を確かめてみよう。大事なのは「チームが実際に使い続けられる」ツールを選ぶこと!

まとめ:ノーコードウェブスクレイパーでビジネス価値を最大化

ノーコードウェブスクレイパーは、ただの時短ツールじゃなくて、データドリブンな意思決定を支える強力な武器。や、などを活用すれば、面倒な作業を自動化してミスを減らし、本当に大事な分析や戦略立案に集中できる。

そのメリットは、時間短縮・生産性アップ・必要な時に必要なデータを手に入れられる自由さ。リードリスト作成、競合調査、新規プロジェクトのデータ収集など、あらゆるシーンでノーコードウェブスクレイパーが活躍するよ。

もうコピペ作業に悩まされる必要はなし。や、今回紹介したツールをぜひ試してみて。さらに詳しいノウハウや最新情報はもチェックしてみてね。

よくある質問

1. ノーコードウェブスクレイパーって何?

ノーコードウェブスクレイパーは、プログラミング不要でウェブサイトからデータを抽出できるツール。ビジュアル操作やAI、テンプレートを使って、誰でも簡単にデータ収集を自動化できるよ。

2. どのノーコードウェブスクレイパーが自分に合ってるか分からない。

自分のITスキル、対象サイトの複雑さ、データ量、連携ニーズを考えてみて。まずは無料プランで試して、操作性やデータ品質を確認するのがおすすめ。

3. ノーコードウェブスクレイパーで動的サイトやログインが必要なサイトも抽出できる?

多くのツールが対応してる。、、は動的コンテンツやログイン、ページネーションもOK。高度な保護サイトにはのアンチボット機能が便利。

4. ウェブスクレイピングは合法?

公開情報を対象にして、各サイトの利用規約を守れば合法。個人情報や機密データの抽出は避けて、必ず事前にポリシーを確認しよう。

5. ノーコードウェブスクレイパーでデータをどうやってエクスポートできる?

多くのツールがCSV、Excel、Google Sheets、Airtable、Notion、API連携に対応。やはスプレッドシートへの直接出力もできて、すぐにデータ活用できる。

ウェブデータ収集の自動化を始めたい人は、ぜひこの記事で紹介したノーコードウェブスクレイパーを試してみて。きっと大幅な時短を実感できるはず。ハッピー・スクレイピング!

さらに詳しく知りたい人はこちら