ネットの世界にはとんでもない量のデータが溢れていて、2025年にはもの情報が生まれると言われています。営業やEC、オペレーション、リサーチの現場で働いている人なら、この膨大なデータをどうやって活用するか、きっと一度は悩んだことがあるはず。手作業でコピペなんて、もう時代遅れ。時間もかかるしミスも多いし、正直やってられません。だからこそ、がAIを使ったウェブデータ抽出を導入して、今まで数週間かかっていた作業を数分で終わらせているんです。

自分もSaaSや自動化の分野で長くやってきましたが、AI搭載の웹 스크래퍼を使うと生産性が一気に上がるのを実感しています。でも、選択肢が多すぎて「どれを選べばいいの?」と迷う人も多いはず。そこで今回は、AIを活用して効率よくウェブサイトからデータを抽出できるおすすめツール10選を、Chrome拡張からエンタープライズ向けクラウドサービスまで幅広く紹介します。

なぜAIでウェブスクレイピング?新しい可能性が広がる

昔ながらのウェブスクレイピングツールは、ちょっとしたサイトのレイアウト変更ですぐ使えなくなる、まるで古いカーナビみたいな存在。でもAI搭載の웹 스크래퍼なら、機械学習や自然言語処理でパターンを見抜き、変化にも柔軟に対応してくれます。しかも「このページから商品名・価格・画像を抜き出して」と英語で指示するだけで、AIが自動で最適な方法を選んでくれるんです()。

AIを使うメリットはこんな感じ:

- スピード: AI 웹 스크래퍼なら、手作業で何週間もかかるリサーチも数分で自動化()。

- 精度: コンピュータビジョンやNLPで、商品名と説明文などをしっかり区別。クリーンで信頼できるデータが手に入る。

- 柔軟性: サイト構造が変わってもAIが自動で対応。メンテの手間が激減。

- 使いやすさ: 専門知識がなくても、やりたいことを文章で伝えるだけでデータ抽出OK。リード獲得や価格調査、市場分析など幅広く使える。

- コスト削減: や人件費の大幅カットも実現。

つまり、AIを使えばプログラミングスキルがなくても、もっと速く・正確にデータをゲットできるってことです。

AIウェブスクレイピングツールの選び方

たくさんあるツールの中から、以下のポイントを重視してトップ10を選びました:

- 使いやすさ: コーディング不要で直感的に使えるか?ビジュアルUIや自然言語対応はあるか?

- AI機能: フィールド自動検出、レイアウト変化への適応、自然言語指示の理解などAIの活用度。

- 機能の充実度: ページネーション、スケジューリング、プロキシ管理、CAPTCHA対応、出力形式など。

- 拡張性: 少量から大規模まで対応できるか?クラウド版はあるか?

- 価格・導入しやすさ: 無料プランや個人・中小企業向けの価格帯か?

- サポート・コミュニティ: ドキュメントやサポート体制、ユーザーコミュニティの活発さ。

- 信頼性: 実際のユーザーレビューや実績。

ブラウザ拡張、デスクトップアプリ、クラウドサービス、開発者向けフレームワークまで幅広くカバーしているので、個人から企業チームまでピッタリの選択肢が見つかります。

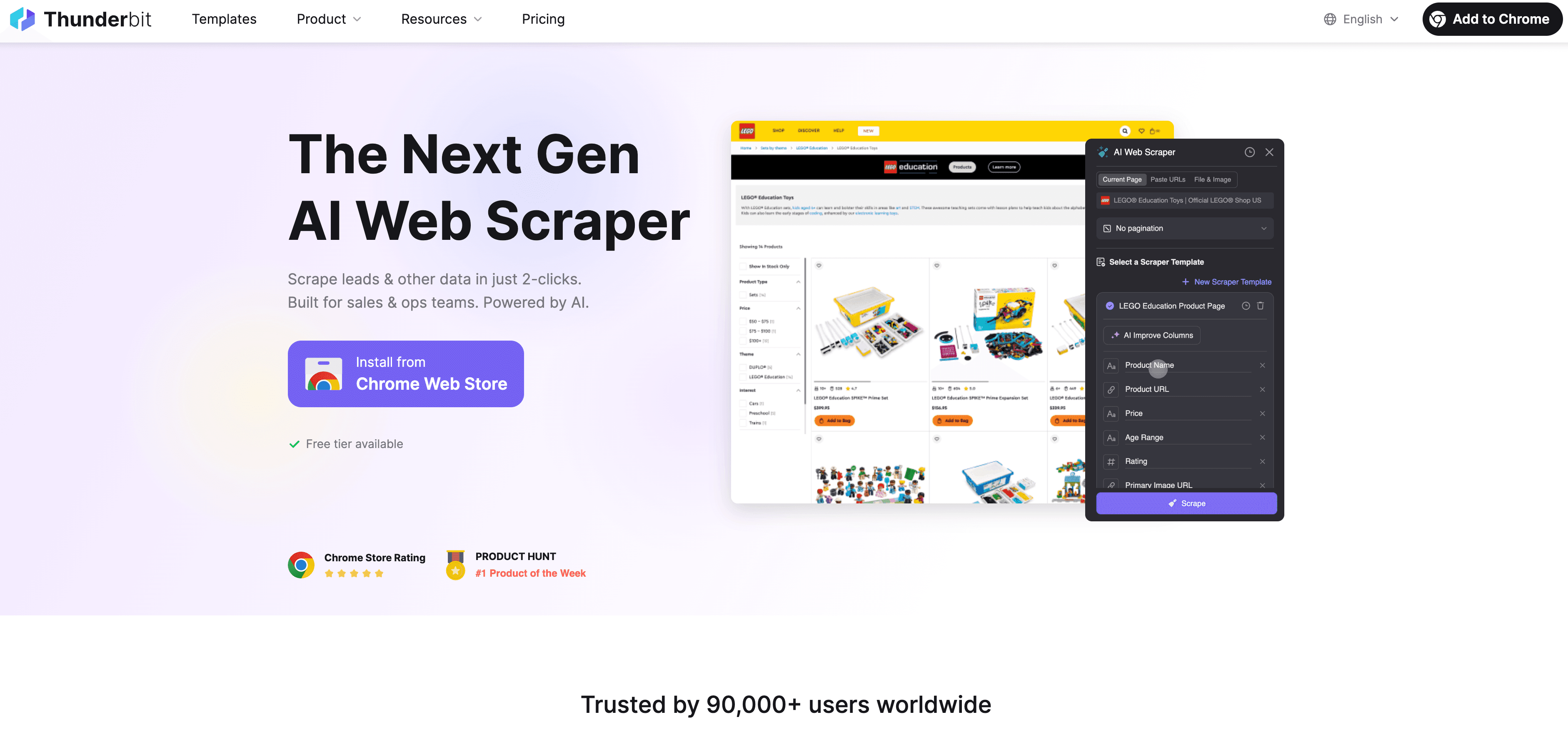

1. Thunderbit

は、ビジネスユーザーがAIでサクッとウェブデータを抽出したいときにぴったりなChrome拡張です。ThunderbitはAIアシスタントのように、ウェブページ(PDFや画像もOK)を読み取り、たった2クリックで構造化データを出力してくれます。

は、ビジネスユーザーがAIでサクッとウェブデータを抽出したいときにぴったりなChrome拡張です。ThunderbitはAIアシスタントのように、ウェブページ(PDFや画像もOK)を読み取り、たった2クリックで構造化データを出力してくれます。

Thunderbitの強み

- 自然言語インターフェース: 「このページから商品名・価格・画像を抜き出して」といった指示を入力するだけで、AIが自動で最適な抽出方法を判断。

- AIフィールド提案: ワンクリックでAIがページを解析し、抽出に最適なカラムを提案。必要に応じて編集もOK。

- サブページ・ページネーション対応: 商品詳細ページや無限スクロールにも自動で対応。

- 即時データエクスポート: Excel、Google Sheets、Airtable、Notionへ無料でエクスポート可能。

- 無料の連絡先抽出: メール・電話番号・画像のワンクリック抽出が無料。

- 定期実行: 「毎週月曜9時」など自然言語でスケジュール設定し、AIが自動で実行。

複雑でクセのあるページ(ニッチなディレクトリ、不動産、EC商品ページなど)にも強く、を獲得しています。

料金: 6~10ページまで無料。500クレジット(ページ)で月額約$15から。データエクスポートはずっと無料。

おすすめ: 営業、マーケ、EC運用、ノーコードでデータ抽出したい人。

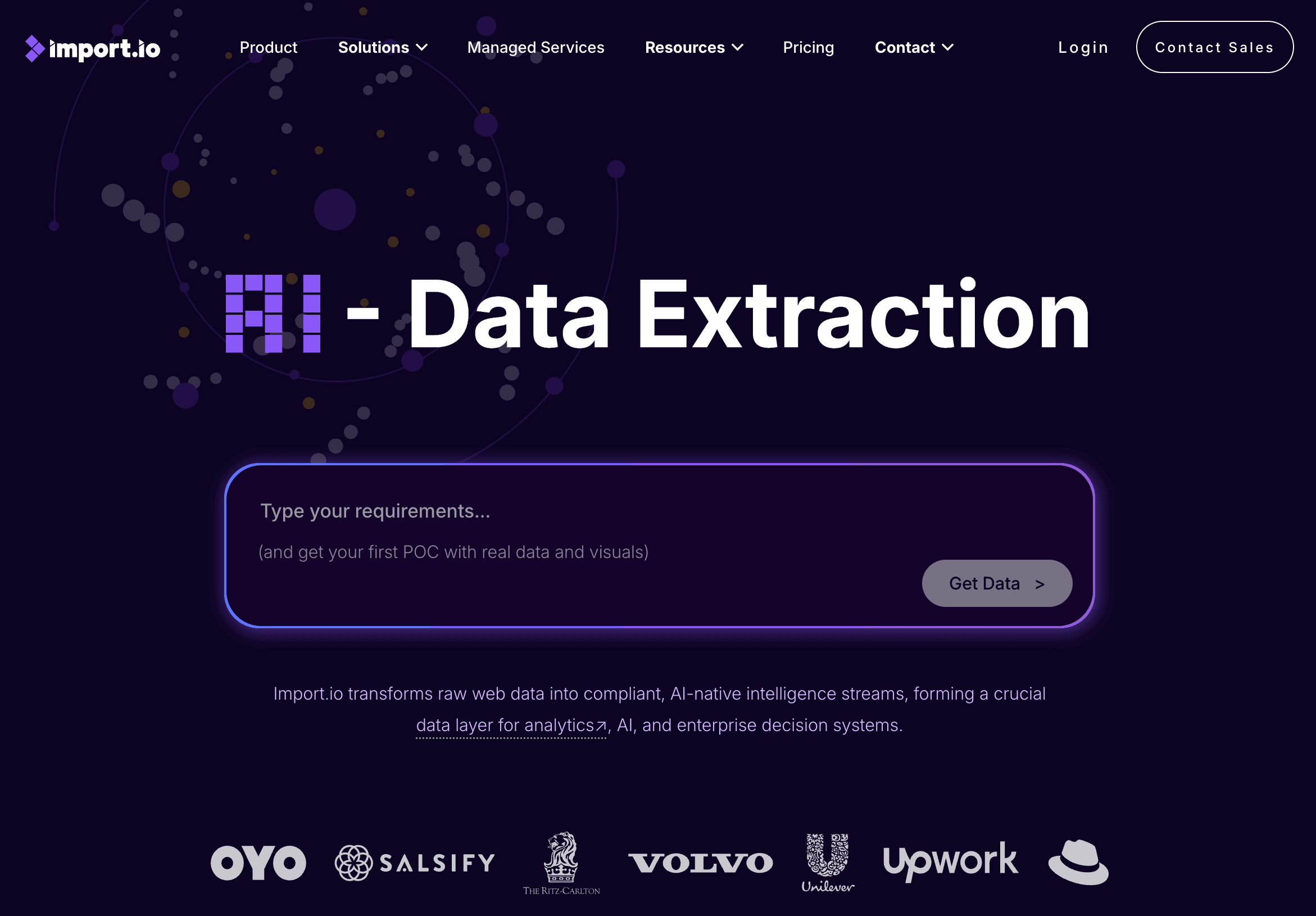

2. import.io

は、UnileverやVolvoなど大手も導入するエンタープライズ向けAI 웹 스크래퍼プラットフォーム。大規模かつミッションクリティカルなデータ抽出に最適です。

は、UnileverやVolvoなど大手も導入するエンタープライズ向けAI 웹 스크래퍼プラットフォーム。大規模かつミッションクリティカルなデータ抽出に最適です。

import.ioの特徴

- AIによる「自己修復」パイプライン: サイト構造が変わってもAIが自動で対応し、スクレイパーが壊れません。

- プロンプトベース抽出: 高度な指示を入力するだけでAIが詳細を自動設定。

- 自動コンプライアンス: GDPRやCCPAなどの法規制に対応したフィルターやPIIマスキング機能。

- フルマネージドクラウド: プロキシ管理やスケジューリング、インフラも全て自動化。

- API連携: どんなウェブサイトもリアルタイムAPI化可能。

料金: 月額約$299から。エンタープライズ向けカスタムプランあり。無料トライアルあり。

おすすめ: 大規模・高信頼性・法令遵守が求められる企業やデータチーム。

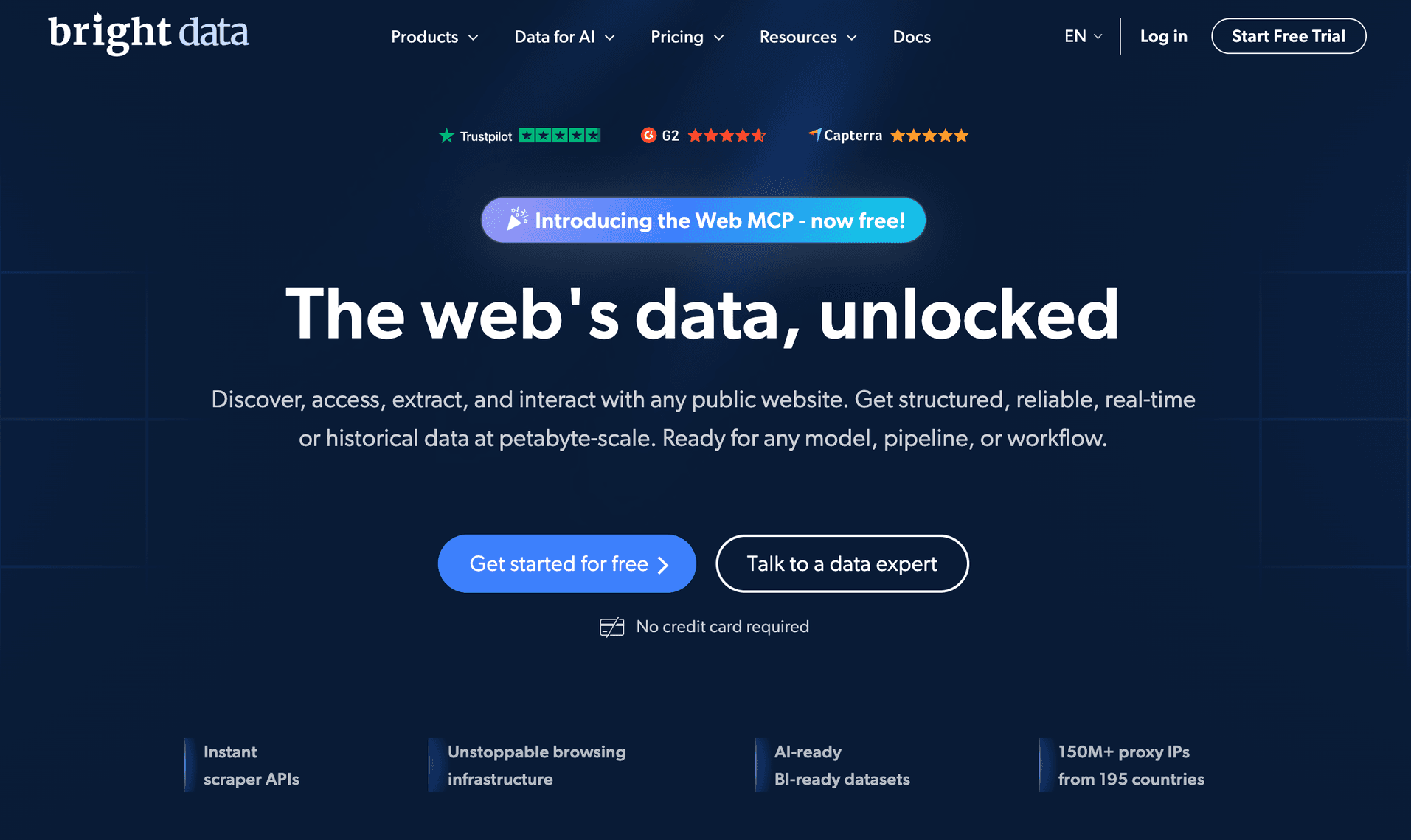

3. Bright Data

は、数百万ページのスクレイピングやグローバルな価格監視、AIモデルへのデータ供給など大規模用途に特化したサービスです。

は、数百万ページのスクレイピングやグローバルな価格監視、AIモデルへのデータ供給など大規模用途に特化したサービスです。

主な機能

- 1億以上のプロキシネットワーク: レジデンシャル、モバイル、データセンターIPで高いアンチブロック性能。

- AI搭載アンブロッカー: CAPTCHA突破やヘッダー自動切替、アンチボット対策もリアルタイムで対応。

- プリセットスクレイパー: Amazon、LinkedIn、Googleなど120以上の人気サイト用API。

- データセットマーケットプレイス: 大規模な事前収集データも購入・利用可能。

- LLM対応データストリーム: AIシステムへのリアルタイムデータ供給。

料金: 従量課金制。大規模利用では高額になる場合も。無料トライアルや一部無料データセットあり。

おすすめ: 大企業、AIプロジェクト、大量・高信頼性データが必要な人。

4. ParseHub

は、Windows/Mac/Linux対応のデスクトップアプリで、動的なJavaScriptサイトも直感的にスクレイピングできます。

は、Windows/Mac/Linux対応のデスクトップアプリで、動的なJavaScriptサイトも直感的にスクレイピングできます。

ParseHubのポイント

- 機械学習によるパターン検出: 1つの要素をクリックするだけで、類似データを自動抽出。

- 動的コンテンツ対応: AJAXや無限スクロール、インタラクティブ要素もOK。

- ビジュアルワークフロー: コード不要で多段階の抽出フローを構築。

- クラウドスケジューリング: クラウド上で定期実行も可能。

- 柔軟なエクスポート: CSV、Excel、JSON、API対応。

料金: 5プロジェクト(1回200ページ)まで無料。月額$189から有料プランあり。

おすすめ: アナリスト、リサーチャー、中小企業で複雑なサイトを扱いたい人。

5. Scrapy

は、開発者向けのPython製オープンソースフレームワーク。拡張性が高く、カスタムスクレイピングに最適です。

は、開発者向けのPython製オープンソースフレームワーク。拡張性が高く、カスタムスクレイピングに最適です。

Scrapyの特徴

- 究極の柔軟性: 独自のスパイダーを作成し、あらゆる規模・用途に対応。

- AI連携: Scrapy-LLMなどの拡張でLLMやNLPを活用した高度な抽出も可能。

- 非同期クロール: 大規模ジョブも高速・効率的に処理。

- オープンなエコシステム: プロキシやブラウザ自動化など豊富なプラグイン。

料金: 無料・オープンソース。インフラ費用のみ自己負担。

おすすめ: 開発者や技術チームで、AI連携やカスタムワークフローを構築したい人。

6. Octoparse

は、ノーコードで使えるクラウド型웹 스크래퍼。ビジネスユーザーやチーム向けです。

は、ノーコードで使えるクラウド型웹 스크래퍼。ビジネスユーザーやチーム向けです。

注目機能

- AI自動検出: AIがページを解析し、抽出対象を自動提案。手動設定不要。

- ドラッグ&ドロップ: ログインやページネーション、動的コンテンツもビジュアル操作で対応。

- テンプレート多数: 人気サイト用のテンプレートが豊富。

- クラウドスケジューリング: クラウド上で定期実行・エクスポート(Sheets、Excel、API)。

- AI正規表現アシスト: AIが正規表現パターンを自動生成。

料金: 無料枠(10タスク)あり。有料プランは月額約$75から。

おすすめ: ノーコード派、マーケティングチーム、中小企業。

7. WebHarvy

は、Windows専用のデスクトップアプリで、パターン検出と買い切り型ライセンスが特徴です。

は、Windows専用のデスクトップアプリで、パターン検出と買い切り型ライセンスが特徴です。

WebHarvyの魅力

- 自動パターン検出: 1つの要素をクリックするだけで、同じ種類のデータを自動抽出。

- ビジュアル抽出: 内蔵ブラウザでクリック操作のみ。コーディング不要。

- 画像・メール抽出: 画像やメールアドレスも簡単に取得。

- 買い切りライセンス: $129からの一括購入。アップデートは有料オプション。

料金: 1ユーザー$129から。

おすすめ: Windowsユーザー、中小企業、オフラインでコスパ重視の人。

8. Apify

は、開発者・ノーコード両対応のクラウド型自動化プラットフォームです。

は、開発者・ノーコード両対応のクラウド型自動化プラットフォームです。

主な機能

- アクターマーケットプレイス: 200以上のプリセットボットで定番タスクも即実行。

- カスタムアクター: JavaScript/Pythonで独自ボット作成やビジュアルツール利用も可能。

- AI連携: 取得データをLLMに渡したり、AIエージェントからスクレイパーを起動可能。

- クラウドスケジューリング・保存: 大規模ジョブやAPI/ワークフロー連携も簡単。

- プロキシ・ヘッドレスブラウザ: 動的サイトやアンチボット対策も対応。

料金: 無料枠($5分/月)あり。有料プランは月額$49から。

おすすめ: 開発者、スタートアップ、自動化・ワークフロー連携を重視するチーム。

9. Diffbot

は、AIによるウェブデータ抽出とナレッジグラフの分野でトップクラスのサービスです。

は、AIによるウェブデータ抽出とナレッジグラフの分野でトップクラスのサービスです。

Diffbotの独自性

- 完全AI駆動の抽出: URLをAPIに渡すだけで、構造化JSONデータを即取得。設定不要。

- ナレッジグラフ: 100億以上のエンティティ(企業・人物・商品・記事)を網羅した巨大グラフにアクセス可能。

- コンピュータビジョン+NLP: テキスト・画像から情報抽出、関係性も推論。

- ファクトベースLLM: ウェブから根拠付きで質問に回答。

料金: 開発者向け無料トライアル(1万回/月)。スタートアッププランは月額$299(25万クレジット)。

おすすめ: 企業、AI企業、リサーチャーで、即時かつ構造化データやナレッジグラフを活用したい人。

10. Data Miner

は、Chrome/Edge拡張機能で、テンプレートベースのスクレイピングを誰でも手軽に実現できます。

は、Chrome/Edge拡張機能で、テンプレートベースのスクレイピングを誰でも手軽に実現できます。

Data Minerの特徴

- 5万以上の公開レシピ: LinkedIn、イエローページ、Amazonなど1.5万サイト以上にワンクリック対応。

- ポイント&クリックでカスタマイズ: 独自レシピもビジュアル操作で作成可能。

- ページネーション・自動化: 複数ページやURLリストも一括抽出。

- 直接エクスポート: CSV/ExcelダウンロードやGoogle Sheets連携。

料金: 月500ページまで無料。有料プランは月額約$19から。

おすすめ: ノンテクユーザーで、手早くブラウザ上で小~中規模のデータ抽出をしたい人。

AIウェブスクレイピングツール10選の比較

各ツールの特徴をまとめました:

| ツール | おすすめ用途 | AI機能 | 使いやすさ | 拡張性 | 料金 | サポート/コミュニティ |

|---|---|---|---|---|---|---|

| Thunderbit | ノーコード、ビジネスユーザー | LLMフィールド検出、自然言語UI | 非常に簡単 | 中(クラウド) | 無料、$15/月~ | メール迅速、開発活発 |

| import.io | 企業、データチーム | 自己修復AI、プロンプトAI | 普通 | 非常に高い | $299/月~ | 専任エンタープライズ |

| Bright Data | 大企業、AIプロジェクト | アンブロッカー、1億+プロキシ | 普通 | 極めて高い | 従量課金 | 企業向け、ドキュメント |

| ParseHub | アナリスト、中小企業、動的サイト | MLパターン検出 | 簡単~普通 | 中~高 | 無料、$189/月~ | ドキュメント、フォーラム |

| Scrapy | 開発者、カスタムワークフロー | LLM/NLPプラグイン | 難(コード) | 非常に高い | 無料(OSS) | コミュニティ、ドキュメント |

| Octoparse | SMB、ノーコード、チーム | AI自動検出、テンプレート | 非常に簡単 | 高(クラウド) | 無料、$75/月~ | ライブチャット、チュートリアル |

| WebHarvy | Windowsユーザー、中小企業、研究者 | パターン検出 | 非常に簡単 | 中 | $129買い切り | メール、レビュー |

| Apify | 開発者、スタートアップ、自動化 | AI連携、アクター | 普通 | 非常に高い | 無料、$49/月~ | ドキュメント、Slack、サポート |

| Diffbot | AI/データサイエンス、企業 | フルAI抽出、ナレッジグラフ | 簡単(API) | 極めて高い | 無料、$299/月~ | 専任、学術向け |

| Data Miner | ノンテク、手早いブラウザ作業 | 5万+レシピ、パターンAI | 非常に簡単 | 低~中 | 無料、$19/月~ | オフィスアワー、レシピ |

自分に合ったAIウェブスクレイピングツールの選び方

選び方のポイントをまとめました:

- ノーコード・手早く使いたい: Thunderbit、Octoparse、Data Miner、WebHarvy。

- 大規模・エンタープライズ用途: import.io、Bright Data、Diffbot。

- カスタム開発・自動化: Scrapy、Apify。

- 動的・複雑なサイト: ParseHub、Octoparse、Apify(ブラウザ自動化)。

- どんなページからも即時構造化データ: Diffbot。

- 買い切り型が良い: WebHarvy。

プロのコツ: 複数ツールの組み合わせもおすすめ。例えばThunderbitでデータをサクッと構造化し、WebHarvyでパターン検出を追加するなど、用途に合わせて使い分けると効率アップ。

主な判断基準:

- 予算: 無料枠はテストに最適。大規模用途は有料プランでサポートも充実。

- 技術力: ノーコードはビジネスユーザー向け、フレームワークは開発者向け。

- データ量: 小規模はブラウザ拡張、大規模はクラウド型が便利。

- サポート体制: 企業向けはSLAあり、他はコミュニティやメール対応が中心。

まとめ:AIでウェブスクレイピングの未来を切り拓く

AIの進化で、ウェブスクレイピングは開発者だけのものから、ビジネス現場の標準ツールへと進化中。リードリスト作成、価格監視、AIモデルへのデータ供給など、用途やスキルに合わせて最適なツールが選べる時代です。今回紹介した10のツールからも、その多様性とパワーが伝わるはず。

これからはさらに自然言語インターフェースやウェブ変化への適応力、業務フローとの連携が進化し、AIスクレイピングはどんどん賢くなっていくでしょう。まずは気になるツールをいくつか試して、自分のワークフローに合うものを見つけてみてください。複数ツールの組み合わせも大いにアリです。

最新のAIスクレイピングを体験したい人は、か、でさらに詳しいガイドをチェックしてみてください。ウェブデータ活用の未来は、もうコピペ地獄とは無縁です。

よくある質問

1. なぜ従来型ではなくAIでウェブスクレイピングすべき?

AI搭載웹 스크래퍼は、ウェブレイアウトの変化に自動対応し、パターン認識も自動。やりたいことを文章で伝えるだけでデータ抽出できるので、スピーディかつ信頼性の高いデータ取得が可能です。

2. ノーコード派におすすめのAIウェブスクレイピングツールは?

Thunderbit、Octoparse、Data Miner、WebHarvyは、コーディング不要で直感的に使えるインターフェースや自然言語対応が充実しています。

3. 大規模・エンタープライズ向けのおすすめは?

import.io、Bright Data、Diffbotは、大量ページ対応・高信頼性・法令遵守・API連携・専任サポートなど、企業ニーズに最適です。

4. 複数ツールの組み合わせは有効?

もちろんです。Thunderbitでサクッと構造化し、WebHarvyでパターン検出、Apifyで自動化など、用途ごとに最適なツールを組み合わせることで、より効率的なワークフローが実現します。

5. 無料で試せるAIウェブスクレイピングツールはある?

はい。多くのツールが無料枠やトライアルを提供しています。Thunderbit、Octoparse、Data Miner、Apifyは無料プランがあるので、まずは気軽に試してみましょう。

ウェブデータ活用をレベルアップしたい人は、ぜひいくつかのツールを試して、その効果を実感してみてください。さらに詳しい情報や最新のAI・自動化ノウハウはやもチェックしてみてください。ハッピー・スクレイピング!

さらに読む