火曜日の午後2時、上司から「競合の価格リストをまとめて」と頼まれ、目の前にはHTMLの壁に隠れたデータがズラリ…。Pythonで自作するか、それとも「魔法のボタン」があれば…とつい考えてしまう、そんな経験ありませんか?

今やウェブスクレイピングは、フード付きパーカーのハッカーや3画面のデータサイエンティストだけのものじゃありません。ビジネス担当やマーケター、リサーチャー、ウェブページをスプレッドシート化したい人まで、幅広く必要とされるスキルです。実際、ウェブスクレイピング業界はに成長し、今も拡大中。けれど、ツールが多すぎて「スイスアーミーナイフと手術用メス、どっちを選ぶ?」状態。今回はPython界の2大定番「Scrapy」と「Beautiful Soup」を徹底比較し、さらにノーコードAIツールがどんな人にピッタリかも紹介します。

Scrapy vs. Beautiful Soup:Pythonウェブスクレイピングの基本

「python スクレイパー」で検索したことがあれば、ScrapyとBeautiful Soupの名前は必ず目にしたはず。どちらも有名ですが、役割や使い勝手は大きく違います。

- Scrapyはフレームワーク。キッチン家電一式のように、ページ取得・リンク追跡・データ解析・出力まで全部自動でやってくれます。大規模サイトのクロールやリクエスト管理、データパイプラインの自動化に最適。

- Beautiful Soupはライブラリ。鋭いシェフナイフのようにHTML解析に特化していますが、材料(HTML取得)や調理(クロール・保存)は自分で用意する必要あり。

どちらも「python スクレイパー」=ウェブサイトからデータを抜き出すスクリプト作成に使われますが、選ぶポイントは機能だけでなく、プロジェクトの規模や自分のコーディング経験も大きく関わってきます。

Scrapyを使うべきシーン:大規模・自動化に強いウェブスクレイピング

例えば、ECサイト全体の商品ページを定期的に取得したい、数千ページをクロールしたい、ボット対策も突破したい…そんな時こそScrapyの出番。

Scrapyは大規模かつ自動化されたウェブスクレイピングに特化しています。

- 非同期リクエスト:複数ページを同時に高速取得。

- クロール機能:リンク追跡やページネーションも自動で処理。

- パイプライン:データのクレンジングやCSV/JSON/DBへの出力も標準装備。

- プロキシ・ユーザーエージェント切替:ボット対策もミドルウェアで対応。

- スケジューリング:定期実行や監視も簡単。

毎日自動で動かしたい、エラー処理や拡張性も重視したいなら、Scrapyはまさにプロのキッチンスタッフのような存在です。

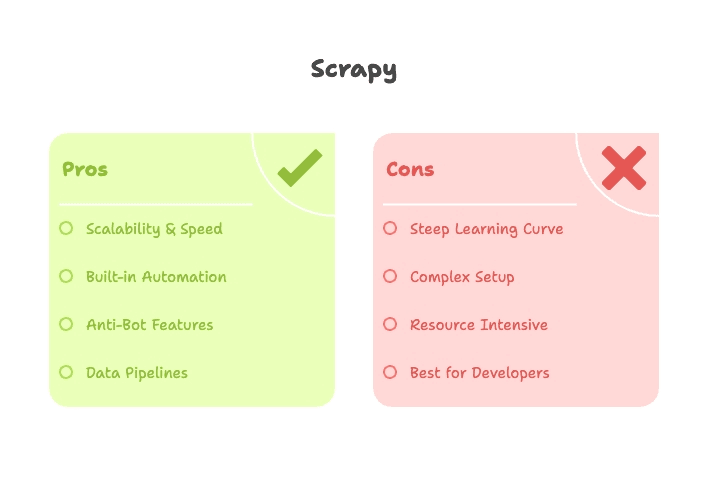

Scrapyの強み

- スケーラビリティ:数千〜数百万ページも効率的にクロール可能()。

- 高速処理:非同期エンジンで大規模案件もスピーディ()。

- 拡張性:CAPTCHA対応やJavaScriptレンダリング、S3出力などもプラグインで追加可能。

- 自動化:本格的な定期運用に最適。

Scrapyの注意点・学習コスト

ただし、Scrapyは初心者向けとは言えません。スパイダーやパイプライン、ミドルウェア、プロジェクト構成など覚えることが多く、インストールも依存関係(Twistedなど)でつまずきがち。セレクタのデバッグも慣れが必要です。

- 学習コストが高い:最初のスパイダー作成まで数時間〜数日かかることも()。

- 小規模案件には不向き:1ページだけ取得したい場合は大げさ。

- JavaScript対応は別途必要:SplashやSeleniumなどとの連携が必要。

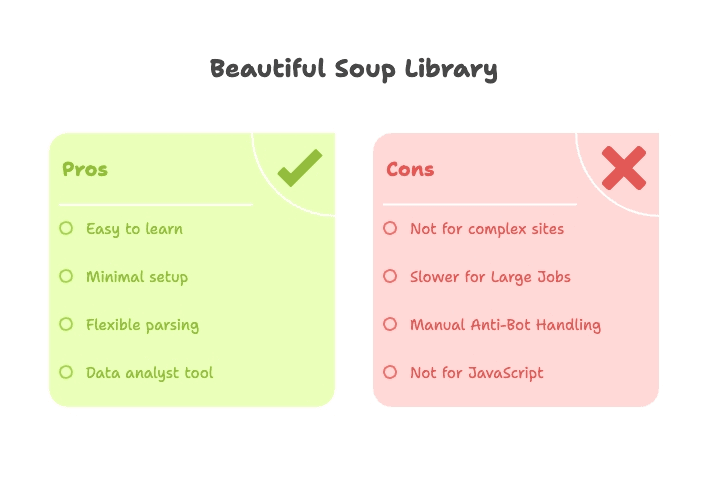

Beautiful Soup:手軽・柔軟・初心者にやさしいウェブスクレイピング

一方、最新ニュースの見出しだけ取得したい、Wikipediaの表を一度だけ抽出したい…そんな時はBeautiful Soupが最適。

Beautiful Soupは軽量なHTML/XMLパーサーライブラリ。ページ取得は自分で(通常はrequestsライブラリと組み合わせて)行い、Beautiful SoupでHTMLを解析・データ抽出します。

- セットアップが簡単:pipでインストール、importしてすぐ使える。

- 学習コストが低い:Python初心者でも1〜2時間で結果が出せる()。

- 柔軟な解析:タグ・クラス・ID・テキストなど多様な検索が可能。

Beautiful Soupのメリット

- 初心者に最適:フレームワーク不要、基本的なPythonとHTMLの知識だけでOK。

- すぐに結果が出る:プロトタイピングや学術用途、単発のデータ取得に最適。

- 柔軟性:requestsやpandasなど他のPythonツールと組み合わせやすい。

- 壊れたHTMLにも強い:Beautiful Soupは不完全なマークアップも解析可能。

Beautiful Soupの弱点

- クロール機能なし:ページ遷移やリンク追跡は自分でループを書く必要あり。

- 大規模案件は遅い:逐次処理のため、数百ページ以上は非効率。

- ボット対策機能なし:ヘッダーやプロキシ設定も手動、ブロック対応も自力。

- 動的コンテンツは苦手:JavaScript対応にはSeleniumやPlaywrightが必要。

Scrapy vs. Beautiful Soup:機能比較一覧

両者の違いをざっくり表でまとめるとこんな感じです:

| 機能 | Scrapy | Beautiful Soup |

|---|---|---|

| タイプ | フレームワーク(オールインワン) | ライブラリ(パーサーのみ) |

| セットアップ | プロジェクト構成・CLI・設定ファイル | シンプルなスクリプト・pipインストール |

| 得意分野 | 大規模・定期・自動化スクレイピング | 小規模・試作・単発タスク |

| 速度 | 大規模で高速(非同期・並列) | 単一ページは速いが大規模は遅い |

| クロール | 標準搭載(リンク追跡・ページネーション) | 手動(自作ループが必要) |

| ボット対策 | プロキシ・UA切替・リトライ・プラグイン | 手動(requestsでヘッダー・プロキシ設定) |

| 拡張性 | プラグイン・ミドルウェア・パイプライン | 他のPythonライブラリと組み合わせ |

| 学習コスト | 高い(スパイダー・パイプライン・非同期) | 低い(基本的なPython+HTML) |

| 動的コンテンツ | プラグイン必要(Splash, Selenium等) | Selenium/Playwrightが必要 |

| データ出力 | CSV, JSON, DB(標準搭載) | 手動(ファイル書き出しやpandas利用) |

| おすすめユーザー | 開発者・データエンジニア・継続案件 | 初心者・アナリスト・簡易スクリプト |

まとめると、Scrapyは大規模・複雑・定期的な案件に最適(Pythonやフレームワークに慣れている人向け)。Beautiful Soupは小規模・単発・初心者や試作にぴったりです。

学習コスト:初心者にやさしいPythonスクレイパーは?

正直、ちょっとした表を抜き出すだけで1週間も勉強したくないですよね。

- Beautiful Soup:PythonとHTMLの基礎があれば、午後にはスクレイピングができるようになります。チュートリアルも豊富で、すぐに成果が出せます()。

- Scrapy:スパイダーやパイプライン、非同期処理、CLIツールなど覚えることが多め。簡単な「Hello World」よりは一歩進んだ内容です()。

エンジニアじゃない人や「とにかく早く終わらせたい」人にはBeautiful Soupがやさしい選択肢。ただし、毎日自動で動かしたい・エラー処理も必要なら、Scrapyを学ぶ価値は十分あります。

パフォーマンスとボット対策:Scrapy vs. Beautiful Soupの実力

パフォーマンス:

- Scrapy:標準で並列処理に対応。16ページ、32ページ…と同時に取得できるため、大規模案件で圧倒的な速さ()。

- Beautiful Soup:逐次処理なので、数ページなら十分速いですが、大量ページには不向き。

ボット対策:

- Scrapy:プロキシ・UA切替・リトライ・CAPTCHA対応やJavaScriptレンダリングもプラグインで対応可能()。

- Beautiful Soup:全て手動。requestsでヘッダーやプロキシを設定する必要があり、ブロックされた場合も自力で対応()。

代表的な用途:Pythonスクレイパーの選び方早見表

用途別のおすすめツールをまとめました:

| 用途 | 最適なツール | 理由 |

|---|---|---|

| リード獲得(少量) | Beautiful Soup | 数ページの単発抽出に最適 |

| リード獲得(大量・継続) | Scrapy または Thunderbit | 開発者はScrapy、非エンジニアはThunderbitで自動化 |

| EC価格監視 | Scrapy または Thunderbit | カスタム・定期クロールはScrapy、即時・ノーコードはThunderbit |

| ニュース・コンテンツ監視 | Scrapy または Thunderbit | 定期・複数サイトはScrapy、ビジネス用途や手軽さ重視はThunderbit |

| SEO監査(少数ページ) | Beautiful Soup | スクリプトで手軽に実行可能 |

| SEO監査(全体) | Scrapy | サイト全体をクロールし構造化データを出力 |

| SNSデータ取得 | Thunderbit | テンプレート・動的コンテンツ対応・ノーコード |

| 学術研究(単発) | Beautiful Soup | プロトタイピングや最小構成に最適 |

| データ拡張・集約 | Thunderbit | AIによるデータ拡張、Sheets/Airtableへの簡単出力 |

多くのビジネスユーザーにとって、開発者でなければのようなツールが「時短の救世主」になるはずです。

Python不要:ノーコードで使えるThunderbitのご紹介

ここで大事なことを一つ。「全員がコードを書きたいわけじゃない」。実際、ウェブページをスプレッドシート化したいだけなら、Pythonを学ぶ必要はありません。

そこで登場するのが。ThunderbitはノーコードAIウェブスクレイパーで、Chrome拡張機能として数クリックでどんなサイトからもデータを抽出できます。特徴は以下の通り:

- Python不要・セットアップ不要:拡張機能を入れてページを開くだけ。

- AIフィールド提案:「AIフィールド提案」をクリックすれば、ページを自動解析し、最適なカラムを提案・テーブル化()。

- サブページ取得:リンク先の詳細データも自動で取得・データ拡張()。

- ページネーション・無限スクロール対応:複数ページや無限スクロールもワンタッチでOK。

- 即時データ出力:Google Sheets、Airtable、Notionへの連携やCSV/Excelダウンロードも簡単()。

- リアルタイムプレビュー:抽出結果をその場で確認可能。

- AIによるデータ拡張:要約・分類・翻訳もワンクリック()。

さらに、AmazonやLinkedIn、Googleマップなど人気サイト用のテンプレートも用意。ビジネス用途の大半は「ボタンを押すだけ」で完結します。

ThunderbitがPython系ツールより優れている理由

- 学習コストゼロ:PythonやHTML、エラーのデバッグ不要。ブラウザ操作ができればOK。

- 圧倒的な速さ:「このデータが欲しい」→「はい、スプレッドシートです」まで数分。

- メンテナンス不要:AIが多くのサイト変更に自動対応、テンプレートも随時更新。夜中にスクリプトが壊れる心配なし。

- ボット対策も安心:ブラウザ上で動作(実ユーザーのように見える)またはクラウド実行でブロック回避。

- チーム共有も簡単:テンプレートや結果をチームで共有、コード管理不要。

- コストパフォーマンス:小規模なら無料、大規模でも手頃な有料プラン()。

営業・マーケ・オペレーションなど「今すぐデータが欲しい」方にはThunderbitが最適です。(Pythonスクリプトのデバッグで夜更かしした経験がある身としては、本当にありがたい…)

最適なウェブスクレイピングツールの選び方

どのツールを選ぶべきか?簡単なフローチャートでまとめます:

- Pythonでのコーディングに慣れていますか?

- はい:次へ。

- いいえ:などノーコードツールを使いましょう。

- プロジェクトは小規模(1ページ・単発・試作)ですか?

- はい:Beautiful Soup(+requests)を使いましょう。

- いいえ:大規模・定期・複雑な案件はScrapyが最適。

- ボット対策・並列処理・自動化が必要ですか?

- はい:Scrapyが最適。

- いいえ:Beautiful Soupで十分です。

- 即時結果・簡単な出力・チーム共有が必要ですか?

- はい:Thunderbitが最適。ノーコードで手間いらず。

チェックリスト:

| ニーズ | 最適なツール |

|---|---|

| コーディング不要・即時結果 | Thunderbit |

| 小規模・単発・スクリプト化 | Beautiful Soup |

| 大規模・自動化・複雑クロール | Scrapy |

| 継続的なビジネスデータ収集 | Thunderbit または Scrapy |

| 学術プロトタイピング | Beautiful Soup |

まとめ:Scrapy・Beautiful Soup・Thunderbit、あなたに最適なのは?

ウェブスクレイピングは、かつてないほど身近で重要なスキルになりました。堅牢なデータパイプラインを構築したい開発者も、ウェブページをスプレッドシート化したいビジネスユーザーも、必ず自分に合ったツールが見つかります。

- Scrapy:開発者向け。大規模・定期・複雑な案件に最適。パワフルだが学習コストあり。

- Beautiful Soup:初心者やアナリスト、少量データの抽出に最適。シンプルで柔軟、試作にもおすすめ。

- Thunderbit:ノーコード・AI搭載の万能型。コーディングやデバッグ、メンテナンス不要で、数分でデータ抽出・拡張・出力が可能。

ノーコードスクレイピングを体験したい方は、をぜひお試しください。さらに詳しいガイドや活用事例はでもご紹介しています。

結局のところ、「自分が欲しいデータを、無駄な苦労なく手に入れられる」ことが一番大切。もしウェブスクレイピングの苦労話を語り合いたくなったら、いつでもご連絡ください。

よくある質問(FAQ)

1. 初心者にはScrapyとBeautiful Soupどちらが向いていますか?

Beautiful Soupの方が圧倒的に初心者向きです。インストールも簡単で、理解しやすく、小規模なスクレイピングに最適。Scrapyは高機能ですが、学習コストが高く、開発者向けです。

2. ScrapyやBeautiful Soupはコーディングなしで使えますか?

基本的にどちらもPythonの知識とHTMLの理解が必要です。スクリプトを書かずに使いたい場合は、のようなノーコードツールがおすすめ。ブラウザ上で直感的にデータ抽出ができます。

3. ScrapyとBeautiful Soupを同時に使う必要はありますか?

ほとんどの場合、どちらか一方で十分です。Scrapyは独自のパーサーを持ち、単独で動作します。Beautiful Soupは小規模案件向け。上級者が組み合わせることもありますが、実用面では単体利用で問題ありません。

4. JavaScriptや無限スクロール対応は?

ScrapyもBeautiful Soupも標準ではJavaScriptに非対応。Seleniumなどの追加ツールが必要です。は多くの動的サイトや無限スクロールにも自動対応します。

5. 1ページだけスプレッドシート化したい場合、Pythonを学ぶ必要は?

いいえ。価格リストやディレクトリをExcel化したいだけなら、ScrapyやBeautiful Soupを学ぶのは大げさです。なら2クリックで完了、コードは一切不要です。

さらに詳しく知りたい方は、、、またはをご覧ください。