ECサイトから商品データを初めて取得しようとしたときのこと、今でもよく覚えています。Python片手にコーヒーを飲みながら「Amazonの価格トラッカーを作るぞ!」と意気込んだものの、数時間後にはXPathの迷路やページネーションの罠、終わりの見えないデバッグに頭を抱えていました。もしウェブデータをコードで扱った経験があるなら、この“ワクワクと混乱”が入り混じる感覚、きっと共感できるはずです。

今やウェブスクレイピングはデータサイエンティストやエンジニアだけのものではありません。営業やEC運営、マーケターなど、ウェブ上の膨大な情報をビジネスに活かしたい人にとって、もはや必須スキルです。実際、ウェブスクレイピング関連のソフトウェア市場はに到達し、今後も拡大が予想されています。ただし、PythonやScrapyのようなフレームワークは大規模・カスタム用途には最適ですが、初心者にはややハードルが高いのも事実。そこで今回は、Amazonを例にScrapyの使い方をわかりやすく解説しつつ、ノーコードで使えるAI搭載の新しい選択肢もご紹介します。

Scrapy Pythonとは?ウェブスクレイピングの最強ツール

まずは基本から。Scrapyは、ウェブクローリングとスクレイピングのために作られたオープンソースのPythonフレームワークです。いわば「自分専用のクローラー(Scrapyでは“スパイダー”と呼びます)」を作り、ウェブサイトを巡回しながらリンクをたどり、ページネーションも自動で処理し、構造化データを大量に抽出できる万能ツールです。

PythonのrequestsやBeautifulSoupと何が違うの?と思うかもしれません。これらは単発のデータ取得には便利ですが、Scrapyは大規模かつ複雑な案件向けに設計されています。たとえば:

- 数千ページ規模のクロール(ECサイト全商品など)

- 自動でリンクをたどりページネーションも処理

- 非同期処理で高速にデータ取得

- データの整形・クレンジング・エクスポートを一括管理

つまり、Scrapyはウェブスクレイピング界の“十徳ナイフ”。パワフルで柔軟ですが、初心者には少し敷居が高いかもしれません。

なぜウェブスクレイピングにScrapy Pythonを使うのか?

開発者やデータチームがScrapyを選ぶ理由をまとめると:

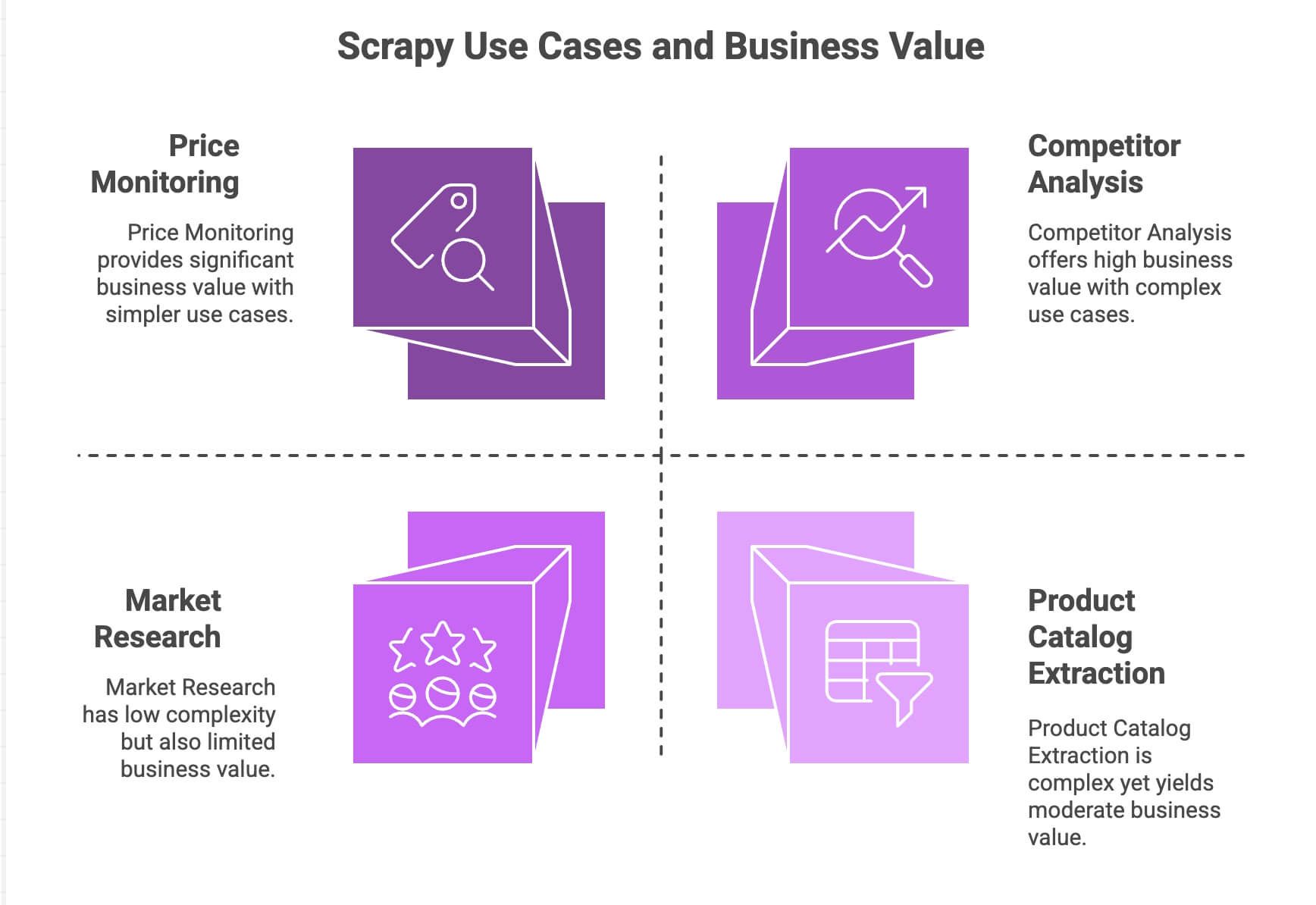

| ユースケース | Scrapyの強み | ビジネス価値 |

|---|---|---|

| 価格監視 | ページネーション・非同期リクエスト・スケジューリング対応 | 競合より先手、動的価格戦略 |

| 商品カタログ抽出 | リンク追跡・構造化データ抽出 | 商品DB構築・分析基盤に活用 |

| 競合分析 | スケーラブル・サイト変更に強い | トレンドや新商品、在庫状況の把握 |

| 市場調査 | データ整形・変換のパイプライン | レビュー集約・感情分析など |

Scrapyは非同期エンジン(Twistedベース)で複数ページを同時に高速取得できます。モジュール設計なので、プロキシやユーザーエージェント、データクレンジングなども柔軟にカスタマイズ可能。パイプライン機能で、データの検証・整形・エクスポートも自在です。

Pythonに慣れているチームならScrapyは強力な武器ですが、正直なところ、一般的なビジネスユーザーには“お手軽”とは言いにくいのが現実です。

Scrapy Pythonの環境構築

実際に手を動かしてみましょう。Scrapyのセットアップ手順は以下の通りです。

1. Scrapyのインストール

まずPython 3.9以上がインストールされていることを確認し、ターミナルで以下を実行:

1pip install scrapyインストール確認:

1scrapy versionWindowsやAnaconda環境の場合は仮想環境の利用をおすすめします。ScrapyはWindows、macOS、Linuxすべて対応です。

2. 新規Scrapyプロジェクト作成

amazonscraperという新しいプロジェクトを作成:

1scrapy startproject amazonscraper生成されるフォルダ構成:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/各ファイルの役割

scrapy.cfg: プロジェクト設定(通常は触らない)items.py: データモデル定義(例:商品名、価格など)pipelines.py: データの整形・検証・エクスポート処理middlewares.py: プロキシやカスタムヘッダーなど高度な設定settings.py: 同時実行数や遅延などの挙動調整spiders/: 実際のスクレイピングロジックを記述

「もうすでに難しそう…」と感じた方も大丈夫。多くのノンコーダーがここでつまずきます。

Pythonスクレイパーを作る:ScrapyでAmazon商品データを取得

実際にAmazonの検索結果から商品データを取得する例で解説します。(注意:Amazonはスクレイピングを禁止しており、強力な対策も施しています。ここでは学習目的のサンプルです)

1. スパイダーの作成

spiders/フォルダ内にamazon_spider.pyを作成:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)このコードのポイント:

- 「スマートフォン」の検索結果ページからスタート

- 各商品ごとにXPathで名前・価格・評価を抽出

- 「次のページ」リンクを見つけて自動でページ送り

2. スパイダーの実行

プロジェクトルートで以下を実行:

1scrapy crawl amazon_example -o products.jsonこれでScrapyが検索結果を巡回し、ページネーションも自動で処理しながらデータをJSONファイルに保存します。

ページネーションや動的コンテンツへの対応

Scrapyはリンク追跡やページネーション処理が得意ですが、JavaScriptで動的に生成されるコンテンツ(無限スクロールやポップアップレビューなど)は標準では取得できません。こうした場合はSeleniumやSplashなどの外部ツールと連携が必要です。

Scrapy Pythonでのデータ整形・エクスポート

取得したデータは、用途に合わせて整形・エクスポートしましょう。

- パイプライン:

pipelines.pyでPythonクラスを作成し、価格の数値変換や不完全な行の除外、翻訳APIの呼び出しなども可能 - エクスポート:Scrapyは

-oフラグでCSV/JSON/XMLに直接出力できます。Google Sheetsなどへの連携は追加のコードや外部ライブラリが必要です。

感情分析や商品説明の翻訳なども、外部APIやPythonライブラリを自分で組み込む必要があります。

Scrapy Pythonの落とし穴:ビジネスユーザーが直面する課題

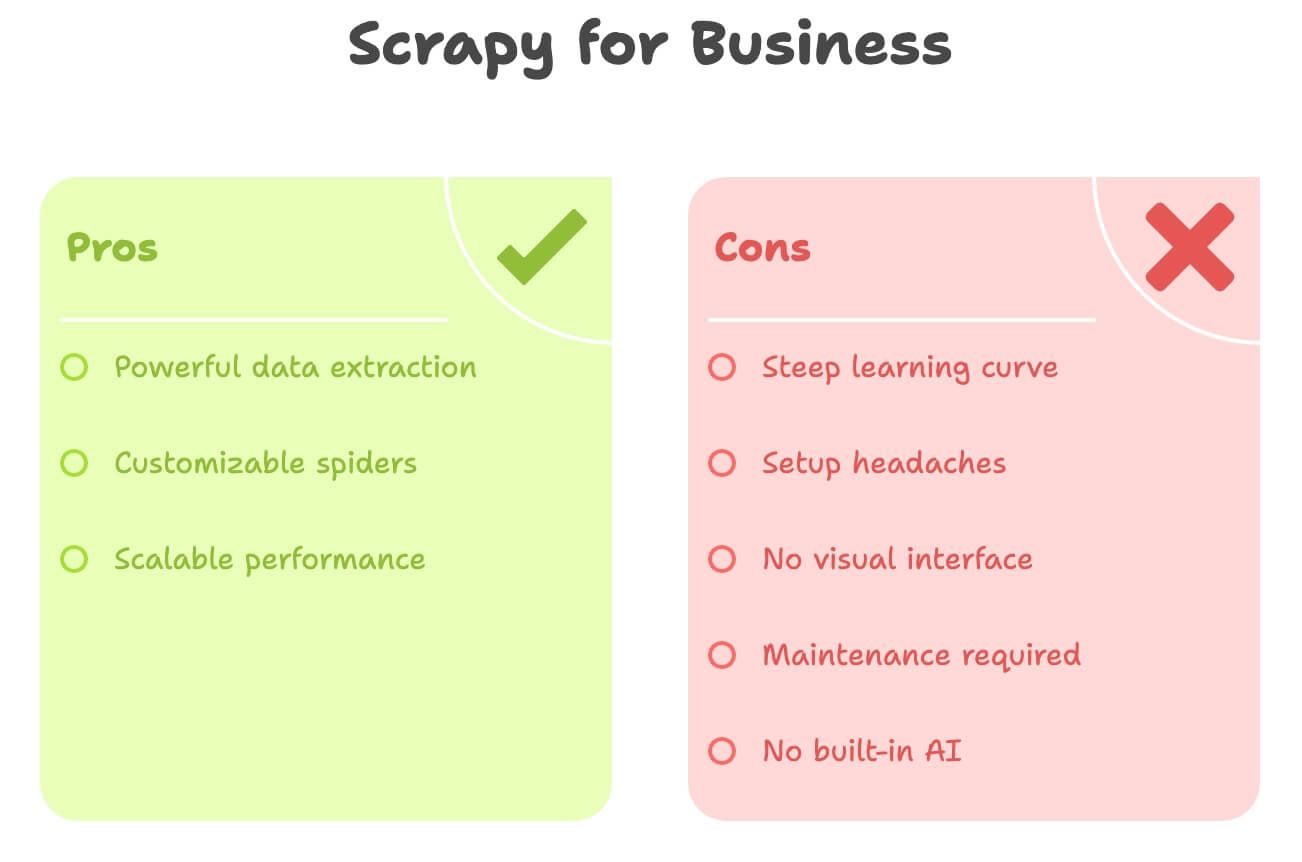

正直なところ、Scrapyは強力ですがノンエンジニアにはハードルが高いです。よくあるつまずきポイントは:

- 学習コストが高い:Python、HTML、XPath/CSS、Scrapyの構造など幅広い知識が必要。慣れるまで数日〜数週間かかることも

- セットアップが面倒:Pythonのインストールや依存関係の管理、エラー対応など特にWindows環境では手間がかかる

- ビジュアル操作不可:すべてコードで記述。画面上でクリックしてデータを選択することはできない

- メンテナンス負担:サイト構造が変わるとスパイダーが動かなくなり、都度修正が必要

- AI機能なし:翻訳や要約、感情分析などはすべて自作で追加

比較表はこちら:

| 課題 | Scrapy (Python) | ビジネスユーザーの理想 |

|---|---|---|

| コーディング必須 | 必要 | できればノーコード |

| セットアップ時間 | 数時間〜数日 | 数分 |

| メンテナンス | サイト変更ごとに対応 | 最小限 |

| データ出力 | CSV/JSON(手動連携) | Excel/Sheets/Notionへ直接出力 |

| AI機能 | なし(自作連携) | 翻訳・感情分析など内蔵 |

マーケターや営業、オペレーション担当者にとっては、Scrapyは“水鉄砲の戦いにバズーカを持ち込む”ようなものかもしれません。

Thunderbit登場:Scrapy Pythonのノーコード代替ツール

ここでの出番です。自動化ツールを長年開発してきた立場から言うと、多くのビジネスユーザーは「コードを書きたい」のではなく「すぐにデータが欲しい」のです。

ThunderbitはAIウェブスクレイパーとしてChrome拡張機能で提供され、技術知識がなくても:

- どんなウェブサイトでも数クリックでデータ取得

- 「商品名、価格、評価」など自然言語で抽出項目を指定

- ページネーションやサブページも自動処理

- Excel、Google Sheets、Airtable、Notionへワンクリックでエクスポート

- 翻訳・要約・感情分析もその場で実行

Pythonもセレクタも不要。メンテナンスの手間もありません。

Thunderbitは「とにかく早く」「AIにお任せしたい」ビジネスユーザー向けに設計されています。

Thunderbit vs. Scrapy Python:徹底比較

両者を並べて比較してみましょう:

| 項目 | Scrapy (Python) | Thunderbit (AIツール) |

|---|---|---|

| 必要スキル | Python、HTML、セレクタ | なし(クリック&自然言語) |

| セットアップ時間 | 数時間(インストール・コーディング・デバッグ) | 数分(拡張機能インストール&サインイン) |

| データ構造化 | 手動(itemsやパイプライン定義) | AIが自動でカラム提案 |

| ページネーション/サブページ | コード記述が必要 | 1クリック(AIが自動処理) |

| 翻訳 | カスタムコードやAPI連携 | 内蔵機能—「翻訳」トグルでOK |

| 感情分析 | 外部ライブラリ/API | 内蔵—「感情」カラム追加でOK |

| エクスポート先 | CSV/JSON(手動でExcel/Sheetsにインポート) | Excel、Google Sheets、Airtable、Notionへワンクリック |

| メンテナンス | サイト変更時は手動修正 | 軽微な変更はAIが自動対応 |

| スケール | 大規模・継続案件向き | クイックなタスクや中規模(数百〜数千行)向き |

| コスト | 無料(ただし開発工数が必要) | 無料枠+有料プラン(月9ドル〜、大幅な時短効果) |

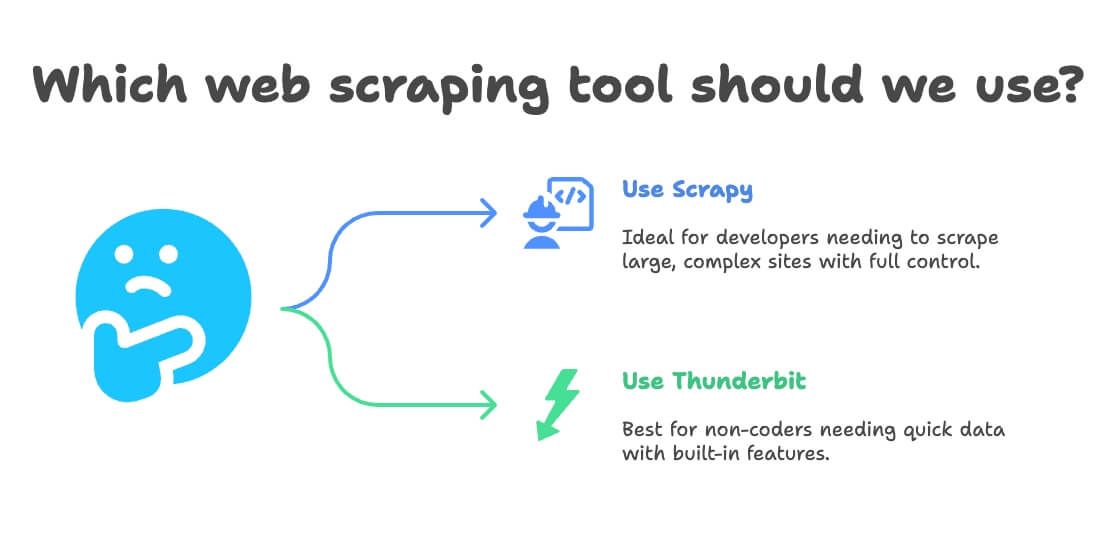

Scrapy PythonとThunderbit、どちらを選ぶべき?

ざっくり判断基準は:

- Scrapyを使うべきケース

- 開発者がいる、または自分でPythonが書ける

- 数万ページ規模の大規模・継続的なスクレイピングが必要

- サイト構造が複雑、独自ロジックが必要

- 完全なカスタマイズ性を重視し、メンテナンスも厭わない

- Thunderbitを使うべきケース

- コーディング不要、またはしたくない

- すぐにデータが欲しい、単発または定期的な業務タスク

- 翻訳や感情分析などAI機能も活用したい

- スピードと柔軟性を重視し、細かいカスタマイズは不要

判断フローはこんな感じ:

- Pythonが書ける?

- Yes → ScrapyもThunderbitもOK(手軽さ重視ならThunderbit)

- No → Thunderbit一択

- 大規模・継続案件?

- Yes → Scrapy

- No → Thunderbit

- 翻訳や感情分析が必要?

- Yes → Thunderbit

- No → どちらでもOK

実践:ThunderbitでAmazon商品データをノーコード取得

先ほどのAmazon例を、今度はThunderbitで簡単にやってみましょう。

1. Thunderbitをインストール

- サインアップ(無料枠あり)

2. Amazonで商品を検索

- で「laptops」など好きな商品を検索

3. Thunderbitを起動

- ブラウザのThunderbitアイコンをクリック

- サイドパネルが開き、Amazonページを自動認識

4. AIフィールド提案を利用

- **「AIフィールド提案」**をクリック

- ThunderbitのAIがページを解析し、「商品名」「価格」「評価」「レビュー数」などのカラムを自動提案

- 必要に応じてカラムを追加・削除(「商品URL」や「Prime対象」なども自由に指定可能)

5. ページネーション・サブページ取得を有効化

- ページネーションをON:Thunderbitが「次へ」を自動クリックし全ページを取得

- サブページ取得をON:各商品の詳細ページも巡回し、説明文やASINなど追加情報も取得

6. スクレイピング実行

- スクレイプをクリック

- Thunderbitがリアルタイムでデータを収集

7. 翻訳・感情分析もワンタッチ

- 商品説明を翻訳したい場合は「翻訳」トグルをON

- レビューの感情分析をしたい場合は「感情」カラムを追加

8. データをエクスポート

- エクスポートをクリック

- Excel、Google Sheets、Airtable、Notionから選択

- 面倒なCSV変換や手動インポート不要、すぐに使えるデータが手に入ります

9. 定期スクレイピングも可能(オプション)

- スケジュール設定(例:毎朝8時)

- Thunderbitが自動でスクレイピングし、指定先を更新

これだけ。コードもセレクタもメンテナンスも不要。ビジネスで即使えるデータが手に入ります。

おまけ:ウェブスクレイピングをもっと活用するコツ

ScrapyでもThunderbitでも、以下のポイントを押さえると成果がグッと上がります:

- データの検証:欠損値や異常値(例:価格0円や空欄)を必ずチェック

- 法令遵守:サイトの利用規約やrobots.txtを確認し、サーバーに負荷をかけすぎない

- 自動化の最適化:必要以上に頻繁にスクレイピングしない、スケジューリングで効率化

- 無料ツールの活用:Thunderbitにはメール・電話番号・画像抽出など無料機能も充実。リード獲得やコンテンツ収集に便利

- 分析しやすい形で整理:SheetsやExcelに直接エクスポートし、フィルタやピボットで素早く分析

さらに詳しいノウハウはやも参考にしてください。

まとめ:ウェブスクレイピングは“目的に合ったツール選び”がカギ

結論:Scrapyは開発者向けの強力ツールですが、多くのビジネスユーザーにはオーバースペックです。 Pythonでカスタム・大規模なスクレイパーを作りたいならScrapyが最適ですが、「とにかく早く・ノーコードで・翻訳や感情分析も使いたい」ならが断然おすすめです。

Thunderbitを使えば、非エンジニアのチームでも「このデータが欲しい!」から「もうスプレッドシートに入ってる!」まで数分で完了。AIフィールド提案やサブページ取得、ワンクリックエクスポートなど、ビジネスインテリジェンス化がこれまでになく簡単になります。

次に商品データの取得や価格監視、リードリスト作成が必要になったときは、「Pythonを書くか?それとも結果を出すか?」を考えてみてください。Thunderbitの無料枠で、ウェブスクレイピングの新しい体験をぜひ試してみてください。

もっと知りたい方は、、またはでウェブスクレイピングの最新情報をチェック!

関連記事:

注意:ウェブスクレイピングは必ず各サイトの利用規約や法令を守って行いましょう。不安な場合は専門家に相談を。思わぬトラブルを避けるためにもご注意ください。

執筆:Shuai Guan(Thunderbit共同創業者・CEO)。SaaS・自動化・AI分野での経験を活かし、皆さんの業務効率化をサポートします。