世界中のリアルタイムな会話の多くがTwitter(今はX)で繰り広げられています。、されているTwitterは、ビジネスやリサーチ、トレンド把握や世論調査をしたい人にとってまさに情報の宝庫。でも、実際にそのデータを手に入れるのは年々ハードルが上がっています。TwitterのAPIはどんどん制限が厳しくなり(しかも高額!)、多くの人が他の方法を探し始めています。

そこで活躍するのが、Pythonを使ったウェブスクレイピングやのようなツール。自動でデータを集めたいエンジニアも、ノーコードでサクッとトレンドを知りたい人も、それぞれに合ったやり方があります。この記事では、APIを使わずにpythonでtwitterデータをスクレイピングする方法や注意点、Thunderbitなら誰でも簡単にtwitterスクレイパーとして使える理由をわかりやすく解説します。

Twitterデータスクレイピングって何?なぜ必要?

Twitterデータスクレイピングは、APIを使わずにTwitterの公開ページ(ツイート、プロフィール、ハッシュタグ、トレンドなど)から直接データを取得する方法です。手作業でコピペもできますが、自動化ツールやスクリプトを使えば圧倒的に効率的。

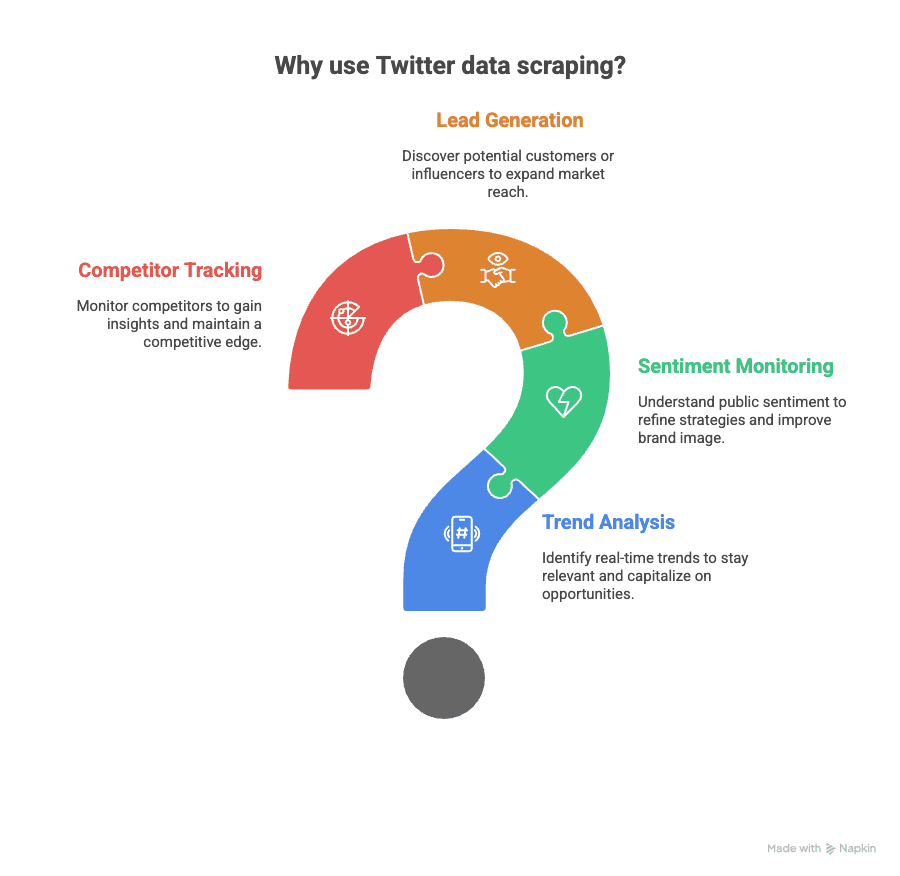

なぜ重要なのか?Twitterデータは、いろんなビジネスや研究現場で大活躍しています。

- トレンド分析:今話題になっていることや最新ニュースをリアルタイムでキャッチ

- 感情分析:商品やブランド、政治イベントへの世間の反応を調べる

- リード獲得:自社業界について話している潜在顧客やインフルエンサーを発見

- 競合調査:ライバル企業の動きや評判をウォッチ

以前はが主流でしたが、2024年以降は無料枠がなくなり、基本プランでも月数万円〜数十万円かかることも。APIはがあり、認証も面倒です。

だからこそ、python twitterやノーコードツールによるウェブスクレイピングが、コスパや柔軟性の面で注目されています。

Pythonでtwitterデータ取得:APIの壁を突破

ちょっと技術寄りの話をします。pythonでtwitterデータを取得する場合、ブラウザを自動操作してTwitterのページを開き、HTMLを解析して必要な情報を抜き出します。APIの制限や料金を気にせず、公開されている情報をそのままゲットできるのが大きな魅力。

Twitterスクレイピングに使えるPythonライブラリ

APIなしでtwitterスクレイパーを作るときによく使われるライブラリはこちら:

- :静的なHTML解析が得意。軽くて速いけど、動的コンテンツ(無限スクロールなど)は苦手。

- :実際のブラウザ(ChromeやFirefoxなど)を自動操作できて、動的なサイトにも強い。JavaScriptやクリック、スクロールもOK。

- :新しめのライブラリで、Seleniumより速くて安定。最新のWebアプリにも強い。

これらを使えば、

- 公開ツイート(本文、日時、いいね数、リツイート数)

- ユーザープロフィール(自己紹介、フォロワー数、登録日)

- トレンドトピック

- ハッシュタグや検索結果

などが取得できます。

※注意:取得できるのは公開情報のみ。非公開アカウントやDMは対象外です。

Pythonスクレイピングライブラリの比較

それぞれの特徴をざっくりまとめると:

| ライブラリ | 得意分野 | JavaScript対応 | 速度 | 使いやすさ | 備考 |

|---|---|---|---|---|---|

| BeautifulSoup | 静的HTML解析 | いいえ | 高速 | 簡単 | シンプルなページ向け(requestsと併用) |

| Selenium | 動的コンテンツ・UI | はい | 普通 | 普通 | JSが多いサイトに最適 |

| Playwright | 最新の動的サイト | はい | 最速 | 普通 | 非同期対応、Seleniumより安定 |

Twitterは動的読み込みや無限スクロールが多いので、SeleniumやPlaywrightが特におすすめです(参照)。

Twitterデータを安全にスクレイピングするための注意点

pythonでtwitterデータ取得を始める前に、ルールをしっかりチェックしましょう。

- Twitterの利用規約を守る:2024年現在、されています。個人利用や研究目的で公開データだけを取得する場合は黙認されることが多いですが、公式にOKなわけではありません。

- アクセス頻度に注意:2〜5秒ごとにリクエストを送る、1時間あたりの取得ページ数を制限する、24時間連続で動かさないなど、過度なアクセスは避けましょう。ボット判定やIPブロックのリスクを減らせます(参照)。

- 公開データのみ取得:非公開アカウントやDM、ログインが必要な情報には絶対にアクセスしないこと。

- 法令遵守:個人情報(メールアドレスや氏名など)を扱う場合は、GDPRなどのプライバシー法に注意。必要に応じて匿名化や集計処理を行いましょう。

より詳しい法的ガイドはも参考にしてください。

pythonでtwitterデータをスクレイピングする手順

実際に、Seleniumを使って公開Twitterプロフィールからツイートを取得する基本的な流れを紹介します。

1. 環境構築

まず必要なライブラリをインストールします:

1pip install selenium pandas webdriver-manager2. スクレイパーの作成

以下はシンプルなサンプルスクリプトです:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5import pandas as pd

6import time

7# ドライバーのセットアップ

8driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

9# 取得したいTwitterプロフィールページにアクセス

10profile_url = '<https://twitter.com/nytimes>'

11driver.get(profile_url)

12time.sleep(5) # ページ読み込み待ち

13# スクロールしてツイートを追加読み込み

14for _ in range(3): # 取得数に応じて調整

15 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

16 time.sleep(3)

17# ツイート本文を抽出

18tweets = driver.find_elements(By.CSS_SELECTOR, '[data-testid="tweetText"]')

19tweet_texts = [tweet.text for tweet in tweets]

20# 投稿日時を抽出

21timestamps = driver.find_elements(By.CSS_SELECTOR, 'time')

22tweet_times = [ts.get_attribute('datetime') for ts in timestamps]

23# DataFrameにまとめる

24df = pd.DataFrame({'Tweet': tweet_texts, 'Timestamp': tweet_times})

25# Excelにエクスポート

26df.to_excel('twitter_scrape.xlsx', index=False)

27driver.quit()ポイント:

- スクロール回数を増やせば、より多くのツイートを取得可能

- いいね数やリツイート数なども、対応するCSSセレクタを指定すれば抽出できます(参照)

- エラーが出た場合は、Twitterのページ構造が変わっていないか確認し、セレクタを修正しましょう

データの解析・エクスポート

上記スクリプトはExcel出力ですが、CSVにも簡単に変更できます:

1df.to_csv('twitter_scrape.csv', index=False)「ツイート本文」「日時」「ユーザー名」「いいね数」「リツイート数」など、分析しやすい形で整理しましょう。

Thunderbit:ノーコードでtwitterデータ取得が超カンタン

「プログラミングは苦手」「もっと手軽にデータを集めたい」そんな人にはがぴったり。ThunderbitはAI搭載のChrome拡張で、数クリックでtwitterデータ取得ができます。Pythonや環境構築は一切不要。

Thunderbitでtwitterデータ取得の流れ

- ChromeでTwitterを開く

- Thunderbit拡張機能をクリック

- 取得したい内容を自然言語で指示:「このページの全ツイート・日付・ユーザー名を抽出して」など

- AIが自動で項目を提案:ツイート本文、日時、いいね数などを自動認識

- 「スクレイプ」ボタンを押す:必要に応じてサブページも取得

- エクスポート:Excel、Googleスプレッドシート、Airtable、Notion、CSVなどに即ダウンロード

も用意されているので、初期設定なしですぐに分析に移れます。

Thunderbitの強みは? コードやドライバー、CSSセレクタの知識が一切不要なこと。AIがTwitterのレイアウト変更にも自動で対応し、データの要約・分類・翻訳も同時にこなします(参照)。

ThunderbitとPython、どっちが自分向き?

両者の違いを比較してみましょう:

| 機能 | Pythonスクレイピング | Thunderbit(ノーコード) |

|---|---|---|

| コーディング必要 | 必要 | 不要 |

| セットアップ時間 | 30分以上 | 1〜2分 |

| 動的ページ対応 | 可能(Selenium/Playwright) | 可能(AI搭載) |

| カスタマイズ性 | 高い(コード次第) | 高い(AIプロンプトで調整) |

| メンテナンス | 手動(スクリプト修正) | AIが自動対応 |

| エクスポート形式 | CSV、Excel、JSON | Excel、Sheets、Notion、CSV |

| おすすめ対象 | 開発者・データ分析者 | ビジネスユーザー・非エンジニア |

細かく制御したいエンジニアや分析好きな人はPythonが最適ですが、多くのビジネスユーザーにはThunderbitの方が圧倒的に手軽でスピーディーです。(Thunderbit Chrome拡張はです)

実例:PythonとThunderbitでTwitterトレンドを取得

実際に、TwitterのトレンドをExcelに出力したい場合の流れを紹介します。

Pythonの場合

SeleniumやPlaywrightで:

- にアクセス

- スクロールしてトレンドを読み込み

- トレンド名・ツイート数・URLを抽出

- ExcelやCSVに保存

サンプルコード:

1# ...(セットアップは前述と同じ)

2driver.get('<https://twitter.com/explore>')

3time.sleep(5)

4trends = driver.find_elements(By.CSS_SELECTOR, '[data-testid="trend"]')

5trend_names = [trend.text for trend in trends]

6df = pd.DataFrame({'Trend': trend_names})

7df.to_excel('twitter_trends.xlsx', index=False)Thunderbitの場合

- ChromeでTwitterのExploreページを開く

- Thunderbitをクリックし、を選択、または「トレンドとツイート数を抽出」と指示

- スクレイプを実行

- ExcelやGoogleスプレッドシート、Notionに直接エクスポート

結果: どちらもデータ取得は可能ですが、Thunderbitなら数秒で完了し、Twitterの仕様変更にも強いです。

Twitterデータ活用の最適解:PythonとThunderbitの合わせ技

実は、どちらか一方だけでなく、両方を組み合わせることで最大限の効率化が可能です:

- Thunderbitで手軽にデータ収集:Twitter投稿・プロフィール・トレンドをノーコードで取得し、ExcelやGoogleスプレッドシートにエクスポート

- Pythonで高度な分析:エクスポートしたデータをPythonで読み込み、感情分析やNLP、可視化などを実施

- Thunderbitのスケジューリング機能で自動化:定期的なデータ取得も可能(参照)

- AirtableやNotionと連携:Thunderbitは直接エクスポートできるので、チームでリアルタイムにデータ共有も簡単

このハイブリッド運用なら、ノーコードのスピードとコードの柔軟性を両立できます。

Twitterスクレイピングのトラブル対策&コツ

Twitterは日々進化しているため、スクレイピングがうまくいかないことも。主なポイントは:

- セレクタの変更:Pythonスクリプトが動かなくなった場合、HTML構造の変更が原因かも。Thunderbitは自動対応しますが、スクリプトは都度修正が必要です。

- ブロック・IP制限:リクエスト間隔を空ける、必要に応じてIPをローテーションする、過度な取得は避ける

- 動的コンテンツ対応:無限スクロールにはSeleniumやPlaywrightで自動スクロール処理を

- 法令遵守:常にを確認し、責任を持ってデータ取得を

より詳しいトラブルシューティングは)やも参考にしてください。

まとめ・ポイント

Twitterデータは今や超貴重で、入手もどんどん難しくなっています。トレンド分析や感情モニタリング、リードリスト作成など、柔軟にデータを取得したいならスクレイピングが最適。pythonでtwitterデータ取得なら細かい制御ができ、なら誰でもノーコードでAIの力を活用できます。

- Pythonスクレイピング:カスタムワークフローやメンテナンスが苦にならない開発者向け

- Thunderbit:ビジネスユーザーやマーケター、研究者が素早く結果を出したいときに最適

- ハイブリッド運用:Thunderbitで取得→Pythonで分析→自動化も可能

常に「責任あるスクレイピング」「プライバシー・法令遵守」「Twitterの仕様変化への対応」を意識しましょう。会話は止まりません。あなたのデータ活用も、止まることはありません。

よくある質問(FAQ)

1. PythonやThunderbitでTwitterデータを取得するのは合法ですか?

公開Twitterデータを個人利用や研究目的で取得するのは黙認されていることが多いですが、AI学習や一部商用利用はTwitterの利用規約で禁止されています。常にを確認し、非公開・機密データは絶対に取得しないでください。

2. Twitter APIとウェブスクレイピングの違いは?

APIは構造化された安定したデータ取得が可能ですが、現在は高額かつ制限が多いです。ウェブスクレイピングは公開サイトを直接解析するためAPI制限を回避できますが、Twitterの仕様変更によりスクリプトの修正が必要になることもあります。

3. TwitterスクレイピングにおすすめのPythonライブラリは?

静的コンテンツならBeautifulSoupが手軽で高速。無限スクロールなど動的コンテンツにはSeleniumやPlaywrightが最適。Playwrightは最新Webアプリに強く、動作も高速です。

4. ThunderbitはなぜTwitterスクレイピングを簡単にできるの?

ThunderbitはAIでTwitterページを解析し、必要な項目を自動提案・抽出。数クリックでExcelやGoogleスプレッドシート、Notion、Airtableに直接エクスポートできます。コーディング不要で、レイアウト変更にも自動対応します。

5. ThunderbitとPythonを組み合わせて使えますか?

もちろん可能です。Thunderbitでデータを取得・エクスポートし、Pythonでさらに分析や加工を行うことで、スピードと柔軟性の両立が実現します。

さらに詳しく知りたい方へ: