ウェブサイトを見ていて、「このデータ、まとめてスプレッドシートに入れられたら最高なのに…」って思ったこと、きっとあるよね?手作業でコピペなんてやってられないし、時間ももったいない。2025年の今、ウェブスクレイピングはエンジニアだけのものじゃなくて、ビジネス現場でも当たり前のスキルになってる。営業リスト作りやECサイトの価格チェックなど、どんな業界でもウェブデータの需要はどんどん増えてるんだ。そして嬉しいことに、Pythonを使えば初心者でも意外と簡単にウェブスクレイピングを始められる。もし最後にコードを書いたのがMySpaceの背景をいじったときでも、全然問題なし!

このガイドでは、Pythonを使ったデータスクレイピングの基礎から応用まで、ステップごとに分かりやすく解説していくよ。静的サイトも動的サイトもバッチリ対応、さらにAI搭載のウェブスクレイパーThunderbitとPythonを組み合わせて、作業効率を爆上げする方法も紹介。完全な初心者も、データ活用をもっと極めたい人も、実践的なヒントやコード例、SaaS業界で培ったノウハウをしっかりお届け!

ウェブスクレイピングって何?なぜPythonが選ばれるの?

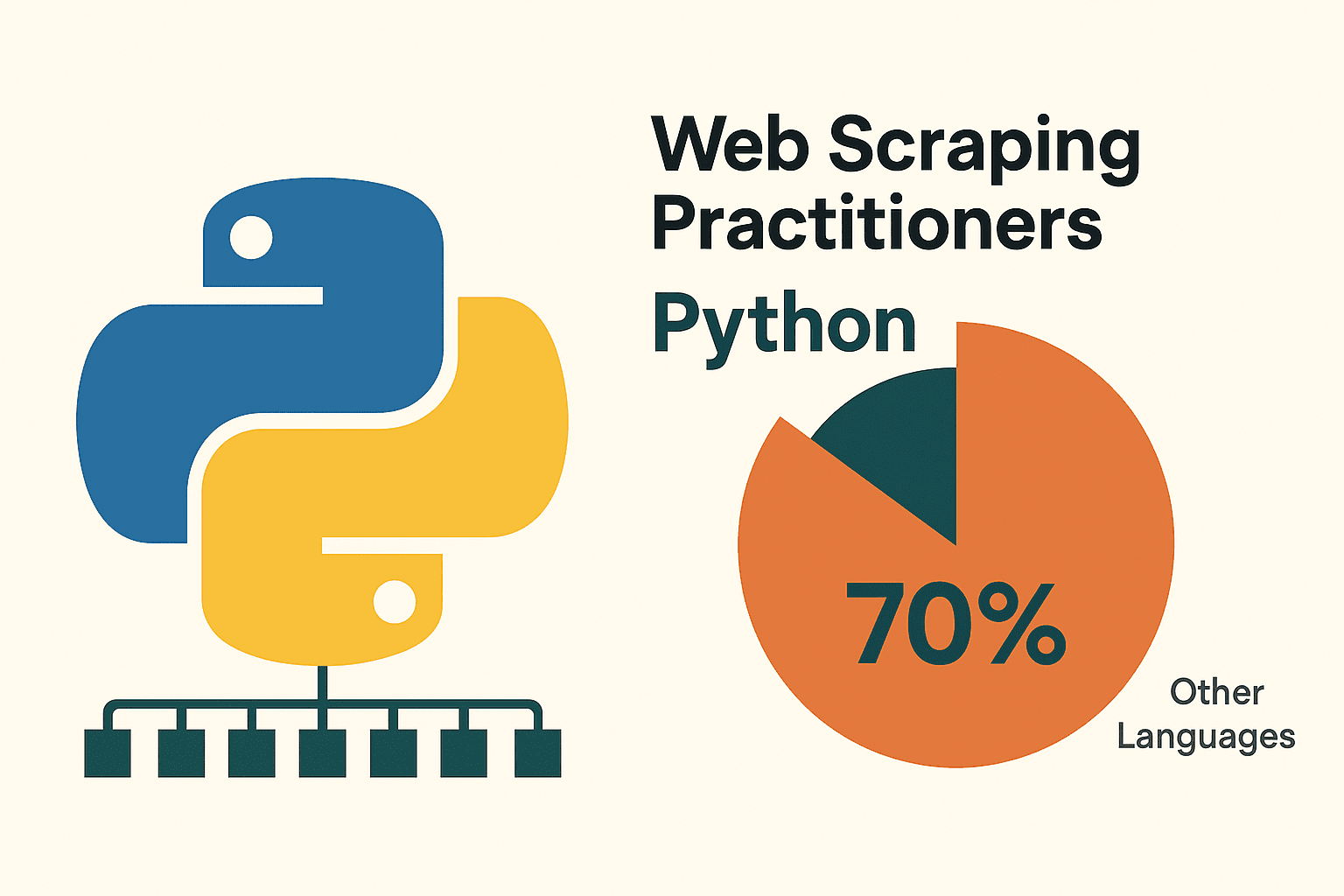

まずは基本から。ウェブスクレイピングは、ウェブサイトから自動で情報を抜き出す技術のこと。たとえば、商品価格やニュースの見出し、連絡先など、必要なデータだけをパソコンに「読ませて」取り出すイメージ()。企業では競合調査や市場分析、リード獲得、AIモデルの学習データ集めなど、いろんな場面で使われてる()。

じゃあ、なんでPythonがスクレイピングにピッタリなのか?理由はシンプル。Pythonは文法が分かりやすくて、英語みたいに読みやすいから、プログラミング初心者でもすぐ慣れる。しかもrequests、BeautifulSoup、Scrapy、Selenium、pandasなど、スクレイピングに必要なライブラリがめちゃくちゃ充実してる。実際、って言われてるよ。

なんでPythonでウェブスクレイピング?

いろんな言語でスクレイピングを試してきたけど、特に初心者にはPythonが圧倒的におすすめ。その理由はコレ:

- シンプルで読みやすい文法:Pythonは直感的で、エラーも見つけやすいし直しやすい()。

- 豊富なライブラリ:requests(HTTP通信)、BeautifulSoup(HTML解析)、Scrapy(大規模クロール)、Selenium(ブラウザ自動操作)、pandas(データ分析)など、必要な機能が全部そろってる()。

- 活発なコミュニティ:困ったときはネットで解決策がすぐ見つかる。

他の選択肢と比べてどうなのか?下の表でまとめてみたよ:

| アプローチ | メリット | デメリット |

|---|---|---|

| Python | 学びやすい、ライブラリが豊富、データ分析に強い、汎用性が高い | コーディングが必要、JavaScriptが多用されたサイトには追加ツールが必要 |

| JavaScript/Node | 動的コンテンツに強い、非同期処理が得意、フロントエンドと同じ言語 | 学習コストが高め、スクレイピング専用ライブラリが少ない、初心者にはやや複雑 |

| R (rvest) | 研究用途でのデータ抽出に便利、Rの分析機能と連携しやすい | ライブラリが少なく、動的サイトには不向き |

| ノーコードツール | コーディング不要、すぐに使える、AIやビジュアル操作(Thunderbitなど) | カスタマイズ性が低い、利用制限がある、細かい制御が難しい |

(, )

ビジネスユーザーやデータ分析を始めたい人には、Pythonが「パワフル・柔軟・親しみやすい」の三拍子そろったベストな選択肢!

Python環境のセットアップ方法

スクレイピングを始める前に、Pythonの開発環境を整えよう。IKEAの家具を組み立てるよりずっと簡単!

1. Pythonのインストール

から最新のPython 3をダウンロード。Windowsならインストール時に「Add Python to PATH」にチェックを。MacはHomebrewでbrew install python3。Linuxはapt install python3 python3-pipでOK()。

2. (推奨)仮想環境の作成

プロジェクトごとにライブラリを分けて管理できる。プロジェクトフォルダで:

1python -m venv venv

2# 有効化:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. 必要なライブラリのインストール

ターミナルで以下を実行:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests:HTTPリクエスト用beautifulsoup4:HTML解析用pandas:データ加工・出力用selenium:動的サイト対応(必要に応じて)lxml:高速なHTML/XML解析

4. コードエディタの選択

- (Python拡張機能あり):軽くて人気、初心者にもおすすめ。

- :本格的なPython専用IDE。

- :対話型でデータ分析に便利()。

5. (Selenium用)WebDriverのインストール

Seleniumはブラウザドライバ(例:ChromeDriver)が必要。webdriver_managerを使うとラク:

1pip install webdriver-managerスクリプト内で:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))トラブル時のヒント:pipが認識されない場合は、PythonがPATHに入ってるか、仮想環境が有効か確認しよう。

静的ウェブサイトのスクレイピング:Pythonでの基本手順

静的サイトはスクレイピングの入門編。ブラウザの「ページのソースを表示」で見えるデータなら、Pythonでサクッと取れる。

例として、練習用サイトを使ってみよう。

ステップ1:ページを取得

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200なら成功ステップ2:HTMLを解析

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")ステップ3:データを抽出

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")ステップ4:ページ送りに対応

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)こんな感じで、数行のコードで複数ページのデータをCSVに保存できる。意外と簡単でしょ()。

ポイント:スクレイピング前に必ずサイトのrobots.txtや利用規約をチェックしよう。リクエストの間にtime.sleep(1)などで間隔を空けるのもマナー。

動的ウェブサイトのスクレイピング:Seleniumの活用

JavaScriptで動的にデータが表示されるサイト(無限スクロールやポップアップなど)は、普通の方法じゃデータが取れない。そんなときはSeleniumの出番!

ステップ1:ブラウザを起動

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")ステップ2:コンテンツの読み込みを待つ

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)ステップ3:スクロールやクリックで追加データを読み込む

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightステップ4:データを抽出

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})ステップ5:保存と後処理

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()コツ:

- 要素の読み込み待ちには

WebDriverWaitが便利()。 - ヘッドレス(画面非表示)モードはChromeオプションで

options.headless = Trueを追加。 - サイトのネットワーク通信からJSON APIが見つかれば、Seleniumを使わず

requestsで高速取得できることも。

ThunderbitとPythonの連携でデータ活用を加速

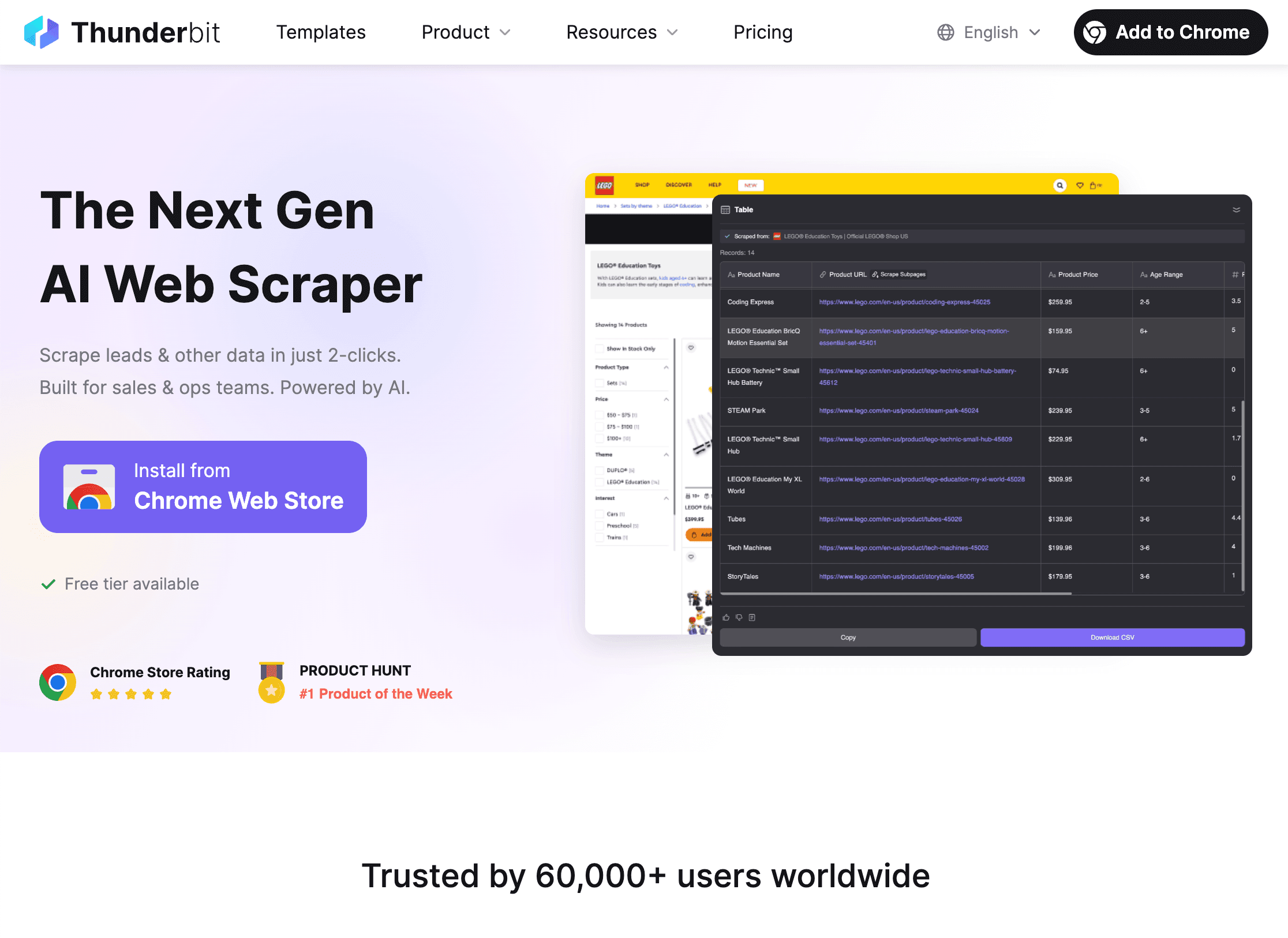

ここからが本番。Pythonのライブラリだけじゃ手間がかかる複雑なサイトや、構造がバラバラなページもある。そんなときはの出番!

ThunderbitはAI搭載のウェブスクレイパーChrome拡張で、クリックだけでどんなサイトからでもデータを抜き出せる。ビジネスユーザーはもちろん、Pythonと組み合わせればさらに高度なデータ活用もできるよ。

Thunderbit × Pythonでできること:

Thunderbit × Pythonでできること:

-

Thunderbitでデータを抽出

- を起動。

- 「AIフィールド提案」で抽出項目を自動選択。

- ページ送りやサブページ、画像・PDFもワンクリックで対応。

- CSV、Excel、Google Sheets、Notion、Airtableなどに直接エクスポート。

-

Pythonでデータ分析・加工

- pandasでエクスポートしたファイルを読み込み:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - フィルタリング、クリーニング、集計、可視化など自由自在。

- pandasでエクスポートしたファイルを読み込み:

-

自動化パイプラインの構築

- Thunderbitは定期スクレイピング(スケジュール機能)にも対応。

- Pythonスクリプトと組み合わせて、レポート自動生成や通知も実現。

なぜ両方使うのか? Thunderbitは面倒なコーディングやデバッグを大幅に省略できて、Pythonはデータ分析や自動化に最適。まさに「いいとこ取り」の組み合わせ!()

Pythonスクレイピングでよくある課題と対策

スクレイピングはいつも順調とは限らない。よくあるトラブルとその解決策をまとめたよ:

1. アクセスブロック(403/429エラー、CAPTCHA)

- User-Agentを変えて本物のブラウザっぽくする

- プロキシでIPアドレスをローテーション()

- リクエスト間に遅延(

time.sleep())を入れる - robots.txtやcrawl-delayを守る

- CAPTCHAはSeleniumで手動対応や外部サービス利用も検討

2. 動的コンテンツが取得できない

- JavaScriptで生成されるページはSeleniumでレンダリング

- ブラウザのネットワークタブでAPI通信を探して、直接JSON取得できる場合も

3. ログインやセッション管理

requests.Session()でクッキーを維持- Seleniumでログイン操作を自動化

4. サイト構造の変更

- セレクタはID優先で堅牢に

- サイトの変更を監視して、必要に応じてスクリプトを修正

- ThunderbitのAIはレイアウト変更にも自動対応できる

5. 大量データの処理

- 並列処理(

concurrent.futuresやasyncio)で高速化 - メモリ節約のため、データは都度ファイルやDBに保存

(, )

スクレイピングスクリプトのデバッグ&最適化

うまく動かないときは、下のチェックリストを参考にしてみて:

- HTTP 404/403/429:URLやヘッダー、リクエスト頻度を確認

- タイムアウト/接続エラー:リトライ処理(指数バックオフ)を実装

- AttributeError/NoneType:要素取得前に存在チェック、取得HTMLを確認

- 文字化け:

response.encoding = 'utf-8'や保存時のエンコーディング指定 - Seleniumで要素が見つからない:明示的な待機やセレクタの見直し

- メモリエラー:データを分割保存、ジェネレータやDB活用

- デバッグ:printやlogging、HTMLをファイル保存して中身を確認

大規模案件では非同期リクエスト(aiohttp)、スレッド、Scrapyなどのフレームワークも検討。ただ、最初は「分かりやすさ重視」でOK!

倫理的・法的に正しいウェブスクレイピングのために

強力なスクレイピング技術には責任もついてくる。以下の点に気をつけよう:

- robots.txtや利用規約を守る:「スクレイピング禁止」と書かれてるサイトは避ける

- 個人情報や機密データは取得しない:公開情報だけを対象に

- マナーを守る:リクエスト頻度を抑えて、サーバーに負荷をかけない

- User-Agentで身元を明示:必要なら連絡先も記載

- 法的リスクの確認:アメリカでは公開データのスクレイピングは原則OKだけど、利用規約違反や非公開データの取得はトラブルの元()

- APIがあればAPIを使う:公式APIの利用が一番安全で安定

(, )

まとめ・ポイント

Pythonによるデータスクレイピングは、今のデータ活用社会でめちゃくちゃ価値のあるスキル。ポイントをおさらいしよう:

- Pythonはウェブスクレイピングの定番。シンプルな文法、豊富なライブラリ、活発なコミュニティが魅力()。

- 静的サイトはrequests+BeautifulSoupで、動的サイトはSeleniumで対応。

- Thunderbitを使えば、複雑なサイトや単発案件も手間なくデータ化。Pythonと組み合わせて分析・自動化も簡単。

- トラブル時はヘッダーやプロキシ、遅延、エラーハンドリングで対策。

- 倫理・法令遵守を忘れずに。公開情報だけ、マナーを守って安全に。

まずはシンプルなサイトで1本目のスクリプトを書いてみよう。慣れてきたらThunderbitとPythonを組み合わせて、もっと高度なデータ活用にチャレンジ!エラーが出ても大丈夫。Stack Overflowなどを活用しながら、一歩ずつスキルアップしていこう。

Thunderbitの活用事例やスクレイピングの最新情報はやでも発信中!

みんなのデータがいつもクリーンで、スクリプトがバグらず、IPがブロックされませんように!

よくある質問(FAQ)

1. ウェブスクレイピングって何?合法なの?

ウェブスクレイピングは、ウェブサイトから自動でデータを抜き出す技術。アメリカなど多くの国では公開データの取得は基本OKだけど、利用規約や個人情報保護法には注意しよう()。

2. なんでみんなPythonでスクレイピングするの?

Pythonは初心者でも扱いやすく、requests・BeautifulSoup・Selenium・pandasなど強力なライブラリがそろってるから、サポートも充実してる()。

3. requests/BeautifulSoupじゃなくてSeleniumを使うのはどんなとき?

JavaScriptで動的に生成されるデータは、Seleniumでブラウザを自動操作しないと取れない。ユーザーが見てる画面と同じ状態を再現できる。

4. ThunderbitはPythonとどう連携できる?

Thunderbitで複雑なデータもAIで簡単に抽出して、CSV/Excel/Sheetsにエクスポート。そのデータをPythonで分析や自動化に活用できる。コーディングの手間も大幅カット。

5. スクレイピングでブロックされないコツは?

User-Agentのローテーション、プロキシ利用、リクエスト間隔の調整、robots.txtの遵守、個人情報の取得回避などがポイント。大規模案件はアンチボット対策も検討しよう。

自分でもスクレイピングを試してみたい人は、をダウンロードして、AIとPythonの組み合わせの便利さを体感してみて。最初は1行のコードから始まるよ。

さらに詳しく知りたい人はこちら