ウェブサイトからデータを初めて取得しようとしたときのこと、今でも鮮明に覚えています。コーヒー片手に、延々と商品価格をコピペしていたあの単純作業を「自動化してやるぞ!」と意気込んでPythonを立ち上げ、BeautifulSoupをインストール。いざ始めてみると、目の前に広がるのは謎だらけのHTMLとエラーの山…。python ウェブスクレイピングに挑戦したことがある人なら、このワクワクと混乱、そして時にはパソコンを投げ出したくなる気持ち、きっと共感できるはずです。

とはいえ、今やウェブ上のデータはビジネスに欠かせない資産。競合価格のチェックやリードリスト作成、市場動向の把握など、リアルタイムな情報が求められています。web scraping pythonは長らく定番の手法でしたが、最近はウェブサイトの構造が複雑化し、対策もどんどん高度化。昔ながらのコード中心のやり方では、正直「もう限界かも…」と感じることも増えてきました。そこで今回は、従来のPythonスクレイピングの基本から、のようなAI搭載の最新aiスクレイパーまで、両方の世界を分かりやすくご紹介します。営業、EC、オペレーション部門の方にも役立つ内容です。

Pythonウェブスクレイピングとは?

まずは基本から。ウェブスクレイピングとは、ウェブサイトから自動でデータを集めること。手作業でコピペする代わりに、スクリプトで効率化します。Pythonは初心者にも人気の言語で、読みやすく、コミュニティも大きく、スクレイピングに便利なライブラリも豊富。プログラマーでなくても始めやすいのが魅力です。

なぜPythonが選ばれるのか?

- 学びやすい: Pythonの文法は直感的で、初めてでもとっつきやすい。

- ライブラリが豊富: Requests、BeautifulSoup、Selenium、Scrapyなど、静的ページから動的なJavaScriptサイトまで幅広く対応。

- コミュニティが大きい: 困ったときはStack Overflowなどで解決策が見つかりやすい。

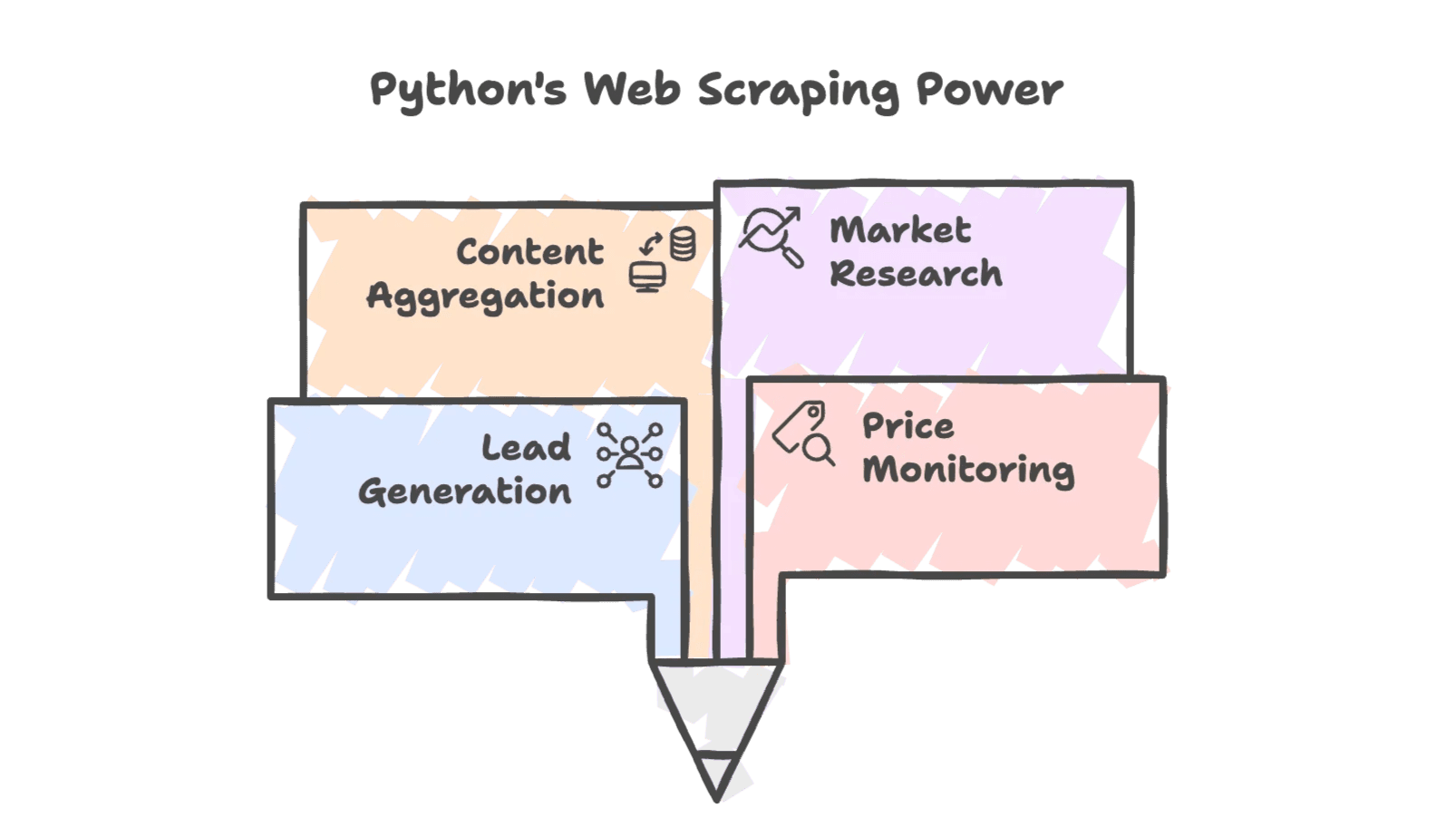

主な活用シーン

Pythonによるウェブスクレイピングは、ビジネスのさまざまな場面で活躍しています:

- リード獲得: ディレクトリやSNSから連絡先情報を収集。

- 価格調査: 競合他社の価格を定期的にチェックし、ダイナミックプライシングに活用。

- コンテンツ集約: ニュース、レビュー、商品リストなどをまとめて取得。

- 市場調査: フォーラムやSNS、検索結果からトレンドを分析。

エンジニアだけでなく、営業やEC、不動産業界でもスクレイピングデータは競争力の源泉。実際、が独自のデータセット構築にウェブスクレイピングを活用しています。

なぜ企業はPythonでウェブスクレイピングを行うのか?

Pythonは柔軟性と強力なライブラリ群で、ビジネス用途にもぴったり。実際の活用例を見てみましょう:

| シナリオ | Pythonウェブスクレイピングの活用方法 | 主なメリット(ROI) |

|---|---|---|

| リード獲得 | ディレクトリから氏名・メール・電話番号を抽出 | 手作業なら50件のところ、1晩で500件のリスト作成が可能 |

| 価格調査 | 競合商品の価格を定期取得 | スクレイピングデータでダイナミックプライシングを実現し、売上4%アップした事例も |

| 在庫チェック | 競合の在庫状況を確認 | ライバルが品切れのタイミングで顧客を狙い撃ち、手作業の確認時間を大幅削減 |

| 競合調査 | 商品情報やレビューをクロール | 1,000件以上のレビューを分析し、マーケや商品開発に活用 |

| 市場調査 | フォーラムやSNS、検索結果からデータ集約 | 最新トレンドを把握し、戦略を消費者ニーズに合わせて最適化 |

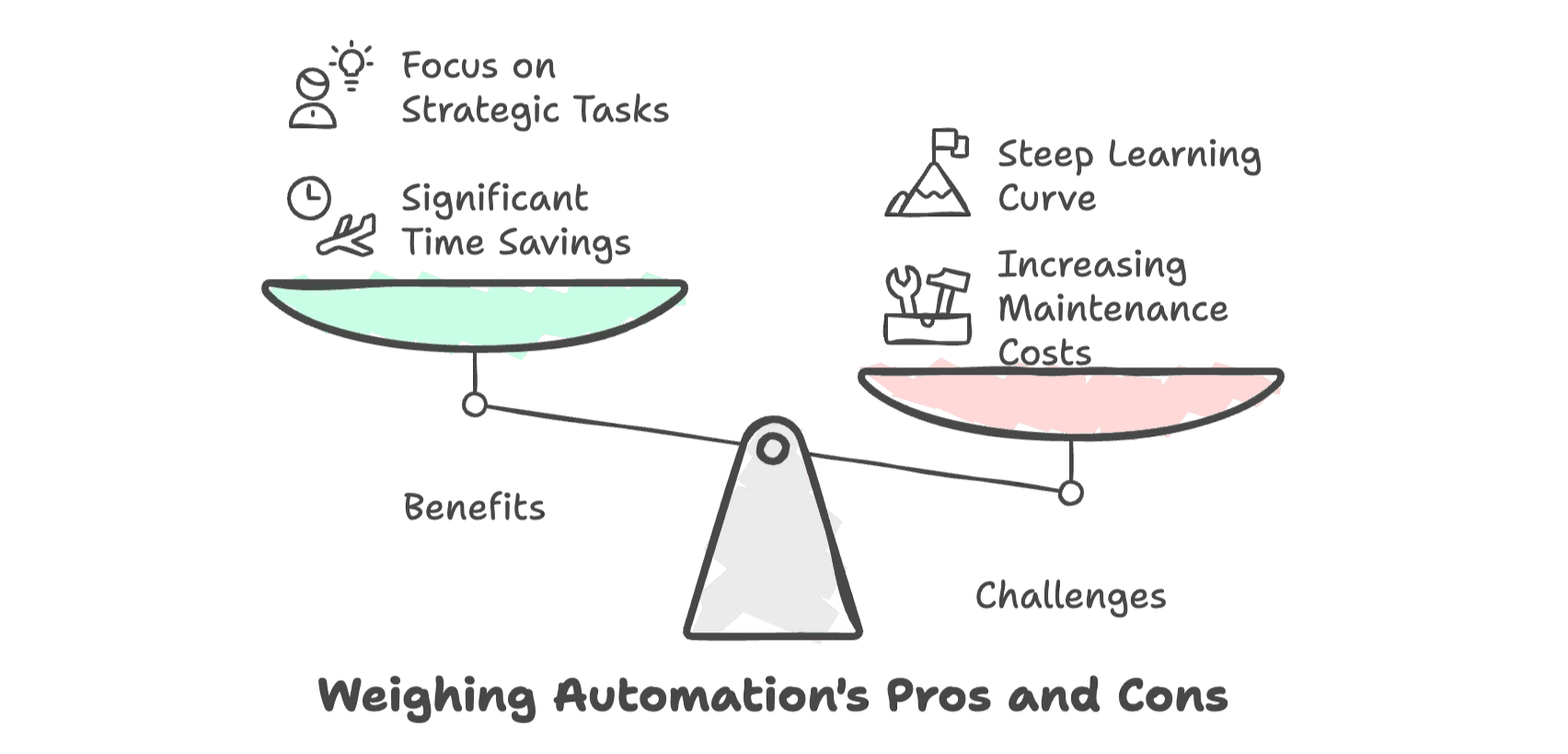

自動化によるデータ収集は、手作業と比べて最大80%の時間短縮につながります(より)。単純作業を減らし、より価値の高い業務に集中できるのが大きな魅力です。

ただし、ウェブサイトの進化に伴い、スクリプトの維持やトラブル対応の手間も増加。非エンジニアにとっては、学習コストや挫折感も無視できません。

Pythonウェブスクレイピングの主要ツール

これから始める方におすすめのPythonツールを簡単にまとめました:

| ツール | 得意分野 | JavaScript対応 | 習得難易度 | 速度・スケール |

|---|---|---|---|---|

| Requests + BeautifulSoup | 静的なシンプルページ | いいえ | 低 | 単一ページなら高速 |

| Selenium | 動的・JSサイト、操作が必要な場合 | はい | 中 | 1ページごとにやや遅い |

| Scrapy | 大規模・構造化クロール | 一部(プラグイン利用) | 高 | 高速・スケーラブル |

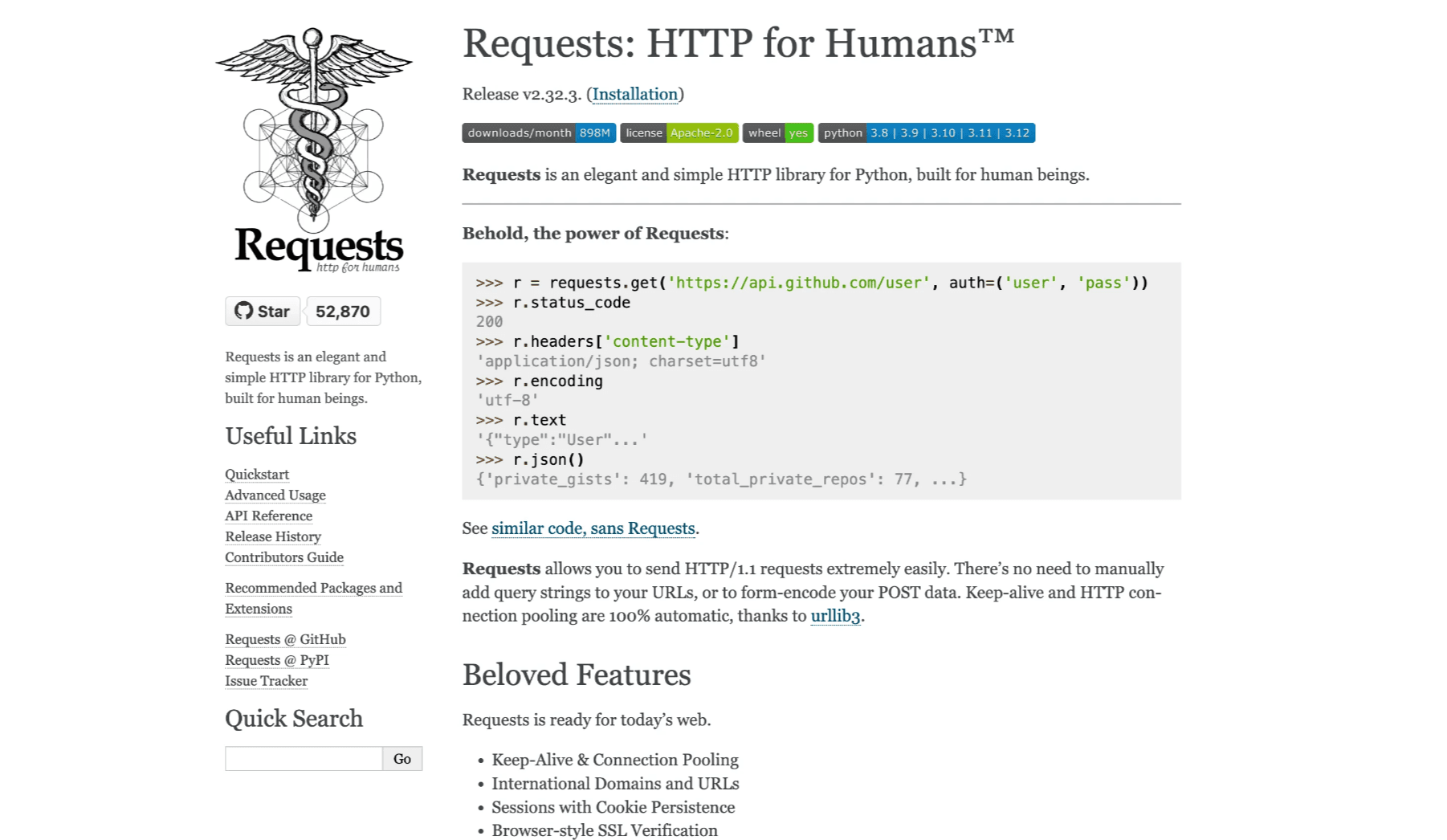

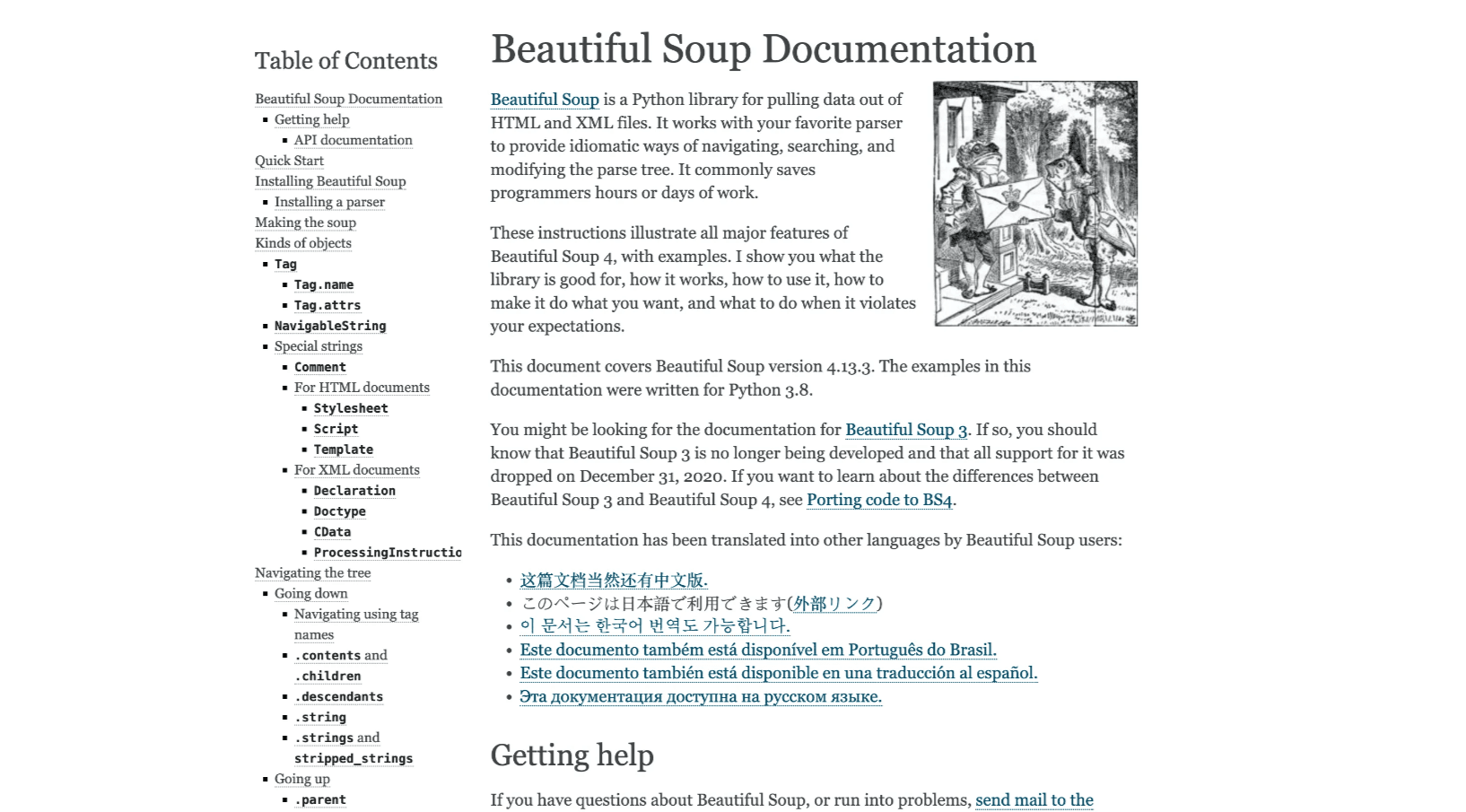

Requests + BeautifulSoup

静的サイト向けの定番コンビ。RequestsでHTMLを取得し、BeautifulSoupで必要なデータを抽出します。軽量で初心者にも扱いやすく、小規模プロジェクトに最適です(, 参照)。

Selenium

JavaScriptで動的に表示されるデータを取得したい場合はSeleniumが便利。実際のブラウザを自動操作できるので、ログインやクリック、スクロールも対応可能です(参照)。ただし、動作はやや遅く、セットアップも複雑です。

Scrapy

大規模なクロールや定期的なデータ収集にはScrapyが最適。堅牢なフレームワークで、並列処理やコードの整理も容易です(参照)。習得には少し時間がかかりますが、大量データの処理には強力な味方です。

実践:Pythonで初めてのウェブスクレイパーを作ろう

実際に手を動かしてみましょう。今回は練習用サイトから本のタイトルと価格を取得します。

Python環境の準備

まずPythonをインストールし、ターミナルで以下を実行:

1pip install requests beautifulsoup4エディタはVS CodeやPyCharmなど、初心者向けのものがおすすめ。シンタックスハイライトがあるだけで作業効率がぐっと上がります。

スクレイピングスクリプトの例

以下はトップページから本のデータを取得するシンプルなスクリプトです:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)このスクリプトの流れ:

- RequestsでHTMLを取得

- BeautifulSoupでパース

- 本のリストを抽出

- 各本のタイトルと価格を取得

データのエクスポート

取得したデータをCSVファイルに保存してみましょう:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)books.csvをExcelやGoogleスプレッドシートで開けば、データが一覧で確認できます。

ワンポイントアドバイス

- 出力データに抜けやエラーがないか必ず確認

- 文字化けがあればUTF-8エンコーディングを見直す

- サイト構造が変わるとスクリプトが動かなくなることもあるので注意

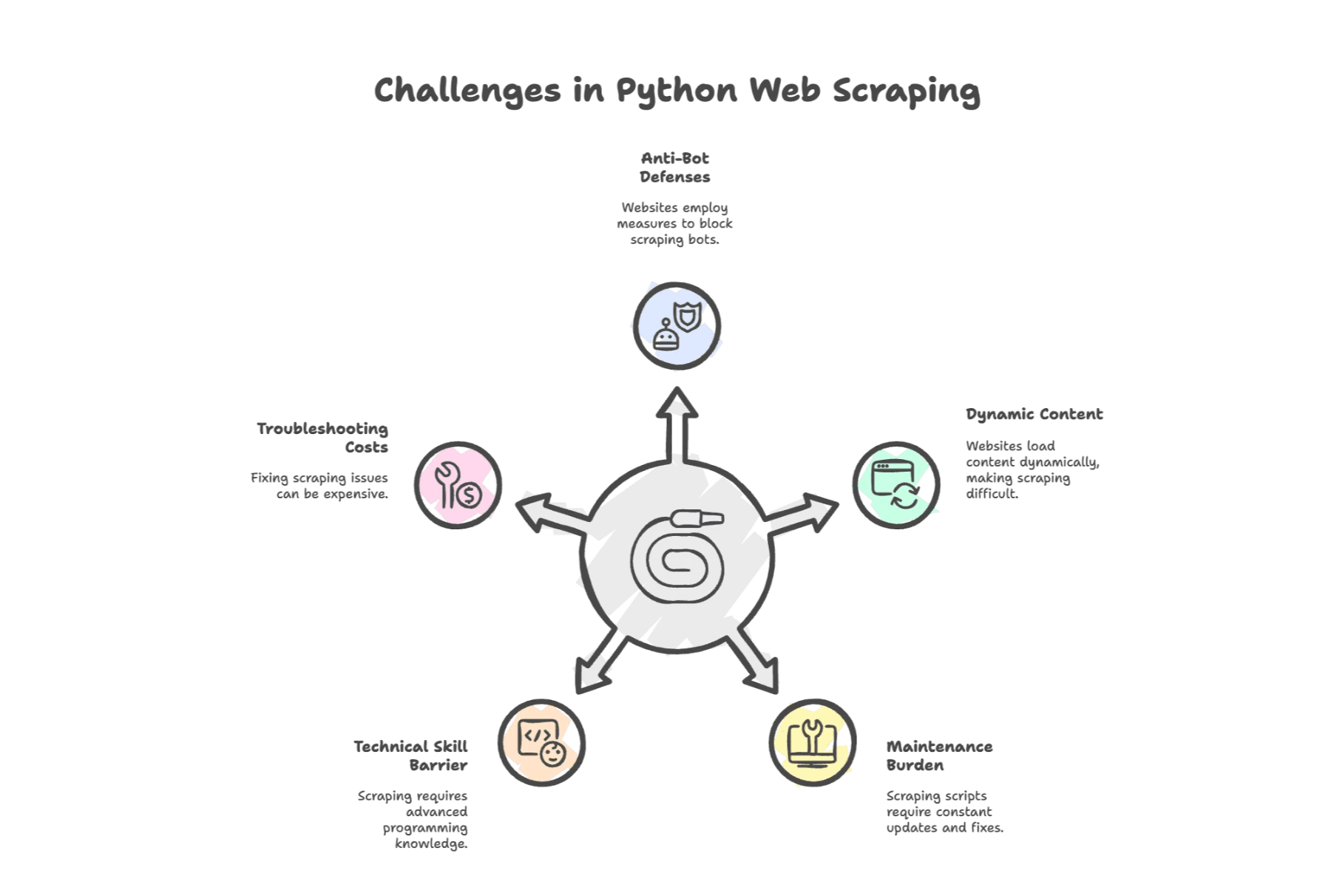

Pythonウェブスクレイピングの主な課題

ここからが本番。Pythonによるスクレイピングは強力ですが、課題も多いのが現実です。

1. ボット対策

最近のウェブサイトはスクレイピング対策が進化。最新の調査では、がIPブロックやCAPTCHAなどの「ブロック」を最大の障壁に挙げています。スクリプトを検知されると、アクセス制限やCAPTCHAが表示されることも。

2. 動的コンテンツ

今どきのサイトはJavaScriptでデータを後から表示することが多く、Requests+BeautifulSoupだけではデータが取得できません。SeleniumやAPI解析が必要になる場合も。

3. メンテナンス負担

ウェブサイトの構造は頻繁に変わります。HTMLのちょっとした変更でスクリプトが動かなくなることも。ある調査では、開発者のが修正作業に費やされ、年間1万5千ドル以上のコストがかかることも。

4. 技術的ハードル

Pythonは簡単とはいえ、HTMLやCSSセレクタ、HTTPの知識は必須。非エンジニアには新しい言語を学ぶような感覚です。

5. トラブル対応コスト

問題が発生した場合、プロキシやヘッドレスブラウザ、外部サービスの導入が必要になることも。デバッグに費やす時間は、本来の業務を圧迫します。

自動ウェブスクレイピングツール:次世代の選択肢

では、ビジネスユーザーや多忙な営業担当者はどうすればいいのでしょう?そこで登場するのが自動ウェブスクレイピングツール、そして近年急速に進化しているaiスクレイパーです。

これらのツールは、面倒な作業を自動化。サイトごとにコードを書く必要も、夜遅くまでデバッグに悩む必要もありません。画面をクリックするだけで、欲しいデータが手に入ります。

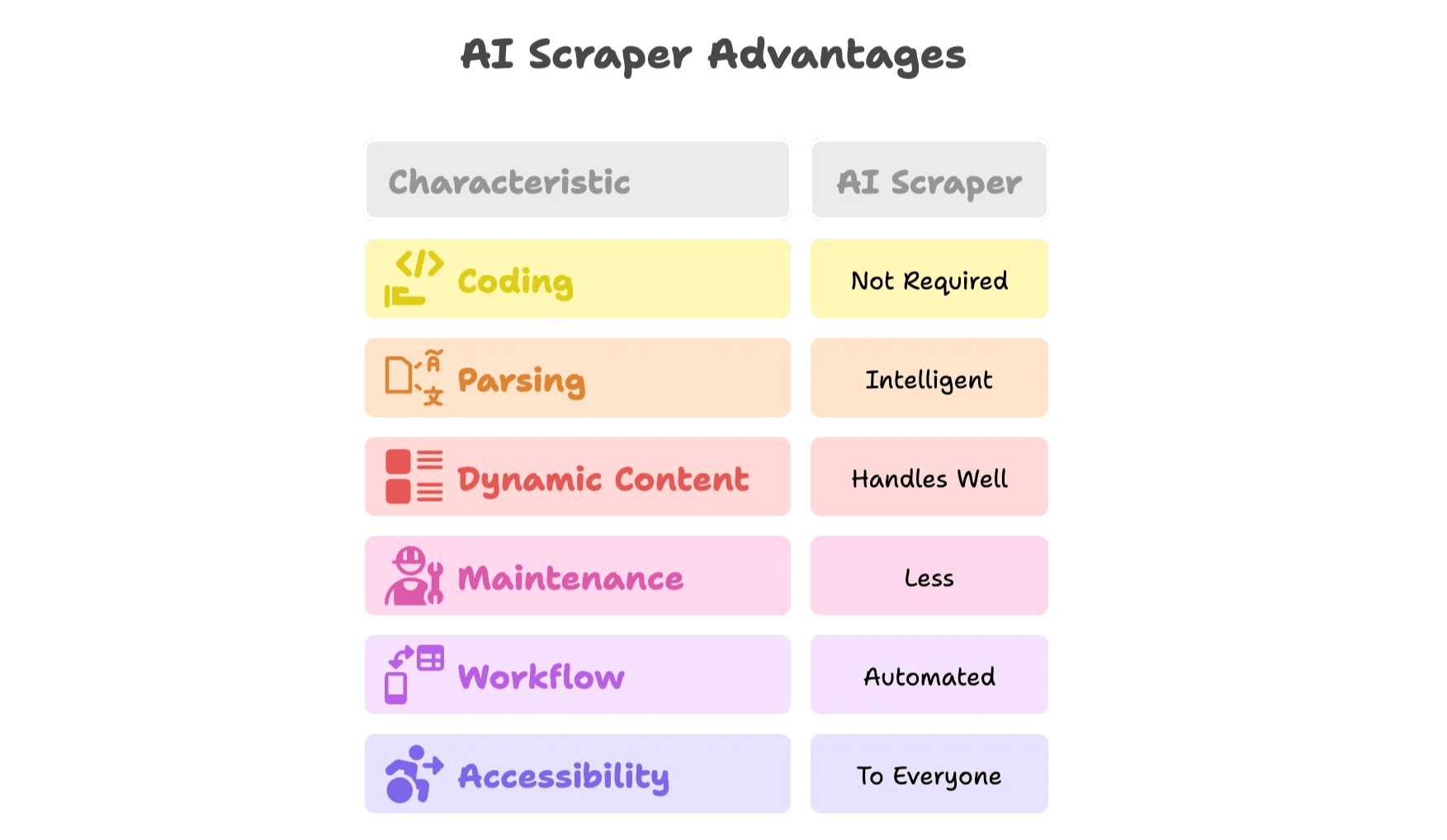

AIウェブスクレイパーの強みとは?

aiスクレイパーは従来のツールを大きく進化させました。その理由は:

- コーディング不要: ビジュアル操作や拡張機能で、画面上のデータを選ぶだけ。AIが自動で解析。

- 賢いデータ抽出: AIが名前・価格・メールなどの項目を自動認識。HTMLを調べる必要なし。

- 動的コンテンツ対応: 実際のブラウザ上で動作するため、JavaScriptやスクロール、クリックもOK。

- メンテナンス負担軽減: サイト構造が変わってもAIが自動対応、またはテンプレートが随時更新。

- ワークフロー自動化: スケジュール実行やGoogle Sheets、Airtable、Notion、Excelへの直接エクスポートも可能。

- 誰でも使える: 「Python担当者待ち」のボトルネックが解消。

実際にでどのように使えるか見てみましょう。

Thunderbit:Pythonに代わるスマートなウェブスクレイピング

私がThunderbitを立ち上げた理由は、手作業や従来型スクレイピングに多くの時間と労力が費やされている現状を変えたかったからです。目指したのは「誰でも簡単にウェブデータを活用できる世界」。コーディング不要、ストレスフリー、そしてすぐに結果が出る仕組みです。

Thunderbit AIウェブスクレイパーの主な特徴

- 2クリックAIウェブスクレイパー: サイトを開いて「AIフィールド提案」をクリックするだけで、ThunderbitのAIが最適な抽出項目を自動で選定。「スクレイピング開始」を押せば完了です。

- 豊富なテンプレート: Amazon、Zillow、LinkedInなど人気サイト用の即時テンプレートを用意。面倒な設定不要。

- サブページ・ページネーション対応: 商品詳細ページへの自動遷移や、ページ送り・無限スクロールも自動化。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notionへワンクリックで出力。追加料金なし。

- メール・電話番号抽出: あらゆるページから連絡先情報を即座に抽出。営業やリード獲得に最適。

- AIによるデータ変換: 要約・分類・翻訳・フォーマット変換もその場で実行。

- 定期実行スケジューリング: 自然言語で繰り返しスクレイピングを設定可能。

- クラウド・ブラウザ両対応: ログインが必要なサイトも含め、用途に応じて選択可能。

- 34言語対応: グローバルチームにも最適。

実際の動作はやでチェックできます。

PythonからAIスクレイパーへ切り替えるべきタイミングは?

判断の目安となるチェックリストをまとめました:

| 状況 | Pythonスクリプト | AIスクレイパー(Thunderbit) |

|---|---|---|

| 単発・静的なシンプルページ | ✔️ | ✔️ |

| 動的コンテンツ(JS、ログイン、無限スクロール) | ⚠️ | ✔️ |

| 頻繁なサイト変更・高メンテナンス | ⚠️ | ✔️ |

| 非エンジニアチーム・スピード重視 | ⚠️ | ✔️ |

| 複数ツール連携(Sheets、CRM等) | ⚠️ | ✔️ |

| 大規模・定期的なスクレイピング | ⚠️ | ✔️ |

| スケジューリングやデータ加工が必要 | ⚠️ | ✔️ |

⚠️が多い場合は、aiスクレイパーの導入を検討するタイミングです。

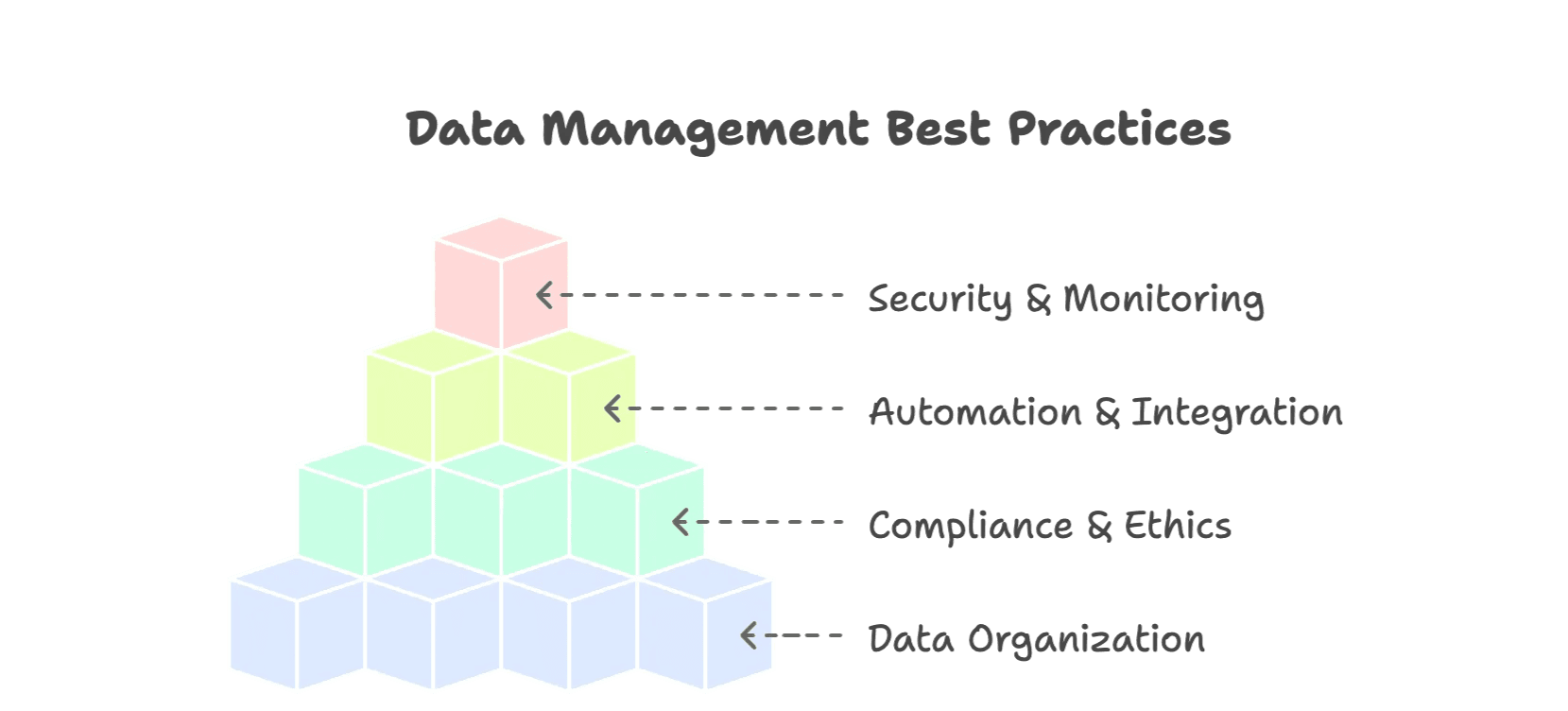

効率的かつ持続可能なウェブデータ収集のコツ

PythonでもAIツールでも、ちょっとした工夫で成果が大きく変わります:

1. データの整理を徹底

- CSVやExcel、データベースなど構造化フォーマットを活用

- 日付・通貨・カテゴリなどの正規化

- 取得元や日付などのメタデータ付与

- 重複排除やデータ検証も忘れずに

2. 法令順守と倫理的配慮

- robots.txtや利用規約を守る(参照)

- サーバーに負荷をかけないよう適切な間隔で実行

- 個人情報や機密データの取得は避ける

- 公開APIがあれば積極的に利用

3. 自動化と連携

- 定期的なスクレイピングで最新データを維持

- SheetsやAirtable、Notionなど業務ツールと直接連携

- エラー検知やアラートでトラブルを早期発見

4. セキュリティと監視

- スクレイピング実行ログやエラーを記録

- データセットのバックアップ

- 機密データへのアクセス制限

より詳しいベストプラクティスはも参考にしてください。

まとめ:ウェブスクレイピングの未来はもっとスマートに

手作業のコピペや壊れやすいPythonスクリプトに頼る時代は終わりつつあります。ウェブデータは今や戦略的資産であり、が公開ウェブデータに投じられ、aiスクレイパー市場はに成長すると予測されています。

Pythonは基礎を学ぶのに最適で、小規模な用途には今も有効です。しかし、ウェブの進化に合わせてツールも進化が必要。Thunderbitのようなaiスクレイパーは、現代のチームに最適な、より効率的でスマートなデータ収集を実現します。

もし「デバッグばかりで成果が出ない」「最新のスクレイピングを体験したい」と感じたら、ぜひThunderbitをお試しください:。営業・EC・オペレーション部門の業務効率が劇的に変わります。