ビジネスデータを初めて集めようとウェブスクレイピングに挑戦したときのこと、今でもよく覚えています。キッチンのテーブルでコーヒーを飲みながら、未完成のPythonスクリプトと格闘し、競合サイトから商品価格を抜き出そうと必死でした。「これくらい簡単だろう」と高をくくっていたのに、結果は空白だらけのCSVファイルと、「Pythonで自動化は簡単」と言う人への新たなリスペクトだけが残りました。2025年の今、ウェブスクレイピングはデータドリブンなビジネスの中心となり、営業やEC、マーケティング、オペレーションなど、あらゆる現場でリアルタイムのインサイトをもたらしています。

ただ、ここで大事なのは、Pythonによるウェブスクレイピングが進化する一方で、その周辺環境も大きく変わってきている点です。ウェブスクレイピング市場は急成長しており、と予測されています。さらに、し、より賢い意思決定を目指しています。でも、実際の課題は「コードを書くこと」そのものではなく、「最適なツール選び」「スケール対応」「複雑なスクリプトの保守」などにあります。このガイドでは、主要なPythonウェブスクレイピングライブラリ(コード例付き)、実際のビジネス活用例、そして私がPython好きでありながら、2025年のビジネスユーザーにはのようなノーコードツールをおすすめする理由を解説します。

Pythonウェブスクレイピングとは?エンジニアじゃなくても分かる解説

ざっくり言うと、ウェブスクレイピングは「自動でコピペしてくれる」仕組みです。大量のインターンを雇って商品価格や連絡先、レビューを集める代わりに、ソフトウェアがウェブページを巡回し、必要なデータを抜き出してスプレッドシートやデータベースにまとめてくれます。Pythonウェブスクレイピングは、その作業をPythonスクリプトで実現する方法。ウェブページを取得し、HTMLを解析し、欲しい情報だけを抜き出します。

イメージとしては、24時間365日休まずにウェブサイトを巡回してくれるデジタルアシスタントのような存在。ビジネスでよく集められるデータは、価格情報、商品詳細、連絡先、レビュー、画像、ニュース記事、不動産情報など。APIが用意されているサイトもありますが、多くは制限があったり、そもそもAPIがありません。そんなときにウェブスクレイピングが大活躍。公式の「ダウンロード」ボタンがなくても、公開されているデータを大量に取得できるのです。

なぜPythonウェブスクレイピングがビジネスに不可欠なのか

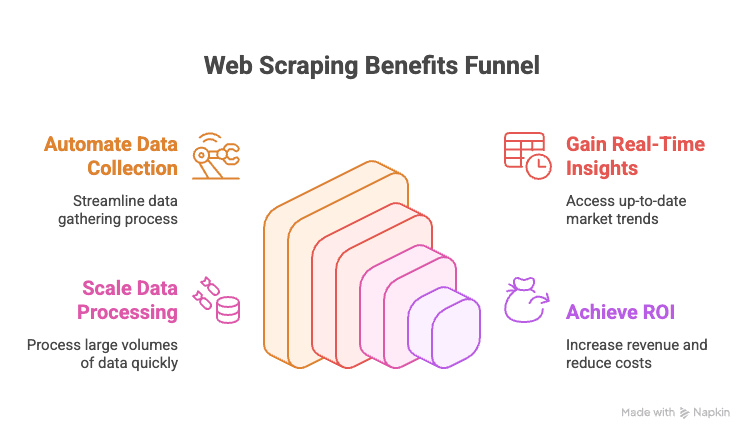

2025年、ウェブスクレイピングを活用しないビジネスは、チャンスを逃していると言っても過言ではありません。その理由は以下の通りです。

- 手作業のデータ収集を自動化:競合サイトやオンラインディレクトリからのコピペ作業はもう不要。

- リアルタイムなインサイト:価格や在庫、トレンドを即座に把握。

- スケール対応:数千ページをランチを温める間に一気に取得。

- ROI向上:データ活用企業はを実現。

ビジネス部門ごとの活用例をまとめました:

| 部門 | 活用例 | 得られる価値 |

|---|---|---|

| 営業 | ディレクトリからリード抽出・メール付与 | 質・量ともに優れたリードリスト |

| マーケティング | 競合価格・プロモ・レビュー追跡 | 柔軟な施策・迅速な対応 |

| EC | 商品価格・在庫・レビュー監視 | 動的価格設定・在庫アラート |

| オペレーション | サプライヤーデータ集約・レポート自動化 | 時間短縮・ミス削減 |

| 不動産 | 複数サイトから物件情報収集 | 多数の物件・迅速な顧客対応 |

つまり、ウェブスクレイピングは「賢く・速く・競争力のある」意思決定の裏側を支えています。

Pythonウェブスクレイピング主要ライブラリまとめ(コード例付き)

ここからはPythonで使える主要なウェブスクレイピングライブラリを、コード例とともに一挙紹介します。

urllib・urllib3:HTTPリクエストの基本

Python標準のHTTPリクエスト用ライブラリ。やや低レベルですが、シンプルな用途には十分です。

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # HTTPステータスコード

6print(response.data[:100]) # 最初の100バイト依存関係を増やしたくない場合や細かく制御したい場合に便利ですが、通常はrequestsの方が使いやすいです。

requests:最も人気のあるPythonウェブスクレイピングライブラリ

Pythonでスクレイピングと言えばrequests。シンプルで強力、HTTP通信の面倒な部分をすべて引き受けてくれます。

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # JSONとしてパースクッキーやセッション、リダイレクトも自動で処理。HTMLの取得だけなので、データ抽出にはBeautifulSoupなどのパーサーが必要です。

BeautifulSoup:HTML解析とデータ抽出の定番

HTML解析ならBeautifulSoup。初心者にも扱いやすく、requestsと組み合わせて使うのが一般的です。

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"小〜中規模のプロジェクトや、初めてのスクレイピングに最適。大規模や複雑な解析にはlxmlもおすすめです。

lxml・XPath:高速・高機能なHTML/XML解析

速度重視やXPath(HTML/XML用のクエリ言語)を使いたい場合はlxmlが便利です。

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPathでピンポイントにデータ抽出が可能。BeautifulSoupより学習コストは高めですが、処理速度は抜群です。

Scrapy:大規模クローリング向けフレームワーク

大規模なスクレイピングにはScrapy。Djangoのようなフルフレームワークです。

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }非同期リクエストやリンク追跡、データのパイプライン処理、各種フォーマットへのエクスポートも可能。小規模用途にはやや大げさですが、大量ページのクロールには最適です。

Selenium・Playwright・Pyppeteer:動的サイトのスクレイピング

JavaScriptでデータが生成されるサイトにはブラウザ自動操作が必要。SeleniumやPlaywrightが代表的です。

Selenium例:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Playwright例:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")人間が操作できるサイトならほぼ対応可能ですが、速度は遅め。必要な場合のみ使いましょう。

MechanicalSoup・RoboBrowser・PyQuery・Requests-HTML:便利系ツール

-

MechanicalSoup:フォーム送信やナビゲーション自動化。Requests+BeautifulSoupベース。

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser:MechanicalSoupに似ていますが、メンテナンス頻度は低め。

-

PyQuery:jQuery風のHTML解析。

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML:HTTPリクエスト、HTML解析、簡易的なJSレンダリングも対応。

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

フォームやCSSセレクタ、軽いJSレンダリングが必要な場合に便利です。

Asyncio・Aiohttp:Pythonスクレイピングの高速化

数百〜数千ページを一気に取得したい場合は、同期処理では遅すぎます。aiohttpとasyncioで並列処理しましょう。

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))同時に多数のページを取得でき、処理速度が大幅に向上します。

特化型ライブラリ:PRAW(Reddit)、PyPDF2など

-

PRAW:Reddit API経由でデータ取得。

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2:PDFからテキスト抽出。

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

その他:Instagram、Twitter、OCR(Tesseract)など、特殊なデータソース用のライブラリも豊富です。

Pythonスクレイピングライブラリ比較表

| ツール/ライブラリ | 使いやすさ | 速度・スケール | 最適な用途 |

|---|---|---|---|

| Requests + BeautifulSoup | 簡単 | 普通 | 初心者・静的サイト・簡易スクリプト |

| lxml(XPath) | 普通 | 高速 | 大規模・複雑な解析 |

| Scrapy | 難しい | 超高速 | 企業・大規模クロール・パイプライン |

| Selenium / Playwright | 普通 | 遅い | JS多用・インタラクティブサイト |

| aiohttp + asyncio | 普通 | 超高速 | 大量・主に静的ページ |

| MechanicalSoup | 簡単 | 普通 | ログイン・フォーム・セッション管理 |

| PyQuery | 普通 | 高速 | CSSセレクタ好き・DOM操作 |

| Requests-HTML | 簡単 | 可変 | 小規模・軽いJSレンダリング |

実践ガイド:Pythonでウェブスクレイパーを作る手順(例付き)

ここでは、(仮想の)ECサイトの商品リストをページ送りしながら取得し、CSVに保存する例を紹介します。

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")このスクリプトのポイント

- ページをループし、HTMLを取得・解析、商品名と価格を抽出、商品がなくなったら終了。

- 結果をCSVに保存し、分析しやすくします。

Excelに出力したい場合はpandasを使いましょう:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)フォーム・ログイン・セッションの扱い

多くのサイトはログインやフォーム送信が必要です。以下のように対応できます。

requestsのセッション利用例:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")MechanicalSoup利用例:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()セッションを使うことで、クッキーを維持しながら複数ページを連続取得できます。

動的コンテンツ・JavaScript生成ページのスクレイピング

HTMLにデータが見当たらない場合(ソース表示で空divなど)、ブラウザ自動操作が必要です。

Selenium例:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceもしくは、JavaScriptが呼び出しているAPIエンドポイントを見つけて、requestsで直接JSONを取得する方が高速です。

取得データのエクスポート:CSV・Excel・データベースなど

-

CSV:Python標準のcsvモジュール(上記参照)

-

Excel:pandasやopenpyxlを利用

-

Googleスプレッドシート:gspreadライブラリを利用

1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

データベース:SQLならsqlite3、pymysql、psycopg2、SQLAlchemy。NoSQLならpymongo(MongoDB)など。

Pythonウェブスクレイピングと最新ノーコードツールの比較:2025年の最適解はThunderbit

さて、最大の課題は「保守」です。自作スクリプトは最初は楽しいですが、100サイト分のスクリプトを管理し、レイアウト変更で一斉に動かなくなる…そんな経験、私も何度も味わいました。

だからこそ、私はを強くおすすめします。2025年のビジネスユーザーに最適な理由は:

- コーディング不要:Thunderbitは直感的な画面操作。AIで項目を自動抽出、列を調整して「スクレイピング」ボタンを押すだけ。Pythonもデバッグも不要です。

- 大規模対応:1万件の商品リストもクラウドで一括取得。スクリプトの監視も不要。

- 保守ゼロ:100社分の競合分析も、テンプレートを選ぶだけ。AIがレイアウト変更にも自動対応。

- サブページ・ページ送りもOK:詳細ページへのリンク追跡やページネーションも自動化。データの付加情報も取得可能。

- 即使えるテンプレート:Amazon、Zillow、LinkedInなど人気サイトはテンプレート完備。ワンクリックでデータ取得。

- 無料エクスポート:Excel、Googleスプレッドシート、Airtable、Notionなどに追加料金なしで出力。

要するに、「とにかくデータが欲しい」ビジネスユーザーにはThunderbitが最適。開発好きな方はPythonも楽しいですが、効率重視ならThunderbitの方が圧倒的に便利です。

Pythonウェブスクレイピングの倫理・法的注意点

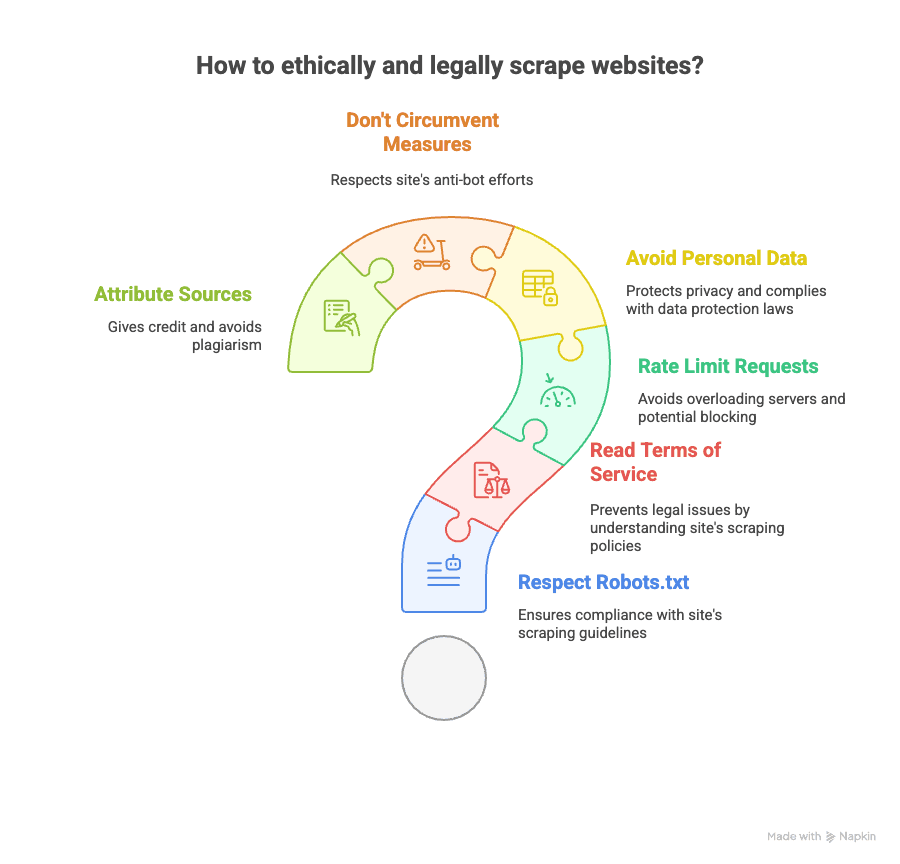

ウェブスクレイピングは強力ですが、責任も伴います。以下の点に注意しましょう。

- robots.txtの確認:サイトのスクレイピング可否を必ず確認。

- 利用規約の遵守:明確に禁止されている場合は要注意。違反するとアクセス禁止や法的リスクも。

- リクエスト間隔を空ける:サーバーに負荷をかけないよう、適切な間隔を設けましょう。

- 個人情報の扱いに注意:メールアドレスや電話番号など、GDPRやCCPAの対象となるデータは慎重に。

- アンチボット対策の回避はNG:CAPTCHAやブロックがある場合は無理に突破しない。

- 出典の明記:分析結果を公開する際は、データ元を明記しましょう。

法的な詳細はやもご参照ください。

さらに学びたい方へ:Pythonウェブスクレイピングの学習リソース

もっと深く学びたい方のために、おすすめリソースをまとめました。

- 公式ドキュメント:

- 書籍:

- 『Pythonクローリング&スクレイピング』Ryan Mitchell著

- 『退屈なことはPythonにやらせよう』Al Sweigart著

- オンラインガイド:

- 動画チュートリアル:

- Corey SchaferのYouTubeチャンネル

- コミュニティ:

ノーコードスクレイピングの実例はやもおすすめです。

まとめ:2025年に最適なウェブスクレイピングの選び方

- Pythonウェブスクレイピングは非常に強力で柔軟。コードが好きで、細かく制御したい方には最適です。

- 静的ページ、動的コンテンツ、フォーム、API、PDFなど、あらゆる用途にPythonライブラリがあります。

- ただし、ビジネス用途で多数のスクリプトを保守するのは大変。 データを素早く大量に、かつ専門知識なしで取得したいならが最適です。

- ThunderbitのAI搭載ノーコードUIなら、数クリックでどんなサイトもスクレイピング可能。サブページやページ送りも自動化、データ出力も自由自在。

- 倫理・法令遵守も重要:サイトの規約やプライバシーに配慮し、責任あるスクレイピングを心がけましょう。

Python好きも、データだけ欲しい方も、2025年はツールがますます進化しています。両方試して、自分のワークフローに合う方法を選びましょう。面倒な作業はロボットに任せて、効率的にデータ活用を進めてください。

もしスクリプトの保守に疲れたら、をぜひお試しください。きっと未来の自分とコーヒーの在庫が感謝してくれるはずです。

さらに詳しく知りたい方は、やもご覧ください。