インターネットの世界は、今や画像で溢れかえっています。毎日何十億枚もの画像がアップされていて、ECサイトの商品カタログからSNSのミームまで、あらゆるシーンで活用されています。営業やマーケティング、リサーチの現場で「画像を一枚ずつ集める」という地味な作業に直面したこと、きっと一度はあるはず。僕も昔は“右クリック→名前を付けて保存”の無限ループに苦しめられていました。でも、もっとスマートなやり方があるんです。python画像スクレイパーやみたいなノーコードツールを使えば、膨大な画像も一気にダウンロードできちゃいます。

この記事では、python画像ウェブスクレイピングの基本から、動的サイトへの対応方法、さらにPythonとThunderbitを組み合わせて最強のワークフローを作るコツまで、実践的な手順やサンプルコードを交えて紹介します。商品カタログ作成や競合調査、単純作業からの解放など、いろんなシーンで役立つ内容です。

Python画像スクレイパーって何?

python画像スクレイパーは、ウェブサイトを自動で巡回して<img>タグなどから画像ファイルを見つけてパソコンに保存してくれるスクリプトやツールのこと。手作業で一枚ずつ保存する必要はなく、Pythonがページ取得・HTML解析・画像保存まで全部やってくれます()。

python画像スクレイパーは、こんな人におすすめ:

- EC担当者:仕入先サイトから商品画像を一括取得してカタログ作成

- マーケター:SNS画像を集めてキャンペーンやトレンド分析

- 研究者:AI/機械学習用の画像データセット構築や学術調査

- 不動産業者:物件写真をまとめて収集し、リストや市場分析に活用

python画像スクレイパーは、飽きたり猫動画に気を取られたりしない“デジタルインターン”みたいな存在です。

なんでPythonで画像スクレイピング?

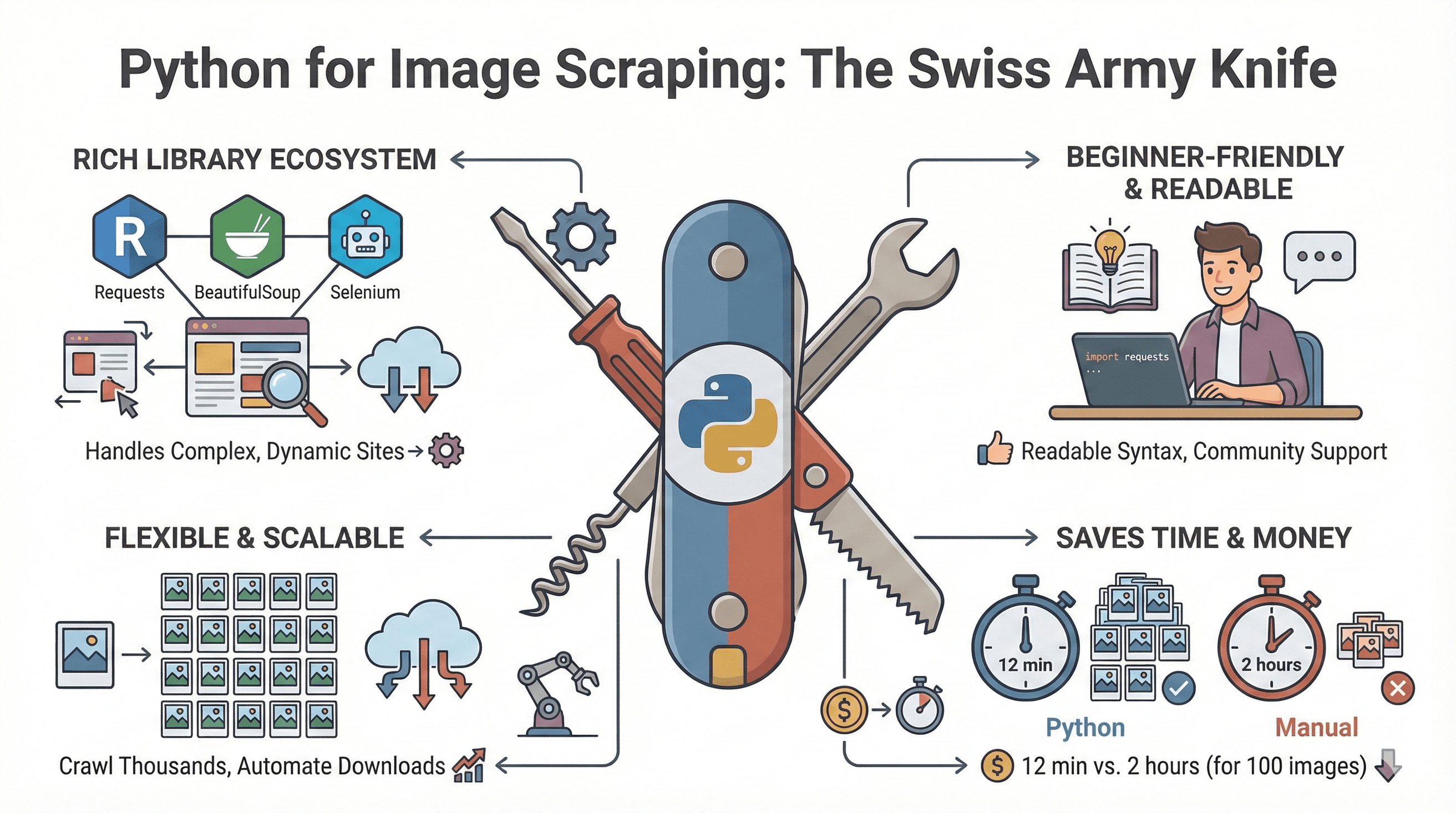

Pythonはウェブスクレイピングの万能ツール。その理由は…

Pythonはウェブスクレイピングの万能ツール。その理由は…

- 豊富なライブラリ:Requests、BeautifulSoup、Seleniumなど、静的HTMLからJavaScriptで動く複雑なサイトまで幅広く対応()。

- 初心者にもやさしい:シンプルな文法と充実したチュートリアル、コミュニティサポート。

- 柔軟&拡張性:1ページだけでなく数千ページも自動巡回、ダウンロード後の画像処理も可能。

- 圧倒的な時短効果:Pythonで100枚の画像を取得するのに約12分、手作業なら2時間以上かかるという検証も()。

ビジネスでの活用例をまとめると:

| 用途 | 手作業の課題 | Pythonスクレイパーの利点 |

|---|---|---|

| 商品カタログ作成 | コピペで何時間もかかる | 数千枚の画像を数分で一括取得 |

| 競合分析 | 情報抜け・遅い | 画像をまとめて比較 |

| トレンド調査 | データが不完全 | 多様な画像サンプルを大量収集 |

| AI/MLデータセット構築 | ラベリングが大変 | 収集から前処理まで自動化 |

| 不動産リスト | 古い・バラバラな画像 | 写真を一元管理&最新化 |

python画像ウェブスクレイピングに必要なツール

Pythonで画像をスクレイピングする時に使う主なライブラリを整理します:

| ライブラリ | 主な役割 | 得意な用途 | メリット | デメリット |

|---|---|---|---|---|

| Requests | HTTP経由でウェブページや画像を取得 | 静的サイト | シンプル・高速 | HTML解析やJS対応不可 |

| BeautifulSoup | HTMLから<img>タグを抽出 | 画像URLの取得 | 使いやすく柔軟 | JS対応不可 |

| Scrapy | 本格的なスクレイピング/クローリングフレームワーク | 大規模プロジェクト | 非同期・エクスポート機能 | 学習コスト高め |

| Selenium | ブラウザ自動操作(JSやスクロール対応) | 動的/JSサイト | JSレンダリング・ユーザー操作再現 | 遅い・セットアップ多め |

| Pillow (PIL) | 画像のダウンロード後処理 | 画像の検証・編集 | リサイズ・変換・チェック | スクレイピング自体は不可 |

使い分けの目安:

- 静的サイトなら「requests + BeautifulSoup」が基本セット。

- 無限スクロールやJSギャラリーなど動的サイトは「Selenium」が最適。

- 大規模・定期的な案件は「Scrapy」で効率化。

- 画像の加工や検証は「Pillow」で後処理。

pythonウェブサイト画像ダウンロードの手順

実際にPythonで静的なウェブサイトから画像をダウンロードする流れを見てみましょう。

Python環境の準備

まずPython 3をインストール。仮想環境の作成もおすすめです:

1python3 -m venv venv

2source venv/bin/activate # Windowsの場合: venv\Scripts\activate必要なライブラリをインストール:

1pip install requests beautifulsoup4画像URLの抽出

対象サイトをブラウザで開き、「検証」から<img>タグを探します。

画像URLを取得するサンプルスクリプト:

1import requests

2from bs4 import BeautifulSoup

3from urllib.parse import urljoin

4import os

5url = "https://example.com"

6response = requests.get(url)

7soup = BeautifulSoup(response.text, "html.parser")

8img_tags = soup.find_all("img")

9img_urls = [urljoin(url, img.get("src")) for img in img_tags if img.get("src")]ワンポイント: 一部サイトはdata-srcやsrcset属性で画像を遅延読み込みしている場合も。これらもチェックしましょう。

画像のダウンロード&保存

画像をフォルダに保存する例:

1os.makedirs("images", exist_ok=True)

2for i, img_url in enumerate(img_urls):

3 try:

4 img_resp = requests.get(img_url, headers={"User-Agent": "Mozilla/5.0"})

5 if img_resp.status_code == 200:

6 file_ext = img_url.split('.')[-1].split('?')[0]

7 file_name = f"images/img_{i}.{file_ext}"

8 with open(file_name, "wb") as f:

9 f.write(img_resp.content)

10 print(f"Downloaded {file_name}")

11 except Exception as e:

12 print(f"Failed to download {img_url}: {e}")整理のコツ:

- 可能なら商品IDやページタイトルでファイル名を付ける

- カテゴリや出典ごとにサブフォルダを分ける

- 重複画像はURLやハッシュでチェック

よくあるエラーと対策

- 画像が取得できない:JavaScriptで読み込まれている可能性。次のセクション参照。

- リクエストがブロックされる:User-Agentを設定し、

time.sleep()で間隔を空ける。 - 重複ダウンロード:URLやファイル名の重複を管理。

- 権限エラー:保存先フォルダへの書き込み権限を確認。

動的・JavaScriptサイトの画像スクレイピング

一部のサイトは画像をJavaScriptや無限スクロール、「もっと見る」ボタンで表示します。こうした場合はSeleniumが有効です。

Seleniumで動的コンテンツに対応

まずSeleniumとブラウザドライバ(例:ChromeDriver)をインストール:

1pip install seleniumをダウンロードし、PATHに追加。

Seleniumの基本スクリプト例:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3import time

4import os

5driver = webdriver.Chrome()

6driver.get("https://example.com/gallery")

7# ページ最下部までスクロールして画像を読み込む

8last_height = driver.execute_script("return document.body.scrollHeight")

9while True:

10 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

11 time.sleep(2) # 画像の読み込み待ち

12 new_height = driver.execute_script("return document.body.scrollHeight")

13 if new_height == last_height:

14 break

15 last_height = new_height

16img_elements = driver.find_elements(By.TAG_NAME, "img")

17img_urls = [img.get_attribute("src") for img in img_elements if img.get_attribute("src")]

18os.makedirs("dynamic_images", exist_ok=True)

19for i, img_url in enumerate(img_urls):

20 # (ダウンロード処理は前述と同様)

21 pass

22driver.quit()ポイント:

WebDriverWaitで画像の出現を待つ- クリックで画像を表示する場合は

element.click()を活用

代替案: Playwright(Python対応)なども複雑なサイトで高速・安定動作()。

ノーコード派におすすめ:Thunderbitで画像スクレイピング

コードやブラウザドライバの設定が面倒な人には、みたいなノーコード・AI搭載のウェブスクレイパーChrome拡張が超おすすめ。画像抽出が驚くほど簡単にできます。

Thunderbitで画像を抽出する手順

- Thunderbitをインストール:を追加

- 対象サイトを開く:画像を取得したいページを表示

- Thunderbitを起動:拡張アイコンをクリックしてサイドバーを開く

- AIフィールド提案:「AIフィールド提案」をクリックすると、ThunderbitのAIがページを解析し「画像」カラムを自動生成()

- スクレイピング開始:「スクレイピング」ボタンで画像を一括収集。サブページや無限スクロールにも対応。

- エクスポート:画像URLやファイルをExcel、Google Sheets、Notion、Airtable、CSVに直接出力。無料プランでも制限なし。

おまけ: Thunderbitの無料画像エクストラクター機能なら、ワンクリックでページ内の全画像URLを取得できます()。

Thunderbitの強み:

- コーディングやHTML知識不要

- 動的コンテンツやサブページ、ページネーションも自動対応

- エクスポートは即時&無制限(無料プランでもOK)

- AIがサイト構造の変化にも自動対応、メンテ不要

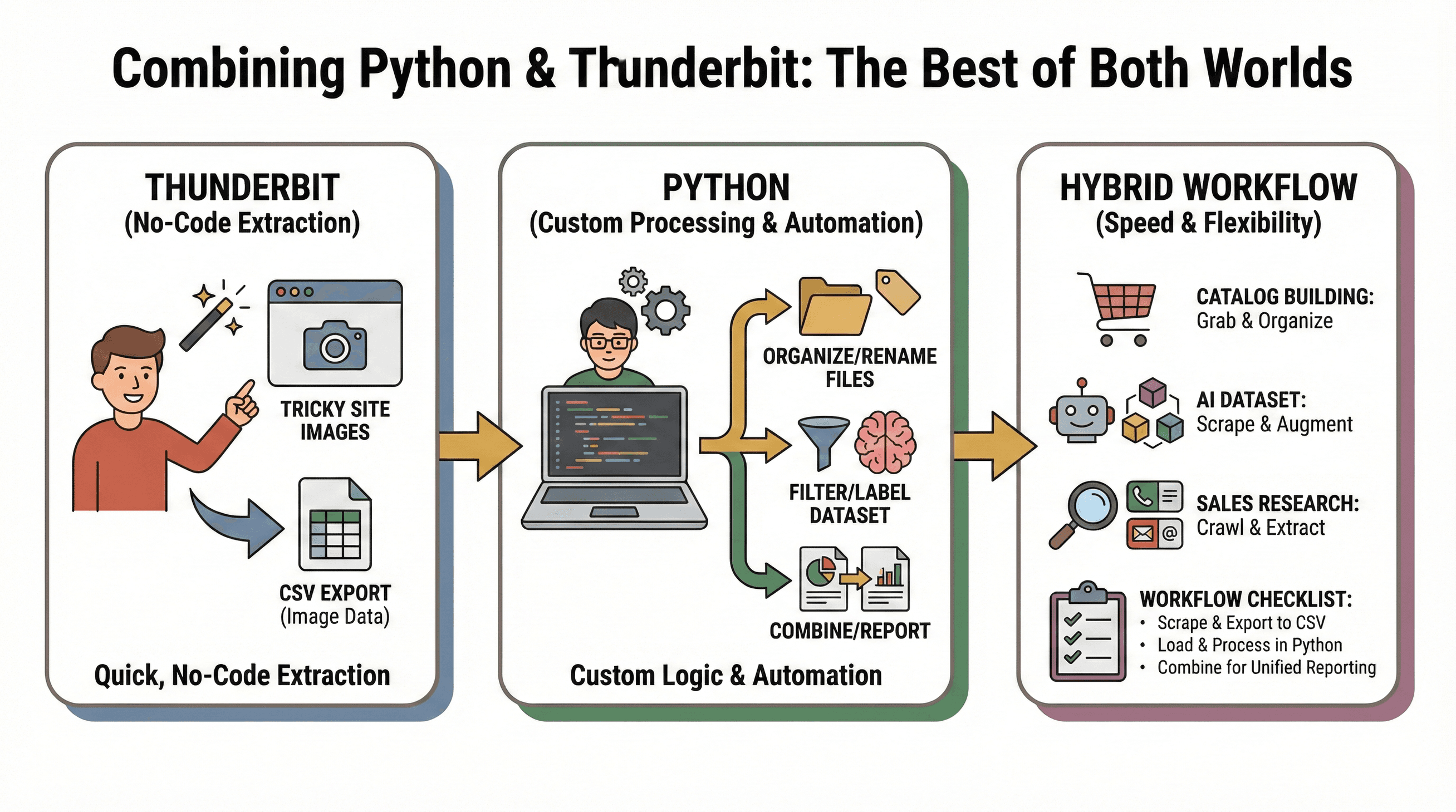

Python×Thunderbitのハイブリッド活用術

おすすめは、Thunderbitで手軽に画像を抽出し、Pythonでカスタム処理や自動化を行うハイブリッド運用。

おすすめは、Thunderbitで手軽に画像を抽出し、Pythonでカスタム処理や自動化を行うハイブリッド運用。

活用例:

- カタログ作成:Thunderbitで画像を一括取得→Pythonで整理・リネーム・加工

- AIデータセット構築:Thunderbitで複数サイトから画像収集→Pythonでフィルタ・ラベル付け・拡張

- 営業リサーチ:Pythonで企業URLリストを巡回→Thunderbitで各サイトから画像・メール・電話番号を抽出

ワークフローチェックリスト:

- Thunderbitで画像をスクレイピングしCSV出力

- PythonでCSVを読み込み、分析や自動処理

- 複数ソースのデータを統合してレポート作成

この組み合わせなら、スピード・柔軟性・あらゆる画像スクレイピング課題への対応力が手に入ります。

python画像ウェブスクレイピングのトラブル対策&ベストプラクティス

よくある課題:

- リクエストブロック:User-Agent設定、ダウンロード間隔を空ける、robots.txtを遵守

- 画像が取得できない:JSで読み込まれる場合はSeleniumやThunderbitを活用

- 重複ダウンロード:URLやファイルハッシュで管理

- 壊れたファイル:Pillowでダウンロード後に画像を検証

おすすめ運用:

- サイト・カテゴリ・日付ごとにフォルダを整理

- 商品IDやページタイトルなど分かりやすいファイル名を付与

- 広告やアイコンなど不要画像はサイズや寸法で除外

- 画像のスクレイピング前に著作権や利用規約を必ず確認()

python画像スクレイパーの比較:コードvsノーコード

主な選択肢を比較表でまとめます:

| 比較項目 | Python(Requests/BS) | Selenium(Python) | Thunderbit(ノーコード) |

|---|---|---|---|

| 使いやすさ | 普通(コーディング必要) | 難しい(コード+ブラウザ自動化) | 非常に簡単(AIでクリック操作) |

| 動的コンテンツ対応 | 不可 | 可能 | 可能 |

| セットアップ時間 | 長め(インストール・コーディング) | 長い(ドライバ・コード) | 非常に短い(拡張機能追加のみ) |

| 拡張性 | 手動(並列化も可) | 遅い(ブラウザ負荷大) | 高い(クラウドで最大50ページ同時) |

| メンテナンス | 高い(サイト変更でスクリプト修正) | 高い | 低い(AIが自動対応) |

| エクスポート | カスタム(CSV, DB等) | カスタム | ワンクリックでExcel, Sheets, Notion等 |

| コスト | 無料(オープンソース) | 無料 | 無料枠あり・大量利用は有料 |

まとめ: コーディングが得意で細かく制御したいならPythonが最強。スピードや手軽さ、動的サイト対応ならThunderbitが圧倒的に便利。多くの現場では両方の併用がベストです。

まとめ&ポイント

ウェブ上の画像データは今や膨大で、活用価値もどんどん高まっています。python画像スクレイパーなら自動化と柔軟性を、Thunderbitみたいなノーコードツールなら誰でも手軽に画像収集が可能です。

ポイントまとめ:

- 静的サイトやカスタム処理はPython(Requests+BeautifulSoup)

- 動的・JSサイトはSelenium

- 手早くノーコードで画像抽出したい時やExcel/Google Sheets/Notionへの即時出力はThunderbit

- 両者を組み合わせれば、データ収集から加工・自動化まで最強のワークフローが実現

画像スクレイピングを効率化したい人は、まずはシンプルなPythonスクリプトを書いてみるか、して、その時短効果を体感してみてください。さらに詳しいノウハウはやも参考にどうぞ。

快適な画像スクレイピングライフを!画像フォルダの整理もお忘れなく。

よくある質問(FAQ)

1. python画像スクレイパーとは?

python画像スクレイパーは、ウェブサイトを自動で巡回し、<img>タグなどから画像ファイルを見つけてパソコンに保存するスクリプトやツールです。手作業で一枚ずつ保存する手間を省けます。

2. 画像スクレイピングにおすすめのPythonライブラリは?

Requests(ページ取得)、BeautifulSoup(HTML解析)、Selenium(動的コンテンツ対応)、Pillow(ダウンロード後の画像処理)が定番です。

3. JavaScriptや無限スクロールのサイトから画像を取得するには?

Seleniumでブラウザを自動操作し、ページをスクロールして全コンテンツを読み込んだ後、画像URLを抽出します。ThunderbitならAIで動的コンテンツも自動対応可能です。

4. ノーコードで画像スクレイピングする方法は?

ThunderbitはノーコードのChrome拡張で、AIがあらゆるサイトから画像を検出・抽出します。クリック操作だけでExcelやGoogle Sheets、Notion、Airtableにエクスポートできます。

5. PythonとThunderbitを組み合わせて使えますか?

もちろん可能です。Thunderbitで手軽に画像を抽出し、Pythonで高度な処理や自動化を行うことで、両者の強みを活かせます。Thunderbitからデータをエクスポートし、Pythonスクリプトでさらに加工・分析しましょう。

さらに詳しく知りたい人へ