正直な話、朝起きて「よし、今日は500件の商品価格を手作業でスプレッドシートにコピペしよう!」なんてワクワクする人は、なかなかいませんよね。(もしそんな方がいたら、その根性に拍手です。手首のサポーターもぜひご用意を!)営業やオペレーション、競合に負けないために日々奮闘している方なら、ウェブサイトからデータを集める大変さを一度は味わったことがあるはず。今やビジネスはウェブデータが命綱。自動でデータを取得したいというニーズは急増していて、です。

SaaSや自動化の現場で長年働いてきた私も、Excelマクロの力技から深夜2時に書いたPythonスクリプトまで、あらゆる手法を試してきました。このガイドでは、python htmlパーサーを使って実際のデータ(今回はIMDbの映画評価)を取得する方法を分かりやすく解説します。そして2025年の今、コード不要でデータ取得ができるAIツールのような新しい選択肢もご紹介します。

HTMLパーサーとは?Pythonで使う理由

そもそもhtmlパーサーって何?ざっくり言うと、ウェブページのごちゃごちゃしたHTMLコードを読みやすい木構造に整理してくれる“ウェブの司書さん”みたいな存在です。これがあれば、タイトルや価格、リンクなど欲しい情報だけをピンポイントで抜き出せるようになります。

pythonはこの分野で定番中の定番。理由はシンプルで分かりやすく、初心者にも優しく、ウェブスクレイピングやパース用のライブラリが豊富だから。実際、です。学びやすく、コミュニティも活発なので安心して始められます。

Pythonで使える主なHTMLパーサー

pythonでhtml解析する時によく使われるライブラリは以下の通りです:

- BeautifulSoup:初心者にぴったりの定番ライブラリ。

- lxml:とにかく速くて高機能。XPathでの検索も得意。

- html5lib:ブラウザ並みにHTMLの崩れにも強い。

- PyQuery:jQuery風のセレクタが使える。

- HTMLParser:Python標準搭載のシンプルなパーサー。

それぞれ特徴は違いますが、どれも生のHTMLを構造化データに変換するのに役立ちます。

ビジネスで活躍するpython htmlパーサーの活用例

ウェブデータの抽出は、もはやエンジニアやデータサイエンティストだけのものではありません。営業やオペレーションなど、幅広い業務で欠かせない存在になっています。その理由を見てみましょう:

つまり、手作業でデータを集めていると、時間もコストも大きく損していることになります。

python htmlパーサー徹底比較:人気ライブラリの特徴

ここからは実践編。主要なpython htmlパーサーの特徴を比較し、用途に合ったツール選びの参考にしてください:

| ライブラリ | 使いやすさ | 速度 | 柔軟性 | 保守の手間 | おすすめ用途 |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | 中程度 | 初心者、HTMLが崩れている場合 |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | 中程度 | 高速処理、XPath、大規模データ |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | 低 | ブラウザ並みの解析、壊れたHTML |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | 中程度 | jQuery好き、CSSセレクタ活用 |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | 低 | シンプルな標準処理 |

BeautifulSoup:初心者にやさしい定番ツール

BeautifulSoupはHTMLパースの“はじめの一歩”として最適です。直感的な文法と充実したドキュメント、そしてHTMLの崩れにも強いのが魅力()。ただし、大規模ページや複雑な構造では速度が遅くなりがちで、XPathなどの高度な検索は標準では使えません。

lxml:高速かつ高機能

速度重視やXPathを使いたい場合はlxmlが最適です()。C言語ベースで動作が速い反面、インストールや使いこなしにはやや慣れが必要です。

その他の選択肢:html5lib、PyQuery、HTMLParser

- html5lib:ブラウザと同じようにHTMLを解析。崩れたマークアップにも強いが、動作は遅め()。

- PyQuery:jQuery風のセレクタが使えるので、フロントエンド経験者におすすめ()。

- HTMLParser:Python標準搭載。高速だが機能は最小限。

ステップ1:python htmlパーサーの環境構築

まずはPython環境を整えましょう。手順は以下の通り:

-

Pythonのインストール:からダウンロード。

-

pipの確認:Python3.4以降は標準搭載。

pip --versionで確認。 -

必要なライブラリのインストール(本ガイドではBeautifulSoupとrequestsを使用):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4:HTMLパーサー本体requests:ウェブページ取得用lxml:BeautifulSoupの高速パーサーとして利用可能

-

インストール確認:

1python -c "import bs4, requests, lxml; print('All good!')"

トラブルシューティングのヒント:

- 権限エラーが出た場合は

pip install --user ...を試す - MacやLinuxでは

python3やpip3が必要な場合あり - “ModuleNotFoundError”が出たら、スペルや環境を再確認

ステップ2:pythonでウェブページを解析してみよう

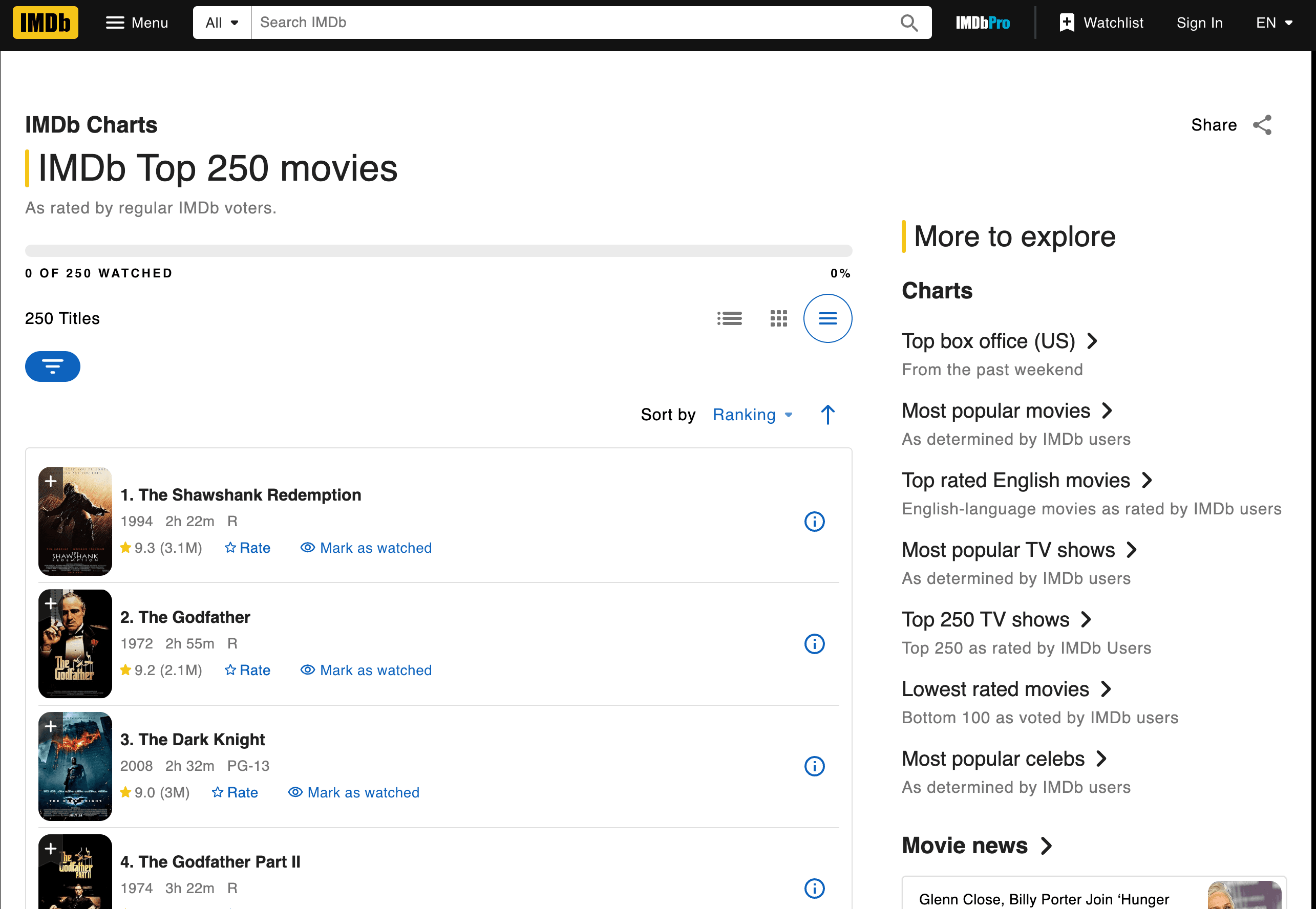

実際にIMDbのトップ250映画のタイトル・年・評価を取得してみましょう。

ページの取得と解析

以下のスクリプトで実行できます:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# タイトルと評価のセルを取得

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# サンプルとして最初の3件を表示

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Rating: {rating}")このスクリプトのポイント:

requests.get()でページを取得BeautifulSoupでHTMLを解析- クラス名で

<td>要素を抽出 - タイトル・年・評価をテキストで取得

出力例:

11. The Shawshank Redemption (1994) -- Rating: 9.3

22. The Godfather (1972) -- Rating: 9.2

33. The Dark Knight (2008) -- Rating: 9.0データ抽出のコツ:タグやクラスの見つけ方

どのタグやクラスを使うかは、IMDbページのHTMLを「右クリック→要素を検証」で調べて特定します。例えば、各映画は<td class="titleColumn">、評価は<td class="ratingColumn imdbRating">に入っています()。

ワンポイント:他のサイトをスクレイピングする場合も、まずHTML構造とクラス名・タグを確認しましょう。

結果の保存・エクスポート

データをCSVファイルに保存する例:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Title', 'Year', 'Rating'])

13 writer.writerows(movies)データ整形のヒント:

.strip()で余分な空白を除去- 欠損データは

ifでチェック - Excelで開く場合はCSV、

pandasを使えば.xlsxも出力可能

ステップ3:HTML構造の変化と保守の課題

ここからが本番です。ウェブサイトは頻繁にレイアウトを変更します。例えばIMDbのクラス名がtitleColumnからmovieTitleに変わると、スクリプトは突然空の結果しか返さなくなります。私も何度も経験しました。

スクリプトが動かなくなる主な原因

よくあるトラブル:

- セレクタが見つからない:指定したタグやクラスが存在しない

- 結果が空:ページ構造が変わった、またはJavaScriptで動的に生成されている

- HTTPエラー:サイト側でボット対策が導入された

対処法:

- 解析しているHTMLがブラウザで見えるものと一致しているか確認

- セレクタを新しい構造に合わせて修正

- 動的コンテンツの場合はSeleniumなどのブラウザ自動化やAPIの利用を検討

最大の悩みは? 10、50、100サイトと数が増えるほど、スクリプトの修正に追われて本来の分析に時間が割けなくなります()。

ステップ4:python htmlパーサー運用の隠れたコスト

IMDbだけでなくAmazonやZillow、LinkedInなど複数サイトをスクレイピングしたい場合、それぞれ専用のスクリプトが必要です。サイトが変わるたびに修正作業も発生します。

見落としがちなコスト:

- 保守工数:

- インフラ整備:プロキシやエラー処理、監視が必要

- パフォーマンス:大量データ時の並列処理やレート制限対応

- 品質管理:スクリプトが増えるほど不具合リスクも増大

非エンジニアのチームでは、これらの運用はすぐに限界を迎えます。まるでインターンを大量に雇って手作業でコピペさせているようなものですが、その“インターン”がサイト変更のたびに休んでしまうのが現実です。

python htmlパーサーの次世代:AI搭載Thunderbitで一気に解決

ここからが本題。もしコードも保守も不要で、どんなサイトでも必要なデータをすぐ取得できたら?

それを実現したのがです。AIウェブスクレイパーChrome拡張機能で、どんなウェブサイトでも2クリックで構造化データを抽出できます。Pythonもスクリプトも不要、面倒なトラブルとも無縁です。

python htmlパーサー vs Thunderbit:徹底比較

| 比較項目 | Python HTMLパーサー | Thunderbit (料金はこちら) |

|---|---|---|

| 導入の手間 | 高い(インストール・コーディング・デバッグ) | 低い(拡張機能を入れてクリック) |

| 使いやすさ | コード必須 | コード不要、直感的操作 |

| 保守性 | 高い(スクリプトが頻繁に壊れる) | 低い(AIが自動対応) |

| 拡張性 | 複雑(スクリプト・プロキシ・インフラ管理) | 標準搭載(クラウドスクレイピング・バッチ処理) |

| データ加工 | 手動(追加コーディングが必要) | 標準搭載(ラベリング・クリーニング・翻訳・サブページ対応) |

AIで一発解決できるなら、わざわざ自作する必要はありません。

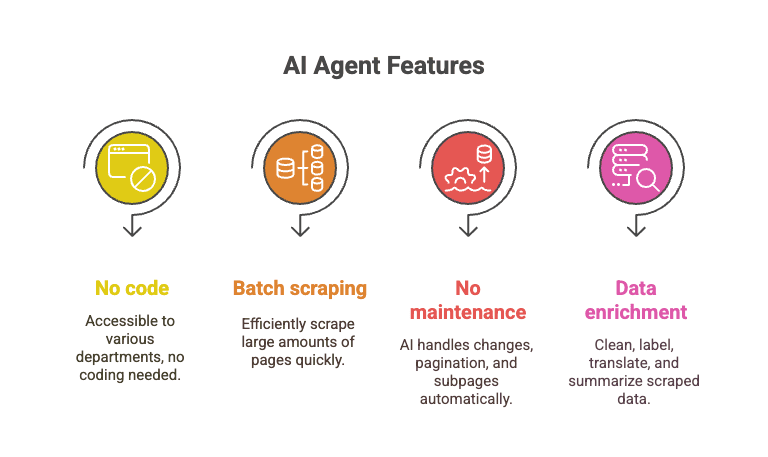

AIでウェブデータ抽出を選ぶ理由

ThunderbitのAIエージェントはページ構造を自動で解析し、レイアウトが変わっても柔軟に対応します。まるで“超優秀なインターン”が24時間働いてくれるようなものです。

- コード不要:誰でも使える(営業・オペレーション・マーケティングなど)

- バッチ処理:1万ページ以上も一瞬で取得

- 保守不要:AIがレイアウト変更やページネーション、サブページも自動対応

- データ加工:取得しながらクリーニング・ラベリング・翻訳・要約も可能

例えばIMDbのトップ250だけでなく、各映画の詳細ページやレビューも数クリックで一括取得。Pythonスクリプトがエラーで止まっている間に、Thunderbitなら一気に完了します。

実践:ThunderbitでIMDb映画評価をスクレイピング

Thunderbitなら同じIMDbのデータ取得も以下の手順で完了:

- をインストール

- にアクセス

- Thunderbitアイコンをクリック

- 「AIでフィールドを提案」をクリック。Thunderbitが自動で(タイトル・年・評価)を抽出

- 必要に応じてカラムを調整

- 「スクレイピング開始」をクリック。全250件が一瞬で取得されます

- Excel・Googleスプレッドシート・Notion・CSVなど好きな形式でエクスポート

これだけ。コードもデバッグも「なぜデータが空?」と悩むこともありません。

実際の操作を見たい方はや、も参考にしてください。

まとめ:自分に合ったウェブデータ取得方法を選ぼう

BeautifulSoupやlxmlなどのpython htmlパーサーは、開発者にとって強力で柔軟、しかも無料です。自分で細かくカスタマイズしたい方には最適ですが、学習コストや保守の手間、規模が大きくなるほど隠れたコストも増えていきます。

一方、ビジネスユーザーや営業チーム、「とにかくデータだけ欲しい」方には、のようなAI搭載ツールが最適。コードも保守も不要で、大量のウェブデータを一括で取得・加工できます。

私のおすすめ:スクリプトを書くのが好きで細かく制御したいならpython。時間や手間を節約したいならThunderbitを試してみてください。AIに任せて、面倒な作業から解放されましょう。

ウェブスクレイピングやデータ抽出、AI自動化についてもっと知りたい方は、の他のチュートリアルもぜひご覧ください。やも人気です。