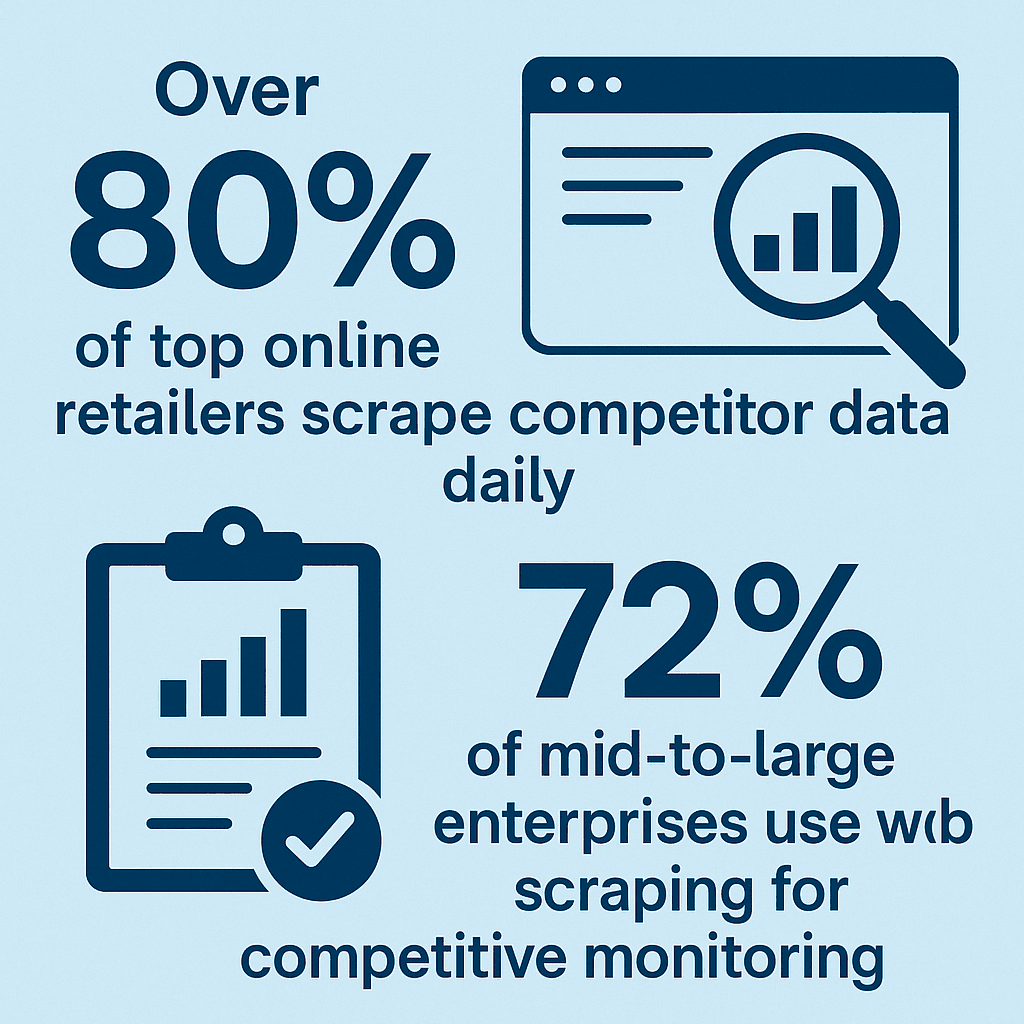

企業がどうやってライバルの価格を正確にキャッチしているのか、営業チームが次々と新しいリードを手に入れている理由、気になったことはないですか?実は、その裏には웹 스크래퍼の活用があるんです。自分も、웹 스크래퍼が一部のエンジニアの趣味から、価格調査や市場分析などビジネス現場で欠かせないツールに進化していくのをリアルに見てきました。そして、その多くの現場でPythonコードが大活躍しています。実際、、しているというデータもあるんですよ。

とはいえ、「Pythonで웹 스크래퍼」と聞くと、プログラミング未経験の人にはちょっとハードル高そうに感じるかもしれません。そこで今回は、Pythonでの웹 스크래퍼の基本や、なぜPythonが選ばれるのか、実際の流れ、そしてのようなツールがどうやって誰でも簡単に웹 스크래퍼を実現しているのか、わかりやすく紹介します。

とはいえ、「Pythonで웹 스크래퍼」と聞くと、プログラミング未経験の人にはちょっとハードル高そうに感じるかもしれません。そこで今回は、Pythonでの웹 스크래퍼の基本や、なぜPythonが選ばれるのか、実際の流れ、そしてのようなツールがどうやって誰でも簡単に웹 스크래퍼を実現しているのか、わかりやすく紹介します。

Pythonでの웹 스크래퍼って何?

まずは基本から。Pythonで웹 스크래퍼とは、Pythonのスクリプトを使ってウェブサイトから自動でデータを集めること。イメージとしては、「このページにアクセスして、必要な情報を集めて保存してね」とロボットにお願いする感じ。手作業でコピペする代わりに、Pythonが“デジタルアシスタント”になって、大量のウェブデータを効率よく集めて整理してくれます(参照)。

웹 스크래퍼自体は、ウェブページから情報を自動で抜き出して、バラバラなウェブ情報を使いやすいデータに変換するプロセス。ハッキングでもなければ、ただのスクリーンショットでもありません。Pythonを使うことで、この作業を効率的かつ柔軟にこなせるんです。

なぜ웹 스크래퍼にPythonが選ばれるの?

じゃあ、なぜ多くの人が웹 스크래퍼にPythonを使うのか?主な理由はこんな感じです:

- 初心者にもやさしい文法:Pythonは読みやすくて、プログラミング未経験でもとっつきやすい言語。

- 豊富なライブラリ:、、など、ウェブページの取得やHTML解析に便利なライブラリが揃ってます。

- 柔軟性:シンプルな静的サイトから、JavaScriptを多用した動的サイトまで幅広く対応できる。

- コミュニティが充実:Pythonで웹 스크래퍼をやってる人が多いから、情報やチュートリアルも豊富で、困ったときも解決しやすい。

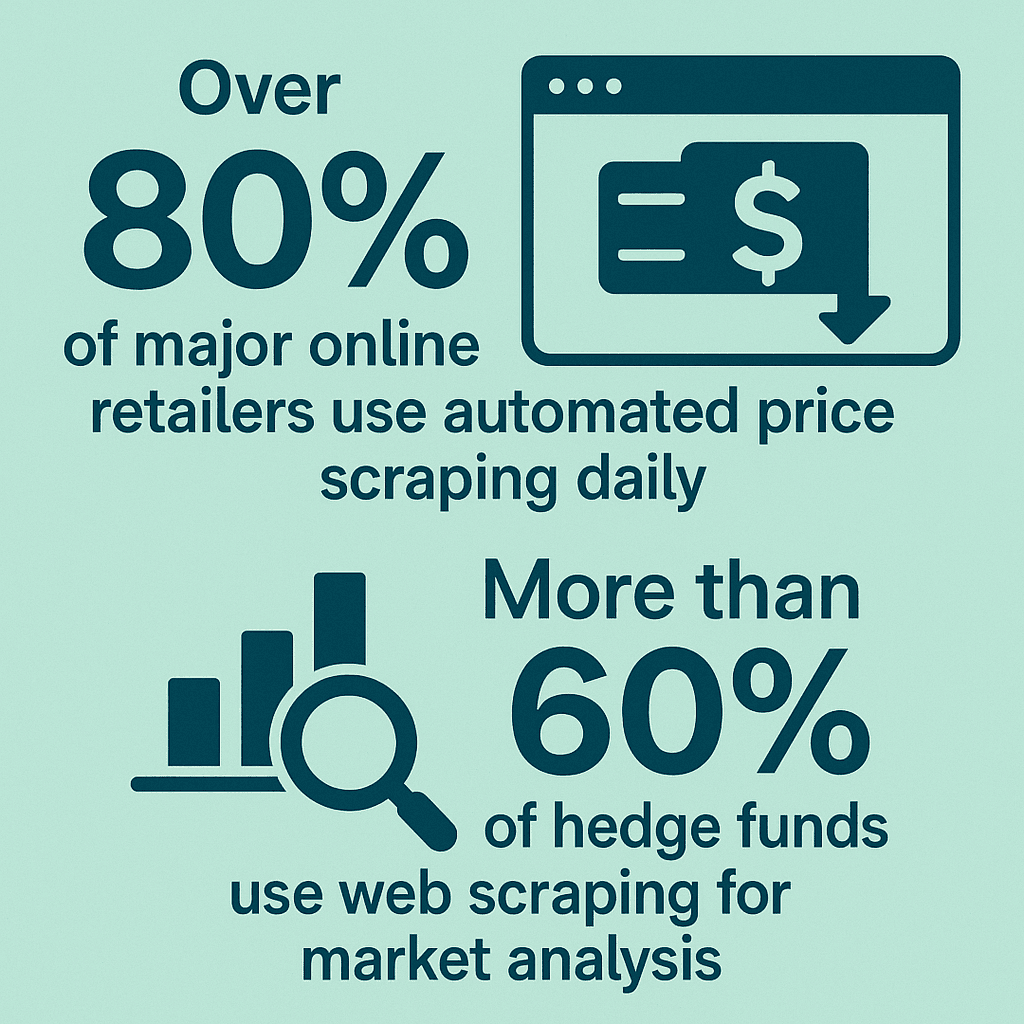

Pythonの人気は本物。営業、EC、マーケ、金融など、ビジネス現場で重要なデータ収集の基盤になっています。たとえば、、しているというデータも。

Python웹 스크래퍼の仕組み

Pythonで웹 스크래퍼をやるとき、実際どんな流れで動いているのか、ざっくり説明します。コードは不要、イメージだけでOK。

- HTTPリクエストを送信:Pythonスクリプトがウェブページにアクセス(ブラウザでURLを入力するのと同じイメージ)。

- HTMLデータを取得:ウェブサイトからページのHTML(ウェブページの設計図)が返ってくる。

- HTMLを解析:BeautifulSoupなどのライブラリでHTMLを読み取り、必要な部分を探しやすくする。

- 必要なデータを抽出:商品名や価格、メールアドレスなど、欲しい情報だけをピンポイントで抜き出す。

- データを保存・出力:抽出したデータをCSVやExcel、データベースなどに保存。

Python웹 스크래퍼の主な構成要素

- HTTPリクエストモジュール(例:Requests):ウェブサイトにアクセスしてページデータを取得。

- HTMLパーサー(例:BeautifulSoup、lxml):HTMLを解析して必要な情報を見つけやすくする。

- データ抽出ロジック:欲しい情報だけを抜き出す“ハイライト”役。

- 保存・出力機能:抽出したデータをスプレッドシートやデータベースに整理。

たとえば、営業担当がリード獲得のためにディレクトリサイトから名前やメールアドレスだけを抜き出したいとき、Pythonのパーサーが大活躍します。

Python웹 스크래퍼の主な活用例

Pythonでの웹 스크래퍼は、エンジニアだけのものじゃありません。いろんな業界で実際にビジネス成果を生み出しています。代表的な活用例はこちら:

| ユースケース | ビジネスユーザーへの価値 |

|---|---|

| 営業リード獲得 | ディレクトリやLinkedInから自動で連絡先情報を収集し、CRMに新規リードを追加。自動化により30%のリード増加を実現。 |

| 価格モニタリング(EC) | 競合の価格や在庫をリアルタイムで追跡。小売業者の81%が自動価格スクレイパーを活用。 |

| 市場調査 | レビューやニュース、SNSの言及を集約し、トレンドや消費者の声を分析。 |

| ブランド評価管理 | レビューやSNSの投稿を収集し、ブランドイメージの把握や改善に活用。 |

| 不動産分析 | Zillowなどから物件情報や価格を取得し、投資や市場調査に役立てる。 |

つまり、Pythonでのスクレイピングは手作業の何倍もの効率で、今まで見えなかった洞察をもたらしてくれます。

非エンジニアにとってのPython웹 스크래퍼の課題

ここで問題になるのが、Pythonのパワフルさと引き換えに、プログラミング未経験者には難しい点が多いこと。主なハードルはこんな感じ:

- コーディングスキルが必要:PythonやHTMLの知識、エラー対応力が求められる。

- スクリプトの保守が大変:ウェブサイトのレイアウトが変わると、スクリプトも修正が必要。

- セットアップが面倒:Pythonやライブラリのインストール、バージョン管理などでつまずくことも。

- アンチボット対策:CAPTCHAやアクセス制限、IPブロックなど、技術的な回避策が必要な場合も。

- 時間がかかる:しっかり動く스크래퍼を作るには、数時間~数日かかることも珍しくない。

実際、ビジネスユーザーがプロジェクトのために스크래퍼を学び始めても、サイトの仕様変更やスクリプトの不具合で挫折するケースが多いんです(参照)。

Thunderbit:Python不要のノーコード웹 스크래퍼

ここで登場するのがです。自分も共同創業者兼CEOとして関わっていますが、Thunderbitはプログラミング不要で誰でも簡単に웹 스크래퍼ができる最適なツールだと自信を持っています。

Thunderbitはで、欲しいデータを「こういう情報が欲しい」と伝えるだけで抽出OK。「AIフィールド提案」機能がページを読み取り、最適なカラムを自動で提案・構造化。コーディングもセットアップも不要、すぐに結果が出ます。

Thunderbitで웹 스크래퍼が簡単になる理由

Thunderbitの基本的な使い方はこんな感じ:

- 拡張機能をインストール:公式サイトからChromeにThunderbitを追加。

- 対象サイトを開く:抽出したいページにアクセス。

- 「AIフィールド提案」をクリック:AIがページを解析し、「商品名」「価格」「画像」など最適なカラムを提案。

- カラムを調整:必要に応じてカラム名の変更や追加、削除もOK。特殊なケースにはカスタム指示も可能。

- 「スクレイピング」を実行:リストや詳細ページ、ページ送りも自動で処理し、きれいな表にまとめます。

- データをエクスポート:CSV/Excelでダウンロード、またはGoogle Sheets、Airtable、Notionへ直接出力。

Thunderbitは詳細ページの巡回や、最大50ページ同時のクラウド스크래핑、定期実行(毎日の価格チェックやリード更新)にも対応。小規模な用途なら無料で使えます。

詳しくはやもチェックしてみてください。

PythonコードとThunderbitの比較

PythonとThunderbitを比べてみましょう:

| 比較項目 | Pythonによるウェブスクレイピング | Thunderbit(ノーコードAIツール) |

|---|---|---|

| 使いやすさ | プログラミング知識とセットアップが必要 | 直感的な操作画面で誰でもすぐ使える |

| 柔軟性 | コード次第でどんなロジックも実装可能 | ビジネス用途の大半をカバー。高度なケースはコードが必要な場合も |

| 拡張性 | サーバーやプロキシの管理が必要 | 最大50ページ同時のクラウド스크래핑で多くのビジネスニーズに対応 |

| 保守性 | サイト変更時はスクリプト修正が必要 | AIがレイアウト変化に自動対応。ユーザーの手間は最小限 |

| アンチボット対策 | プロキシや遅延処理など自分で実装が必要 | Thunderbitが自動で対策を実施 |

| 習得のしやすさ | 非エンジニアにはハードルが高い | 初心者でも数分で結果が出せる |

| コスト | Python自体は無料だが、時間や開発コストが発生 | 無料プランあり。大量利用は有料プランも |

| おすすめ対象 | 開発者や技術者、大規模・高度なカスタマイズが必要な場合 | 営業・マーケ・オペレーションなど、素早く簡単にデータが欲しいビジネスユーザー |

まとめると、Pythonはカスタマイズ性や大規模案件に最適ですが、スキルと時間が必要。Thunderbitは、手軽にデータを取得したいビジネスユーザーにぴったりです。

웹 스크래퍼の法的・倫理的注意点

どのツールを使う場合でも、웹 스크래퍼には法的・倫理的な配慮が欠かせません。注意すべきポイントは以下の通り:

- 公開データのみを対象に:ログインや有料会員でしか見られない情報は避け、誰でも見られるデータだけを収集しましょう(参照)。

- 利用規約やrobots.txtの確認:サイトの利用規約やrobots.txtを必ず確認し、禁止されている場合はスクレイピングを控えましょう。

- サーバーへの負荷を避ける:リクエストの間隔を空け、サイトに過度な負荷をかけないように。Thunderbitなど多くのツールは自動で制限を設けています。

- 個人情報の扱いに注意:氏名やメールアドレスなどの個人情報は、GDPRやCCPAなどの法規制に従い慎重に扱いましょう。

- データの利用は責任を持って:著作権のあるコンテンツの再配布や、個人情報のスパム利用は厳禁です。

より詳しい法的ガイドはも参考にしてください。

まとめ:自分に合った웹 스크래퍼手法を選ぼう

ポイントをまとめると:

- Pythonによる웹 스크래퍼は強力な自動化手段だけど、プログラミングスキルや保守の手間が必要。

- Pythonの強みは柔軟性・拡張性・カスタマイズ性。開発者や独自要件のあるチームに最適。

- Thunderbitなどノーコードツールは、AIによるフィールド自動検出やサブページ対応、即時エクスポートなど、誰でも簡単に使えるのが魅力。ビジネスユーザーにおすすめ。

- 法令遵守が大切:公開データのみを対象に、サイトのルールを守り、サーバーや個人情報の扱いに注意しましょう。

自分のスキルやプロジェクトの目的に合わせて、最適なツールを選んでください。「とにかく手軽にデータを集めたい!」という人は、。数クリックで驚くほど簡単にデータ収集ができます。もちろん、コーディングが得意な人にはPythonもおすすめです。

さらに詳しく知りたい人は、やもチェックしてみてください。

よくある質問

1. Pythonによる웹 스크래퍼とは?

Pythonスクリプトを使ってウェブサイトから自動的にデータを収集・抽出すること。まるでプログラム可能なロボットが、必要な情報を集めて整理してくれるイメージです。

2. なぜPythonが웹 스크래퍼で人気なの?

Pythonは読みやすい文法、強力なライブラリ(BeautifulSoup、Scrapy、Requestsなど)、活発なコミュニティが揃っていて、シンプルなサイトから複雑な動的サイトまで幅広く対応できるからです。

3. Pythonで웹 스크래퍼する際の主な課題は?

コーディングスキルが必要、スクリプトの保守(サイト変更への対応)、アンチボット対策、セットアップやデバッグに時間がかかる点が主な課題です。

4. ThunderbitとPythonコードの違いは?

Thunderbitはノーコード・AI搭載のChrome拡張で、数クリックでウェブデータを抽出できます。コーディングや保守の手間がなく、ビジネスユーザーに最適です。

5. 웹 스크래퍼は合法ですか?

公開されているデータを、サイトの利用規約やrobots.txt、プライバシー法を守って収集する限り、一般的には合法です。ログインが必要なページや個人情報の無断取得、サーバーへの過度な負荷は避けましょう。

웹 스크래퍼でビジネスを加速させたい人は、して、Python不要でウェブを“使えるデータ”に変えてみてください。