ウェブ上には、入力フォームやダッシュボード、データ整理など、手間がかかる作業が山ほどありますよね。僕も「このサイト、毎回手作業でやるのはもうしんどい…もっとラクなやり方ないの?」と何度も思ったことがあります。きっと同じように感じている人も多いはず。2024年には、PythonがGitHubでJavaScriptを抜いて一番人気の言語になり、Pythonエンジニアの約4人に1人が自動化やウェブスクレイピングに活用しているんです(、)。その理由は、Pythonならプログラミング経験が浅くても、ウェブサイトの自動操作が現実的に、しかも簡単にできるからなんです。

この記事では、python ウェブサイト自動化・python ウェブタスク自動化をテーマに、Pythonでウェブサイト操作を効率よく自動化する方法を分かりやすく解説します。なぜPythonが選ばれるのか、環境構築の手順、Seleniumを使ったフォーム入力やサイト操作のコツ、さらにAI搭載ツールを使った高度な自動化まで、実践的なノウハウをまとめました。単調な作業にうんざりしているビジネスユーザーも、業務効率化を目指すエンジニアも、すぐに使える手順やコード例、僕自身の経験から得たポイントを紹介します。

なぜPythonでウェブサイト操作を自動化するのか?

「なんでPythonなの?」という疑問、よく聞きます。僕や開発仲間の実感をまとめると、Pythonは自動化の“万能ツール”なんです。その理由は…

- 直感的で分かりやすい: Pythonの文法はシンプルで、初心者でもすぐに理解できます。プログラミング経験が浅くても、Pythonスクリプトなら無理なく書けるし読めます()。

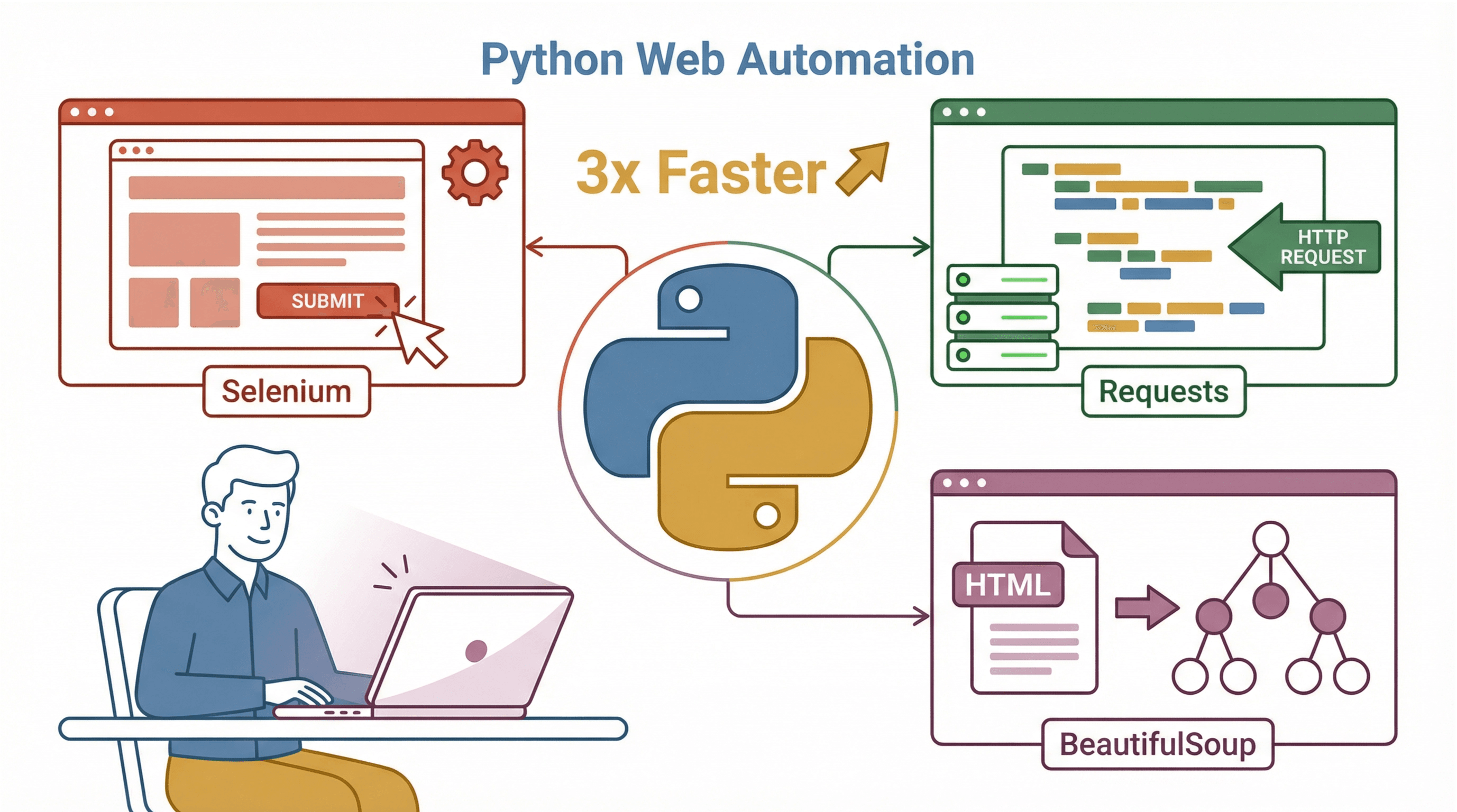

- ライブラリが豊富: ウェブ自動化に便利なライブラリが揃っています。代表的なのは

- Selenium: ブラウザ上で実際のユーザー操作(クリック、入力、ページ遷移など)を自動化

- Requests: ブラウザを使わずにウェブページやAPIへHTTPリクエストを送信

- BeautifulSoup: HTMLやXMLからデータを抽出・解析

- コミュニティが活発: 困ったときはStack Overflowやブログで同じ悩みを解決した人がすぐ見つかります。

- マルチプラットフォーム: Windows、macOS、Linuxどれでもほぼ同じスクリプトが動きます。

JavaやC#と比べても、Pythonなら少ないコードで効率よく自動化できます。JavaScriptもブラウザ自動化に使えますが、Pythonのライブラリやドキュメントの充実度は、ビジネス自動化の現場で特に重宝されています()。

Python自動化環境のセットアップ方法

自動化を始める前に、まずは環境を整えましょう。Windows、macOS、Linuxどれでも、以下の手順でPython自動化環境が作れます。

1. Pythonとpipのインストール

- Windows: からPython 3をダウンロード。インストール時に「Add Python to PATH」にチェックを入れるのを忘れずに。

- macOS: 公式インストーラー、またはHomebrewユーザーなら

brew install python3でOK。 - Linux: ほとんどのディストリビューションでPythonは標準搭載。なければ

sudo apt-get install python3 python3-pipでインストール。

インストールできたか確認するには

1python3 --version

2pip --versionpipが見つからない場合は、別途インストールが必要です(Ubuntuならsudo apt-get install python3-pip)。

2. Seleniumなど必要なパッケージのインストール

Pythonとpipが使えるようになったら、必要なライブラリをインストールします。

1pip install selenium requests beautifulsoup4- Selenium: ブラウザ自動操作用

- Requests: HTTPリクエスト用

- BeautifulSoup: HTML解析用

3. Selenium用WebDriverのダウンロード

SeleniumはWebDriverを通じてブラウザを操作します。Chromeなら、Firefoxならをダウンロード。

- ドライバをシステムのPATHに置くか、スクリプト内でパスを指定します。

1from selenium import webdriver

2driver = webdriver.Chrome(executable_path="/path/to/chromedriver")新しいSeleniumでは、PATHにあれば自動で見つけてくれることも多いです。

4. 仮想環境の構築

venvやvirtualenvなどの仮想環境を使うことで、プロジェクトごとに依存関係を分けて、バージョンの衝突を防げます()。

仮想環境の作成と有効化は

1python3 -m venv myenv

2source myenv/bin/activate # Windowsの場合: myenv\Scripts\activateこの状態でpip installすれば、他のプロジェクトに影響しません。

5. OSごとの注意点・トラブル対策

- Windows:

pythonやpipが認識されない場合は、PATH設定やpyランチャーを確認。 - macOS: システムPythonと区別するため

python3を使いましょう。 - Linux: サーバーなどGUIがない場合は、SeleniumのヘッドレスモードやXvfbの利用を検討。

ドライバのバージョンやパッケージの不整合でエラーが出た場合は、互換性を再確認し、必要に応じてアップデートしましょう。

Seleniumでフォーム入力やサイト操作を自動化する

ここからが本番です。Seleniumを使えば、ログインや複数ステップの作業も自動化できます。

ブラウザを開いてページを表示

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://example.com/login")これでChromeが起動し、ログインページが開きます。

要素の取得と操作

Seleniumでは、IDやname、CSSセレクタ、XPathなどで要素を取得できます。

1username_box = driver.find_element(By.ID, "username")

2password_box = driver.find_element(By.NAME, "pwd")

3login_button = driver.find_element(By.XPATH, "//button[@type='submit']")- テキスト入力:

username_box.send_keys("alice") - ボタンをクリック:

login_button.click() - ドロップダウン選択:

1from selenium.webdriver.support.ui import Select

2select_elem = Select(driver.find_element(By.ID, "country"))

3select_elem.select_by_visible_text("Canada")- 別ページへ遷移:

driver.get("https://example.com/profile")

要素選択のベストプラクティス

- IDや一意な属性を優先して安定性を確保

- CSSセレクタで簡潔に指定

- 絶対パスのXPathは避ける(ページ構造が変わると壊れやすい)()

動的コンテンツや待機処理への対応

最近のウェブサイトは非同期で要素を読み込むことが多いです。要素が表示される前に操作しようとするとエラーになるので、明示的な待機を使いましょう。

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(EC.element_to_be_clickable((By.ID, "loginBtn")))これで最大10秒間、ログインボタンがクリック可能になるまで待機します。time.sleep()よりも明示的な待機の方が賢くて安定します()。

実例:複数ステップのウェブフォーム自動化

2段階のサインアップフォームを自動化してみましょう(デモサイトを使用)。

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.support.ui import WebDriverWait

4from selenium.webdriver.support import expected_conditions as EC

5driver = webdriver.Chrome()

6driver.get("https://practicetestautomation.com/Practice-Signup")

7# Step 1: 最初のフォーム入力

8driver.find_element(By.ID, "name").send_keys("Alice")

9driver.find_element(By.ID, "email").send_keys("alice@example.com")

10driver.find_element(By.ID, "password").send_keys("SuperSecret123")

11driver.find_element(By.ID, "nextBtn").click()

12# Step 2: 次のフォームが表示されるまで待機し、入力

13driver.find_element(By.ID, "address").send_keys("123 Maple St")

14driver.find_element(By.ID, "phone").send_keys("5551234567")

15driver.find_element(By.ID, "submitBtn").click()

16# Step 3: 完了メッセージを確認

17WebDriverWait(driver, 5).until(EC.text_to_be_present_in_element((By.TAG_NAME, "h1"), "Welcome"))

18print("サインアップ成功!")

19driver.quit()このように、各ステップで待機と入力を組み合わせることで、安定した自動化が実現できます。

Thunderbit:AIで複雑なウェブ操作も自動化

「コードを書かずに複雑なサイトを自動化したい」「PDFや画像からもデータを抽出したい」そんな人におすすめなのがです。

Thunderbitは、AIウェブスクレイパーのChrome拡張機能で、クリック操作だけでデータ抽出やウェブ操作を自動化できます。特にビジネスユーザーにとって画期的な理由は…

- 自然言語で指示できる: 「商品名、価格、評価」など、欲しい情報を日本語や英語で伝えるだけでAIが自動で抽出方法を判断()。

- サブページも自動巡回: 商品ごとの詳細ページも自動で訪問し、データをまとめて取得。

- 即時テンプレート: AmazonやZillowなど有名サイトはワンクリックでテンプレート利用可能。

- PDFや画像にも対応: Pythonなら追加ライブラリが必要なPDFや画像からのテキスト抽出も、Thunderbitなら簡単。

- 定期実行もOK: 「毎週月曜9時に」など、自然な言葉でスケジュール設定。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notion、CSV、JSONなどに無料で出力。

Thunderbitは、非構造化データを整理したい時や、非エンジニアのチームメンバーにも自動化を広げたい時に特に力を発揮します。まるでAIのリサーチアシスタントが、面倒な作業を黙々とこなしてくれる感覚です。

ThunderbitとPythonスクリプトの使い分け

-

Python(Selenium/Requests/BeautifulSoup)を使うべき場合:

- 独自ロジックや他システム連携、細かい制御が必要な時

- ウェブスクレイピング以外にもデータ分析やAPI連携など複雑な処理を含む場合

- コード管理やバージョン管理を重視したい場合

-

Thunderbitを使うべき場合:

- コード不要で素早くデータ抽出や定型作業を自動化したい時

- 複雑で非構造的なサイトやPDF・画像データを扱う時

- 非エンジニアの方や、頻繁な一括データ取得を効率化したい時

僕も実際、用途によって両方を使い分けています。Thunderbitは営業やオペレーションチームの即戦力、Pythonはカスタマイズ性重視の業務に最適です。

Python自動化スクリプトの安定性・信頼性を高めるコツ

自動化は「安定して動く」ことが一番大事。僕が実践しているポイントを紹介します。

エラーハンドリングとリトライ処理

不安定な操作はtry/exceptで囲みましょう。

1try:

2 element = driver.find_element(By.ID, "price")

3except Exception as e:

4 print("価格要素の取得エラー:", e)

5 driver.save_screenshot("screenshot_error.png")

6 # 必要に応じてリトライやスキップネットワークエラーや一時的な失敗にはリトライ処理を。

1import time

2max_retries = 3

3for attempt in range(max_retries):

4 try:

5 driver.get(url)

6 break

7 except Exception as e:

8 print(f"{attempt+1}回目の試行に失敗、再試行します…")

9 time.sleep(5)明示的な待機を徹底

要素の準備ができるまで必ず明示的な待機を。

1WebDriverWait(driver, 10).until(EC.element_to_be_clickable((By.CLASS_NAME, "result"))).click()ログ出力と監視

長時間動かす場合はloggingモジュールで進捗やエラーを記録。重大なエラーはメールやSlack通知も有効。失敗時のスクリーンショットも必須です。

リソース管理

スクリプト終了時は必ずdriver.quit()でブラウザを閉じましょう。

サーバーへの配慮

大量ページをスクレイピングする場合は、time.sleep(random.uniform(1,3))でランダムな待機を入れ、robots.txtを守りましょう。

サイト変更への対応

ウェブサイトは日々変化します。将来の変更に備えて

- 柔軟なセレクタ(安定した属性や

data-*属性)を優先 - セレクタはスクリプト冒頭にまとめて管理

- 定期的なテストで早期に不具合を発見

- Gitなどでバージョン管理

社内ツールの場合は、開発チームに自動化用の安定した属性(例:data-automation-id)を追加してもらうのも有効です。

Python自動化ツール比較:Selenium、Requests、BeautifulSoup、Thunderbit

用途に応じたツール選びの参考に、主な自動化ツールを比較します。

| ツール | 強み・主な用途 | 制約・注意点 |

|---|---|---|

| Selenium (WebDriver) | 本格的なブラウザ自動操作。動的JS対応。実際のユーザー操作を再現。複数ステップの業務に最適 | 動作が重くなりがち。ドライバ設定が必要。セレクタが脆弱だと壊れやすい |

| Requests + BeautifulSoup | 静的ページやAPIの大量データ取得に高速・軽量。HTML解析が簡単。JS不要な場合に最適 | 動的JSやユーザー操作は不可。パースロジックは手動で実装が必要 |

| Thunderbit | ノーコード・AI駆動。複雑/非構造サイトやPDF・画像も対応。サブページ巡回、即時テンプレート、無料エクスポート。非エンジニアも使える | カスタムロジックには不向き。外部サービス依存。AIの初期提案は微調整が必要な場合も |

(、)

実践ステップ:Pythonでウェブ操作を自動化する流れ

僕が普段使っている自動化チェックリストを紹介します。

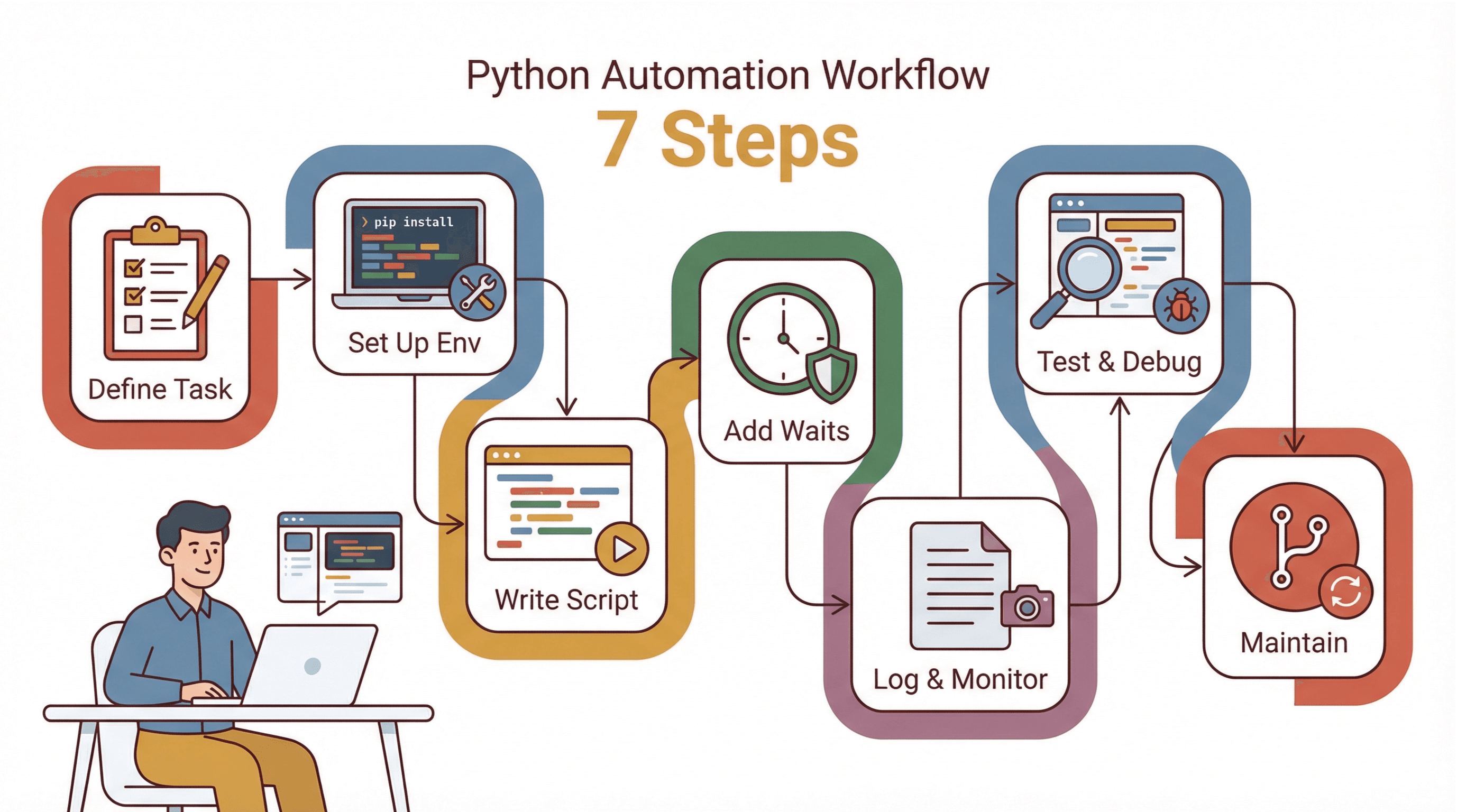

- 作業内容を明確化: 手作業での手順を書き出し、ログインやポップアップ、動的要素など注意点を洗い出す。

- 環境構築: Python、pip、仮想環境、Selenium、WebDriverをセットアップ。

- スクリプトを段階的に作成: まずはページ遷移だけ、次に入力やクリック…と少しずつ追加し、都度テスト。

- 待機・エラー処理を追加: 明示的な待機やtry/exceptで安定性を強化。

- ログ・監視を実装: 進捗やエラーを記録し、失敗時はスクリーンショットも保存。

- テスト・デバッグ: ブラウザの開発者ツールでセレクタ確認。可視モードで予期せぬポップアップやリダイレクトもチェック。

- 保守・更新: セレクタは冒頭にまとめ、バージョン管理し、定期的に見直す。

初めての人は、まずはテストサイトへのログインや簡単なフォーム入力から始めるのがおすすめ。小さな成功体験を積み重ねていきましょう。

まとめ・ポイント

python ウェブサイト自動化・python ウェブタスク自動化は、日々の作業を劇的に効率化できる強力な手段です。シンプルなフォーム入力から複雑な業務フローまで、Pythonの分かりやすい文法と豊富なライブラリで幅広く対応できます。コミュニティも活発で、情報も豊富。1日15分の時短でも、1年で約90時間の節約になります()。

ただし、複雑なサイトや非エンジニアの自動化には、AI搭載ののようなツールもかなり便利。数クリックでデータ抽出やウェブ操作ができるので、チーム全体の生産性アップにもつながります。

まずは、日常的に「面倒だな」と感じているウェブ作業を1つ選んで、PythonやThunderbitで自動化にチャレンジしてみてください。「またこの作業か…」が「数秒で完了!」に変わる感動をぜひ体験してみてください。

さらに詳しいウェブスクレイピングのノウハウはでも紹介しています。

よくある質問(FAQ)

1. なぜPythonはウェブサイト自動化で人気なの?

Pythonは文法が分かりやすく、SeleniumやRequests、BeautifulSoupなど自動化向けのライブラリが豊富で、コミュニティも活発だから、ウェブ自動化やスクリプト作成に最適です()。

2. Selenium、Requests、BeautifulSoupの違いは?

Seleniumは動的サイトやユーザー操作の自動化、Requestsは静的ページやAPIの取得、BeautifulSoupはHTML解析に使います。用途に応じて組み合わせて使います。

3. Thunderbitはどんな時にPythonスクリプトよりおすすめ?

Thunderbitは、ノーコードでAIによるデータ抽出や、PDF・画像対応、非エンジニアの自動化に最適。カスタムロジックや高度な連携が必要な場合はPythonスクリプトが向いています。

4. Python自動化スクリプトを安定稼働させるコツは?

明示的な待機、try/exceptによるエラー処理、ネットワーク障害時のリトライ、ログ出力、セレクタの一元管理・定期更新がポイントです。

5. ThunderbitとPythonを組み合わせて使える?

もちろんOK。Thunderbitで素早くデータ抽出し、Pythonで分析や加工を行う、またはPythonで複雑な処理、Thunderbitでノーコードスクレイピングなど、用途に応じて併用できます。

ウェブ業務の自動化に挑戦したい人は、を試すか、Pythonスクリプト作成にチャレンジしてみてください。どちらも、すぐに「賢く働く」実感が得られるはずです。

さらに学ぶ