多くのエンジニアがウェブスクレイピングに初めて挑戦するきっかけは、「競合サイトの商品情報を集めてみたい」といった素朴な興味から始まることが多いですよね。BeautifulSoupのようなツールは検索ですぐ見つかりますが、最初は「難しそう…」と感じる人も少なくありません。何度か試して pip install beautifulsoup4 を実行し、HTMLの見出しなどを抜き出せた瞬間、「やった!」と嬉しくなるのは、Python初心者なら誰もが通る道です。こうした体験が、ウェブスクレイピングの世界への第一歩になることも多いです。

もしあなたがウェブスクレイピングを始めたばかりなら、まず耳にするのがBeautifulSoupでしょう。その理由はとてもシンプルで、使いやすくてパワフル、しかも10年以上Python界隈で定番として愛されてきたからです。この記事では、pipでのBeautifulSoupインストール方法から、実際のPythonコード例、そして今も多くの開発者やデータ分析担当者に選ばれている理由まで、分かりやすく解説します。また、BeautifulSoupの苦手な部分や、最近多くのチーム(特に非エンジニア層)がAI搭載ののようなツールに移行している背景についても、正直にお伝えします。

BeautifulSoupとは?なぜ今も選ばれ続けているのか

まずは基本から。BeautifulSoupとは何か?ざっくり言うと、Python用のとても扱いやすい「HTMLパーサー」です。HTMLやXMLのデータを渡すと、Pythonコードで簡単に検索・抽出・操作できるツリー構造に変換してくれます。ウェブページの中身を“見える化”して、複雑なタグや属性も自在にデータとして扱えるようになります。

BeautifulSoupが今も人気な理由

新しいスクレイピングフレームワークが次々登場しても、BeautifulSoupはPython初心者の定番ツールであり続けています。実際、PyPIではもダウンロードされていて、Stack Overflowでもが投稿されています。つまり、初心者でも安心して使える大きなコミュニティと情報量があるんです。

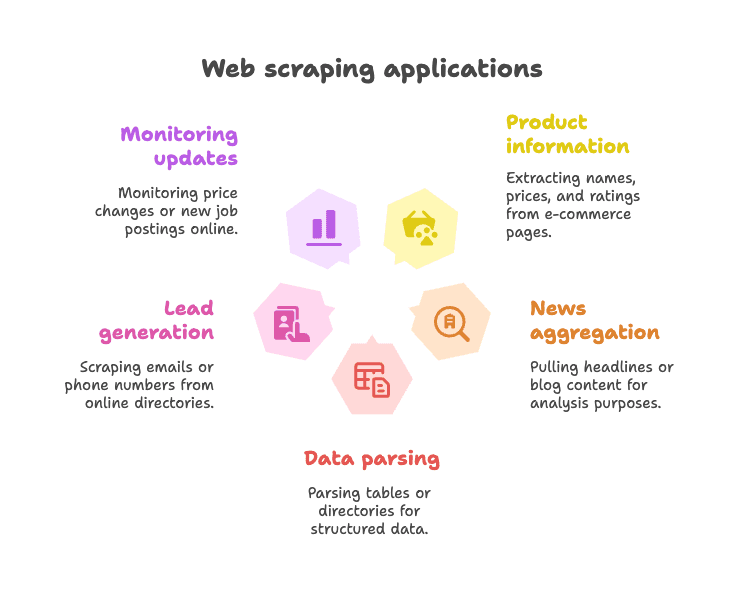

主な活用例:

- ECサイトの商品情報抽出(商品名・価格・評価など)

- ニュースやブログの見出し収集・分析

- テーブルやディレクトリの構造化データ抽出(例:企業リスト)

- リード獲得(メールアドレスや電話番号の抽出)

- 価格変動や新着情報の監視

BeautifulSoupは特に、HTML内にデータがそのまま記載されている「静的なウェブページ」のスクレイピングに最適です。HTMLが多少崩れていても柔軟に動作するので、2025年になってもPythonでスクレイピングを始める人の“最初の一歩”として選ばれ続けているのも納得です()。

pipでBeautifulSoupをインストールする方法

pipって何?なぜ使うの?

Python初心者の方へ。pipはPythonのパッケージ管理ツールで、PyPI(Python Package Index)からライブラリを簡単にインストールできます。いわばPythonの“アプリストア”のようなもの。pipを使えば、BeautifulSoupの導入も一瞬です。

ワンポイント:正しいパッケージ名は「beautifulsoup4」です(「beautifulsoup」ではありません)。必ず「4」を付けて最新版をインストールしましょう。

ステップバイステップ:BeautifulSoupのインストール

1. Pythonのバージョン確認

BeautifulSoupはPython 3.7以上が必要です。ターミナルで以下を実行:

1python --versionまたは

1python3 --version2. pipでBeautifulSoup4をインストール

ターミナルやコマンドプロンプトで:

1pip install beautifulsoup4複数のPythonバージョンがある場合は:

1pip3 install beautifulsoup4Windowsの場合:

1py -m pip install beautifulsoup43. (推奨)パーサーの追加インストール

BeautifulSoupは標準の"html.parser"でも動きますが、より高速・高精度にしたい場合はlxmlやhtml5libもインストールしましょう:

1pip install lxml html5lib4. (推奨)Requestsのインストール

BeautifulSoup自体はHTMLの解析専用で、ウェブページの取得は行いません。多くの人はライブラリを併用します:

1pip install requests5. インストール確認

Pythonで以下を試してみましょう:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)<title>Example Domain</title>と表示されればOKです。

仮想環境でBeautifulSoupをインストールする

Pythonプロジェクトではの利用がとてもおすすめです。依存関係が整理され、他のプロジェクトと干渉しません。

仮想環境の作成方法:

1python -m venv venv

2# Windowsの場合:

3venv\Scripts\activate

4# macOS/Linuxの場合:

5source venv/bin/activate

6pip install beautifulsoup4 requests lxml html5libこれでインストールしたパッケージはこのプロジェクト内だけで有効になります。「パッケージが見つからない」などのトラブルも減ります。

その他のインストール方法(Condaなど)

を使っている場合は:

1conda install beautifulsoup4パーサーも同様に:

1conda install lxml事前にconda環境をアクティベートしておきましょう。

BeautifulSoup Python:基本的な使い方とコード例

実際にBeautifulSoupを使ったPythonスクリプト例を見てみましょう。

例1:ウェブページを取得してタイトルを抽出

1from bs4 import BeautifulSoup

2import requests

3url = "https://en.wikipedia.org/wiki/Python_(programming_language)"

4response = requests.get(url)

5soup = BeautifulSoup(response.content, "html.parser")

6# ページタイトルを取得

7title_text = soup.title.string

8print("Page title:", title_text)WikipediaのPythonページを取得し、タイトルを表示します。とてもシンプルです。

例2:すべてのリンクを抽出

1links = soup.find_all('a')

2for link in links[:10]: # 最初の10件を表示

3 href = link.get('href')

4 text = link.get_text()

5 print(f"{text}: {href}")ページ内の最初の10個のリンクテキストとURLを表示します。

例3:見出し(h2)を抽出

1headings = soup.find_all('h2')

2for h in headings:

3 print(h.get_text().strip())<h2>タグの見出しをすべて取得できます。

例4:CSSセレクタを使う

1items = soup.select("ul.menu > li")

2for item in items:

3 print(item.get_text())select()メソッドでCSSセレクタが使えます。

例5:属性やネストしたタグの取得

1first_link = soup.find('a')

2print(first_link['href']) # 直接アクセス(無いとエラー)

3print(first_link.get('href')) # 安全なアクセス(無い場合None)例6:ページ内の全テキストを取得

1text_content = soup.get_text()

2print(text_content)ページ全体のテキストを一括取得できます。簡易分析などに便利です。

BeautifulSoupでよく使う基本操作

-

単一要素の取得:

soup.find('div', class_='price') -

複数要素の取得:

soup.find_all('p', class_='description') -

テキストの取得:

element.get_text() -

属性値の取得:

element.get('href') -

CSSセレクタの利用:

soup.select('table.data > tr') -

要素が無い場合の処理:

1price = soup.find('span', class_='price') 2if price: 3 print(price.get_text())

BeautifulSoupの構文は直感的で、HTMLが多少崩れていても柔軟に対応できます()。

BeautifulSoupの限界と現代のウェブスクレイピング事情

ここでBeautifulSoupの弱点についても触れておきます。静的ページや小規模な用途には最適ですが、万能ではありません。

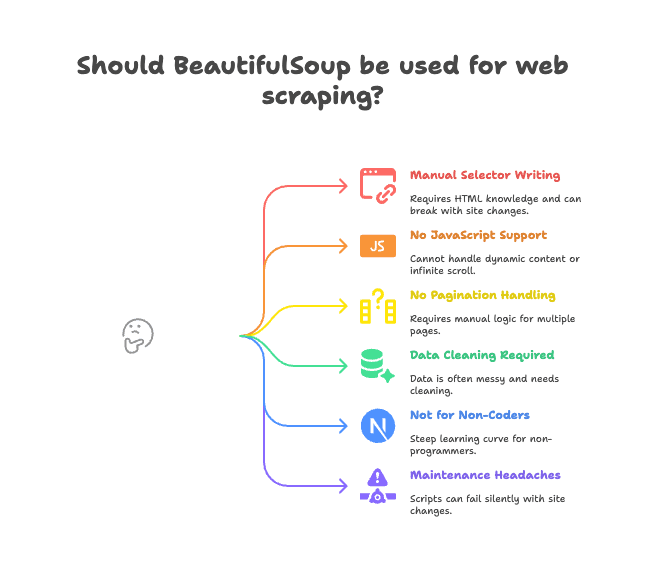

主な課題点:

- セレクタの手動記述が必要: HTML構造を自分で調べてタグやクラスを指定する必要があり、サイト構造が変わるとスクリプトが動かなくなります。

- JavaScript対応不可: BeautifulSoupはサーバーから送られてきたHTMLしか見えません。JavaScriptで動的に生成されるデータ(無限スクロールや動的コンテンツ)は取得できません()。

- ページ送りや詳細ページの自動処理がない: 複数ページや詳細ページを巡回したい場合、すべて自分でロジックを書く必要があります。

- データの整形が必要: 取得したデータは空白や特殊文字、フォーマットのばらつきが多く、後処理が必須です。

- 非エンジニアには難しい: コードが書けない営業・マーケ・事務職の方にはハードルが高いです。

- メンテナンスが大変: サイト構造が変わるとスクリプトが壊れたり、データが抜け落ちたりします。

こうした「ちょっとした」課題が積み重なり、実際の業務では生産性のボトルネックになることも少なくありません。私自身も、スクレイピングスクリプトの修正に追われてプロジェクトが止まってしまう現場を何度も見てきました。

いま多くのチームがThunderbitに乗り換える理由

では、代替手段は?ここで登場するのがです。ThunderbitはPythonライブラリではなく、Chrome拡張機能として動作するAI搭載のウェブデータ抽出アシスタントです。

使い方はとても簡単:

- 抽出したいウェブサイトを開く

- 「AIフィールド提案」をクリックすると、ThunderbitのAIがページを解析し、「商品名」「価格」「所在地」など適切なカラムを自動で提案

- 必要に応じてカラム名や型を調整

- 「スクレイプ」ボタンを押すだけで、データを自動で抽出・整形

- Excel、Googleスプレッドシート、Notion、Airtableなどにワンクリックでエクスポート

コード不要。セレクタ不要。メンテナンスの手間もありません。

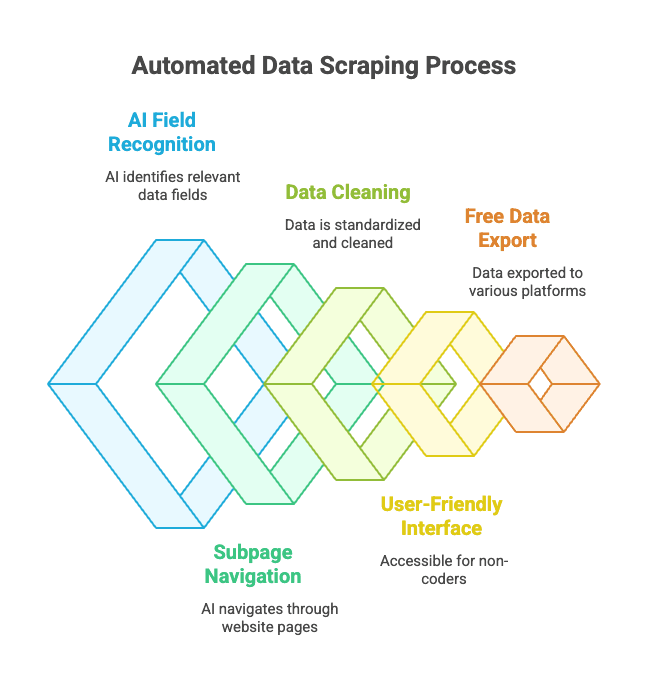

Thunderbitの主な特長:

- AIによるフィールド自動認識: HTMLが複雑でも、AIが欲しいデータを自動で見つけてくれます。

- サブページ・ページ送り対応: 商品詳細ページや「次へ」リンクも自動で巡回可能。

- データの自動整形: 電話番号・メール・画像なども標準化。

- 非エンジニアでも使いやすい: ブラウザ操作ができれば誰でもOK。

- 無料エクスポート: ExcelやGoogleスプレッドシート、Airtable、Notionなどに無料で出力。

- 定期スクレイピング: スケジュール設定で自動実行も可能。

ビジネスユーザーにとって、ウェブデータ抽出の常識が変わる体験です。Pythonスクリプトを組む必要はなく、クリックだけで欲しいデータが手に入ります。

ThunderbitとBeautifulSoupの比較:どちらが自分に合う?

違いをまとめると:

| 機能 | BeautifulSoup(Pythonコーディング) | Thunderbit(ノーコードAI) |

|---|---|---|

| セットアップ | Python・pip・コードが必要 | Chrome拡張、2クリックで開始 |

| データ取得までの速さ | 最初のスクリプト作成に数時間 | サイトごとに数分 |

| JavaScript対応 | 不可(追加ツール必要) | 可能(ブラウザ上で動作) |

| ページ送り・サブページ | 手動でコード記述 | 標準搭載、ワンタッチ切替 |

| データ整形 | 手動でコード記述 | AIが自動で整形 |

| エクスポート方法 | CSV/Excel出力は自作 | SheetsやNotion等にワンクリック |

| おすすめ対象 | 開発者・技術好き | ビジネスユーザー・非エンジニア |

| コスト | 無料(ただし時間が必要) | フリーミアム(小規模は無料) |

BeautifulSoupが向いている人:

- Pythonに慣れていて細かく制御したい

- 静的なサイトや独自ロジックが必要な場合

- 大規模なPythonワークフローに組み込みたい

Thunderbitが向いている人:

- コード不要ですぐに結果が欲しい

- JavaScriptで動的に生成されるサイトを扱いたい

- 営業・マーケ・事務など非エンジニア

- データをそのまま業務ツールに出力したい

正直、私自身も開発者ですが、ちょっとしたデータ抽出ならThunderbitを使うことが増えています。ブラウザだけで完結するのは本当に便利です。

BeautifulSoupのインストール・活用のコツ

BeautifulSoupを使う場合、以下のポイントを押さえておくと安心です:

- 必ず仮想環境を使う: 依存関係が整理され、環境トラブルを防げます。

- pipやパッケージは常に最新に:

pip install --upgrade pipやpip list --outdatedで定期的に更新。 - 推奨パーサーもインストール:

pip install lxml html5libでパフォーマンス向上。 - コードは分割して書く: 取得処理と解析処理を分けるとデバッグしやすい。

- robots.txtやアクセス頻度に配慮: サイトに負荷をかけないよう

time.sleep()で間隔を空ける。 - 安定したセレクタを使う: すぐ壊れる詳細なパスは避ける。

- HTMLを保存してテスト: オフラインで解析テストすると効率的。

- コミュニティを活用: で疑問を解決。

BeautifulSoupインストール時のトラブルシューティング

うまくいかない場合は以下をチェック:

- 「ModuleNotFoundError: No module named bs4」

- 正しい環境で

beautifulsoup4をインストールしたか確認。python -m pip install beautifulsoup4を試す。

- 正しい環境で

- 間違ったパッケージ(beautifulsoup)をインストールした

- 古いものをアンインストール:

pip uninstall beautifulsoup - 正しいものをインストール:

pip install beautifulsoup4

- 古いものをアンインストール:

- パーサーやUnicodeの警告

lxmlやhtml5libをインストールし、パーサーを指定:BeautifulSoup(html, "lxml")

- 要素が見つからない

- データがJavaScriptで生成されていないか確認。BeautifulSoupはHTMLソースしか見えません。

- pipのエラーや権限問題

- 仮想環境を使うか、

pip install --user beautifulsoup4を試す。 - pipをアップグレード:

pip install --upgrade pip

- 仮想環境を使うか、

- Condaの問題

conda install beautifulsoup4を試すか、conda環境内でpipを使う。

それでも解決しない場合は、やStack Overflowでほとんどのケースがカバーされています。

まとめ:BeautifulSoupインストール&活用のポイント

-

BeautifulSoupはPythonで最も人気のウェブスクレイピングライブラリ。シンプルで柔軟、初心者にも最適。

-

pipでインストール:

1pip install beautifulsoup4 lxml html5lib requests -

仮想環境を使って環境をクリーンに保つ

-

静的ページや小規模用途には最適だが、JavaScriptやページ送り、メンテナンスには弱い

-

Thunderbitはビジネスユーザーや非エンジニア向けの最新AIツール。コード不要、手間なし、すぐデータ取得

-

自分に合ったツールを選ぼう:

- 開発者や技術好き:BeautifulSoupで細かく制御

- ビジネスユーザーやチーム: ですぐに結果

両方試してみて、「一番ラクに目的を達成できる方法」を選ぶのがベストです。

よくある質問:pipでBeautifulSoupをインストールするには?

Q: beautifulsoupとbeautifulsoup4の違いは?

A: 必ずbeautifulsoup4をインストールしてください。これが最新でサポートされているバージョンです。古いbeautifulsoupはPython3非対応で、from bs4 import BeautifulSoupと記述します()。

Q: lxmlやhtml5libは必須?

A: 必須ではありませんが、パース速度や安定性が大きく向上するので強く推奨します。pip install lxml html5libでインストールできます()。

Q: BeautifulSoupでJavaScript生成のサイトは扱える?

A: いいえ。BeautifulSoupは静的HTMLのみ対応です。JavaScriptで生成されるデータは、Seleniumなどのブラウザ自動化ツールや、のようなAI搭載ブラウザツールを使いましょう()。

Q: BeautifulSoupのアンインストール方法は?

A: ターミナルでpip uninstall beautifulsoup4を実行してください()。

Q: Thunderbitは無料で使える?

A: Thunderbitはフリーミアムモデルで、小規模な用途なら無料で利用できます。ブラウザからすぐに試せます()。

BeautifulSoupとThunderbitの実際の使い勝手を比較したい方は、もご覧ください。さらにウェブスクレイピングの基礎や、、も参考にどうぞ。

スクレイピングを楽しんでください!Pythonのプロでも、スプレッドシートにデータをまとめたいだけの方でも、あなたに合ったツールとコミュニティがきっと見つかります。