2026年のウェブは、まさに混沌とした世界になっています。今やネットのトラフィックの半分はボットが占めていて、オープンソースのウェブクローラーは価格チェックからAIの学習データ集めまで、あらゆるシーンで縁の下の力持ちとして活躍中です。SaaSや自動化の現場で長年やってきた自分が断言できるのは、「最適なセルフホスト型ウェブクローラーを選ぶことが、チームの負担やトラブルを大幅に減らす近道」ということ。数ページだけのスクレイピングから、何百万URLの大規模クロールまで、このリストにあるFirecrawlのオープンソース代替ツールなら、規模や技術スタック、運用の複雑さに関係なくしっかり対応できます。

ただし、どんな現場にも万能なツールはありません。Scrapyのような圧倒的なパワーやHeritrixのアーカイブ機能が必要なチームもあれば、オープンソースの保守コストが重荷になる場合もあります。そこで、2026年におすすめしたいFirecrawlのオープンソース代替ツール9選を、用途ごとに分かりやすく紹介します。あなたのビジネスにぴったりのツール選びを、無駄な遠回りなしでサポートします。

Firecrawlのオープンソース代替を選ぶコツ

リストに入る前に、まずは戦略を整理しましょう。オープンソースのウェブクローラーはどんどん多様化していて、選択肢も豊富です。選ぶときは、以下のポイントを意識してみてください:

- 使いやすさ:ノーコードのUIがいいのか、それともPythonやGo、JavaScriptで開発できる人がいるか?

- スケーラビリティ:1サイトだけで十分か、数百万ページ・複数ドメインをクロールしたいのか?

- 対応コンテンツ:静的HTMLだけでOKか、JavaScriptで動的に生成されるサイトも必要か?

- 連携ニーズ:データをExcelに出したい?DBや分析基盤に流したい?

- 保守性:独自コードのメンテができるか、サイト構造の変化に自動で対応したいか?

迷ったときの早見表はこちら:

| シナリオ | 最適ツール |

|---|---|

| ノーコード・オフライン閲覧 | HTTrack |

| 大規模・複数ドメインクロール | Scrapy, Apache Nutch, StormCrawler |

| 動的/JS多用サイト | Puppeteer |

| フォーム自動化/ログイン必須 | MechanicalSoup |

| 静的サイトのダウンロード/アーカイブ | Wget, HTTrack, Heritrix |

| Go開発者・高パフォーマンス | Colly |

それでは、2026年注目のFirecrawlオープンソース代替ツール9選を詳しく見ていきましょう。

1. Scrapy:大規模Pythonクローリングに最適

は、オープンソースウェブクローラーの定番。Python製で、数百万ページ規模のクロールや複雑なサイト構造にも対応できる、開発者向けの強力なフレームワークです。

Scrapyの強み

- 大規模対応:1秒間に数千リクエストも可能。大手企業も月間数十億ページのクロールに利用()。

- 拡張性・モジュール性:独自スパイダーやプロキシ、ログイン処理、出力形式(JSON/CSV/DB)も柔軟にカスタマイズ。

- 活発なコミュニティ:プラグインやドキュメント、Q&Aも豊富。

- 実績多数:EC、ニュース、研究分野など世界中で本番運用。

注意点:非エンジニアには学習コストが高め。サイト構造が変わるたびにスパイダーの保守が必要ですが、自由度とスケール重視なら最有力です。

2. Apache Nutch:エンタープライズ向け検索エンジン構築に

は、インターネット規模のクロールを想定した老舗オープンソースクローラー。自社検索エンジンや大規模データ収集に最適です。

Apache Nutchの強み

- Hadoop連携で大規模対応:Hadoop基盤で数十億ページを分散クロール()。

- バッチクロール:シードURLを投入して定期的に大規模クロールが可能。

- 連携性:SolrやElasticsearchなどビッグデータ基盤と統合。

注意点:HadoopやJavaのセットアップが複雑。構造化データ抽出よりも「大量クロール」に特化。小規模用途にはオーバースペックですが、規模重視なら最強です。

3. Heritrix:ウェブアーカイブ・法令対応に最適

は、Internet Archive公式のクローラー。ウェブアーカイブやデジタル保存に特化しています。

Heritrixの強み

- アーカイブ品質:ページ・画像・リンクを丸ごと保存。法令遵守や歴史的スナップショットに最適。

- WARC形式出力:標準化されたWeb ARChiveファイルで保存・再生・分析が容易。

- ウェブUI管理:ブラウザからクロール設定・監視が可能。

注意点:ディスク・メモリ消費が大きい。JavaScript実行不可、構造化データ抽出には不向き。図書館やアーカイブ、規制業界向け。

4. Colly:Go開発者向け・高速クローリング

は、Go言語で開発された軽量・高速なウェブスクレイパー。Go開発者に人気です。

Collyの強み

- 圧倒的な高速性:Goの並列処理で数千ページを低リソースでクロール()。

- シンプルなAPI:HTML要素ごとにコールバック定義、Cookieやrobots.txtも自動処理。

- 静的サイトに最適:APIやサーバーレンダリングページ、Goバックエンドとの統合にも便利。

注意点:JavaScriptレンダリング非対応(動的サイトはChromedp等と併用推奨)。Goの知識が必要。

5. MechanicalSoup:フォーム自動化・シンプルな認証突破に

は、PythonでHTTPリクエストと簡易ブラウザ操作の中間を担うライブラリ。

MechanicalSoupの強み

- フォーム自動化:ログインやフォーム送信、セッション維持が簡単。認証後のデータ取得に最適。

- 軽量設計:RequestsとBeautifulSoupベースでセットアップも手軽。

- インタラクティブサイト向け:検索フォーム送信やログイン後のデータ取得に便利()。

注意点:JavaScript実行不可。静的・サーバーレンダリングページや簡単な操作向け。

6. Puppeteer:動的・JavaScript多用サイトに最適

は、最新のJavaScriptサイトを自在に操作できるNode.jsライブラリ。ヘッドレスChromeを完全制御できます。

Puppeteerの強み

- 動的コンテンツ対応:SPAや無限スクロール、AJAXで読み込まれるデータも取得可能()。

- ユーザー操作の自動化:ボタン操作、フォーム入力、スクリーンショット、CAPTCHA対応(プラグイン利用)。

- 強力な自動化:テストや監視、ユーザー視点のスクレイピングに最適。

注意点:リソース消費大(Chromeを実行)、HTTP専用ツールより遅い。大規模運用にはハードウェアやクラウド管理が必要。

7. Wget:コマンドラインで手軽にダウンロード

は、静的サイトやファイルを一括ダウンロードできる定番コマンドラインツール。

Wgetの強み

- シンプル操作:コマンド一発でサイト全体やディレクトリを取得。コーディング不要。

- 高速性:C言語製で動作も軽快。

- 静的コンテンツ向け:ドキュメントサイトやブログ、ファイル一括取得に最適()。

注意点:JavaScriptやフォーム非対応。生データのダウンロード専用。

8. HTTrack:ノーコードでオフライン閲覧

は、WgetのGUI版ともいえるツール。ノーコードでサイトを丸ごとミラーできます。

HTTrackの強み

- GUIで簡単操作:ウィザード形式で非エンジニアでも使いやすい。

- オフライン閲覧:リンクを自動調整し、ローカルでサイトを再現。

- アーカイブ用途に最適:研究者やマーケター、サイトのスナップショット保存に便利()。

注意点:動的コンテンツ非対応。大規模サイトでは遅く、構造化データ抽出には不向き。

9. StormCrawler:リアルタイム分散クロールに

は、リアルタイムかつ分散型の大規模クロールに特化した最新クローラー。ニュース監視や検索エンジン用途に最適です。

StormCrawlerの強み

- リアルタイムクロール:Apache Storm上でストリーム処理。ニュースや検索エンジン向け()。

- モジュール性・拡張性:パースやインデックス、独自処理を柔軟に追加可能。

- Common Crawlでも採用:世界最大級のオープンウェブアーカイブのニュースデータセットを支える。

注意点:Java開発・Stormクラスタ構築が必須。分散システム経験者向け。小規模用途には不向き。

Firecrawlオープンソース代替ツール徹底比較:どれが自分に合う?

9つのツールを横並びで比較します:

| ツール | 最適用途 | 主なメリット | デメリット | 言語/セットアップ |

|---|---|---|---|---|

| Scrapy | 大規模・頻繁なクロール | 強力・拡張性・コミュニティ充実 | 学習コスト高・Python必須 | Pythonフレームワーク |

| Apache Nutch | エンタープライズ・大規模クロール | Hadoop連携・大規模実績 | セットアップ複雑・バッチ処理型 | Java/Hadoop |

| Heritrix | アーカイブ・法令対応クロール | サイト丸ごと保存・WARC出力 | 重い・JS不可・生アーカイブ | Javaアプリ・Web UI |

| Colly | Go開発・高速スクレイピング | 高速・シンプルAPI・並列処理 | JS不可・Go必須 | Goライブラリ |

| MechanicalSoup | フォーム自動化・ログイン取得 | 軽量・セッション管理 | JS不可・大規模不可 | Pythonライブラリ |

| Puppeteer | 動的/JS多用サイト | ブラウザ完全制御・自動化 | リソース消費大・Node.js必須 | Node.jsライブラリ |

| Wget | 静的サイトDL・オフライン閲覧 | シンプル・高速・CLI | JS不可・生データ | コマンドラインツール |

| HTTrack | 非技術者・サイトアーカイブ | GUI・簡単オフライン閲覧 | JS不可・大規模遅い | デスクトップアプリ(GUI) |

| StormCrawler | リアルタイム・分散クロール | スケール・モジュール・リアルタイム | Java/Storm知識必須 | Java/Stormクラスタ |

独自開発か既存オープンソースか?

正直なところ、「自作クローラー」は一見魅力的に見えますが、実際は保守やプロキシ、アンチボット対策で苦労しがち。上記のオープンソースツールは、長年の知見とコミュニティの工夫が詰まっています。業界レポートでも「既存ツールの活用が最速・最も信頼できる方法」とされています()。

- オープンソース採用が向いている場合:既存ツールで要件が満たせる、開発期間を短縮したい、コミュニティサポートを重視したい。

- 独自開発が向いている場合:独自要件が多い、社内に高度な技術者がいる、スクレイピングが事業のコア。

ただし、オープンソースも「無料」ではありません。エンジニア工数やサーバー運用、アンチスクレイピング対策の更新コストは要注意。もし「強力なクローラーの恩恵をコードなしで得たい」なら、もう一つ選択肢があります。

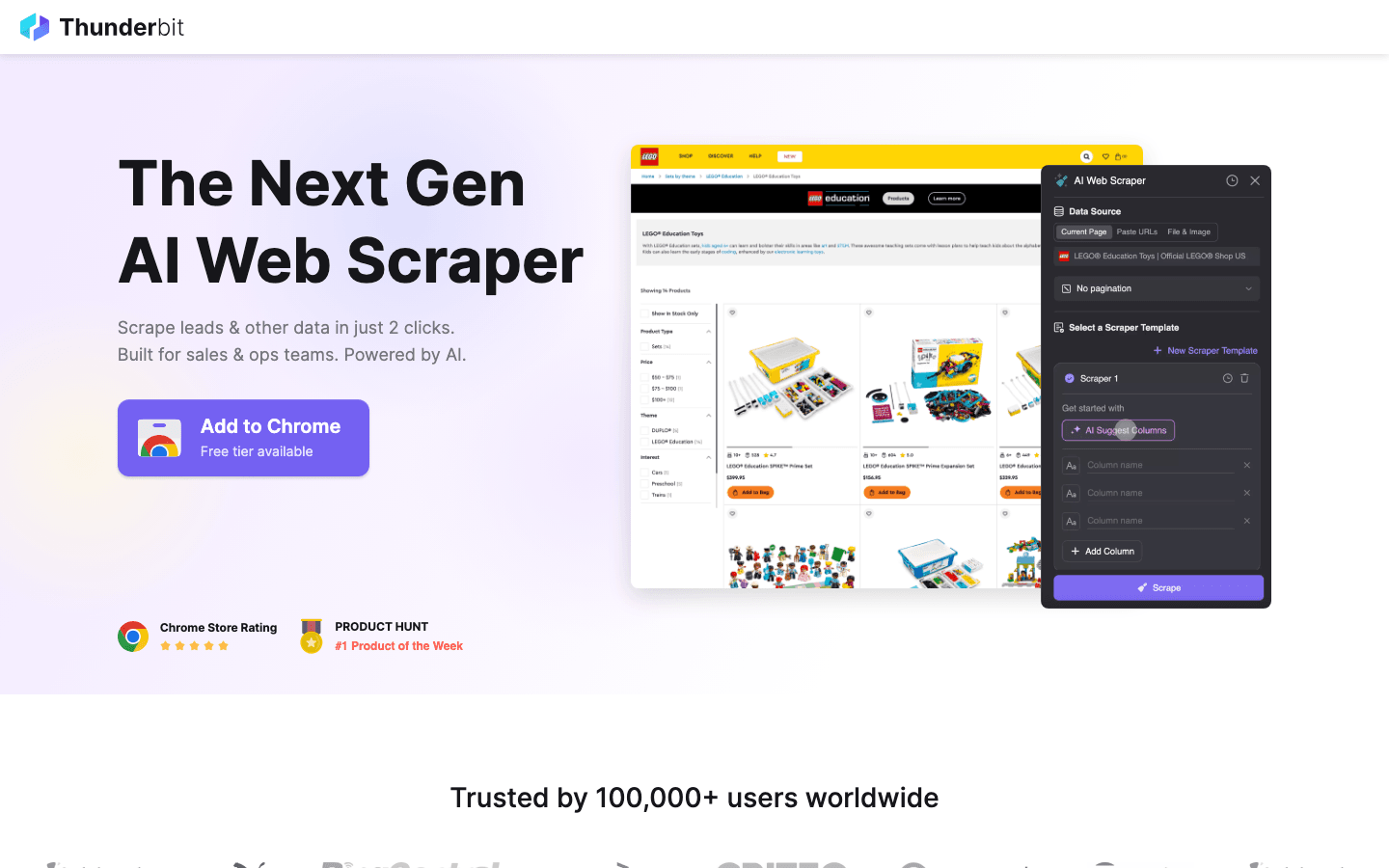

番外編:オープンソースが難しいならThunderbitを試そう

上記ツールは開発者向けとして優秀ですが、共通の課題もあります。コーディングが必須、AI型アンチボットへの対応が難しい、保守が大変…。

は、こうした課題を解決するおすすめのAI 웹 스크래퍼。強力なスクレイピングと手軽さを両立します。

Thunderbitがオープンソースより優れている理由

- コーディング不要:ScrapyやPuppeteerと違い、ThunderbitはAI搭載のChrome拡張。"AIで項目を自動抽出"をクリックするだけでスクレイパーが完成。

- 面倒な処理もAIで自動化:動的コンテンツや無限スクロール、ページネーションもAIが自動対応。スクリプト作成の手間を大幅削減。

- 即エクスポート:ウェブからExcel、Google Sheets、Notionへ2クリックで出力。

- 保守不要:サイト構造が変わってもAIが自動で対応。コードの修正は不要。

営業・マーケ・リサーチなど「今すぐデータが欲しい」「PythonやGoは使いたくない」方には、Thunderbitがオープンソースの強力な補完役となります。

実際の動作を見たい方は、してお試しください。

まとめ:2026年に最適なセルフホスト型ウェブクローラーを選ぶには

Firecrawlのオープンソース代替は、かつてないほど充実しています。ScrapyやNutchの大規模対応、Heritrixのアーカイブ品質など、用途に応じて最適な選択肢が必ず見つかります。大切なのは「自分のニーズに合ったツールを選ぶ」こと。ちょっとしたデータ取得ならシンプルなツールで十分、大規模クロールなら投資を惜しまないのがコツです。

もしオープンソースが難しければ、AIツールのThunderbitが強力な味方になります。

さあ、次のデータプロジェクトにScrapyを導入するもよし、手軽にAIスクレイピングを始めるならのもおすすめ。さらに詳しいノウハウやチュートリアルはでチェックしてください。

よくある質問

1. Firecrawlのオープンソース代替を使う最大のメリットは?

オープンソースなら柔軟性が高く、コストも抑えられます。セルフホストやカスタマイズも自由。ベンダーロックインを避け、活発なコミュニティのサポートも受けられます。

2. 非技術者がすぐに使えるおすすめツールは?

はオフライン閲覧に最適なオープンソースです。ただし、Excel形式など構造化データ抽出なら、AI機能を持つがおすすめです。

3. 動的・JavaScript多用サイトはどう対応すれば?

が最適です。実際のブラウザを操作するので、SPAやAJAXコンテンツも取得できます。

4. Apache NutchやStormCrawlerのような大型クローラーはどんな時に使う?

数百万ページ・複数ドメインのクロールや、リアルタイム分散クロール(検索エンジンやニュース監視など)が必要な場合に最適です。

5. 独自クローラー開発と既存オープンソース、どちらが良い?

多くのチームには既存オープンソースのカスタマイズが速くて安定。独自開発は特殊要件や長期運用体制がある場合のみ推奨です。

データ取得がスムーズに進みますように!

さらに詳しく知りたい方へ