デジタル社会の今、ニュースはまさに一日中絶え間なく流れ続けています。新しいトピックが次々と登場し、意見が飛び交い、物語がどんどん変化していくのが日常茶飯事ですよね。僕自身、長年自動化やAIツールの開発に関わってきた経験から、タイムリーなニュースがビジネスの意思決定やマーケティング、企業イメージにどれだけ大きな影響を与えるかを痛感しています。でも、膨大な情報の波を手作業で追いかけるのは、まるで稲妻を虫取り網で捕まえようとするようなもの。だからこそ、ウェブ上のニュースデータを自動で集めて整理する「ニューススクレイピング」は、リアルタイムで情報が必要な人にとって欠かせない武器になっています。

ただ、ニューススクレイピングは単に見出しを集めるだけじゃありません。大事なのは「正確さ」「スピード」「ルール遵守」。やり方を間違えると、古い・不完全・あるいはグレーなデータを手にしてしまうことも。正しくやれば、常に最新情報をキャッチできる“ニュースレーダー”を手に入れられます。この記事では、での実体験や最新の業界トレンドをもとに、2025年版のニューススクレイピングのベストなやり方を紹介します。ビジネスインテリジェンス、PR、リサーチ、ニュース好きまで、現場で役立つノウハウやワークフロー、ちょっとした小ネタも交えてお届けします。

ニューススクレイピングって何?なぜ大事?

ニューススクレイピングは、ニュースサイトから記事・見出し・著者・日付などの情報を自動で抜き出して、バラバラなニュースを整理されたデータとして活用できるようにする技術です。一般的なウェブスクレイピングが静的な商品ページやディレクトリを対象にするのに対し、ニューススクレイピングは「鮮度」と「継続的な更新」が命。自分専用のニュース配信システムを作るイメージです。

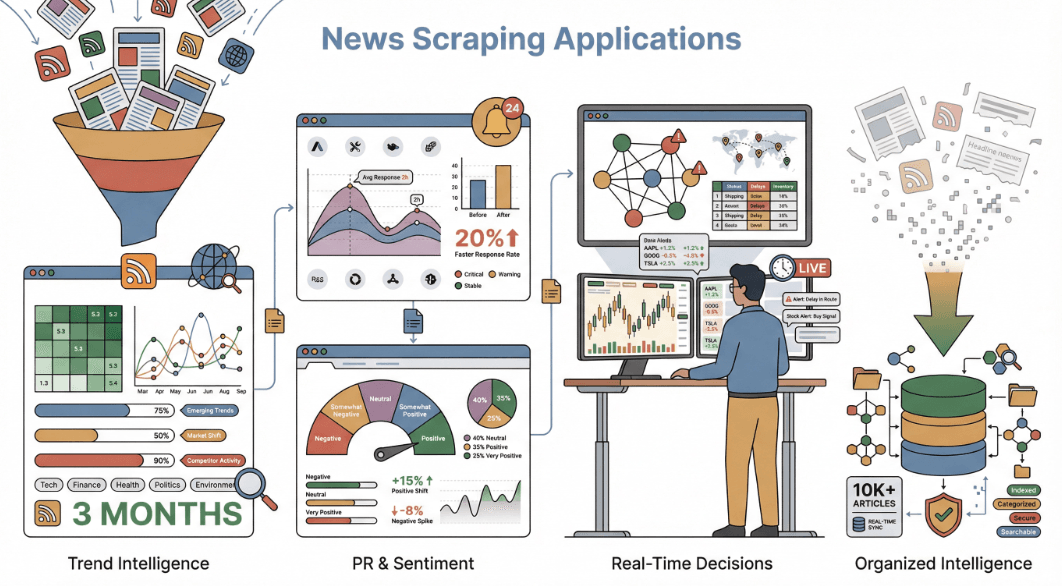

なぜこれが重要なのか?今やしていて、企業もニュースを戦略的なインテリジェンスとして活用しています。市場動向の把握、競合の監視、世論分析、PR危機管理など、必要なニュースをすぐに手に入れることは大きなアドバンテージです。

企業がニューススクレイピングを活用する主な例:

- 市場・トレンド分析:複数メディアからニュースを集めることで、業界の変化を一般的なレポートより数ヶ月早く察知できます。

- 競合・PRモニタリング:自社や競合のニュース露出をリアルタイムで追跡。ニュースの感情を監視することでした事例も。

- 感情分析・リサーチ:数千の記事を解析し、世論やバイアス、ストーリーの傾向を把握。経済学者が使うのような使い方も。

- リアルタイム意思決定:ニュースデータをトレーディングアルゴリズムやサプライチェーンのアラート、経営ダッシュボードに連携し、即時の意思決定を実現。

つまり、ニューススクレイピングは日々の膨大なニュースを「整理されたインテリジェンス」に変換し、現代社会ではもはや欠かせない存在です。

ニュースAPIじゃなくてスクレイピングを選ぶ理由

「ニュースAPIを使えばいいんじゃない?」と思う人も多いはず。

ニュースAPI(NewsAPI.orgやGoogle News APIなど)は、いろんなニュースソースから見出しや要約、メタデータを構造化して提供してくれるサービス。手軽でカバー範囲も広いけど、実は制約も多いんです:

- 取得できる情報が限定的:多くのAPIは見出し・ソース・日付・要約くらいしか取れません。記事全文や著者情報、コメント、関連リンクなどは難しいことがほとんど。

- カバー範囲に抜け漏れ:ニッチなサイトやローカル紙、有料記事は含まれないことも。

- カスタマイズ不可:API提供元の仕様や更新頻度に依存します。

- コスト・利用制限:高品質なAPIは利用回数や料金に制限があることが多いです。

一方、ニューススクレイピングなら、ページ上に表示されているあらゆる情報(コメント、タグ、画像、関連ニュースなど)を自由に抽出できます。自分のニーズに合わせてデータ構造や更新頻度を柔軟に設計でき、知識グラフのような高度なデータベースも作れます。

比較表はこちら:

| データ項目 | ニュースAPI | ニューススクレイピング |

|---|---|---|

| 見出し/タイトル | あり | あり |

| 記事URL | あり | あり |

| ソース名 | あり | あり |

| 公開日時 | あり | あり |

| 著者名 | 一部 | あり |

| 記事全文 | 一部(有料) | あり |

| メイン画像URL | 多い | あり |

| タグ/カテゴリ | 場合による | あり |

| コメント/ディスカッション | なし | あり |

| 関連記事リンク | なし | あり |

| SNSエンゲージメント | なし | あり(表示されていれば) |

| データ一貫性 | 高い | 変動(正規化が必要) |

スクレイピングなら、ニュースの多様な情報を余すことなく取得できて、分析やダッシュボード構築にもピッタリです。

詳しくはもチェックしてみてください。

スケジューリングのコツ:IPブロック回避とデータ精度の両立

ニューススクレイピングで一番悩むのが「どのくらいの頻度でスクレイピングすればいいの?」「IPブロックをどう防ぐ?」という点。

ニュースは鮮度が命。遅すぎると速報を逃し、速すぎるとIPがブロックされてしまう。最適なバランスを見つけるのが大事です。

スケジューリングのベストなやり方:

- サイトの更新頻度に合わせる:1時間ごとに更新されるサイトなら1時間ごと、日刊ニュースなら1日1回で十分。速報性の高いサイト(CNN、Reuters、Google Newsなど)は30分ごと、業務時間中はさらに高頻度が理想(参照)。

- リクエストの間隔を空ける:一度に大量のページを連続でリクエストしないよう、適度な間隔を設ける。

- robots.txtの遵守:必ずrobots.txtを確認し、クロール禁止や遅延指示に従う。

- エラー監視:空データやCAPTCHAが頻発したら、頻度を下げるサイン。

Thunderbitでは、スケジュールスクレイパー機能を用意しています。例えば「平日の4時間ごと」など、自然な言葉で間隔を指定するだけで、クラウド上で自動的に分散実行。最大50ページを同時処理し、通常のユーザーアクセスのように見せかけてブロックリスクを減らします。

スケジューリングやブロック対策の詳細はも参考にどうぞ。

動的ニュースサイトからのデータ抽出:精度を高める技術

最近のニュースサイトは、無限スクロールや「もっと見る」ボタン、AJAXコメント、頻繁なレイアウト変更など、複雑な仕組みが多いのが現実。これらはスクレイピングの大きな壁になります。

主な課題:

- 無限スクロール・ページネーション:スクロールや「次へ」クリックで記事が追加表示されるため、単純なスクレイパーでは大半の記事を見逃します。

- 動的要素:コメントや画像、関連リンクなどが遅延表示やユーザー操作後に現れることも。

- 頻繁なレイアウト変更:HTML構造が変わると、従来のスクレイパーはすぐに動かなくなります。

Thunderbitの解決策:

- 自動ページネーション・無限スクロール対応:ThunderbitのAIが複数ページや無限スクロールを自動検出し、全記事を取得。

- AIフィールド抽出:壊れやすいセレクタに頼らず、AIが見出し・著者・日付などをページから読み取ります。サイトがリニューアルされても柔軟に対応。

- サブページスクレイピング:記事一覧から各記事ページに自動遷移し、本文やコメント、関連情報も一括取得。

- ブラウザモードで動的コンテンツ対応:JavaScript実行や遅延読み込みにも対応し、AJAX主体のサイトも正確に抽出。

例えばGoogleニュースをThunderbitでスクレイピングすれば、動的に追加される見出しやソース、タイムスタンプも漏れなく取得可能。サイト構造が変わっても「AIフィールド改善」ボタンで即対応できます。

技術的な詳細はもどうぞ。

法令順守とセキュリティ:ニューススクレイピングのコンプライアンス

ニューススクレイピングは法的・倫理的にグレーな部分もあるので、ルールを守るのが大切です。主な注意点は以下の通り:

- robots.txtや利用規約の遵守:禁止されているセクションは絶対にスクレイピングしない。

- 有料・非公開コンテンツは対象外:公開されている情報のみ抽出し、ペイウォール突破は厳禁。

- 社内利用に限定:社内分析やダッシュボード用途なら比較的安全ですが、記事全文の再配信は避けましょう。

- サーバーへの負荷を避ける:リクエスト頻度を抑え、サイト運営に迷惑をかけない。

- 個人情報の慎重な扱い:著者名やコメントなどを取得する場合は、GDPRなどのプライバシー法にも配慮。

Thunderbitは、ユーザーのブラウザ権限を活用し、セキュリティを回避せず、データもローカル保存で管理できます。エクスポートも無料・ローカルなので、データの流出リスクもありません。

法的観点の詳細はも参考にしてください。

Thunderbitがニューススクレイピングに最適な理由

ちょっと自慢になっちゃいますが、Thunderbitは開発者だけじゃなく誰でも簡単にニューススクレイピングできるように作られています。主な特長は:

- AIによるフィールド自動検出:「AIフィールド提案」ボタンで、見出し・著者・日付・本文・画像など最適なカラムを自動提案。コーディング不要。

- サブページ・複数ページ自動取得:記事リンクをたどって本文やコメント、関連情報も一括抽出。

- 動的コンテンツ対応:無限スクロールやAJAX、レイアウト変更にもAIが柔軟に対応。

- クラウド&ブラウザモード:公開サイトは高速なクラウド処理、ログインやJavaScript必須サイトはブラウザモードで対応。

- 無料・柔軟なエクスポート:Excel、Google Sheets、Airtable、Notion、JSONなどに制限なく出力可能。

- ノーコードで簡単操作:ブラウザが使えれば誰でもOK。XPathやスクリプトは不要。

- リーズナブルな価格:小規模なら無料、上位プランも月額15ドルからと手頃。

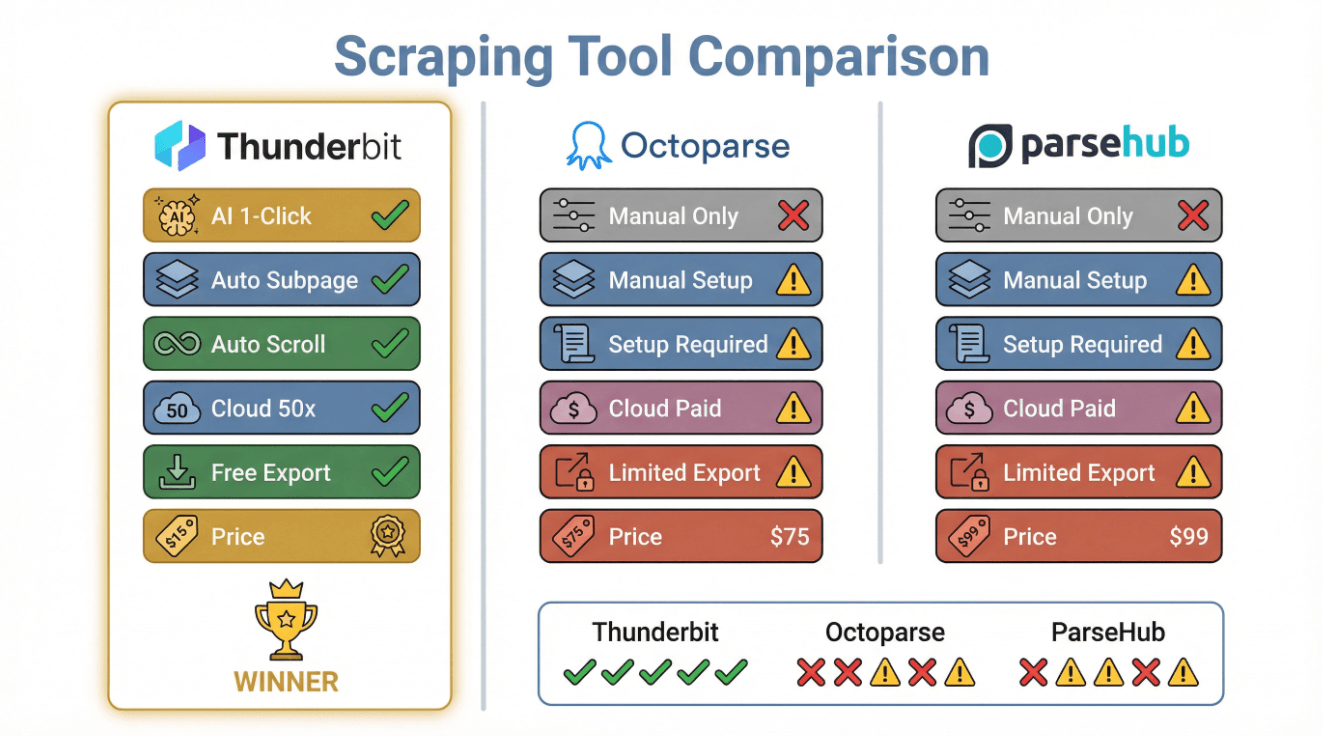

比較表はこちら:

| 機能 | Thunderbit | Octoparse | ParseHub |

|---|---|---|---|

| AIフィールド検出 | あり(1クリック) | なし(手動) | なし(手動) |

| サブページ取得 | あり(自動) | あり(手動) | あり(手動) |

| 無限スクロール対応 | あり(自動) | あり(設定必要) | あり(設定必要) |

| クラウドスクレイピング | あり(同時50件) | あり(有料) | あり(有料) |

| 無料エクスポート | あり(全プラン) | 制限あり | 制限あり |

| ノーコード設定 | あり | あり | あり |

| 価格 | 無料/15ドル〜 | 75ドル〜 | 99ドル〜 |

詳細はもチェック!

正確かつ迅速なニューススクレイピングのベストプラクティス

どんなプロジェクトでも使えるチェックリストをまとめました:

- 信頼できるソースを選ぶ:Googleニュース、BBC、CNN、Reuters、TechCrunchなど、更新頻度が高く信頼性のあるサイトを選定。

- スクレイピング頻度を調整:速報系は1時間ごと、通常ニュースは1日1回など、サイトの更新ペースに合わせる。

- 動的コンテンツに対応:Thunderbitのような無限スクロールやAJAX対応ツールを活用。

- データの重複排除・検証:重複記事の除去、欠損フィールドの確認、フォーマットの正規化。

- 法令順守を徹底:robots.txtや利用規約を確認し、有料・非公開コンテンツは避ける。

- 監視と適応:失敗時のアラート設定や定期的な出力チェックで精度維持。

- 自動化・連携:Sheets、Notion、Airtableなどにエクスポートし、ダッシュボードやアラートも自動化。

クイックリファレンス表:

| ステップ | ベストプラクティス |

|---|---|

| ソース選定 | 信頼性・関連性・多様性を重視 |

| スケジューリング | 更新頻度に合わせ、リクエストを分散 |

| 動的対応 | AI/自動化でスクロール・ページネーション・AJAX対応 |

| データ品質 | 重複排除・検証・正規化 |

| コンプライアンス | robots.txt・利用規約・プライバシー法の遵守 |

| 監視 | アラート・手動チェック・サイト変更への適応 |

| エクスポート・活用 | Sheets・Notion・ダッシュボード・アラート自動化 |

ニューススクレイピングのワークフロー構築:実践ガイド

実際にを使ったニューススクレイピングの流れを紹介します。ノーコードで超カンタンです。

ステップ1:対象ニュースサイトの選定

- サイト選定:BBC、CNN、Reutersなど大手、TechCrunchやMedical News Todayなど業界特化、Googleニュースなどのアグリゲーターも活用。

- アクセス確認:有料記事や非公開コンテンツでないか事前にチェック。

- 言語・地域も考慮:Thunderbitは34言語対応なので、グローバル展開もOK。

- URLリスト化:トップページ、セクションページ、検索結果(例:「AI規制」のGoogleニュース)など。

ステップ2:Thunderbitの設定

- をインストール

- Chromeで対象ページを開く

- 「AIフィールド提案」をクリック:見出し、URL、ソース、公開日時、著者、画像などのカラムを自動提案。

- 必要に応じて調整:カテゴリなど追加・名称変更もOK。

- テンプレート保存:同じタイプのページで繰り返し使えます。

ステップ3:スケジューリングと監視

- スケジュール設定:「毎日7時」や「業務時間中は毎時」など柔軟に指定。

- 手動テスト実行:期待通りのデータが取れるかチェック。

- エラー監視:出力に欠損やエラーがあれば「AIフィールド提案」やスケジュールを調整。

- サブページ対応:記事本文も取得したい場合はサブページスクレイピングを活用。

ステップ4:データのエクスポートと活用

- 好きなツールにエクスポート:Google Sheets、Airtable、Notion、Excel、JSONなど。

- ダッシュボード自動化:Google Data StudioやTableau、Power BIと連携し、リアルタイム分析も可能。

- アラート設定:ZapierやIFTTTで新着見出しやキーワード通知も自動化。

- 継続的な改善:ニーズに応じてフィールドやソース、スケジュールを柔軟に調整。

詳細はもどうぞ。

まとめ:効果的なニューススクレイピングのポイント

結論として、ニュースがSNS並みのスピードで流れる今、自動ニューススクレイピングこそが情報収集・競争力強化・先手対応のカギです。ベストプラクティスはシンプルだけど強力:信頼できるソース選定、適切なスケジューリング、動的コンテンツ対応、法令順守、そして継続的な監視。

Thunderbitなら、これらを誰でも簡単に実現できます。コーディング不要、ストレスフリーで、正確かつタイムリーなニュースデータをすぐに分析やダッシュボード、アラートに活用可能。ビジネスアナリスト、PR担当、研究者、ニュース好きまで、リアルタイムのニュースレーダーを自分で作れます。

手作業でニュースを追いかけるのに疲れたら、ぜひThunderbitを試してみてください。きっと未来の自分や受信箱が感謝してくれるはず。

さらに詳しいノウハウはでチェック!

よくある質問

1. ニュースAPIじゃなくてスクレイピングを使うメリットは?

スクレイピングなら、コメントや著者情報、関連リンク、記事全文などAPIでは取れない多様なデータをカスタマイズして集められます。包括的なニュースデータセットや感情分析、知識グラフ構築にも最適です。

2. ニュースサイトのスクレイピングでIPブロックを避けるには?

Thunderbitのスケジュールスクレイパーのようなツールでリクエスト間隔を調整し、サイトの更新頻度に合わせて実行。robots.txtも必ず確認し、過度な連続リクエストやエラー・CAPTCHA発生時は頻度を下げましょう。

3. 無限スクロールやAJAX対応の動的ニュースサイトはどう対処すればいい?

Thunderbitのように自動ページネーションやAIフィールド抽出に対応したスクレイパーを選びましょう。これで動的に追加される記事も漏れなく取得できます。

4. ニューススクレイピングは合法ですか?

公開ニュースを社内分析目的で取得するのは一般的にOKですが、robots.txtや利用規約は必ず確認。有料・非公開コンテンツの取得や著作権・プライバシー法違反には注意が必要です。

5. Thunderbitがニューススクレイピングに最適な理由は?

ThunderbitはAIフィールド検出、サブページ取得、動的コンテンツ対応、Excel/Sheets/Airtable/Notionへの無料エクスポートなど、ノーコードでビジネスユーザー向けに設計されています。正確かつタイムリーなニュースデータを手軽に取得できます。

自分だけのニュースデータパイプラインを作りたい人は、して、その手軽さを体感してみてください。

さらに詳しく知りたい方へ