2026年のウェブは、まさに“データの密林”状態。企業はこの膨大な情報の中から必要なデータを整理し、ビジネスの意思決定や競合分析、業務の自動化に活用しようと日々奮闘しています。営業やEC、オペレーションの現場では、構造化されたウェブデータを求める声が絶えません。でも、ウェブスクレイピングソフトウェア市場はすでにに到達し、ネットのトラフィックの約半分がボットによるものとなった今、最適なツール選びは“デジタルの干し草の山から針を探す”ようなものです。

じゃあ、2026年に本当に使えるウェブスクレイピングツールってどれ?AI搭載のChrome拡張からオープンソース、ノーコード型まで、人気のツールを徹底的に調査・比較しました。技術に自信がないビジネスユーザーも、Pythonでガンガン開発したいエンジニアも、このガイドを読めば、次のデータプロジェクトにぴったりの一手が見つかるはず。もうコピペ地獄からも卒業できますよ。

2026年版 人気ウェブスクレイピングツールの選定基準

数あるツールの中から、今回は使いやすさ、自動化の強さ、対応範囲、実際のユーザーレビュー、ビジネス適合性を重視してピックアップ。AIの手軽さ、ノーコードの柔軟性、オープンソースのパワー、ブラウザ拡張の便利さなど、いろんなタイプをバランスよく選びました。営業・EC・リサーチ・オペレーション部門のリアルな利用状況やレビューも参考にしています。結果、「とにかく表にしたい」から「明日までに100万ページクロールしたい」まで、幅広いニーズに応える7つのツールを厳選!

それでは、順番に見ていきましょう。

1. Thunderbit

は、コードや面倒な設定なしで、サクッとウェブデータを集めたいビジネスユーザーにぴったりのツール。AI搭載のChrome拡張として、使い方は超シンプル。「AIで項目を提案」→「スクレイピング開始」をクリックするだけ。AIがページを解析して、必要なデータを自動でテーブル化してくれます。技術的な知識は一切不要!

Thunderbitは、営業・EC・オペレーション部門がリード情報や商品データ、競合情報を数分でゲットしたいときに大活躍。「まるでインターンが全部コピペしてくれるみたい」と評判なのも納得です。

Thunderbitの主な特徴

- AIによる項目提案: AIがウェブサイトを解析し、名前・価格・メールアドレスなど最適なカラムを自動で提案。セレクタ設定や抽出項目の推測は不要。

- サブページ・ページネーション対応: ページ送りや詳細ページ(例:商品詳細やLinkedInプロフィール)も自動で巡回し、データを拡充。

- 即時テンプレート: AmazonやZillow、Instagramなど人気サイトはワンクリックでテンプレート利用OK。AI設定も不要。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notionへ直接エクスポート。追加料金や制限なし。

- AIオートフィル: オンラインフォームの自動入力や繰り返し作業もワンクリックで自動化。

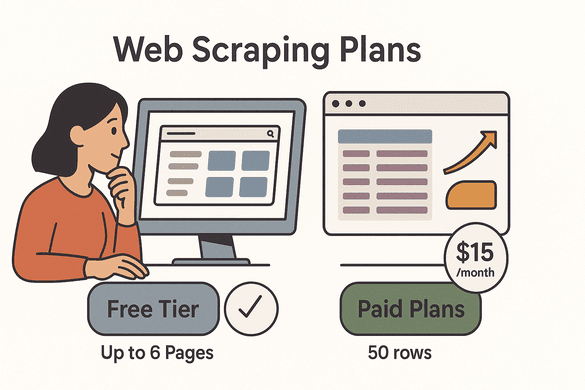

- クレジット制料金: 無料プランで最大6ページ(トライアルで10ページ)まで利用可能。有料プランは月額$15/500行から、チーム規模に応じて拡張できます。

Thunderbitは、学習コストゼロで今すぐデータを集めたい人に最適。すでにが利用し、「シンプルで正確」と高評価。詳しくはもチェック!

2. Scrapy

は、オープンソースのウェブスクレイピングフレームワークの代表格。Python製で、開発者からはその高速性・柔軟性・拡張性で絶大な支持を集めています。数千~数百万ページのクロールや、ログイン・データベース連携・分析パイプラインなど、複雑な要件にも対応可能。コーディングに慣れているなら、Scrapyは最強の相棒です。

Scrapyは価格監視や機械学習用データ収集など、幅広い用途で活躍。非エンジニアにはハードルが高いですが、使いこなせれば無限の可能性を秘めています。

ビジネスでのScrapy活用ポイント

- 高パフォーマンス: 非同期アーキテクチャで大規模データも高速クロール。

- カスタマイズ性: 独自のスパイダー(クローラー)を作成し、ログイン・フォーム・プロキシなど柔軟に対応。

- 拡張性: プラグインでプロキシローテーションや重複排除、外部連携も簡単。

- 無料・オープンソース: ライセンス費用不要。開発リソースとインフラ投資のみ。

- コミュニティサポート: 豊富なドキュメントとStackOverflowでの情報交換。

自社にエンジニアがいる、または細かく制御したい場合に最適です。Scrapyの詳細な比較はも参考に。

3. Octoparse

は、ノーコードで使えるビジュアル型ウェブスクレイピングツール。画面上の要素をクリックしていくだけでワークフローを作成でき、クラウド上で定期実行も可能。日々の価格調査やリード収集など、繰り返し作業に最適です。

マーケターやリサーチャー、中小企業に特に人気で、プログラミング不要でデータ収集を自動化できます。

Octoparseのビジネス活用ポイント

- ビジュアルワークフローデザイナー: 欲しいデータをクリックで選択、コーディング不要。

- 自動検出&テンプレート: データリストを自動認識し、Amazon・eBay・Twitterなどのテンプレートも豊富。

- クラウド抽出&スケジューリング: Octoparseのサーバーで自動実行・定期実行が可能。

- 動的コンテンツ対応: JavaScriptサイトやログイン、上位プランではCAPTCHAも突破。

- 多彩なエクスポート: CSV、Excel、JSON、HTML、Google SheetsやDBへの直接出力も。

- 料金: 無料プランは10タスク・1万件/回まで。有料は月$75~、上位プランで大規模・高度な機能に対応。

ノーコードでパワフルな自動化を求める方におすすめ。詳細やユーザー評価は。

4. ParseHub

は、ビジュアル型ノーコードツールの中でも、Windows・Mac・Linuxのクロスプラットフォーム対応が特徴。プロジェクト単位で複雑な操作(クリック、ループ、条件分岐など)を視覚的に設計でき、動的なJavaScriptサイトにも強いです。

ParseHubの強み

- クロスプラットフォーム: Windows・Mac・Linuxで動作。仮想環境不要。

- ビジュアル操作: 要素選択、ループ、マルチステップワークフローも直感的に設定。

- 動的コンテンツ対応: フォームやドロップダウン、無限スクロールもOK。

- スケジューリング&クラウド実行: 有料プランでクラウド実行・API連携も。

- 柔軟なエクスポート: CSV、Excel、JSON、Dropbox/Google Drive連携も。

- 料金: 無料プランは5プロジェクト・200ページ/回。有料は月$189~、大規模・高速化に対応。

やや学習コストはありますが、複雑な案件も自動化できるパワフルなツールです。詳細はもご覧ください。

5. Apify

は、ウェブスクレイピングと自動化・API連携を融合したクラウドプラットフォーム。スクリプト(“アクター”)をクラウドで実行・スケジューリングし、APIとしてデータ提供も可能。市場調査や競合分析、リアルタイムダッシュボード連携など、継続的な大規模データ収集に最適です。

Apifyの長期データプロジェクト活用

- スケーラブルなクラウド基盤: 小規模から数百万ページの大規模クロールまで、IPローテーションやブロック対策も万全。

- アクターマーケットプレイス: 人気サイト用の既成スクレイパー多数。独自開発もJavaScript/Pythonで可能。

- API連携: どんなスクレイパーもAPIエンドポイントやWebhook化でき、リアルタイムデータ配信も。

- ワークフロー自動化: ブラウザ操作やフォーム入力、ヘッドレスブラウザボットも自動化。

- 柔軟な料金体系: 無料枠(月$5分のクレジット)、有料は月$39~、エンタープライズ向けも。

技術力のあるチームや、大規模なデータパイプライン自動化を目指す方におすすめ。詳細はも参考に。

6. WebHarvy

は、Windows専用のビジュアル型スクレイパーで、特に画像抽出のしやすさが魅力。商品画像やファイルのダウンロード、テキストと画像の同時取得も、クリック操作だけで簡単に実現できます。

中小企業やECショップ、研究者など、サブスクリプション不要で手軽に使いたい方に人気です。

WebHarvyの中小企業向け活用

- Windowsデスクトップアプリ: 軽快で安定、Windowsユーザーに最適。

- クリック操作で抽出: テキスト・画像・価格など、要素をクリックするだけで取得。

- 画像・ファイル抽出: データ取得と同時に画像やファイルもダウンロード。

- ページネーション・多階層対応: 次ページやサブページ巡回、フォーム送信もOK。

- 買い切り価格: 1ユーザー$129(1年のアップデート・サポート付)、チーム向けライセンスも。月額費用なし。

- 多彩なエクスポート: CSV、Excel、JSON、XML、SQLデータベース直出力も。

画像重視の定期的なスクレイピングに最適。詳細はもご覧ください。

7. Data Miner

は、即時・手軽なデータ抽出に特化したChrome拡張。営業やマーケター、リサーチャーがウェブ上の表やリストをワンクリックでExcelやGoogle Sheetsに落とし込めます。設定不要・コーディング不要で、すぐに使えるのが魅力です。

6万件以上の公開レシピ(抽出ルール)があり、ほとんどの基本的なスクレイピングはそのまま利用可能。

Data Minerのリアルタイム活用

- ブラウザ完結の手軽さ: ブラウザ上で表やリストをワンクリック抽出。

- 豊富なレシピ: LinkedIn、Yelp、Amazonなど人気サイト用の抽出ルールが充実。

- ページネーション対応: 複数ページやリストもレシピで自動巡回。

- カスタムレシピ・JavaScript: 上級者は独自スクレイパーやJSで動的コンテンツも対応。

- 無料&有料プラン: 無料で月500ページまで。有料は月$19.99~、機能・上限拡張。

- 多彩なエクスポート: CSV、Excel、Google Sheetsへ直接出力。

手早くデータを取得したい個人や小規模チームに最適。詳細はもご覧ください。

2026年 人気ウェブスクレイピングツール比較表

| ツール | 使いやすさ | 自動化・スケール | 対応環境 | おすすめ用途 | 料金 | エクスポート |

|---|---|---|---|---|---|---|

| Thunderbit | 非常に簡単(AI・ノーコード) | 良好(サブページ・ページネーション・スケジューリング) | Chrome(Win/Mac/Linux) | ビジネスユーザー・営業・業務 | 無料(6~10ページ)、月$15~ | Excel、CSV、Sheets、Airtable、Notion |

| Scrapy | 難しい(コーディング必須) | 優秀(大規模・カスタムロジック) | Python(全OS) | 開発チーム・大規模案件 | 無料(オープンソース) | CSV、JSON、DB、カスタム |

| Octoparse | 普通(ノーコードUI) | 高度(クラウド・スケジューリング・動的対応) | Windowsアプリ/クラウド | 非技術者・マーケター | 無料、月$75~ | CSV、Excel、JSON、Sheets |

| ParseHub | 普通(ビジュアル・クロスプラットフォーム) | 良好(マルチステップ・クラウド実行) | Win/Mac/Linux | 非エンジニア・リサーチ | 無料、月$189~ | CSV、Excel、JSON、API |

| Apify | 難しい(技術・API重視) | 優秀(クラウド・API・大規模) | Web/クラウド(全OS) | 開発者・データエンジニア | 無料、月$39~ | JSON、CSV、API、Webhook |

| WebHarvy | 簡単(クリック操作) | 標準(ページネーション・画像) | Windowsのみ | 中小企業・画像抽出 | $129買い切り | CSV、Excel、JSON、画像 |

| Data Miner | 非常に簡単(ブラウザ) | 低~中(ページネーション・レシピ) | Chrome/Edge | 営業・即時抽出 | 無料(500ページ)、月$19.99~ | CSV、Excel、Sheets |

ビジネスに最適なウェブスクレイピングツールの選び方

最適なツール選びのコツは、次のポイントを押さえること:

- 技術スキルは? コーディング不要ならThunderbit、Octoparse、ParseHub、WebHarvy、Data Minerが安心。開発者がいればScrapyやApifyで高度な自動化もOK。

- プロジェクトの複雑さは? シンプルなリストや表ならThunderbitやData Miner。動的サイトや多段階フロー、定期実行ならOctoparse、ParseHub、Apifyが有力。

- 必要なデータ量・頻度は? 単発や小規模なら無料・買い切り型で十分。大規模・継続案件ならクラウド型を検討。

- データの出力先は? ExcelやGoogle Sheets中心なら直接エクスポート対応ツールを。APIやDB連携ならApifyやScrapyが最適。

- 予算は? 小規模なら無料・低価格ツールでOK。エンタープライズ用途ならスケール・サポート・自動化に投資を。

まずは無料プランやトライアルで実際に試して、自社のワークフローに合うか確認するのが一番。結局、「使い続けられるツール」が最良の選択です。

まとめ:ビジネス価値を最大化するウェブスクレイピングツール

ウェブスクレイピングは、もはや開発者だけのものじゃなく、ビジネスの必須ツールに進化しました。AIやクラウド、ノーコードの普及で、より強力かつ使いやすく自動化も進化中。リードリスト作成、価格監視、最新データでの分析など、用途やスキルに合った最適なツールがきっと見つかります。

ウェブデータをビジネスの武器にしたいなら、ぜひこれらのツールを試してみてください。特にAIでスクレイピングをもっと手軽にしたい人は、を数クリックで体験してみてください。

さらに詳しいノウハウやガイドはでも発信中です。

よくある質問(FAQ)

1. 2025年、非エンジニアに最も簡単なウェブスクレイピングツールは?

とはどちらもノーコードで使いやすいです。ThunderbitはAIで項目を自動提案、2クリックで完了。Data Minerはブラウザ上でレシピを選ぶだけで即抽出できます。

2. 大規模・複雑なスクレイピングに最適なツールは?

はカスタム・大規模案件に強い開発者向け。はクラウド・API連携で大規模自動化に最適です。

3. これらのツールで定期的なスクレイピングは可能?

はい。、、、は自動・定期実行機能を備えています。

4. 画像やファイル抽出に強いウェブスクレイピングツールは?

は画像・ファイル抽出に特化しており、ECやリサーチ用途で高評価です。

5. 自社に合ったウェブスクレイピングツールの選び方は?

技術スキル、プロジェクトの複雑さ、データ量、出力先、予算を考慮しましょう。まずは無料プランやトライアルでワークフローに合うか試し、必要に応じてアップグレードするのがおすすめです。詳しくはもご参照ください。

快適なスクレイピングライフを!データがいつもクリーンで構造化され、すぐに活用できることを願っています。