月曜の朝、コーヒー片手にメールをチェックしていたら、AIツールから機密データが流出したというニュースが飛び込んでくる――そんなシーン、もう他人事じゃありません。CEOからは説明を求められ、法務チームはピリピリ。お客さんからも「うちのデータ、本当に大丈夫?」と鋭い質問が飛んできます。これが2026年のリアルな現場。AIデータプライバシーは、もはやIT担当だけの話じゃなく、経営やブランドの信頼、そして自分のキャリアにも直結する超重要テーマになっています。

今やAIは営業、マーケ、不動産、ECなど、どんな業界にも当たり前のように入り込んでいます。でも、AI導入が進むほどリスクも急増。過去1年でAI関連のプライバシーインシデントは56%増、世界でAI企業を信頼して個人データを預けられると答えた人は**47%**しかいません(, )。SaaSや自動化プラットフォームの開発に長年関わり、今はの共同創業者として断言します。最新のAIデータプライバシー統計を押さえることは、単なるコンプラ対応じゃなく、デジタル時代を生き抜くための必須スキルです。

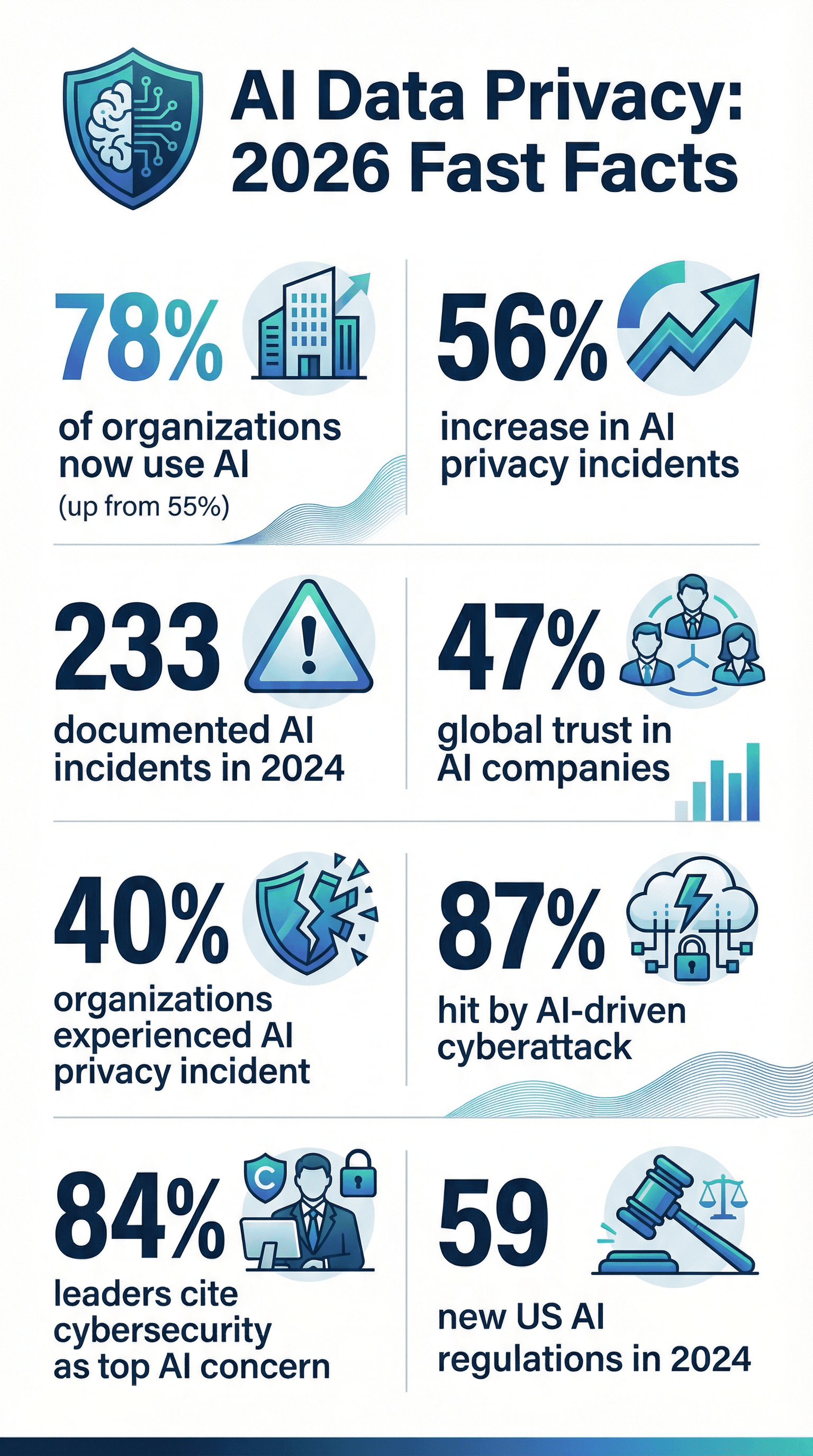

2026年のAIデータプライバシー:押さえておきたい数字

次の経営会議やクライアント向けプレゼンで使える、2026年のAIデータプライバシーに関する注目データをまとめました。

- AI普及率: 2024年には78%の企業がAIを導入。前年の55%から大幅アップ()。

- インシデント急増: AI関連のプライバシー・セキュリティインシデントは1年で56%増、2024年には233件が記録()。

- 情報漏洩は日常茶飯事: 40%の企業がAI関連のプライバシーインシデントを経験、**21%**は過去1年でサイバー攻撃を受けた(, )。

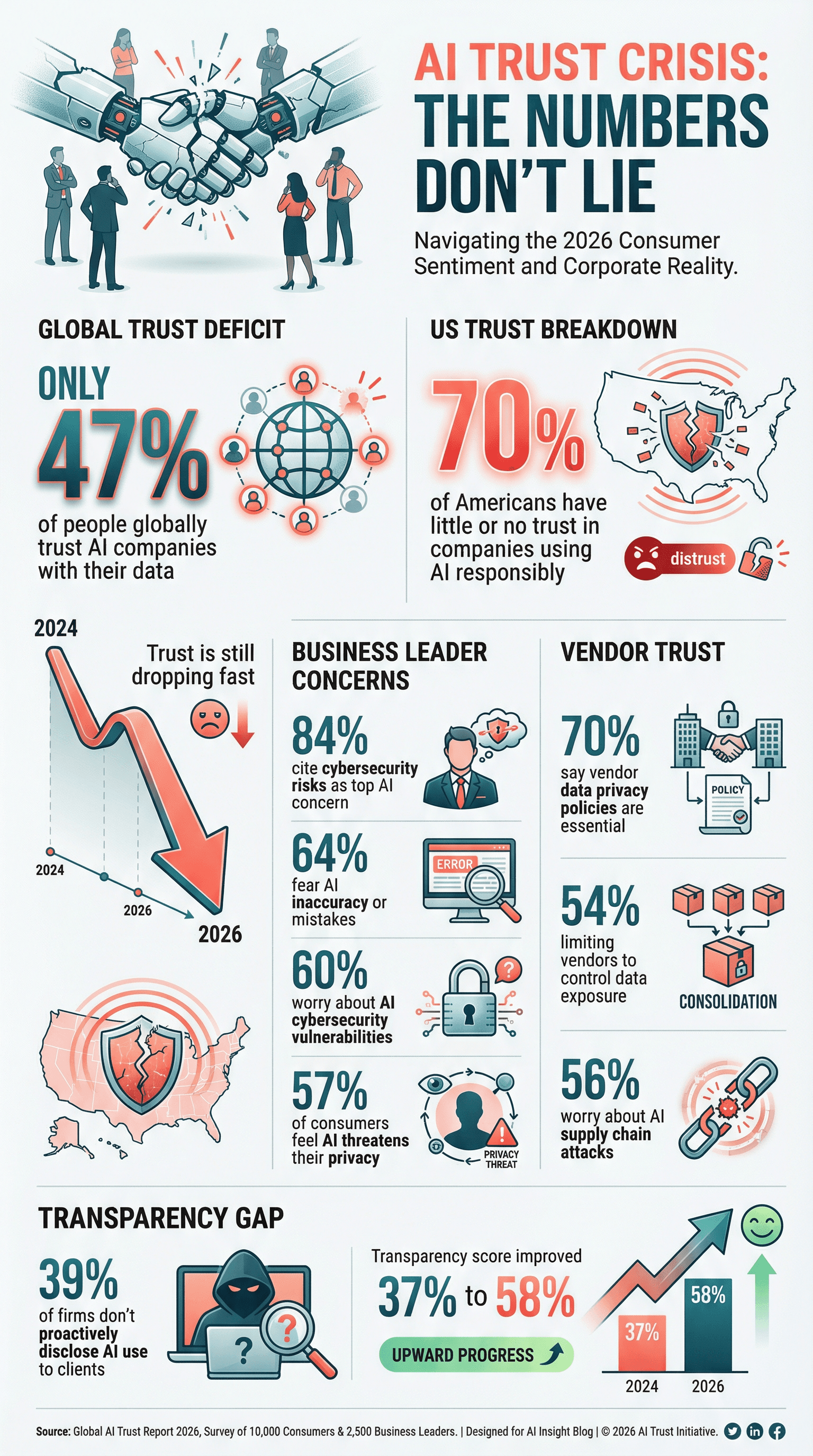

- 信頼度ダウン: 世界でAI企業を信頼している人は**47%だけ。アメリカでは70%**が「AIを適切に使う企業をほとんど信頼していない」と回答()。

- プライバシーは最重要: 61%の企業がサイバーセキュリティ(AIデータ保護含む)を戦略的優先事項トップ3に()。

- ベンダー選定も厳格化: 70%の企業がAIやテクノロジーパートナー選びでデータプライバシーポリシーを重視()。

- 経営層も警戒: 84%のビジネスリーダーがAI導入時のサイバーリスクを最大の懸念事項と回答()。

- 規制強化: 米国連邦機関は2024年に59件のAI関連規制を発表。前年の2倍以上()。

- ガバナンスポリシーの遅れ: 43%の企業だけがAIガバナンスポリシーを策定済み。**77%**は現在策定中(, )。

- AIサイバー攻撃が常態化: 87%の企業が過去1年でAIを使ったサイバー攻撃を経験()。

これらの数字は、データ管理やコンプラ、DX推進に関わる全員への警告です。

なぜAIデータプライバシーが今まで以上に大事なのか

AIは単なるITのアップグレードじゃなく、組織のデータの集め方・使い方そのものを根本から変えています。従来のソフトと違い、AIは顧客メールや医療記録など、膨大で多様なデータを学習に使います。しかもAIモデルは、思わぬ形で情報を「覚えて」いて、意図せず機密データを出力してしまうことも()。

AIモデル1つで何百万件ものデータを処理したり、ウェブ全体からデータをスクレイピングしたりも普通。しかも、はっきり同意を取らずにデータが使われることも。AIは一瞬で意思決定するので、バイアスやエラーが一気に広がり、プライバシー侵害や人権問題に発展するリスクも高まります。

「うちはプライバシーポリシーがあるから大丈夫」と思っていませんか?実は、AI特有のリスク(データポイズニング、モデル反転、敵対的攻撃など)は従来の管理策だけではカバーしきれません。AIによるプライバシー事故が起きれば、顧客離れや罰金、ブランドイメージの失墜など、回復に時間がかかる事態も。2026年、AIデータプライバシーは「守るべきルール」から「生き残るための必須条件」へと変わっています。

AIデータプライバシー統計:導入状況・懸念・コンプラ

AI導入はもう当たり前

AIは「新しい技術」じゃなく、すでに主流。2024年には78%の企業がAIを導入し、前年の55%から大きく伸びました()。法務や金融など一部業界では導入率がさらに高く、2025年には42%の法律事務所がAIツールを活用()。この急拡大で、集める・分析する・流出するデータ量も爆増しています。

プライバシーへの不安も拡大

AIの力が増すほど、責任と不安も増大。**世界の消費者の57%がAIによるプライバシーリスクを深刻と感じており()、アメリカではAIに詳しい人の70%が「企業がAIで集めたデータをちゃんと扱うとは思えない」と回答()。経営層も64%**がAIの誤りや不正確さ、**60%**がAI関連のサイバー脆弱性を大きな懸念としています()。

AIの力が増すほど、責任と不安も増大。**世界の消費者の57%がAIによるプライバシーリスクを深刻と感じており()、アメリカではAIに詳しい人の70%が「企業がAIで集めたデータをちゃんと扱うとは思えない」と回答()。経営層も64%**がAIの誤りや不正確さ、**60%**がAI関連のサイバー脆弱性を大きな懸念としています()。

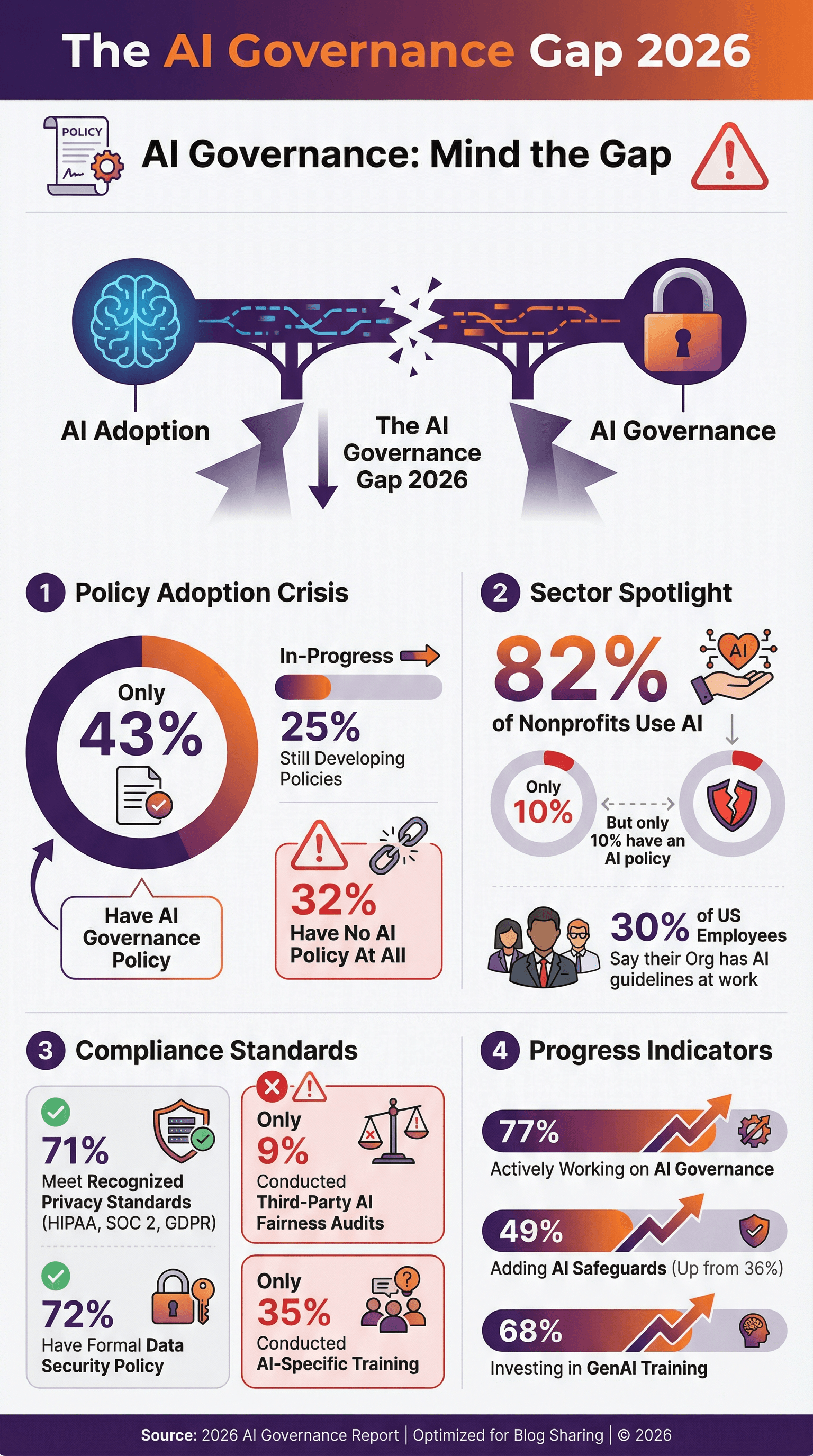

コンプラは常に進化中

GDPR、CCPA、HIPAA、SOC 2などの規制対応に追われる中、AIは新たな課題を持ち込みます。71%の企業が公認のデータプライバシー基準を満たし()、**72%**が正式なデータセキュリティポリシーを持っています。でも、AI専用のガバナンスや倫理ポリシーを持つ企業は半分以下。**43%**がAIガバナンスポリシーを策定済み、**25%**が策定中(, )。残りは、ほぼ手探り状態です。

AIデータプライバシーポリシーの現状

AIデータプライバシーポリシーは「あると便利」から「なきゃヤバい」へと変化中。でも現場はまだ発展途上。

- 43%の企業がAIガバナンスポリシーを策定済み、**25%**が策定中()。

- アメリカでは**従業員の30%**だけが「自社にAI利用のガイドラインやポリシーがある」と回答()。

- 非営利団体では82%がAIを利用しているのに、**AIポリシーを持つのは10%**だけ()。

- ポジティブな動きとして、77%の企業がAIガバナンス強化に取り組み中。AI活用が進んでいる企業では90%近くに()。

先進企業は、AIの禁止用途や人によるレビュー義務、公平性・透明性へのコミットメントなどをポリシーに盛り込んでいます。まだ未着手なら、法規制や事故が起こる前に早めの対応が必須です。

AIデータプライバシー監査・認証

ポリシーだけじゃなく、監査や認証で「ちゃんとやってる」ことを証明するのも大事。

- 71%の企業がHIPAA、SOC 2、GDPRなどの基準に準拠()。

- **51%**がベンダーに医療データのHIPAA準拠を要求、**45%**がエンドツーエンド暗号化を必須に()。

- 9%の企業だけがAIの公平性やバイアスに関する第三者監査を実施済みですが、今後は規制強化で増加が見込まれます()。

SOC 2、ISO 27001、HITRUSTなどの認証は競争力の源泉。ベンダーは証明書の提示を求められ、発注側もパートナーの信頼性を厳しくチェックする時代です。

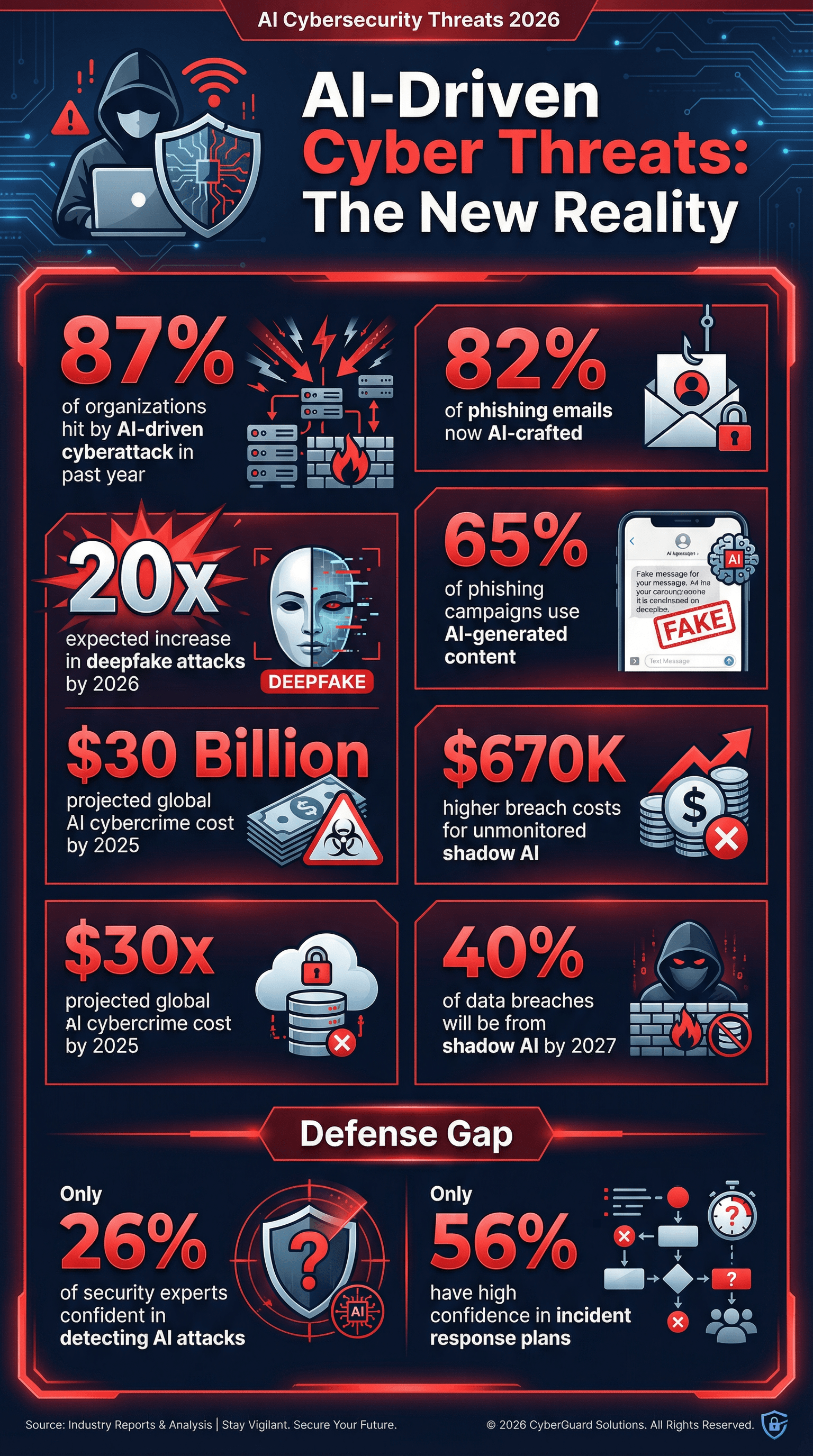

AIサイバーセキュリティ:脅威・インシデント・対策

サーバールームの「象」とも言える話題、AIは攻撃対象であり、同時に攻撃者の武器にもなっています。数字は本当に衝撃的です。

- 87%の企業が過去1年でAIを使ったサイバー攻撃を経験()。

- 65%のフィッシング攻撃がAI生成コンテンツを利用()。

- 82%のフィッシングメールがAIの力で作成されていると推定()。

- ディープフェイク攻撃は2026年までに20倍に増加する見込み()。

- シャドーAI(従業員による無許可AI利用)は拡大中。Gartnerは2027年までに40%のデータ漏洩がAIやシャドーAIの誤用に起因すると予測()。

さらに、セキュリティ専門家で「AI攻撃を高確率で検知できる」と自信を持つのは**26%**だけ()。まるでマジシャンと鬼ごっこしてるようなものです。

AI主導のサイバー攻撃:現場の数字

- 87%の企業が過去12ヶ月でAIを使った攻撃を受けた()。

- フィッシングの高度化: 2025年末には82%以上のフィッシングメールがAI生成()。

- ディープフェイクの急増: 音声・映像のディープフェイク攻撃は2026年までに20倍に。

- シャドーAIのリスク: 2027年までに40%のデータ漏洩がAIやシャドーAIの誤用に起因()。

- 漏洩コストの増大: シャドーAIを監視しない企業は、厳格な管理を行う企業より平均67万ドル高い損失を被っている()。

- 世界的な被害額: AIを使ったサイバー犯罪の被害額は2025年に300億ドルに達する見込み()。

AI生成メールやディープフェイク対策をしていないと、リスクはどんどん高まります。

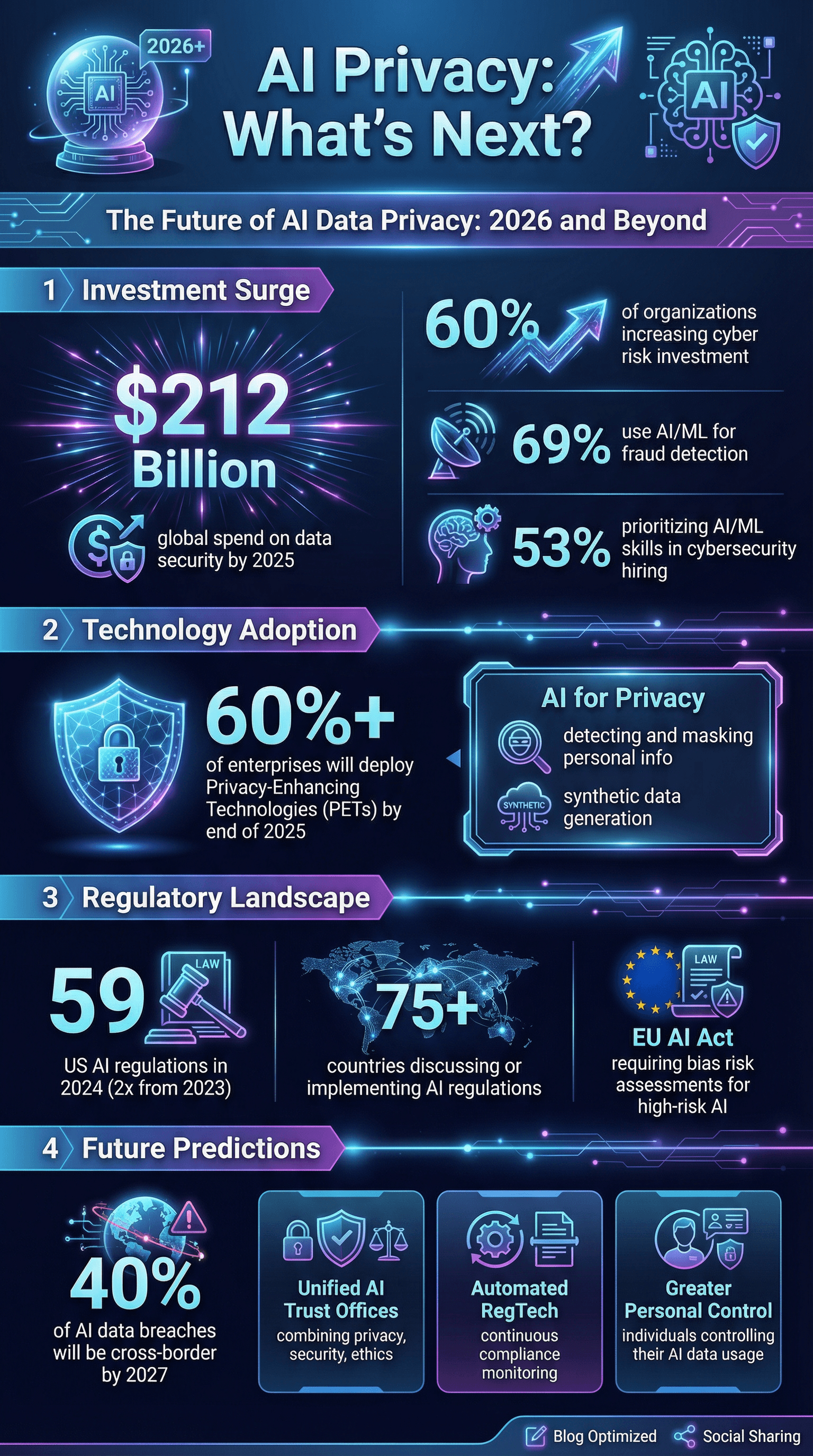

AIサイバーセキュリティへの投資トレンド

明るい話題も。企業はAIサイバーセキュリティへの投資を拡大中です。

- 60%の企業がサイバーリスク対策への投資を増やし、AIがその原動力()。

- **69%**がAIや機械学習を不正検知・防止に活用()。

- **53%**がサイバーセキュリティ人材採用でAI/MLスキルを重視()。

- データセキュリティ・リスク管理の世界市場は2025年に2,120億ドルに到達見込み()。

ただし、56%の企業しかサイバー攻撃へのインシデント対応計画に高い自信を持っておらず、AI特有のシナリオに対応できている企業はさらに少数です。

AIデータガバナンス:教育・監督・バイアス対策

どれだけ技術を入れても、人とプロセスが追いつかなければリスクは残ります。

- 35%の企業だけがAIのプライバシー・セキュリティ・倫理に関する社内研修を実施()。

- **68%**が生成AI研修に投資()。

- **30%**がAIの安全対策として人による監督を重視()。

- **9%**だけがAIの公平性に関する独立監査を実施()。

- **49%**がAIガバナンス強化を進行中(前年は36%)。

バイアスも大きなプライバシー課題。AIが人種や性別などで個人データを不公平に扱えば、法的リスクや社会的批判につながります。46%の経営層が「責任あるAI(公平性含む)」をAI投資の最重要目標としています()。でも、バイアスの測定・対策はまだまだ発展途上です。

AIバイアスと公平性:プライバシーへの影響

- バイアスや安全性に関するAIインシデントは年々急増()。

- バイアス対策で候補者推薦の性別格差が25%減少した企業も。

- 規制圧力も強化。EUのGDPRやAI法案では「高リスクAI」にバイアスリスク評価が義務化される見込み。

AIのバイアス検証を怠れば、イメージダウンだけでなく、訴訟やビジネス損失にも直結します。

ベンダー・エコシステムリスク:統合とサードパーティの影響

どの会社も単独ではやっていけません。多くはベンダーやクラウド、パートナーに頼っていて、そこからもプライバシーリスクが生まれます。

- 54%の企業がコスト削減とデータ露出抑制のためベンダー数を制限()。

- 70%の企業がテクノロジーベンダー選定時にデータプライバシーポリシーを重視。

- **56%**がAIによるサプライチェーン攻撃を懸念()。

今後はベンダー統合、プライバシー管理の強化、パートナーも自社のセキュリティ境界の一部とみなす姿勢が主流になります。

規制・顧客からの圧力:AIデータプライバシーの透明性と開示

規制当局や顧客からの要求もどんどん高まっています。2024年、アメリカでは59件のAI関連規制が発表され、前年の2倍以上。世界では75カ国以上がAI規制を議論・導入済み()。

- 透明性が新常識: 顧客はAI利用の開示を期待しているのに、39%の企業はAI利用を積極的に伝えていません()。

- 監査対応力が必須: HIPAA、SOC 2、AIツールリスト、データ管理体制など、証拠の提示が求められる時代。

- 主要AIモデル開発企業の透明性スコアは半年で37%から58%に向上()。

監査や厳しい顧客アンケートに備えていなければ、2026年のビジネスは乗り切れません。

AIデータプライバシーの未来:これからの流れ

今後の展望と専門家の意見をまとめました。

- プライバシーが競争力に: AIの安全性・プライバシー・倫理性を証明できる企業が顧客の信頼をゲット()。

- 統合ガバナンス: プライバシー・セキュリティ・倫理をまとめて管理する「AIトラスト」部門の設置が進む。

- プライバシー強化技術(PETs): 60%以上の企業が2025年末までにPETs導入を計画()。

- 自動化されたコンプラ: AIの規制対応を自動監視するRegTechツールが必須に。

- 越境データの課題: 2027年までに**AI関連データ漏洩の40%**が越境データの誤用に起因()。

- 個人によるデータ管理の強化: ユーザー自身がAIでのデータ利用をコントロールできるツールが普及。

- AIによるプライバシー保護: AIが個人情報の検出・マスキングや合成データ生成などに活用される。

- インシデント対応とレジリエンス: 予防だけでなく、AIインシデント保険やデータ汚染・モデル破損からの復旧訓練も重視される。

自動化・AIに情熱を持ちつつ、データプライバシーへの警戒心も強い自分としては、今後10年で生き残るのは「プライバシーとセキュリティを本質的価値と捉える企業」だと確信しています。

まとめ:2026年AIデータプライバシー統計から学ぶべきこと

最後に、すぐに実践できるアクションをまとめます。来年の「やらかし事例」にならないために:

- AIデータプライバシーを戦略のど真ん中に。 後付けじゃなく、最初から組み込む。

- AIリスクアセスメントを徹底。 AIシステムやデータフロー、リスクポイントを把握。

- AI特化の教育・ガバナンスに投資。 チームが弱点にならないよう強化。

- AIを意識した技術的防御を強化。 AIでAIを守る、高度な監視・検知ツールを活用。

- ベンダー管理を徹底。 統合・精査・コンプラ証明の要求を強化。

- 透明性を重視。 AIの利用状況を顧客・ユーザーに積極的に開示。

- プライバシー強化技術を導入。 匿名化・暗号化・データ最小化を徹底。

- 最悪の事態に備える。 AIインシデント対応計画を作り、定期的に訓練。

- 法規制や基準の最新動向を常にチェック。 変化の速い規制環境に遅れない。

- 信頼を最優先に。 2026年以降、信頼こそ最大の資産。

参考文献・さらに知りたい人へ

もっと詳しく知りたい、プレゼン用の統計が欲しい人は、以下のリソースもぜひ活用してください。

- )

AIや自動化、データプライバシーの最新情報はや、、のガイドもチェックしてみてください。