インターネット上には数えきれないほどのデータが転がっていて、営業やオペレーション、いろんなビジネス現場で「この情報をどうやって価値あるヒントに変えよう?」と悩んでいる人も多いはず。僕もリード獲得や価格リサーチ、市場分析など、データ収集を自動化したいチームをたくさん見てきたけど、正直、誰だってウェブサイトから手作業でコピペするのは避けたいよね。そんな時に頼りになるのがウェブスクレイピング、そしてこの分野で圧倒的な人気を誇るのがPythonなんだ。

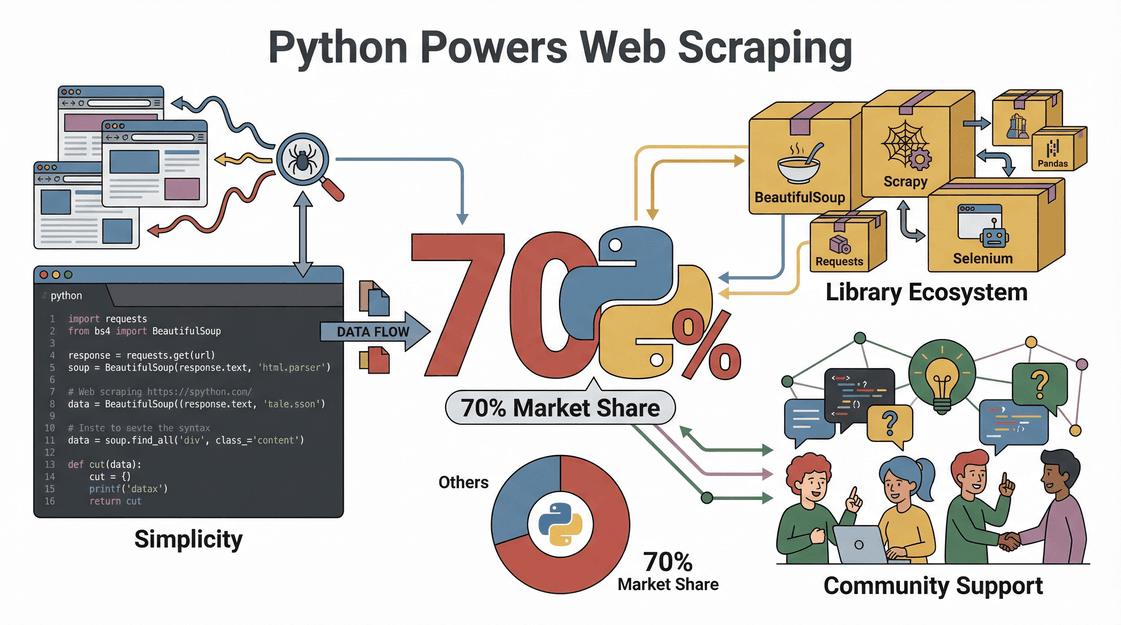

Pythonがウェブスクレイピングで選ばれるのは、ただの流行じゃない。実際、がPythonで作られているんだよ。理由は、直感的で分かりやすい文法、豊富なライブラリ、そして困った時に助けてくれる活発なコミュニティが揃っているから。この記事では、Pythonでウェブスクレイピングを始める方法から、最初のスクリプト作成までをステップごとに解説するよ。もし「コーディングよりクリック派」なら、を使ったもっと手軽なやり方も紹介するから安心して。

ウェブスクレイピングって何?なぜPythonが選ばれるの?

まずは基本から。ウェブスクレイピングは、ウェブサイトから自動でデータを引っ張ってくる技術のこと。イメージとしては、デジタルアシスタントがウェブページから情報をコピーしてスプレッドシートに貼り付けてくれる感じだけど、めちゃくちゃ速くて文句も言わない。ビジネス現場では、など、いろんな場面で活躍してるよ。

じゃあ、なんでPythonがウェブスクレイピングにピッタリなのか?

- 使いやすさ: Pythonは直感的で読みやすいから、プログラミング初心者でも始めやすい。

- ライブラリが豊富: Requests、BeautifulSoup、Selenium、Scrapyなど、HTML解析からJavaScript対応まで幅広くカバー。

- コミュニティが活発: 困った時はStack OverflowやGitHubで解決策がすぐ見つかる。

- 柔軟で速い: 新しいサイトやデータ構造にもすぐ対応できて、小規模から大規模まで幅広く使える。

つまり、Pythonはウェブスクレイピングの万能ツール。パワフルで柔軟、初心者にもやさしいのが魅力だよ。

ビジネスでの価値:Pythonウェブスクレイピングがもたらす成果

ウェブスクレイピングは単なる技術じゃなくて、ビジネスを加速させる武器。実際にPythonでスクレイピングして、企業がどんな成果を出しているか見てみよう。

| 活用例 | Pythonの役割 | ビジネス効果 |

|---|---|---|

| リード獲得 | ディレクトリやLinkedInから連絡先情報を抽出 | CRMに新鮮でターゲットを絞ったリードを自動追加 |

| 価格調査 | ECサイトで競合価格を追跡 | 柔軟な価格戦略で競争力を維持 |

| 市場調査 | レビューや記事、SNS投稿を集約 | トレンドを把握し、データに基づく意思決定が可能に |

| 不動産データ収集 | 複数サイトから物件情報を取得 | 最新の市場データベースを構築 |

| 商品カタログ管理 | 仕入先から仕様や在庫情報を取得 | 在庫更新を自動化し、手作業ミスを削減 |

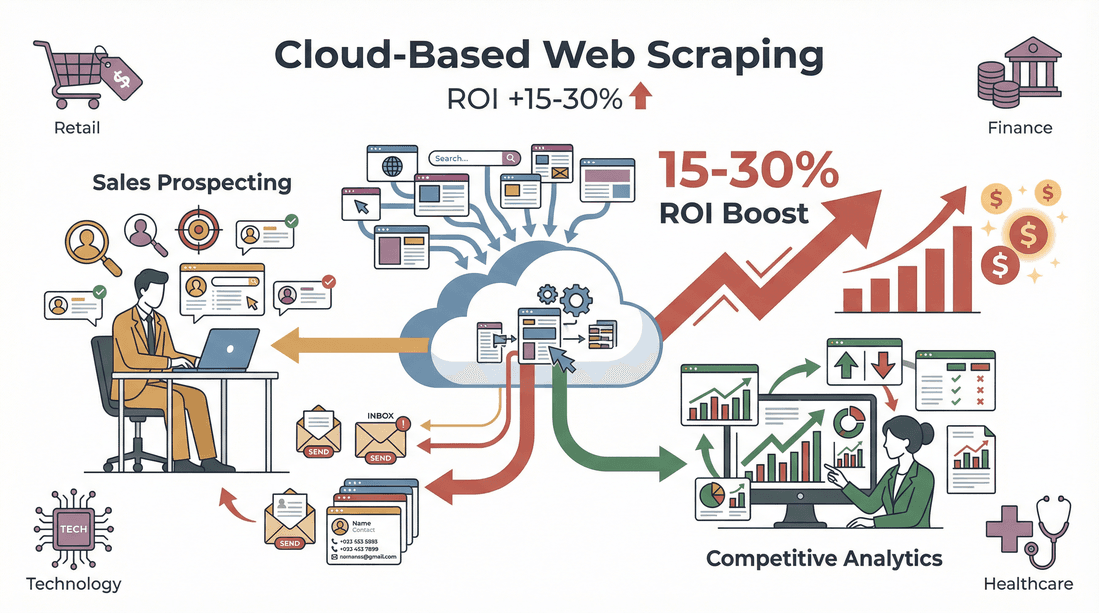

ROI(投資対効果)も見逃せない。あるでは、リード収集の自動化で週8時間の業務削減に成功。業界全体でも、したというデータもあるよ。

Python環境のセットアップ方法

スクレイピングを始める前に、Pythonの環境を整えよう。初心者でも迷わず進める手順を紹介するね。

1. Pythonのインストール

- Pythonをダウンロード: から最新版(3.10以上推奨)をゲット。

- PATHに追加: Windowsなら「Add Python to PATH」にチェックを入れてインストールすれば、コマンドラインからすぐ使えるよ()。

2. 仮想環境の作成

仮想環境を使えば、プロジェクトごとにライブラリを管理しやすい。

1# Windowsの場合

2python -m venv venv

3venv\Scripts\activate

4# Mac/Linuxの場合

5python3 -m venv venv

6source venv/bin/activate3. コードエディタの選び方

- VS Code: 無料で軽くて、拡張機能も豊富。

- PyCharm: 大規模プロジェクト向きで、賢い補完機能あり。

- Jupyter Notebook: 実験やデータ可視化にピッタリ。

4. トラブルシューティングのコツ

- Pythonコマンドが動かない時はPATH設定を再確認。

- 権限エラーが出たら、管理者権限でターミナルを起動。

- MacならXcodeコマンドラインツール(

xcode-select --install)が必要なことも。

Pythonで使えるウェブスクレイピング用ライブラリ

Pythonの強みはライブラリの多さ。代表的なライブラリと用途をまとめてみたよ。

| ライブラリ | 得意分野 | 使いやすさ | 速度 | JavaScript対応 | 拡張性 |

|---|---|---|---|---|---|

| Requests | ウェブページの取得(HTTP通信) | 簡単 | 速い | なし | 良い |

| BeautifulSoup | HTML/XMLの解析 | 非常に簡単 | 普通 | なし | 良い |

| lxml | 高速なXML/HTML解析 | 普通 | 非常に速い | なし | 良い |

| Selenium | 動的サイトの操作 | 普通 | 遅い | あり(ブラウザ操作) | 中程度 |

| Scrapy | 大規模・自動化スクレイピング | 普通 | 非常に速い | 一部/あり | 優秀 |

- RequestsはシンプルなHTTPリクエストに最適。

- BeautifulSoupは初心者にも扱いやすく、HTML解析に便利。

- lxmlは大量データの高速処理向きだけど、ちょっと上級者向け。

- Seleniumは実際にブラウザを動かして、JavaScriptで生成されるデータも取れる。

- Scrapyは大規模なクローリングや自動化にピッタリなフレームワーク。

初心者にはRequests+BeautifulSoupの組み合わせが特におすすめ()。

実践:Pythonでウェブスクレイピングをやってみよう

ここでは、架空のECサイトから商品データを取ってくる例で、実際の流れを解説するよ。

1. サイト構造の確認

ブラウザの開発者ツール(F12キーや右クリック→検証)で、欲しいデータ(商品名、価格、評価など)がどのHTML要素に入っているかチェック。この作業が後のコーディングの精度を左右するよ()。

2. HTTPリクエストの送信

Requestsでページを取得。

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. BeautifulSoupでHTML解析

必要なデータを抜き出す。

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. データの抽出と整形

各商品ごとに詳細情報をゲット。

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # 計算用に価格を整形

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. データをCSV/Excelに出力

Pandasを使って結果を保存。

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

これで、分析やCRMへのインポートに使える構造化データが完成!

動的コンテンツやページネーションへの対応

すべてのウェブサイトが静的とは限らない。JavaScriptでデータが後から読み込まれたり、複数ページに分かれている場合もある。そんな時の対処法を紹介するよ。

動的コンテンツのスクレイピング

データが取れない時は、JavaScriptで動的に生成されている可能性あり。そんな時はSeleniumを使おう。

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# 以降はBeautifulSoupで解析()

ページネーションの処理

複数ページにまたがる場合は、ページ番号や「次へ」ボタンをループで処理。

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # 以降は同様に解析()

大規模なクロールにはScrapyが便利()。

取得データの活用方法

データが集まったら、次は活用しよう。

- CSV/Excelへのエクスポート: Pandasで簡単に出力できる。

- データのクレンジング: 重複除去や表記ゆれの修正、フォーマット統一など()。

- 業務フローへの統合: SalesforceやHubSpotなどのCRM、分析ツールへのインポートもOK。Pythonスクリプトで自動化もできる。

Thunderbit:ビジネスチームのためのPythonウェブスクレイピング簡単化ツール

正直、Pythonは強力だけど、コーディングに慣れてない人にはハードルが高いことも。そこで登場するのが。は、ビジネスユーザーでも手軽にデータ抽出できるように作られてるよ。

Thunderbitが営業・オペレーションチームに選ばれる理由:

- AIフィールド自動認識: 「AIでフィールドを提案」をクリックするだけで、ページ内の項目(名前、価格、メールなど)を自動で抽出・設定。

- サブページの自動取得: 商品詳細やLinkedInプロフィールなど、各サブページも自動で巡回してテーブルに情報を追加。

- ページネーション・動的コンテンツ対応: 複数ページや無限スクロールもノーコードで処理。

- すぐ使えるテンプレート: Amazon、Zillow、Shopifyなど人気サイトはテンプレートを選ぶだけ。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notionへワンクリックで出力。

- メンテナンス不要: ThunderbitのAIがサイト構造の変化にも自動対応。スクリプト修正の手間なし。

「データが欲しいけど、どう始めればいいかわからない」って人でも、5分以内にスプレッドシートが完成することも。しかももあるから、気軽に試せるよ。

ThunderbitとPythonの組み合わせで最強のデータ収集環境を実現

データ分析や業務自動化にこだわるなら、ThunderbitとPythonの併用がイチオシ。僕がよくやる流れはこんな感じ:

- Thunderbitでデータ抽出: 複雑なサイトや初見のサイトでも、CSVやExcel形式ですぐデータをゲット。

- Pythonで加工・分析: Pandasなどでデータをクレンジング・分析・自動処理。

- 業務フローの自動化: Thunderbitで定期的にデータを取得し、Pythonスクリプトで自動アップロードや通知も実現。

このハイブリッドなやり方なら、スピードと柔軟性を両立できて、毎回ゼロから作り直す手間も省けるよ。

ウェブスクレイピングの法的・倫理的注意点

「ウェブスクレイピングって合法なの?」とよく聞かれるけど、ルールを守れば基本的に問題なし。

- robots.txtや利用規約を確認: サイトによってはスクレイピング禁止の場合もあるから、必ず事前にチェックしよう()。

- 個人情報や著作権データは避ける: 公開されている事実情報だけを対象に。

- リクエストの間隔を空ける: サーバーに負荷をかけないよう、適切な間隔やレート制限を守ろう()。

- プライバシー法令を遵守: メールアドレスや個人情報を扱う場合は、GDPRやCCPAなどの規制に注意()。

Thunderbitは、ブラウザで表示されている範囲だけを対象にして、サイトの制限も守りやすい設計になってるよ。

Pythonウェブスクレイピングのトラブル対策とベストプラクティス

どんなに優秀な웹 스크래퍼でも、トラブルはつきもの。僕が実践しているチェックリストを紹介するね。

- リクエストがブロックされる: ユーザーエージェントの変更、プロキシの利用、リクエスト間隔の調整()。

- HTML解析で失敗: セレクタの指定ミスや、サイト構造の変更に注意。

- データが取得できない: 動的コンテンツの場合はSeleniumを検討。

- Captchaやログイン制限: ボット対策が厳しいサイトは、手動取得や他の方法も検討。

ベストプラクティス:

- まずは少量データでテストしてから本格運用。

- エラーはログに記録し、例外処理も丁寧に。

- サイトのルールを守り、機密データや制限付き情報は避ける。

- コードは分かりやすく、再利用しやすい形で管理。

- 定期的なメンテナンスも忘れずに()。

まとめ・ポイント

Pythonによるウェブスクレイピングは、現代ビジネスの強力な武器。ポイントをおさらいしよう:

- Pythonはウェブスクレイピングの定番。使いやすさ、強力なライブラリ、活発なコミュニティが魅力。

- 基本の流れはシンプル:サイト構造の確認→ページ取得→HTML解析→データ抽出・整形→CSV/Excel出力。

- Thunderbitならノーコードで簡単。フィールド自動認識やサブページ抽出、データ出力も数クリックで完了。

- ThunderbitとPythonの併用で最強。素早い抽出と高度なデータ処理を両立。

- 法令・倫理を守ることが大切。サイトのルールや個人情報の扱いには十分注意しよう。

さあ、Pythonでスクレイピングにチャレンジしてみない?「コードは苦手…」という人は、して、ウェブデータ収集の手軽さを体感してみて。さらに詳しいノウハウはでも紹介してるよ。

よくある質問(FAQ)

1. ウェブスクレイピングって何?なぜPythonが人気なの?

ウェブスクレイピングは、ウェブサイトから自動でデータを取得する技術。Pythonは、読みやすい文法や強力なライブラリ(RequestsやBeautifulSoupなど)、初心者から上級者まで支える大規模なコミュニティがあるから特に人気()。

2. Pythonでウェブスクレイピングする時のおすすめライブラリは?

多くの場合、Requests(ページ取得)とBeautifulSoup(HTML解析)の組み合わせが基本。動的サイトにはSelenium、大規模・複雑な案件にはScrapyもおすすめ()。

3. ThunderbitとPythonのウェブスクレイピングの違いは?

ThunderbitはAI搭載のChrome拡張機能で、2クリックでデータ抽出が可能。コーディング不要でビジネスユーザー向き。一方、Pythonはカスタマイズ性や大規模処理に強みがある()。

4. ウェブスクレイピングは合法?

公開データだけを対象にして、robots.txtや利用規約を守り、個人情報や著作権データを避ければ、基本的に合法。必ず事前にサイトのルールを確認しよう()。

5. ThunderbitとPythonを組み合わせて高度なワークフローを作るには?

Thunderbitで構造化データを素早く抽出し、CSVやExcelでエクスポート。その後、Python(Pandasなど)でデータのクレンジングや分析、自動処理をすれば、両方の強みを活かせる。

ウェブをビジネスの最強データソースに変えたい人は、ぜひPythonとThunderbitを試してみて。

さらに詳しく知りたい人へ