正直なところ、初めて競合分析のためにGoogle検索結果を集めようとしたとき、「これくらい楽勝だろう」と思ってたんですよ。でも、数時間後にはPythonスクリプトのエラーやプロキシの問題、Googleから「異常なトラフィックを検出しました」って警告が出て、コーヒーはすっかり冷めてるし、イライラしながらもデータは全然スプレッドシートにまとまらない…そんな経験ありませんか?

SEOや営業リスト作成、データ好きの好奇心でGoogle検索結果から構造化データを取り出そうとしたことがある人なら、この苦労はきっと身に覚えがあるはず。Googleはし、と圧倒的。もしこのデータを手に入れられたら、リアルタイムで市場の動きが丸わかり。でも、従来のスクレイピングはコードやメンテ、Googleのボット対策など、まるで迷路みたいな障壁だらけ。でも2025年には、みたいなノーコード・AI搭載ツールのおかげで、Google検索 スクレイピングが誰でもサクッとできる時代になりました。

それじゃあ、ノーコードでストレスフリー、冷めたコーヒーともお別れできるGoogle検索結果 スクレイピングのやり方を紹介します!

Google検索結果のウェブスクレイピングって何?

まずは基本から。Google検索結果のウェブスクレイピングは、Googleの検索結果ページ(SERP)からタイトルやURL、スニペットなどの構造化データを自動で抜き出すこと。つまり、青いリンクや説明文を手作業でコピペする面倒を、爆速で自動化するイメージです。

Googleスクレイピングが、商品カタログやニュースサイトのスクレイピングと違うのはどこ?GoogleのSERPはめちゃくちゃ動的で、いろんな要素が混ざってます:

- オーガニック検索結果(青いリンクとスニペット)

- 広告(「広告」と表示されるやつ)

- 「他の人はこちらも質問」ボックス

- 強調スニペット

- 地図・画像・動画・ショッピング結果

これら全部、ツールが賢ければデータとして抽出OK。ただし、Googleの検索結果は分単位で変わるし、同じキーワードでも場所や検索履歴で表示内容が違う()。つまり、Google検索 スクレイピングはただHTMLを取るだけじゃなく、常に変化する非構造データをきれいな表に変換する作業なんです。

ビジネスでGoogle検索結果をスクレイピングする理由

なんでわざわざGoogleをスクレイピングするの?それは、GoogleのSERPが「今、世界が何に注目してるか」をリアルタイムで映す鏡だから。トレンド、SEOの勝者、競合の動き、新しい顧客候補まで、全部ここに現れるんです。

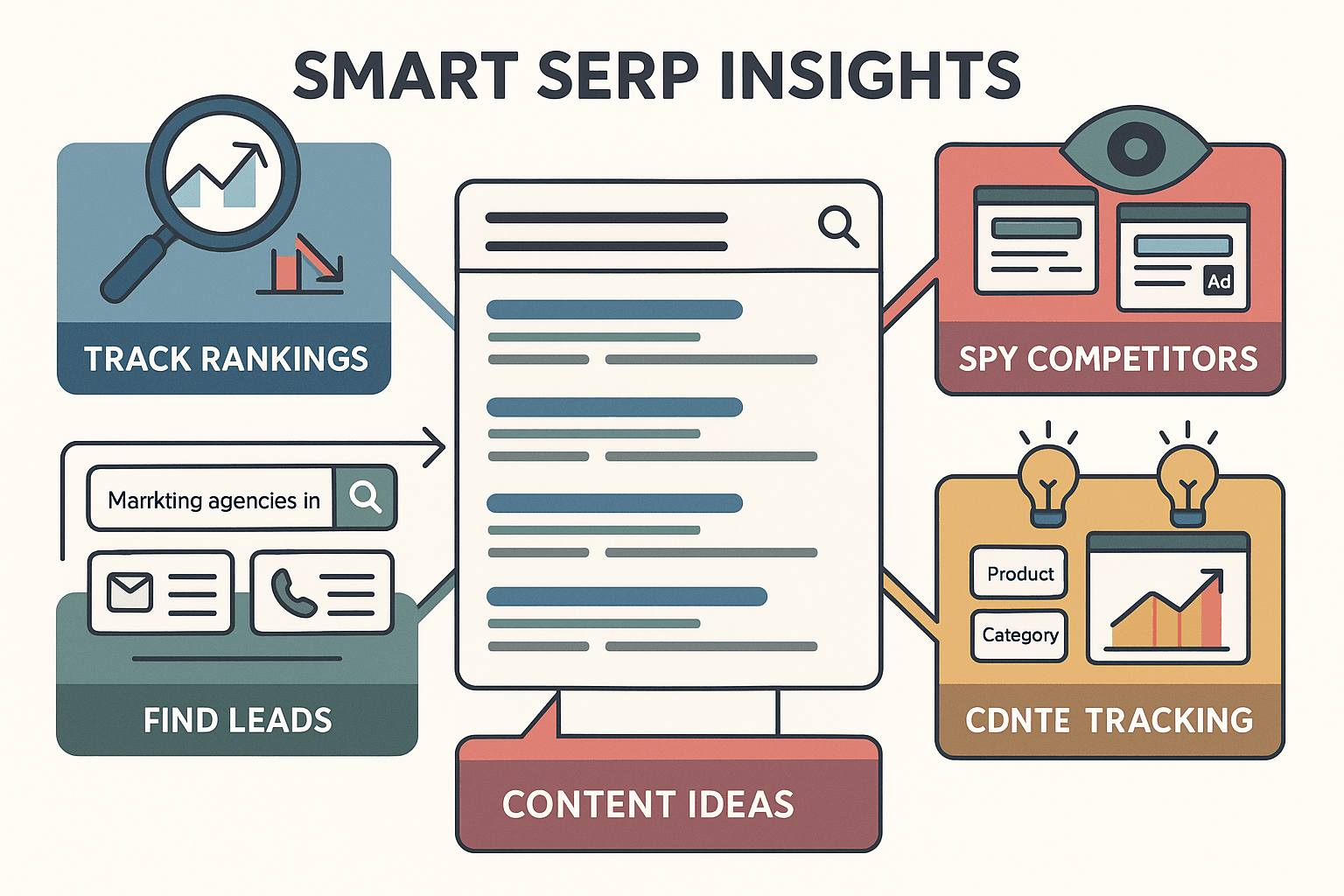

実際に多くの会社で使われてる主な用途はこんな感じ:

- SEOモニタリング・キーワード順位追跡: 上位表示や競合の動き、SERPの特徴を分析して新しいコンテンツのチャンスを発見()。

- 競合分析: どの競合がどのキーワードで強いか、タイトルや説明文、広告コピーの傾向も丸わかり。

- リード獲得: 「大阪のマーケティング会社」みたいな検索ワードでリストを抽出して、連絡先もゲット()。

- コンテンツ戦略: 「他の人はこちらも質問」や上位見出しを抜き出して、トレンドやよくある質問をリサーチ()。

- 市場調査: SERPの変化から消費者の関心や新しいテーマの台頭をキャッチ()。

Googleスクレイピングの主な活用例をまとめると:

| ユースケース | 主な利用者 | 得られる価値 |

|---|---|---|

| SEOパフォーマンス追跡 | SEO担当者、マーケター | キーワード順位の監視、競合分析、コンテンツ改善、強調スニペットやPAA対策 |

| 競合リサーチ | マーケティング、戦略担当 | 競合の露出状況、メッセージ、広告戦略の分析 |

| リード獲得 | 営業、事業開発 | 見込み顧客リストの作成、SERPやリンク先からメール・電話番号抽出 |

| コンテンツ戦略 | コンテンツ担当、編集者 | トレンドや人気の質問、上位コンテンツのリサーチ |

| 市場・トレンド分析 | プロダクトマネージャー、アナリスト | 検索トレンドの追跡、新テーマの発見、商品開発やポジショニングの指針 |

| 広告モニタリング | PPCマーケティングチーム | 競合広告の収集、入札や広告文の最適化、広告表示状況の追跡 |

さらに、オペレーションやPR、カスタマーサポート部門でも、SERPデータを使って自社の掲載状況チェックやブランド監視、業界の話題チェックなどにも活用できます。要するに、Google検索データを使わないのは、競合がすでに手にしてるインサイトを自分だけ見逃してるのと同じです。

スクレイピング手法の比較:ノーコード vs コーディング vs API

実際にGoogleのデータを取るには、主に3つの方法があります:

- ノーコードツール(Thunderbitなど): 直感的な操作でAIが自動化、エンジニアじゃなくてもOK。

- 自作コーディング(Python, BeautifulSoup, Selenium): 柔軟性は高いけど、構築や保守が大変。

- SERP API(Google公式やサードパーティ): 大規模運用に最適だけど、技術力とコストが必要。

それぞれの特徴をまとめると:

| 方法 | 使いやすさ | セットアップ・保守 | コスト | 柔軟性・スケール |

|---|---|---|---|---|

| ノーコードツール(Thunderbit) | 最も簡単 | 最小限、自動アップデート | 無料枠あり、追加はクレジット制 | 標準用途・中規模まで最適 |

| 自作コーディング | 難易度高い | 頻繁な保守が必要 | ライブラリは無料だが開発工数がかかる | 柔軟性は最高、インフラ構築で大規模化可 |

| SERP API | 普通 | 保守は不要(提供元が管理) | リクエストごとに課金、コスト増大 | 大規模対応可、APIの項目に制限あり |

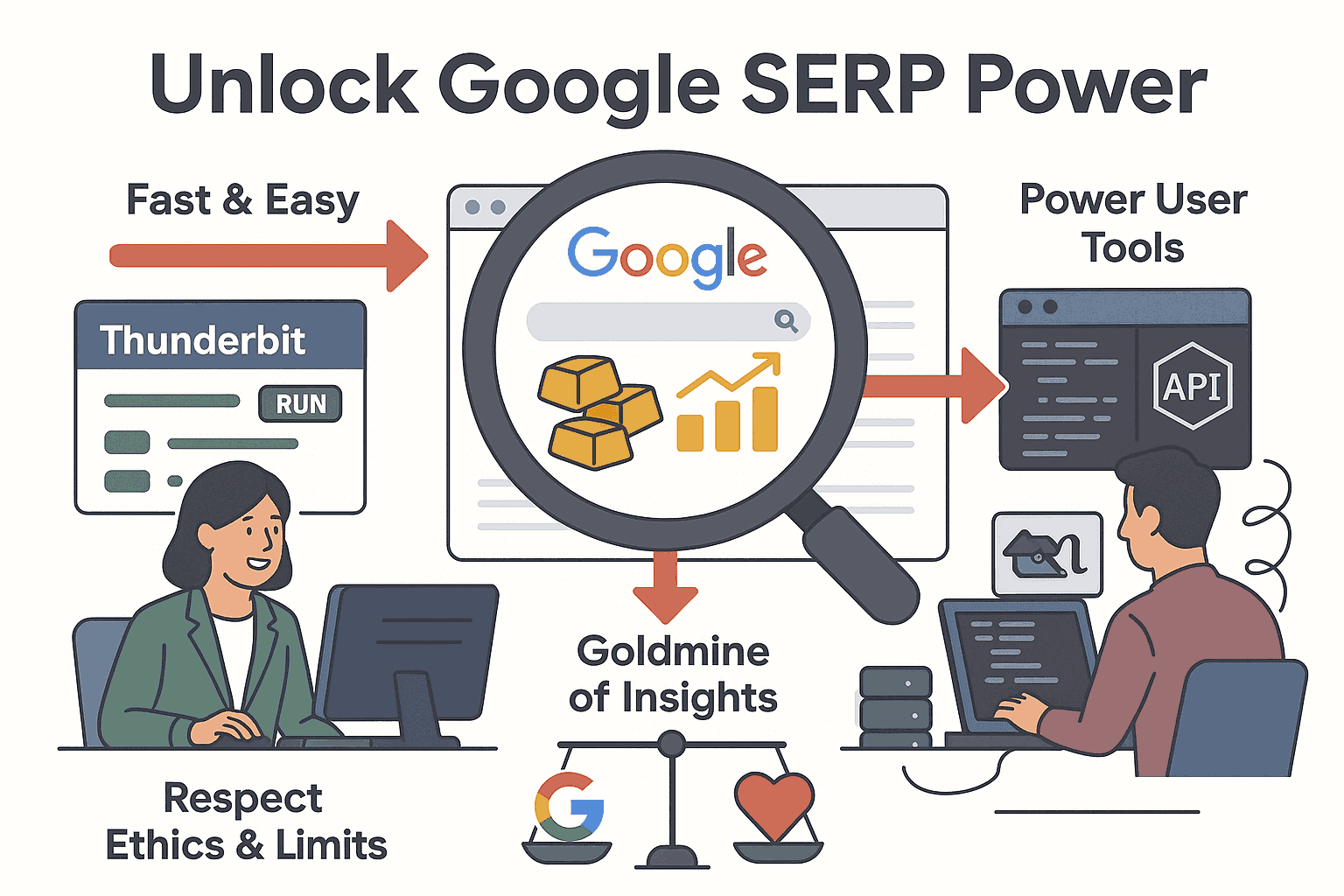

多くのビジネスユーザーにとっては、ノーコードツールが一番早くて手っ取り早く価値を生み出せます。コーディングは技術者や開発チーム向け、APIはSEOプラットフォームなど大量自動化が必要な場合におすすめです。

Thunderbit:ノーコード・AI搭載のGoogleスクレイピングソリューション

Thunderbitは、AIウェブスクレイパーをChromeブラウザに直接組み込める。主なポイントは:

- AIフィールド自動検出: ThunderbitのAIがGoogle検索ページを解析して、タイトル・URL・スニペット・広告・PAAなど抽出対象を自動で提案。CSSセレクタやXPathの知識は一切不要。

- サブページスクレイピング: 各検索結果のリンク先にも自動でアクセスして、メールアドレスや商品情報など追加データも取得OK。

- ページ送り自動化: 「次へ」ボタンを自動でクリックして、複数ページ分のデータも一括取得。

- 即時エクスポート: Excel、Googleスプレッドシート、Notion、Airtableへワンクリックで出力。

- 多言語対応: 34言語に対応して、世界中のSERPを抽出可能。

- クラウド・ブラウザ両対応: 最大50ページ同時処理のクラウドモード、ログインや地域指定が必要な場合はブラウザモードも選択OK。

何よりすごいのは、「このデータが欲しい」と思ってから実際に手に入るまで2分もかからないこと。コードも設定ファイルも不要、スクリプトのエラーに悩まされることもありません。

従来のコーディング手法:Pythonスクリプトやカスタムパーサー

開発者や技術好きなら、PythonやBeautifulSoup、Seleniumなどを使う選択肢もありますが、現実はこんな感じ:

- セットアップが大変: GoogleのHTML取得、パース、ページ送り、データ保存まで全部自作が必要。

- 保守が頻繁: GoogleのHTML構造はしょっちゅう変わるので、スクリプトがすぐ壊れる。デバッグ必須。

- ボット対策: Googleはボット検出が超厳しくて、CAPTCHAやIPブロック、「異常なトラフィック」エラーが頻発。プロキシや遅延、CAPTCHA回避も必要。

- 柔軟性は高いけど手間も多い: 何でも抽出できるけど、保守にめちゃくちゃ時間がかかる。

日常的にスクレイピングを業務にしてる人や、特殊な要件がある場合以外は、プロ向けの方法です()。

Google SERP APIの活用:メリット・デメリット・コスト

大規模運用ならAPIが便利。Google公式のやサードパーティAPIもたくさんあります。

- メリット: CAPTCHAやIPローテーション、パース処理など面倒な部分をAPI側が全部自動対応。クエリを送るだけで構造化データが返ってきます。

- デメリット: APIは基本有料。例えばSerpAPIは5,000検索で月約75ドル()、Zenserpは5,000検索で約29ドル()。大量に使うとコストが膨らみます。

- 技術力が必要: API呼び出しやデータ処理のスクリプト作成は必須。

- 項目制限: APIで取れるデータ項目は限られてます。

APIはエンタープライズ規模の自動化に最適だけど、一般的な用途やスポット的なスクレイピングならノーコードツールの方が手軽でコストも抑えられます。

ThunderbitでGoogle検索結果をスクレイピングする手順

どれだけ簡単か、Thunderbitを使ったGoogle検索結果 スクレイピングの流れを紹介します。

ステップ1:Thunderbitをインストール・セットアップ

まずはをインストール。30秒くらいで完了、Googleアカウントやメールでログインすれば準備OK。34言語対応なので、どの国のSERPも抽出できます。

ステップ2:Google検索でキーワードを入力

Chromeでgoogle.comを開いて、例えば「2025年おすすめCRMソフト」など検索ワードを入力してEnter。検索結果ページが全部表示されるのを確認。特定の国や言語の結果が欲しい場合は、Googleの設定やVPNを使ってください。

ステップ3:AIフィールド自動検出でSERPデータを抽出

ブラウザのThunderbitアイコンをクリックして、ThunderbitパネルでAIフィールド自動検出を選択。AIがページを解析して、タイトル・URL・スニペットなどの抽出項目を提案してくれます。不要な項目は削除、必要なら追加や名前変更もOK。「他の人はこちらも質問」や広告見出しも追加できます。

各フィールドごとにカスタムAI指示も設定できるけど、普通のGoogle検索ならデフォルト提案で十分。

ステップ4:Google検索結果を抽出・プレビュー

スクレイピングをクリックすると、Thunderbitがデータを抽出して表形式で表示。各検索結果が1行、タイトル・URL・スニペットなどが列に並びます。内容を確認して、必要に応じて項目を調整して再実行もOK。

ステップ5:Excel・Googleスプレッドシート・Notion・Airtableへエクスポート

エクスポートをクリックして、好きな形式を選択。Excel/CSVでダウンロード、クリップボードコピー、または、Notion、Airtableへ直接送信もOK。無料プランでもエクスポート制限なし、追加料金も不要。

これでSERPデータがスプレッドシートにまとまり、分析やグラフ化、チーム共有もすぐできます。

ステップ6:応用テクニック – ページ送り・サブページ・スケジューリング

1ページ目だけじゃなく複数ページを取りたい場合は、Thunderbitの設定でページ送りを有効化。「次へ」を自動クリックして、指定したページ数分を一括抽出できます。各検索結果のリンク先から追加情報を取りたい場合は、サブページスクレイピングでメールや価格情報なども自動収集。

さらに、特定のSERPを定期的に監視したい場合は、Thunderbitのスケジューリング機能が便利。「毎朝9時に」みたいに自然な日本語でスケジュールを指定すれば、ブラウザを閉じてても自動でスクレイピングが実行されます。

Googleスクレイピングの注意点とベストプラクティス

たくさんのSERPをスクレイピングしてきた経験から、いくつかアドバイスを:

- Googleの利用規約を守る: Googleは自動スクレイピングを禁止してます。小規模な社内利用なら問題になりにくいけど、大量・商用利用は公式APIを使いましょう()。

- Googleに負荷をかけない: 人間っぽいペースで抽出しましょう。大量ページ取得時はThunderbitのクラウドモードでリクエストを分散。CAPTCHAが出たら手動で対応、またはペースを落としてください。

- 検索環境を統一: Googleは位置情報や検索履歴で結果をパーソナライズします。データの一貫性を保つには、シークレットモードや地域・言語指定を活用しましょう。

- データのクレンジング: 抽出後は重複除去や書式修正、タイムスタンプ追加などをやると分析が楽になります。

- 倫理的に利用: メールアドレスなど個人情報を扱う場合はGDPRなどの法令を守って。戦略立案のために活用し、スパムやコンテンツ盗用はNG。

もっと詳しいベストプラクティスはもチェックしてみてください。

Thunderbitと他のGoogleスクレイピング手法の使い分け

どの方法が自分に合ってるか迷ったら、次の基準で選んでみて:

- Thunderbit(ノーコードAI): 非エンジニアやスポット利用、中規模までの用途に最適。思い立ったらすぐデータ化したい人におすすめ。

- 自作コーディング: 独自ロジックや深い連携、特殊な要件がある場合向け。保守に時間をかける覚悟が必要。

- SERP API: 大量自動化やSEOプラットフォームなど、毎日数千キーワードを追跡する場合に最適。スクリプト作成やAPIコストも考慮しましょう。

多くのチームは、まずThunderbitでサクッとインサイトを得てから、必要に応じてAPIや自作コードに移行しています。用途・スキル・予算に合わせて最適な方法を選びましょう。

まとめ・ポイント

昔はGoogle検索結果のスクレイピングって技術者だけの世界だったけど、2025年にはノーコードで2分あれば誰でもできる時代に。を使えば、GoogleのSERPをSEO・営業・マーケティングなど色んなビジネスデータに変換できます。

覚えておきたいポイント:

- Google SERPデータはビジネスインサイトの宝庫。 使わないのはもったいない!

- ThunderbitみたいなノーコードAIツールなら、誰でも高速・正確・ノーコードでスクレイピング可能。

- 従来のコーディングやAPIも高度な用途では有効だけど、多くのビジネスにはノーコードが最適解。

- 責任を持ってスクレイピングを: Googleの規約を守り、サーバーに負荷をかけず、データは倫理的に活用しよう。

次にGoogle検索データが必要になったら、スクリプトじゃなくThunderbitを試してみて。コーヒーは熱いまま、データはきれいに整い、本当に大事な「インサイト活用」に時間を使えます。

ウェブスクレイピングやリストクロール、Excelへのデータ出力についてもっと知りたい人はもぜひチェック。Google検索結果のスクレイピングを今すぐ始めたい人は、してみてください。

ノーコードで、快適なスクレイピングを!

よくある質問(FAQ)

1. Google検索結果をスクレイピングするとは?

Google検索結果のスクレイピングは、検索エンジンの結果ページ(SERP)からタイトル・URL・スニペット・広告・PAAボックスなどの構造化データを抜き出すこと。これで、バラバラなウェブページを分析しやすいデータセットに変換して、SEO追跡や競合調査、リード獲得などに活用できます。

2. Google検索データのスクレイピングは合法ですか?

個人や社内利用の範囲でGoogleをスクレイピングするケースは多いけど、Googleの利用規約では自動データ抽出は禁止されてます。大規模・商用利用の場合は公式APIの利用が推奨。個人情報を扱うときはGDPRなど各国の法令も守りましょう。

3. Thunderbitみたいなノーコードツールを使うメリットは?

Thunderbitみたいなノーコードツールなら、プログラミング不要でGoogleを簡単にスクレイピングできます。主なメリットは:

- AIによるフィールド自動検出(タイトル・URL・スニペットなど)

- サブページやページ送りにも対応

- Excel・Googleスプレッドシート・Notion・Airtableへ出力OK

- セットアップや保守が不要 ビジネスユーザーが素早く正確なSERPデータを得るのにぴったりです。

4. ThunderbitとPythonスクリプトやSERP APIの違いは?

ThunderbitはPythonスクリプトよりも簡単・高速で、コーディングや保守の手間がありません。SERP APIと比べても、スポット利用や中規模用途ならThunderbitの方が手軽。APIは大規模自動化に向いてます。

5. スクレイピングしたGoogleデータはどう活用できますか?

抽出したSERPデータは、

- SEOモニタリング: キーワード順位や強調スニペットの追跡

- 競合分析: 競合の検索表示状況の分析

- リード獲得: ビジネス検索から連絡先リスト作成

- コンテンツ戦略: トレンドや人気質問の発見

- 市場調査: 検索トレンドや消費者関心の変化把握 など、マーケティング・営業・商品開発など幅広い意思決定に役立ちます。

さらに詳しく知りたい方へ: