インターネットの世界には、想像を超えるほどのデータが溢れています。2024年には、世界中のデジタルデータ量がに到達したと言われていて、しかもこの2年で世界のデータの90%以上が生まれたというから驚きです。ビジネスの現場では、次のヒットやリード、競争優位のヒントが、きっとどこかのウェブ上に眠っています――それを手に入れられれば、の話ですが。

そこで頼りになるのがウェブスクレイピング。営業やEC、マーケティングリサーチなど、ウェブ上のデータを自動で集めて整理できれば、ビジネスの武器になります。プログラミング初心者でも大丈夫。Pythonなら、ウェブスクレイピングがびっくりするほど簡単に始められます。このガイドでは、環境構築からデータのクレンジングまで、ひとつずつ丁寧に解説。さらに、を使ったノーコードでの爆速スクレイピング方法も紹介します。

Pythonウェブスクレイピングって何?

まずは基本から。ウェブスクレイピングは、ウェブサイトからデータを自動で抜き出す技術のこと。たとえば、ネットショップの商品価格を一覧で取得したい、ディレクトリからリードリストを作りたい、競合のニュースを定期的にチェックしたい――そんな時、手作業でコピペしていたらキリがありません。ウェブスクレイピングなら、スクリプトがその作業を一気に自動化してくれます。

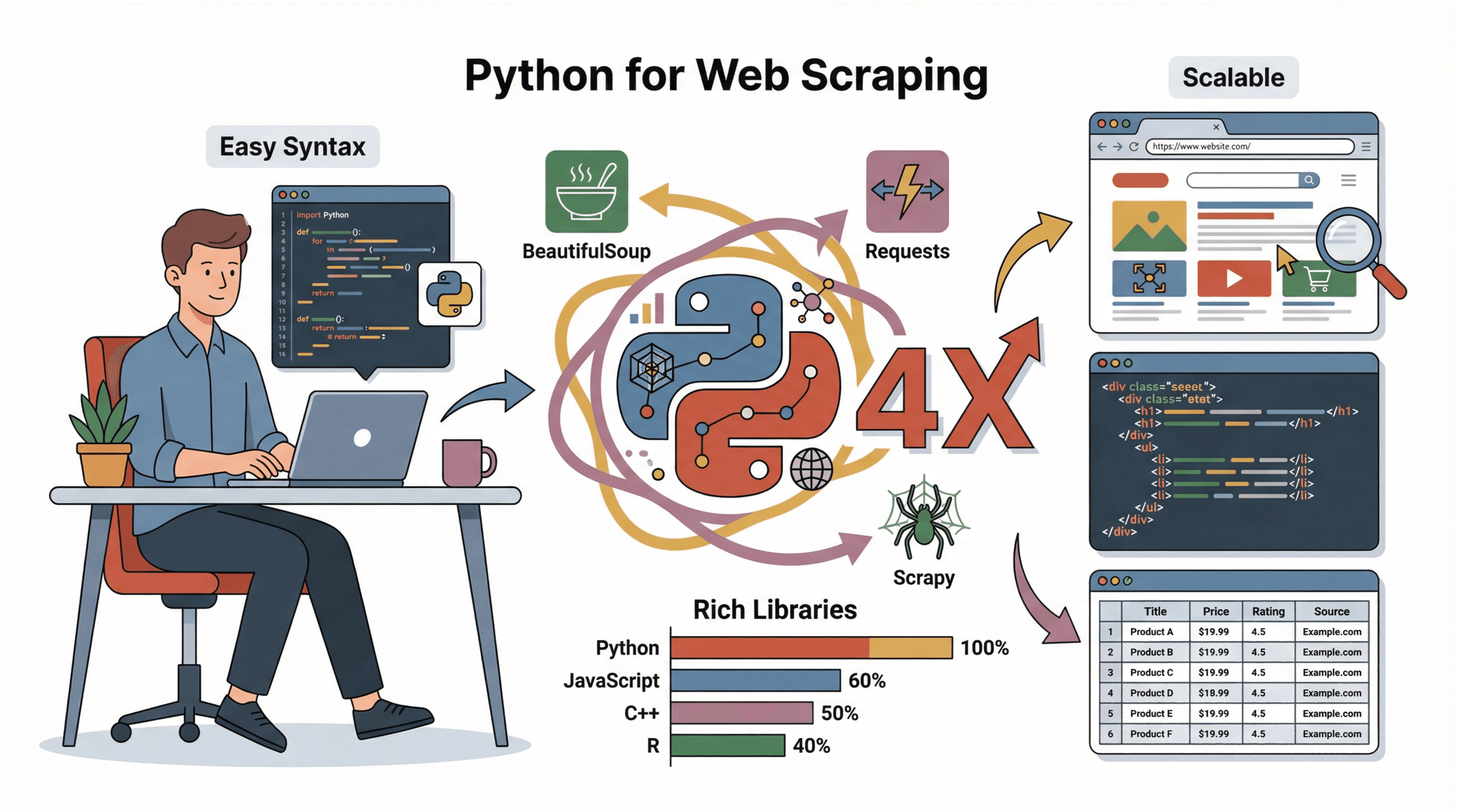

Pythonウェブスクレイピングは、その自動化をPythonというプログラミング言語で実現する方法。Pythonはシンプルな文法と豊富なライブラリが魅力で、プログラミング経験が少なくても扱いやすいのが特徴です。ウェブページの取得、内容の解析、データの保存まで、短時間で実装できます。

ビジネス現場での活用例:

- リード獲得:ディレクトリやレビューサイトから見込み顧客リストを作成

- 価格調査:競合商品の価格や在庫状況を自動でチェック

- 市場調査:ニュース、レビュー、SNSの言及を集約

- 業務効率化:サプライヤー情報、求人情報、不動産リストの収集

つまり、ウェブ上にあるデータなら、Pythonでサクッと大量に取得できるというわけです。

なぜウェブスクレイピングにPythonが最強なのか

自分もいろんな言語でスクレイピングを試してきました(「なんで動かないんだ!」と何度も頭を抱えたことも…)。その中でもPythonがダントツで使いやすい理由はコレ:

自分もいろんな言語でスクレイピングを試してきました(「なんで動かないんだ!」と何度も頭を抱えたことも…)。その中でもPythonがダントツで使いやすい理由はコレ:

- 初心者にやさしい:直感的で読みやすい文法だから、プログラミング未経験でも始めやすい

- ライブラリが豊富:、、など、データ取得・解析・保存が簡単

- コミュニティが充実:困った時はチュートリアルやフォーラム、サンプルコードが山ほどある

- 拡張性・スケーラビリティ:小さなスクリプトから大規模なプロジェクトまで幅広く対応

JavaScriptやC++、Rと比べても、Pythonは手軽さとデータ分析のしやすさで頭ひとつ抜けています(参照)。だからこそ、初心者から大企業まで幅広く選ばれているんです。

スクレイピング環境の準備:Pythonセットアップ手順

スクレイピングを始めるには、まずPython本体と必要なライブラリをインストールしましょう。初めてでも大丈夫、以下の手順で進めてみてください:

-

Pythonのインストール:

- から最新版をダウンロード

- Windowsなら「Add Python to PATH」にチェックを入れてインストール

- Macはで

brew install python3 - Linuxは

sudo apt install python3 python3-pipなどパッケージマネージャーを利用

-

pip(パッケージ管理ツール)の確認:

- 通常はPythonと一緒にインストールされます。

pip --versionで確認 - 見つからない場合は、インストーラーを再実行するか

python -m ensurepip --upgradeを試す

- 通常はPythonと一緒にインストールされます。

-

仮想環境の作成(おすすめ):

- プロジェクトフォルダで

python -m venv envを実行 - 有効化:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- プロジェクトフォルダで

-

必要なライブラリのインストール:

- 仮想環境を有効にした状態で以下を実行:

1pip install requests beautifulsoup4 pandas scrapy - 動的なサイト対応には

seleniumもおすすめ

- 仮想環境を有効にした状態で以下を実行:

-

エディタの選択:

- 初心者には、、などが使いやすい

トラブルシューティング:

pipが認識されない場合はpython -m pip install ...を試す- 権限エラー時は管理者権限でターミナルを起動、またはMac/Linuxなら

sudoを利用 - WindowsではPythonインストール後にターミナルを再起動

スクレイピング前のウェブサイト調査方法

コードを書く前に、ターゲットとなるウェブサイトの構造をしっかりチェックしましょう。自分がよくやる手順はこんな感じ:

-

開発者ツールを開く:

- Chromeなら、要素を右クリックして「検証」または

F12キー - 「Elements」タブでHTML構造を確認

- Chromeなら、要素を右クリックして「検証」または

-

取得したいデータを探す:

- 「要素選択」ツール(マウスポインタのアイコン)で、欲しいデータ(例:商品名や価格)をクリック

- 対応するHTMLがハイライトされる

-

パターンを見つける:

- 独自のタグやクラス、IDをチェック。例:

<h2 class="product-title">Laptop XYZ</h2> - データがリスト(

<ul>や<div class="item">など)やテーブルにあるか確認

- 独自のタグやクラス、IDをチェック。例:

-

ページネーションの有無を確認:

- HTML内に「次へ」ボタンやページ番号があるか探す。

?page=2のようなURLがあれば、スクリプトで繰り返し取得可能

- HTML内に「次へ」ボタンやページ番号があるか探す。

-

動的コンテンツかどうか:

Ctrl+Uでページソースにデータがなければ、JavaScriptで後から読み込まれている可能性。SeleniumやAPIエンドポイントの調査が必要な場合も

詳しい手順はも参考にしてみてください。

Requestsでウェブページを取得する

ライブラリは、Pythonでウェブページをダウンロードする定番ツール。基本の使い方はこんな感じ:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # エラー時は例外を発生

6html = response.textポイント:

User-Agentヘッダーを設定して、ブロックされにくくする(参照)response.status_codeでステータスを確認(200=成功、404=未検出、403=禁止、429=リクエスト過多)

BeautifulSoupでHTMLを解析しデータを抽出

HTMLを取得したら、次は必要な情報を抜き出します。を使えばとても簡単です:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]よく使う処理例:

- テキスト抽出:

element.get_text(strip=True) - リンク取得:

[a['href'] for a in soup.select('a')] - クラス指定で検索:

soup.find_all('span', class_='price') - 画像URL抽出:

[img['src'] for img in soup.select('img')] - テーブル処理:

soup.select('table')で行・セルをループ

HTMLが複雑な場合のコツ:

- 最初の一致だけ欲しい時は

soup.select_one() - 欲しい要素がない場合は

Noneチェックを忘れずに - レイアウトがバラバラな場合は正規表現やカスタムロジックも活用

Scrapyフレームワーク:効率的かつ大規模なスクレイピング

大量のページをクロールしたい時は、が最適。Scrapyは、ウェブサイトの巡回・データ抽出・エクスポートまで一括でこなせる強力なフレームワークです。

Scrapyの特長:

- 高速処理:非同期で複数ページを同時取得

- 便利な機能:リトライ、キャッシュ、CSV/JSON出力など標準装備

- 大規模対応:定期的なクロールや大規模案件にも最適

基本的な使い方:

- インストール:

pip install scrapy - プロジェクト作成:

scrapy startproject myproject - Spiderクラスで

start_urlsとparseメソッドを定義 yieldでリンク追跡やデータ抽出- 実行:

scrapy crawl spidername -o output.csv

詳しくはをチェック!

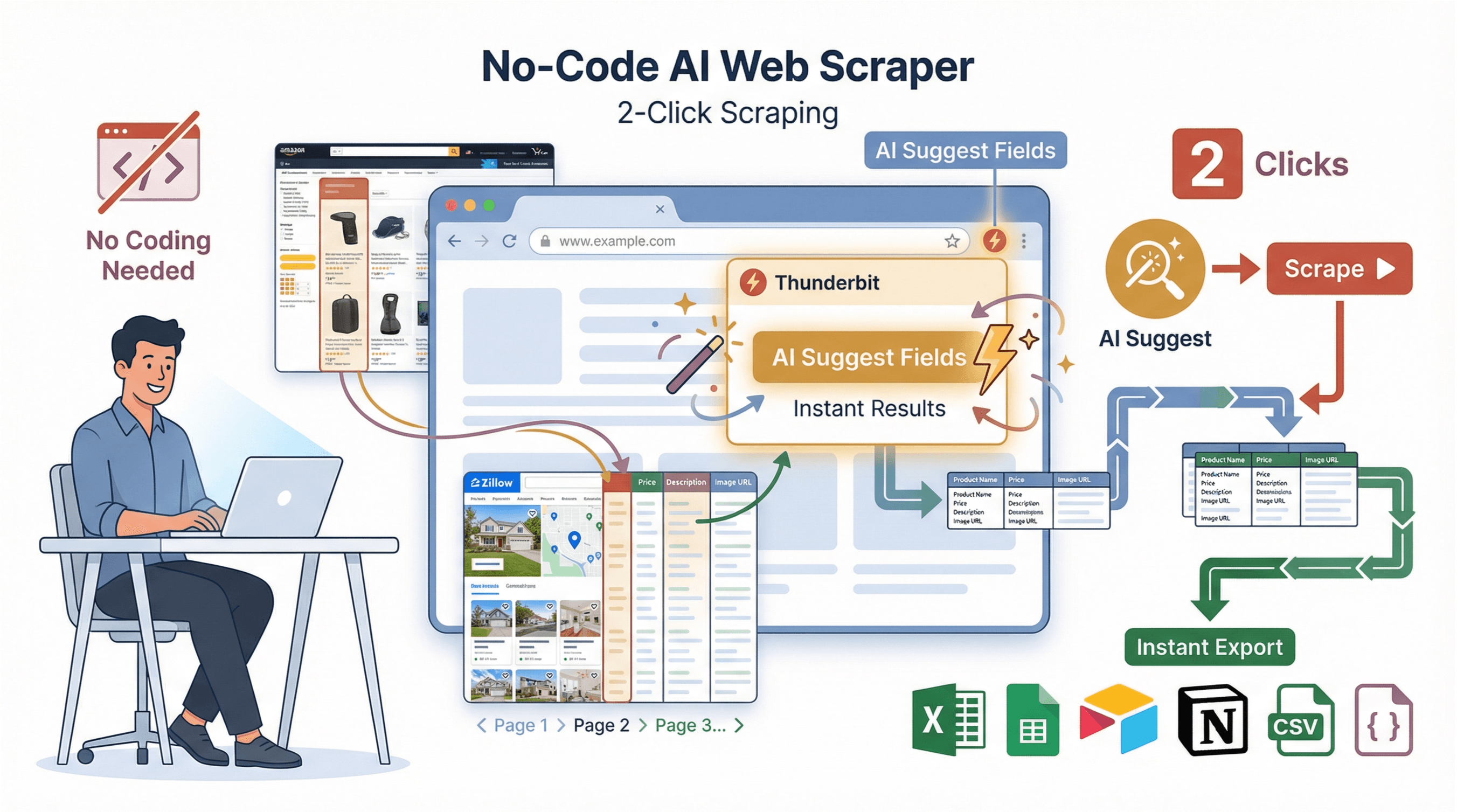

ノーコードで即結果:ThunderbitのAIウェブスクレイパー

正直、コードや依存関係、デバッグに悩みたくない人も多いはず。そんな人のために生まれたのが。Thunderbitは、ビジネスユーザー向けに設計されたAI搭載のウェブスクレイパーChrome拡張機能。2クリックで欲しいデータをゲットできます。

正直、コードや依存関係、デバッグに悩みたくない人も多いはず。そんな人のために生まれたのが。Thunderbitは、ビジネスユーザー向けに設計されたAI搭載のウェブスクレイパーChrome拡張機能。2クリックで欲しいデータをゲットできます。

Thunderbitの主な機能:

- AIフィールド提案:「AIフィールド提案」をクリックすると、Thunderbitがページを解析し、最適なカラムを自動で提案

- 2クリックでスクレイピング:「スクレイプ」ボタンを押すだけで、ページネーションやサブページ、複雑なレイアウトも自動対応

- サブページ対応:商品詳細やプロフィールなど、各サブページも自動で巡回し、データを充実化

- 即使えるテンプレート:Amazon、Zillow、Instagram、Shopifyなど人気サイト用のテンプレートも用意。1クリックでエクスポート可能

- 無料データエクスポート:Excel、Google Sheets、Airtable、Notion、CSV、JSONなど多彩な形式で出力。追加料金や面倒な手続きなし

ThunderbitとPythonの比較

| 機能 | Python(手動) | Thunderbit(ノーコード) |

|---|---|---|

| セットアップ時間 | 30~60分 | 2分 |

| コーディングの必要性 | あり | なし |

| ページネーション対応 | カスタムコードが必要 | 自動対応 |

| サブページ取得 | 手動でループ | 1クリック |

| データエクスポート | CSV/Excel用のコードが必要 | Sheets/Excel/Notionへ1クリック |

| メンテナンス | サイト構造変更時は手動修正 | AIが自動で適応 |

| おすすめ用途 | カスタムロジックや統合 | 迅速な結果、非エンジニア向け |

さらに詳しくはもどうぞ。

データのクレンジングと保存:使えるデータに仕上げる

取得したままのデータは、そのままでは使いにくいことが多いもの。を使って、データを整理・保存しましょう。

1import pandas as pd

2# 例:辞書型リスト scraped_data がある場合

3df = pd.DataFrame(scraped_data)

4# 重複行の削除

5df = df.drop_duplicates()

6# 欠損値のある行を除外

7df = df.dropna(subset=['title', 'price'])

8# 価格をfloat型に変換($やカンマを除去)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# CSVに保存

11df.to_csv('results.csv', index=False)ベストプラクティス:

- 欠損や不整合データのチェックを忘れずに

- 日付や価格などのフォーマットを統一

- 共有にはCSV、共同作業にはExcelやGoogle Sheetsが便利

- 大量データはSQLiteやPostgreSQLなどのデータベースも検討

Pythonウェブスクレイピング実践:ステップバイステップ解説

実際に、サンプルECサイトから商品名と価格を取得する例で流れをまとめます。

1. サイト構造を調査

例としてを使います。ページを検証すると:

- 本のタイトルは

<article class="product_pod">内の<h3>タグ - 価格は

<p class="price_color">タグ

2. ページを取得

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. データを解析・抽出

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. データをクレンジング・保存

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"{len(df)}件の本をbooks.csvに保存しました")5. トラブルシューティング

booksが空の場合はCSSセレクタを再確認- 文字化け時はCSVをUTF-8で開く

- 複数ページ対応は

http://books.toscrape.com/catalogue/page-2.htmlのようにURLをループ

上級者向けヒント:動的サイトや複雑な処理はSeleniumやScrapyの活用、またはThunderbitに任せるのもおすすめです。

まとめ・ポイント

Pythonによるウェブスクレイピングは、リード獲得から市場分析まで、ビジネスに大きな可能性をもたらします。今回ご紹介した内容を振り返ると:

- Pythonはウェブスクレイピングに最適:シンプルな文法と強力なライブラリが魅力

- RequestsとBeautifulSoup:HTML取得と解析の基本ツール

- Scrapy:大規模・本格的なスクレイピングに最適

- Thunderbit:ノーコード&AIで即結果。非エンジニアやスピード重視の方におすすめ

- データのクレンジング・保存:生データを価値ある情報に変えるために必須

さらに深く学びたい人は、練習用サイトで自作スクレイパーに挑戦したり、をダウンロードして、どれだけ素早くデータを取得できるか試してみてください。最新情報やノウハウはでも発信中です。

スクレイピングを楽しみながら、いつでもクリーンで構造化されたデータを手に入れましょう!

よくある質問(FAQ)

1. ウェブスクレイピングは合法ですか?

公開されているデータの収集は基本的に合法ですが、各サイトの利用規約やrobots.txt、GDPRなどのプライバシー法は必ず守りましょう。個人情報の無断取得やログイン・セキュリティの突破は絶対NGです(参照)。

2. Requests、BeautifulSoup、Scrapyの違いは?

- Requests:ウェブページの取得

- BeautifulSoup:HTMLからデータを抽出・解析

- Scrapy:大規模なクロールやデータ抽出、複数ページ・エクスポートまで対応するフレームワーク

3. JavaScriptでデータが読み込まれるサイトは?

初期HTMLにデータがない場合は、やPlaywrightでブラウザを自動操作するか、ネットワーク通信からAPIエンドポイントを探して直接取得しましょう。

4. スクレイピングでブロックされないコツは?

リアルなヘッダー(特にUser-Agent)を設定し、リクエスト間にランダムな遅延を入れる、サーバーに負荷をかけすぎないなどが大事。大規模な場合はIPローテーションやプロキシの利用も検討(参照)。

5. コーディングなしでデータを取得できますか?

もちろん可能です。なら、AIを活用して2クリックでどんなウェブサイトもスクレイピングできます。Chrome拡張をインストールし、欲しいデータを指定するだけで即エクスポート。

さらに詳しいガイドや上級テクニックはでチェック!

さらに学ぶ