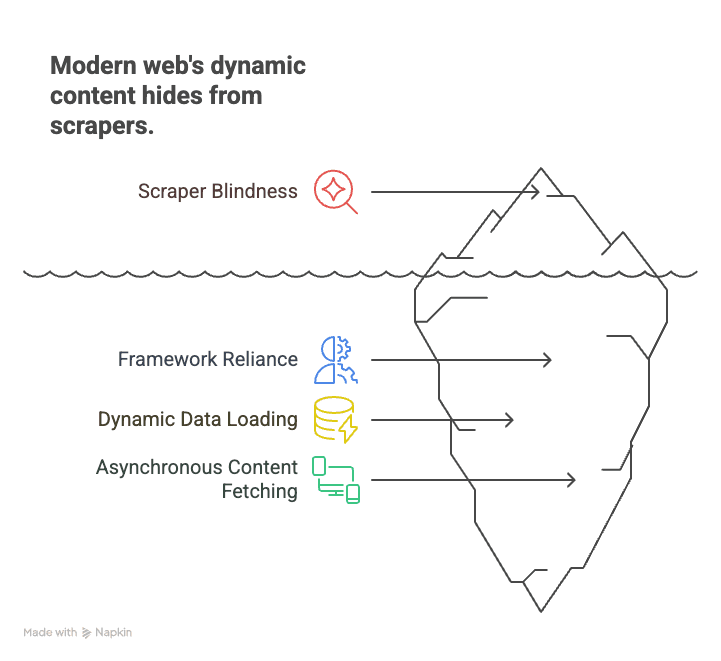

最新のウェブサイト、たとえば不動産ポータルやECサイト、SNSのフィードからデータを集めようとしたことがある人なら、一度は「情報が見つからない…」という壁にぶつかったことがあるはずです。ページのHTMLを見ても、欲しいデータ(価格、リスト、レビューなど)がどこにもない。これは、今のウェブが単なるHTMLじゃなく、JavaScriptで動的にコンテンツを生成しているからなんです。実際、**全ウェブサイトの約99%**がクライアントサイドのスクリプトを使っていると言われています()。昔ながらのクローラーだと、まるで映画の台本だけ読んで本編を見ていないようなもの。動的に表示される本当の情報は取得できません。

SaaSや自動化の現場で長年やってきた僕も、この変化で多くのビジネスユーザーや営業、リサーチ担当が困っているのを何度も見てきました。でも、もう安心してください。javascriptクローリングは、エンジニアだけのものじゃありません。正しいやり方とAIツール(など)を使えば、誰でも動的でインタラクティブなサイトからデータを抜き出せる時代です。ここでは、JavaScript生成ページのクローリングの基本から、なぜ重要なのか、ノーコードで始める方法まで、分かりやすく解説します。

JavaScript生成ページのクローリングとは?今のウェブデータ抽出に欠かせない理由

まずは基本から。javascriptクローリングとは、ウェブページを開いてJavaScriptを実行した後に表示されるコンテンツを抜き出す方法です。昔のHTMLスクレイピングは、サーバーから送られてくる生のHTMLだけを取得していましたが、今のウェブではそれは“骨組み”にすぎません。実際の情報(商品リスト、レビュー、価格など)は、JavaScriptで後から埋め込まれることがほとんど。時には、スクロールやクリックなどの操作をしないと表示されないこともあります。

なぜ重要なのか? 今のウェブはReact、Angular、Vueみたいなフレームワークで作られていて、シングルページアプリケーション(SPA)が主流。これらは必要なデータをその場で読み込むので、静的なスクレイパーではほとんどの情報が取れません。たとえば:

- ECサイト:商品価格や在庫情報は、スクロールやフィルター選択後に初めて表示される

- 不動産サイト:リストはスクロールに応じて動的に追加される

- SNS:投稿やコメント、いいねは非同期で取得され、最初のHTMLには含まれない

昔のクローラーだと空っぽのページしか見えず、肝心な情報を逃してしまいます。一方、javascriptクローリングは、実際にChromeでページを開いて全てのスクリプトを実行し、目に見える情報をそのまま取得するイメージです。

まとめると:2025年のウェブからデータを集めたいなら、javascriptクローリングは必須スキル。これを知らないと、ほとんどの情報を見逃してしまいます()。

JavaScript生成ページのクローリングでよくある課題と解決策

javascriptクローリングは「手順が増えただけのスクレイピング」じゃありません。独特の難しさがあります。ここでは主な課題と、その乗り越え方を紹介します。

動的コンテンツのレンダリング

課題:多くの情報はHTMLには含まれておらず、ページ表示後にJavaScriptで読み込まれます。HTMLだけを取得しても、プレースホルダーや空のコンテナしか得られません。

解決策:ヘッドレスブラウザを使いましょう。これは本物のブラウザのように動作し、全てのスクリプトを実行してコンテンツが表示されるまで待ちます。やが業界標準です。

- ページを開いてJavaScriptを実行

- 特定の要素(例:.product-list)が表示されるまで待機

- 完全にレンダリングされたDOMからデータを抽出

この方法が、動的サイトのスクレイピングでは今や定番です()。

ボット対策・自動化ブロック

課題:多くのサイトはボット対策を強化しています。たとえば:

- CAPTCHA

- IP制限やアクセス頻度制限

- ブラウザフィンガープリント(本物のユーザーか判定)

- ハニーポット(ボットを検出するための偽リンク)

解決策:人間の行動を真似して、マナーを守ってクロールしましょう。

- robots.txtや利用規約を守る

- リクエスト間隔を調整して、サーバーに負荷をかけない

- IPローテーション(大規模な場合のみ、倫理的に実施)

- 本物のブラウザヘッダーを使い、ボットとバレない工夫

- ログイン後のページやCAPTCHA突破は避ける

Thunderbitも、公開データだけを対象にし、法令遵守のベストプラクティスを組み込んでいます()。

無限スクロールやユーザー操作が必要な場合

課題:多くのサイトは無限スクロールや「もっと見る」ボタンなど、ユーザー操作でデータを追加表示します。初期表示だけを取得しても、ほとんどの情報が抜け落ちます。

解決策:ブラウザ自動化で以下を実現します。

- 自動スクロール(ユーザーのように追加データを読み込む)

- 「もっと見る」ボタンやタブのクリック

- 新しいコンテンツが表示されるまで待機してから抽出

ThunderbitのAIは、こうしたパターンを自動検出し、スクロールやページ送りも自動で対応します()。

パフォーマンスとスケーラビリティの維持

課題:ヘッドレスブラウザは1ページごとに多くのリソースを消費します。大量のページを処理する場合、PCの負荷や速度が問題になります。

解決策:並列クロールで複数のブラウザやタブを同時に動かす、またはクラウドに処理を任せましょう。Thunderbitのクラウドスクレイピング(Lightning Network)は最大50ページを同時に処理し、大規模な作業も高速化します()。

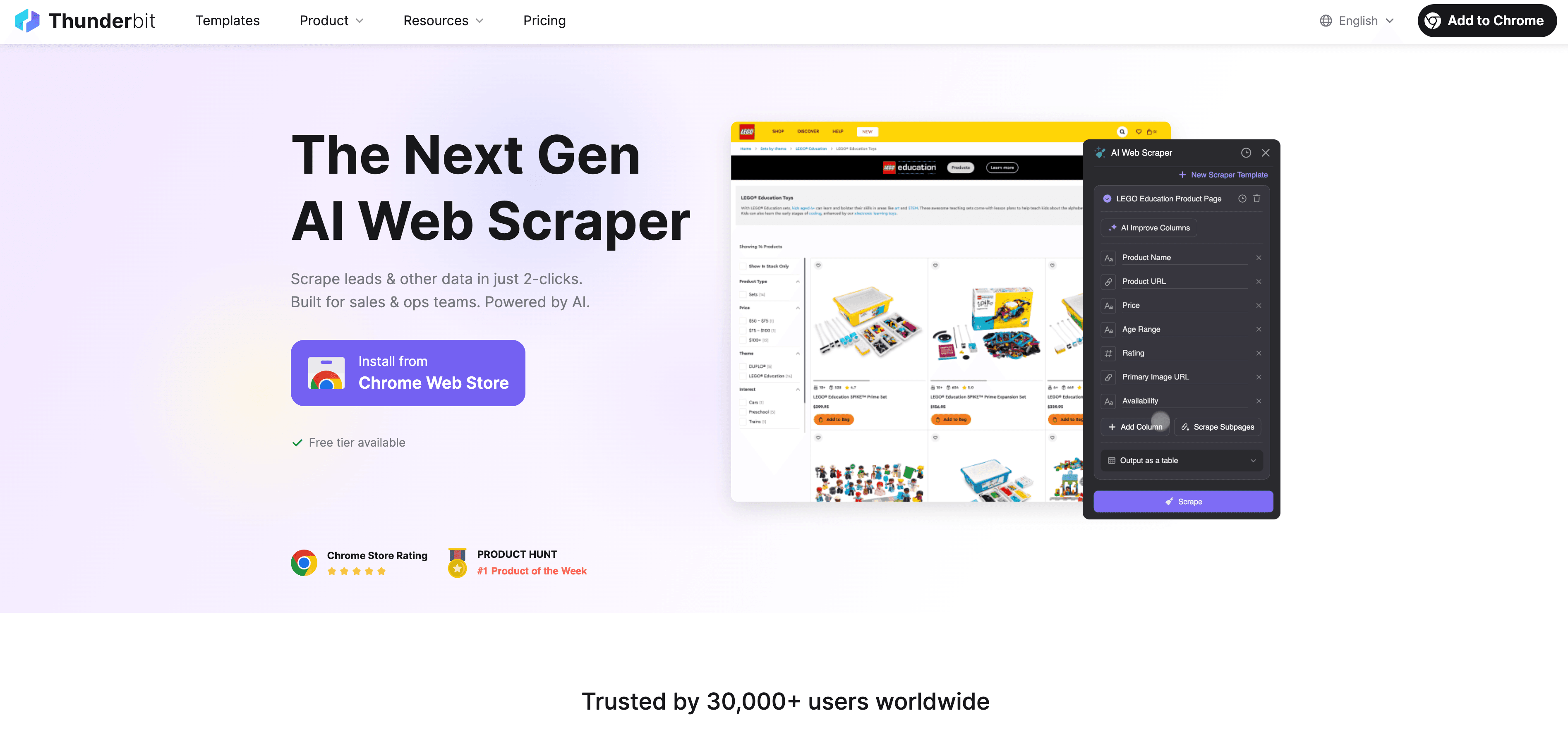

Thunderbit:JavaScript生成ページのクローリングを誰でも簡単・強力に

正直、ビジネスユーザーの多くはコードを書いたり、セレクタを調整したり、スクリプトの管理に時間をかけたくないはず。そこで登場したのが。開発知識がなくても、動的なJavaScriptサイトからデータを取得できるAI搭載웹 스크래퍼です。

Thunderbitがjavascriptクローリングを簡単にするポイント:

- AIフィールド提案:「AIフィールド提案」ボタンを押すだけで、ThunderbitのAIがページを解析し、最適なカラムやデータ型を自動で提案。もう手探りで設定する必要なし。

- 自然言語での抽出指示:「商品名、価格、評価を取得して」といった日本語や英語で指示するだけで、Thunderbitが自動で抽出方法を判断。

- 動的コンテンツ対応:Thunderbitは実際のブラウザ(Chromeやクラウド)上で動作し、JavaScriptを実行してコンテンツが表示されるまで待機。

- サブページ・ページネーション対応:複数ページや詳細ページ(例:商品詳細)も自動で巡回し、全データを1つのテーブルにまとめます。

- クラウド高速化:大規模な作業もThunderbitのLightning Networkで最大50ページ同時処理。PCに負荷をかけません。

- ノーコード・直感的なUI:Excel感覚で使える操作性。技術的な設定は不要です。

- 無料データエクスポート:Excel、Google Sheets、Airtable、Notion、JSON形式でワンクリック出力。追加料金なし。

Thunderbitは世界中で3万人以上のユーザーに使われていて、営業、EC、不動産業界など幅広い分野で活躍しています()。

AIフィールド提案&自然言語抽出

Thunderbitの一番の強みはここ。HTMLやXPathを調べる必要はありません。ボタン1つでAIがページ構造を理解し、最適な抽出項目を提案。欲しい情報があれば、自然な言葉で入力するだけでAIが自動でマッピングします。

初心者にとっては革命的な機能です。HTMLやCSS、JavaScriptの知識は不要。「何を取りたいか」だけ伝えれば、あとはAIが全部やってくれます()。

ページネーション・サブページの自動巡回

Thunderbitは1ページだけでなく、

- ページネーションの自動検出・対応(「次へ」クリックやスクロールで追加読み込み)

- サブページ(商品詳細、著者プロフィール、レビューなど)の巡回とデータ統合

- 無限スクロールもユーザー操作を模倣して全データ取得

たとえば、20ページ分の商品リストを取得したい場合も、Thunderbitが自動で全ページを巡回し、結果をまとめてくれます。各商品の詳細ページも自動で訪問し、追加情報をデータセットに付加できます()。

Lightning Network & クラウド高速化:大規模JavaScriptクローリングも簡単

数百・数千ページを1つずつ処理するのは現実的じゃありません。ThunderbitのLightning Networkなら、

- クラウドスクレイピング:Thunderbitのクラウドサーバー(米国、EU、アジア)で最大50ページ同時処理。大規模作業も高速化。

- 並列クロール:1,000ページの商品データも、クラウドで分散処理すれば数分で完了。

- 定期スクレイピング:価格やリストの毎日監視も「毎朝9時に」など自然言語でスケジュール設定可能。Google Sheetsやデータベースに自動エクスポート()。

営業やEC、運用チームが新鮮なデータを大量に集めたい時も、エンジニアやサーバー不要で実現できます。

複数ページ・大量データの一括抽出

Thunderbitなら、

- ディレクトリやカタログ全体の一括取得(例:カテゴリ内全商品、地域内全リスト)

- Excel、Google Sheets、Airtable、Notionへのワンクリック出力

- 手作業の大幅削減—実際に不動産リスト数百件+担当者情報を10分以内で取得した事例も。

Thunderbitで始めるJavaScript生成ページのクローリング:ステップバイステップガイド

実際にやってみたい人向けに、Thunderbitを使ったクローリングの流れを紹介します。

初めてのクローリング設定

- Thunderbitをインストール:をダウンロードし、無料アカウントを作成。

- ターゲットサイトを選択:取得したいウェブサイトを開きます。ログインが必要な場合は先にログイン(Thunderbitはブラウザの状態を利用)。

- Thunderbitを起動:ChromeツールバーのThunderbitアイコンをクリック。データソース(現在のページ、URLリスト、ファイルアップロード)を選択。

- 実行モードを選択:小規模やログインが必要な場合はブラウザモード、大規模作業はクラウドモードで並列処理。

- AIフィールド提案:「AIフィールド提案」をクリック。ThunderbitのAIがページを解析し、「商品名」「価格」「画像URL」など最適なカラムを提案。

- カラム調整:必要に応じて項目名の変更・追加・削除や、AI指示でデータの整形・分類も可能。

- ページネーション/スクロール設定:ページ送りや無限スクロールがある場合は、Thunderbitの設定で有効化。

- 「スクレイピング」実行:Thunderbitがページを読み込み、JavaScriptを実行し、データをテーブルに抽出します。

データの抽出とエクスポート

- 結果プレビュー:Thunderbit上でテーブル表示。抜けや誤りがないか確認。

- エクスポート:Excel、CSV、JSON、Google Sheets、Airtable、Notionへワンクリック出力。

- 検証:いくつかの行を実際のサイトと照合し、正確性を確認。

- トラブルシューティング:データが抜けている場合は、ページを手動でスクロール、AI指示の調整、クラウドモードへの切り替えなどを試しましょう。

詳しい手順はやも参考にしてください。

安全・法令遵守のためのJavaScript生成ページのクローリング実践ポイント

強力なスクレイピング機能には、責任ある使い方が求められます。以下を守りましょう:

- robots.txtや利用規約の確認:スクレイピング禁止のサイトではやらない()。

- 個人情報の取得は避ける:GDPRやCCPAでは、名前やメールアドレス、プロフィールも保護対象。正当な理由と同意がない限り取得しない。

- ログイン突破やCAPTCHA回避はNG:法的リスクが高いので、公開データだけを対象に。

- リクエスト間隔の調整:サーバー負荷を避ける。Thunderbitのクラウドモードは自動で間隔調整・IPローテーション。

- データの倫理的利用:著作権侵害や不正利用はしない。

- 削除依頼には速やかに対応:データ削除要請があれば必ず応じる。

Thunderbitは、公開データのみ・ハッキング禁止・責任ある利用を推奨する設計です。

法的リスクを避けるために

- 公開かつ非個人情報のみ取得

- 明確に禁止されているサイトは避ける

- 不明な場合は許可を取るか公式APIを利用

- 取得日時や内容の記録を残す

- 削除要請には即時対応

詳しくはもご覧ください。

JavaScript生成ページのクローリング主要ツール比較:Thunderbit vs. 従来型ツール

| 項目 | Puppeteer/Playwright(コード) | Sitebulb(SEOクローラー) | Thunderbit(AIノーコード) |

|---|---|---|---|

| セットアップ時間 | 数時間(コーディング必須) | 中程度(設定必要) | 数分(クリック操作) |

| 必要スキル | 高(開発者向け) | 中 | 低(誰でもOK) |

| JSコンテンツ対応 | あり(手動スクリプト) | あり(SEO用途) | あり(AI自動) |

| ページネーション/サブページ | 手動スクリプト | 限定的 | 自動(AI検出) |

| 保守性 | 高(変更で壊れやすい) | 中 | 低(AIが適応) |

| スケーラビリティ | 手動(コード追加) | 限定的 | クラウド内蔵(50倍速) |

| エクスポート | 手動(コード記述) | CSV/Excel | Excel、Sheets、Notion |

| おすすめ対象 | 開発者・カスタム用途 | SEO監査 | ビジネスユーザー・分析担当 |

ビジネスユーザーが素早く結果を出したいなら、Thunderbitが圧倒的におすすめです()。

まとめ・重要ポイント

javascriptクローリングは、もはや一部の専門家だけの技術じゃありません。**全ウェブサイトの約99%**がクライアントサイドスクリプトを使う今、昔のスクレイピングでは十分なデータが取れません()。でも、エンジニアじゃなくても大丈夫。

覚えておきたいポイント:

- 動的コンテンツが主流:今のサイトのデータ取得にはJavaScript実行が必須

- 課題はあるが解決可能:ヘッドレスブラウザ、スマートな待機、クラウド高速化で難しいデータも取得できる

- Thunderbitなら簡単:AIフィールド提案、自然言語抽出、サブページ・ページネーション対応、クラウド高速化で誰でも強力なクローリングが可能

- 法令遵守を徹底:サイトのルールやプライバシー法、倫理を守る

- 今すぐ始めよう:Thunderbitをインストールし、サイトを選んで数クリックでデータ取得を体験

もっと知りたい人はやもチェックしてみてください。

みんなのクローリングが、いつも最新・完全・すぐ使えるデータで満たされますように。

よくある質問(FAQ)

1. JavaScriptクローリングとは?従来のスクレイピングと何が違う?

JavaScriptクローリングは、ウェブページを開いて全てのJavaScriptを実行した後に表示されるコンテンツを抜き出す方法です。昔のスクレイピングは生のHTMLしか取れず、今のサイトの多くの情報を見逃します。

2. ビジネスデータ取得にJavaScriptクローリングが必要な理由は?

ほぼ全ての今どきのウェブサイトがJavaScriptでコンテンツを動的に表示しているので、これを使わないと商品リストやレビュー、価格など大事なデータが取れません。

3. Thunderbitは初心者でもJavaScriptクローリングを簡単にできる?

ThunderbitはAIでフィールド提案や動的コンテンツ対応、ページネーション・サブページの自動化を実現。自然言語で指示するだけでOK、コーディング不要です。

4. JavaScriptクローリングは合法?注意点は?

公開データだけ、robots.txtや利用規約を守り、個人情報の無断取得を避ければ合法です。Thunderbitは法令遵守と責任ある利用を推奨しています。

5. 大規模なJavaScriptクローリングを効率化するには?

ThunderbitのLightning Network(クラウドスクレイピング)を使えば、最大50ページ同時処理で大量データも短時間で取得可能。価格監視やリード獲得など大規模用途にも最適です。

さらに詳しく: