正直なところ、2025年のウェブはまるで巨大なスプレッドシートみたいなものなのに、「Excelにエクスポート」ボタンがどこにも見当たらないんですよね(本当にあればいいのに…と思いませんか?)。SaaSや自動化ツールの開発現場で長年やってきた経験から、営業やマーケ、オペレーションの現場では、リードリストや競合価格、不動産トレンドなど、常に新鮮で正確なウェブデータが求められているのを肌で感じています。でも、ウェブスクレイピングのニーズが高まる一方で、「どうやって集めるか」の手法はどんどん進化しています。

Javaは昔から本格的で大規模なウェブスクレイピングの定番言語として使われてきました。ただ、Javaでスクレイパーを作るのって、説明書なしでIKEAの家具を組み立てるようなもので、最後にネジが3本余る…そんな感覚です。だからこそ、僕たちが開発したみたいなAIウェブスクレイパーの登場にはワクワクしています。コーディングやHTMLの知識がなくても、たった2クリックでデータ抽出できる時代が来たんです。この記事では、Javaが今も現役で選ばれる理由や、スクレイパー構築の流れ、そしてAIツールがどんなふうにウェブスクレイピングを誰でも使えるものに変えているのかを、分かりやすく解説します。

2025年もJavaウェブスクレイピングが選ばれる理由

ノーコードやAI搭載ツールがどんどん増えている今でも、Javaは大規模なウェブスクレイピングプロジェクトの主役です。その理由はシンプルで、Javaはパフォーマンスも信頼性も高く、エンタープライズ規模のデータ抽出に必要な細かい制御ができるからです。

Javaが活躍する現場

- リード獲得・営業: Javaの並列処理を使えば、ディレクトリやLinkedInから数百万件のプロフィールを一晩で集めることも可能。寝ている間に営業リストがどんどん増えていきます。

- 競合価格のモニタリング: ECチームはJavaスクレイパーで競合サイトの数千SKUを監視し、リアルタイムで価格調整。例えばTarget社は、データ駆動型の価格最適化を導入して)した事例も。

- 不動産データの収集: エージェントや投資家はJavaを使って、複数サイトから物件情報や過去価格、人口統計データを集めて投資チャンスを見極めています()。

- 金融市場リサーチ: 投資会社はJavaの安定性を活かして、株価やニュース、SNSの動向を24時間体制で収集。金融の世界では、数秒の遅れが大きな損失につながることも。

トレードオフ:柔軟性と手軽さのバランス

Javaは細かいカスタマイズができて、どんなケースにも柔軟に対応できるし、バックエンドシステムとの連携も自由自在です。ただ、その分プログラミングスキルが必須で、学習コストや保守の手間も大きくなります。だからこそ、Javaが大規模案件で活躍する一方で、日常的なデータ収集にはAIやノーコードのツールを選ぶビジネスユーザーが増えているんです()。

Javaウェブスクレイピングの基本をざっくり解説

難しい専門用語は抜きで説明します。

Javaでのウェブスクレイピングは、プログラムがロボットみたいにウェブページを巡回して、内容を読み取り、必要なデータを抜き出すこと。つまり、デジタルなインターンが超高速でコピペ作業をしてくれるイメージです。

基本的な流れ:

- リクエスト送信: JavaプログラムがウェブページのHTMLを取得(ブラウザと同じ動き)。

- HTML解析: ページ構造(

<div>や<span>,<table>など)を読み取る。 - データ抽出: 例えば「

<span class='price'>の価格を全部取得」みたいに、欲しい情報を指定。 - エクスポート: 抽出したデータをCSVやExcel、データベースに保存。

静的なサイトなら比較的簡単ですが、JavaScriptで動的にデータが表示されるサイトの場合は、実際のブラウザをシミュレートする追加ツールが必要です(後で説明します)。

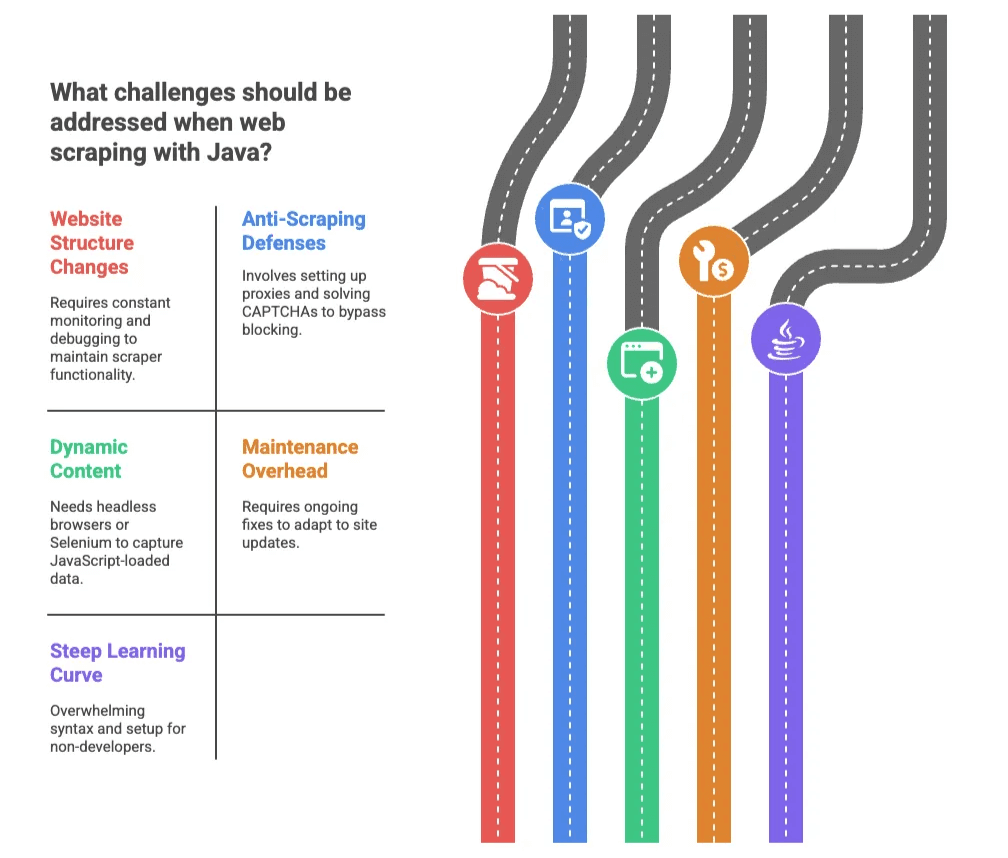

Javaウェブスクレイピングでよくある課題

Javaはパワフルですが、決して楽な道のりではありません。CAPTCHAやIPブロック、頻繁に変わるHTML構造など、いろんな壁があります。

1. サイト構造の変化

せっかく動くようになったスクレイパーも、サイトのデザイン変更やCSSクラス名の変更で簡単に動かなくなります。深夜にデバッグ作業…なんてことも()。

2. アンチスクレイピング対策

CAPTCHAやIP制限、リクエスト制限など、サイト側も防御策を強化しています。が「ブロック対策が最大の悩み」と回答。Javaでこれに対応するには、プロキシやCAPTCHA回避など、まるでモグラ叩きのような対応が必要です。

3. 動的コンテンツ

最近のサイトはJavaScriptでデータを後から表示することが多く、基本的なJavaスクレイパーでは取得できません。Seleniumなどのヘッドレスブラウザを使う必要があり、難易度も上がります。

4. メンテナンスの手間

一度作った後も、サイトの更新に合わせて修正が必要。保守作業が継続的に発生します。

5. 学習コストの高さ

非エンジニアにとって、Javaの文法や環境構築はハードルが高いです。ちょっとしたミスでも難解なエラーが出ることも。

従来型Javaウェブスクレイピングの流れ

自分でJavaコードを書いてスクレイパーを作る場合、一般的な手順はこんな感じです:

| ステップ | Javaでの実装 | AI/ノーコードツールの場合 |

|---|---|---|

| 環境構築 | JDKやIDE、ライブラリ導入(初心者は数時間かかることも) | ブラウザ拡張機能のインストールやサインアップ(数分) |

| データ項目の特定 | HTMLを調査しセレクタを記述(HTML/CSSの知識が必要) | AIが自動で項目を検出、またはクリックで選択 |

| 動的コンテンツ対応 | SeleniumやHtmlUnitを実装(複雑で遅くなる) | ツールが自動で対応 |

| デバッグ・修正 | エラー解析・コード修正・テストを繰り返す | ツールが大半を自動処理、必要なら項目選択を微調整 |

| データ出力 | CSV/DB保存のコードを書く、手動連携 | ExcelやGoogle Sheets、Airtable、Notionへワンクリック出力 |

| メンテナンス | サイト変更の監視・コード修正(継続的な開発が必要) | AIが自動で適応、ユーザーの手間は最小限 |

代表的なJavaウェブスクレイピング用ライブラリ

- Jsoup: 静的HTML向け。使いやすいけど、JavaScriptで生成されるデータには非対応()。

- HtmlUnit: ブラウザをシミュレートし、JavaScriptも実行可能。ただし動作が遅く、最新のウェブ技術には弱い場合も。

- Selenium: 実際のブラウザ(ChromeやFirefox)を操作でき、動的サイトにも対応。強力だけど、非エンジニアにはやや難解。

まとめ: これらのライブラリは開発者向けには最適ですが、ビジネスユーザーには「ピザを頼むのにロケットを作る」くらい大げさに感じるかもしれません。

AIウェブスクレイパーの登場:誰でも使える時代へ

ここからが本題です。AI搭載のウェブスクレイパー(など)は、コーディング不要で誰でも簡単にデータ収集できる新しい選択肢を提供しています。

Thunderbitの特徴

- AIによる項目提案: ボタン一つでAIがページを解析し、抽出すべきカラムやデータ型を自動提案。HTMLの知識は不要です。

- 2クリックで完結: 「AIで項目提案」→「スクレイピング実行」だけ。あとはAIが自動で処理。

- サブページの自動巡回: 商品やプロフィールなど、詳細ページも自動で訪問し、データを拡充。

- 多彩なエクスポート先: Excel、Google Sheets、Airtable、Notionなどにワンクリックで出力。

- クラウド/ブラウザ両対応: クラウドなら最大50ページ同時処理、ログインが必要なサイトはブラウザで対応。

本当にこれだけ簡単です。技術に自信がない人でも「セレクタって何?」から「競合商品の500件を10分で取得」まで、あっという間に到達できます。

Thunderbitと従来型Javaスクレイピングの比較

| 機能 | 従来のJava | Thunderbit AIウェブスクレイパー |

|---|---|---|

| セットアップ時間 | 数時間〜数日 | 数分(Chrome拡張をインストール) |

| 必要スキル | Java、HTML、CSS、デバッグ | 不要(ウェブ操作ができればOK) |

| メンテナンス | 手動・継続的 | AIが自動対応 |

| データ出力 | コーディングが必要 | Excel、Sheets、Airtable、Notionへワンクリック |

| 動的コンテンツ | Selenium/HtmlUnitで複雑 | 自動対応 |

| サブページ巡回 | 独自ロジックの実装が必要 | ワンクリックで内蔵 |

| 拡張性 | マルチスレッドやプロキシの実装 | クラウドで並列処理 |

| コスト | 開発者の工数・インフラ費用 | 手頃なプラン、無料枠あり |

多くのビジネスユーザーにとって、Thunderbitのアプローチは「マニュアル車から自動運転車に乗り換える」ような快適さです。

実践ガイド:Javaでウェブスクレイピングを始める手順

Javaで自作に挑戦したい人のために、ざっくりとした流れを紹介します:

-

環境構築: Java Development Kit(JDK)とIntelliJやEclipseなどのIDEをインストール。HTML解析用にJsoupなどのライブラリを追加()。

-

ターゲット選定: ブラウザで対象サイトを開き、HTMLを調査。取得したい要素(商品名や価格など)を特定。

-

コード作成: Jsoupでページを取得し、必要なデータを抽出。例:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

ページ送り対応: URLを変更したり「次へ」リンクをたどって複数ページを処理。

-

データ出力: 結果をCSVファイルに書き出し、ExcelやGoogle Sheetsで利用。

-

テスト・調整: スクレイパーを実行し、エラーや抽出精度を確認しながら修正。

Javaスクレイパーの保守ポイント

- 出力の監視: 抽出データに抜けや空欄がないか定期的にチェック。

- セレクタの一元管理: HTMLセレクタはまとめて管理し、変更時にすぐ修正できるように。

- ブロック対策: プロキシやユーザーエージェントのローテーションを活用。

- ドキュメント化: コードにコメントを付け、各処理の役割を明記。

- 法令遵守: スクレイピング前に必ずサイトの利用規約やrobots.txtを確認。

「大変そう…」と感じた人も多いはず。だからこそ、AIツールへの移行が進んでいます。

ThunderbitなどAIウェブスクレイパーを選ぶべきタイミング

どちらを選ぶべきか?現場経験からのアドバイスです:

Javaを選ぶべきケース:

- 独自ロジックやシステム連携、大規模なデータ収集が必要な場合

- セキュリティやコンプライアンス要件が厳しい場合

- 開発リソースと保守の時間が確保できる場合

Thunderbit(または他のAIウェブスクレイパー)を選ぶべきケース:

- コーディング不要で手軽にデータが欲しい場合

- すぐにデータが必要、セットアップを最小限にしたい場合

- サイト構造が頻繁に変わる、または多様なサイトを対象にしたい場合

- ExcelやGoogle Sheets、Airtable、Notionに直接出力したい場合

- 作業効率やストレス軽減を重視したい場合

Thunderbitは、営業・EC・不動産など、IT部門を待たずに繰り返しデータ収集を自動化したいチームにぴったり。リード獲得や競合調査など、スピードと手軽さが求められる場面で特に威力を発揮します。

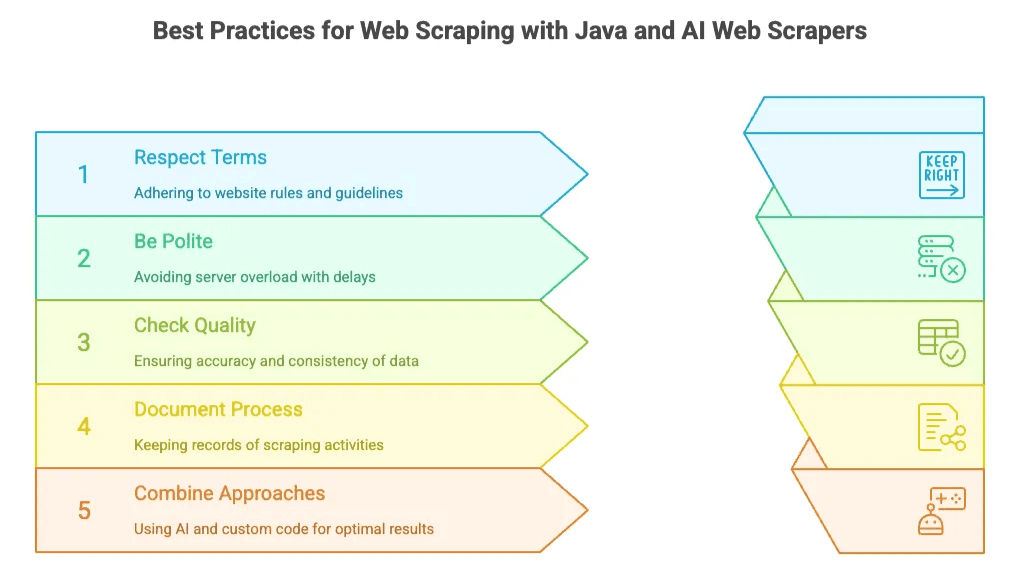

Java・AIウェブスクレイパー共通のベストプラクティス

どちらの方法でも、守るべきポイントは共通です:

- 利用規約の遵守: robots.txtや利用規約を必ず確認し、非公開・機密データは取得しない。

- サーバーへの配慮: リクエスト間隔を空ける、AIツールの自動制御を活用するなど、過剰な負荷をかけない。

- データ品質の確認: 抽出結果の正確性・一貫性をチェック。Thunderbitの「Field AI Prompt」機能でデータの整形も可能。

- 作業の記録: どのサイトから何を、どの頻度で取得したかを記録。

- ハイブリッド活用: まずAIツールで素早く結果を出し、必要に応じてカスタムコードに移行するのも有効です。

まとめ:2025年のビジネスユーザーにとってのウェブスクレイピング

2025年のウェブスクレイピングは「選択肢の時代」。Javaは大規模・高度なカスタマイズが必要なプロジェクトで今も主役ですが、営業・マーケ・オペレーションなど多くのビジネス現場では、のようなAIウェブスクレイパーの登場で、開発者でなくてもウェブデータを自在に活用できるようになりました。

市場も急成長中。世界のウェブスクレイピングソフト市場はに達し、が2028年までに自動分析ツールを導入すると予測されています。データドリブンな意思決定は今後も加速し、ツールもますます進化していくでしょう。

迷っている人は、をぜひ一度試してみてください。無料で始められて、数クリックで驚くほど多くのことが実現できます。(Java好きの開発者の方もご安心を。大規模・難易度の高い案件では、あなたのスキルが今後も必要とされます!)

さらに詳しく知りたい人は、で実践ガイドやノウハウを公開中です。やもぜひチェックしてみてください。

快適なスクレイピングライフを!データがいつも新鮮で正確、そしてワンクリックで手に入りますように。もし人生のすべてがこれくらい簡単なら…とつい思ってしまいますね。

よくある質問(FAQ)

1. 2025年にJavaでウェブスクレイピングを使う理由は?

Javaは大規模・エンタープライズ向けのスクレイピングで今も高い人気を誇ります。高速・高信頼・柔軟な制御が可能で、金融データ監視や競合価格追跡、大規模リードデータベースの収集など、細かな制御やシステム連携が求められる用途に最適です。

2. Javaでウェブスクレイピングする際のデメリットは?

強力な一方で、Javaは学習コストが高く、保守の手間も大きいです。HTML構造の変化による頻繁な修正、JavaScript主体のサイトへの対応の難しさ、プロキシやCAPTCHA、ページネーション処理など複雑なセットアップが必要です。

3. ThunderbitのようなAIツールは何が便利?

Thunderbitは、AIで項目を自動検出し、動的コンテンツやサブページ巡回も自動化。ExcelやNotionなどへの直接エクスポートも可能で、コーディングやHTMLの知識・セットアップは一切不要。非エンジニアでもすぐに使えます。

4. JavaではなくThunderbitを使うべきタイミングは?

Thunderbitは、素早く・確実にデータを取得したいビジネスユーザーに最適です。営業リスト作成やECモニタリング、リサーチなど、スピードと手軽さが重視される場面で特におすすめです。

5. JavaとAIスクレイピングツールを併用できますか?

もちろん可能です。多くのチームは、まずThunderbitのようなAIツールで素早く結果を出し、より高度・大規模な処理が必要な場合はJavaに移行する「ハイブリッド型」を採用しています。

さらに詳しく: