営業リードリストを初めて作るために웹 스크래핑에挑戦したときのこと、今でも鮮明に覚えています。「JavaScriptならなんとかなるだろう」と軽く考えていたのに、数時間後には複雑なセレクタや消える動的コンテンツ、強力な봇対策に頭を抱えていました。実は、これは自分だけの悩みじゃありません。がデータの重要性を認識していて、웹 스크래핑はその中心的な役割を担っています。でも、ウェブサイトが進化するにつれて、JavaScriptでの스크래핑はパワフルだけど、まるで難解なパズルみたいになってきました。

この記事では、web scraping javascriptの基礎から応用、そしてのようなAI搭載ツールで効率化する方法まで、僕の経験を交えて分かりやすく紹介します。ECサイトの商品リストを集めたい人も、営業リードを自動化したい人も、JavaScriptとAIを活用したweb scraping using javascriptの実践ノウハウを一緒に見ていきましょう。

JavaScriptで웹 스크래핑:基本と限界

まずは基本から。web scraping javascriptとは、ブラウザやNode.jsなどでスクリプトを動かして、ウェブサイトからデータを自動取得すること。JavaScriptはウェブの標準言語なので、스크래핑にも自然に使えます。特にCheerio(静的HTML解析)、PuppeteerやPlaywright(ヘッドレスブラウザ自動化)など、便利なライブラリが揃っています。

JavaScriptが스크래핑で人気な理由は?

- DOMに直接アクセスできる:ブラウザ上で人間みたいにDOMを操作できる

- エコシステムが豊富:Node.jsならHTTPリクエストやパース、自動化の強力なライブラリが使える

- 柔軟性:ログインやクリック、スクロールなど、Chromeでできる操作はほぼ自動化可能

でも注意点も。最近のウェブサイトはJavaScriptで動的にコンテンツを生成したり、DOM構造を頻繁に変えたり、봇対策を強化しています。そのせいで、今日動いたスクリプトが明日には動かなくなることも。セレクタの修正やポップアップ対応、非同期データの取得など、まるで두더지 잡기ゲームみたいな作業が続きます。

複雑なウェブページがJavaScript스크래핑を難しくする理由

昔はHTMLを取得して必要なデータを抜き出すだけでOKでしたが、今のウェブはそう簡単じゃありません。Facebook MarketplaceやAmazon、不動産サイトなどはJavaScriptフレームワークで動的にコンテンツを描画し、무한 스크롤や複雑なDOM構造でデータを隠しています。

従来のHTMLパースだけでは、例えば商品レビューや入れ子になったコメントなど、単純な<div>の抽出では済まないケースが増えています。要素同士の関係性やフィールドの意味まで理解しないと、正確なデータ取得は難しいんです。

ここで大事なのが「意味を理解した前処理」。ただHTMLを取得するだけじゃなく、「どれが商品名か」「どれが価格か」「どれがユーザーレビューか」といったページの意味を把握する必要があります。これは普通のJavaScriptだけでは難しいけど、AI搭載ツールなら得意分野です。

従来のJavaScript웹 스크래핑手法

ここで、よく使われるJavaScript스크래핑のツールを紹介します。

- Cheerio:静的HTMLのパースに最適。サーバーサイドjQueryみたいな存在。

- Puppeteer/Playwright:ヘッドレスブラウザ自動化。実際のブラウザを立ち上げてJavaScriptを実行し、人間のようにページを操作できます。

一般的なワークフローはこんな感じ:

- ページにリクエスト(ヘッドレスブラウザを使う場合も)

- コンテンツの読み込みを待つ(

waitForSelectorなど) - DOMをパースして必要なデータを取得

- データを抽出・構造化

一見シンプルだけど、サイトのレイアウトが変わるたびにセレクタが壊れたり、ポップアップでスクリプトが止まったり、フィールドの順番が変わってデータが混乱したりと、メンテナンスが大変です。

主要なJavaScript스크래핑ライブラリの比較

| 機能 | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| 得意分野 | 静的HTML | 動的ページ | 動的ページ |

| ブラウザ自動化 | なし | あり | あり |

| JSコンテンツ対応 | なし | あり | あり |

| 速度 | 高速 | やや遅い | やや遅い |

| APIのシンプルさ | シンプル | 普通 | 普通 |

| ボット回避 | 限定的 | 中程度 | 中程度 |

| クロスブラウザ | なし | Chromeのみ | Chrome, Firefox, WebKit |

| 主な用途 | シンプルなサイト・API | インタラクティブなサイト | インタラクティブなサイト |

Cheerioは静的ページやHTMLを返すAPIには高速で最適ですが、JavaScriptの実行はできません。PuppeteerやPlaywrightは動的なページに強いですが、セットアップや運用の手間が増えます。ログインやクリック、スクロールの自動化も可能ですが、サイトごとに細かいロジックを書く必要があります。

Thunderbitのご紹介:JavaScriptワークフローを強化するAI웹 스크래퍼

ここからが本題。Thunderbitでは、単なるHTMLの取得じゃなく、人間のようにページの意味を理解することが大事だと考えました。そこで開発したのが、AI 웹 스크래퍼 Chrome拡張機能です。

仕組みは?

- ThunderbitはウェブページをMarkdown形式に変換し、より整理された構造にします。

- そのMarkdownをAIが解析し、フィールドや関係性、文脈を自動で特定。価格やレビュー、装飾用の絵文字まで区別します。

- 結果として、レイアウト変更や動的コンテンツ、DOM構造の変化にも強い、ラベル付きの構造化データが得られます。

ビジネスユーザーにとっては、手作業でのデータ整理や壊れやすいスクリプトの修正が激減し、本来の分析に集中できるのが大きなメリット。開発者にとっても、ブラウジングの自動化(ログインやクリック、スクロール)は自分で行い、データ抽出の面倒な部分はThunderbitに任せることができます。

実践:JavaScriptによる웹 스크래핑(従来手法とThunderbit活用)

実際に手を動かしてみましょう。ここでは、ECサイトの商品リストを例に、まずPuppeteerを使った従来手法、次にThunderbitで効率化する方法を紹介します。

ステップ1:JavaScript스크래핑環境の準備

まずはをインストール。その後、Puppeteerを導入します:

1npm install puppeteer複数ブラウザ対応のPlaywrightを使いたい場合は:

1npm install playwrightプログラミング初心者でも、コードをコピペして動かせばOK。各部分の役割も解説します。

ステップ2:動的ページの操作と自動化

最近のサイトはログインやポップアップ、무한 스크롤でデータを隠しがち。Puppeteerでこれらを自動化する例です:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // ログインページへ移動

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'your_username');

8 await page.type('#password', 'your_password');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // 商品リストページへ

12 await page.goto('https://example.com/products');

13 // スクロールして商品を追加読み込み

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // 商品が表示されるまで待機

21 await page.waitForSelector('.product-card');

22 // ...(次のステップでデータ抽出)

23})();このスクリプトはログインし、商品ページに移動、スクロールして商品を読み込みます。要素が表示されるまで待つのがポイントです。

ステップ3:JavaScriptでデータを抽出

各商品が.product-card内にある場合、次のようにデータを取得します:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);よくある落とし穴:

- セレクタが壊れやすい:

.product-titleが.titleに変わると動かなくなります。 - 非表示データ:価格やレビューがAJAXで後から読み込まれる場合も。

- 봇対策:リクエストが多すぎるとブロックされることも。

ステップ4:Thunderbit AIで抽出を強化

ここでThunderbitの出番。セレクタや複雑なロジックに悩まず、レンダリング後のHTML(またはスクリーンショット)をThunderbitに渡すだけでAIが抽出してくれます。

実際の流れ:

- PuppeteerやPlaywrightでブラウジングやログイン、ページ遷移を自動化

- 抽出したいページでHTMLを取得:

1const pageContent = await page.content();- このHTMLをでAI抽出

Thunderbitは:

- ページをMarkdownに変換し、意味解析しやすくします

- AIでフィールドや関係性、文脈を特定

- ExcelやGoogle Sheets、Airtable、Notionにエクスポート可能な構造化データを出力

もうセレクタの変更やデータの手直しに悩む必要はありません。

動的コンテンツや非同期読み込みへの対応

動的コンテンツは스크래퍼泣かせ。무한 스크롤や「もっと見る」ボタン、AJAXで後から読み込まれるレビューなどが典型です。

従来の対策:

waitForSelectorで要素が現れるまで待つ- 「ネットワークアイドル」(リクエストが止まる)まで待機

- スクロールやクリックを手動でトリガー

でも、これらはサイトの仕様が変わるとすぐ壊れます。

Thunderbitのアプローチ: ページをMarkdown化しAIで構造を解析するため、特定のDOM構造やIDに依存しません。レイアウトが変わってもコンテンツが存在すれば、AIが自動で見つけて抽出できることが多いです。メンテナンス負担が減り、データ取得の信頼性がアップします。

持続可能なデータパイプライン構築:スクリプトからビジネス活用へ

스크래핑は一度きりの作業じゃなく、データパイプラインの起点です。僕のおすすめフロー:

- JavaScript(Puppeteer/Playwright)で自動化・抽出

- ThunderbitでAIによる構造化・ラベリング

- ExcelやGoogle Sheets、Airtable、Notionなどにエクスポート

- Thunderbitので定期実行(例:「毎週月曜9時」など)

- 構造化データを業務フローに連携(営業リスト、価格監視、市場調査など)

この組み合わせなら、再現性が高く、メンテナンス不要なデータパイプラインを構築できます。

まとめ:目的に合った웹 스크래핑手法の選び方

web scraping javascriptで最適な方法は?僕の結論:

- 従来のJavaScript스크래핑(Cheerio, Puppeteer, Playwright)は、シンプルな静的サイトや細かい自動化が必要な場合に有効。ただし、セレクタの修正やレイアウト変更、봇対策などメンテナンスの手間がつきもの。

- ThunderbitのAI抽出は、ページの意味を理解してデータを取得するため、レイアウト変更にも強く、手作業のデータ整理が不要。スクリプトのデバッグに悩まず、分析に集中できます。

使い分けの目安:

- シンプルなページの単発스크래핑ならCheerioやPuppeteerで十分

- 複雑・動的なサイトや、将来のメンテナンスを考えるならThunderbitのAI抽出と組み合わせるのがおすすめ

- コード不要で手軽にデータ化したいビジネスユーザーには、Thunderbit Chrome拡張が最短ルート

さらに詳しい事例はで、やなども紹介しています。

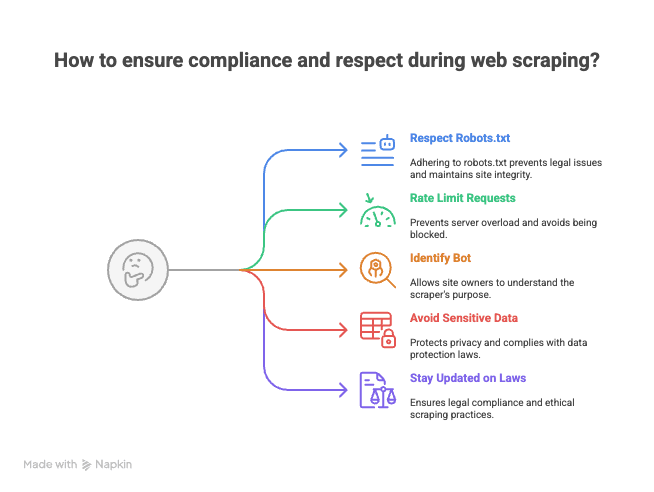

おまけ:스크래핑時の法令遵守とマナー

스크래핑を始める前に、ウェブ管理者から「ご丁寧な」メールをもらった経験からアドバイス:

- robots.txtや利用規約を必ず確認・遵守しよう

- リクエストの間隔を空けるなど、サーバーに負荷をかけない工夫を

- User-Agentを明示し、봇であることを伝える

- 個人情報や機密データの取得は避ける。公開情報のみに限定

- 法的なルールや最新のベストプラクティスを把握しておく

「大きな力には大きな責任が伴う」——스크래핑も同じ。時には警告メールが届くこともあるので、節度を持って活用しよう。

web scraping javascriptは、まさに技術と工夫の融合。AIの力も借りれば、ウェブを自分だけのデータ資源に変えることができます。もし困ったときは、コーヒー片手にThunderbitを開いてセレクタと格闘している僕を思い出してください。

ハッピー・스크래핑!

よくある質問(FAQ)

1. JavaScriptでの웹 스크래핑とは?なぜ人気なの?

JavaScriptでの웹 스크래핑は、ブラウザやNode.js上でスクリプトを実行し、ウェブサイトからデータを自動取得する手法です。DOMへ直接アクセスでき、HTTPリクエストや自動化のライブラリが豊富、ログインやクリック、スクロールなど柔軟な操作が可能な点が人気の理由です。

2. 現代の動的ウェブサイトを스크래핑する主な課題は?

最近のウェブサイトはJavaScriptフレームワークで動的にコンテンツを生成し、무한 스크롤やポップアップでデータを隠し、レイアウトも頻繁に変わります。そのため、従来の스크래핑手法はセレクタの変更や非同期データの取得で壊れやすくなっています。

3. Cheerio、Puppeteer、Playwrightなど従来のJavaScript스크래핑ツールの違いは?

- Cheerioは静的HTML向けで高速ですが、JavaScriptで生成されたコンテンツやブラウザ自動化はできません。

- PuppeteerとPlaywrightは動的ページやブラウザ自動化に対応し、JavaScriptコンテンツも取得可能。ただし速度は遅めでセットアップも必要。Playwrightは複数ブラウザ対応、Puppeteerは主にChrome専用です。

4. Thunderbitは従来手法と比べてどんなメリットがある?

ThunderbitはAIでページをMarkdown化し、意味を理解してラベル付きデータを抽出します。レイアウト変更にも強く、手作業のデータ整理やメンテナンスの手間を大幅に削減できます。

5. ス크래핑時の法令遵守・マナーのベストプラクティスは?

- robots.txtや利用規約を必ず確認・遵守

- サーバー負荷を避けるためリクエストを制限

- User-Agentで봇を明示

- 個人情報や機密データの取得は避け、公開情報のみ取得

- 法的なルールや最新のベストプラクティスを把握

さらに詳しく知りたい方へ: