新製品のリリース情報を初めて追いかけたときのドキドキ感、今でも鮮明に覚えています。モニターにはGoogleニュースのタブがずらりと並び、競合の突然の発表やPRトラブルを見逃さないかと、ずっと気が気じゃありませんでした。実際、これは自分だけの悩みじゃなく、今やがネットに公開されている時代。全部チェックするなんて現実的じゃないし、コーヒー片手にサクッと目を通すのも到底無理ですよね。

営業、マーケ、オペレーション、PR…どの部署でもこの「情報の洪水」問題は共通です。手作業でニュースを追うのは、まるで消火栓から水を飲もうとするようなもの。だからこそ、pythonでgoogleニュースをスクレイピングするのは、現代ビジネスの強力な武器になります。自動でニュースを集めて、分析しやすい形に整理できるから、ブランド監視や競合調査、トレンドの早期キャッチなど、重要な情報を見逃さずに済みます。このガイドでは、初心者向けのサンプルから実用的なgoogleニューススクレイパー pythonの作り方まで、コード例やベストプラクティス、分析に役立つコツを交えて分かりやすく解説します。

ビジネスユーザーがgoogleニューススクレイピングを活用すべき理由

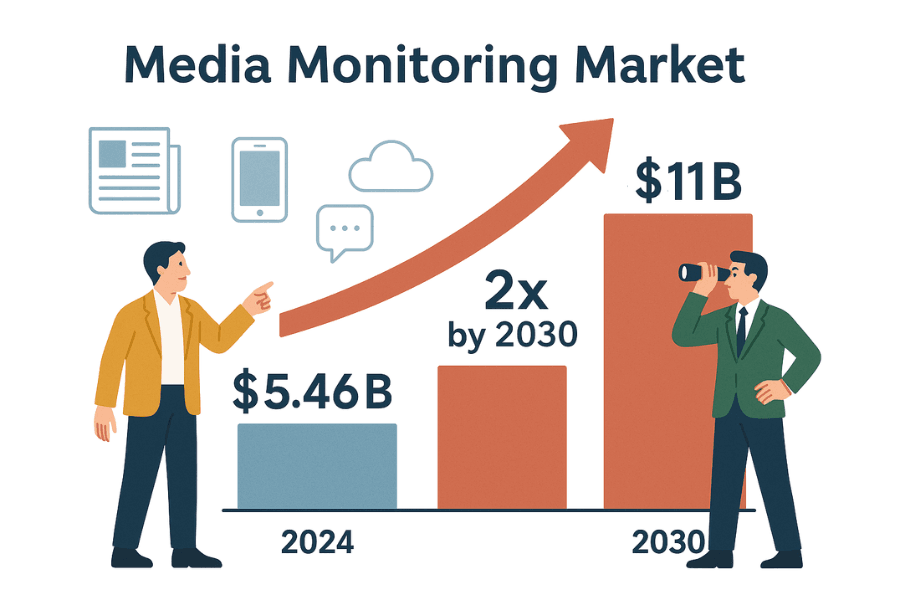

ビジネスのスピードはニュースの速さと直結しています。PRや営業、戦略部門など、今何が話題かを即キャッチすることが求められます。世界のメディアモニタリングツール市場はすでに規模で、2030年には倍増する見込み。企業が自社の評判や売上、法令遵守に関わるニュースを見逃せないからです。

googleニュースのウェブスクレイピングで「情報通」になれる理由をまとめました:

| 活用例 | 自動ニュースデータのメリット |

|---|---|

| ブランド評判の監視 | ネガティブな報道や危機を早期キャッチし、素早く対応(Doveのニュース監視がPR危機を回避した事例を参照)。 |

| 競合インテリジェンス | 競合の新製品発表や経営陣の交代、M&A動向を把握し、自社戦略に活用(詳細)。 |

| セールスリードの発掘 | 見込み顧客の資金調達や事業拡大、注目イベントをモニタリング(事例)。 |

| トレンド・市場分析 | 業界ニュースを集約し、新たなトレンドや市場の動向をいち早く察知(なぜ重要か)。 |

| リスク管理 | 訴訟や規制、政策変更などビジネスに影響するリスク情報を自動で検知(例)。 |

手作業での追跡は遅いし、ミスも多くて大事なチャンスやリスクを見逃しがち()。でも自動スクレイピングなら、常に最新で構造化されたニュースフィードを手に入れられます。もう「情報難民」になる心配はありません。

はじめに:pythonでgoogleニュースをスクレイピングする前の基礎練習

いきなり本番に行く前に、まずは練習用サイトでウェブスクレイピングの基本を身につけましょう。ここは練習用なので、ブロックや規約違反を気にせず安心してトライできます。

進め方はこんな感じです:

- ホームページにリクエストを送る

- BeautifulSoupでHTMLを解析

- 本のタイトルと価格を抽出

- pandasのDataFrameに保存してCSV出力

- ページ送りやエラー処理も実装

ステップ1:リクエスト送信とHTML解析

まずはPythonのrequestsライブラリでホームページを取得:

1import requests

2url = "http://books.toscrape.com/index.html"

3response = requests.get(url)

4print(response.status_code) # 200ならOKステータスコード200が返れば成功です()。

次にHTMLを解析:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(response.text, 'html.parser')これでsoupオブジェクトができ、ページのDOMをPythonで操作できます()。

ステップ2:データ抽出とCSV保存

本のリストを取得:

1books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

2print(f"Found {len(books)} books on this page")タイトルと価格を抽出:

1book_list = []

2for item in books:

3 title = item.h3.a["title"]

4 price = item.find("p", class_="price_color").get_text()

5 book_list.append({"Title": title, "Price": price})pandasでCSVに保存:

1import pandas as pd

2df = pd.DataFrame(book_list)

3df.to_csv("books.csv", index=False)標準のcsvモジュールでもOK:

1import csv

2keys = book_list[0].keys()

3with open("books.csv", "w", newline="", encoding="utf-8") as f:

4 writer = csv.DictWriter(f, fieldnames=keys)

5 writer.writeheader()

6 writer.writerows(book_list)books.csvをExcelで開けば、データ収集の威力を実感できます。

ステップ3:ページ送りとエラー処理

全ページの本を取得したい場合はループを使います:

1all_books = []

2for page in range(1, 51): # 全50ページ

3 url = f"http://books.toscrape.com/catalogue/page-{page}.html"

4 try:

5 res = requests.get(url, timeout=10)

6 if res.status_code != 200:

7 break

8 soup = BeautifulSoup(res.text, 'html.parser')

9 books = soup.find_all("li", {"class": "col-xs-6 col-sm-4 col-md-3 col-lg-3"})

10 for item in books:

11 title = item.h3.a["title"]

12 price = item.find("p", class_="price_color").get_text()

13 all_books.append({"Title": title, "Price": price})

14 except requests.exceptions.RequestException as e:

15 print(f"Request failed: {e}")

16 continueこのループでページ送りやネットワークエラーにも対応できます。(マナーとしてtime.sleep(1)でリクエスト間隔を空けましょう)

これでウェブスクレイピングの基本(リクエスト、解析、抽出、ページ送り、エラー処理)が身につきました。googleニュースのウェブスクレイピングでも同じ考え方が使えます。

pythonでgoogleニュースをスクレイピング:実践編

いよいよ本番。googleニュースの見出し、リンク、ソース、日時などを自動で取得し、分析用データに変換しましょう。

Python環境の準備

Python 3と以下のライブラリをインストールしてください:

1pip install requests beautifulsoup4 pandas()

GoogleにブロックされないようUser-Agent文字列も用意しましょう()。

googleニューススクレイパー pythonの作り方

手順を分かりやすく分解します:

1. 検索URLとパラメータの設定

Googleニュースの検索URLはこんな感じ:

1https://news.google.com/search?q=YOUR_QUERY&hl=en-US&gl=US&ceid=US:enq: 検索キーワードhl: 言語(例:en-US)gl: 国(例:US)ceid: 国と言語(例:US:en)

Pythonでの設定例:

1base_url = "https://news.google.com/search"

2params = {

3 'q': 'technology',

4 'hl': 'en-US',

5 'gl': 'US',

6 'ceid': 'US:en'

7}

8headers = {

9 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)...'

10}()

2. 結果ページの取得

1response = requests.get(base_url, params=params, headers=headers)

2html = response.text

3print(response.status_code)()

3. データの解析と抽出

HTMLを解析し、記事情報を抽出:

1soup = BeautifulSoup(html, 'html.parser')

2articles = soup.find_all('article')

3news_data = []

4for art in articles:

5 headline_tag = art.find('h3')

6 title = headline_tag.get_text() if headline_tag else None

7 link_tag = art.find('a')

8 link = link_tag['href'] if link_tag else ''

9 if link.startswith('./'):

10 link = 'https://news.google.com' + link[1:]

11 source_tag = art.find(attrs={"class": "wEwyrc"})

12 source = source_tag.get_text() if source_tag else None

13 time_tag = art.find('time')

14 time_text = time_tag.get_text() if time_tag else None

15 snippet_tag = art.find('span', attrs={"class": "xBbh9"})

16 snippet = snippet_tag.get_text() if snippet_tag else None

17 news_data.append({

18 "title": title,

19 "source": source,

20 "time": time_text,

21 "link": link,

22 "snippet": snippet

23 })()

CSVに保存:

1df = pd.DataFrame(news_data)

2df.to_csv("google_news_results.csv", index=False)欠損データへの対応

タグが存在するか必ず確認しましょう。GoogleのHTMLは一定じゃないので、抜けている項目はNoneや空文字で処理します。

複数ページの取得とレート制限対策

Googleニュースは無限スクロール方式なので、requestsでは最初の結果しか取得できません。もっと多くの記事が必要な場合は:

- クエリのRSSフィードを利用()

- ヘッドレスブラウザ(SeleniumやPlaywright)でスクロール(上級者向け)

- 頻繁にスクレイピングして新着記事をキャッチ

注意: スクレイピングが速すぎるとGoogleにブロックされます。10回程度の連続リクエストで429エラーが出ることも()。

time.sleep(random.uniform(2,6))でリクエスト間隔を空ける- 大量取得時はUser-AgentやIPをローテーション

- CAPTCHAやブロックページを検知したら中断

googleニュース結果のスクレイピングを再現性・分析向けに仕上げるコツ

良いスクレイピングは「データを取る」だけじゃなく、再現性と分析しやすさが大事。 BIダッシュボードやPRモニタリング、競合追跡を長期運用するなら、言語・地域・時間・重複管理は必須です。

言語・地域・時間での絞り込み

Googleニュースはパーソナライズが強いので、安定した結果を得るには:

hl(言語)、gl(国)、ceid(国:言語)パラメータを活用()- 例:韓国ニュースなら

hl=ko&gl=KR&ceid=KR:ko、インド英語ならhl=en-IN&gl=IN&ceid=IN:en

時間での絞り込み:

- Googleニュースは「過去24時間」などのURLパラメータはありませんが、通常は新しい順に並びます

- スクレイピング後に

timeが「hour ago」「minutes ago」「Today」などを含む記事だけを抽出 - さらに細かく制御したい場合はRSSや検索演算子を活用

ニュース結果のフィルタリングと重複排除

重複は分析の大敵。対策例:

- ソース・トピックのホワイトリスト:特定の媒体やトピックだけを抽出。クエリに

source:演算子も使えます(例:q=Tesla source:Reuters)。 - URLで重複排除:トラッキングパラメータ(

utm_*など)を除去して正規化。

1import urllib.parse

2clean_link = urllib.parse.urljoin(link, urllib.parse.urlparse(link).path)()

- タイトルで重複排除:似たタイトルは1件だけ残す。小文字化や記号除去でざっくり一致判定。

- 既読記事の管理:毎日スクレイピングする場合は、正規化URLのハッシュを保存し、重複を防ぐ。

こうすることで、データがクリーンになり、分析やレポート作成も正確に行えます()。

比較:python自作スクレイパー vs. GoogleニュースAPI

自作のpythonスクレイパーと外部のGoogleニュースAPIサービス、どちらが良いのでしょうか?

| 比較項目 | 自作Pythonスクレイパー | 外部GoogleニュースAPIサービス |

|---|---|---|

| 実装の手間 | コード作成・デバッグ・サイト変更対応が必要 | API呼び出しのみ、HTML解析不要 |

| 柔軟性 | 欲しい項目やリンクも自由に抽出可能 | APIが対応する項目のみ取得可能 |

| データ管理 | 生データを完全にコントロールできる | 加工済みデータを受け取る(解析はAPI任せ) |

| スケール・速度 | IPやリソースに依存、ブロックリスクあり | プロバイダーがプロキシ・ブロック対策済みで大規模対応 |

| 信頼性 | GoogleのHTML変更やIPブロックで動かなくなることも | API側が自動で対応し高い信頼性 |

| メンテナンス | セレクタやアンチボット対策の更新が必要 | プロバイダーが保守対応 |

| コスト | 無料(時間やプロキシ費用は別) | 有料(リクエスト数や月額課金、価格例) |

| ブロックリスク | 注意しないと高い、GoogleにIPを止められる | API側でブロック・リトライ対応 |

| データ鮮度 | 好きなタイミングで取得できるが、頻度が高いとブロックリスク | 高頻度・リアルタイム取得も可能(プラン次第) |

| 法的・利用規約 | Googleの規約順守は自己責任 | APIも注意は必要だが、運用はAPI側が主導(法的助言ではありません) |

学習や小規模用途なら自作が最適。大規模運用や安定性重視ならAPIが便利です。(両方の良いとこ取りをしたいなら、後述のThunderbitもおすすめ)

googleニューススクレイピングでよくあるトラブルと対策

googleニュースのウェブスクレイピングは、必ずしも順調とは限りません。主なトラブルと対策をまとめました:

- CAPTCHAや「異常なトラフィック」ページ:リクエスト間隔を空け、User-Agentを変え、必要ならプロキシを使う。CAPTCHAが出たら一旦中断()。

- HTTP 429/503エラー:レート制限やブロック。指数的なリトライ、robots.txtの確認、並列実行の回避。

- HTML構造の変化:GoogleのUI変更に合わせてセレクタを更新。try/exceptでエラー回避。

- データ項目の欠損:全ての記事にスニペットやソースがあるとは限らないので、柔軟に対応。

- 重複データ:前述の重複排除を実装。

- 文字化け・エンコーディング問題:ファイル保存時はUTF-8を指定。

- JavaScriptで生成されるコンテンツ:通常はサーバーサイドですが、必要に応じてSeleniumやPlaywrightを利用。

さらに詳しいトラブルシューティングはやも参考にしてください。

googleニューススクレイピングの倫理とベストプラクティス

スクレイピングの力には責任が伴います。以下の点に注意しましょう:

- robots.txtの尊重:Googleニュースのrobots.txtで禁止されているパスは避けましょう()。

- サーバーへの負荷を避ける:リクエスト間隔を空け、深夜など混雑しない時間帯に実行。

- 許可された用途で利用:見出しやスニペット、リンクのみを分析目的で利用し、記事全文の転載は避ける()。

- 出典の明記:分析結果を共有する際はGoogleニュースや元記事の媒体名を明記。

- スクレイパーの定期的な見直し:ウェブの変化に合わせてコードも更新。

- プライバシー・法令順守:データは安全に保管し、個人情報保護法などに従う。

- フェアユースとレート制限:無理な大量取得は避け、要請があれば速やかに停止()。

要するに、「ネットの良き市民」としてスクレイピングを行いましょう。将来の自分やIT部門もきっと助かります。

まとめと次のステップ

おさらいです:

- PythonのrequestsとBeautifulSoupでウェブスクレイピングの基本を学び、静的サイトからgoogleニュースまで応用できるようになりました。

- 再現性の高いgoogleニューススクレイピングのワークフローを構築し、言語・地域・時間の制御や重複排除、分析しやすいデータ作成のコツを習得。

- 自作スクレイピングとAPIの違いを理解し、コントロール・信頼性・コストのバランスを把握。

- トラブル対策や倫理的な運用方法も身につけました。

次は、これらの技術を自社のブランド監視や競合調査、カスタムニュースダッシュボード構築などに活用してみましょう。さらに発展させたい方は、他のニュースサイトのスクレイピングやデータパイプラインの自動化、見出しの感情分析などにも挑戦してみてください。

もしPythonスクリプトの保守に疲れた、またはもっと手軽に始めたいならをぜひ試してみてください。ThunderbitはAI搭載のウェブスクレイパーChrome拡張機能で、Googleニュースや他のサイトも数クリックでスクレイピングできます。コード不要で、「AIフィールド提案」や定期実行、サブページ自動巡回、ExcelやGoogleスプレッドシートへの即時エクスポートなど、チームのニュース収集を劇的に効率化します。()

さらにスクレイピングのコツはや、、、もぜひチェックしてみてください。

快適なスクレイピングライフを!あなたのニュースフィードがいつも新鮮で、構造化され、競合より一歩先を行けることを願っています。

執筆:Shuai Guan(Thunderbit共同創業者・CEO)。SaaS・自動化・AI分野で長年活動し、混沌としたデータをクリーンで使える情報に変えるのが今でも大好きです。質問やスクレイピング談義は気軽にどうぞ。

よくある質問(FAQ)

1. なぜ企業はpythonでgoogleニュースをスクレイピングすべき?

googleニュースのウェブスクレイピングで、自社や競合、業界に関するニュース記事を自動収集できます。PR危機の早期発見、競合動向の把握、営業インサイトの獲得、市場トレンド分析、リスク管理などがリアルタイムで可能に。手作業では見逃しがちな情報も、スクレイピングなら構造化された最新フィードとして確実に入手できます。

2. pythonでgoogleニュースをスクレイピングする基本手順は?

主な流れは:

requests、BeautifulSoup、pandasなどのライブラリを用意- googleニュースの検索URLとパラメータ(クエリ、言語、地域など)を設定

- 適切なヘッダー(User-Agent含む)でリクエストを送信

- HTMLを解析し、タイトル・リンク・ソース・日時・スニペットなどを抽出

- 取得データをCSVに保存

- 欠損データや重複を処理し、分析しやすいデータセットに整形

3. googleニューススクレイピングで直面しやすい課題と対策は?

主な課題と対策:

- CAPTCHAや「異常なトラフィック」警告:リクエスト間隔を空け、User-Agentを変え、必要ならプロキシを利用

- レート制限(HTTP 429/503):遅延を入れ、並列実行を避ける

- HTML構造の変化:セレクタの定期更新、try/exceptでエラー回避

- データ項目の欠損や不一致:タグの存在を都度確認

- 重複データ:URLやタイトルで重複排除

- 文字化け:UTF-8で保存

- JavaScript生成コンテンツ:必要に応じてSeleniumやPlaywrightを利用

4. googleニューススクレイピングを再現性・分析向けにするには?

hl、gl、ceidパラメータで言語・地域を制御- スクレイピング後やRSSで時間による絞り込み

- URL正規化やタイトル比較で重複排除

- 既読記事の管理で二重カウント防止

- データは安全に保管し、手順を記録しておく

5. 自作スクレイパーと外部API、どちらを選ぶべき?

自作はコントロール性・柔軟性が高く、基本無料(時間やプロキシ費用は別)ですが、保守やブロックリスクも大きいです。APIは信頼性・スケール性が高く、アンチボット対策も自動ですが、コストやデータ項目の制限があります。学習や小規模なら自作、大規模や運用重視ならAPIが最適です。