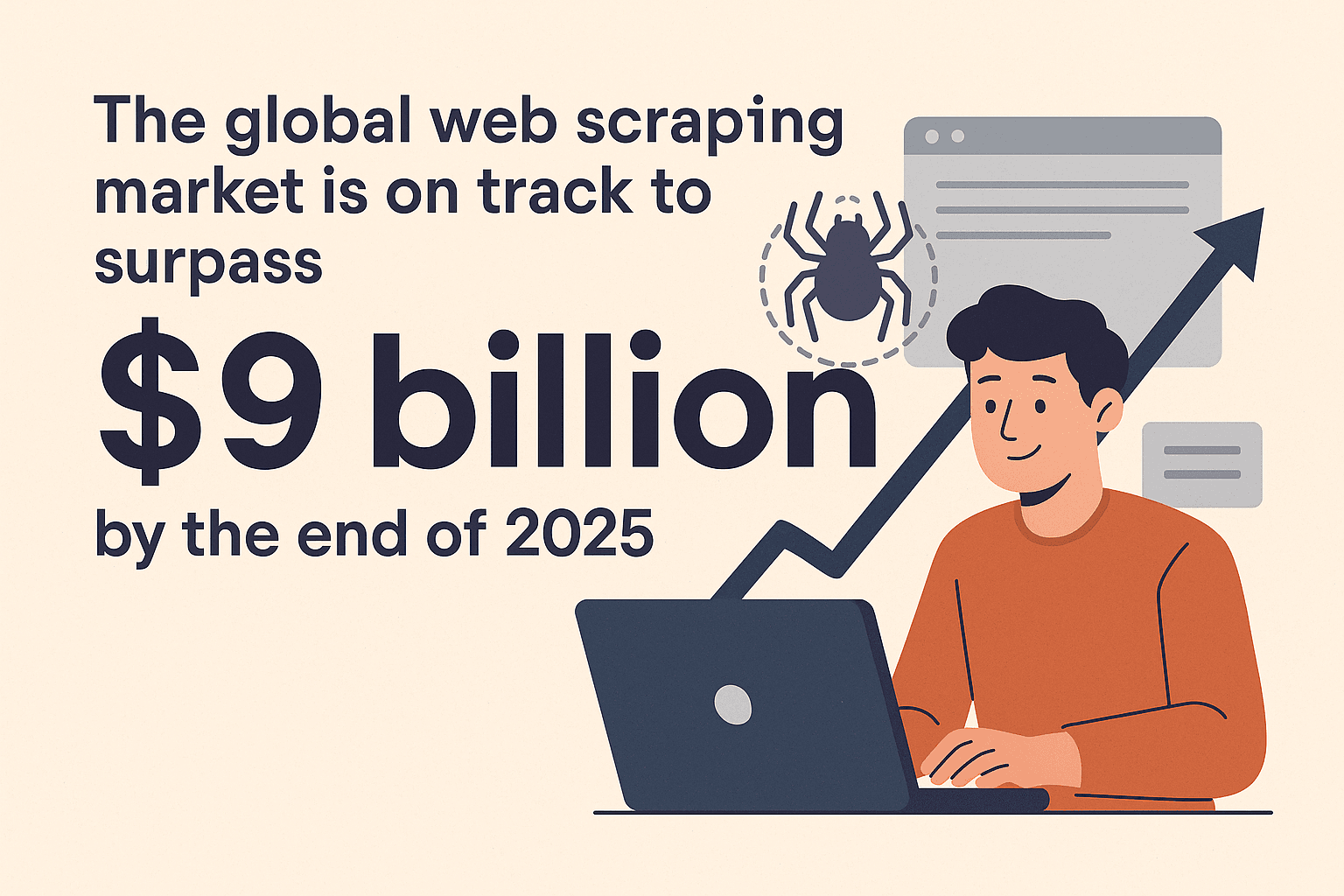

今や世界中のデータ量は爆発的に増え、その活用をめぐる競争もどんどん激しくなっています。毎日、何十億ものウェブページがウェブクローラーでスクレイピングされていて、インサイトや価格調査、リード獲得、リサーチなど、さまざまな目的で使われています。こうしたデータ活用は、ECサイトの価格競争からAI開発まで、あらゆる分野の土台になっています()。世界のウェブスクレイピング市場は2025年末には90億ドル超えが予想されていて、効率的なウェブクローラーを使いこなせないと、大きなチャンスを逃すことになりかねません()。

SaaSや自動化の現場で長くやってきた自分の経験から言うと、どんなウェブクローラーを選ぶかでプロジェクトの成否が決まることが本当に多いです。最近特に注目しているのがRust。この記事では、Rustがウェブクローラー開発に向いている理由や導入の流れ、のようなAIツールと組み合わせてスピード・安全性・効率を最大化する方法を、実体験を交えて紹介します。

なぜRustでウェブクローラーを作るのか?

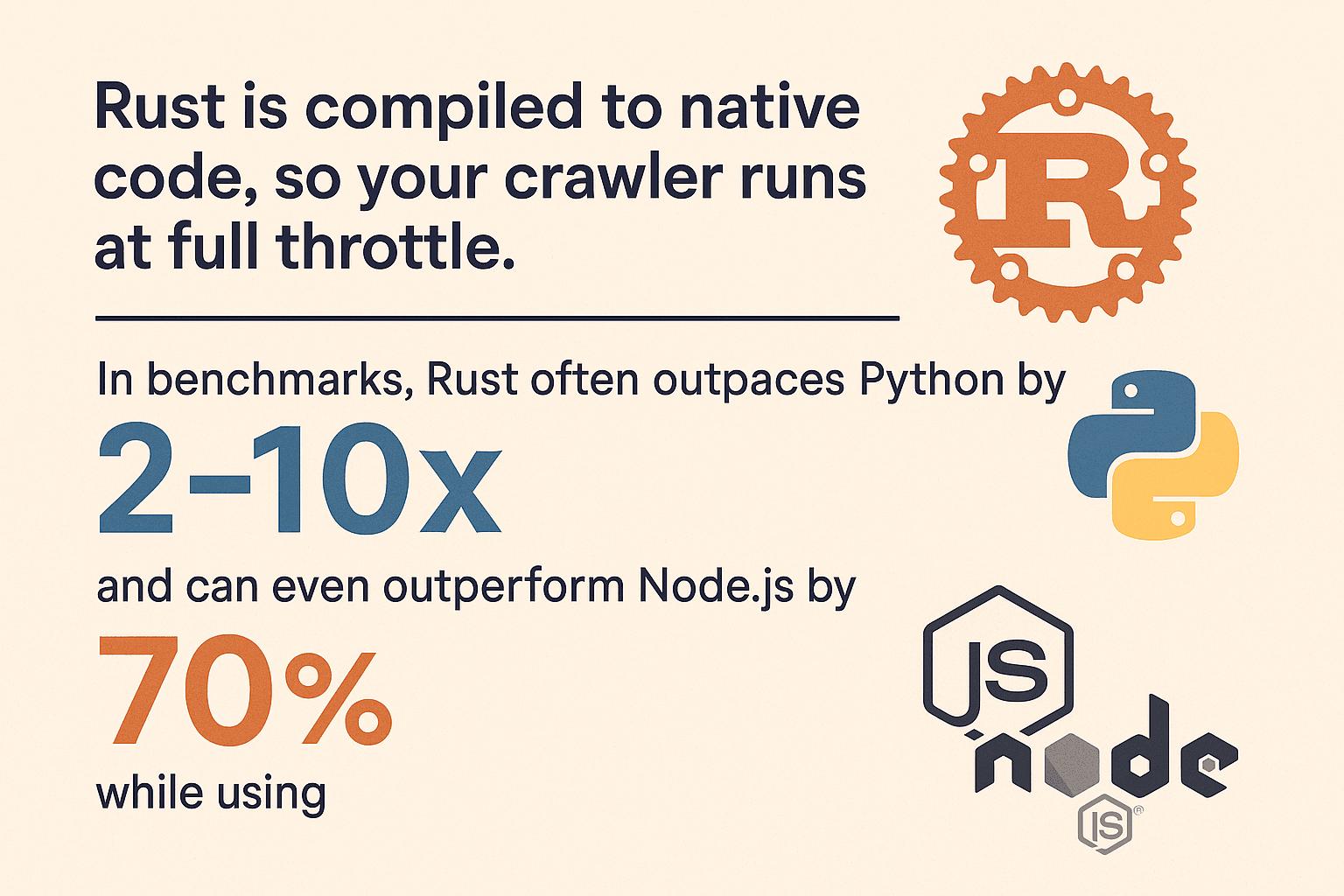

「なんでRustなの?」とよく聞かれます。特にPythonやNode.jsでスクレイピングしてきた人からは疑問に思われがち。でもRustにはこんな強みがあります:

- とにかく速い:Rustはネイティブコードにコンパイルされるので、クローラーの処理がめちゃくちゃ速い。ベンチマークだと、計算が重い処理でPythonの2〜10倍、Node.jsより70%速くてメモリ消費は90%減なんてことも(, )。

- メモリ安全性バツグン:Rust独自の所有権モデルで、メモリリークや謎のクラッシュから解放されます。バグはコンパイル時に見つかるので、安心して開発できます。

- 並列処理が得意:Rustは並列処理を前提に設計されていて、100ページ同時取得も安全にこなせます。型システムがスレッド間のデータ競合を防いでくれます。

- 信頼性が高い:

ResultやOptionでエラー処理がしっかりできるので、予期せぬクラッシュを防げます。 - セキュリティも強い:バッファオーバーフローやヌルポインタ参照の心配がなく、壊れたHTMLや悪意あるデータにも強いです。

Python(手軽だけど遅くてメモリ食い)、Node.js(I/Oは速いけどシングルスレッドで重い処理は苦手)と比べて、Rustはパフォーマンスと安定性を両立。大規模なクローリングにもピッタリです()。

Rustウェブクローラーの開発環境を整える

それじゃあ、Rustの開発環境をサクッと整えていきましょう。

1. RustとCargoのインストール

Rustはからインストールできます。OSごとにインストーラーをダウンロードして、指示通りに進めればOK。WindowsならVisual C++ Build Toolsが必要な場合もあるので注意。

インストールできたか確認するには:

1rustc --version

2cargo --versionバージョンが表示されれば準備完了!

2. 新しいプロジェクトを作る

ターミナルで以下を実行:

1cargo new rust_web_crawler

2cd rust_web_crawlerこれでCargo.tomlとsrc/main.rsができあがります。

3. 必要なライブラリを追加

ウェブクローラーにはこのあたりが便利:

- (HTTPクライアント)

- (CSSセレクタでHTML解析)

- (非同期処理ランタイム)

- (データのエクスポート用)

追加方法は:

1cargo add reqwest scraper csv tokio --features fullもしくはCargo.tomlを直接編集:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. IDEやツールの選び方

個人的にはVS Code+拡張がイチオシ。コード補完やドキュメント表示、Lintもバッチリ。大規模開発ならJetBrainsのCLionやIntelliJ+Rustプラグインもおすすめ。

5. トラブル時のコツ

cargoが見つからない時は、Rustの.cargo/binがPATHに入ってるか確認。- WindowsだとC++ビルドツールのインストールを求められることも。

- 依存関係エラーが出たら

cargo updateやCargo.tomlの記述ミスをチェック。

Rustウェブクローラーの基本実装ステップ

ここからは、ページ取得→データ抽出→CSV出力までの基本的なクローラーを作ってみます。

Webページの取得

まずはreqwestでページを取得:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}本番運用ではunwrap()の代わりにエラー処理をしっかり:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};データの解析と抽出

scraperでHTMLを解析して、商品情報を抜き出します。

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}このやり方はの手法を参考にしていて、ECやディレクトリ型サイトにも幅広く応用できます。

URL管理と重複回避

本格的なクローラーなら、リンクをたどりつつ同じページを二重にクロールしない工夫が必要です。

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // `url`クレートが便利!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}相対パスや末尾スラッシュ、フラグメントの処理にはクレートが役立ちます。

並列処理でクローリングを高速化

ここからがRustの本領発揮。1ページずつじゃなく、並列で一気にクロールしましょう。

オプション1:マルチスレッド

Arc<Mutex<>>でキューを共有して、複数スレッドで処理。小規模ならこれで十分。

オプション2:Tokioによる非同期処理

本格的に高速化したいなら非同期処理が最適。tokio+非同期reqwestで、数百リクエストを同時に投げてもメモリ消費は最小限。

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;非同期Rustは速いだけじゃなく、安全性も抜群。データ競合や謎バグとも無縁です()。

スクレイピングしたデータのエクスポート・保存

データを取ったら、csvクレートでサクッとエクスポートできます:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();で構造体をシリアライズしたり、JSON形式での出力もOKです。

Thunderbitでウェブデータ抽出をもっと手軽に

ここでの出番。自分でコードを書くのも楽しいけど、「とにかくデータが欲しい!」って時はThunderbitが最強。AI搭載のChrome拡張で、クリックだけでデータをゲットできます。

ThunderbitはAIウェブスクレイパーのChrome拡張で、ビジネスユーザーがAIの力でウェブサイトからデータを簡単に取得できる生産性ツール。繰り返し作業の自動化や時短にも大活躍です。

Thunderbitの強み

- AIによる項目提案:ページを自動解析して、名前・メール・価格など抽出すべきカラムをAIが提案()。

- ワンクリック抽出:「スクレイプ」ボタンを押すだけで、データが表形式で取得できます。

- サブページ抽出:詳細ページの情報も自動で巡回して、テーブルを充実させます()。

- ページネーション・無限スクロール対応:ページ送りや無限スクロールも自動検出。

- 無料データエクスポート:Excel、Google Sheets、Notion、Airtable、CSVなどにワンクリックで出力。

- AIオートフィル:ログインやフォーム入力もAIで自動化し、認証が必要なデータも取得可能。

Thunderbitは、動的サイトやJavaScript中心のページでもしっかり使えて、ビジネスユーザーや開発者の頼れる味方です。

ThunderbitとRustの使い分け

- Thunderbit:サクッとプロトタイプを作りたい時や、単発のデータ取得、ノーコードでチーム全員が使いたい時に最適。

- Rust:大規模・高性能・カスタマイズ重視のクローラーや、システム連携が必要な時におすすめ。

実際は、この2つを組み合わせるのが一番効率的です。

Rustウェブクローラーの他技術との比較

Rustは他の主要言語と比べてどれくらい優れているのか?

| 言語/フレームワーク | 速度 | メモリ使用量 | 並列処理 | 安定性 | エコシステム |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 低い | 🟢 優秀 | 🟢 高い | 中程度 |

| Python (Scrapy) | 🚀 | 🔴 高い | 🟡 制限あり | 🟡 普通 | 🟢 豊富 |

| Node.js | 🚀🚀 | 🔴 高い | 🟢 良い | 🟡 普通 | 🟢 豊富 |

| Go | 🚀🚀 | 🟢 低い | 🟢 優秀 | 🟢 高い | 中程度 |

- RustはPythonの2〜10倍の速さ、メモリ消費は10%以下になることも(, )。

- Node.jsはI/Oに強いけど、JS実行はシングルスレッドなので重い処理は苦手。

- Goも有力だけど、Rustのメモリ安全性とゼロコスト抽象化は長時間・高負荷クローラーで真価を発揮。

大規模クロールや最高のパフォーマンスを求めるなら、Rustがベストです。

ThunderbitとRustのハイブリッド活用で効率最大化

自分のおすすめは、ThunderbitとRustの併用。

- プロトタイピング:Thunderbitでサイト構造やサンプルデータをサクッと把握。

- 役割分担:Thunderbitで動的・認証付き・複雑なページを、Rustで静的・API中心の大量ページを担当。

- 定期スクレイピング:Thunderbitの定期実行でデータ取得、Rustでバックエンド処理や統合。

- ノンデベロッパーも活用:オペレーションやマーケ担当もThunderbitでデータ取得、開発者は高度な処理に集中。

- 柔軟性:Rustクローラーがレイアウト変更で動かなくなっても、ThunderbitのAIなら即対応。

このハイブリッド戦略で、Thunderbitの柔軟さとRustのパワーを両立できます。

Rustウェブクローラーのトラブル対策とベストプラクティス

堅牢なクローラーを作るには、コードだけじゃなく「現実のウェブのカオス」に備えることが大事です。

よくある課題

- アンチボット対策:User-Agentを本物っぽく設定、robots.txtを守る、リクエスト間隔を調整、大量クロール時はプロキシも検討()。

- CAPTCHAやログイン:CAPTCHAや複雑な認証がある場合はThunderbitのAIオートフィルや、・などのヘッドレスブラウザを活用。

- JavaScript中心のサイト:AJAXでデータ取得ならAPIを探す。どうしてもJSレンダリングが必要ならThunderbitやヘッドレスブラウザを検討。

- エラーハンドリング:

ResultやOptionで例外処理、タイムアウトやエラーログも忘れずに。 - 並列処理の落とし穴:

Arc<Mutex<>>やDashMapなどスレッドセーフな構造体を使い、共有状態のボトルネックに注意。 - メモリ管理:数百万ページをクロールする場合は、データを都度ディスクに書き出してメモリ消費を抑える。

- 倫理・法令順守:サイトの利用規約を守り、サーバーに過度な負荷をかけず、個人情報保護にも配慮。

ベストプラクティス

- モジュール設計:取得・解析・保存処理を分けて、保守性アップ。

- 設定ファイル活用:URLや並列数、遅延時間などは設定ファイルやCLI引数で柔軟に。

- ロギング:

logクレートで構造化ログを記録。 - テスト:サンプルHTMLを使ったパース処理のユニットテストを実施。

- 監視:CPU・メモリ・エラー数など、長時間稼働時のヘルスチェックも大事。

さらに詳しいトラブル対策はやも参考にどうぞ。

まとめ・ポイント

Rustでウェブクローラーを作るのは、単なる技術チャレンジじゃなく、データ活用時代の強力な武器になります。押さえておきたいポイントは:

- Rustはウェブクローリングの最強エンジン:速い・安全・並列処理に強い。

- 手順を踏んで開発:環境構築→ページ取得→解析→URL管理→並列化→データ出力の流れが大事。

- Thunderbitはノーコードで頼れる助っ人:動的・複雑なサイトも手軽にデータ取得。

- 両者の併用で効率最大化:Thunderbitでプロトタイピングや難しいページ、Rustで大規模・カスタマイズ対応。

- 現実的な選択を:時には数クリックで済む解決策が、何百行ものコードより有効なことも。

本格的にウェブクローリングを始めたい人は、ぜひRustにチャレンジしてみてください。そして、必要に応じての力も借りてみてください。さらにスクレイピングや自動化のノウハウを知りたい人はもチェック!

快適なクローリングライフを!データがいつもクリーンで速く、そしてちょっと賢くなりますように。

よくある質問(FAQ)

1. Rustでウェブクローラーを作るメリットは?PythonやNode.jsと比べてどう違う?

Rustは圧倒的なパフォーマンス、メモリ安全性、並列処理の強さが特長。PythonやNode.jsは手軽だけど、大規模・長時間・高信頼性が求められるクローラーにはRustが最適です()。

2. Rustクローラー開発に必須のライブラリは?

HTTPリクエストにはreqwest、HTML解析にはscraper、非同期処理にはtokio、データ出力にはcsvが便利。URL正規化にはurlクレートも役立ちます。

3. JavaScript中心や認証付きサイトはRustでどう対応?

API呼び出しを探すか、fantocciniなどのヘッドレスブラウザを使うのが定番。認証ページはreqwestでCookie管理、またはThunderbitのAIオートフィル機能で自動ログインも可能です。

4. ThunderbitとRustを組み合わせるメリットは?

ThunderbitはAIによるノーコード抽出で、プロトタイピングや動的ページ、ノンデベロッパーの活用に最適。Rustはカスタム・高性能クローラーに最適。両者を組み合わせることで、スピードと拡張性を両立できます。

5. クローリングでブロックやBANを避けるには?

robots.txtの遵守、リアルなヘッダー設定、リクエスト間隔の調整、大量クロール時はプロキシ利用を検討。常に倫理的に、利用規約や個人情報保護法も守りましょう()。

Thunderbitの実力を体験したい人は、して、賢くスクレイピングを始めてみてください。さらにウェブ自動化の深掘り記事はで!

さらに詳しく知りたい方へ