Googleがネットの隅々まで把握しているように感じるのは、どうしてなんだろう?2012年に書いたあの地味なブログ記事まで検索で出てくるのって、ちょっと不思議だよね。でも、これは魔法でもなければ、徹夜でネットを巡回しているインターンの仕業でもないんだ。その正体は「クローラー」と呼ばれるデジタルの探検家たち。彼らは世界中のウェブサイトを巡回して、情報を集めて整理し、インデックス化している。自分も長年自動化やAIツールの開発に関わってきて、クローラーがネット体験にどれだけ大きな影響を与えているか、身をもって感じている。ウェブサイト運営者にとって、クローラーの仕組みを知ることは単なる好奇心じゃなくて、「見つけてもらえるか、埋もれてしまうか」の分かれ道なんだ。

この記事では、クローラーの基本から、彼らがどうやってサイトを「見て」いるのか、SEOのカギになる理由、そしてあなたのコンテンツがネットの闇に埋もれないための対策まで、分かりやすく解説していくよ。さらに、最近注目しているAI搭載の新しいツールが、ウェブサイト運営やデータ活用の現場をどう変えているのかも紹介するね。

クローラーの基本:何をしている?どう動く?

クローラーは、まるでデジタル図書館の司書、もしくは整理整頓が得意なクモみたいな存在。技術的には「クローラー(スパイダー、ボットとも呼ばれる)」は、ウェブサイトを自動で巡回してページを取得し、リンクをたどって見つけた情報を集めるソフトウェア。GoogleやBingなどの検索エンジンは、こうしたクローラーによって膨大なウェブコンテンツのインデックスを作っているんだ。

クローラーの基本的な流れはこんな感じ:

- 既知のURLリストからスタート(例:トップページや「シード」サイト)

- 各ページのHTMLを取得

- ページ内のリンクを抽出し、次に巡回するリストに追加

- このプロセスを繰り返し、新しいページをカタログ化し、検索エンジンのインデックスを更新

図書館の司書が本棚を走り回って、すべての本のタイトルを記録し、相互参照しているイメージを持つと分かりやすい。クローラーがいなければ、ウェブの大半は検索エンジンにもユーザーにも見つけてもらえないんだ。

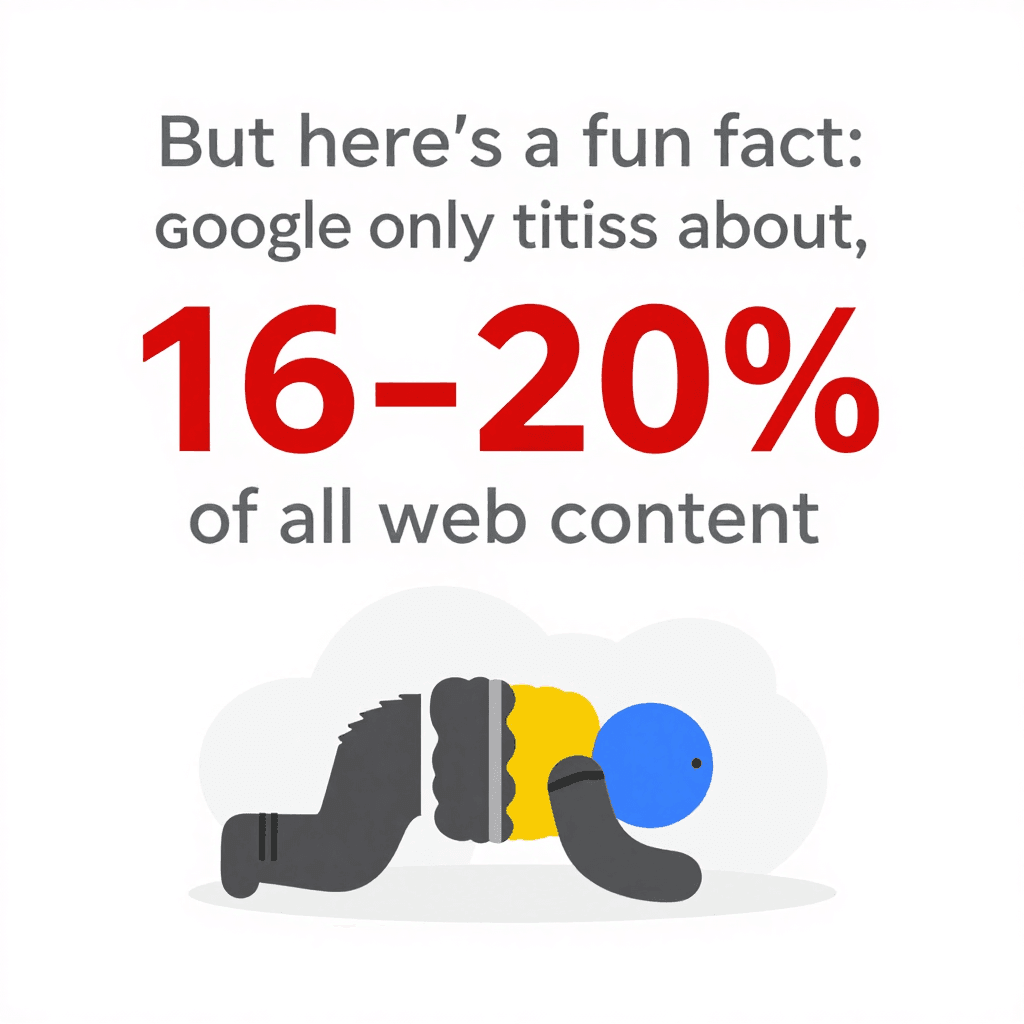

ちなみに、Googleのクローラーがどれだけ頑張っても、実際にインデックスされているのはしかない。残りは「ディープウェブ」と呼ばれていて、ほとんどのクローラーの目に触れないまま。つまり、サイトの構造やクローラーへの配慮が、検索で見つけてもらえるかどうかを大きく左右するってこと。

ちなみに、Googleのクローラーがどれだけ頑張っても、実際にインデックスされているのはしかない。残りは「ディープウェブ」と呼ばれていて、ほとんどのクローラーの目に触れないまま。つまり、サイトの構造やクローラーへの配慮が、検索で見つけてもらえるかどうかを大きく左右するってこと。

クローラーはウェブサイトをどう「見る」?

クローラーは人間みたいにウェブサイトを見ているわけじゃない。おしゃれなフォントや画像、凝ったアニメーションには興味がなくて、HTMLの生データを読み取ってテキストやタグ、リンクを解析している。建物の設計図を読むような感覚だね。

クローラーが重視するポイントはこんな感じ:

- HTML構造:見出し、段落、リスト、リンクなど

- 内部リンク:サイト内の各ページをつなぐ道。リンクがなければ、そのページはクローラーにとって「存在しない」も同然。

- ナビゲーションとサイトマップ:整理されたメニューや最新のサイトマップは、クローラーにとっての地図や標識の役割。

- メタデータや構造化データ:

<title>や<meta description>, Schema.orgなどのマークアップは、ページの内容をクローラーに伝える大事なヒント。

ウェブサイトを「都市」に例えるなら、クローラーは配達員。内部リンクやサイトマップは、彼らが迷わず目的地にたどり着くための道路標識や地図なんだ。

サイトマップとrobots.txtがクローラーに与える影響

クローラーの動きを左右する2つの重要なファイルがあるよ:

-

XMLサイトマップ:サイト内の主要ページをリスト化した機械可読なファイル。図書館司書に「本の一覧表」を渡すようなもの。特に大規模・複雑なサイトでは、サイトマップを用意することでする。

-

robots.txt:サイトのルートに置くテキストファイルで、クローラーに「どこにアクセスしていいか/ダメか」を指示する。管理画面や重複ページをブロックしたいときに使うけど、

Disallow: /みたいなミスで全ページをブロックしちゃうこともあるから注意。robots.txtを活用してしよう。

ワンポイント:robots.txtで必ずサイトマップの場所を案内しよう。「まずはここから見てね!」っていう合図になるよ。

クローラーがウェブサイトにもたらす影響:SEOと集客

クローラーがページにたどり着けなければ、そのページは「存在しない」のと同じ。クロールされなければインデックスもされず、検索流入もゼロ。せっかく作り込んだコンテンツやデザインも、Googlebotに見つけてもらえなければ意味がない。

なぜ重要か?、というデータが示す通り、クローラー対策を怠ると最大の集客チャンスを逃してしまう。

クローラーにしっかり巡回されるサイトは:

クローラーにしっかり巡回されるサイトは:

- 多くのページがインデックスされる:検索結果に表示されるチャンスが増える

- 上位表示しやすい:検索エンジンがコンテンツの関連性を正しく評価できる

- 更新が早く反映される:新しい情報がすぐに検索に反映

- ユーザー体験も向上:必要な情報が見つけやすく、信頼性や流入もアップ

リンク切れやnoindexタグの誤設定を直しただけで、アクセスが急増した事例もたくさんある。「見えているのに見つけてもらえない」っていう、よくある落とし穴だね。

クローラーが検索順位に与える影響

検索エンジンはクローラーが集めたデータをもとに、どのページがどの検索キーワードに最適かを判断している。評価ポイントは:

- コンテンツの質やキーワード

- 内部・外部リンク

- ページの新しさや更新頻度

- モバイル対応(Googleはモバイルファーストインデックスを採用)

大規模サイトでは「クロールバジェット(クロール予算)」も重要。例えば10万ページあるサイトでも、Googlebotが1日5,000ページしか巡回しなければ、全ページのインデックスに数週間かかることも。だからこそ(多くのページがトップページから数クリックで到達できる設計)が有効なんだ。

従来型クローラーの限界:現代ウェブの課題

ここからが本題。今のウェブはJavaScriptや動的コンテンツ、ログイン制限などが当たり前。従来型のクローラーは、こうした仕組みに対応できず、途中で迷子になったり、情報を取得できなかったりする。

主な課題は:

- 動的コンテンツやJavaScript:多くのクローラーは最初のHTMLしか見ない。JavaScriptで後から表示される情報(無限スクロールや「もっと見る」ボタンなど)は、基本的に見えない。GoogleのクローラーもJavaScriptをある程度レンダリングできるけど、表示が遅かったりユーザー操作が必要な場合は。

- ログインが必要なページ:ログインしないと見られないページは、ほとんどのクローラーがアクセスできない。意図的な場合もあるけど、公開したい情報が誤ってログイン制限されているケースも。

- robots.txtやメタタグの設定ミス:ちょっとしたミスで、サイト全体や重要な部分がクローラーから遮断されてしまうことも。

- ボット対策:CAPTCHAやアクセス制限、不明なユーザーエージェントのブロックなどで、クローラーが弾かれることも増えている。

している今、クローラーも進化が求められているけど、依然として見落とされるコンテンツは多いのが現状。

クローラーが苦手な動的コンテンツやJavaScript

例えば、商品一覧がスクロールに応じて表示されるECサイトの場合、従来型クローラーは最初の20商品しか認識できず、残りは見逃してしまう。レビューがタブ切り替えで表示される場合も同じ。

結果として、価値あるコンテンツがインデックスされず、検索流入のチャンスを失うことに。解決策は、ページネーションやサーバーサイドレンダリングなど、クローラーが認識できる経路を用意すること。また、Google Search ConsoleのURL検査ツールなどで、クローラー視点での見え方を確認しよう。

進化したクローラーツール:Thunderbitが複雑なページに強い理由

ここからが本題。まさにこうした課題を解決するためには生まれた。Thunderbitは単なるクローラーじゃなくて、AIを活用したウェブスクレイピングエージェント。人間のようにページを「読み」、構造化データを抽出し、現代的なウェブデザインの複雑さにも柔軟に対応する。

Thunderbitの特長は:

- AIによる項目提案:HTMLやコードを解析する必要なし。ThunderbitのAIが「商品名」「価格」「連絡先メール」など、最適なカラムを自動で提案。必要に応じて調整もできる。

- サブページの自動クロール:詳細情報が必要な場合、Thunderbitは各サブページ(商品詳細やプロフィールなど)も自動で巡回し、データを統合。手作業やコピペは不要。

- JavaScriptやログインにも対応:ThunderbitはChrome拡張機能(またはクラウド上の実ブラウザ)として動作するから、JavaScriptの実行や動的コンテンツの取得、ログイン後のページのスクレイピングもOK。

- サイト構造の変化にも強い:従来型スクレイパーはレイアウト変更で壊れがちだけど、ThunderbitのAIは毎回ページを解析するから、ちょっとした変更では止まらない。

- 定期スクレイピング:価格監視やリードリストの自動更新も、英語で「毎週月曜9時に」などと指定するだけでOK。あとはThunderbitが自動でやってくれる。

Thunderbitは、営業・マーケティング・EC・不動産など、データを活用したいビジネスユーザー向けに設計されている。Google SheetsやNotion、Airtableへのエクスポートもワンクリック(しかも無料)。

ThunderbitのAI機能でクローラー最適化

Thunderbitの真骨頂は自然言語処理。単なるテキスト抽出じゃなくて、文脈を理解してデータを分類する。例えば、電話番号・メールアドレス・商品価格の違いを自動で判別し、ラベル付けや翻訳もできる。

ユーザーからも高評価。「インフルエンサーの連絡先データ収集にThunderbitは欠かせません。以前は有料データベースを使っていましたが、今は数分で自分専用リストを作れます」といった声も。頻繁にレイアウトが変わるECサイトでも、Thunderbitなら「メンテナンス不要」で使い続けられる。

クローラーに好かれるサイト設計:構造・戦略・スマートツール

クローラーにとって理想的なサイトにするためのポイント:

- 論理的なサイト構造を設計:重要なページはトップページから数クリック以内で到達できるように。がクロール効率とインデックス率を高める。

- 内部リンクを強化:関連ページ同士を文脈に合わせてリンク。リンク切れは定期的にチェック・修正。

- 最新のXMLサイトマップを維持:重要なURLをリスト化し、Google Search ConsoleやBing Webmaster Toolsに送信。

- robots.txtを最適化:重要コンテンツへのアクセスは許可し、不要な部分のみブロック。設定ミスに注意。

- 表示速度を改善:高速でエラーのないページはクロール効率もアップ。画像最適化やCDN活用、サーバーエラーの修正も大事。

- 重複コンテンツ対策:カノニカルタグを活用し、クロールバジェットを無駄にしない。

- 構造化データ・メタデータの活用:Schema.orgマークアップやメタタグを適切に設定。

- クロール状況の監視:Google Search Consoleのインデックスカバレッジやクロール統計で早期に問題を発見。

- スマートツールでテスト:Thunderbitなどを使い、クローラー視点での見え方やデータパイプラインの健全性をチェック。

サイト構造とクローラーのニーズを一致させる

しっかり設計されたサイト構造は、クローラーだけじゃなくユーザーにもメリットがある。Screaming FrogやSitebulbなどのツールで定期的にクロール監査を行い、リンク切れや孤立ページを早期に発見しよう。

また、Googleのモバイルファーストインデックスに対応するため、モバイルサイトにも重要なコンテンツやリンクを必ず含めておこう。そうしないと、せっかくのページがインデックスから漏れてしまうリスクがある(参照)。

Thunderbitと従来型クローラーツールの比較

違いをまとめると:

| 項目 | Thunderbit(AIウェブスクレイパー) | 従来型クローラー/スクレイパー |

|---|---|---|

| 使いやすさ | ノーコード、AIが項目を提案、ビジネスユーザーも2クリックで開始可能。 | 技術的なセットアップが必要、コーディングや手動でのセレクタ設定が多い。 |

| 適応力 | AIがレイアウト変更に自動対応、メンテナンスほぼ不要。 | サイト構造が変わると動作停止、手動での修正が必要。 |

| 動的コンテンツ対応 | JavaScriptやログイン、インタラクティブ要素も標準対応。 | 静的HTMLのみ対応が多く、JSやログイン必須ページは苦手。 |

| サブページ巡回 | サブページやページネーションも自動巡回、データ統合も自動。 | 深さの設定や再帰クロールは手動で追加作業が必要。 |

| データ構造化 | AIが意味のあるカラムでテーブル出力、テキスト・数値・メール・画像・PDFなど多様なデータ型に対応。 | 生データ出力が多く、構造定義はユーザー任せ。HTML以外はカスタム実装が必要。 |

| 連携 | Google Sheets、Notion、Airtable、CSVなどにワンクリックでエクスポート。 | 手動でのエクスポート/インポートが多く、直接連携は少ない。 |

| ボット対策 | プロキシやユーザーエージェント、リトライも自動対応。成功率最大化のための多段アプローチ。 | IPブロックやCAPTCHA対策はユーザー任せ、複雑かつコスト増大しがち。 |

| 対象ユーザー | 非技術系ビジネスユーザー(営業・マーケ・運用・EC・不動産など)。 | 開発者・IT・データエンジニア向け。 |

| 料金体系 | クレジット制、無料枠あり、使った分だけ支払い。 | サブスクリプションや席数課金、サーバー・プロキシ・保守費用が隠れコストに。 |

要するに、Thunderbitは高度なクロール機能を誰でも使える形で提供。速くて正確、しかも変化の激しいウェブにも柔軟に対応できる。

まとめ:クローラーを味方につけてウェブサイトを最大活用

- クローラーはウェブの可視性を左右する存在。クローラー対策が不十分だと、検索流入や新規訪問者を逃してしまう。

- サイト構造と戦略が重要。論理的なナビゲーション、内部リンク、サイトマップ、robots.txtを活用しよう。

- 現代のウェブには賢いクローラーが必要。JavaScriptや動的コンテンツ、ログイン制限もAI搭載ツールなら対応できる。

- 継続的な監視がカギ。Search Consoleやクロール監査、スマートなスクレイピングツールでサイトの健全性を保とう。

- ツールのアップグレードを検討。SEO最適化やデータパイプライン構築には、より賢いクローラーが時短・精度向上・ビジネス判断の強化に役立つ。

Thunderbitがどんな複雑なウェブサイトでもクロール・インデックス・データ抽出をサポートできるか、ぜひして体験してみて。ウェブスクレイピングやSEO、自動化の最新情報はもチェック!

よくある質問

1. クローラーとは?なぜ自分のサイトに重要なの?

クローラーはウェブサイトを自動で巡回・インデックスするソフトウェアボット。クローラーに優しくないサイトは検索結果に表示されず、ユーザーに見つけてもらえない。

2. サイトマップやrobots.txtはクローラーにどう影響する?

サイトマップは重要ページへの道しるべ、robots.txtはアクセス許可・禁止エリアの指示書。どちらも効率的なクロールとインデックス化に不可欠。

3. 従来型クローラーが現代ウェブで直面する課題は?

JavaScript主体のコンテンツや動的要素、ログイン必須ページ、ボット対策などに弱く、重要な情報を見逃したり部分的にしかインデックスできないことがある。

4. Thunderbitは複雑なサイトにどう対応する?

ThunderbitはAIでページを「理解」し、JavaScriptやログイン後のページ、サブページや動的コンテンツも構造化データとして抽出。コーディング不要でサイト変更にも柔軟に対応。

5. クローラーに優しいサイト作りのコツは?

論理的なサイト構造、内部リンク、最新のサイトマップとrobots.txt、表示速度の最適化、クロール状況の定期監視が重要。Thunderbitのようなスマートツールでテスト・改善もおすすめ。

さらに詳しく知りたい人は、やで最新情報をチェックしてみて。

さらに詳しく