ウェブ上のデータは今や“디지털 원유”と呼ばれるほど、2025年にはセールス戦略や市場リサーチなど、あらゆる分野で活用されるのが当たり前になっています。実際、ECや부동산、SaaSなど色んな業界のチームが、複雑なウェブページを 깔끔한 스프레드시트로 변환して 업무 효율을 확 끌어올리는現場を何度も見てきました。この記事を読んでいるあなたも、きっとその波に乗りたいはず。좋은 소식입니다。Pythonを使えば、개발자가 아니어도 웹 스크래핑을 손쉽게 시작할 수 있습니다。

このガイドでは、Pythonでのウェブスクレイピングの基本から、Scrapyのようなフレームワークを使った大規模自動化まで、실전에서 바로 쓸 수 있는 단계별 노하우를 알기 쉽게 정리했습니다。また、のようなAI 탑재 툴이 비즈니스 유저에게 얼마나 데이터 추출을 쉽게 해주는지도 소개합니다。초보자부터 경험자까지 바로 써먹을 수 있는 코드 예시와 실무 팁을 한데 모았습니다。

Pythonでのウェブスクレイピングとは?概要をサクッと解説

ウェブスクレイピングは、웹사이트에서 정보를 자동으로 추출하는 기술です。つまり、컴퓨터에게 “초고속 대량 복붙”을 시키는 느낌이죠。Pythonなら、웹페이지를 불러와서 HTML을 분석하고、원하는 데이터(상품 가격, 연락처, 리뷰 등)를 콕 집어 추출하는 스크립트를 작성할 수 있습니다。

ビジネス現場では、ウェブスクレイピングは 진짜 보물창고입니다。영업 리스트 만들기, 경쟁사 가격 모니터링, 시장 동향 분석 등 흩어진 웹 정보를 정리해서 분석 가능한 데이터로 바꿀 수 있죠。Python은 강력하면서도 다루기 쉬워서, 소규모부터 대규모까지 다양한 스크래핑 프로젝트에서 사랑받고 있습니다()。

なぜPythonがウェブスクレイピングに最適なのか

왜 많은 사람들이 Python으로 웹 스크래핑을 할까요? 핵심 이유는 “간단한 문법”, “풍부한 라이브러리”, “활발한 커뮤니티” 이 세 가지입니다.

- 읽기 쉬운 문법:Python은 직관적이라서 프로그래밍 초보도 금방 시작할 수 있습니다。

- 강력한 라이브러리:BeautifulSoup, Scrapy, Requests 등 스크래핑과 HTML 분석, 크롤링에 특화된 툴이 가득합니다。

- 다재다능함:Python은 데이터 분석이나 자동화에도 강해서, 스크래핑 후 처리까지 한 언어로 끝낼 수 있습니다。

- 커뮤니티 지원:막히면 Stack Overflow 같은 곳에서 바로 해결책을 찾을 수 있습니다。

다른 언어와 비교하면 Python의 강점이 확실히 드러납니다:

| 言語 | メリット | デメリット | 得意分野 |

|---|---|---|---|

| Python | 간단한 문법, 풍부한 라이브러리, 커뮤니티 | C++나 Java에 비해 속도가 약간 느림 | 소규모부터 대규모까지 전반 |

| JavaScript | JS로 동작하는 사이트에 강함 | HTML 분석 라이브러리가 약간 부족, 비동기 처리 복잡 | SPA나 동적 사이트 |

| R | 데이터 분석에 강함 | 스크래핑용 프레임워크가 적음 | 소규모·통계 분석용 |

| Java/C# | 엔터프라이즈 용도, 처리 속도 빠름 | 코드가 장황하고 복잡 | 대규모·통합 시스템 |

Python은 웹 스크래핑 분야에서 항상 상위권에 랭크되어 있고, 2023년에는 SQL을 제치고 세계에서 세 번째로 많이 쓰이는 언어가 되었습니다()。

Pythonウェブスクレイピングの必須ツール&ライブラリ

Python으로 스크래핑을 시작한다면, 이 세트는 꼭 챙기세요:

- Requests:HTTP 요청을 쉽게 보낼 수 있는 대표 라이브러리。웹페이지 가져오기에 딱입니다。

- BeautifulSoup:HTML이나 XML 분석에 편리한 “만능 칼”。데이터 추출이나 필터링이 쉽습니다。

- Scrapy:대규모 크롤링이나 자동화에 특화된 프레임워크。

- Selenium:JavaScript로 동적으로 생성되는 페이지 자동 조작에。

- 기타:

lxml(고속 분석),pandas(데이터 가공),Playwright(최신 브라우저 자동화) 등도 유용합니다。

사용 구분 팁

- Requests + BeautifulSoup:정적 페이지나 소규모 작업에 최적。

- Scrapy:대량 페이지 크롤링이나 데이터 일괄 출력에。

- Selenium/Playwright:JavaScript로 동작하는 사이트나 사용자 조작이 필요한 경우。

스타트 가이드:Python 스크래핑 환경 준비하기

Python 초보자도 쉽게 환경을 만들 수 있습니다。

-

Python 설치:에서 Python 3.x 다운로드。경로 설정도 잊지 마세요。

-

가상환경 만들기:의존성 관리가 쉬워집니다。

1python3 -m venv venv 2# Windowsの場合: 3venv\Scripts\activate 4# Mac/Linuxの場合: 5source venv/bin/activate -

라이브러리 설치:

1pip install requests beautifulsoup4 scrapy selenium -

프로젝트 구성:소규모라면 하나의 .py 파일로 충분。Scrapy는

scrapy startproject myproject로 프로젝트 생성。 -

동작 확인:

1import requests, bs4, scrapy, selenium 2print("모든 라이브러리가 정상적으로 임포트되었습니다!") -

User-Agent 설정(추천):일부 사이트는 “Python-requests”를 차단하니, 브라우저처럼 위장하는 게 좋습니다。

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

이제 준비 끝입니다!

BeautifulSoup로 HTML 분석:Python으로 첫 웹 스크래퍼 만들기

실제로 간단한 스크래퍼를 만들어봅시다。(연습용 사이트)에서 명언과 저자를 추출합니다。

스텝1:사이트 구조 확인

- Chrome에서 사이트 열기

- 명언 부분 우클릭→“검사”

- 각 명언은

<div class="quote">안에 있고, 텍스트는<span class="text">, 저자는<small class="author">에 들어 있습니다

스텝2:스크래퍼 작성 및 실행

기본 스크립트는 아래와 같습니다:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"요청 실패: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")자주 발생하는 문제:

- 요소를 못 찾을 땐

.get_text()전에None체크를。 - 셀렉터는 브라우저에서 꼭 확인하세요。

스케일업:Scrapy로 Python 스크래핑 최적화

“한 페이지만”이 아니라 “사이트 전체를 자동으로 크롤링하고 싶다”면 Scrapy가 제격입니다。

- 아키텍처:Scrapy는 “스파이더”(크롤·분석 클래스), 파이프라인(데이터 처리), 비동기 요청으로 고속화 실현。

- Scrapy의 강점:수천 페이지 수집, 에러 처리, CSV/JSON 출력도 간단。

BeautifulSoup보다 Scrapy를 써야 할 때

- 여러 페이지를 자동으로 순회하고 싶을 때

- 재시도, 속도 조절, 데이터 파이프라인을 활용하고 싶을 때

- 정기적으로 실행하거나 팀에서 공유하고 싶을 때

Scrapy 실전 예시

전체 페이지 명언을 수집하는 스파이더 예시:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)실행 방법:

1scrapy crawl quotes -O quotes.json이렇게 하면 모든 데이터가 JSON 파일로 정리됩니다。

대규모 데이터 수집에는 Scrapy의 구조와 속도가 큰 무기가 됩니다。

Thunderbit:Python 스크래핑을 가속하는 AI 툴

솔직히 Python만으로는 동적 사이트나 서브페이지, 레이아웃 변경 대응이 꽤 번거롭습니다。이럴 때 믿고 쓸 수 있는 게 입니다。

Thunderbit는 AI가 탑재된 Chrome 확장 프로그램으로, 단 두 번 클릭만으로 웹사이트 데이터를 추출할 수 있습니다:

- AI가 항목 제안:AI가 페이지를 분석해 “상품명”, “가격” 등 최적의 컬럼을 자동 제안。

- 스크래핑 실행:한 번 더 클릭하면 페이지 넘김, 서브페이지, 무한 스크롤까지 한 번에 수집。

Thunderbit 추천 포인트:

- 노코드로 사용 가능:비즈니스 유저나 분석가에게 딱입니다。

- 복잡한 사이트도 OK:동적 콘텐츠나 레이아웃 변경도 AI가 자동 대응。

- 즉시 내보내기:Excel, Google Sheets, Airtable, Notion으로 원클릭 출력。

- 서브페이지도 자동 순회:상품이나 프로필별 상세도 자동으로 테이블에 추가。

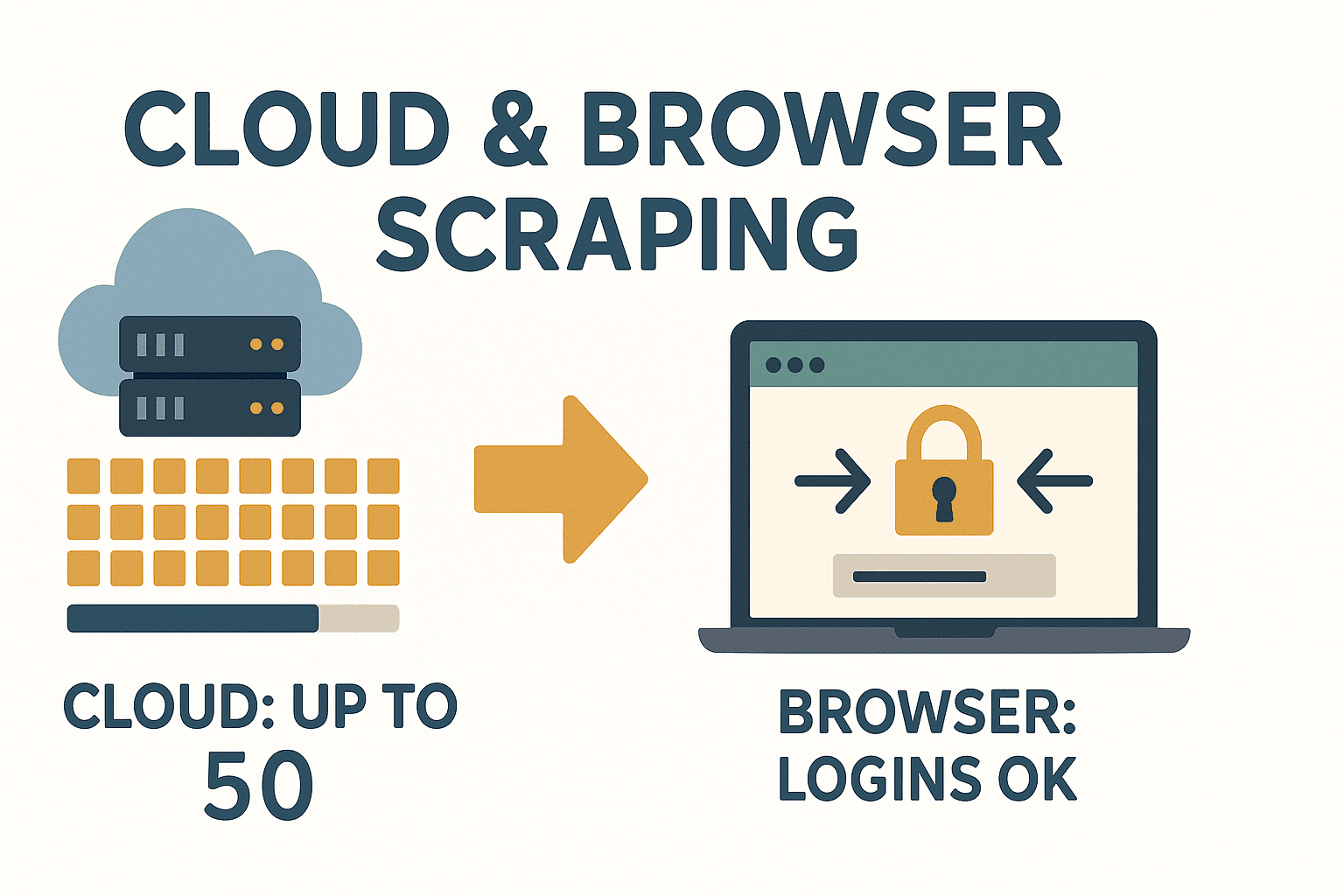

- 클라우드/브라우저 모두 지원:클라우드는 최대 50페이지 동시 수집, 로그인 필요한 사이트는 브라우저에서。

Thunderbit는 빠르게 데이터가 필요한 사람이나, 사이트 구조 변화에 매번 골치 아프기 싫은 사람에게 혁신적인 툴입니다。

Thunderbit는 빠르게 데이터가 필요한 사람이나, 사이트 구조 변화에 매번 골치 아프기 싫은 사람에게 혁신적인 툴입니다。

Thunderbit 같은 AI 툴이 활약하는 상황

- 지금 당장 데이터가 필요하고, IT팀이나 코딩을 기다릴 수 없을 때

- 사이트가 복잡하거나 동적이고, 자주 바뀔 때

- 비개발자 팀원에게도 데이터 수집을 맡기고 싶을 때

- 번역이나 카테고리 분류 등 데이터 가공도 한 번에 하고 싶을 때

Thunderbit는 Python 워크플로우와도 찰떡궁합。프로토타이핑이나 난이도 높은 사이트, 유지보수 비용을 줄이고 싶을 때 특히 추천합니다。자세한 내용은 도 참고하세요。

동적 콘텐츠나 페이지 넘김 대응법

요즘 웹사이트는 JavaScript로 동적으로 데이터를 보여주는 경우가 많아 스크래핑 난이도가 높아졌습니다。대응법은 다음과 같습니다:

- 동적 콘텐츠:데이터가 HTML에 없으면 Selenium이나 Playwright로 브라우저를 자동 조작해, 화면에 표시된 후 추출。

- 페이지 넘김:“다음” 링크를 따라가거나, URL의 페이지 번호를 늘려서 루프。Scrapy는 요청 자동 추적이 특기입니다。

BeautifulSoup로 페이지 넘김 처리 예시

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...명언 추출...

12 page += 1무한 스크롤이나 “더 보기” 버튼의 경우:Selenium으로 스크롤이나 클릭을 자동화하거나, 네트워크 탭에서 API 요청을 조사해 Requests로 흉내낼 수도 있습니다。

데이터 저장 방법:비즈니스 활용에 최적화된 포맷

추출한 데이터는 용도에 맞게 저장하세요。

- CSV:Excel이나 Google Sheets에서 다루기 쉬운 범용 포맷。

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel:pandas를 쓰면 손쉽게 내보낼 수 있습니다。

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - 데이터베이스:대규모·정기 운영이라면 SQLite나 PostgreSQL이 편리합니다。

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...테이블 생성·데이터 삽입... 4conn.close()

팀에서 공유하려면 Excel이나 Google Sheets가 간편합니다。

Python 웹 스크래핑의 법적·윤리적 주의점

스크래핑은 강력하지만, 규칙을 지키는 게 중요합니다。

- 공개 데이터만 수집:로그인이나 유료 벽 뒤는 주의。

- 이용약관 확인:스크래핑 금지 사이트도 있으니, 위반하면 차단이나 법적 리스크도()。

- robots.txt 존중:법적 구속력은 없지만, 매너상 지키는 게 좋습니다。

- 개인정보 회피:GDPR이나 CCPA로 이름·이메일·전화번호 수집은 리스크 큽니다。

- 서버 부하 피하기:요청 간격을 두고, 심야 등 한가할 때 실행。

컴플라이언스 체크리스트

- 사이트 이용약관·robots.txt 확인

- 개인정보나 기밀 데이터는 수집하지 않기

- 데이터 출처 명시

- 서버에 과도한 부하 주지 않기

법적 세부 내용은 도 참고하세요。

Python 웹 스크래핑 트러블 대처 & 베스트 프랙티스

스크래핑이 항상 순조롭진 않습니다。주요 대처법은:

- HTTP 에러(403, 404, 429):User-Agent를 바꿔보고, 요청 간격 조절。에러 땐 친절하게 처리。

- IP 차단:대량 수집 시 프록시나 IP 로테이션 활용。ただし 윤리도 고려。

- CAPTCHA:마주치면 계속할지 고민。해결 서비스도 있지만 그레이존。

- 사이트 구조 변경:튼튼한 셀렉터 설계,

None체크, try/except로 예외 처리。 - 문자 깨짐:UTF-8 사용, Excel이나 Sheets에서 출력 확인。

베스트 프랙티스

- 각 처리 과정을 로그로 남겨 트러블 위치 파악

- 실패 시 재시도 & 백오프

- 우선 소수 페이지로 테스트

- 수집 건수가 급감하면 사이트 구조 변화를 의심

매번 사이트 변경에 쫓기기 싫다면, 의 AI가 자동으로 레이아웃 변화를 대응해줍니다。

Thunderbit의 AI라면 유지보수 스트레스 없이 분석과 활용에 집중할 수 있습니다。

정리 & 핵심 포인트

Python으로 하는 웹 스크래핑은, 웹상의 방대한 정보를 정리해 비즈니스에 바로 쓸 수 있는 “무기”입니다。이번 내용 요약:

- Python은 웹 스크래핑의 스탠다드。읽기 쉬운 문법과 강력한 라이브러리가 매력。

- Requests+BeautifulSoup은 소규모·정적 페이지용, Scrapy는 대규모·자동화에 최적。

- Thunderbit는 AI로 누구나 쉽게 스크래핑 가능。노코드, 유지보수 필요 없음。

- 동적 콘텐츠나 페이지 넘김은 Selenium이나 Scrapy로 대응。

- 데이터 저장은 CSV, Excel, 데이터베이스 등 용도에 맞게。

- 법과 윤리 준수:공개 데이터만, 사이트 규칙 준수, 개인정보는 피하기。

- 튼튼한 스크래퍼 구축:로그·재시도·모니터링 철저。Thunderbit AI 활용도 추천。

이제 Python으로 첫 스크래퍼를 만들어보세요。코드 없이 시작하고 싶다면, 을 설치해 웹 데이터 추출의 간편함을 직접 느껴보세요。더 많은 실전 팁은 에서!

자주 묻는 질문(FAQ)

1. Python으로 웹 스크래핑하는 게 합법인가요?

공개 데이터를 수집하고, 사이트 이용약관·robots.txt·GDPR 등 법을 지키면 합법입니다。개인정보나 기밀 데이터 수집은 피하고, 반드시 사전에 규칙을 확인하세요()。

2. BeautifulSoup과 Scrapy의 차이는?

BeautifulSoup은 가벼운 HTML 파서로, 단일 페이지나 소규모 작업에 최적。Scrapy는 다수 페이지 크롤링이나 대규모 데이터 자동 수집에 강한 프레임워크입니다。빠른 스크립트 작성은 BeautifulSoup, 대규모 운영은 Scrapy가 어울립니다()。

3. JavaScript로 동작하는 사이트는 Python으로 어떻게 대응하나요?

Selenium이나 Playwright로 브라우저를 자동 조작해, JS로 표시된 후의 데이터를 추출합니다。또는 네트워크 탭에서 API 요청을 확인해 Requests로 흉내낼 수도 있습니다。

4. Thunderbit는 Python 스크래핑 라이브러리와 뭐가 다른가요?

Thunderbit는 AI로 항목 제안, 서브페이지 순회, 레이아웃 변화 자동 대응을 실현。노코드로 쓸 수 있고, 유지보수도 필요 없습니다。비즈니스 유저나 팀의 빠른 데이터 수집에 최적입니다()。

5. 추출 데이터 저장·공유 방법은?

CSV나 Excel로 쉽게 공유할 수 있습니다。대규모 작업은 pandas로 데이터베이스 저장도 가능。Thunderbit는 Google Sheets, Airtable, Notion으로 바로 내보내기나 CSV/Excel 다운로드도 무료로 지원합니다。

쾌적한 스크래핑 라이프를! 데이터가 항상 정리되어 바로 활용되길 바랍니다。