ウェブの進化は今やものすごいスピードで進んでいて、ビジネスやテック業界、あるいは僕みたいなデータ好きの人なら、「本当に価値があるのは“見えてる”データじゃなくて、“集められる”データだ」と気づいてるはず。今や多くの会社がウェブデータの自動収集にしのぎを削っていて、ウェブスクレイピング業界はになると予想されてるんだ。面白いことに、がAIや分析、業務効率化のためにウェブクローラーや웹 스크래퍼を使ってるんだよ。

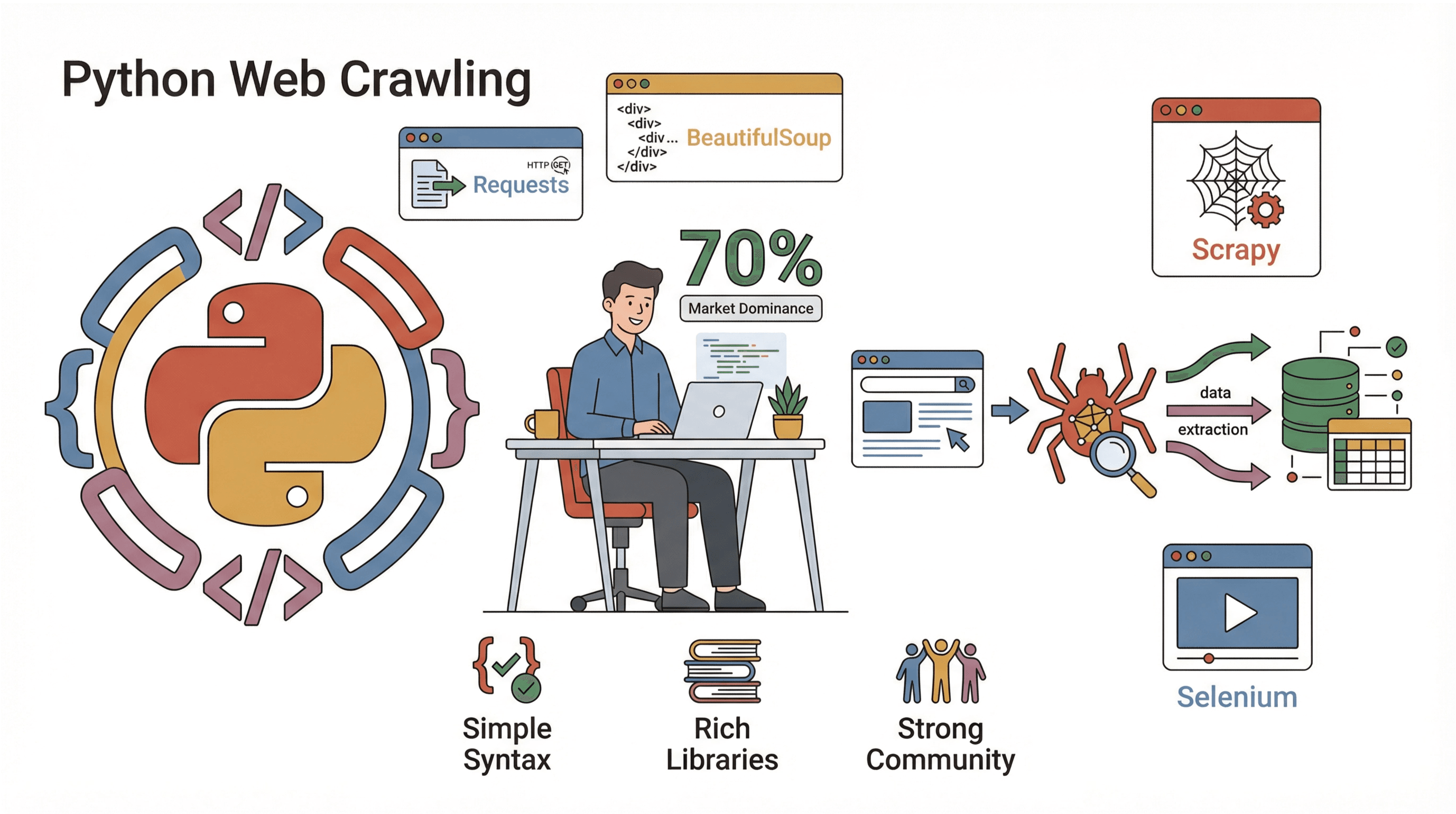

じゃあ、この流れにどう乗る?多くの人にとって、その答えはPython。Pythonはウェブクローラー作りの定番言語で、シンプルでパワフル、しかもライブラリがめちゃくちゃ充実してるから、クローリングもスクレイピングもサクッとできる。本記事では、ウェブクローラーって何?なぜPythonが最強なの?自作クローラーの作り方、さらにみたいなツールでどれだけラクになるか(コード書くのが苦手な人にもおすすめ)を解説するよ。エンジニアはもちろん、データ活用型マーケターや単純作業を自動化したい人にも、ウェブデータ活用のヒントが満載!

ウェブサイトクローラーって何?(なぜ大事?)

ざっくり言うと、ウェブサイトクローラーは自動でウェブを巡回して、ページを訪問し、リンクをたどりながら(必要なら)データを集めてくれるプログラム。まるで疲れ知らずのウェブサーファーみたいに、24時間ノンストップで、タブを間違って閉じることもない。クローラーはGooglebotみたいな検索エンジンの基盤だけど、企業では価格調査や市場分析など、いろんな場面で使われてる。

ちなみに、“クローリング”と“スクレイピング”の違いって知ってる?クローリングはページを見つけて巡回すること(都市の地図を作るイメージ)、スクレイピングはそのページから特定のデータを抜き出す作業(街中のレストランのメニューを集める感じ)。実際のプロジェクトでは、まずクローリングでページを探して、次にスクレイピングで必要なデータを取るのが一般的(参照)。

クローラーのビジネス活用例:

- リード獲得: ディレクトリやSNSから自動で連絡先を集める

- 価格調査: 競合商品の価格や在庫を大量に追跡

- コンテンツ監視: ニュースやブログ、フォーラムで自社ブランドの言及をキャッチ

- SEO監査: サイト内のリンク切れやメタデータ漏れをチェック

- 市場調査: 不動産情報や求人、商品レビューをまとめて分析

「自分がもう一人いれば…」って思ったことあるなら、クローラーはまさにその分身!

ビジネス自動化でウェブサイトクローラーが超重要な理由

実際、なんで企業はクローラーや웹 스크래퍼に投資するの?それは、コスパがめちゃくちゃ高いから。各部門がクローラーをどう使って、どんな成果を出してるかまとめてみたよ:

| ユースケース | 主なメリット | 主な利用部門 |

|---|---|---|

| リード獲得 | 見込み顧客リストの自動作成で大幅な時間短縮 | 営業、採用 |

| 価格追跡 | 競合の価格動向をリアルタイムで把握、動的価格設定 | EC、商品企画 |

| コンテンツ監視 | ブランド保護やトレンド把握 | マーケティング、PR |

| SEOサイト監査 | サイト健全性の維持、検索順位向上 | SEO、ウェブ担当者 |

| 市場調査 | 最新かつ大規模なデータセットを分析に活用 | アナリスト、リサーチ部門 |

ある会社では、週に5~7サイトのデータ収集を自動化しただけで、1人の社員が年間50時間以上も節約できたんだって。これがチーム全体に広がれば、って声も納得だよね。

Pythonがウェブサイトクローラー作りで選ばれる理由

じゃあ、なんでPythonがクローリング界で圧倒的な人気なのか?主な理由は3つ!

じゃあ、なんでPythonがクローリング界で圧倒的な人気なのか?主な理由は3つ!

- シンプルさ: Pythonは文法が分かりやすくて、初心者でも数行でクローラーが書ける。

- 豊富なライブラリ: ページ取得、HTML解析、JavaScript対応など、何でも揃ってる。

- コミュニティ: がPythonで行われてて、情報もチュートリアルも山ほどある。

代表的なPythonクローリング用ライブラリ:

- Requests: ウェブページ取得の定番(HTTP GET/POST)

- BeautifulSoup: HTML解析と要素抽出の王道

- Scrapy: 大規模クローリング向けのフレームワーク

- Selenium: JavaScriptで動的に生成されるページの自動操作

JavaやC#と比べても、Pythonならアイデアから実用的なクローラーまで爆速で作れる。データ分析派なら、Pandasと組み合わせてすぐ解析できるのも魅力!

解析手法の比較:Regex vs. BeautifulSoup vs. Scrapy

ウェブページからデータを“抜き出す”方法はいろいろ。主な手法の特徴を比べてみよう:

| 手法 | 仕組み | メリット 🟢 | デメリット 🔴 | おすすめ用途 |

|---|---|---|---|---|

| Regex | 生HTMLをパターンマッチで抽出 | シンプルなパターンなら高速 | HTML構造が変わると壊れやすい | URL抽出などの簡易用途 |

| BeautifulSoup | HTMLをツリー構造で解析、タグで検索 | 柔軟で扱いやすく、崩れたHTMLにも強い | 大規模ページではやや遅い、クロールは手動実装 | 小~中規模のスクレイピングスクリプト |

| Scrapy | フレームワークでクロール&解析(CSS/XPath) | 高速・スケーラブル、クロールと解析を一括管理 | 学習コストや初期設定がやや高い | 大規模・本番運用のクローラー |

- Regexは砂浜で金属探知機を使う感じ。速いけど、地形が変わると見逃しやすい。

- BeautifulSoupは地図とスコップを持って自分で掘るイメージ。どこでも掘れるけど、歩く手間は必要。

- ScrapyはトラックとGPSを持ったチームで大規模に掘る感じ。小規模には大げさだけど、大規模には最強。

初心者はまずRequests+BeautifulSoupの組み合わせがおすすめ。基礎を学んで、必要に応じてScrapyにステップアップしよう!

実践:Pythonでシンプルなウェブサイトクローラーを作る手順

実際に手を動かしてみよう。ページを巡回して、リンクをたどり、データを取る基本的なクローラーを一緒に作ってみるよ。

ステップ1:Python環境の準備

まずPython 3.10以上が入ってるか確認(python --versionでチェック)。プロジェクト用の仮想環境を作ろう:

1python -m venv venv

2source venv/bin/activate # Windowsの場合: venv\Scripts\activate必要なライブラリをインストール:

1pip install requests beautifulsoup4これで準備OK。好きなエディタでコードを書き始めよう。

ステップ2:最初のクローラースクリプトを書く

まずは1ページを取得してみよう。シンプルな例:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # 200以外はエラー

5 print(response.text[:500]) # 最初の500文字を表示

6crawl_page("https://www.scrapingcourse.com/ecommerce/")コンソールにHTMLが表示されたら、ウェブと通信できてる証拠!

ステップ3:リンクをたどって複数ページを巡回

次は、リンクをたどって複数ページを巡回するクローラーに拡張。訪問予定URLリストと、既に訪問したURLセットを管理しよう:

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # 安全のための上限

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Failed to retrieve {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawled: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) and url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)このスクリプトは同じサイト内で最大20ページまで巡回して、各URLを表示するよ。

ステップ4:ページからデータを抽出

例えば、各ページから商品名と価格を取りたい場合はこんな感じ:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ...(上記と同じ)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ...(クロール処理続き)

18# CSVに保存

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Scraped {len(product_data)} products.")これで取った商品データがCSVファイルに保存されて、分析やアップロード、共有もラクラク!

ステップ5:クローラーのデバッグと最適化

クローラーを作るだけじゃなく、安定して動かす工夫も大事。僕の経験から、ここは意識しよう:

- User-Agentヘッダーを設定: 一部サイトは“Python-requests”をブロックするから、ブラウザっぽく見せよう。

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - エラー処理を丁寧に: try/exceptで取得失敗時もスキップできるように。

- 無限ループ防止: 訪問済みURLを必ず記録して、最大ページ数も設定。

- リクエスト間隔を空ける:

time.sleep(1)でアクセスを間引いて、ブロック回避。 - robots.txtを確認: サイトのクローリングルールは必ず守ろう()。

- 進捗ログを残す: 各URLを表示・記録しておくと、トラブル時に助かる。

もしブロックされたり、データが取れなかったら、ヘッダーやリクエスト間隔、アンチボット対策を見直してみて。

Thunderbit:AIでウェブクローリングをもっとラクに

ここで、“簡単ボタン”みたいなを紹介!Pythonも最高だけど、「とにかくデータが欲しい」「設定やメンテは面倒」って人にはThunderbitがピッタリ。ThunderbitはAI搭載の웹 스크래퍼拡張機能で、数クリックでどんなサイトからでもデータを取れる。

Thunderbitの特長:

- AIによる項目提案: ページをAIが解析して、抽出できるデータを自動で提案。HTMLやセレクタの知識は不要。

- ノーコード・ブラウザ完結: ブラウザ上で動いて、ログインが必要なサイトやJavaScript中心のページにも対応。

- サブページ自動巡回: 商品詳細などのサブページも自動で回って、データをしっかり集める。

- 即時エクスポート: Excel、Google Sheets、Airtable、Notionなどにワンクリックで出力。

- クラウド/ローカル両対応: 公開サイトは高速なクラウド、ログインサイトや特殊なページはローカルで柔軟に使い分け。

- スケジューリング: 定期実行も簡単。サーバーやcronの設定は不要。

ビジネスユーザーにとってThunderbitはまさに革命的。データが欲しいと思ったら、数分でスプレッドシート化できる。エンジニアにも、ちょっとした作業やバックアップ用途に最適!

使い方を試したい人は、して、好きなサイトで웹 스크래퍼を体験してみて。無料プランでも数ページは試せるし、有料プランは月15ドルから500クレジット使えるよ。

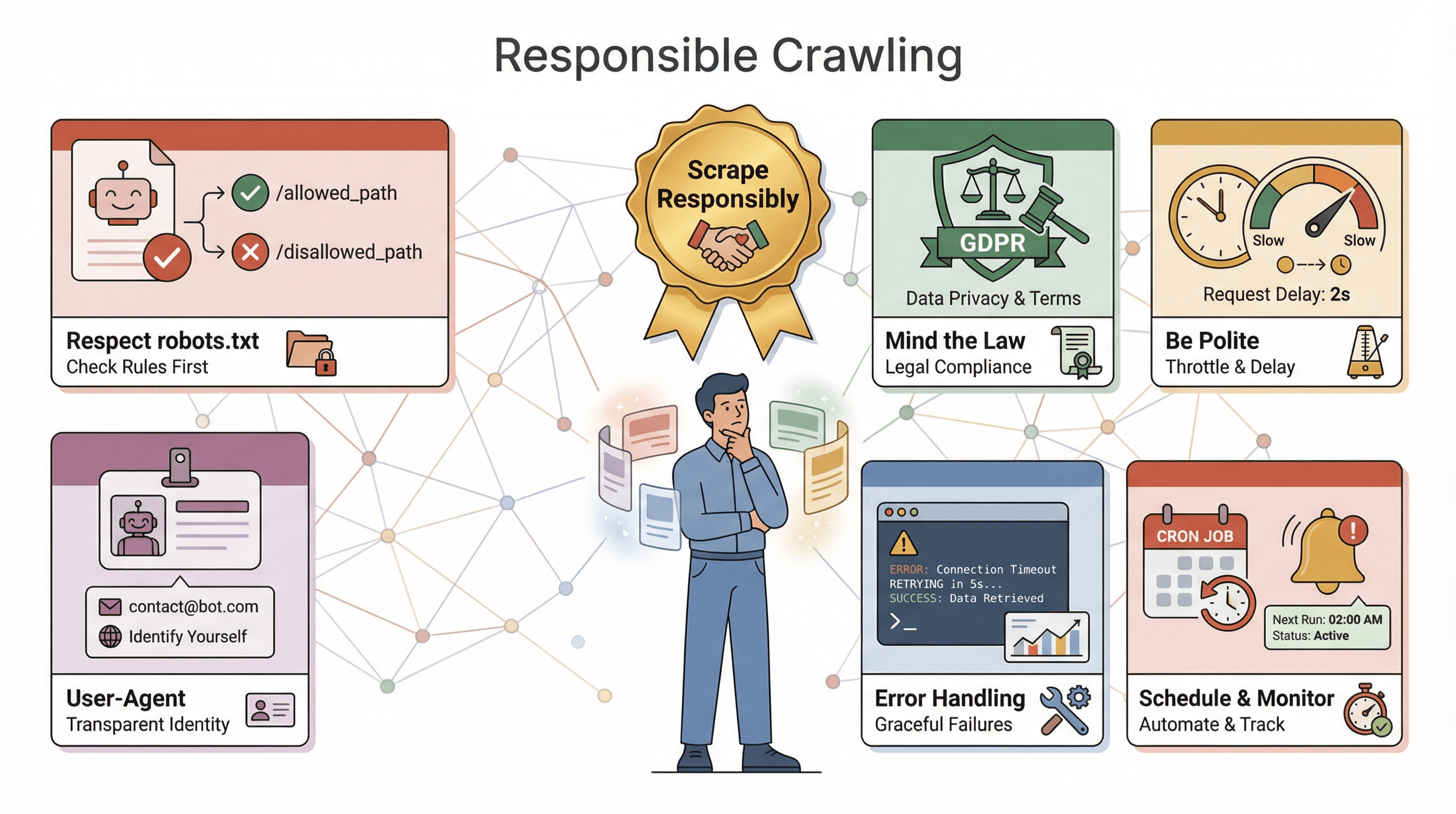

Pythonでウェブサイトクローラーを作るときの注意点

クローラーを本格運用する前に、いくつか大事な注意点があるよ:

クローラーを本格運用する前に、いくつか大事な注意点があるよ:

- robots.txtの遵守: 多くのサイトは

robots.txtでクローラーの許可範囲を指定してる。無視するとブロックや法的トラブルの原因になるから、必ず確認してルールを守ろう()。 - 法令順守: サイトによっては利用規約でスクレイピングを禁止してる場合も。個人情報を扱う場合はGDPRやCCPAなどのプライバシー法にも注意が必要(参照)。迷ったら公開・非個人データだけに絞ろう。

- マナーを守る: サイトに過剰なリクエストを送らないよう、間隔を空けたり、ピーク時間を避けたりしよう。

- 自己識別: 独自のUser-Agentを設定して、大規模クロール時は連絡先も明記すると親切。

- エラー処理とログ: サイト構造の変化やデータの乱れは日常茶飯事。エラー処理やログ、監視機能を組み込んでおこう。

- 定期実行と監視: 定期クロールにはcronやThunderbitのスケジューラーを活用して、失敗時やデータゼロ時のアラートも設定しよう。

大事なのは**「責任あるスクレイピング」**。ウェブはみんなの資源。迷惑行為は絶対NG!

応用編:Pythonクローラーのスケールアップ&高度化

基礎をマスターしたら、さらに進化したクローラーにも挑戦できるよ:

- JavaScript対応: SeleniumやPlaywrightで動的データもゲットできる。

- 大規模化: Scrapyや

aiohttpなどの非同期ライブラリで並列リクエストを実現。 - プロキシ活用: IPアドレスをローテーションして大量クロール時のブロック回避。

- データパイプライン自動化: データベースやクラウドストレージに直接書き込む設計も可能。

- 監視とアラート: 長時間稼働時はログやヘルスチェック、通知機能を実装。

クローラーが業務の要になるなら、マネージドサービスやAPIの活用も検討しよう。複数サイト・多様なレイアウトを扱う場合は、パーサーをモジュール化して保守性を高めるのがコツ!

まとめ・ポイントのおさらい

Pythonでウェブサイトクローラーを作れるようになると、データ活用の幅が一気に広がる。今回のポイントを振り返ろう:

- ウェブサイトクローラーはページ巡回とデータ抽出を自動化して、ビジネスやリサーチ、競合分析に欠かせない存在。

- Pythonはシンプルな文法、強力なライブラリ、巨大なコミュニティでクローラー作りに最適。

- 解析手法は用途で使い分け。簡単な用途はregex、汎用はBeautifulSoup、大規模はScrapy。

- ステップバイステップで、1ページ取得からサイト全体の構造化データ保存まで誰でも実現できる。

- ThunderbitならAIとノーコードでさらに手軽にデータ取得。ビジネスユーザーやスピード重視の人に最適。

- 責任あるクローリングが大前提。ルール遵守・エラー対応・倫理意識を忘れずに。

- スケールアップもツール次第で自在。JavaScript対応や並列処理、Thunderbitの自動化も活用しよう。

まずは小さく始めてみよう。スクリプトを書いたりThunderbitを試したり、どんなデータが手に入るか体験してみて。ウェブはまさに“データの宝庫”!

さらに深く学びたい人はこちらもどうぞ:

- で最新ノウハウや応用テクニックをチェック

快適なクローリングライフを!웹 스크래퍼は速く、データはクリーンに、コーヒーは切らさずに。

よくある質問(FAQ)

1. ウェブサイトクローラーと웹 스크래퍼の違いは?

クローラーはサイト構造を巡回・発見する役割(地図作り)、웹 스크래퍼はそのページから特定データを抜き出す役割。実際のプロジェクトでは両方を組み合わせて使うのが一般的。

2. なぜPythonがウェブサイトクローラー作りで人気なの?

Pythonは学びやすく、RequestsやBeautifulSoup、Scrapy、Seleniumなど強力なライブラリが揃い、コミュニティも巨大。ウェブスクレイピングの約7割がPythonで行われてて、業界標準になってる。

3. 解析にはregex・BeautifulSoup・Scrapyのどれを使うべき?

単純なパターン抽出はregex、ほとんどのスクリプトにはBeautifulSoup、スピードや並列処理が必要な大規模運用にはScrapyが最適。

4. ThunderbitとPythonでのクローラー作りの違いは?

ThunderbitはAIとノーコードで直感的にデータ抽出ができる。ビジネスユーザーや短時間作業に最適。Pythonは細かな制御やカスタマイズができるけど、コーディングや保守が必要。

5. クローリング時の法的・倫理的注意点は?

必ずrobots.txtを確認して、サイトの利用規約を守ろう。個人情報や機密データの収集は避けて、リクエスト頻度も控えめに。責任あるスクレイピングがウェブの健全性を守る!

自分でも試してみたい人は、するか、お気に入りのPythonエディタでクローリングを始めてみて。データはすぐそこにある!

さらに詳しく知りたい人へ