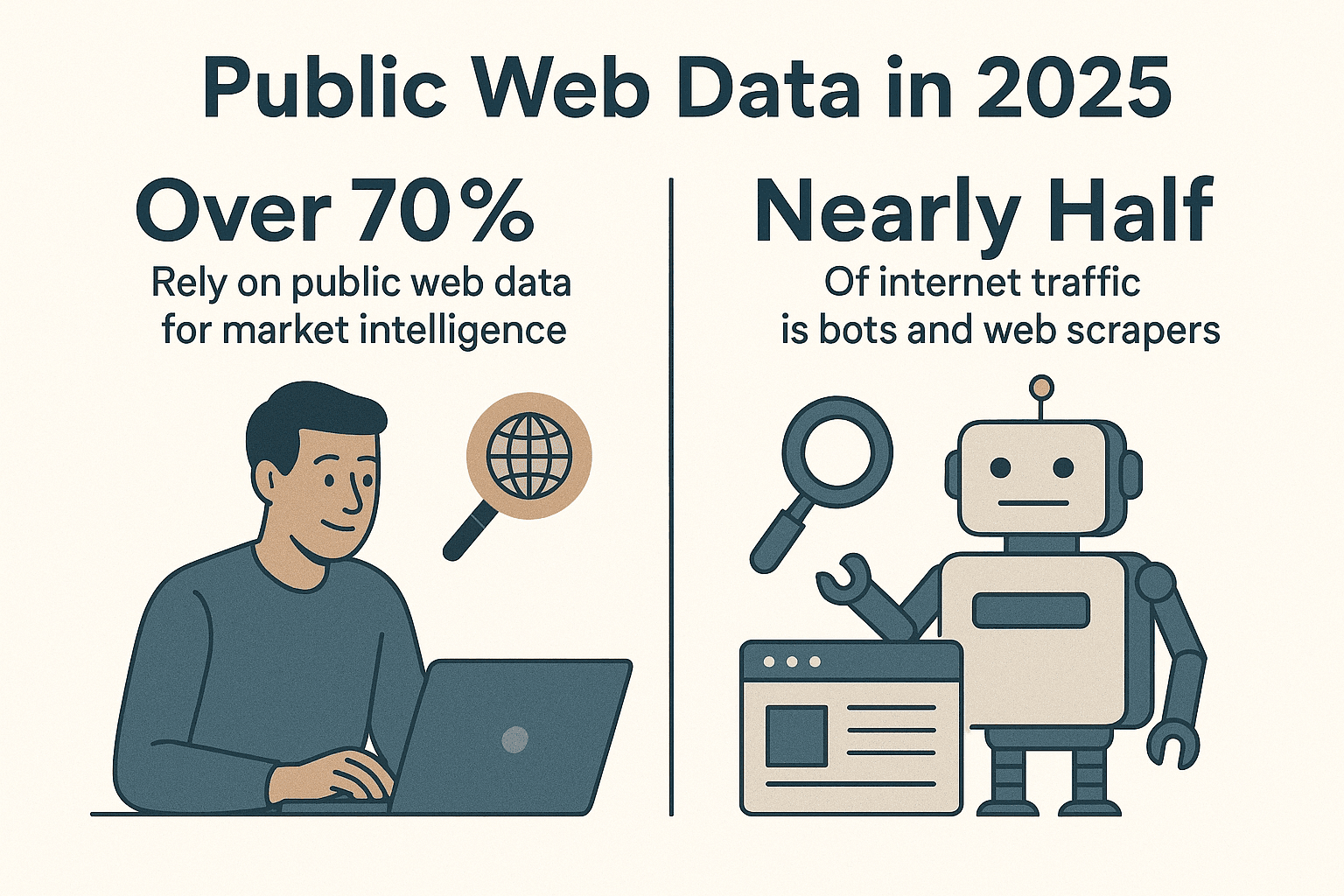

ウェブ上にはとてつもない量のデータが溢れていて、今や多くの企業がそのカオスな情報をビジネスの武器に変えようとしのぎを削っています。実際、しているし、インターネットのトラフィックの半分近くは人間じゃなくてボットや웹 스크래퍼が占めているんです()。自分も長年自動化ツールを作ってきた経験から断言できるのは、Python製のweb spiderでデータ収集を自動化しないのは、圧倒的な効率化のチャンスを逃しているってことです。

Pythonは웹 스크래핑分野で定番中の定番。営業、マーケ、オペレーション、リサーチ…どんな現場でも、しっかり作り込んだPython web spiderがあれば、膨大な時間を節約できて、他の手段じゃ見つからないインサイトも手に入ります。この記事では、効率的なPython web spiderの作り方を基礎から解説しつつ、オススメのライブラリやベストプラクティス、さらにみたいなツールを使って動的なウェブサイトにも柔軟に対応する方法まで紹介します。

Pythonは웹 스크래핑分野で定番中の定番。営業、マーケ、オペレーション、リサーチ…どんな現場でも、しっかり作り込んだPython web spiderがあれば、膨大な時間を節約できて、他の手段じゃ見つからないインサイトも手に入ります。この記事では、効率的なPython web spiderの作り方を基礎から解説しつつ、オススメのライブラリやベストプラクティス、さらにみたいなツールを使って動的なウェブサイトにも柔軟に対応する方法まで紹介します。

なぜweb spiderにPythonが最強なのか?

まず知ってほしいのは、Pythonが웹 스크래핑界隈で圧倒的な人気を誇っているという事実。最新の業界データによると、。JavaScriptや他の言語を大きく引き離してます。2024年には、PythonがGitHubで一番人気の言語になった()のも納得。データサイエンスや自動化に強いのが理由です。

Pythonがweb spiderに向いてる理由は?

- 直感的で読みやすい文法:初心者でもすぐ書けるし、上級者もスピード開発できる

- ライブラリが豊富: 、、、など、ページ取得からHTML解析、ブラウザ自動化まで全部カバー

- コミュニティが活発:困ったら世界中のエンジニアが助けてくれるし、チュートリアルやサンプルも山ほどある

- 柔軟性抜群:ちょっとしたスクリプトから大規模クローラーまで、用途に合わせてスケールできる

他の言語と比べても、Pythonはパワフルさと扱いやすさのバランスが最高。JavaScript(Node.js)は動的コンテンツに強いけど非同期処理のクセがあるし、JavaやC#は堅牢だけど記述量が多くなりがち。その点、Pythonはデータ取得に集中できるのが魅力です。

Python web spiderの開発環境を整えよう

スパイダー作りを始める前に、まずは開発環境をしっかり準備しましょう。自分が新しいプロジェクトで必ずやる手順を紹介します。

1. Python 3のインストール

から最新のPython 3.xをダウンロードするか、OSのパッケージマネージャーでインストール。pythonまたはpython3コマンドがターミナルで使えるか確認しよう。

2. 仮想環境の作成

プロジェクトごとに依存関係を分けるため、仮想環境を作成します:

1python3 -m venv .venv

2# Unix/Macの場合

3source .venv/bin/activate

4# Windowsの場合

5.venv\Scripts\activateこれでパッケージの競合を防げます。

3. 必須ライブラリのインストール

仮想環境を有効化した状態で、主要なライブラリをインストール:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemy各ライブラリの役割はこんな感じ:

- Requests:HTTP経由でウェブページを取得

- BeautifulSoup:HTMLの解析・操作

- lxml:高速なHTML/XMLパーサー(BeautifulSoupの高速化にも使える)

- Scrapy:大規模クロール向けのフレームワーク

- Selenium:JavaScript多用の動的サイトのブラウザ自動化

- pandas:データの整形・加工

- SQLAlchemy:データベース保存

これで、簡単なスクリプトから本格的なスパイダーまで作れます。

Python web spider向けライブラリの選び方

Pythonにはいろんな웹 스크래핑ツールがあります。自分が使い分ける基準はこんな感じ:

| ライブラリ/ツール | 使いやすさ | 速度・スケール | おすすめ用途 |

|---|---|---|---|

| Requests + BeautifulSoup | 非常に簡単 | 普通(1ページずつ) | 初心者、静的ページ、ちょっとした作業 |

| Scrapy | やや学習コストあり | 非常に高速(非同期・並列) | 大規模クロール、サイト全体のデータ収集 |

| Selenium/Playwright | 普通 | やや遅い(ブラウザ起動) | JS多用サイト、ログインが必要なページ |

| aiohttp + asyncio | 普通(非同期) | 非常に高速(多数URL同時処理) | 大量の静的ページの取得 |

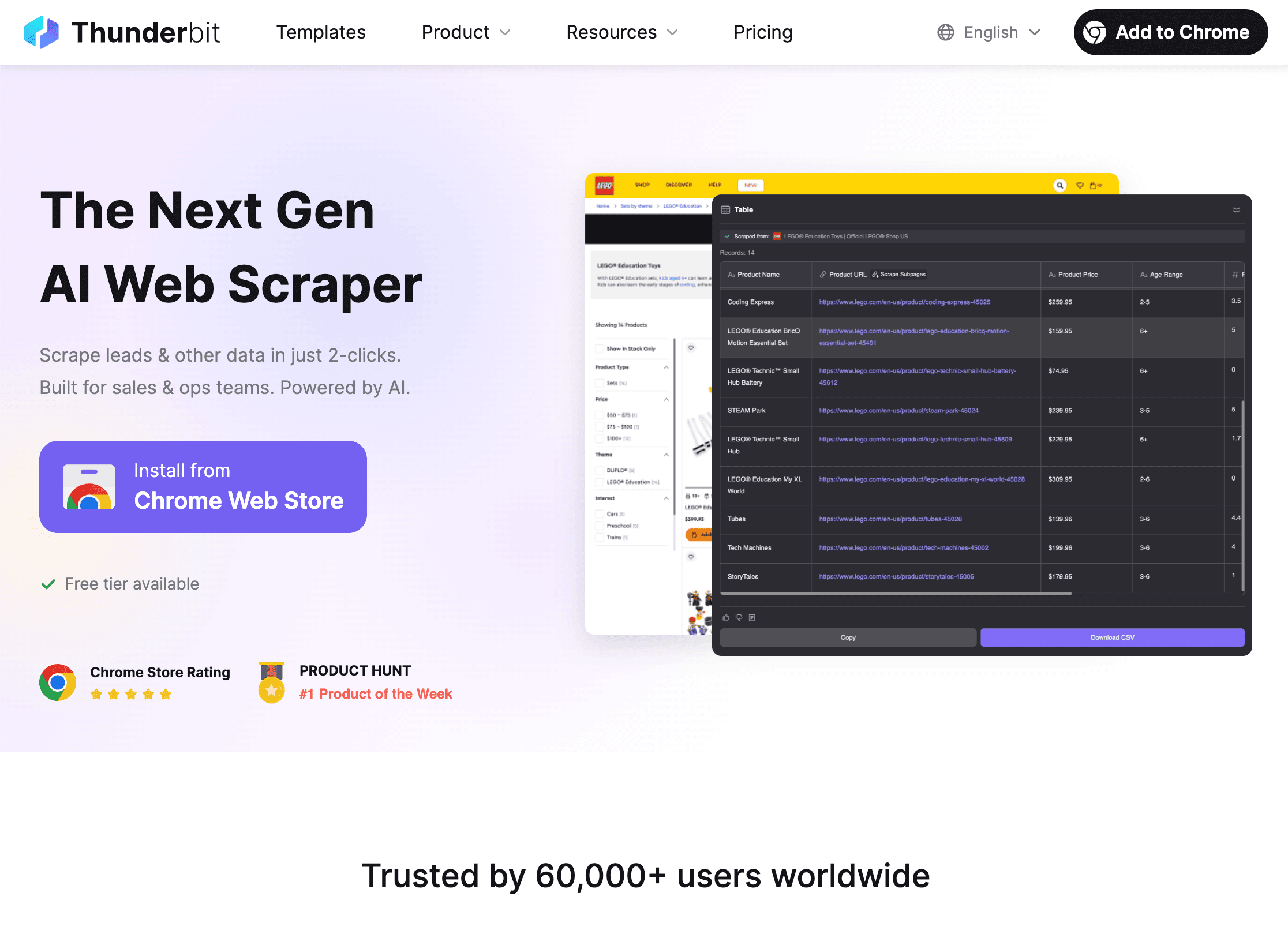

| Thunderbit (ノーコード) | 最も簡単(AI駆動) | 高速(クラウド/ローカル) | コーディング不要、動的サイト、すぐに結果が欲しい場合 |

自分の使い分けポイント:

- 静的ページが数ページならRequests + BeautifulSoupで十分

- 数百〜数千ページやクロール機能が必要ならScrapy

- ブラウザ操作が必要な場合(無限スクロールやログイン)はSeleniumやPlaywright

- 「今すぐデータが欲しい」「コード書きたくない」ならが最適

Pythonで基本的なweb spiderを作る:実践ステップ

ここでは、Hacker Newsのストーリータイトルを取得するシンプルなスパイダーを例に解説します。웹 스크래핑の「Hello World」的な定番です。

1. ウェブページの取得

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. HTMLの解析

1soup = BeautifulSoup(html_content, "html.parser")3. データの抽出

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. ページ送り(ページネーション)への対応

Hacker Newsの下部には「More」リンクがあります。これを辿るには:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (上記と同様に記事を抽出)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # サーバーに優しく!

11 else:

12 page_url = None5. エラー処理とマナー

response.status_codeでレスポンスを必ず確認time.sleep()でアクセス間隔を空ける- カスタムUser-Agentを設定

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)この基本スパイダーを応用すれば、ほとんどの静的サイトに対応できます。もっと複雑な案件にはScrapyを使いましょう。

Scrapyでスパイダーを強化する

単純なスクリプトじゃ手に負えない規模や要件には、Scrapyが最適。導入手順はこんな感じ:

1. Scrapyプロジェクトの作成

1scrapy startproject myspider2. スパイダーの作成

myspider/spiders/quotes_spider.py内:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. スパイダーの実行

1scrapy crawl quotes -o quotes.jsonScrapyなら複数ページのクロール、並列処理、リンクの自動追跡、データのJSON(CSVやXMLもOK)出力まで、最小限のコードで実現できます。

Scrapyの魅力:

- 並列処理やレート制限、マナーを標準サポート

- robots.txtの自動遵守

- データのエクスポートやパイプラインも簡単

- 数ページから数百万ページまでスケール可能

ThunderbitでPython web spiderの可能性を拡張

さて、ここで多くの人がつまずく「動的ウェブサイト」問題について。Pythonは強力だけど、JavaScriptで動的に生成されるページや、頻繁にレイアウトが変わるサイト、ボット対策が厳しいサイトはなかなか手強い。そんな時に頼りになるのがです。

Thunderbitの特長は?

- AIによるフィールド自動抽出: を開いて「AIフィールド提案」をクリックするだけで、AIが抽出すべきデータを自動で提案。HTMLやセレクタの知識は不要。

- サブページのクロール:商品詳細やプロフィールなど、リンク先のページも自動で辿ってデータを統合。

- 動的コンテンツ対応:Thunderbitは実際のブラウザ上で動作するから、JavaScriptで生成されるページや無限スクロール、AIオートフィルによるフォーム入力にも対応。

- ノーコード・自然言語指示:「このページから求人タイトルと勤務地を抽出して」みたいな指示だけでOK。

- 即時データエクスポート:CSV、Excel、Google Sheets、Airtable、Notionなどにワンクリックで出力。無料・無制限。

- 定期スクレイピング:毎日9時など、スケジュール設定で自動的に最新データを取得。

ThunderbitとPythonの連携活用

自分のお気に入りワークフローは:

- Thunderbitで 動的・複雑なサイトのデータをサクッと抽出

- CSVやExcelでエクスポート

- Python(pandas)で データの加工や分析、自動化処理

Thunderbitが面倒な抽出作業を担当し、Pythonがデータ処理を担う、まさに最強タッグです。

ThunderbitとPython web spiderの使い分け

- Thunderbit:コーディング不要、動的サイト、単発のデータ取得、ビジネスユーザー向け

- Python:高度なロジック、大規模・定期クロール、他システムとの連携が必要な場合

- 両方:Thunderbitで抽出、Pythonで分析・自動化。まるで「ピーナッツバターとジャム」みたいに、単体でも良いけど組み合わせると最強。

ハイブリッド活用の詳細はもチェックしてみてください。

法律とウェブサイトのルールを守るために

웹 스크래핑は強力だけど、正しく使わないとトラブルの元。ここでは、法的・倫理的に正しいスクレイピングのポイントをまとめます。

1. robots.txtの遵守

多くのサイトはrobots.txtでクロール可能な範囲を指定しています。Pythonでの確認例:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("robots.txtでスクレイピング禁止")Scrapyはデフォルトでrobots.txtを守ります(ROBOTSTXT_OBEY=True)。

2. マナーを守る

- アクセス間隔(

time.sleep()やScrapyのDOWNLOAD_DELAY)を設ける - 連絡先入りのUser-Agentを設定

- 個人情報や保護されたデータは取得しない

- サイト側からブロックや停止要請があれば従う

3. レート制限・CAPTCHAへの対応

- 429エラー(リクエスト過多)が出たら速度を落とすかプロキシを利用

- CAPTCHAが出たら無理に突破しようとせず、引き下がる

スクレイピングの倫理や法令遵守についてはも参考にしてください。

Pythonでデータを整理・保存する

データを取得したら、次は整形・変換・保存。自分の定番フローを紹介します。

1. pandasでクレンジング・変換

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. CSVやExcelへのエクスポート

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. SQLAlchemyでデータベース保存

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)これで、スパイダーからダッシュボードまで一貫したデータパイプラインが作れます。

データパイプラインの自動化

定期的な処理には自動化が必須:

- cronジョブ:Pythonスクリプトを日次・時間単位で自動実行

- Apache Airflow:複雑なワークフローも一元管理

- Thunderbitのスケジューリング:スクレイピングを自動化し、Pythonで後処理

詳しくはも参考に。

Python web spiderのトラブルシューティングと最適化

どんなに優秀なスパイダーでも、時には問題が発生します。よくある課題と対策をまとめました:

- リクエストがブロックされる(403/429):User-Agentのローテーション、速度調整、プロキシ利用、robots.txtの確認

- データが取得できない:セレクタの見直し、HTML構造の変化に注意

- 動的コンテンツ:SeleniumやThunderbitを活用

- パフォーマンス:非同期処理(aiohttp)やScrapyの並列処理、データの逐次保存でメモリ節約

- デバッグ:ログ出力、ブラウザの開発者ツール、出力データの確認

さらに詳しいトラブルシューティングはも参考にしてください。

まとめ・重要ポイント

効率的なPython web spiderの構築は、時間の節約と高品質なデータ獲得に直結します。今回紹介した内容を振り返ると:

- Pythonはweb spiderの最有力言語。シンプルな構文、豊富なライブラリ、活発なコミュニティが魅力

- 仮想環境と主要ライブラリ(Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy)で環境構築

- 用途に応じて最適なツールを選択。小規模ならスクリプト、大規模や動的サイトはScrapyやSelenium、ノーコードならThunderbit

- robots.txtや利用規約を守り、マナーあるスパイダーを作成

- pandasやSQLAlchemyでデータを整理・保存し、パイプラインを自動化

- ThunderbitとPythonを組み合わせて、AIによる抽出と高度な分析・自動化を両立

웹 스크래핑をさらに進化させたい人は、して、どんな難しいサイトでも簡単にデータ取得できる体験をしてみてください。さらに深く学びたい人は、で最新のガイドや実践例もチェック!

快適なスクレイピングライフを!あなたのスパイダーが必要なデータをしっかり集め、CAPTCHAの罠にかからないことを祈ってます。

よくある質問(FAQ)

1. なぜPythonがweb spider開発に最適なの?

Pythonはシンプルな文法、豊富なライブラリ(Requests, BeautifulSoup, Scrapyなど)、活発なコミュニティで、初心者でも扱いやすく、大規模プロジェクトにも対応できるパワーがあります。

2. Pythonスパイダーを自作する代わりにThunderbitを使うべきタイミングは?

Thunderbitはコーディング不要で、動的・JavaScript多用サイトや、すぐにデータが欲しい時に最適。高度なカスタマイズや大規模・システム連携が必要な場合はPythonスパイダーが向いてます。多くのチームは両方を併用し、Thunderbitで抽出、Pythonで分析しています。

3. web spiderの合法性・倫理性をどう担保すればいい?

必ずrobots.txtを確認し、マナーを守ったクロール(遅延・User-Agent設定)を心がけ、個人情報や保護データは取得しないこと。サイト側から停止要請があれば従いましょう。詳しくはを参照。

4. 取得したデータの最適な保存・加工方法は?

pandasでデータを整形・変換し、CSVやExcelで共有。大規模・定期データはSQLAlchemyでデータベース(SQLiteやPostgreSQLなど)に保存するのがおすすめ。

5. 웹 스크래핑の自動化方法は?

cronジョブやApache AirflowでPythonスクリプトをスケジューリング。Thunderbitの定期スクレイピング機能と組み合わせれば、完全自動のデータパイプラインが作れます。

さらに実践的なスクレイピングノウハウはやのチュートリアルもぜひ。