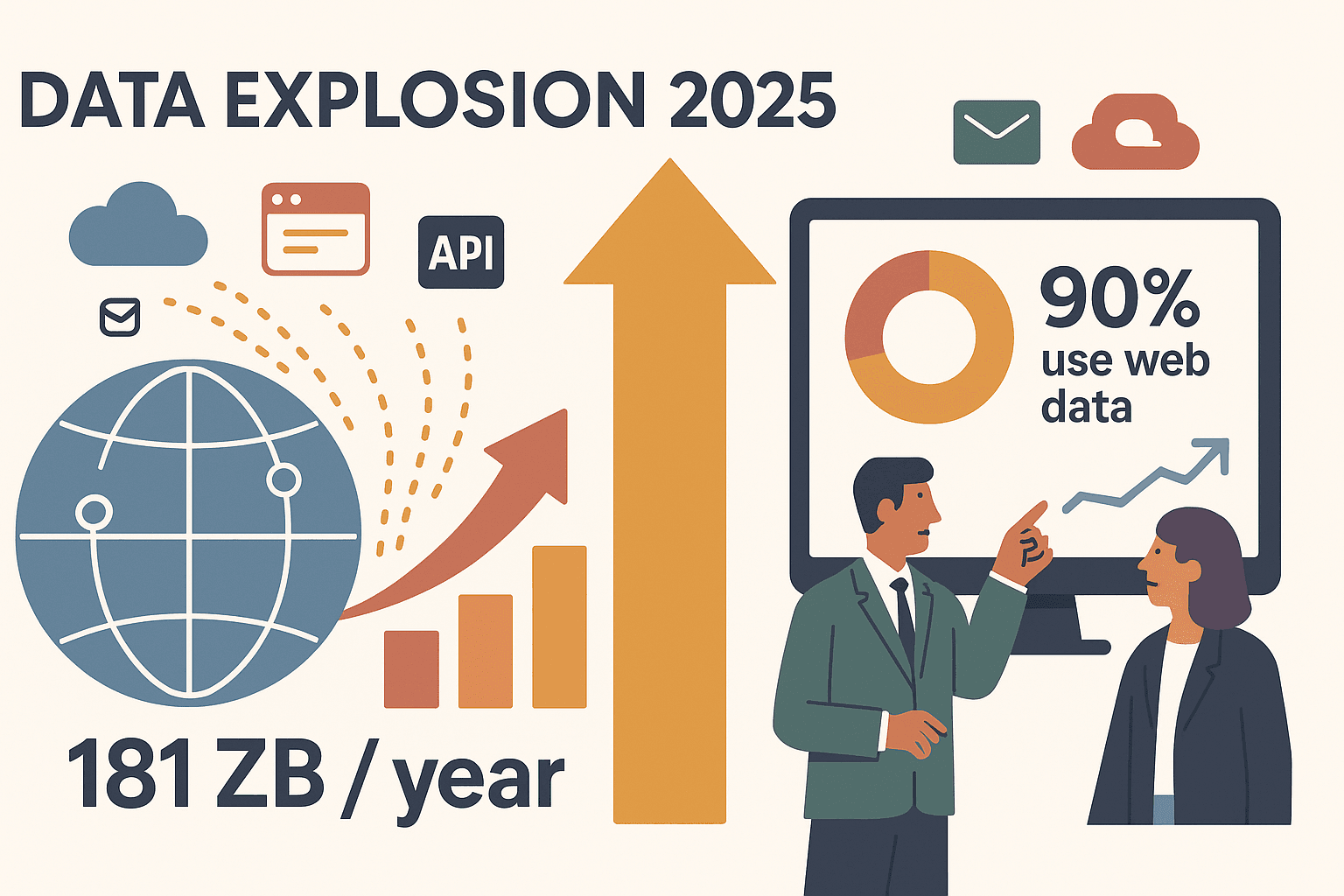

2025年のウェブは、まさにデータの宝庫。でも同時に、情報が溢れかえる“ジャングル”みたいなもの。今や多くの企業が、このカオスなデータをビジネスのヒントやリード、売上に変えるためにしのぎを削ってるんだよね。自分も現場で何度も見てきたけど、昔は何時間もかけて手作業でコピペしてたチームが、今では価格調査やリード獲得など、ほとんどの作業を自動化できるようになってる。実際、2025年には世界のデータ生成量がを超えて、が外部ウェブデータを戦略に活用する時代になってる。

じゃあ、個人事業主から大規模なデータ活用を目指すエンタープライズまで、どんなツールを選べばいいの?ここでは、AI搭載のノーコード型(みたいな)から開発者向けフレームワーク、エンタープライズ向けプラットフォームまで、2025年注目のウェブスクレイピングソリューション15選を厳選して紹介するよ。直感的な操作が好きな人も、細かいカスタマイズを求める人も、きっとピッタリのツールが見つかるはず!

2025年、企業がスクレイピングソリューションを必要とする理由

結論から言うと、ウェブスクレイピングはもう一部の技術者だけのものじゃない。競争力を維持したいすべてのビジネスにとって、なくてはならない存在になってる。その理由はこんな感じ:

- 市場調査の高速化:インターンにコピペ頼む時代はもう終わり。スクレイパーを使えば、商品情報やレビュー、ニュースも数分で集められる。不動産会社なら、物件リストや価格動向を自動で取得して投資判断に活用してるよ()。

- リード獲得・営業インテリジェンス:営業チームはディレクトリやLinkedInから最新の見込み客リストを自動生成。手作業の時間を大幅カットして、より新鮮なデータが手に入る。

- 価格監視・競合分析:ECチームは毎日競合の価格や在庫を自動取得。オンライン購入者のしてる今、スピード対応が必須。

- 業務自動化:定期レポートやダッシュボード更新もスクレイパーで自動化。これでをもっと価値ある仕事に使える。

つまり、スクレイピングソリューションは面倒な手作業を自動化して、信頼できるデータパイプラインを作ってくれる。チームはデータ整理じゃなく、分析や意思決定に集中できるってわけ。

最適なスクレイピングソリューションの選定基準

ツールが多すぎて迷う人のために、2025年のビジネス利用で本当に大事なポイントだけに絞って選んだよ:

- 使いやすさ:プログラミング不要で誰でもすぐ使える?ビジュアルエディタやクリック操作、自然言語プロンプトがあると最高。

- カスタマイズ性:複雑な案件にも対応できる?スクリプトやAI、テンプレートマーケットプレイスの有無も大事。

- パフォーマンス・拡張性:動的サイトや大量データ、定期実行に強い?大規模運用でも安定してる?

- ウェブサイト対応力:静的ページから無限スクロール、ログイン必須サイトまで幅広く対応できる?

- 価格:無料プランはある?小規模から大企業まで納得できる料金体系?

ノーコード拡張機能からエンタープライズ向け、開発者向けまで幅広くカバーしてるよ。それじゃ、順番に見ていこう!

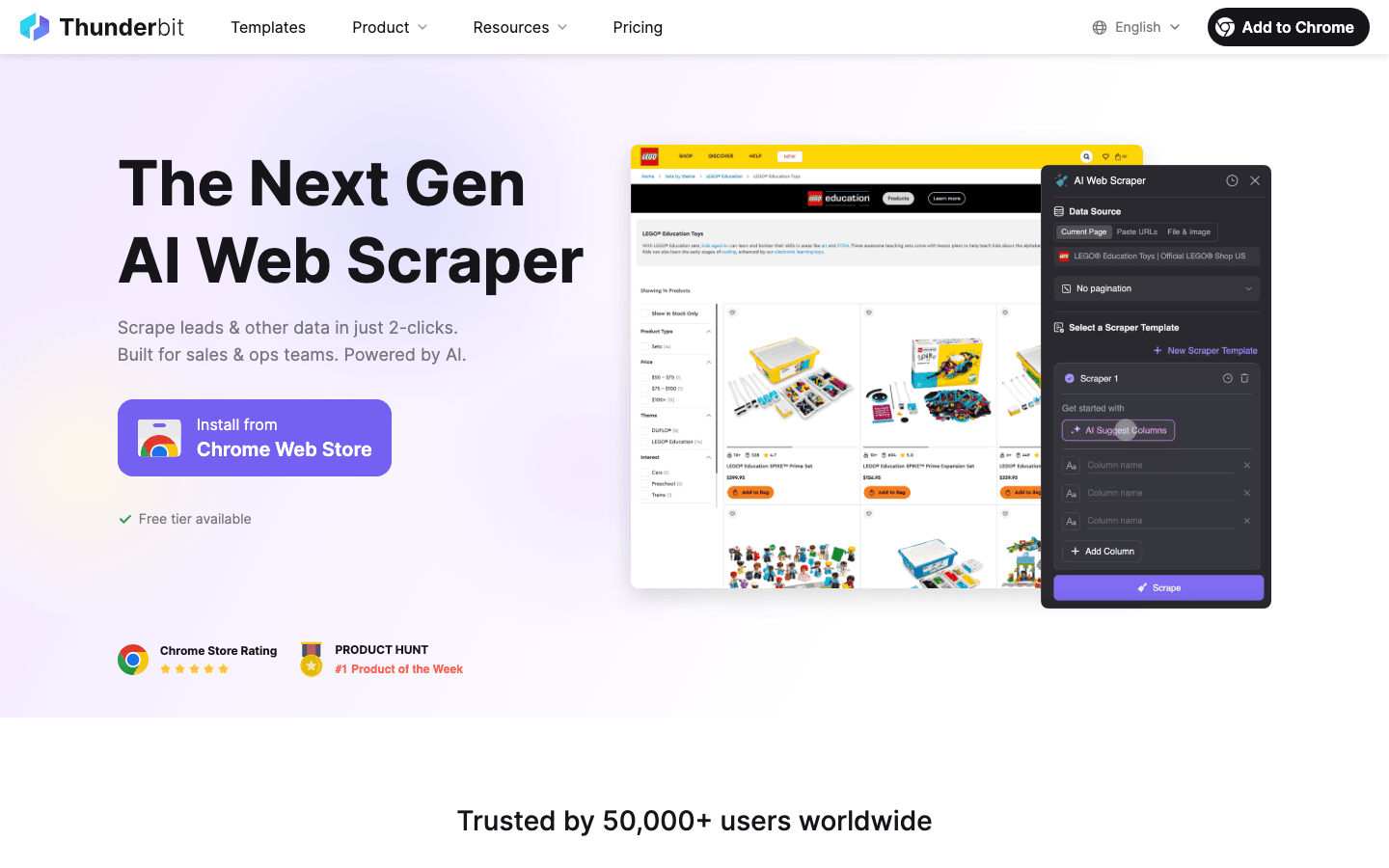

1. Thunderbit

は、AI搭載・ノーコードでビジネスユーザーにピッタリなウェブスクレイパー。自分が共同創業者として開発した理由は、営業やマーケ現場で複雑なツールに苦しむ人を何度も見てきたから。Thunderbitのポイントは:

- AIによる自動化:「AIフィールド提案」をクリックするだけで、ページを解析して必要なカラムや設定を自動生成。英語でやりたいことを説明するだけでOK、コーディングもテンプレートも不要。

- 2クリックで完了:ページを開いて「スクレイピング」を押すだけ。サブページやページネーション、画像・PDFも自動対応。

- 即時エクスポート:Excel、Google Sheets、Airtable、Notionへワンクリックでデータ出力。しかも無料。

- サブページ対応:商品詳細やLinkedInプロフィールなど、各サブページも自動で巡回してテーブルを充実。

- 豊富なテンプレート:Amazon、Zillow、Instagram、Shopifyなど人気サイトはワンクリックで即取得。

- 料金:6ページまで無料(トライアルで10ページ)。有料プランは月15ドル/500行から。大規模チーム向け上位プランも。

おすすめ用途:営業・マーケ・EC・不動産など、スピード重視で正確なデータが欲しい非エンジニアの人に最適。数分で結果が出るから、現場で大人気。

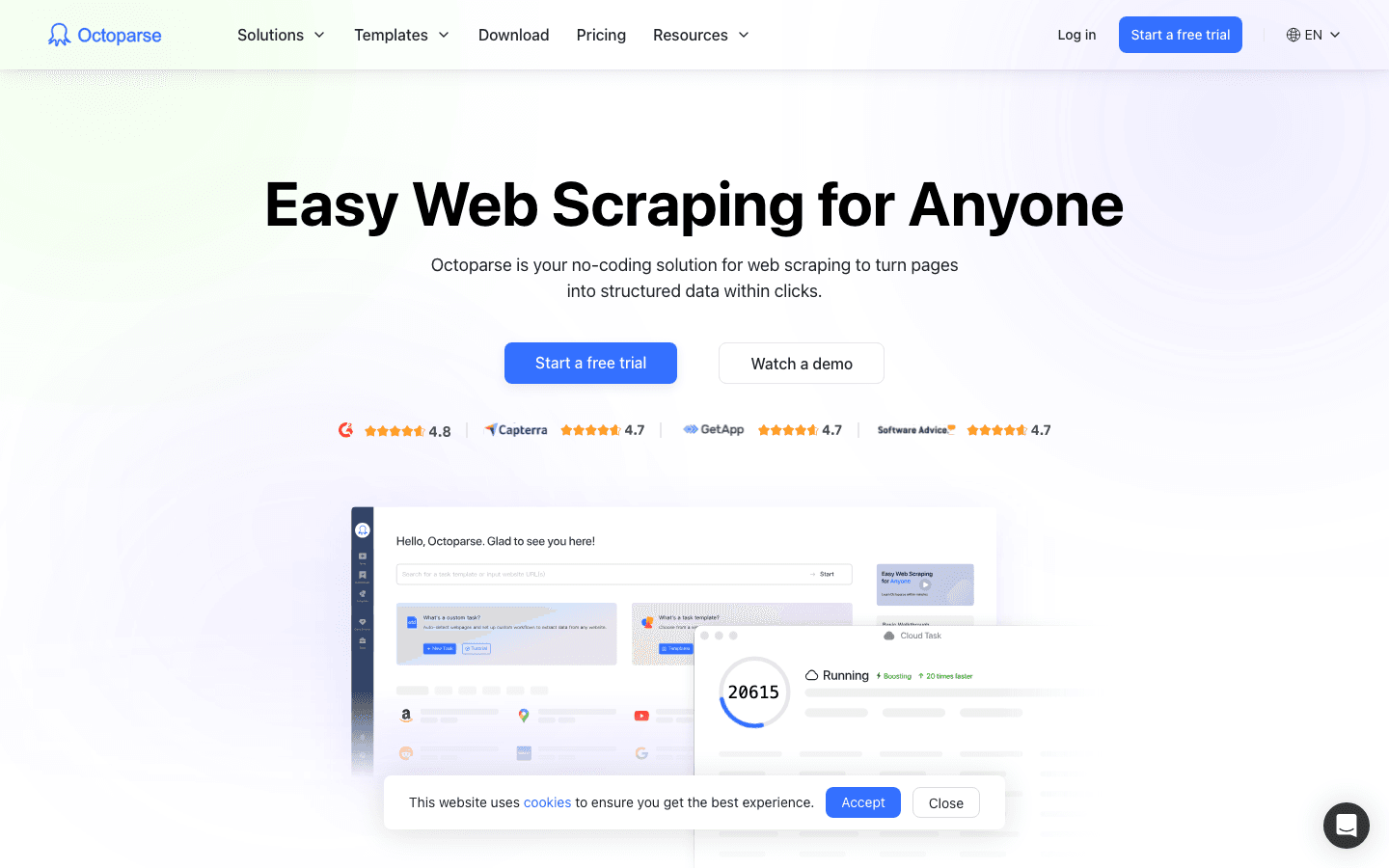

2. Octoparse

は、ビジュアル操作で使えるノーコード型ウェブスクレイパー。初心者や中小企業に人気の理由は:

- AIによる自動検出:リストや価格、ページネーションをAIが自動認識。クリックするだけで抽出OK。

- クラウド実行・スケジューリング:Windowsで設計してクラウドで自動実行。PCを起動し続ける必要なし。定期実行もラクラク。

- 人気サイト用テンプレート:Amazon、Googleマップ、LinkedInなどのテンプレートが豊富。

- 多彩なエクスポート:Excel、CSV、JSON、データベースやGoogle Sheetsにも対応。

- 料金:ローカルで10タスクまで無料。有料は月89ドル〜。

おすすめ用途:ノーコードでクラウド実行したい中小企業やアナリスト、マーケター向け。

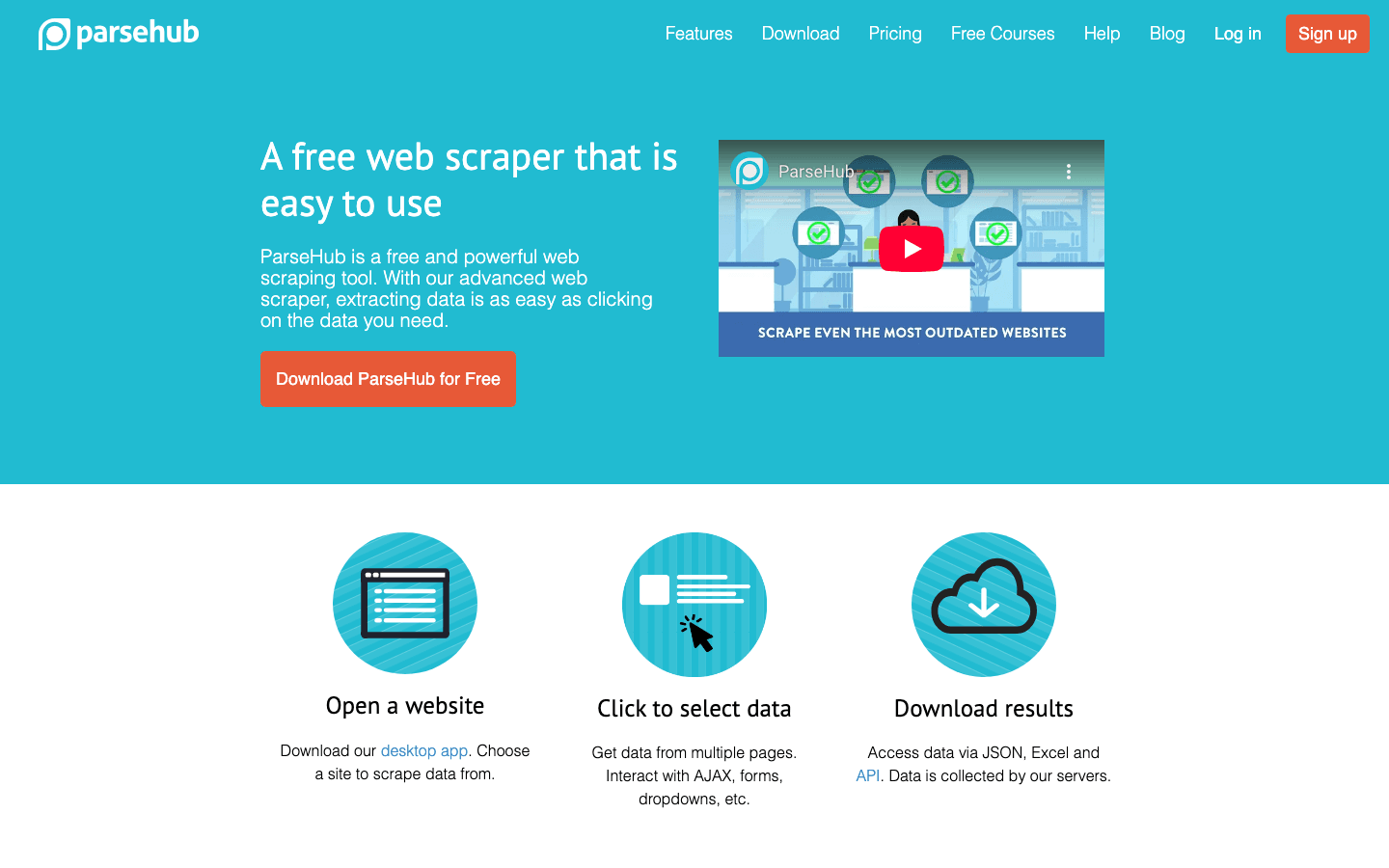

3. ParseHub

は、Windows/Mac/Linux対応のデスクトップアプリ。ビジュアル操作とロジックの柔軟性が魅力:

- ビジュアルエディタ:クリックでデータ選択、ワークフロー設計、フォームやドロップダウン、複数ステップも対応。

- 動的サイト対応:JavaScriptや無限スクロール、AJAXにも強い。

- 条件分岐ロジック:if/thenやループもノーコードで設定可能。高度な処理もOK。

- クラウド実行・API:クラウドでプロジェクト実行、スケジューリング、API連携も。

- 料金:1回200ページまで無料。有料は月189ドル〜。

おすすめ用途:ノーコード以上の柔軟性を求める中上級者やMacユーザーに。

4. Scrapy

は、開発者向けPythonフレームワークの定番:

- 完全なコード制御:独自のスパイダーを構築し、あらゆるサイトやワークフローに対応。

- 高パフォーマンス:非同期クロールで大規模データも高速処理。数百万ページもOK。

- 豊富なエコシステム:プラグインやミドルウェア、コミュニティサポートも充実。

- 無料・オープンソース:ライセンス費不要。開発者の工数とインフラのみ。

おすすめ用途:大規模・高度なカスタマイズが必要な開発チームやエンタープライズ。Pythonスキルがあれば最強。

5. Import.io

は、エンタープライズ向けのデータ提供プラットフォーム:

- ノーコードUI+運用代行:クリック操作で設定可能。Import.ioのチームがスクレイパーの構築・保守も代行。

- クラウド自動化:定期実行やログイン対応、クラウドでのデータ処理も。

- データ連携:APIやWebhook、アプリ・DBへの直接出力も。

- データ変換:Excelのようなルールでデータを整形して出力。

- 料金:カスタム見積もり(目安:月299ドル〜)。

おすすめ用途:自社でスクレイパーを作らず、信頼性重視でデータ抽出を外部委託したい大企業向け。

6. Apify

は、クラウド型で「アクター」と呼ばれるテンプレートが特徴:

- アクターマーケットプレイス:AmazonやTwitter、Googleマップなどの既成スクレイパーを選んで即実行。

- カスタムスクリプト:JavaScriptやPythonで独自アクターも作成可能。

- クラウド拡張性:複数ジョブの並列実行、ヘッドレスブラウザやプロキシ管理も。

- API連携:JSON、CSV、Google Sheets、API/Webhook出力も。

- 料金:無料枠あり。有料は月39ドル〜。

おすすめ用途:開発者や技術に強いチーム、またはマーケットプレイスのアクターを活用したい非エンジニア。

7. WebHarvy

は、Windows専用のビジュアル型デスクトップスクレイパー:

- 直感的UI:クリックでデータ取得。パターンやリストも自動認識。

- ページネーション・無限スクロール:「もっと見る」ボタンや複数ページも対応。

- フォーム入力:複数の検索語やURLで結果を取得。

- 買い切りライセンス:1ユーザー約129ドル(1年分のアップデート付)。

- エクスポート:CSV、Excel、XML、DB直送も。

おすすめ用途:コスト重視でシンプルなデスクトップツールを求める中小企業やマーケター、リサーチャー向け。

8. Dexi.io

は、業務自動化に強いクラウド型スクレイピング&ワークフロープラットフォーム:

- ビジュアルロボットデザイナー:ブラウザ上でスクレイピングボットを設計。

- クラウドスケジューリング:Dexiサーバーで定期実行・進捗管理も。

- データ加工:取得データのクレンジングや変換もリアルタイムで可能。

- チームコラボ:複数ユーザー管理や権限設定も。

- 料金:カスタム見積もり(中小企業で月数百ドル〜)。

おすすめ用途:リテール・EC・マーケティングの業務自動化や分析チームに。

9. Data Miner

は、Chrome/Edge拡張機能でテンプレート型の手軽なスクレイピング:

- 6万以上のレシピ:Google、LinkedIn、Amazonなど主要サイトはワンクリックで取得。

- カスタムレシピ:クリック操作で独自テンプレートも作成可能。

- ブラウザベース:ログイン後の画面もそのまま取得。

- エクスポート:CSV、Excel、Google Sheets対応。

- 料金:月500ページまで無料。有料は月19ドル〜。

おすすめ用途:営業リストやリード獲得など、手早くデータが欲しいビジネスパーソンに。

10. Mozenda

は、クラウド型のエンタープライズ向けスクレイピングプラットフォーム:

- ビジュアルエージェントビルダー:Windowsアプリで直感的に設定。

- クラウド実行:クラウドでエージェントを実行、定期ジョブやデータ一元管理も。

- チームコラボ:複数ユーザー管理や権限設定。

- 手厚いサポート:トレーニングや導入支援、ライブサポートも充実。

- 料金:月99ドル〜。エンタープライズプランあり。

おすすめ用途:大規模・反復的なデータ抽出やサポート重視の企業・団体に。

11. OutWit Hub

は、Windows/Mac/Linux対応のビジュアル型デスクトップアプリ:

- 自動データ認識:リンクや画像、メールアドレスなどをワンクリックで抽出。

- ポイント&クリック選択:パターンを指定して構造化データを取得。

- 多様なデータ型:テキスト、画像、ファイルなど幅広く対応。

- 料金:無料版あり。プレミアムは一括75ユーロ程度。

おすすめ用途:ジャーナリストや研究者、中小企業で多様なデータを手軽に取得したい人に。

12. Visual Web Ripper

は、Windows専用の上級者向けデスクトップスクレイパー:

- ビジュアルプロジェクトデザイナー:複雑なサイトやページネーション、サブページもテンプレート化。

- スケジューリング・自動化:定時実行やDB自動エクスポートも。

- データ変換:抽出時にデータ加工も可能。

- 買い切りライセンス:1ユーザー約349ドル。

おすすめ用途:Windows環境で強力なスクレイピングを求めるデータ担当者や中小企業に。

13. Content Grabber

は、データプロフェッショナルや代理店向けのエンタープライズ型デスクトップ/ウェブスクレイパー:

- 高度なスタジオ:ビジュアル設計+C#スクリプトで柔軟なロジック構築。

- 自動化・スケジューリング:数百のエージェントを並列管理、他システム連携も。

- 連携性:DBやAPI出力、クライアント向けスタンドアロン作成も。

- 料金:プロ/エンタープライズライセンスは数千ドル規模(無料枠なし)。

おすすめ用途:代理店や大企業、SaaS事業など、ウェブスクレイピングが事業の中核となるケースに。

14. 80legs

は、ビッグデータ向けのクラウド型ウェブクローラー:

- 大規模クロール:1ジョブで1,000万ページ以上も対応。

- カスタム抽出:パターンや正規表現で抽出内容を指定可能。

- APIアクセス:プログラムからクロール設定・管理も。

- 料金:1クロール1万URLまで無料。有料は月29ドル〜。

おすすめ用途:大規模なウェブ全体の分析やリサーチを行うデータサイエンティストやエンジニア、企業向け。

15. Diffbot

は、AIで非構造データを自動で構造化するデータ抽出プラットフォーム:

- 自動ページ解析:URLを渡すだけで、記事・商品・ディスカッションなどを構造化JSONで返却。手動設定不要。

- 多彩なAPI:Article API、Product API、Knowledge Graphなど。

- Crawlbot:サイト全体をクローリングし、AIでデータ化。

- 料金:月299ドル〜。大規模利用は従量課金。

おすすめ用途:多様なソースから高品質な構造化データを取得したいエンタープライズや開発者向け。

スクレイピングソリューション比較表

各ツールの特徴を一目で比較できるよ:

| ツール | 主な特徴 | 使いやすさ | カスタマイズ性 | パフォーマンス・拡張性 | 対応サイト | 料金 | おすすめ用途 |

|---|---|---|---|---|---|---|---|

| Thunderbit | AI, 2クリック, サブページ, テンプレート | 非常に簡単 | 中 | 良好 (クラウド/ローカル) | すべてのブラウザサイト | 無料/15ドル〜月 | 営業、マーケ、非エンジニア |

| Octoparse | ビジュアル, クラウド, テンプレート | 簡単 | 中 | 高 (クラウド) | 動的/AJAXサイト | 無料/89ドル〜月 | SMB、アナリスト、初心者 |

| ParseHub | ビジュアル, ローコード, API | 普通 | 高 | 高 (クラウド) | JS多用、複雑サイト | 無料/189ドル〜月 | 技術志向、Macユーザー |

| Scrapy | Python, コード, 拡張性 | 難 (開発者向け) | 非常に高い | 優秀 | すべて (コード次第) | 無料 | 開発者、大規模データ |

| Import.io | 運用代行, クラウド, API, 変換 | 普通 | 中 | 高 (エンタープライズ) | 複雑/ログイン | 299ドル〜月 | 大企業、運用委託 |

| Apify | マーケット, スクリプト, クラウド | 簡単/普通 | 非常に高い | 高 (クラウド) | すべて (JS, ヘッドレス) | 無料/39ドル〜月 | 開発者、上級者 |

| WebHarvy | デスクトップ, クリック操作 | 非常に簡単 | 低/中 | 普通 | 静的/動的サイト | 129ドル買い切り | SMB、マーケ、Windows |

| Dexi.io | クラウド, ビジュアル, 自動化, チーム | 普通 | 高 | エンタープライズ | 多く (ログイン含む) | カスタム/200ドル〜 | 業務、リテール、EC |

| Data Miner | 拡張機能, テンプレ, クイック出力 | 非常に簡単 | 低 | 普通 | ほぼ全ブラウザサイト | 無料/19ドル〜月 | 短期・非エンジニア |

| Mozenda | クラウド, ビジュアル, チーム, サポート | 簡単 (慣れれば) | 中 | 高 (クラウド) | 動的/ログイン | 99ドル〜月 | 大企業、リサーチ |

| OutWit Hub | デスクトップ, 自動認識, 多データ | 簡単 | 低/中 | 普通 | 静的サイト | 無料/75ユーロ買い切り | ジャーナリスト、研究者 |

| Visual Web Ripper | デスクトップ, 高度ビジュアル, スケジューリング | 普通 | 高 | 高 (ローカル) | 複雑/フォーム | 349ドル買い切り | データ担当、SMB、Windows |

| Content Grabber | デスクトップ/ウェブ, スクリプト, SDK | 難 (開発/IT) | 非常に高い | 非常に高い | すべて (コード次第) | 数千ドル (企業向け) | 代理店、SaaS、大企業 |

| 80legs | クラウド, 大規模, API | 普通 (技術要) | 中 | 優秀 | 超大規模 | 無料/29ドル〜月 | ビッグデータ、リサーチ、クロール |

| Diffbot | AI, API, ナレッジグラフ | 簡単 (開発者向け) | 低 (ユーザー) | 高 (クラウド) | すべて、JS多用、AI | 299ドル〜月 | 企業、AI、構造化データ |

ビジネスに最適なスクレイピングソリューションの選び方

選び方のポイントをまとめたよ:

-

技術スキル

- コーディング不要:Thunderbit、Octoparse、WebHarvy、Data Miner、Mozenda

- 少しコーディング可:ParseHub、Apify、Visual Web Ripper

- 開発チーム向け:Scrapy、Content Grabber、80legs

-

データ量・頻度

- 単発/小規模:Data Miner、WebHarvy、OutWit Hub

- 定期・中規模:Thunderbit、Octoparse、Dexi.io、Mozenda

- 大規模:Scrapy、Apify、80legs、Diffbot

-

サイトの複雑さ

- 静的/シンプル:どのツールでもOK

- 動的/JS多用:Octoparse、ParseHub、Apify、Diffbot、Content Grabber

-

連携ニーズ

- Excel/Sheets出力:Thunderbit、Octoparse、Data Miner

- API/DB連携:Import.io、Apify、Dexi.io、Content Grabber

-

予算

- 無料/低コスト:Thunderbit(無料枠)、Data Miner、Scrapy、WebHarvy(買い切り)

- エンタープライズ:Import.io、Mozenda、Dexi.io、Diffbot、Content Grabber

-

サポート・運用

- 運用代行希望:Import.io、Mozenda、Dexi.io

- 自力+コミュニティ:Scrapy、Apify

まずは無料枠やトライアルで実際に試して、自社のワークフローやデータ要件に合うかチェックしよう!

実際の活用事例とよくある課題

EC価格監視

中堅小売業者がDexi.ioで競合500商品の価格を毎日自動取得。スケジューリングと自動化で1日4時間の工数削減、を実現。

営業リード獲得

B2B営業チームがThunderbitで業界ディレクトリを自動取得。2日かかっていた作業が10分に短縮。四半期で5,000件のリードを獲得し、パイプラインが大幅増()。

ジャーナリズム・リサーチ

記者がDiffbotのArticle APIで1週間に1,200本のニュース記事を自動取得。手作業なら1ヶ月かかる作業を自動化()。

よくある課題

- アンチボット対策:プロキシ自動切替(Dexi、Apify)やブラウザ型(Thunderbit)で回避。

- データ整形:フィールドプロンプト(Thunderbit)や内蔵変換機能(Import.io、Mozenda)でクリーンなデータに。

- サイト構造変更:AIや自動修復機能(Diffbot、Thunderbit)搭載ツールならレイアウト変更にも柔軟対応。

まとめ:理想のスクレイピングソリューションを見つけよう

2025年、ウェブデータはビジネスの成長を加速させる“隠し味”。営業リード獲得、価格監視、分析基盤構築など、最適なスクレイピングソリューションを選べば、作業時間を大幅短縮できて精度もアップ。新しいビジネスチャンスも広がるよ。

- 非エンジニア:Thunderbit、Octoparse、Data Miner、WebHarvy

- 技術志向チーム:ParseHub、Apify、Visual Web Ripper

- 開発者・大企業:Scrapy、Import.io、Dexi.io、Content Grabber、Diffbot、80legs

多くのツールが無料トライアルを用意してるから、ぜひ実際に試してみて。用途ごとに使い分けるのもおすすめ。AIでスクレイピングがどれだけ簡単になったか体感したい人は、もぜひチェックしてみてね。

みんなのデータが、いつもクリーンで構造化されて、すぐに活用できるものでありますように。さらに詳しい解説や実践ガイドはもぜひ参考にしてみて!

よくある質問(FAQ)

1. ビジネスでウェブスクレイピングソリューションを使う最大のメリットは?

ウェブスクレイピングソリューションは、ウェブサイトからのデータ収集を自動化して、時間短縮・ミス削減・リアルタイムな営業・マーケ・業務分析を実現できるよ。

2. 非エンジニアにおすすめのスクレイピングソリューションは?

Thunderbit、Octoparse、WebHarvy、Data Minerは、ノーコードで直感的に使える設計になってる。

3. アンチスクレイピング対策のあるサイトはどうすれば?

プロキシ自動切替(Dexi.io、Apify)やブラウザ型(Thunderbit)を選ぼう。大規模案件なら80legsやDiffbotも有効。

4. 取得先サイトのレイアウトが変わった場合は?

AIや自動修復機能付き(Thunderbit、Diffbot)を使うか、テンプレートやスクリプトを都度更新しよう。

5. ウェブスクレイピングはビジネス利用で合法・倫理的ですか?

公開データの取得は一般的に合法だけど、各サイトの利用規約やプライバシーポリシーは必ず確認しよう。個人情報や機密データの取得は避けて、robots.txtもちゃんと守ってね。