2026年の今、インターネットにはとんでもない量のデータが溢れていて、そのデータをビジネスの武器に変える競争はますます激しくなっています。営業やEC、オペレーションの現場では、昔は何時間もかかっていた単純作業が今や自動化されて、仕事の効率がグッと上がりました。もしまだウェブデータスクレイピングソフトを使っていないなら、ライバルが2杯目のコーヒーを飲んでいる間に、あなたはまだスプレッドシート地獄から抜け出せていないかもしれません。

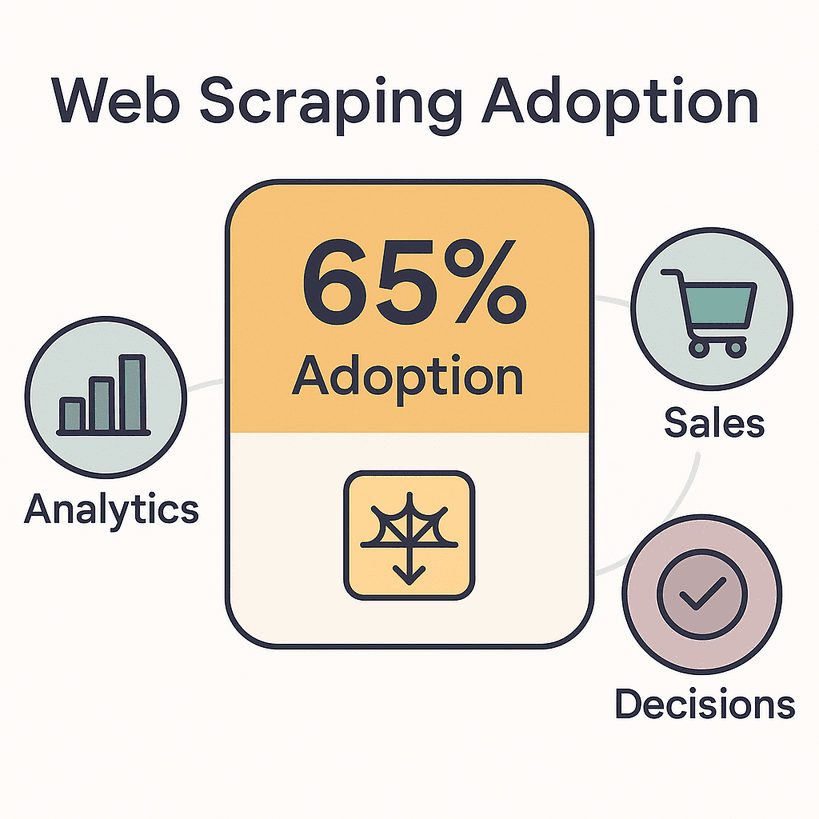

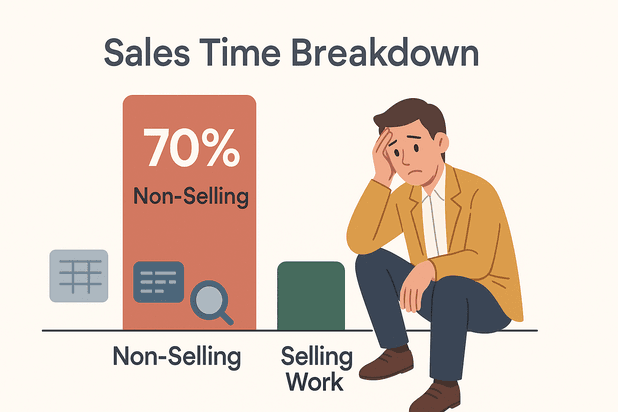

実際、して、分析や営業、意思決定にフル活用しています。世界のウェブデータ抽出市場はすでにに到達し、2030年にはその2倍に成長する見込み。営業担当者はをデータ入力やリサーチなど、売上に直結しない作業に費やしているのが現実です。本来なら商談や休憩に使えるはずの時間が、無駄になっているんですよね。

じゃあ、2026年に本当に使えるウェブデータスクレイピングソフトはどれなのか?ここでは、どんな規模やスキルのチームでも使いやすい注目の5つのツールを徹底比較します。プログラミングが苦手な人も、柔軟性を求める開発者も、きっとピッタリの選択肢が見つかるはず!

優秀なウェブデータスクレイピングソフトの条件って?

正直、すべてのウェブスクレイパーが同じってわけじゃありません。2026年のベストウェブデータスクレイピングソフトは、誰でもサクッと・確実に・簡単にデータを抜き出せるのが大きなポイント。Pythonが得意な人だけのものじゃないんです。

僕が重視するポイント(多くのビジネスユーザーも同じだと思います):

- 使いやすさ:エンジニアじゃなくても数分でスクレイピング設定できる?ノーコードやAI搭載のUIはマスト。

- 対応データソースの幅:ウェブページだけじゃなく、PDFや画像、動的コンテンツ(無限スクロールやAJAX)にも対応してる?多いほど便利。

- 自動化・スケジューリング:定期実行やページネーション、サブページの自動巡回ができる?「放置できる」か「手間がかかる」かの分かれ道。

- 連携・エクスポート:ExcelやGoogle Sheets、Notion、Airtable、API連携など、手作業をどれだけ減らせるか?

- 必要な技術スキル:本当にノーコード?正規表現とかの知識が必要?初心者から上級者まで対応できる?

- スケーラビリティ:数百・数千ページの大量データも安定して処理できる?

- サポート・コミュニティ:ドキュメントやサポート体制、ユーザーコミュニティが充実してる?

これらは「あると便利」じゃなくて、作業効率を大きく左右する超重要な基準です。2026年にはになっているので、ちゃんとしたスクレイパー選びが勝負の分かれ目になります。

それじゃ、注目の5ツールを詳しく見ていきましょう!

2026年おすすめウェブデータスクレイピングソフト5選

- :ノーコード・AI搭載・マルチソース対応

- :エンタープライズ向け統合データパイプライン

- :開発者向けオープンソースフレームワーク

- :ビジュアルUI・ノーコード・スケジューリング対応

- :直感的な操作で日常業務を自動化

1. Thunderbit:AI搭載・ノーコードで一番カンタンなウェブデータスクレイピングソフト

は、コードを書かずにウェブデータを抜き出したい人にピッタリのツール。実は僕自身も開発に関わっているのでちょっと贔屓目ですが、Thunderbitは「結果を出したいビジネスユーザー」のために作られています。

Thunderbitの強み

- AIフィールド自動提案:「AI Suggest Fields」を押すだけで、AIがページを解析して抽出項目を自動設定。セレクタやテンプレートの知識は一切不要。

- マルチソース対応:ウェブページだけじゃなく、PDFや画像からもテキスト・リンク・メール・電話番号・画像を2クリックで抽出。

- サブページ・ページネーション自動化:商品やプロフィールなど詳細ページも自動巡回して情報をまとめて取得。無限スクロールやページ送りも自動対応。

- バッチ・定期実行:URLリストを貼り付けて一括処理、定期ジョブもスケジューリングOK。価格監視やリードリスト更新も自動化。

- 即時エクスポート:Excel、Google Sheets、Airtable、Notion、CSV、JSONにワンクリックで出力。コピペの手間ゼロ。

- カスタムAIプロンプト:抽出時にカテゴリ分けや翻訳、ラベル付けなどもAIが自動でやってくれる。

- クラウド・ローカル両対応:クラウドで高速処理(同時50ページ)、ログインが必要なサイトはローカル実行もOK。

Thunderbitはに使われていて、営業・不動産・ECなど幅広い業種で大活躍。無料プランは6ページ(トライアルで最大10ページ)まで使えて、使った分だけ課金(1行ごとに1クレジット)という分かりやすい料金体系です。

おすすめポイント:Thunderbitなら、エンジニアじゃなくても「このデータが欲しい」から「スプレッドシート完成」まで5分以内。直感的なUIと、ウェブサイトの変化にもAIが自動対応するので、メンテナンスの手間も最小限。

おすすめ用途:営業、EC、オペレーションなど、ノーコード・AI活用で手間なくデータ抽出したい人全般。

さらに詳しい使い方はもチェックしてみてください。

2. Import.io:エンタープライズ向けウェブデータ統合プラットフォーム

は、大規模なデータ収集と業務システムへの直接連携が必要な企業向けの強力なプラットフォーム。

Import.ioの特徴

- エンタープライズ対応パイプライン:ただのスクレイパーじゃなく、継続的な自動データ供給を実現する「データ・アズ・ア・サービス」基盤。

- AIによる自己修復:ウェブサイトの構造が変わっても、AIが自動でフィールドを再マッピングしてパイプラインの停止を防ぐ。

- 高度な自動化:毎時・毎日・カスタム間隔での定期実行や、異常時のアラート通知も可能。

- インタラクティブなワークフロー:ログインやフォーム入力、複数ステップの操作も記録・再現できる。

- コンプライアンス・ガバナンス:個人情報の自動検出・マスキング・監査ログなど、規制業界にも対応。

- API・各種連携:Google Sheets、Excel、Tableau、Power BI、データベース、独自アプリへのAPI連携もバッチリ。

Unilever、Volvo、RedHatなど大手企業も導入。数千サイトの価格監視や市場調査、AI/MLモデルへのデータ供給など、ミッションクリティカルな用途に最適です。

料金:セルフサービスプランは月額約$299から。無料トライアルあり。データ活用が事業の中核なら十分な投資価値あり。

おすすめ用途:信頼性・拡張性・コンプライアンス・システム連携が必要な大企業やデータ主導型組織。

3. Scrapy:開発者向けオープンソースウェブスクレイピングフレームワーク

は、Pythonで自由にカスタマイズしたい開発者向けのオープンソースフレームワーク。

開発者に人気の理由

- 完全カスタマイズ:スパイダー(スクリプト)を自作して、複雑なフローやデータ加工も思いのまま。

- 非同期・高速処理:アーキテクチャが高速・大規模処理向け。1分間に数百ページ、分散実行で数百万ページも可能。

- 拡張性:プロキシやヘッドレスブラウザ(Splash/Playwright)連携、各種プラグインも豊富。

- 無料・オープンソース:ライセンス費用不要。自社サーバーやクラウドで自由に運用可能。

- 活発なコミュニティ:GitHubスター5万超、情報も豊富。困ったときも解決策が見つかりやすい。

注意点:Pythonの知識とコマンドライン操作が必須。UIはなく、完全にコードベース。独自プロジェクトやAI学習用データ、大規模クローリングには最適。

おすすめ用途:社内に開発者がいる組織、カスタムデータパイプライン、大規模・複雑なスクレイピング案件。

4. Octoparse:ビジュアルUIでカンタンに使えるウェブデータスクレイピング

は、ノーコードで強力なスクレイピングをしたい非エンジニアに人気のツール。

Octoparseが選ばれる理由

- ビジュアルワークフロービルダー:内蔵ブラウザで要素をクリックするだけでパターンを自動検出。コーディング不要。

- 動的コンテンツ対応:AJAXや無限スクロール、ログイン必須サイトもOK。クリックやスクロール、フォーム送信もシミュレート。

- クラウドスクレイピング・スケジューリング:クラウド上で高速並列処理、定期実行もカンタン。

- テンプレート多数:Amazon、Twitter、Zillowなど人気サイト用テンプレートが豊富で即スタート可能。

- エクスポート・API:CSV、Excel、JSONでの出力やAPI連携、Google SheetsやDBとの連携も。

「初心者でもすぐ使える」と評判。無料プランは制限ありですが、有料プラン(月額約$83〜)でクラウド実行やスケジューリングが解放されます。

おすすめ用途:非エンジニア、マーケター、リサーチャー、小規模チームの定期的なデータ収集。

5. ParseHub:日常業務にピッタリなユーザーフレンドリーなデータ抽出ツール

は、特に中小企業やフリーランスが日々のデータ作業を自動化したいときに便利なノーコードツール。

ParseHubの魅力

- 直感的なポイント&クリック操作:ブラウザ画面で要素をクリックしてデータ選択。ワークフローもビジュアルで構築。

- JavaScript・動的サイト対応:JSで動くページや無限スクロール、複数ステップのナビゲーションもOK。

- クラウド・ローカル両対応:デスクトップでもクラウドでも実行可能。上位プランでAPI連携や定期実行も。

- 多彩なエクスポート:CSV、Excel、JSONでの出力やAPI連携も。

- マルチプラットフォーム:Windows、Mac、Linux対応。

無料プランは1回200ページまでですが、有料プラン(月額約$189〜)でより多くのデータやAPI連携が可能。

おすすめ用途:中小企業、フリーランス、日常的なデータ収集を手軽に自動化したい人。

一目で分かる!ウェブデータスクレイピングソフト比較表

| ツール名 | 使いやすさ | 対応データソース | 自動化・スケジューリング | 連携・エクスポート | 技術スキル | 料金体系 |

|---|---|---|---|---|---|---|

| Thunderbit | ノーコード・AI搭載 | Web、PDF、画像 | サブページ、ページネーション、定期・一括実行 | Excel、Sheets、Notion、Airtable、CSV、JSON | 不要 | フリーミアム(従量課金) |

| Import.io | ポイント&クリックUI | Web(静的・動的・ログイン) | 自己修復、定期実行、アラート | API、BIツール、Sheets、Excel、DB | 低〜中 | $299〜/月 |

| Scrapy | コード必須 | Web、API(JSはアドオン) | コードによる完全自動化 | 任意(コード次第) | Python開発者 | 無料(OSS) |

| Octoparse | ビジュアル・ノーコード | Web(動的・ログイン) | クラウド定期実行、テンプレート | CSV、Excel、JSON、API | 不要 | $83〜/月 |

| ParseHub | ビジュアル・ノーコード | Web(JS・動的) | クラウド/ローカル、定期実行 | CSV、Excel、JSON、API | 不要 | $189〜/月 |

ビジネスに最適なウェブデータスクレイピングソフトの選び方

どれを選べばいいか迷ったら、こんな感じで選んでみてください:

- 非エンジニア・スピード重視:かがおすすめ。ThunderbitはAI搭載・マルチソース対応で即時抽出、OctoparseはビジュアルUIと定期実行が強み。

- エンタープライズ連携・コンプライアンス・大規模運用:が最適。継続的なデータパイプラインと深いシステム連携が可能。

- 開発者・カスタム案件・大規模クローリング:一択。Pythonスキル必須だけど、自由度は無限大。

- 中小企業・フリーランス・日常業務:は直感的な操作と適度な自動化で使いやすい選択肢。

選定のコツ

- チームの技術力やデータ活用ニーズに合ったツールを選ぶ

- 対象サイトの複雑さ(動的コンテンツ・ログイン有無など)を考慮

- データの利用方法(Sheetsへの直接出力か、API連携か)を明確に

- まずは無料トライアルやフリーミアムプランで実際に試してみる

- サポートやドキュメントの充実度も大事な判断材料

まとめ:最適なウェブデータスクレイピングソフトでビジネス価値を最大化しよう

2026年、ウェブデータはビジネスの意思決定を支える超重要な資源。最適なウェブデータスクレイピングソフトを導入すれば、作業時間を大幅に短縮できて、ミスも減り、チームの競争力もグッと上がります。リードリスト作成、競合調査、分析基盤へのデータ供給など、いろんな場面で大活躍!

要点まとめ:

- Thunderbit:AI搭載・ノーコードでビジネスユーザーに最適

- Import.io:エンタープライズ向けの継続的・統合型データパイプライン

- Scrapy:開発者向けのフルカスタマイズ可能なオープンソースツール

- Octoparse/ParseHub:誰でも使えるビジュアル・ノーコード型スクレイパー

多くのツールが無料トライアルやフリープランを用意しているので、ぜひ実際に試してみてください。単純作業を自動化して、新しいインサイトを発見し、チーム本来の仕事に集中できる環境を手に入れましょう。

データ抽出が、いつでも新鮮で構造化されて、すぐに使えるものでありますように!

よくある質問(FAQ)

1. ウェブデータスクレイピングソフトは何に使うの?

ウェブデータスクレイピングソフトは、ウェブサイトやPDF、画像から情報を自動で抜き出すツール。リード獲得、価格調査、市場リサーチ、コンテンツ収集など幅広い用途で使われています。

2. ウェブデータスクレイピングは合法?

公開情報を集めて、各サイトの利用規約やプライバシー法を守ればOK。必ず対象サイトのポリシーを確認して、正しくデータを使いましょう。

3. コーディング知識がなくても使える?

Thunderbit、Octoparse、ParseHubなどは非エンジニア向けに設計されています。もっと高度なカスタマイズや大規模案件には、Scrapyみたいな開発者向けツールが必要。

4. 抽出したデータをExcelやGoogle Sheetsに出力できる?

Thunderbit、Octoparse、ParseHubなど多くの最新スクレイパーは、ExcelやGoogle Sheets、CSV、Notion、Airtableへのワンクリック出力に対応しています。

5. 動的サイトやログインが必要なページも対応できる?

Import.io、Octoparse、ParseHubなど主要ツールは、AJAXや無限スクロール、ログイン必須サイトにも対応。Thunderbitも動的ページやサブページの抽出が可能です。

最新のウェブスクレイピングを体験したい人は、をダウンロード、またはで活用事例やノウハウをチェックしてみてください。