インターネットには本当に膨大なデータが溢れていて、営業や마케팅、オペレーションに関わる人なら「必要な情報をいかに早く手に入れるか」がどれだけ大事か、身にしみてるはずです。でも、正直なところ、誰もがウェブサイトからデータを手作業でコピペしてスプレッドシートにまとめるなんて、やりたくないですよね。実際、僕の周りでも多くのチームが毎月何十時間も「データ集め」に追われて、結局ミスや古いリストに悩まされているのをよく見かけます。でも、今は違います。最新のスクリーンスクレイピングツールを使えば、エンジニアじゃなくても、数分でウェブデータを集めて整理し、すぐに活用できる時代になりました。

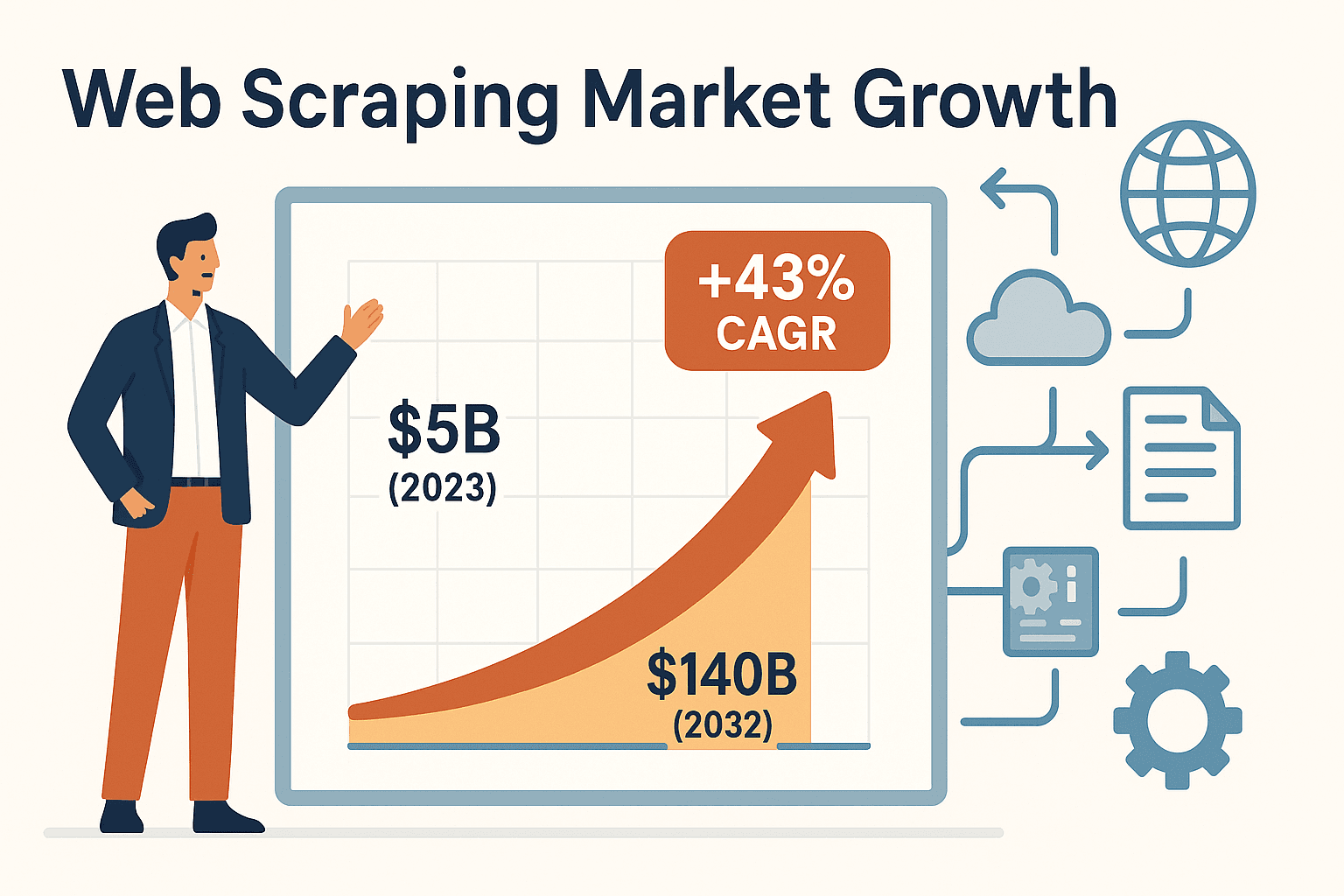

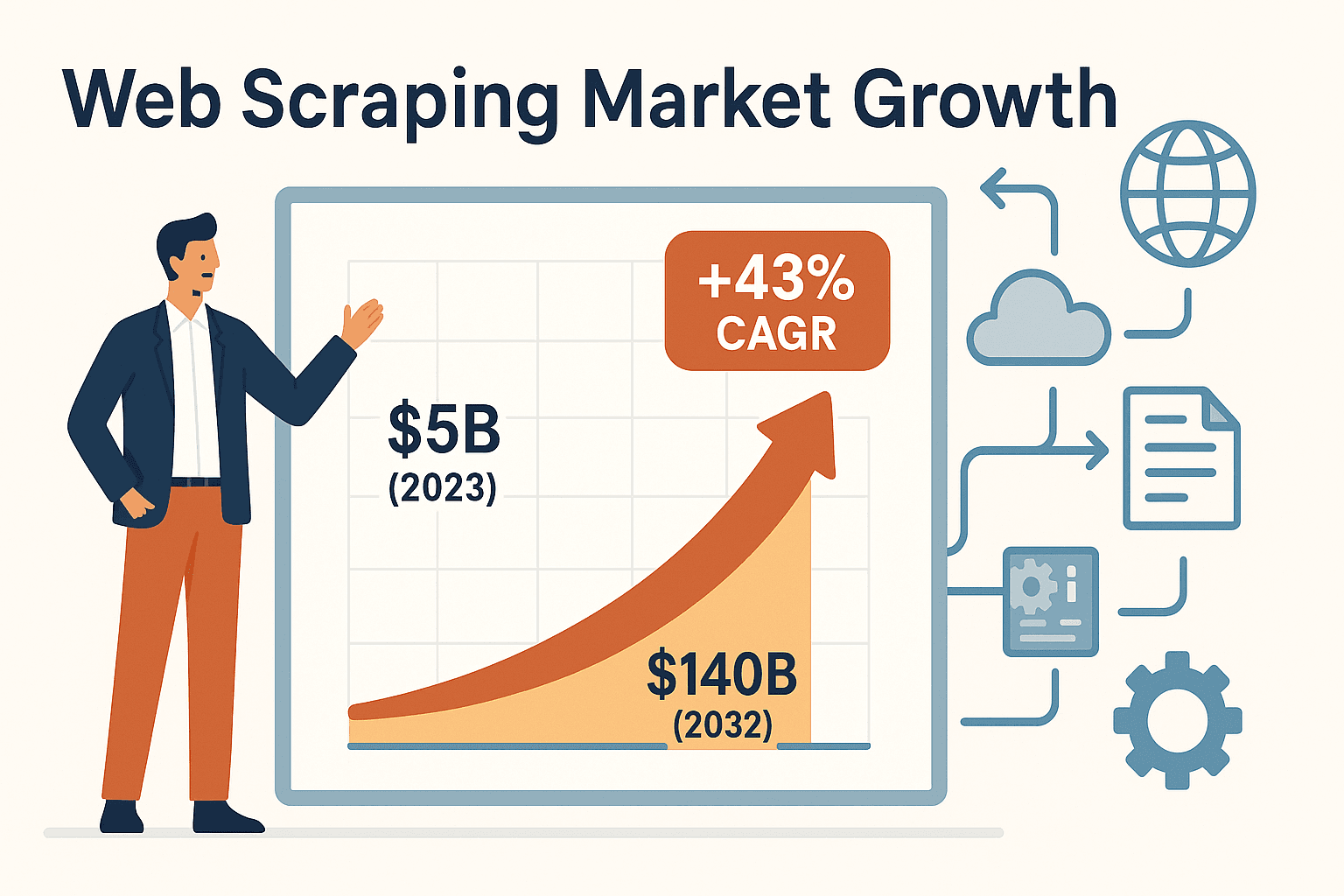

スクリーンスクレイピングツールの需要は今、爆発的に伸びています。世界のウェブスクレイピング市場はで、年平均成長率はなんと43%。なぜここまで注目されているのか?それは、ビジネスの現場で自動化が「あると便利」から「ないと困る」レベルになってきているからです。リードリスト作成、競合調査、不動産情報の収集など、正しいツールを使えばデータ作業の時間を30〜40%短縮できて、データ取得コストも最大40%カットできるんです()。

ここからは、2025年におすすめしたい効率的なデータ収集のためのスクリーンスクレイピングツール6選を紹介します。それぞれの特徴やおすすめユーザー、選び方のコツも分かりやすく解説するので、エンジニアじゃない人も、開発経験がある人も、ぜひ参考にしてみてください。

ビジネスユーザーにとってスクリーンスクレイピングツールが重要な理由

営業リードリストを常に最新に保ったり、競合の価格を手作業でチェックしたことがある人なら、その大変さはよく分かるはず。手作業でのデータ収集は時間もかかるし、ミスも起きやすい。営業担当や마케터、不動産エージェント、オペレーション担当など、ITに詳しくないビジネスユーザーにとって、スクリーンスクレイピングツールはまさに救世主。繰り返しのコピペ作業を自動化して、数時間かかっていた作業がワンクリックで終わります。

実際にスクリーンスクレイピングツールがビジネス現場をどう変えているか、具体例を挙げると:

- リード獲得: ディレクトリやSNSから数百件の見込み顧客情報を一括取得。営業チームはコピペ作業から解放され、本来の営業活動に集中できる。

- 競合モニタリング: 競合サイトの価格や新商品情報を自動で定期取得。John Lewisのような小売業者はを実現。

- 不動産データ収集: Zillowなどのサイトから物件情報を数秒で取得し、常に最新の在庫や顧客リストを維持。

- 業務自動化: 取得したデータをExcelやGoogle Sheets、Airtable、Notionに直接エクスポート。フォーム入力や他のソフト連携も自動化可能。

つまり、スクリーンスクレイピングツールを使えば、IT部門に頼らず自分でウェブデータを活用できるようになります。意思決定も早くなり、フレッシュな情報で競争力もアップ!

スクリーンスクレイピングツールの選び方

選択肢が多すぎて、どれを選べばいいか迷う人も多いはず。車選びみたいに「速さ」や「使いやすさ」など、重視するポイントは人それぞれ。以下のチェックリストを参考に、自分に合ったツールを見つけてみてください:

- 使いやすさ: ノーコードで直感的に使いたい?それともスクリプトを書いてカスタマイズしたい?

- カスタマイズ性: 複雑なサイトやログイン、動的コンテンツ(無限スクロールなど)に対応したい?

- 対応データタイプ: テキストだけじゃなく、画像やPDFも取得したい?

- スケーラビリティ: 数ページだけじゃなく、毎日数千ページを処理したい?

- エクスポート先: ExcelやGoogle Sheets、CRMなどに簡単にデータを送れる?

- 価格: 無料で使いたい?それとも本格的な自動化に投資する?

- サポート・保守: 管理サービスを利用したい?自分でスクリプトの保守もOK?

これらのポイントを意識しながら、次に紹介する6つのツールを比較してみてください。大事なのは「実際にチームが使い続けられるかどうか」です。

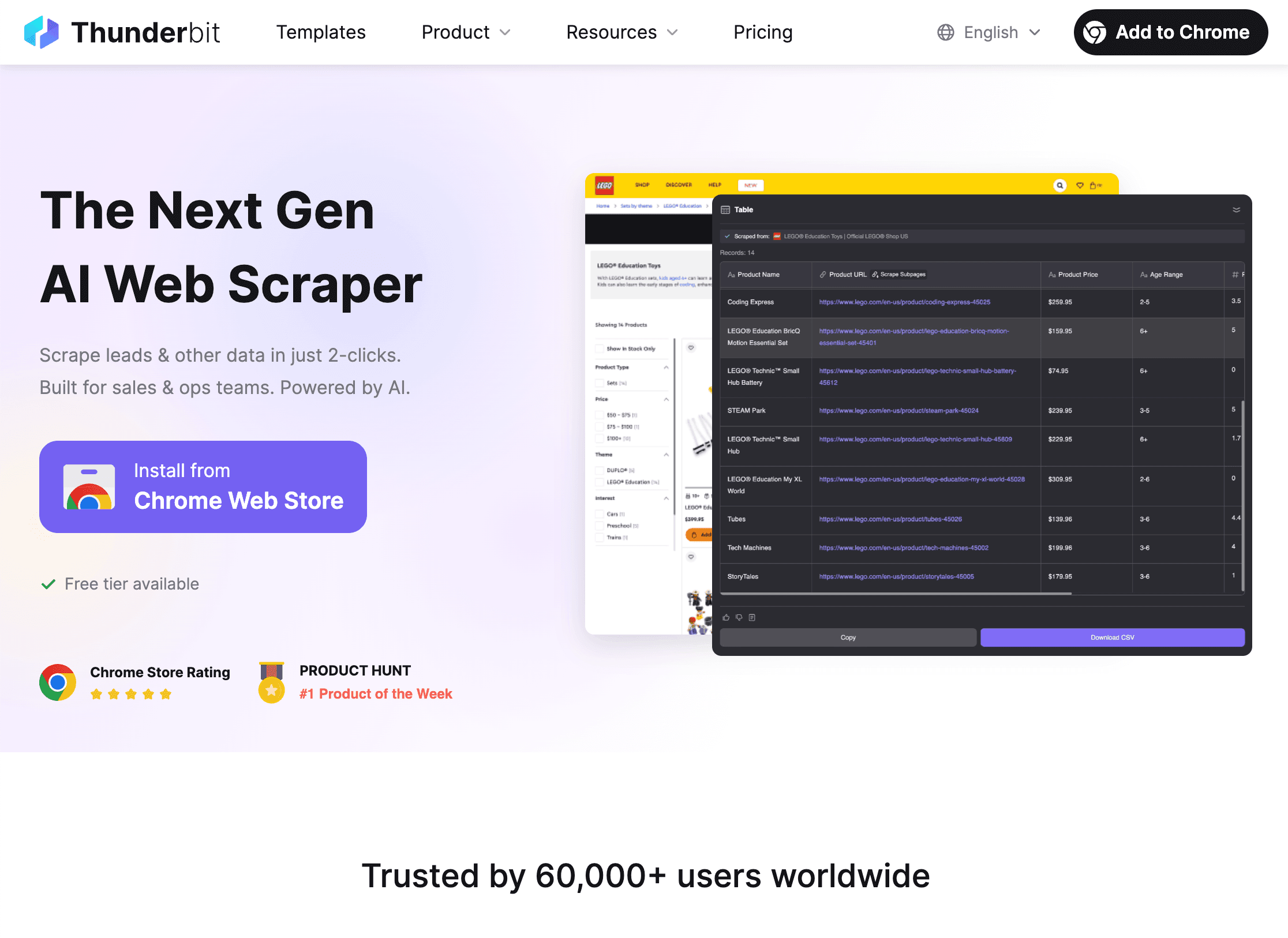

1. Thunderbit

は、ノーコードでサクッとウェブデータを集めたい非エンジニアに特におすすめ。僕自身が共同創業者兼CEOとして開発した理由も、ビジネスユーザーが複雑な開発者向けツールに苦労している現状を変えたかったからです。

Thunderbitの強みは「シンプルさ」と「パワフルさ」の両立:

- AIによるフィールド自動提案: 「AIでフィールド提案」をクリックするだけで、ページ内容をAIが解析し、最適なカラム(名前、価格、メールなど)やデータ型を自動設定。

- 2クリックでスクレイピング: どのサイトでも「スクレイプ」を押すだけ。面倒な設定やセレクタ指定は不要。

- サブページ・ページネーション対応: 商品詳細やLinkedInプロフィールなど、サブページの情報も自動で取得。無限スクロールにも対応。

- 即使えるテンプレート: Amazon、Zillow、Instagramなど人気サイト用のテンプレートを用意。検索ワードを入力するだけでデータ取得。

- 無料データエクスポート: Excel、Google Sheets、Airtable、Notionへのエクスポートが無料。

- 高度な機能: PDFや画像からのデータ抽出、AIオートフィルによるフォーム自動入力(これも無料)、自然言語での定期実行スケジューリングも可能。

- 料金: クレジット制で、6ページまで無料(トライアルで10ページ)。有料プランは月額15ドル(年払いなら9ドル)から500行まで利用でき、どんな規模のチームにも手が届きます。

Thunderbitはのユーザーに使われていて、営業・마케팅・不動産・ECなど幅広い業種で活躍中。「これで何時間もかかっていたリード収集が数分で終わるなんて信じられない!」という声もよく聞きます。ぜひして、その便利さを体感してみてください。

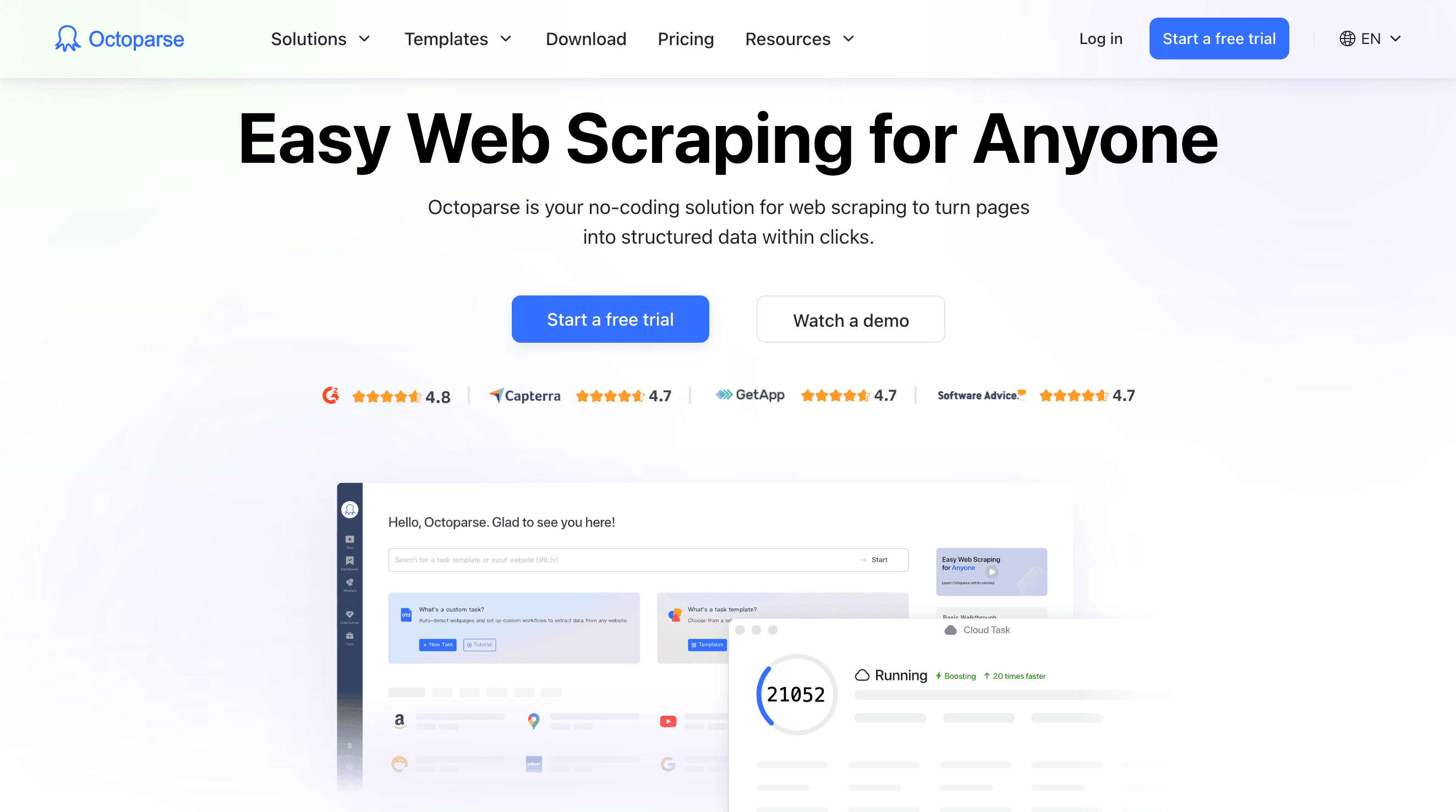

2. Octoparse

は、ノーコードで使えるビジュアル型のスクレイピングツールの代表格。ドラッグ&ドロップでワークフローを作成でき、ログインやAJAX、無限スクロール、複雑なナビゲーションにも対応。コードを書かずに高度なスクレイピングを実現したいパワーユーザーにぴったりです。

主な特徴:

- ビジュアルワークフローデザイナー: サンプルページをクリックしていくだけで、類似要素を自動検出し、抽出フローを構築。

- 動的コンテンツ対応: JavaScriptや無限スクロール、ログインが必要なページもOK。

- クラウドスクレイピング: クラウド上で24時間稼働。PCを起動し続ける必要なし。大量データも処理可能。

- テンプレートライブラリ: Amazon、LinkedIn、Twitterなど100種類以上のテンプレートを利用可能。

- エクスポート形式: CSV、Excel、JSONでダウンロード、またはDBに直接送信。

- 料金: 無料プランあり(機能制限あり)。有料は月額約75ドルから。上位プランで同時実行や高度な機能が利用可能。

Octoparseは、分析担当者やリサーチャー、中小企業で中規模のノーコードスクレイピングを求める人におすすめ。高度なワークフローには慣れが必要ですが、ビジュアルUIと充実したドキュメントで、ITに強い人ならすぐに使いこなせます。

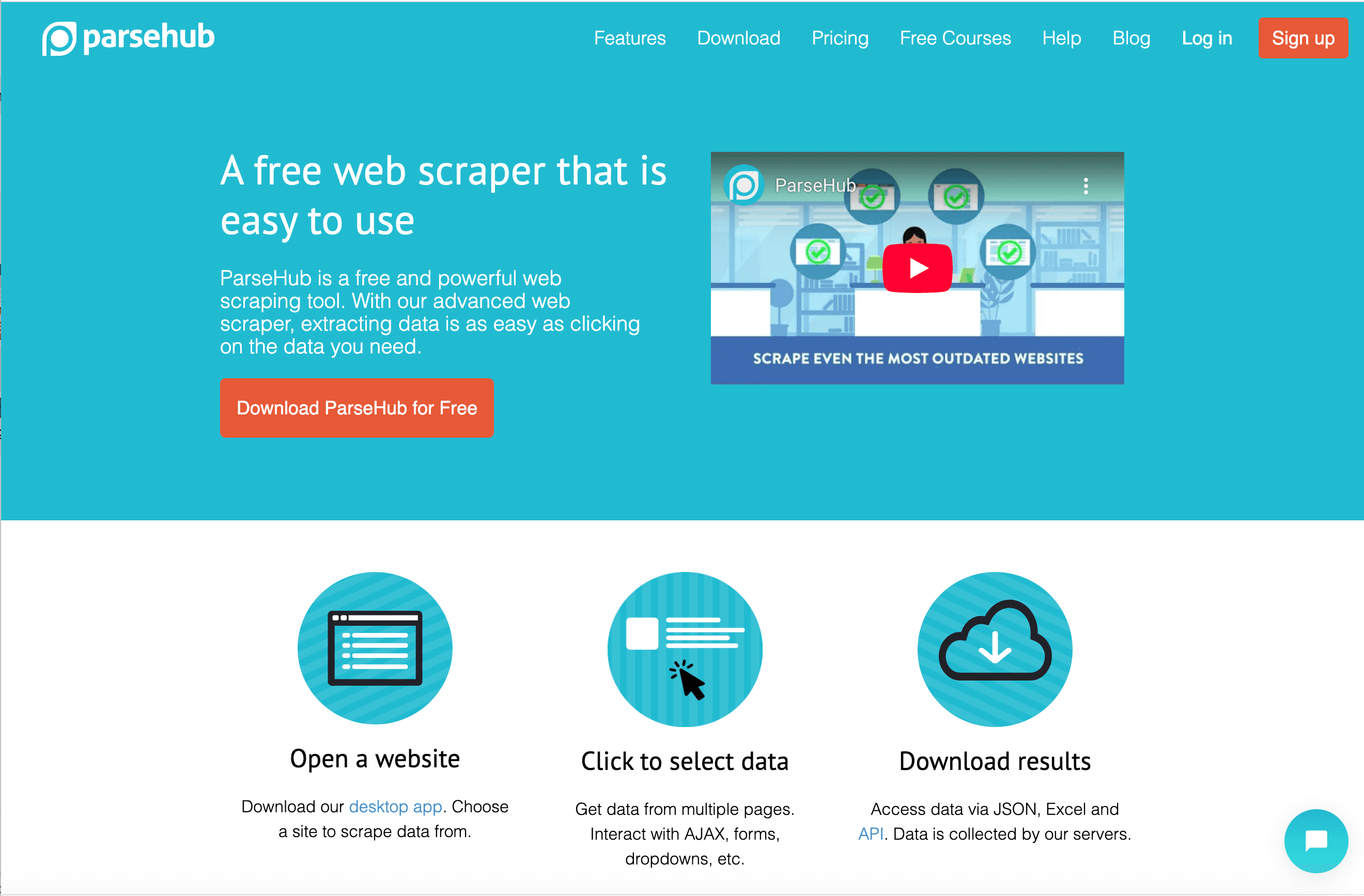

3. ParseHub

は、デスクトップアプリで動的なウェブサイトにも強いビジュアル型スクレイピングツール。JavaScriptが多用されたサイトや、インタラクティブな要素が多いページのデータ取得に特に向いています。

ParseHubの特徴:

- デスクトップ型ビジュアルスクレイパー: 内蔵ブラウザでサイトを操作しながら、必要なデータを直感的に選択。

- JavaScript・AJAX対応: コンテンツの読み込み待ちやボタン操作、フォーム入力なども自動化。

- API連携: プロジェクトの自動実行やデータ取得をプログラムから操作可能。

- クラウドスケジューリング: 上位プランでクラウド実行も対応。

- エクスポート形式: CSV、Excel、JSONでダウンロード。

- 料金: 無料プランは1回200ページまで。有料は月額189ドル(Standard)、599ドル(Professional)から。

ParseHubは、データジャーナリストやリサーチャー、中小企業で動的サイトのデータ取得をしたい人に人気。初心者向けのガイドも充実していますが、大規模利用にはコストがかかります。

4. Scrapy

は、開発者や技術チーム向けの本格的なPython製オープンソースフレームワーク。大規模・複雑・カスタマイズ性重視のスクレイピングに最適で、独自のクローラーを構築できます。

Scrapyが開発者に選ばれる理由:

- 究極の柔軟性: Pythonでスパイダーやクロールルール、データパイプラインを自由に設計。並列処理やリトライ、エクスポートも自動化。

- 高パフォーマンス: 数千〜数百万ページの大規模クロールも効率的に処理。

- 拡張性: プロキシやDB、API、独自ミドルウェアとの連携も自在。

- オープンソース: 無料で利用可能。コストは自前のインフラやクラウド(ZyteのScrapy Cloudなど)次第。

- コミュニティ: 豊富なドキュメントとチュートリアル、大規模なエコシステム。

Scrapyは学習コストが高く、コードの保守も必要ですが、開発リソースがあるチームで大規模なデータパイプラインを構築したい場合には最適です。

5. Diffbot

は、AIと機械学習を活用し、あらゆるウェブページから自動で構造化データを抽出するユニークなサービス。スクレイパーを作る必要はなく、API経由でURLを送るだけで、きれいなJSONデータが返ってきます。

Diffbotの特徴:

- AIによる自動抽出: 記事、商品、ディスカッションなど用途別に最適化されたAPI。人間のようにページを「読み取り」、主要項目を抽出。

- Crawlbot: サイト全体やサイトマップを自動クロール。

- ナレッジグラフ: 12億以上のウェブサイト、2億4,600万の組織データベースを活用可能。

- 大規模対応: エンタープライズ規模のデータ収集に最適。

- 料金: 無料枠(1万クレジット/月)あり。有料は月額299ドル(25万クレジット)から。

Diffbotは、エンタープライズやデータサイエンティスト、大量の構造化ウェブデータが必要な人におすすめ。カスタマイズ性は低いですが、手間なくAIで大規模データを取得したい場合に最適です。

6. DataMiner

は、ChromeやEdgeで使えるブラウザ拡張型のスクレイピングツール。ちょっとしたデータ抽出やリサーチ、リストの取得を素早く行いたい人にぴったりです。

DataMinerが選ばれる理由:

- 直感的な操作: ページ上の要素をクリックして「レシピ」を作成。1万5,000以上のサイト向けに6万件超の公開レシピも利用可能。

- ワンクリック抽出: レシピを適用して、CSVやExcelに即エクスポート。

- ページネーション・一括処理: 複数ページやURLリストの一括処理も対応。

- フォーム入力: CSVデータを使ったフォーム自動入力も可能。

- 無料枠: 月500ページまで無料。有料は月額19.99ドル(2,500ページ)から。

DataMinerは、アドホックな作業やリサーチ、ブラウザ上で手軽にデータを扱いたい人に最適。大規模案件には向きませんが、中小規模のプロジェクトにはとても便利です。

スクリーンスクレイピングツール比較表(一覧)

| ツール名 | 使いやすさ | 主な特徴 | おすすめユーザー | 料金体系 | 独自の強み |

|---|---|---|---|---|---|

| Thunderbit | 非常に簡単(ノーコード) | AIフィールド提案、サブページ・ページネーション、テンプレート、無料エクスポート | 非エンジニアのビジネスユーザー(営業、業務、不動産) | 無料/9〜15ドル〜 | 最速セットアップ、AI活用、即時スクレイピング |

| Octoparse | やや簡単(ノーコード) | ビジュアルワークフロー、クラウド実行、動的サイト、テンプレート | 技術に強い分析担当・リサーチャー | 無料/75ドル〜 | ビジュアル構築、クラウドスケジューリング、柔軟なロジック |

| ParseHub | やや簡単(ノーコード) | デスクトップアプリ、JS/AJAX対応、API、クラウド実行 | 動的サイト、技術初心者 | 無料/189ドル〜 | 複雑サイト対応、デスクトップ操作 |

| Scrapy | 難しい(Pythonコード) | オープンソース、スケーラブル、完全制御、パイプライン | 開発者・エンジニアチーム | 無料(自前運用) | 究極の柔軟性、大規模カスタムスクレイピング |

| Diffbot | 簡単(開発者向け) | AI抽出、API、ナレッジグラフ、Crawlbot | エンタープライズ、データサイエンティスト | 無料/299ドル〜 | 手間いらずのAI、大規模データ、知識グラフ |

| DataMiner | 非常に簡単(ブラウザ) | ブラウザ拡張、6万+レシピ、ワンクリック、フォーム入力 | アドホック作業、ジャーナリスト、グロースハッカー | 無料/19.99ドル〜 | 最速のブラウザ型、豊富なテンプレート |

あなたに最適なスクリーンスクレイピングツールは?

- ノーコードで即結果が欲しい人:ThunderbitまたはDataMinerがおすすめ。ThunderbitはAIで多ページやサブページの構造化データ取得に強く、DataMinerはブラウザ上で手軽に使えます。

- ビジュアルワークフローやクラウド実行が必要な人:Octoparseが最適。複雑なサイトや定期実行にも対応。

- 動的・JavaScript多用サイトのスクレイピング:ParseHubのデスクトップ型が便利。IT初心者にもおすすめ。

- 開発者がいてフルカスタマイズしたい場合:Scrapyが大規模・複雑案件に最適。

- AIで大規模・エンタープライズデータが必要な場合:Diffbotなら手間なく構造化データと巨大な知識グラフが手に入ります。

まずは無料トライアルや無料枠から始めて、自分のスキル・データ量・業務フローに合うツールを試してみましょう。いろいろ試してみるのが成功の近道です。

まとめ:最適なスクリーンスクレイピングツールでデータ収集を加速

スクリーンスクレイピングツールは、昔はエンジニア向けのニッチな存在でしたが、今やビジネスの生産性を大きく高める必須ツールになりました。営業リードの獲得、価格調査、不動産リストの収集など、どんな業種でもウェブを「自分専用のデータベース」として活用できます。大事なのは、チームのスキルやビジネス目標に合ったツールを選ぶこと。実際に「使い続けられる」ツールこそが、あなたにとってのベストな選択肢です。

もうコピペ作業に悩まされるのは終わりにしませんか?するか、今回紹介した他のツールもぜひ試してみてください。さらに詳しいノウハウやチュートリアルはでもチェックできます。

よくある質問(FAQ)

1. スクリーンスクレイピングツールって何?どうやって動くの?

スクリーンスクレイピングツールは、ウェブサイトからデータを自動で抽出するためのツール。手作業で情報をコピペする代わりに、欲しいデータを選んでExcelやCSVなどの構造化データとして出力できます。AIやビジュアルワークフローを活用し、エンジニアじゃなくても簡単に使えるものも増えています。

2. どんな人がスクリーンスクレイピングツールを使うべき?

効率的にウェブデータを集めたい営業、마케터、不動産エージェント、リサーチャー、業務担当者など。リードリスト作成、競合調査、リスト集約など、時間短縮とミス削減に役立ちます。

3. ノーコードとコードベースのスクレイピングツールの違いは?

ノーコードツール(Thunderbit、Octoparse、ParseHub、DataMinerなど)は、直感的な操作で非エンジニア向け。コードベース(Scrapyなど)はプログラミングが必要ですが、柔軟性と拡張性が高く、複雑な案件に向いています。

4. スクリーンスクレイピングツールの利用は合法?

公開データの取得は合法ですが、各ウェブサイトの利用規約やプライバシー法は必ず守りましょう。個人情報の無断取得や過剰なアクセスはNGです。

5. 自分に合ったスクリーンスクレイピングツールの選び方は?

技術スキル、データ量、対象サイトの複雑さ、エクスポート先、予算などを考慮しましょう。まずは無料トライアルで実際に使い、直感的に使いやすく、求める結果が得られるツールを選ぶのがポイントです。

ウェブデータの力を活用したい人は、ぜひこれらのツールを試してみてください。きっと業務効率が大きくアップします。