ウェブは今や世界最大のデータの宝庫で、みんながその中から最高の“砂の城”を作ろうと奮闘してるよね。営業やEC、リサーチ、そして僕みたいなデータ好きまで、ウェブスクレイピングは賢い意思決定や業務効率化の“隠れた必殺技”みたいな存在。2025年には、テック大手だけじゃなくて、がデータドリブンな意思決定を命綱にしてるんだ。その中心にいるのがPython。ウェブスクレイピング用のライブラリやツールがめちゃくちゃ充実してて、この変化を支えてる。

SaaSや自動化の現場で長くやってきた僕だけど、Pythonのウェブスクレイピングツールをうまく使えば、何時間もかかる作業が2分で終わるのを何度も見てきた。でも、選択肢が多すぎて、昔ながらのライブラリからブラウザ自動化、ノーコード、AI搭載ツールまで色々あって迷う人も多いはず。この記事では、初心者向けの定番からみたいな最新AIソリューションまで、自動化に最適なPythonウェブスクレイピングライブラリ12選を徹底的に紹介するよ。開発者もオペレーション担当も、「とにかくデータが欲しい!」ってビジネスユーザーも、きっと役立つ情報が見つかるはず。

なぜPythonウェブスクレイピングツール選びが大事なのか

正直、すべてのウェブスクレイピング案件が同じ難易度ってわけじゃない。どのツールを選ぶかで、スムーズに自動化できるか、壊れたスクリプトのデバッグで1週間消耗するかが決まる。例えば、ある人材紹介会社はリードスクレイピングを自動化して3ヶ月で売上10倍、営業1人あたり週8時間の工数削減、数千件の新規リード獲得を実現したんだ()。逆に、動的コンテンツに対応できないライブラリを選んで、何日も無駄にしたチームも見てきた。

ツール選びが大事な理由はこんな感じ:

- ビジネスインパクト: いいツールを使えば、リード獲得、価格監視、競合分析、業務自動化などが実現できて、営業・EC・リサーチ分野で大きな武器になる()。

- 静的 vs 動的データ: シンプルなHTMLサイトもあれば、JavaScriptで作られた複雑なサイトも。動的コンテンツに対応できないと、肝心なデータを取りこぼすことも。

- スケールと信頼性: 数ページだけならどんなツールでもOKだけど、毎日数千ページをクロールするならScrapyやクラウド型フレームワークが必要。

プロの裏ワザ: してる。例えば、静的ページはBeautiful Soup、動的ページはSeleniumって組み合わせが定番。最適な組み合わせが、あなたの“秘密兵器”になるよ。

Pythonウェブスクレイピングライブラリの評価ポイント

たくさんあるライブラリやプラットフォームの中から、ビジネスと技術の両面で本当に大事なポイントだけに絞って評価したよ:

- 使いやすさ: プログラミング未経験でも使える?APIは直感的?ビジュアル/ノーコード対応ならさらに高評価。

- 自動化・拡張性: 複数ページのクロールやスケジューリング、大量データに対応できる?クラウドやオンプレミスで動く?

- 動的コンテンツ対応: JavaScriptで生成されるページや無限スクロール、ログイン後のデータも取れる?

- 連携・エクスポート: Excel、Googleスプレッドシート、データベース、ワークフローへの連携が簡単?

- コミュニティ・保守性: 開発が活発?チュートリアルやサポートが充実してる?

- コスト: 無料・オープンソースか有料か?チームやビジネスでのコスパは?

実際にツールを触って、ユーザーレビューや事例も調べたよ。それじゃあ、厳選12選を紹介!

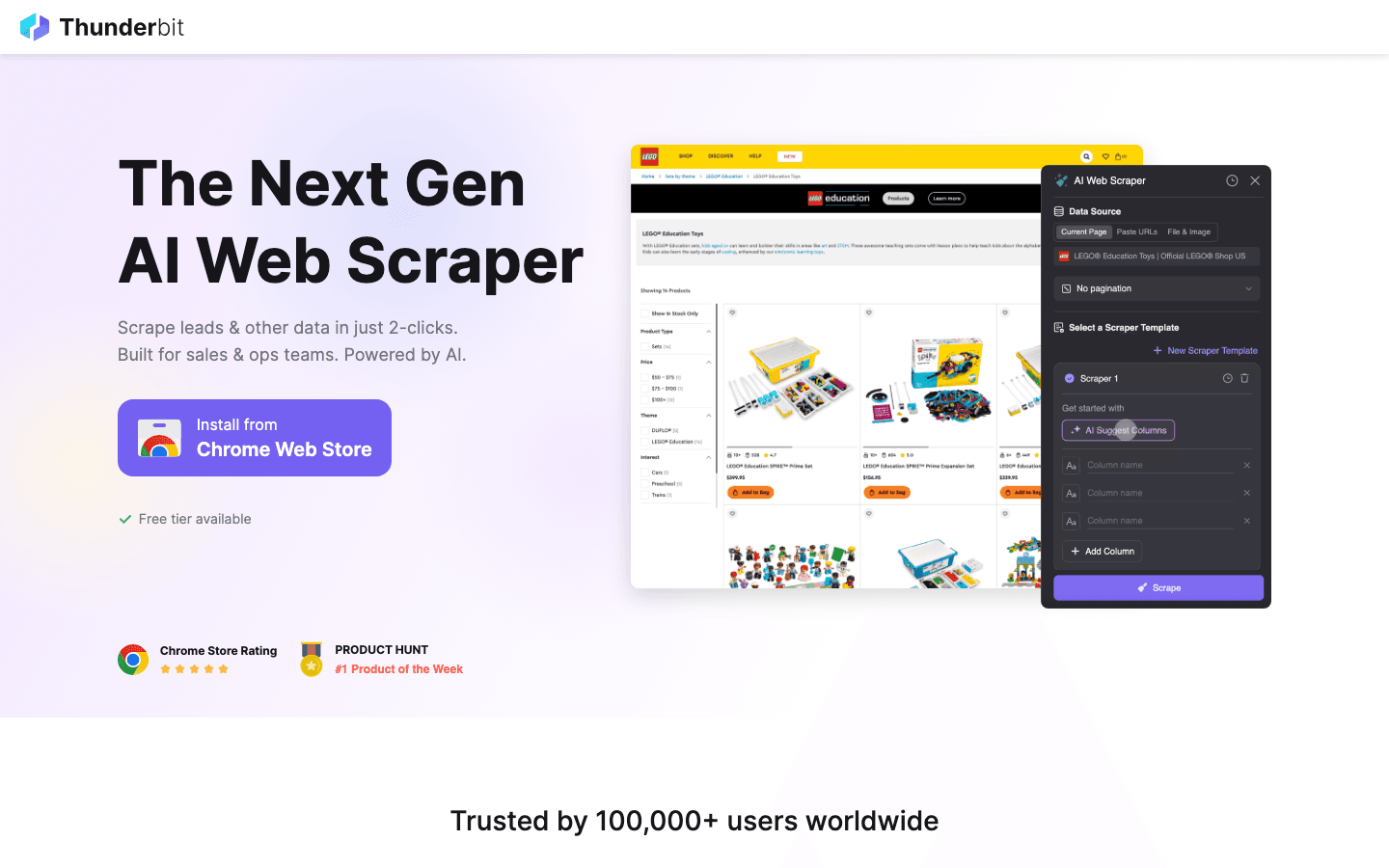

1. Thunderbit

は、手間なくウェブスクレイピングしたい人にぴったりのAI 웹 스크래퍼。 で、どんなウェブサイトでも2クリックでデータ抽出OK。コードもテンプレートも不要で、ストレスフリー。

は、手間なくウェブスクレイピングしたい人にぴったりのAI 웹 스크래퍼。 で、どんなウェブサイトでも2クリックでデータ抽出OK。コードもテンプレートも不要で、ストレスフリー。

おすすめポイント: Thunderbitは営業、オペレーション、EC、不動産など、スピーディーにデータが欲しいビジネスユーザー向けに設計されてる。「AIでフィールドを提案」を押すと、AIがページを解析して抽出項目を自動で選んでくれる。「スクレイプ」ボタンを押すだけで、サブページやページネーション、動的コンテンツ、オンラインフォームの自動入力まで対応。Excel、Googleスプレッドシート、Airtable、Notionへのエクスポートも無料。

主な特徴:

- AIによるフィールド自動提案: ページ内容をAIが解析して、名前・価格・メールアドレスなど抽出項目を自動で提案。

- サブページ自動取得: 商品詳細や問い合わせページなど、サブページも自動で巡回してデータを拡充。

- 即時テンプレート: Amazon、Zillow、Instagramなど主要サイトはテンプレートを選ぶだけ。

- クラウド/ブラウザ両対応: 最大50ページをクラウドで一括取得、ログインが必要なサイトはブラウザで対応。

- データエクスポート無料: 取得データのエクスポートに追加料金なし。

おすすめ対象: 非エンジニアのチーム、営業・EC担当、スピード重視の人。

注意点: Pythonライブラリじゃないから、Pythonコードに直接組み込む場合はデータのエクスポート・インポートが必要。でも、ほとんどのビジネス用途なら十分な機能。

使い方はやでチェックできるよ。

2. Beautiful Soup

は、HTMLやXMLの解析に特化したPythonの定番ライブラリ。僕が初めて使ったウェブスクレイピングツールでもあって、今でも初心者には一番おすすめ。

は、HTMLやXMLの解析に特化したPythonの定番ライブラリ。僕が初めて使ったウェブスクレイピングツールでもあって、今でも初心者には一番おすすめ。

おすすめ理由: シンプルで柔軟、ちょっとしたプロジェクトに最適。Requestsでページを取得して、Beautiful SoupでHTMLを解析、直感的なAPIでデータ抽出できる。崩れたHTMLにも強いのが特徴。

おすすめ対象: 小〜中規模プロジェクト、データクレンジング、スクレイピング学習者。

注意点: JavaScriptで生成される動的コンテンツには非対応。必要ならSeleniumなどと組み合わせて使おう。

3. Scrapy

は、大規模な自動ウェブクローリングに特化したPythonフレームワーク。数千〜数百万ページのクロールやデータパイプライン、定期実行が必要なときに最適。

は、大規模な自動ウェブクローリングに特化したPythonフレームワーク。数千〜数百万ページのクロールやデータパイプライン、定期実行が必要なときに最適。

強み: 非同期処理で高速かつスケーラブル。クローラー(スパイダー)を定義して、リンク追跡やページネーション、データ処理も柔軟に設計できる。多くの企業スクレイピング案件の基盤になってる。

おすすめ対象: 本格的なクローラー構築、複数ページ・複数サイトの自動化、プロダクション用途。

注意点: Beautiful Soupより学習コストは高め。標準ではJavaScript非対応だけど、SplashやSeleniumと連携できる。

4. Selenium

は、PythonからChromeやFirefoxなどのブラウザを自動操作できるツール。動的コンテンツや複雑な操作が必要なサイトのスクレイピングには欠かせない。

は、PythonからChromeやFirefoxなどのブラウザを自動操作できるツール。動的コンテンツや複雑な操作が必要なサイトのスクレイピングには欠かせない。

必須理由: ユーザーのクリックやフォーム送信、スクロールなどを自動化して、実際のブラウザで表示される内容をそのまま取得できる。

おすすめ対象: JavaScriptで動的に生成されるサイト、ログイン後のデータ取得、無限スクロール対応など。

注意点: HTTPライブラリに比べて動作が重いから、数千ページ規模の大量取得には向いてない。

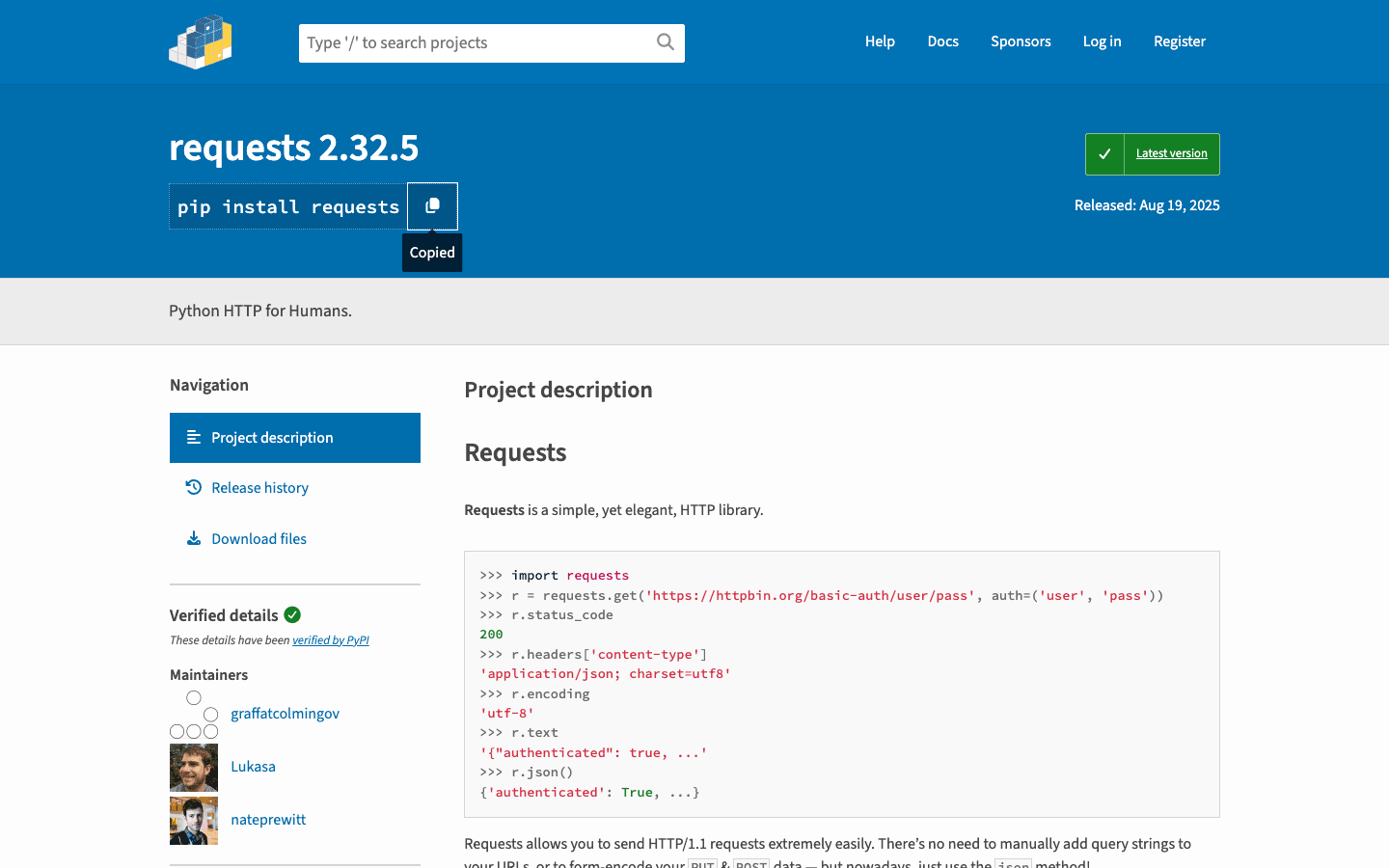

5. Requests

は「人間のためのHTTP」ライブラリ。Pythonスクレイピングの基礎で、ページ取得やフォーム送信、Cookie管理などに使われる。

は「人間のためのHTTP」ライブラリ。Pythonスクレイピングの基礎で、ページ取得やフォーム送信、Cookie管理などに使われる。

定番理由: シンプルなAPIで信頼性抜群。Beautiful Soupやlxmlと組み合わせても最適。静的サイトやAPI取得におすすめ。

おすすめ対象: 静的HTMLの取得、API呼び出し、カスタムスクレイパーの基盤。

注意点: JavaScriptで生成されるコンテンツには非対応。動的サイトにはSeleniumなどと併用しよう。

6. LXML

は、高速なHTML・XMLパーサー。強力なXPathやCSSセレクタが使えて、大規模データの解析にも最適。

は、高速なHTML・XMLパーサー。強力なXPathやCSSセレクタが使えて、大規模データの解析にも最適。

人気の理由: 大きなページや複雑なクエリが必要なときに最適。Scrapyの内部でも使われてる。

おすすめ対象: パフォーマンス重視、大規模データセット、XPathによる高度な抽出。

注意点: 学習コストやインストールがちょっと難しい場合も。

7. PySpider

は、ウェブUI付きのPythonスクレイピングフレームワーク。Scrapyに似てるけど、ダッシュボードでジョブ管理やスケジューリング、進捗確認ができる。

は、ウェブUI付きのPythonスクレイピングフレームワーク。Scrapyに似てるけど、ダッシュボードでジョブ管理やスケジューリング、進捗確認ができる。

独自性: Pythonでスパイダーを書いて、スケジューリングや結果確認もブラウザからできる。複数案件を管理したいチームにぴったり。

おすすめ対象: 複数プロジェクトの管理、定期クロール、ビジュアル管理が必要なチーム。

注意点: Scrapyほど開発は活発じゃなくて、最新のJavaScriptサイト対応は限定的。

8. MechanicalSoup

は、シンプルなブラウザ操作を自動化できる軽量Pythonライブラリ。Seleniumほど重くなくて、フォーム入力やリンク遷移ができる。

は、シンプルなブラウザ操作を自動化できる軽量Pythonライブラリ。Seleniumほど重くなくて、フォーム入力やリンク遷移ができる。

便利な理由: RequestsとBeautiful Soupを組み合わせてて、ログインやフォーム送信、遷移後のページ取得が簡単。

おすすめ対象: ログイン自動化、フォーム送信、JavaScript不要なシンプルなワークフロー。

注意点: JavaScriptが多いサイトや複雑な操作には非対応。

9. Octoparse

は、ノーコードで使えるウェブスクレイピングツール。ドラッグ&ドロップの直感的なUIで、プログラミング不要。

は、ノーコードで使えるウェブスクレイピングツール。ドラッグ&ドロップの直感的なUIで、プログラミング不要。

人気の理由: ページネーションや動的コンテンツ、クラウドでの定期実行にも対応。主要サイト向けのテンプレートも豊富で、ExcelやCSV、Googleスプレッドシートへのエクスポートも簡単。

おすすめ対象: 非エンジニア、マーケットリサーチ、リード獲得、スピード重視のチーム。

注意点: 無料プランは機能制限あり。高度な機能は有料(月額約75ドル〜)。

10. ParseHub

は、サイトをクリックしながら複雑なワークフローを作れるビジュアル型スクレイパー。動的サイトや条件分岐、クラウドでの定期実行にも強い。

は、サイトをクリックしながら複雑なワークフローを作れるビジュアル型スクレイパー。動的サイトや条件分岐、クラウドでの定期実行にも強い。

注目ポイント: 条件分岐や多段階ワークフローに対応して、ポップアップやタブ、隠れたデータの取得も得意。

おすすめ対象: コーディング不要で複雑・動的なサイトをスクレイピングしたい人、定期データ収集。

注意点: 無料プランは制限あり。大量データ取得には有料プランが必要。

11. Colly

は、Go言語で書かれた高速ウェブスクレイピングフレームワーク。Pythonじゃないけど、圧倒的なパフォーマンスで一部Pythonチームもマイクロサービスとして使ってる。

は、Go言語で書かれた高速ウェブスクレイピングフレームワーク。Pythonじゃないけど、圧倒的なパフォーマンスで一部Pythonチームもマイクロサービスとして使ってる。

注目理由: Collyは最小限のメモリで1秒間に数千ページを取得可能。大規模クロールやGoとの連携に最適。

おすすめ対象: 高速・並列処理が必要なエンジニアチーム、GoベースのクローラーをPythonワークフローに統合したい場合。

注意点: Goの知識が必要。Pythonライブラリじゃない。

12. Portia

は、Scrapinghub(現Zyte)発のオープンソースビジュアルスクレイパー。ブラウザ上で要素をクリックしてScrapyスパイダーを作れる。

は、Scrapinghub(現Zyte)発のオープンソースビジュアルスクレイパー。ブラウザ上で要素をクリックしてScrapyスパイダーを作れる。

おすすめ理由: コーディング不要でScrapyの強力な機能を活用できる。抽出ルールをビジュアルで定義して、ScrapyやZyteクラウドで実行できる。

おすすめ対象: データチームの非エンジニア、Scrapyスパイダーのプロトタイピング。

注意点: 開発はやや停滞気味。動的・インタラクティブなサイトには弱い。

一目で分かる!Pythonウェブスクレイピングライブラリ比較表

| ツール/ライブラリ | 使いやすさ | 動的コンテンツ対応 | 自動化・拡張性 | おすすめ用途 | 価格 |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | 非エンジニア、ビジネスユーザー、即効性重視 | 無料+クレジット |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | 初心者、静的ページ、データクレンジング | 無料 |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | 開発者、大規模クロール | 無料 |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | 動的サイト、ブラウザ自動化 | 無料 |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | 静的HTML、API、簡易スクリプト | 無料 |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | パフォーマンス、大規模データ、XPath | 無料 |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | チーム、定期クロール、ウェブUI | 無料 |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | フォーム自動化、ログイン、簡易ワークフロー | 無料 |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | ノーコード、ビジネスユーザー、定期取得 | 無料+有料 |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | ノーコード、複雑・動的サイト | 無料+有料 |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | 高速、クロスプラットフォーム、Go連携 | 無料 |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | ビジュアルScrapyスパイダー、非エンジニア | 無料 |

ビジネス用途別 Pythonウェブスクレイピングツールの選び方

どのツールを選ぶか迷ったら、下の早見表を参考にしてみて:

- 非エンジニア・ビジネスユーザー: 、、がオススメ。直感的でサクッと結果が出るよ。

- 開発者・大規模案件: やでガッチリしたクローラーを作ろう。

- 動的/JavaScriptサイト: やブラウザ自動化対応のビジュアルツールが活躍。

- 静的ページのクイック取得: +が最速の入門ルート。

- パフォーマンス重視・クロスプラットフォーム: をGoマイクロサービスとして活用、Pythonと組み合わせるのもアリ。

- Scrapyのビジュアルプロトタイピング: は非エンジニアと開発者の橋渡しに最適。

アドバイス: まずは自分の用途に合った一番シンプルなツールから始めてみて。迷ったらで気軽に体験、スケールが必要ならScrapyプロジェクトを立ち上げてみよう。

大事なのは、「必要なデータを、確実かつ効率的に、ストレスなく手に入れる」こと!

よくある質問(FAQ)

1. なぜPythonはウェブスクレイピングで人気なの?

Pythonはシンプルな文法、豊富なライブラリ、活発なコミュニティが魅力。)してて、初心者からプロまで幅広く使われてる。

2. 動的(JavaScript)サイトに最適なPythonライブラリは?

動的サイトにはが定番。実際のブラウザを操作できるから、JavaScriptで生成されるページも取得できる。ノーコードなら、、もおすすめ。

3. ScrapyとBeautiful Soup、どっちを選ぶべき?

は手軽な案件や学習用に最適。は大規模・自動化・複数ページ対応が必要なときにおすすめ。

4. ThunderbitはPythonワークフローと連携できる?

もちろんOK。で取得したデータはCSV、Excel、Googleスプレッドシート形式でエクスポートできて、Pythonスクリプトでの分析や追加処理に使える。

5. 開発者じゃなくても簡単にウェブスクレイピングを始める方法は?

、、など、ノーコードで使えるツールがオススメ。詳しいガイドやヒントはもチェックしてみて。

快適なスクレイピングライフを!データがいつもクリーンで構造化されて、ワンクリックで手に入りますように。

さらに詳しく知りたい人はこちらもどうぞ