2026년의 웹 스크래핑 세상은 아침 7시에 북적이는 농수산물 시장과도 비슷해요. 모두가 신선한 데이터를 찾으려고 몰려들고, 좋은 도구만 있으면 붐비기 전에 원하는 걸 빠르게 챙길 수 있죠. 영업 리드 확보부터 경쟁사 분석까지, 비즈니스의 거의 모든 장면에서 스크래핑 데이터가 쓰이고 있는 요즘, Python 웹 스크래핑 라이브러리 선택은 단순한 기술적 선택이 아니라 전략적인 결정이 되어버렸어요. 워낙 선택지가 많다 보니 ‘궁극의 가이드’도 넘쳐나고, 뭘 골라야 할지 헷갈리는 것도 당연하죠.

SaaS랑 자동화 현장에서 오래 일해온 제 경험상, 제대로 된 Python 웹 스크래핑 툴만 잘 쓰면 일주일 걸릴 작업도 반나절이면 끝낼 수 있습니다. 개발자로서 탄탄한 파이프라인을 만들고 싶은 분도, 스프레드시트에 깔끔하게 데이터만 넣고 싶은 비즈니스 유저도, 2026년에 추천할 만한 Python 웹 스크래핑 라이브러리 12가지와, 노코드로 쓸 수 있는 AI 기반 신상 툴까지 한 번에 정리해봤어요.

왜 Python 웹 스크래핑 라이브러리 선택이 중요한가

웹 스크래핑은 단순히 데이터만 긁어오는 게 아니에요. “필요한 데이터를, 적당한 속도로, 스트레스 없이” 가져오는 게 핵심이죠. 2026년에는 미국 기업의 이 영업, 시장조사, 업무 자동화를 위해 웹 스크래핑을 도입했고, 하루에 크롤링되는 페이지 수가 에 달합니다. 잘못된 툴을 고르면 기회를 놓치거나, 스크립트가 망가지거나, 디버깅에 몇 시간씩 날릴 수도 있어요.

Python 웹 스크래핑 툴을 고를 때 꼭 봐야 할 포인트는 아래와 같아요:

- 성능: 대용량 작업도 거뜬한가?

- 사용 편의성: 코딩에 시간 뺏기지 않고 바로 결과 볼 수 있나?

- 브라우저/JavaScript 지원: 최신 동적 사이트도 문제없나?

- 확장성: 나중에 요구사항이 늘어나도 커버 가능한가?

- 연동성: 기존 데이터 파이프라인이나 업무 플로우에 쉽게 붙일 수 있나?

주요 비즈니스 용도로는 리드 확보, 가격 모니터링, 경쟁사 분석, 귀찮은 데이터 입력 자동화 등이 있어요. 제대로 된 라이브러리만 골라도 영업팀이 한발 앞서 나갈 수 있습니다.

Python 웹 스크래핑 라이브러리 평가 기준

이번 글에서는 각 라이브러리를 아래 기준으로 평가했어요:

- 성능/확장성: 대형·복잡 사이트도 문제없는지

- 사용 편의성: 초보도 쓸 수 있는지, 고급자용인지

- 브라우저/JavaScript 지원: 동적 콘텐츠나 최신 웹앱에 강한지

- 보안/유지보수: 안전하고 개발이 활발한지

- 커뮤니티/지원: 문서, 튜토리얼, 질문할 곳이 있는지

- 연동성: Thunderbit 같은 AI 솔루션이나 다른 툴과 조합 가능한지

실제 비즈니스 현장에서의 실용성도 중요하게 봤어요. 결국 코드를 짜서 얼마나 가치 있는 데이터를 뽑아내느냐가 관건이니까요.

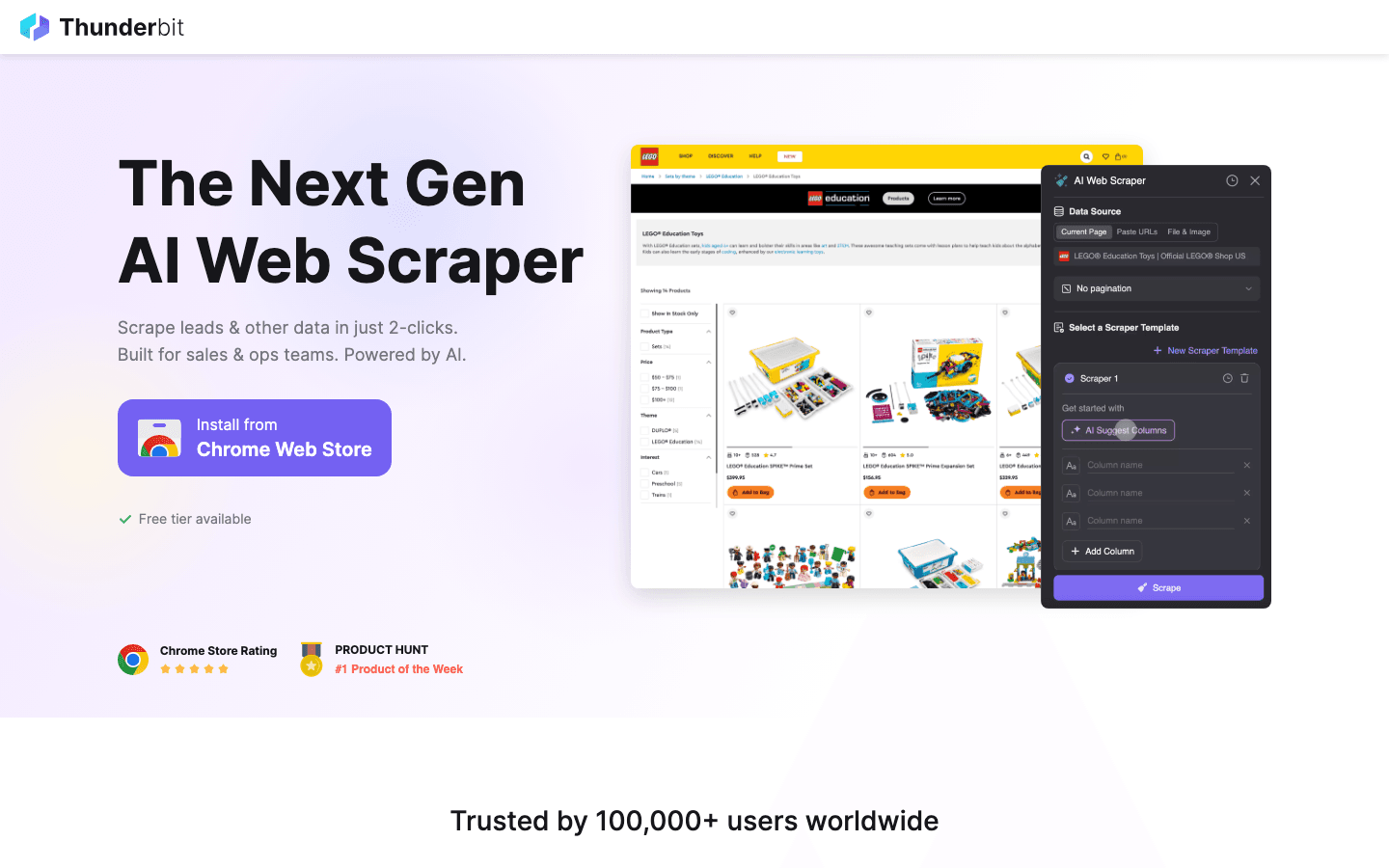

1. Thunderbit

은 기존 Python 라이브러리와 달리, 입니다. 2026년에는 비즈니스 유저와 개발자 모두의 웹 스크래핑 상식을 완전히 바꿔놓은 존재로 주목받고 있어요.

은 기존 Python 라이브러리와 달리, 입니다. 2026년에는 비즈니스 유저와 개발자 모두의 웹 스크래핑 상식을 완전히 바꿔놓은 존재로 주목받고 있어요.

주요 특징:

- AI 필드 추천: 원하는 데이터를 설명만 하면 AI가 자동으로 컬럼과 데이터 타입을 잡아줌

- 서브페이지 자동 추출: 상품 상세, LinkedIn 프로필 등 하위 페이지도 자동으로 순회·수집

- 즉시 템플릿: Amazon, Zillow, Shopify 등 인기 사이트는 원클릭 추출

- 무료 데이터 내보내기: Excel, Google Sheets, Airtable, Notion, CSV, JSON 등 추가 비용 없이 내보내기

- 노코드 워크플로우: 비개발자도 OK. Python 툴과 연동도 가능

추천 용도: 영업 리드, 이커머스 가격 모니터링, 부동산 리스트, 업무 자동화 등 구조화 데이터가 바로 필요한 상황

장점:

- 코딩 필요 없음. 직관적으로 데이터 수집

- AI가 사이트 구조 변화에도 유연하게 대응

- 복잡하고 비정형 웹 데이터도 쉽게 처리

- Scrapy, Beautiful Soup 등 Python 라이브러리와 조합 활용 가능

단점:

- 순수 Python 라이브러리는 아님 (Python 파이프라인 연동은 가능)

- 코드 기반 스크래핑 보조나 비즈니스 유저에게 특히 적합

활용 팁: Thunderbit로 빠르게 프로토타입이나 단발성 데이터 수집을 하고, 대규모 자동화는 내보낸 데이터를 Python 스크립트로 추가 가공하는 게 좋아요.

2. Beautiful Soup

은 HTML, XML 파싱·조작에 특화된 Python 라이브러리입니다. 망가진 마크업이나 복잡한 페이지 정리에 강하고, 초보부터 고수까지 두루 사랑받고 있어요.

은 HTML, XML 파싱·조작에 특화된 Python 라이브러리입니다. 망가진 마크업이나 복잡한 페이지 정리에 강하고, 초보부터 고수까지 두루 사랑받고 있어요.

주요 특징:

- 직관적인 문법으로 HTML/XML 검색·조작 가능

- 불완전한 마크업도 유연하게 처리

- 와 조합해 페이지 가져오기 쉬움

추천 용도: 소~중규모 페이지 스크래핑, 데이터 정제

장점:

- 배우기 쉽고 바로 쓸 수 있음

- 지저분한 HTML 정리에 최적

- 유연하고 관대한 설계

단점:

- 대용량 문서에서는 보다 느림

- JavaScript 처리는 불가

활용 팁: 속도 올리고 싶으면 lxml 파서와 같이 쓰세요. 동적 사이트는 Selenium이나 Pyppeteer랑 조합도 좋아요.

3. Selenium

은 브라우저 자동화의 대표주자. Chrome, Firefox 등 주요 브라우저를 마음대로 조작할 수 있고, JavaScript가 많은 동적 사이트 스크래핑에 딱입니다.

은 브라우저 자동화의 대표주자. Chrome, Firefox 등 주요 브라우저를 마음대로 조작할 수 있고, JavaScript가 많은 동적 사이트 스크래핑에 딱입니다.

주요 특징:

- 실제 브라우저(Chrome, Firefox 등) 자동 조작

- 헤드리스 모드 지원으로 빠르고 리소스 절약

- 폼 입력, 버튼 클릭 등 사용자 액션도 재현

추천 용도: 로그인, 클릭 등 액션이 필요한 사이트, JavaScript가 많은 페이지

장점:

- 어떤 동적 사이트도 커버

- 여러 브라우저·플랫폼 지원

- 테스트 자동화와 스크래핑을 한 번에

단점:

- 헤드리스 전용 툴보다 느림

- 리소스 소모 큼

- 사이트 구조 변화에 약할 때도

활용 팁: 다른 방법이 안 통할 때 최후의 수단으로 활용. 대량 데이터·고속 처리엔 Scrapy나 Pyppeteer도 고려해보세요.

4. Requests

는 Python에서 HTTP 요청을 쉽게 보낼 수 있는 필수 라이브러리. 많은 스크래핑 워크플로우의 기본이죠.

는 Python에서 HTTP 요청을 쉽게 보낼 수 있는 필수 라이브러리. 많은 스크래핑 워크플로우의 기본이죠.

주요 특징:

- 심플하고 직관적인 API

- 쿠키, 세션, 인증도 쉽게 처리

- Beautiful Soup, LXML과 연동도 부드러움

추천 용도: 정적 페이지, API 수집, 커스텀 스크래퍼의 기본 구성

장점:

- 정말 쓰기 쉬움

- 안정적이고 유지보수도 잘됨

- 프로토타입, 간단 스크립트에 최적

단점:

- HTML 파싱 기능 없음

- JavaScript 렌더링 불가

활용 팁: Beautiful Soup, LXML과 조합해 가벼운 스크래핑 스택을 만들어보세요.

5. LXML

은 HTML/XML 파싱의 속도에 특화된 라이브러리. 대용량 문서나 복잡한 XPath 쿼리 처리에 강합니다.

은 HTML/XML 파싱의 속도에 특화된 라이브러리. 대용량 문서나 복잡한 XPath 쿼리 처리에 강합니다.

주요 특징:

- C언어 기반의 초고속 파서

- XPath, CSS 셀렉터 완벽 지원

- HTML, XML 모두 지원

추천 용도: 대용량 데이터 분석, 복잡한 문서 구조 처리, 속도 중시 프로젝트

장점:

- 대량 데이터도 빠르게 처리

- 강력한 셀렉터 기능

- 에러 처리도 튼튼

단점:

- 불완전한 HTML엔 다소 약함

- 배우는 데 약간 시간 필요

활용 팁: Beautiful Soup 파서로 LXML을 지정하면, 편의성과 성능을 모두 잡을 수 있어요.

6. Pyppeteer

는 Puppeteer의 Python 버전. 헤드리스 Chrome을 자유자재로 다루며, JavaScript가 많은 최신 웹앱 스크래핑에 강력합니다.

는 Puppeteer의 Python 버전. 헤드리스 Chrome을 자유자재로 다루며, JavaScript가 많은 최신 웹앱 스크래핑에 강력합니다.

주요 특징:

- 헤드리스 Chrome/Chromium 완전 제어

- JavaScript 렌더링, 사용자 액션 자동화에 강함

- 복잡한 내비게이션, 스크린샷, PDF 생성도 가능

추천 용도: 최신 JavaScript 사이트, 사용자 플로우 자동화, 안티봇 우회

장점:

- JavaScript 지원력 최상

- 사람처럼 조작 가능

- SPA(싱글 페이지 앱) 스크래핑에 최적

단점:

- Requests, Scrapy보다 무겁고 느림

- 유지보수 상황 체크 필요

- 세팅이 다소 번거로움

활용 팁: Selenium이 안 통할 때 대안으로 좋아요. Thunderbit AI로 데이터 필드 정의하고, Pyppeteer로 내비게이션 담당하는 것도 추천!

7. Splash

는 JavaScript 렌더링에 특화된 경량 브라우저 엔진. Scrapy와 조합해 동적 사이트 대량 처리에 많이 써요.

는 JavaScript 렌더링에 특화된 경량 브라우저 엔진. Scrapy와 조합해 동적 사이트 대량 처리에 많이 써요.

주요 특징:

- 헤드리스 브라우저 + HTTP API

- JavaScript 렌더링 후 HTML, 스크린샷, HAR 파일 반환

- Scrapy 미들웨어 연동 가능

추천 용도: JavaScript 페이지 일괄 처리, 대규모 스크래핑 파이프라인, 서버사이드 렌더링

장점:

- 대량 처리도 빠르고 효율적

- API 기반이라 통합 쉬움

- 풀 브라우저 자동화보다 저렴한 리소스

단점:

- Selenium, Pyppeteer만큼 인터랙티브하진 않음

- 세팅, 스크립트 작성에 약간 익숙함 필요

활용 팁: 동적 사이트 대량 스크래핑엔 Scrapy+Splash 조합이 최고입니다.

8. MechanicalSoup

은 웹 폼 자동 입력, 간단한 내비게이션에 특화된 경량 라이브러리. Requests, Beautiful Soup 위에 만들어졌어요.

은 웹 폼 자동 입력, 간단한 내비게이션에 특화된 경량 라이브러리. Requests, Beautiful Soup 위에 만들어졌어요.

주요 특징:

- 폼 제출, 페이지 이동 자동화

- 세션, 쿠키 관리도 간단

- 초보도 쓰기 쉬운 심플한 API

추천 용도: 로그인, 검색 폼 자동화, 정적/가벼운 동적 페이지 수집

장점:

- 세팅이 매우 간단

- 쿠키, 세션 관리 자동

- 간단한 로그인, 검색에 최적

단점:

- JavaScript 미지원

- 대형·고도 동적 사이트엔 부적합

활용 팁: 로그인은 MechanicalSoup, 데이터 수집은 Requests+Beautiful Soup로 나눠 쓰면 효율적이에요.

9. Twisted

는 Python의 이벤트 기반 네트워크 엔진. 직접적인 스크래퍼는 아니지만, 대규모·고속 커스텀 스크래핑 파이프라인의 기반으로 많이 활용돼요.

는 Python의 이벤트 기반 네트워크 엔진. 직접적인 스크래퍼는 아니지만, 대규모·고속 커스텀 스크래핑 파이프라인의 기반으로 많이 활용돼요.

주요 특징:

- HTTP, TCP 등 비동기 네트워크 통신 지원

- 수천 동시 접속도 스케일업 가능

- 커스텀 분산형 스크래핑 시스템 구축에 최적

추천 용도: 대량 데이터 커스텀 스크래퍼 구축, 다른 비동기 프레임워크와 연동

장점:

- 압도적 확장성

- 다양한 프로토콜 지원

- 고급자용 강력 툴

단점:

- 배우기 매우 어려움

- 일반 스크래핑엔 오버스펙

활용 팁: 수백만 페이지급 대규모 스크래핑이 필요하다면 Twisted를 배워보세요.

10. Scrapy

는 Python 웹 스크래핑의 만능 툴. 대규모·실전용으로 설계됐고, 비동기 구조로 수천 페이지 크롤링도 거뜬해요.

는 Python 웹 스크래핑의 만능 툴. 대규모·실전용으로 설계됐고, 비동기 구조로 수천 페이지 크롤링도 거뜬해요.

주요 특징:

- 비동기·이벤트 기반 엔진으로 고속 처리

- 파이프라인, 미들웨어, 데이터 내보내기(JSON, CSV, XML) 기본 탑재

- 크롤링, 파싱, 데이터 정제까지 한 번에 관리

- 프록시, 유저에이전트 등 확장도 다양

추천 용도: 기업급 대규모 스크래핑, 구조화 데이터 추출, 속도·신뢰성 중시 프로젝트

장점:

- 대량 처리도 엄청 빠름

- 커스터마이즈, 확장성 높음

- 커뮤니티, 문서도 풍부

단점:

- 초보에겐 약간 어렵다

- JavaScript 사이트 지원은 기본으론 제한적

활용 팁: JavaScript 렌더링엔 연동, AI 필드 감지·데이터 구조화엔 조합도 추천!

11. PyQuery

는 jQuery 스타일 셀렉터 문법을 Python에서 쓸 수 있는 라이브러리. jQuery에 익숙한 분들에겐 특히 편해요.

는 jQuery 스타일 셀렉터 문법을 Python에서 쓸 수 있는 라이브러리. jQuery에 익숙한 분들에겐 특히 편해요.

주요 특징:

- jQuery 느낌의 API로 HTML 조작

- lxml 기반의 빠른 처리

- CSS 셀렉터, DOM 조작 지원

추천 용도: jQuery 경험자, 프로토타이핑, 유연한 셀렉터가 필요한 프로젝트

장점:

- 빠르고 효율적

- jQuery 경험자에겐 직관적

- HTML 파싱·수정 모두 OK

단점:

- Beautiful Soup, LXML보다 커뮤니티 작음

- 불완전한 HTML 대응은 제한적

활용 팁: lxml의 파워를 살리면서 XPath보다 CSS 셀렉터가 편한 분께 추천!

12. Parsel

은 XPath, CSS 셀렉터로 HTML/XML 데이터 추출에 특화된 강력한 라이브러리. Scrapy의 파싱 엔진 핵심이기도 해요.

은 XPath, CSS 셀렉터로 HTML/XML 데이터 추출에 특화된 강력한 라이브러리. Scrapy의 파싱 엔진 핵심이기도 해요.

주요 특징:

- XPath, CSS 셀렉터 고급 지원

- 데이터 추출·정제를 위한 깔끔한 API

- 단독 또는 Scrapy 내에서 사용 가능

추천 용도: 복잡한 데이터 추출, 견고한 셀렉터 로직이 필요한 프로젝트, Scrapy 연동

장점:

- 유연하고 강력한 추출 기능

- 복잡한 페이지 구조도 커버

- 문서도 잘 돼 있고 유지보수 활발

단점:

- 셀렉터 지식 필요

- 풀 기능 스크래핑 프레임워크는 아니고, 파싱 컴포넌트로 최적

활용 팁: Scrapy 스파이더나 커스텀 파싱 스크립트에서 유용하게 써보세요.

비교표: Python 웹 스크래핑 툴 한눈에 보기

| 라이브러리 | 주요 특징 | 성능 | 사용 편의성 | JavaScript 지원 | 추천 용도 | 연동 옵션 |

|---|---|---|---|---|---|---|

| Thunderbit | AI 탑재·노코드·서브페이지 지원 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 있음(브라우저 기반) | 비즈니스 유저, 하이브리드 운용 | Excel, Sheets, Notion, Python |

| Beautiful Soup | HTML/XML 파싱·관대한 설계 | ⭐⭐ | ⭐⭐⭐⭐⭐ | 없음 | 데이터 정제, 소규모 작업 | Requests, LXML, Thunderbit |

| Selenium | 브라우저 자동화·동적 콘텐츠 지원 | ⭐⭐ | ⭐⭐ | 있음 | 동적 사이트, 사용자 액션 | Beautiful Soup, PyQuery |

| Requests | HTTP 요청·세션 관리 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 없음 | 정적 페이지·API 수집 | Beautiful Soup, LXML |

| LXML | 초고속 파싱·XPath·CSS 셀렉터 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 없음 | 대용량 문서·복잡 파싱 | Beautiful Soup, PyQuery |

| Pyppeteer | 헤드리스 Chrome·JS 렌더링 | ⭐⭐ | ⭐⭐ | 있음 | 최신 JS 사이트·SPA | Thunderbit, Pandas |

| Splash | JS 렌더링·API 기반 | ⭐⭐⭐ | ⭐⭐ | 있음 | JS 일괄 처리·파이프라인 | Scrapy, Thunderbit |

| MechanicalSoup | 폼 조작·내비게이션 | ⭐⭐ | ⭐⭐⭐⭐ | 없음 | 간단 폼·로그인 | Requests, Beautiful Soup |

| Twisted | 비동기 네트워크·커스텀 파이프라인 | ⭐⭐⭐⭐⭐ | ⭐ | 없음 | 대량·커스텀 스크래퍼 | Scrapy, 커스텀 프레임워크 |

| Scrapy | 고성능·비동기·파이프라인 | ⭐⭐⭐⭐⭐ | ⭐⭐ | 제한적(Splash 경유) | 기업급·구조화 데이터 | Splash, Parsel, Thunderbit |

| PyQuery | jQuery 스타일 셀렉터·고속 | ⭐⭐⭐ | ⭐⭐⭐⭐ | 없음 | jQuery 팬·고속 프로토타이핑 | LXML, Requests |

| Parsel | XPath/CSS 셀렉터·유연한 파싱 | ⭐⭐⭐⭐ | ⭐⭐⭐ | 없음 | 복잡 추출·Scrapy 유저 | Scrapy, 단독 사용 |

최적의 Python 웹 스크래핑 라이브러리 고르는 법

간단한 선택 플로우 정리해봤어요:

-

정적 페이지나 API만 수집하면?

Requests+Beautiful Soup 또는 LXML을 써보세요. -

대량 데이터를 빠르게 처리하고 싶다면?

Scrapy가 최고. 비동기 네트워크엔 Twisted도 고려. -

동적/JavaScript 사이트 스크래핑?

Selenium, Pyppeteer, 또는 Scrapy+Splash를 써보세요. -

jQuery 스타일 셀렉터가 익숙하다면?

PyQuery가 딱입니다. -

폼이나 로그인 자동화가 필요하다면?

MechanicalSoup이 쉽고 효과적이에요. -

코딩 없이 빠르게 세팅하고 싶다면?

Thunderbit로 자연어로 원하는 데이터만 지정하면, 구조화 데이터로 바로 내보낼 수 있어요. -

하이브리드 운용?

Thunderbit로 데이터 구조만 빠르게 만들고, Python 스크립트로 추가 가공하는 것도 추천!

툴 선택 체크리스트:

- 사이트 복잡도(정적/동적)

- 필요한 데이터 양

- 폼/로그인 필요 여부

- Python, 셀렉터 숙련도

- Excel, Sheets, Notion 등 업무 툴로 내보내기 필요성

- 지속적 유지보수 필요성

마무리: 2026년 Python 웹 스크래핑의 가능성

Python 웹 스크래핑은 그 어느 때보다 강력하고 친근해졌어요. Scrapy로 대규모 크롤링, Beautiful Soup으로 데이터 정제, Selenium·Pyppeteer로 JavaScript 대응, 노코드로 스프레드시트에 데이터 넣고 싶을 때도 최적의 툴이 다 준비돼 있죠.

진짜 노하우는 툴을 조합해서 쓰는 것! 각 Python 웹 스크래핑 라이브러리마다 강점이 다르고, AI 탑재 같은 솔루션을 더하면 작업 시간은 확 줄고, 실수도 줄고, 새로운 비즈니스 인사이트도 얻을 수 있습니다.

2026년, 승자는 가장 빠른 코더가 아니라 “최적의 툴을 골라 귀찮은 일은 자동화하고, 진짜 가치 있는 일에 집중하는 사람”입니다. 웹 데이터를 비즈니스 가치로 바꿔보세요!

자주 묻는 질문

1. 초보자에게 추천하는 Python 웹 스크래핑 라이브러리는?

Beautiful Soup은 문법이 쉽고 관대한 설계라 입문자에게 딱이에요. 코딩 없이 하려면 Thunderbit AI 노코드 버전도 추천!

2. 동적/JavaScript 사이트에 강한 Python 스크래핑 툴은?

Selenium, Pyppeteer, Splash가 동적 콘텐츠 수집에 강해요. 특히 Pyppeteer는 최신 JavaScript 앱에 최적.

3. Thunderbit와 Scrapy, Beautiful Soup 등 Python 라이브러리 병행 사용 가능?

물론이죠. Thunderbit로 구조화·내보낸 데이터를 원하는 Python 라이브러리로 추가 가공하면 됩니다.

4. 대용량 HTML 문서 파싱이 가장 빠른 Python 라이브러리는?

LXML이 일반적으로 가장 빠릅니다. XPath, CSS 셀렉터로 대용량 파싱에 최적.

5. Scrapy와 Selenium은 어떻게 구분해서 써야 하나요?

정적 사이트의 대규모·구조화 스크래핑엔 Scrapy, 동적 요소나 로그인, JavaScript 대응이 필요하면 Selenium을 쓰세요.

Thunderbit로 웹 스크래핑 효율을 극대화하고 싶다면 하고, 다른 가이드도 꼭 참고해보세요. 스크래핑, 재밌게 시작하세요!

더 알아보기