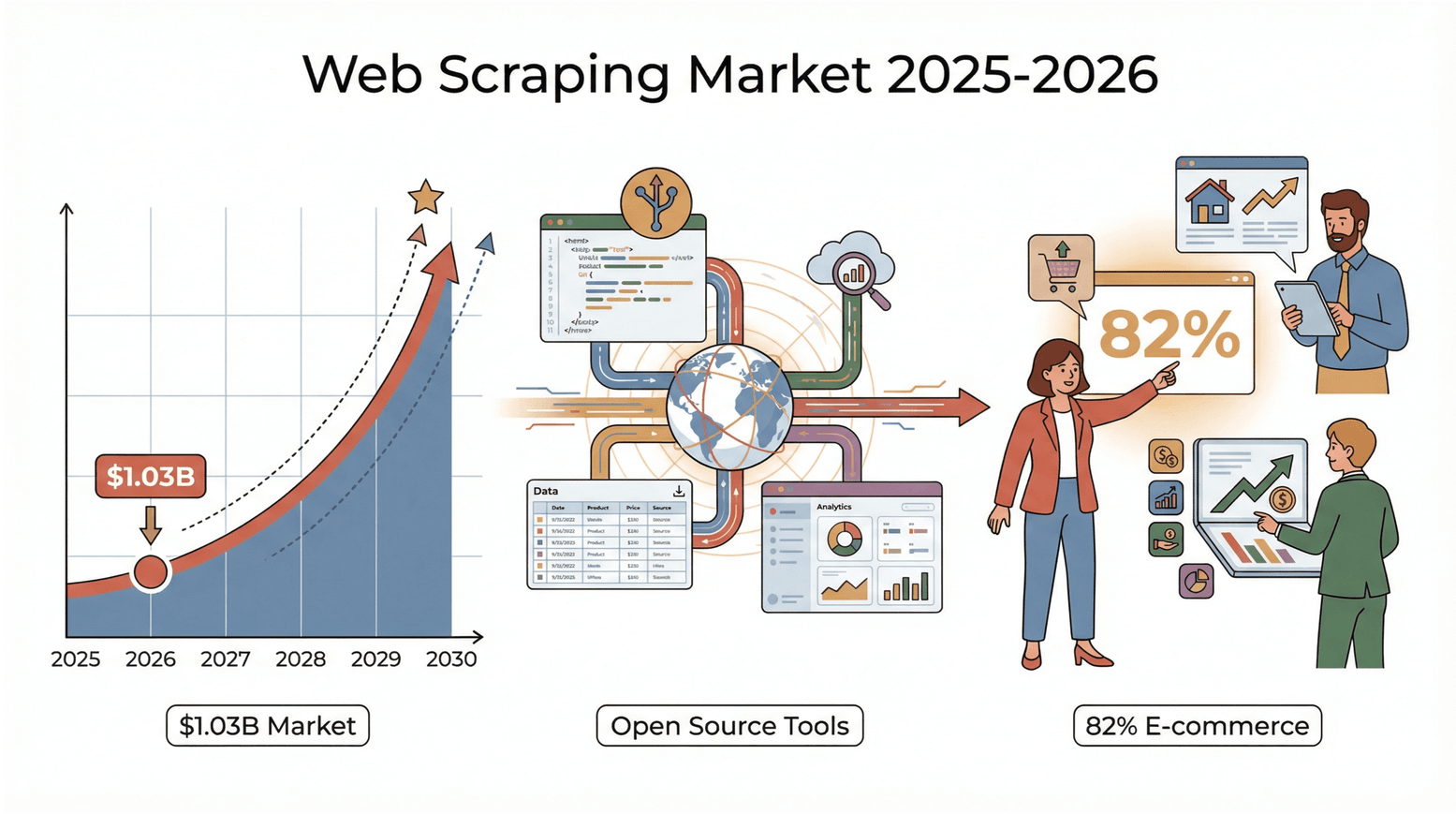

2026年の今、ネットの世界にはとんでもない量のデータが溢れていて、そのデータをどうやって価値ある情報に変えるかの競争は、かつてないほど激しくなっています。営業やEC、不動産業界はもちろん、データ好きな人なら「コピペ」だけじゃもう全然追いつかないって実感してるはず。実際、世界のウェブスクレイピング市場はに到達し、2030年にはその倍になる勢い。しかも使ってるのはIT大手だけじゃなくて、**EC企業の82%**や投資会社の3分の1以上が、リード獲得や価格調査、市場分析のためにウェブスクレイピングを活用してるんです()。つまり、ウェブスクレイピングツールを使わないのは、ビジネスチャンスや大事なヒントを自分から逃してるのと同じこと。

でも嬉しいことに、今はオープンソースのウェブスクレイピングツールがどんどん進化して、使いやすさもパワーもコミュニティのサポートもめちゃくちゃ充実してきてます。Pythonが得意なエンジニアも、JavaScript派も、「とにかくデータが欲しい!」ってビジネスユーザーも、自分にピッタリのツールがきっと見つかるはず。SaaSや自動化の現場で長年この分野を見てきた僕が、2025年に注目してほしいオープンソースウェブスクレイピングツール10選と、選び方のコツを紹介します。

なんでオープンソースのウェブスクレイピングツールがいいの?

オープンソースのウェブスクレイピングツールは、まさにデータ活用の万能アイテム。コストを抑えられる(ライセンス料ゼロ)、自分好みにカスタマイズできる、中身がオープンだから安心して使える。最大の魅力は、世界中の開発者やユーザーが集まる活発なコミュニティ。プラグインやチュートリアル、トラブル解決の知恵がどんどんシェアされてるから、困ったときも一人で悩まなくてOK()。

商用ツールと比べて、オープンソースは自分のペースで使えるのが強み。ベンダーの都合や値上げに振り回されず、ウェブサイトの仕様変更にも柔軟に対応できる。実は多くの商用スクレイピングサービスも、こうしたオープンソースエンジンをベースにしてるんです。だったら最初から「本家」を使うのも賢い選択!

ベストなオープンソースウェブスクレイピングツールの選び方

選択肢が多すぎて迷うけど、僕が重視してるポイントはこれ:

- 使いやすさ:プログラミング未経験でも始めやすい?ビジュアルやAI搭載のツールはある?

- 拡張性・スケーラビリティ:大規模案件にも耐えられる?

- 対応言語・プラットフォーム:Python、JavaScript、ブラウザ型、デスクトップ型など幅広く対応してる?

- コミュニティとメンテナンス:ちゃんと更新されてる?フォーラムやドキュメント、プラグインが充実してる?

- 独自機能:AIフィールド検出、サブページ対応、スケジューリング、クラウド連携など。

さらに、実際のビジネス現場での使い勝手やフィードバックも大事。結局、「自分の課題を解決できるか」が一番重要です。

2026年注目のオープンソースウェブスクレイピングツール5選

それじゃ、AI搭載の手軽なものから開発者向けの本格派まで、厳選したツールを紹介します。

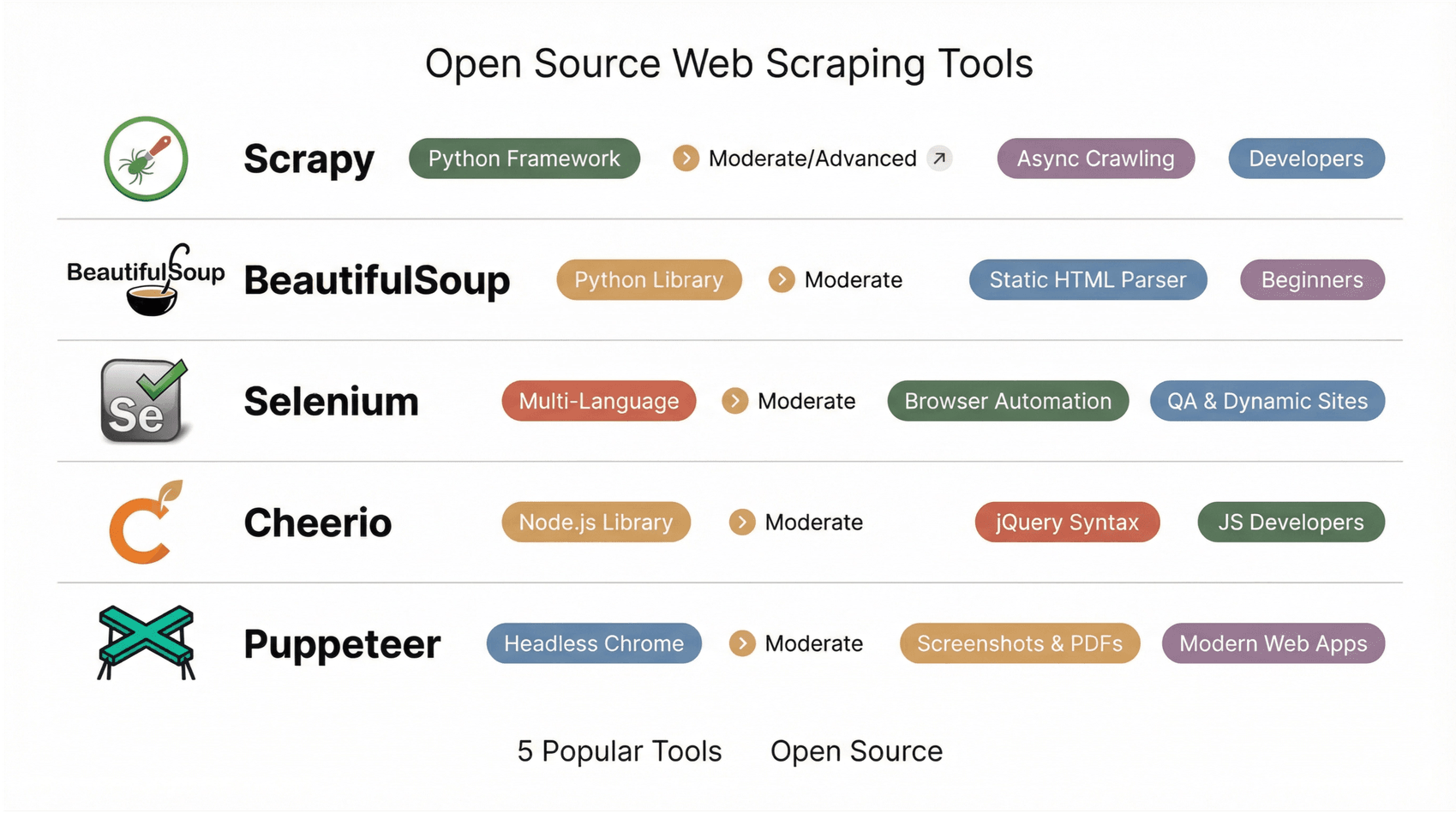

1. Scrapy

は、Pythonエンジニアにとって理想的なフレームワーク。大規模で柔軟なクローラーやデータパイプラインを作れるし、非同期ネットワーク処理で数千~数百万ページのクロールもサクサク。Pythonで「スパイダー」を定義すれば、キュー管理やスロットリング、JSON/CSV/XMLへのエクスポートも自動でやってくれる。

プラグインも豊富で、プロキシやクッキー管理、動的サイト向けのヘッドレスブラウザ連携もOK。ECサイト全体のクロールやニュース集約など、大規模案件にピッタリ。非エンジニアにはちょっとハードル高めだけど、パワーと柔軟性を求めるならScrapyは外せません()。

2. Beautiful Soup

は、PythonでサクッとHTMLを解析できる定番ライブラリ。初心者からプロまで幅広く愛用されてて、ちょっと崩れたHTMLでも柔軟にパースできるのが魅力。ページ取得(普通はrequestsを使う)後、Beautiful Soupで要素を簡単に抽出できる。

小規模プロジェクトやプロトタイプ、学習用途に最適。ただし、JavaScriptの実行はできないから、静的HTML専用。動的サイトを扱うならSeleniumやrequests_htmlと組み合わせるのがベター()。

3. Selenium

は、もともとテスト自動化用に作られたブラウザ操作ツールだけど、今や動的・JavaScript主体のサイトのスクレイピングにも欠かせない存在。実際のブラウザ(ChromeやFirefoxなど)を立ち上げて、クリックやスクロール、ログインなど人間の操作をそのまま再現できる。人が見れるものはSeleniumでも取得可能。

Python、Java、JavaScript、C#など複数言語に対応してて、ログイン後のページやインタラクティブなフローにも強い。速度やリソース消費はちょっと大きいけど、難易度高めのサイトには頼れる相棒です()。

4. Cheerio

は、Node.js環境でjQueryっぽくHTMLを解析できるライブラリ。HTMLを取得(AxiosやFetchを使う)して、Cheerioに読み込ませてセレクタで要素を抽出。静的ページの解析に特化してて、めちゃくちゃ高速。

JavaScriptで全部完結したい開発者に人気だけど、JavaScriptの実行はできないから動的コンテンツには不向き。他のNode.jsツールとの連携もスムーズ()。

5. Puppeteer

は、Node.jsからChromeやChromiumをヘッドレスで操作できるライブラリ。SeleniumのJavaScriptネイティブ版みたいな感じで、最新のWebアプリやSPA、JavaScript依存のサイトのスクレイピングに最適。スクリーンショットやPDF生成、ネットワーク通信の傍受もできて、async/awaitで直感的に書けるAPIが魅力。

ちょっと開発者向けだけど、動的サイトを扱うなら必須のツール()。

主要オープンソースウェブスクレイピングツール比較表

| ツール名 | 使いやすさ | 対応プラットフォーム/言語 | 動的コンテンツ対応 | おすすめ用途 | 主な強み |

|---|---|---|---|---|---|

| Scrapy | 中~上級(コード必須) | Pythonフレームワーク | 一部対応 | 開発者、データサイエンティスト | 非同期クロール、プラグイン、巨大なコミュニティ |

| BeautifulSoup | 中級(シンプルなコード) | Pythonライブラリ | 非対応 | 初心者、手軽な解析 | 寛容なパーサ、静的HTMLに最適 |

| Selenium | 中級(スクリプト記述) | 複数言語対応 | 対応 | QA、動的サイトのスクレイピング | 実ブラウザ操作、ログイン・ユーザー操作も可能 |

| Cheerio | 中級(JSコード) | Node.jsライブラリ | 非対応 | JS開発者、静的ページ | jQuery風シンタックス、高速HTML解析 |

| Puppeteer | 中級(JSコード) | Node.js(ヘッドレスChrome) | 対応 | 開発者、最新Webアプリ | スクリーンショット、PDF、SPA対応、async/await API |

自分に合ったオープンソースウェブスクレイピングツールの選び方

ツール選びのコツをまとめると:

- 技術レベル:ノーコード派はThunderbit、Octoparse、ParseHub、WebHarvy。エンジニアならScrapy、Cheerio、Puppeteer、Apify。

- プロジェクト規模:単発や小規模ならBeautiful Soup、Cheerio、WebHarvy。大規模・定期運用ならScrapy、Apify、Thunderbit(スケジューリング対応)。

- データタイプ:静的HTMLならCheerio、Beautiful Soup、WebHarvy。動的・JS主体ならPuppeteer、Selenium、Thunderbit、Octoparse。

- 連携性:SheetsやNotion、DBへのエクスポートが必要ならThunderbitやOctoparse。APIや独自パイプライン構築ならScrapyやApify。

- コミュニティ・サポート:活発なフォーラムや最新アップデート、チュートリアルが豊富なものを。Scrapy、Cheerio、Seleniumは巨大なコミュニティがあり、ThunderbitやOctoparseもユーザーが急増中。

まずは小さな案件で2~3ツールを試して、自分のワークフローや好みに合うものを見つけてみて。ビジュアルツールでサクッとデータを取って、必要に応じてコード系フレームワークで深掘りするのもおすすめ。

オープンソーススクレイピングのコミュニティとサポートの強み

オープンソース最大の魅力は、やっぱりコミュニティの存在。活発なフォーラムやGitHubリポジトリ、Stack Overflowのタグなど、困ったときは世界中の仲間が助けてくれる。コミュニティ主導のツールはアップデートや新機能追加も早いし、チュートリアルやプラグイン、ベストプラクティスも豊富()。

ThunderbitやOctoparseみたいなビジュアルツールは、ユーザーフォーラムやテンプレート共有が宝の山。開発者向けツールはGitHubのIssueやDiscord/Slackグループが情報交換の場。オープンソースツールを選ぶってことは、世界中の課題解決ネットワークに参加するってことなんです。

Thunderbit:誰でも使えるノーコードウェブスクレイピングの新定番

オープンソースは最高だけど、「とにかくデータが欲しい」「スクレイパーの構築や保守は面倒」って人も多いはず。全部が全部コードで解決できるわけじゃない。そんな時におすすめなのがThunderbit。ここまで読んで「ツールはすごいけど、もっと手軽にデータを取りたい」と思った人にはThunderbitがピッタリ。

は、ビジネスユーザー向けに作られたAI搭載のChrome拡張。セレクタやスクリプトを書く代わりに、AIフィールド提案をクリックするだけ。AIがページ構造を理解して、カラムを自動で提案。2クリックでスクレイピングが完了。ページネーションやサブページ、リスト詳細の抽出も自動化。

Thunderbitの一番の強みは、「欲しい情報」を自然言語で伝えるだけで、AIが構造化データに変換してくれるところ。たとえば「商品名・価格・評価を集めて」と指示すれば、きれいな表にまとめてくれる。サブページの自動巡回で、より細かいデータも簡単に取得可能。Excel、Google Sheets、Notion、Airtableへのエクスポートもワンクリック。

営業・マーケ・EC・不動産など、データ重視の現場で特に人気。多言語対応、動的サイトにも強く、無料プランも充実。オープンソースじゃないけど、オープンソースツールと組み合わせて使うのもおすすめ。アイデア検証や定期的な業務スクレイピングを、エンジニアの手を借りずに実現できます。

まとめ:オープンソースツールでウェブデータを最大活用しよう

ウェブスクレイピングは、もうエンジニアや大企業だけのものじゃない。今や誰でも、オープンソースツールでウェブを構造化データに変換できる時代。リードリスト作成、価格モニタリング、AIプロジェクトのデータ収集など、使い道は無限大。大事なのは、自分の目的に合ったツールを選ぶこと。スピード重視ならAI・ビジュアル系、パワーや拡張性重視ならコード系フレームワークを使い分けよう。

まずは気になるツールを一つ選んで、実際の業務で試してみて。きっと、これまでの作業時間や手間がグッと減るはず。手軽に始めたい人はして、その便利さを体感してみて。ウェブは宝の山。データという真珠を、ぜひ手に入れてください。

さらに詳しい解説やチュートリアルはでチェック!ハッピー・スクレイピング!

よくある質問(FAQ)

1. オープンソースウェブスクレイピングツールの一番のメリットは?

コストを抑えられて、柔軟にカスタマイズできて、活発なコミュニティのサポートが受けられること。ベンダーロックインを避けて、知見やアップデートもシェアできる。

2. 非エンジニアのビジネスユーザーにおすすめのオープンソースツールは?

Thunderbit、Octoparse、ParseHub、WebHarvyはノーコードで使える優秀な選択肢。特にThunderbitはAIによる2クリック操作と多彩なエクスポート機能が魅力。

3. オープンソースツールで動的・JavaScript主体のサイトもスクレイピングできる?

もちろんOK。Thunderbit、Selenium、Puppeteer、Octoparse、ParseHubなどは、実ブラウザやヘッドレスブラウザで動的コンテンツも取得可能。

4. ツールが今もメンテナンス・サポートされてるか確認するには?

GitHubで最新のコミットやIssue、コントリビューターの活動状況をチェック。活発なフォーラムやブログ、ユーザー作成のプラグイン・テンプレートも目安。

5. ウェブスクレイピング初心者が始めるのに最適な方法は?

ThunderbitやOctoparseなど、ビジュアル・AI搭載ツールから始めるのがおすすめ。まずは小さなデータセットをExcelやSheetsにエクスポートして、慣れてきたらコード系ツールにも挑戦してみよう。

Thunderbitの実力を体験したい人は、して、3万人以上のユーザーと一緒にノーコードでウェブをデータ化しよう。

さらに詳しく知りたい人はこちらもチェック!